Protagonis cerita hari ini ialah dua saintis, Sanjeev Arora dan Anirudh Goyal.

Arora dari Princeton University dan Goyal dari Google DeepMind.

Mereka berkumpul dan hanya mahu meneroka satu soalan.

Iaitu, adakah LLM burung nuri rawak yang hanya berbual-bual, atau adakah ia benar-benar belajar sesuatu dan bertukar menjadi ejen pintar dengan keupayaan yang muncul?

AI perintis Hinton dan Ng Enda juga bercakap tentang isu ini, tetapi mereka tidak membuat sebarang kesimpulan yang jelas pada masa itu.

Hinton menegaskan bahawa jika kata sepakat tidak dapat dicapai dalam isu ini, sukar juga untuk mencapai kata sepakat tentang potensi bahaya yang mungkin dibawa oleh AI.

Arora dan Goyal percaya bahawa LLM bukan sekadar meniru pembelajaran berulang mekanikal. Mereka menegaskan bahawa kandungan output LLM bukan sahaja dijana secara rawak daripada sejumlah besar data latihan, dan perkara ini patut diterokai lebih lanjut.

Dua orang menulis kertas kerja untuk ini.

Alamat kertas: https://arxiv.org/abs/2307.15936

Sebenarnya selepas banyak latihan, skala LLM menjadi lebih besar dan lebih besar, dan keupayaan yang berkaitan dengannya penambahbaikan yang lebih baik dan membangunkan keupayaan baru.

Ini bukan sesuatu yang boleh dilakukan oleh pilih atur dan kombinasi biasa.

Seperti yang kita sedia maklum, LLM ialah rangkaian neural tiruan yang besar, menghubungkan "neuron" satu demi satu.

sebenarnya merujuk kepada parameter model. Lebih banyak parameter yang ada, lebih besar LLM.

Mari kita fahami dulu mekanisme dan pautan latihan LLM.

Proses latihan akan menyertakan pautan ini - berikan LLM satu ayat, sembunyikan perkataan terakhir, dan kemudian biarkan LLM meramalkan siapa perbendaharaan kata kosong itu harus berdasarkan kebarangkalian.

Jika LLM tahu 1000 perkataan, maka ia akan menjana 1000 kebarangkalian. Akhir sekali, pilih yang mempunyai kebarangkalian tertinggi dan isikannya.

Pada mulanya, LLM mungkin tidak dapat memilih perkataan yang betul, dan algoritma akan memberikan nilai kerugian, iaitu "jarak" antara jawapan awal yang diberikan oleh LLM dan jawapan yang betul kepada ayat asal dalam ruang matematik berdimensi tinggi tertentu "(jarak), dan kemudian gunakan nilai ini untuk memperhalusi parameter. Selepas

, untuk ayat yang sama, LLM boleh mengira taburan kebarangkalian yang lebih betul, dan nilai kerugian di atas akan berkurangan sedikit.

Dengan cara ini, proses ini dijalankan melalui berbilion-bilion ayat dalam data latihan, sehingga nilai kerugian keseluruhan LLM dikurangkan ke tahap yang cukup baik.

Begitu juga, ujian LLM juga akan mengikuti proses ini, dan keputusan ujian akan diperolehi berdasarkan nilai kerugian (sudah tentu ayat yang digunakan untuk ujian mesti tiada dalam data latihan, jika tidak, ia tidak akan menipu) .

Selepas latihan dan ujian, LLM berkemungkinan besar menjana perkataan yang paling betul apabila menemui gesaan teks baharu. Apabila perkataan keluar, ia dilemparkan ke dalam gesaan dan perkataan seterusnya dihasilkan.

dijana perlahan-lahan, dan jawapan yang kelihatan koheren muncul di atas kertas.

Walau bagaimanapun, dalam proses ini, tiada petunjuk bahawa LLM yang lebih besar akan berprestasi lebih baik pada soalan yang memerlukan penaakulan. .

Dalam erti kata lain, LLM berskala lebih besar akan berprestasi lebih baik daripada model berskala kecil dari segi keupayaan penaakulan Walaupun tiada perbezaan dalam kaedah latihan antara kedua-duanya, satu-satunya perbezaan adalah dalam skala.

Arora keliru, dari mana datangnya kebolehan ini?

Ini adalah titik permulaan penyelidikan Arora dan Goyal - cuba membina rangka kerja teori untuk menganalisis bagaimana keupayaan baharu ini muncul.

Jadi, mereka menumpukan perhatian kepada bidang matematik dan membidik sesuatu yang dipanggil graf rawak. Ringkasnya, istilah ini terletak pada persimpangan teori graf dan teori kebarangkalian.

Dalam graf rawak, sama ada terdapat tepi yang menghubungkannya antara mana-mana dua nod adalah rawak, sama seperti melambung syiling.

Jika syiling dibaling kepala, ada kelebihan dengan kebarangkalian p. Apabila nilai

p berubah, sifat keseluruhan graf rawak mungkin berubah secara tiba-tiba. Sebagai contoh, jika nilai p melebihi ambang tertentu, beberapa nod terpencil (iaitu titik yang tidak disambungkan ke nod lain) akan hilang secara tiba-tiba.

Dua saintis menyedari bahawa ciri graf rawak ini boleh menjadi cara intuitif untuk mensimulasikan model bahasa yang besar.

Walaupun kerumitan rangkaian saraf tidak terkata dan hampir sukar untuk dianalisis, konsep graf rawak telah dikaji oleh ahli matematik sejak sekian lama, dan pelbagai alat telah dibangunkan untuk analisis.

Mungkin, melalui teori berkaitan graf rawak, penyelidik rangkaian saraf boleh cuba memahami dan menganalisis beberapa ciri model bahasa besar.

Di sini, kedua-dua penyelidik memfokuskan pada graf dwipartit, yang mengandungi dua jenis nod.

Dalam model mereka, satu jenis nod mewakili serpihan teks. Ambil perhatian bahawa serpihan di sini mestilah sekurang-kurangnya satu perenggan dari segi panjang, malah mungkin beberapa halaman panjang, bukannya satu perkataan.

Nod sedemikian membentuk garis lurus.

Jenis nod kedua mewakili kemahiran yang diperlukan untuk memahami teks yang diberikan di atas. Sebagai contoh, pemahaman tentang hubungan logik, atau keupayaan untuk mengira, atau lebih khusus, keupayaan untuk memahami sindiran.

Tujuan memberikan contoh ini adalah untuk menjelaskan bahawa jenis nod kedua ini mewakili pelbagai kebolehan, dan semua perkara di atas disertakan.

Arora berkata jika LLM dapat melihat bahawa teks tertentu mengandungi ironi, pemahaman keseluruhan mungkin berubah dengan ketara.

Walau bagaimanapun, seperti yang kami nyatakan di atas, keupayaan yang diwakili oleh jenis nod kedua tidak bermakna tujuan LLM semasa proses latihan adalah untuk mencapai keupayaan ini. Dalam erti kata lain, LLM hanya melatih keupayaan untuk meramalkan kemungkinan perkataan seterusnya semasa latihan.

Dalam erti kata lain, keupayaan yang diwakili oleh jenis nod kedua telah direka oleh Arora dan Goyal dari perspektif hasil, untuk memahami dengan lebih baik keupayaan yang dipaparkan oleh LLM.

Setelah tetapan selesai, kedua-dua jenis nod akan mula bersambung antara satu sama lain Sambungan mewakili keupayaan LLM untuk memahami perenggan teks tertentu. Ia mungkin satu-dengan-satu, mungkin satu-dengan-banyak, atau mungkin banyak-dengan-satu.

Juga ambil ironi membaca sebagai contoh titik kemahiran ini akan mewujudkan hubungan dengan semua teks yang mengandungi unsur ironis.

Sambungan tidak semudah itu. Anda tahu, syarikat besar seperti OpenAI dan DeepMind tidak akan mendedahkan data latihan atau data ujian. Jadi kedua-dua penyelidik tidak boleh bergantung pada ini.

Selain itu, apa yang ingin mereka fahami ialah hubungan antara skala, tingkah laku dan keupayaan.

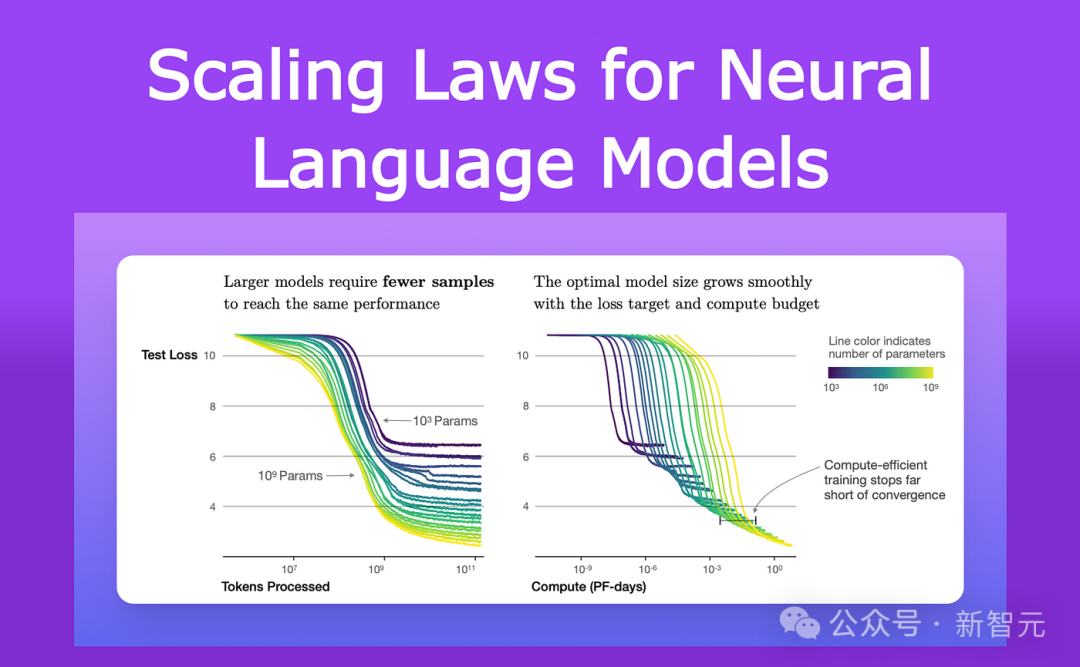

Sejak 2021, penyelidik yang mengkaji prestasi LLM dan rangkaian saraf lain telah memerhatikan ciri yang sama.

Mereka menyedari bahawa apabila model berkembang, kedua-dua saiz dan jumlah data latihan, ia hilang pada data ujian (perbezaan antara ramalan dan jawapan yang betul untuk teks baharu selepas latihan) Dikurangkan dengan cara yang sangat khusus.

Pemerhatian ini telah dikodkan ke dalam persamaan yang dipanggil Undang-undang Penskalaan Neural.

Oleh itu, Arora dan Goyal menyatakan bahawa teori mereka tidak bergantung pada kes mana-mana LLM tunggal, atau set data latihan dan ujian tertentu, sebaliknya sejenis undang-undang universal: kerugian yang diramalkan oleh undang-undang skala.

Kunci kepada penyelidikan lanjut mereka ialah hubungan antara undang-undang penskalaan saraf dan graf dwipartit yang diperkenalkan di atas.

Pertama, pengkaji mengandaikan bahawa terdapat graf bipartit yang sepadan dengan tingkah laku LLM pada data ujian.

Untuk memanfaatkan perubahan kehilangan LLM pada data ujian, mereka membayangkan cara seperti berikut untuk menerangkan bagaimana LLM memperoleh kemahiran.

Mari kita ambil kemahiran memahami ironi sebagai contoh -

Konsep ini diwakili oleh nod kemahiran, jadi penyelidik melihat nod teks mana nod kemahiran ini disambungkan.

Jika hampir semua nod teks yang disambungkan ini berjaya - bermakna ramalan LLM terhadap teks yang diwakili oleh kemahiran khusus ini adalah sangat tepat - maka LLM cekap dalam kemahiran khusus ini.

Tetapi jika lebih daripada bahagian tertentu nod kemahiran disambungkan kepada nod teks yang gagal, maka LLM akan gagal pada kemahiran ini.

Hubungan antara graf dwipartit dan LLM ini membolehkan Arora dan Goyal memanfaatkan alatan teori graf rawak untuk menganalisis kelakuan LLM.

Mengkaji graf ini mendedahkan perhubungan tertentu antara nod. Hubungan ini kemudiannya diubah menjadi kaedah yang logik dan boleh diuji untuk menerangkan bagaimana model bahasa besar memperoleh beberapa keupayaan yang tidak dijangka.

Di sini, Arora dan Goyal menerangkan terlebih dahulu tingkah laku utama - mengapa LLM yang lebih besar lebih mahir dalam kemahiran individu berbanding model yang lebih kecil.

Mereka bermula dengan kehilangan ujian yang lebih rendah yang diramalkan oleh undang-undang penskalaan saraf.

Jika terdapat lebih sedikit nod ujian yang gagal, ini bermakna terdapat lebih sedikit sambungan antara nod ujian yang gagal dan nod kemahiran. Oleh itu, lebih banyak nod kemahiran disambungkan kepada nod ujian yang berjaya menunjukkan bahawa model telah meningkatkan keupayaan dalam kemahiran.

Seterusnya, kedua-dua penyelidik menemui cara untuk menerangkan kuasa yang diperoleh oleh model yang lebih besar - apabila saiz LLM meningkat dan kehilangan ujian berkurangan, gabungan rawak nod kemahiran mula disambungkan ke nod teks individu.

Ini menunjukkan bahawa LLM juga menjadi lebih baik dalam menggunakan berbilang kemahiran secara serentak dan mula menjana teks menggunakan berbilang kemahiran, walaupun gabungan kemahiran tepat ini tidak muncul dalam mana-mana teks dalam data latihan.

Sebagai contoh, LLM sudah boleh menjana teks menggunakan satu kemahiran, maka jika kita mengembangkan bilangan parameter atau data latihan LLM mengikut susunan magnitud, ia akan sama baik dalam menjana teks yang memerlukan kedua-dua kemahiran.

Secara analogi dan mengikut urutan magnitud yang lain, LLM kini boleh melaksanakan tugas yang memerlukan empat kemahiran pada masa yang sama! Selain itu, tahap kecekapan dalam setiap kebolehan juga adalah sama.

Oleh itu, LLM yang lebih besar mempunyai lebih banyak cara untuk menggabungkan kemahiran bersama-sama, yang membawa kepada peningkatan yang ketara dalam prestasi LLM itu sendiri.

Apabila LLM meningkat, kebarangkalian ia menghadapi semua kombinasi kemahiran ini dalam data latihan menjadi semakin kecil, sehingga 0.

Mengikut peraturan teori graf rawak, setiap gabungan datang daripada pensampelan rawak kemahiran yang mungkin. Jadi jika terdapat kira-kira seribu nod kemahiran tunggal asas dalam graf, dan katakan kita ingin menggabungkan empat kemahiran, terdapat kira-kira 1000 hingga kuasa keempat - itu adalah trilion penuh kemungkinan kombinasi.

Dalam erti kata lain, jika LLM benar-benar boleh melaksanakan tugasan ini dengan menggabungkan empat daripada 1,000 kemahiran, ini bermakna model itu mesti mempunyai keupayaan generalisasi Tambahan pula, model ini berkemungkinan Bukan burung nuri rawak lagi.

Tetapi Arora dan Goyal ingin melangkaui teori dan menguji idea mereka bahawa LLM menjadi lebih baik dalam menggabungkan lebih banyak kemahiran apabila saiz dan data latihan mereka meningkat, dan oleh itu menunjukkan prestasi yang lebih baik dalam generalisasi.

Bersama-sama dengan seluruh pasukan, mereka mereka kaedah yang dipanggil pengadunan kemahiran untuk menilai keupayaan LLM menjana teks menggunakan pelbagai kemahiran.

Untuk menguji LLM, pasukan penyelidik memintanya menjana tiga ayat tentang topik yang dipilih secara rawak.

Sebagai contoh, mereka meminta GPT-4 menulis artikel tentang ilmu pedang, dan kemudian mereka meminta model itu menunjukkan kemahiran dari empat bidang: berat sebelah diri, metafora, statistik dan penguasaan percubaan fizik.

Keluaran GPT-4 adalah seperti ini:

Dalam tarian dengan keluli ini, kemenangan saya (menggunakan metafora) adalah pasti seperti jatuh bebas objek (menggunakan fizik) .

Dan sebagai duelist terkenal, saya secara semula jadi fleksibel, kerana kebanyakan orang mengenali saya (menggunakan statistik). gagal? Boleh sahaja kerana medan perang berat sebelah kepada musuh, bukan kerana kekurangan saya (berat sebelah diri).

Hasil sebenar, seperti yang diramalkan oleh matematik, ialah GPT-4 jauh mengatasi GPT-3.5.

Arora membuat tekaan berani, adakah model yang jauh melepasi GPT-4 dalam masa setahun?

Atas ialah kandungan terperinci Princeton DeepMind menggunakan matematik untuk membuktikan: LLM bukan burung nuri rawak! 'Lebih besar skala, lebih kuat keupayaan' mempunyai asas teori. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Formula pilih atur dan gabungan yang biasa digunakan

Formula pilih atur dan gabungan yang biasa digunakan

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk membuka fail torrent

Bagaimana untuk membuka fail torrent

Pengenalan kepada penggunaan vscode

Pengenalan kepada penggunaan vscode

kaedah pemadaman fail hiberfil

kaedah pemadaman fail hiberfil

Bagaimanakah prestasi php8?

Bagaimanakah prestasi php8?

Arah aliran harga Eth hari ini

Arah aliran harga Eth hari ini

Berita rasmi terkini hari ini mengenai PaiCoin adalah benar

Berita rasmi terkini hari ini mengenai PaiCoin adalah benar