Persidangan Antarabangsa mengenai Pembelajaran Perwakilan (ICLR) ke-11 dijangka diadakan di luar talian di Kigali, ibu negara Rwanda, dari 1 hingga 5 Mei. Baru-baru ini, ICLR mengumumkan keputusan penerimaan kertas, termasuk sejumlah 3 kertas oleh NetEase Fuxi. Di antara ketiga-tiga kertas ini, satu dipilih sebagai kertas pembentangan lisan dan dua lagi dipilih sebagai kertas pembentangan sorotan. Kandungan kertas kerja ini melibatkan banyak bidang seperti pembelajaran pengukuhan dan pemprosesan bahasa semula jadi. Kertas kerja yang dipilih kali ini merupakan pencapaian penting pasukan NetEase Fuxi dalam hala tuju penyelidikan ini, dan ia juga merupakan pengiktirafan dan sumbangan cemerlang mereka dalam dunia akademik.

Eksperimen menunjukkan bahawa KLD lebih sensitif kepada titik abnormal, manakala TCD adalah teguh.

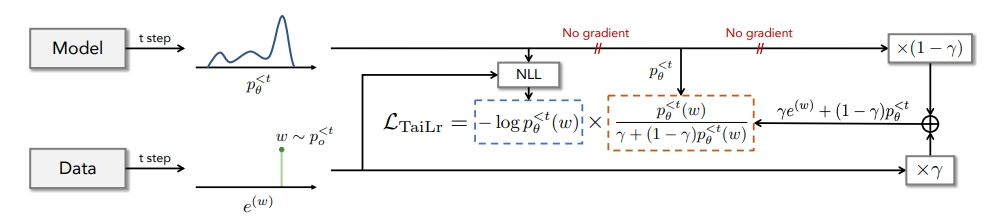

Untuk mengimbangi anggaran TVD, kami memperkenalkan sasaran TaiLr. TaiLr mencapai matlamat ini dengan mengurangkan berat sampel data sebenar dengan kebarangkalian model yang rendah, dan kekuatan penalti boleh dilaraskan mengikut keperluan. Eksperimen menunjukkan bahawa kaedah kami mengurangkan anggaran terlalu tinggi bagi jujukan yang merosot sambil mengekalkan kepelbagaian dan meningkatkan kualiti penjanaan untuk pelbagai tugas penjanaan teks.

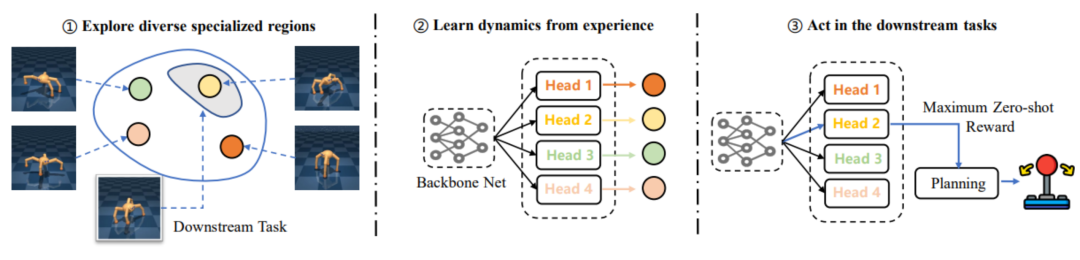

Walau bagaimanapun, kerja lepas sering memfokuskan pada pra-latihan strategi dengan kemahiran yang berbeza melalui penerokaan alam sekitar Walau bagaimanapun, adalah sukar untuk memastikan peningkatan prestasi tugas hiliran melalui kaedah pra-latihan penerokaan pelbagai, malah mungkin membawa kepada peningkatan. kepada penggunaan pra-latihan yang lebih besar Semakin rendah prestasi, masalah "tidak sepadan". Oleh itu, NetEase Fuxi dan pasukan Makmal Pembelajaran Pengukuhan Dalam Universiti Tianjin mencadangkan rangka kerja EUCLID, yang memperkenalkan paradigma RL berasaskan model untuk mendapat manfaat daripada model dinamik yang tepat melalui pra-latihan jangka panjang untuk mencapai penyesuaian tugas hiliran yang pantas dan kecekapan pensampelan yang lebih tinggi. Dalam fasa penalaan halus, EUCLID menggunakan model dinamik yang telah dilatih untuk perancangan berpandukan dasar Tetapan ini boleh menghapuskan kejutan prestasi yang disebabkan oleh masalah ketidakpadanan dan memperoleh peningkatan prestasi yang membosankan.

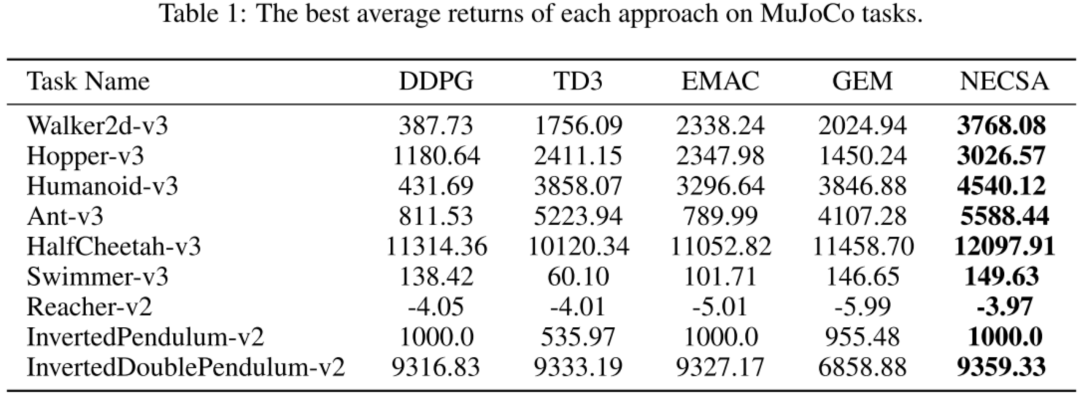

Hasil percubaan menunjukkan bahawa NECSA mencapai markah tertinggi dalam semua persekitaran eksperimen dan mencapai tahap terkini.

NECSA boleh disepadukan dengan mudah ke dalam algoritma pembelajaran pengukuhan dan mempunyai serba boleh yang kuat. Salah satu senario aplikasi biasa ialah latihan robot pertandingan permainan. NECSA menyediakan idea baharu berdasarkan analisis keadaan, yang boleh meningkatkan kesan pembelajaran dan amat sesuai untuk perwakilan keadaan permainan yang kompleks dan berdimensi tinggi. Melalui NECSA, tahap daya saing dan antropomorfisme robot boleh dioptimumkan dengan lebih baik dan lebih pantas, dan kebolehtafsiran model yang baik boleh disediakan. Pada masa hadapan, NetEase Fuxi akan mempromosikan aplikasi praktikal kaedah NECSA dalam berbilang senario permainan.

Terima kasih khas kepada pasukan Profesor Huang Minlie dari Universiti Tsinghua atas sumbangan penyelidikan penting mereka kepada "Menyesuaikan Model Penjanaan Bahasa di bawah Jumlah Jarak Variasi". Kerja penyelidikan mereka telah memberikan sumbangan penting dalam penyesuaian model penjanaan bahasa, menyediakan idea dan kaedah baharu untuk meningkatkan teknologi pemprosesan bahasa semula jadi. Pada masa yang sama, kami ingin mengucapkan terima kasih kepada Makmal Pembelajaran Pengukuhan Dalam Universiti Tianjin atas sumbangan penyelidikannya yang penting kepada "EUCLID: Ke Arah Pembelajaran Pengukuhan Tanpa Penyeliaan yang Cekap dengan Model Dinamik Pelbagai pilihan". Kerja penyelidikan mereka tertumpu pada bidang pembelajaran tetulang tanpa pengawasan dan mencadangkan model dinamik pelbagai pilihan yang cekap, memberikan sumbangan penting kepada pembangunan algoritma pembelajaran tetulang. Di samping itu, kami juga ingin mengucapkan terima kasih kepada Makmal Pangu Universiti Kyushu atas sumbangan penyelidikannya yang penting kepada "Kawalan Episodik Neural dengan Abstraksi Negeri". Kerja penyelidikan mereka memberi tumpuan kepada kawalan memori neuron dan abstraksi keadaan, dan mencadangkan kaedah kawalan neuron baru, yang menyediakan idea baharu dan sokongan teknikal untuk pembangunan dan aplikasi sistem pintar. Sumbangan pasukan penyelidikan ini bukan sahaja penting dalam akademik tetapi juga mempunyai potensi implikasi untuk aplikasi praktikal. Kami merakamkan ucapan terima kasih yang tulus kepada mereka atas kerja cemerlang mereka dan mengharapkan kejayaan berterusan mereka dalam bidang masing-masing Sebagai institusi penyelidikan dan aplikasi AI permainan dan pan-hiburan teratas, NetEase Fuxi komited untuk membuka teknologi dan produk AI kepada lebih banyak lagi. rakan kongsi. Untuk mempromosikan aplikasi teknologi kecerdasan buatan dalam pelbagai bidang. Setakat ini, lebih daripada 200 pelanggan telah memilih perkhidmatan NetEase Fuxi, dan bilangan panggilan telah melebihi ratusan juta setiap hari.

Atas ialah kandungan terperinci NetEase Fuxi mempunyai 3 kertas kerja yang dipilih dalam ICLR 2023, meliputi bidang seperti pembelajaran pengukuhan dan pemprosesan bahasa semula jadi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Aplikasi kecerdasan buatan dalam kehidupan

Aplikasi kecerdasan buatan dalam kehidupan

Apakah konsep asas kecerdasan buatan

Apakah konsep asas kecerdasan buatan

Bagaimana untuk menyelesaikan pengecualian membaca fail besar Java

Bagaimana untuk menyelesaikan pengecualian membaca fail besar Java

Kedudukan terkini pertukaran mata wang digital

Kedudukan terkini pertukaran mata wang digital

Apa itu j2ee

Apa itu j2ee

Pengenalan kepada kaedah penyelenggaraan penukar frekuensi

Pengenalan kepada kaedah penyelenggaraan penukar frekuensi

Mulakan semula arahan pelayan

Mulakan semula arahan pelayan

Penyelesaian kepada tiada bunyi dalam sistem win7

Penyelesaian kepada tiada bunyi dalam sistem win7