Dalam bidang pemanduan autonomi, dengan pembangunan sub-tugas/penyelesaian hujung-ke-hujung berasaskan BEV, data latihan berbilang-pandangan berkualiti tinggi dan simulasi yang sepadan pembinaan tempat kejadian semakin penting . Sebagai tindak balas kepada titik kesakitan tugas semasa, "kualiti tinggi" boleh dipecahkan kepada tiga aspek:

Untuk simulasi, penjanaan video yang memenuhi syarat di atas boleh dijana terus melalui reka letak, yang sudah pasti cara paling langsung untuk membina input sensor berbilang ejen. DrivingDiffusion menyelesaikan masalah di atas dari perspektif baharu.

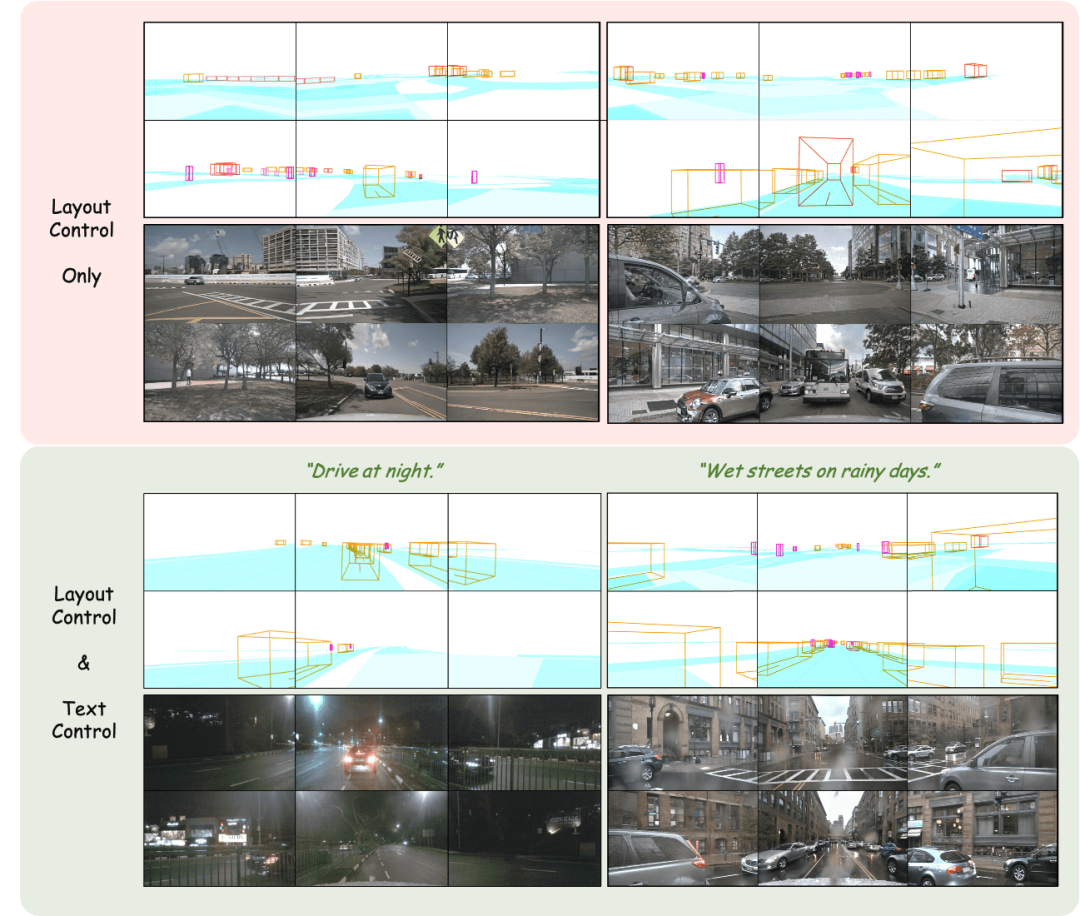

Penjanaan imej berbilang perspektif dengan kawalan reka letak

Laraskan reka letak: Kawal dengan tepat hasil yang dijana

Penjanaan video berbilang paparan terkawal reka letak

Janakan bingkai berikutnya berdasarkan bingkai input + keterangan teks

Secara langsung menjana bingkai seterusnya berdasarkan bingkai input

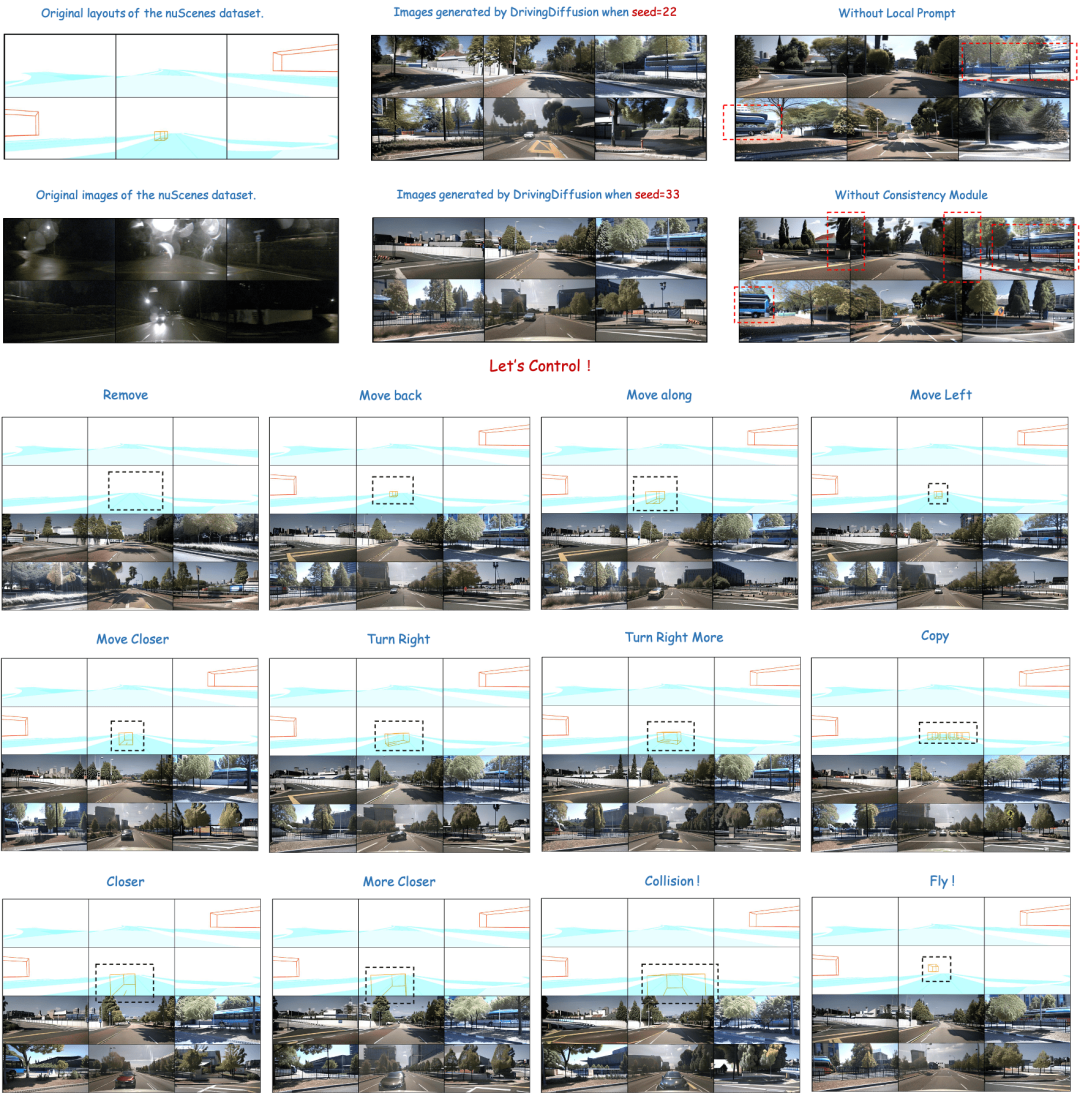

DrivingDiffusion mula-mula membina secara buatan semua nilai sebenar 3D (halangan/struktur jalan) di tempat kejadian Selepas menayangkan nilai sebenar ke dalam imej Layout, ia digunakan sebagai input model untuk mendapatkan imej/video sebenar daripada berbilang kamera. perspektif. Sebab mengapa nilai benar 3D (pandangan BEV atau contoh yang dikodkan) tidak digunakan secara langsung sebagai input model, tetapi parameter digunakan untuk input pasca unjuran, adalah untuk menghapuskan ralat konsistensi 3D-2D yang sistematik. (Dalam set data sedemikian, nilai sebenar 3D dan parameter kenderaan dibina secara buatan mengikut keperluan sebenar. Yang pertama membawa keupayaan untuk membina data pemandangan yang jarang berlaku sesuka hati , dan yang terakhir menghapuskan Ralat pengeluaran data tradisional dalam ketekalan geometri)

Masih ada satu soalan lagi buat masa ini: Bolehkah kualiti imej/video yang dijana memenuhi keperluan penggunaan? Apabila membina senario, semua orang sering berfikir untuk menggunakan enjin simulasi Walau bagaimanapun, terdapat jurang domain yang besar antara data yang dijana dan data sebenar. Hasil yang dihasilkan kaedah berasaskan GAN selalunya mempunyai berat sebelah tertentu daripada pengedaran data sebenar sebenar. Model Penyebaran adalah berdasarkan ciri-ciri rantai Markov yang menjana data dengan mempelajari bunyi bising Kesetiaan hasil yang dihasilkan adalah lebih tinggi dan lebih sesuai untuk digunakan sebagai pengganti kepada data sebenar. DrivingDiffusion secara langsung menjanapandangan berbilang paparan berurutan berdasarkan adegan yang dibina secara buatan dan parameter kenderaan, yang bukan sahaja boleh digunakan sebagai data latihan untuk tugas pemanduan autonomi hiliran, tetapi juga membina sistem simulasi autonomi untuk maklum balas algoritma memandu.

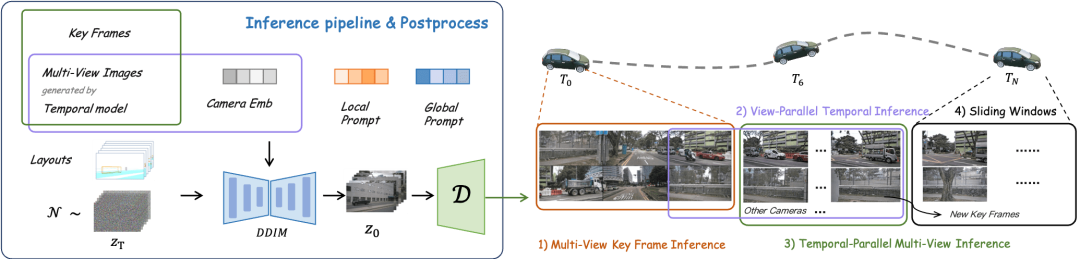

"Adegan buatan buatan" di sini hanya mengandungi halangan dan maklumat struktur jalan, tetapi rangka kerja DrivingDiffusion boleh memperkenalkan maklumat susun atur seperti papan tanda, lampu isyarat, kawasan pembinaan dan juga mod kawalan seperti grid/peta kedalaman pendudukan peringkat rendah.Terdapat beberapa kesukaran semasa menjana video berbilang tontonan:

Model berbilang paparan bingkai tunggal: menjana bingkai kekunci berbilang paparan,

menggunakan bingkai utama sebagai kawalan tambahan, model pemasaan paparan tunggal dikongsi berbilang paparan: melaksanakan pemasaan pada setiap paparan dalam Sambungan selari, Model berbilang paparan bingkai tunggal dengan hasil yang dijana sebagai kawalan tambahan: memperhalusi bingkai berikutnya dalam selari temporal, tentukan bingkai utama baharu dan lanjutkan video melalui tetingkap gelongsor.

tentukan bingkai utama baharu dan lanjutkan video melalui tetingkap gelongsor.

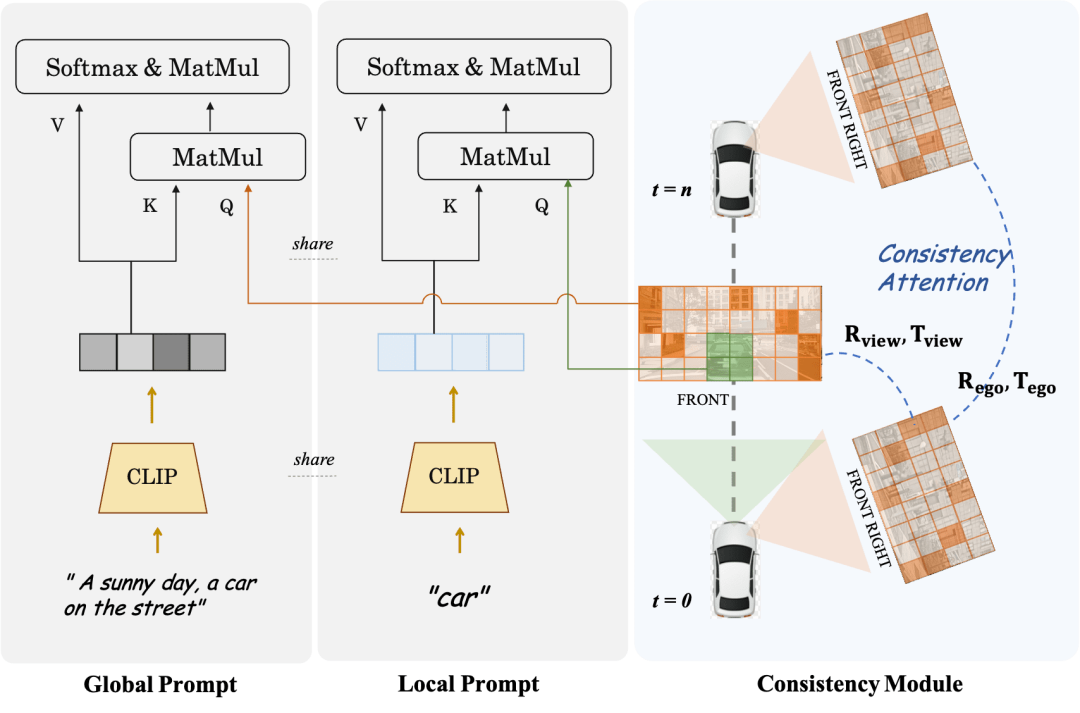

Modul Konsistensi terbahagi kepada dua bahagian: Mekanisme Perhatian Konsisten dan Kehilangan Persatuan Konsisten.

Mekanisme perhatian konsisten memfokuskan pada interaksi antara pandangan bersebelahan dan bingkai berkaitan temporal Khususnya, untuk ketekalan bingkai silang, ia hanya memfokuskan pada interaksi maklumat antara pandangan bersebelahan kiri dan kanan yang bertindih Untuk model temporal, setiap bingkai sahaja memfokuskan pada bingkai kunci dan bingkai sebelumnya. Ini mengelakkan beban pengiraan yang besar yang disebabkan oleh interaksi global.

Kehilangan korelasi yang konsisten menambah kekangan geometri dengan korelasi mengikut piksel dan mengundur pose, yang kecerunannya disediakan oleh regressor pose yang telah terlatih. Regressor menambah kepala regresi pose berdasarkan LoFTR dan dilatih menggunakan nilai pose sebenar pada data sebenar set data yang sepadan. Untuk model berbilang paparan dan model siri masa, modul ini masing-masing menyelia pose relatif kamera dan pose gerakan kenderaan utama.

Local Prompt dan Global Prompt bekerjasama untuk menggunakan semula semantik parameter CLIP dan stable-diffusion-v1-4 untuk mempertingkatkan kawasan contoh kategori tertentu secara tempatan. Seperti yang ditunjukkan dalam rajah, berdasarkan mekanisme perhatian silang token imej dan gesaan penerangan teks global, pengarang mereka bentuk gesaan tempatan untuk kategori tertentu dan menggunakan token imej dalam kawasan topeng kategori untuk menanyakan tempatan. segera. Proses ini menggunakan maksimum konsep penjanaan imej berpandukan teks dalam domain terbuka dalam parameter model asal.

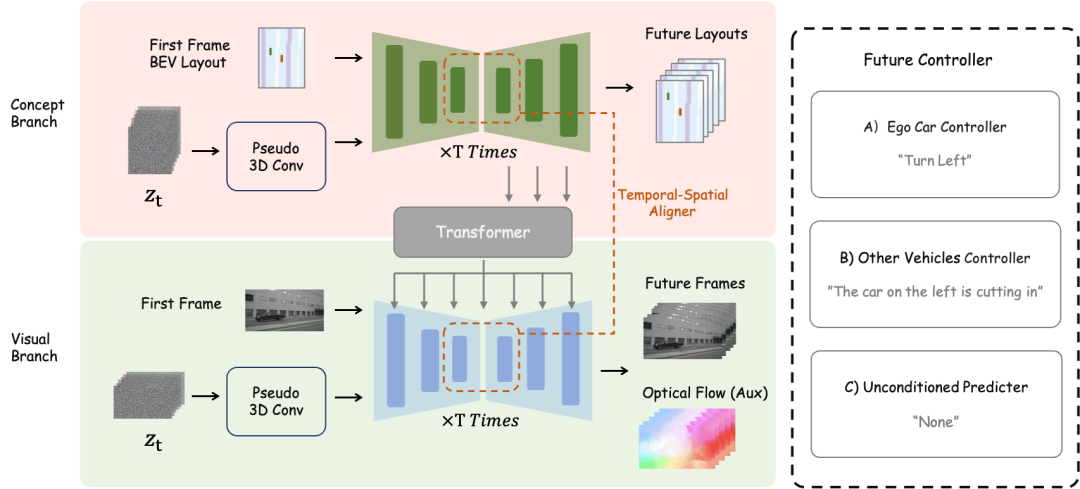

Untuk tugas pembinaan adegan masa hadapan, DrivingDiffusion-Future menggunakan dua kaedah: satu ialah meramalkan imej bingkai berikutnya (cawangan visual) terus daripada imej bingkai pertama, dan Gunakan aliran optik bingkai sebagai kehilangan tambahan. Kaedah ini agak mudah, tetapi kesan penjanaan bingkai berikutnya berdasarkan penerangan teks adalah purata. Cara lain ialah menambah cawangan konsep baharu berdasarkan bekas, yang meramalkan paparan BEV bagi bingkai berikutnya melalui paparan BEV bagi bingkai pertama Ini kerana ramalan pandangan BEV membantu model menangkap maklumat teras pemanduan adegan dan mewujudkan konsep. Pada masa ini, perihalan teks bertindak pada kedua-dua cawangan pada masa yang sama, dan ciri-ciri cabang konsep bertindak pada cawangan visual melalui modul penukaran perspektif BEV2PV Beberapa parameter modul penukaran perspektif telah dilatih dengan menggunakan imej nilai benar untuk menggantikan input hingar (dan dalam Pembekuan semasa latihan berikutnya). Perlu diingat bahawa pengawal keterangan teks kawalan kenderaan utama dan pengawal penerangan teks kawalan kenderaan/persekitaran lain dipisahkan.

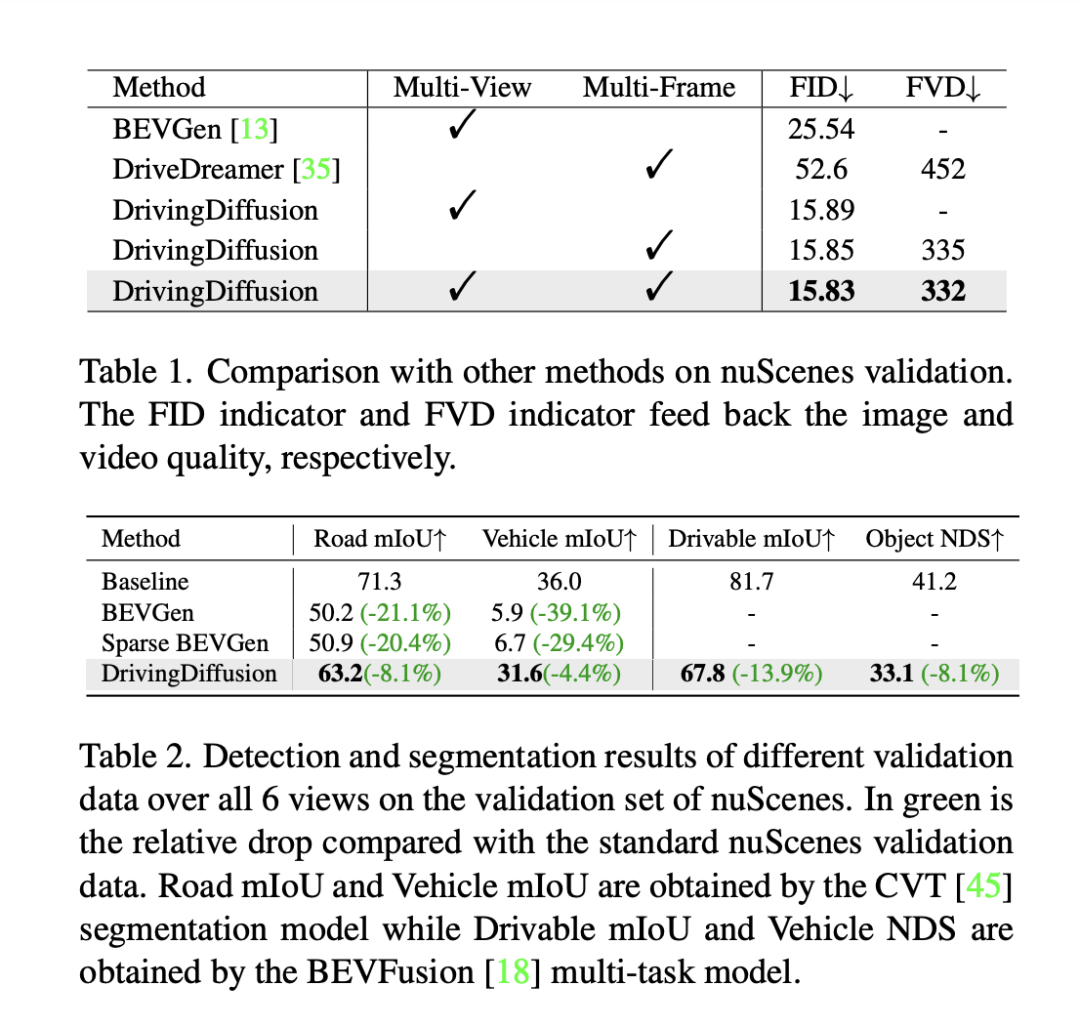

Untuk menilai prestasi model, DrivingDiffusion menggunakan Fréchet Inception Distance (FID) peringkat bingkai untuk menilai kualiti imej yang dijana, dan dengan itu menggunakan FVD untuk menilai kualiti video yang dijana. Semua metrik dikira pada set pengesahan nuScenes. Seperti yang ditunjukkan dalam Jadual 1, berbanding dengan tugas penjanaan imej BEVGen dan tugas penjanaan video DriveDreamer dalam senario pemanduan autonomi, DrivingDiffusion mempunyai kelebihan yang lebih besar dalam penunjuk prestasi di bawah tetapan yang berbeza.

Walaupun kaedah seperti FID sering digunakan untuk mengukur kualiti sintesis imej, kaedah ini tidak memberi maklum balas sepenuhnya terhadap matlamat reka bentuk tugasan, dan juga tidak mencerminkan kualiti sintesis untuk kategori semantik yang berbeza. Memandangkan tugas itu dikhususkan untuk menjana imej berbilang paparan selaras dengan reka letak 3D, DrivingDiffuison mencadangkan untuk menggunakan metrik model persepsi BEV untuk mengukur prestasi dari segi ketekalan: menggunakan model rasmi CVT dan BEVFusion sebagai penilai, menggunakan model 3D sebenar yang sama sebagai set pengesahan nuScenes Jana imej secara bersyarat pada susun atur, lakukan inferens CVT dan BevFusion pada setiap set imej yang dijana, dan kemudian bandingkan keputusan yang diramalkan dengan keputusan sebenar, termasuk purata persimpangan di atas skor U (mIoU) bagi kawasan boleh pandu dan NDS bagi semua kelas objek Statistik ditunjukkan dalam Jadual 2. Keputusan eksperimen menunjukkan bahawa penunjuk persepsi set penilaian data sintetik adalah sangat hampir dengan set penilaian sebenar, yang mencerminkan ketekalan tinggi hasil yang dijana dan nilai sebenar 3D dan kesetiaan tinggi kualiti imej.

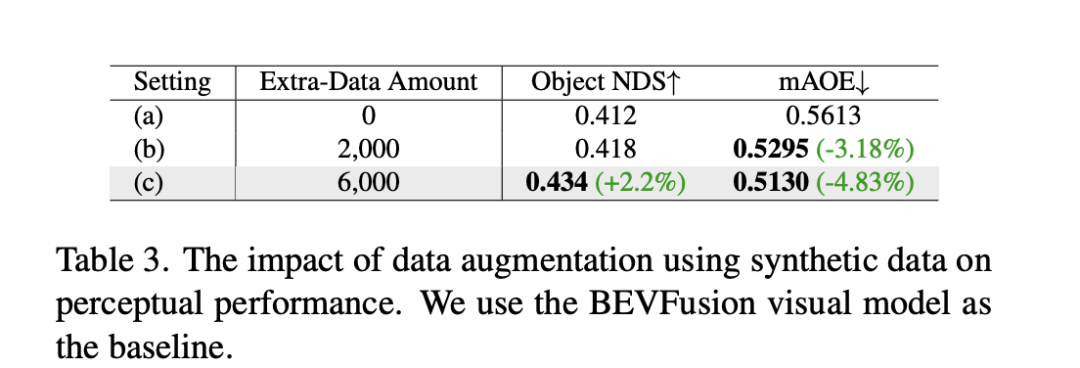

Selain daripada eksperimen di atas, DrivingDiffusion menjalankan eksperimen untuk menambah latihan data sintetik untuk menangani masalah utama yang diselesaikannya - meningkatkan prestasi tugasan hiliran pemanduan autonomi. Jadual 3 menunjukkan peningkatan prestasi yang dicapai oleh penambahan data sintetik dalam tugas persepsi BEV. Dalam data latihan asal, terdapat masalah dengan pengagihan ekor panjang, terutamanya untuk sasaran kecil, kenderaan jarak dekat dan sudut orientasi kenderaan. DrivingDiffusion memfokuskan pada penjanaan data tambahan untuk kelas ini dengan sampel terhad untuk menyelesaikan masalah ini. Selepas menambah 2000 bingkai data yang tertumpu pada penambahbaikan pengagihan sudut orientasi halangan, NDS bertambah baik sedikit, manakala mAOE turun dengan ketara daripada 0.5613 kepada 0.5295. Selepas menggunakan 6000 bingkai data sintetik yang lebih komprehensif dan tertumpu pada adegan yang jarang berlaku untuk membantu latihan, peningkatan ketara boleh diperhatikan pada set pengesahan nuScenes: NDS meningkat daripada 0.412 kepada 0.434, dan mAOE menurun daripada 0.5613 kepada 0.5130. Ini menunjukkan peningkatan ketara yang boleh dibawa oleh penambahan data data sintetik kepada tugas persepsi. Pengguna boleh membuat statistik mengenai pengedaran pelbagai dimensi dalam data berdasarkan keperluan sebenar, dan kemudian menambahnya dengan data sintetik yang disasarkan.

DrivingDiffusion pada masa yang sama merealisasikan keupayaan untuk menjana video berbilang tontonan adegan pemanduan autonomi dan meramalkan masa depan, yang sangat penting untuk tugas pemanduan autonomi. Antaranya, reka letak dan parameter semuanya dibina secara buatan dan penukaran antara 3D-2D adalah melalui unjuran dan bukannya bergantung pada parameter model yang boleh dipelajari Ini menghapuskan ralat geometri dalam proses mendapatkan data sebelumnya dan mempunyai nilai praktikal yang kukuh. Pada masa yang sama, DrivingDiffuison sangat berskala dan menyokong susun atur kandungan pemandangan baharu serta pengawal tambahan Ia juga boleh meningkatkan kualiti penjanaan tanpa kehilangan melalui teknologi pemasukan bingkai video dan resolusi super.

Dalam simulasi pemanduan autonomi, semakin banyak percubaan di Nerf. Walau bagaimanapun, dalam tugas penjanaan paparan jalan, pemisahan kandungan dinamik dan statik, pembinaan semula blok berskala besar, kawalan penampilan decoupling cuaca dan dimensi lain, dan lain-lain, membawa sejumlah besar kerja Di samping itu, Nerf sering perlu dijalankan dalam julat adegan tertentu Hanya selepas latihan ia boleh menyokong tugasan sintesis perspektif baharu dalam simulasi seterusnya. DrivingDiffusion secara semula jadi mengandungi sejumlah pengetahuan am sebelum ini, termasuk sambungan teks visual, pemahaman konsep kandungan visual, dll. Ia boleh mencipta pemandangan mengikut keperluan dengan cepat hanya dengan membina reka letak. Walau bagaimanapun, seperti yang dinyatakan di atas, keseluruhan proses adalah agak kompleks, dan penjanaan video panjang memerlukan penalaan halus dan pengembangan model pasca pemprosesan. DrivingDiffusion akan terus meneroka pemampatan dimensi perspektif dan dimensi masa, serta menggabungkan Nerf untuk penjanaan dan penukaran perspektif baharu, serta terus meningkatkan kualiti penjanaan dan kebolehskalaan.

Atas ialah kandungan terperinci Model dunia penjanaan video adegan pemanduan berbilang paparan autonomi |. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

ppt ke perkataan

ppt ke perkataan

Apakah perbezaan antara bahasa c++ dan c

Apakah perbezaan antara bahasa c++ dan c

apakah alamat mac

apakah alamat mac

Penyelesaian kepada kod java tidak berjalan

Penyelesaian kepada kod java tidak berjalan

Bagaimana untuk menyambung ke pangkalan data dalam vb

Bagaimana untuk menyambung ke pangkalan data dalam vb

Bagaimana untuk menyemak pautan mati laman web

Bagaimana untuk menyemak pautan mati laman web

MySQL menukar kata laluan root

MySQL menukar kata laluan root