Mengapa robotik ketinggalan jauh di belakang pemprosesan bahasa semula jadi (NLP), penglihatan dan bidang kecerdasan buatan yang lain? Antara kesukaran lain, kekurangan data adalah sebab utama. Untuk menyelesaikan masalah ini, Google DeepMind dan institusi lain melancarkan set data X-Embodiment terbuka dan berjaya melatih model RT-X yang lebih berkuasa

Pencapaian berterusan dalam model besar, penyelidikan Dalam 2023 pada robot pintar yang terkandung yang menggunakan model besar sebagai otak untuk membantu dalam operasi juga sedang berkembang pesat. Lebih 2 bulan yang lalu, Google DeepMind melancarkan model Vision-Language-Action (VLA) pertama untuk mengawal robot - RT-2. Model ini membolehkan robot bukan sahaja mentafsir arahan manusia yang kompleks, tetapi juga memahami objek di hadapannya (walaupun objek itu tidak pernah dilihat sebelum ini) dan mengambil tindakan mengikut arahan. Sebagai contoh, anda meminta robot untuk mengambil "haiwan pupus" di atas meja. Ia akan merebut anak patung dinosaur di hadapannya.

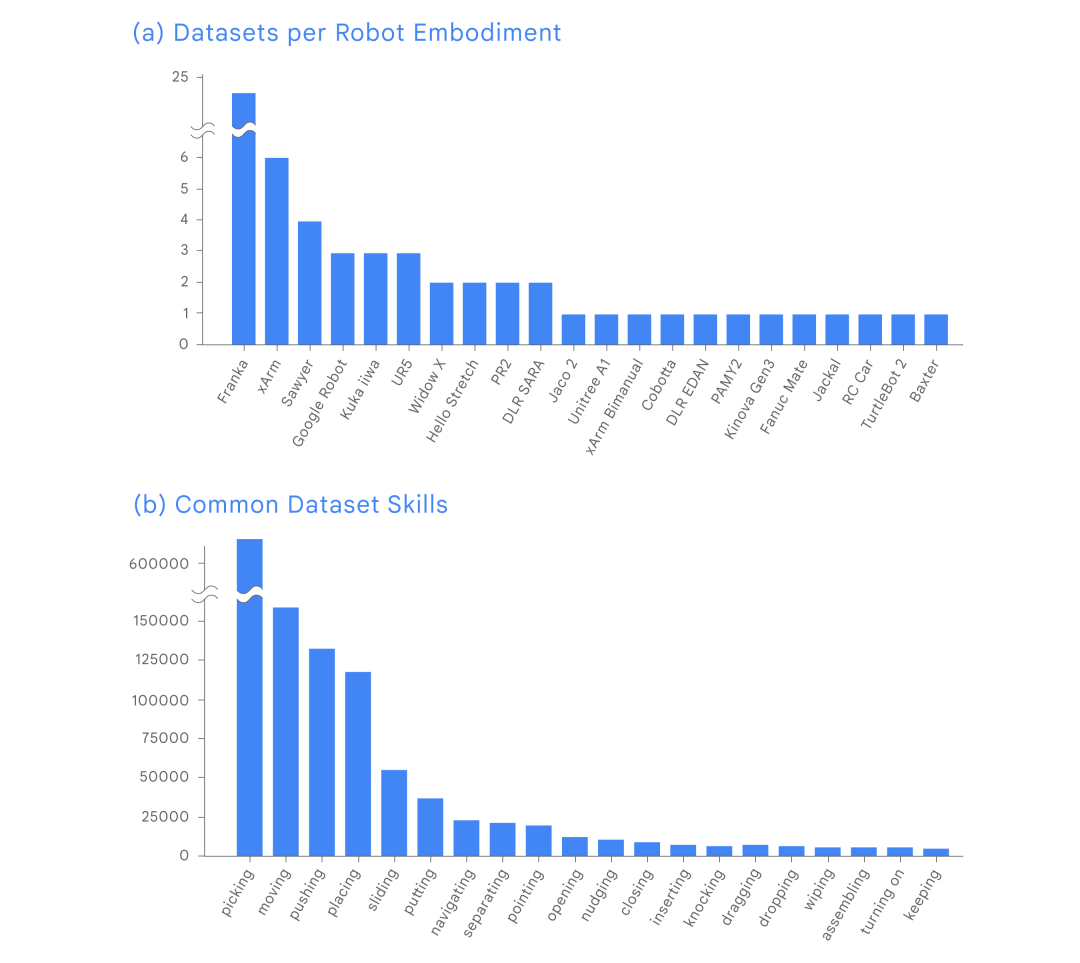

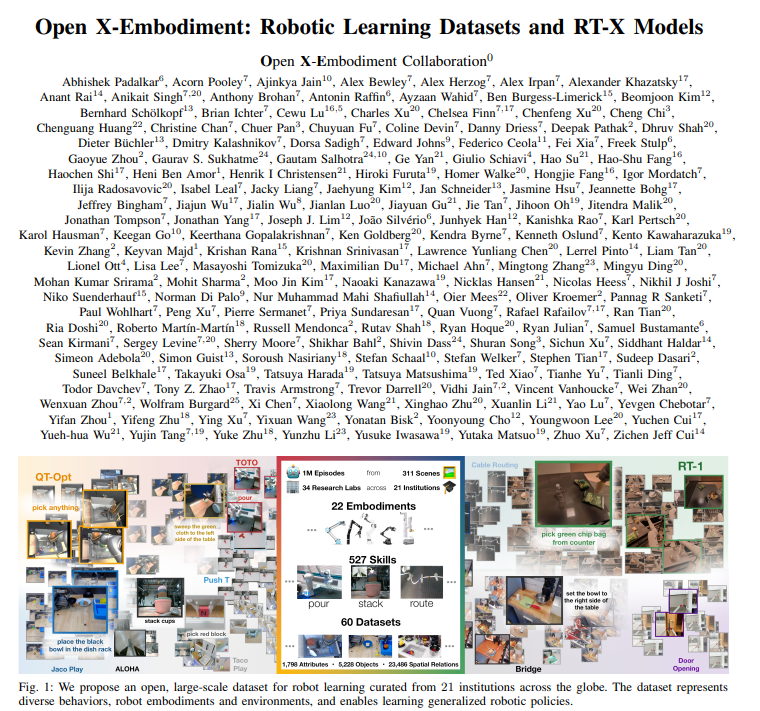

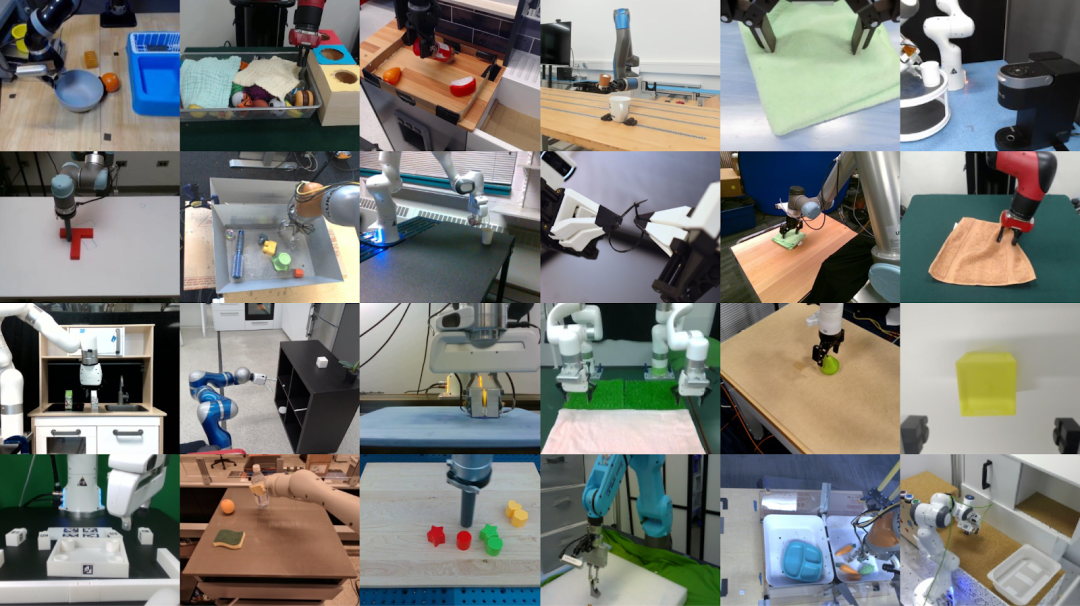

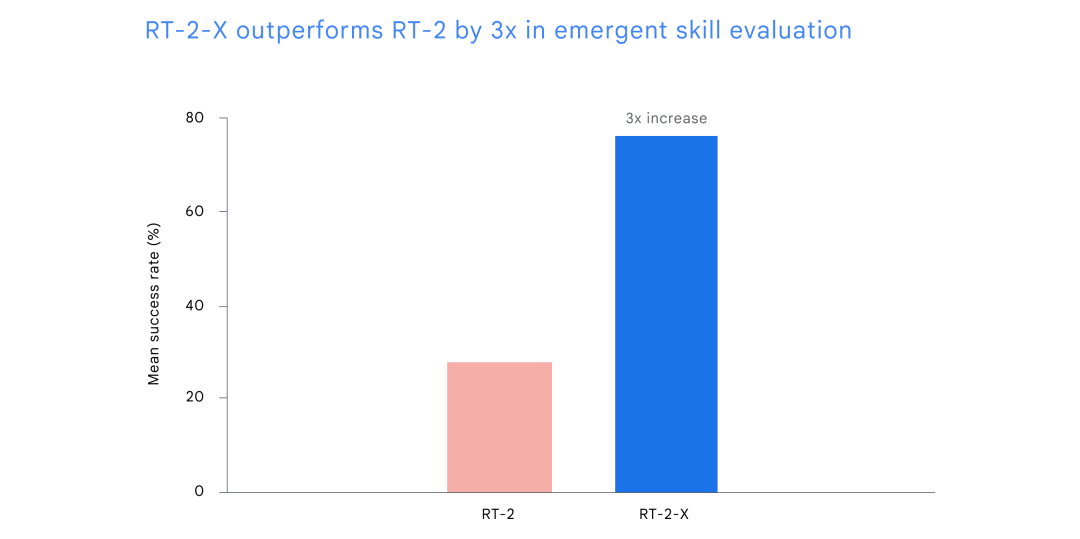

Pada masa itu, seorang eksekutif Google berkata RT-2 adalah lonjakan besar ke hadapan dalam cara robot dibina dan diprogramkan. "Disebabkan oleh perubahan ini, kami terpaksa memikirkan semula keseluruhan rancangan penyelidikan kami." Kita tahu bahawa robot biasanya sangat khusus dalam melakukan satu perkara, tetapi mempunyai keupayaan am yang lemah. Biasanya, anda perlu melatih model untuk setiap tugas, robot dan persekitaran. Menukar pembolehubah selalunya memerlukan bermula dari awal. Tetapi bagaimana jika kita boleh menggabungkan pengetahuan daripada pelbagai disiplin robotik untuk mencipta cara untuk melatih robot sejagat? Inilah yang DeepMind lakukan sejak sekian lama. Mereka mengumpulkan data daripada 22 jenis robot berbeza untuk mencipta dataset Open X-Embodiment, dan kemudian melatih RT-X yang lebih berkebolehan ( RT-1-X dan RT-2-X masing-masing). Mereka menguji model RT-1-X dalam lima makmal penyelidikan berbeza dan keputusan menunjukkan bahawa kaedah baharu itu sama-sama berjaya merentas lima robot berbeza yang biasa digunakan berbanding kaedah yang dibangunkan secara bebas untuk setiap robot meningkat sebanyak 50%. . Mereka juga menunjukkan bahawa RT-2-X yang dilatih pada set data di atas meningkatkan prestasi kemahiran robot dunia sebenar dengan faktor 2, dan dengan mempelajari data baharu, RT-2-X menguasai banyak kemahiran baharu. Kerja ini menunjukkan bahawa model tunggal yang dilatih pada data daripada berbilang jenis robot menunjukkan prestasi yang lebih baik pada berbilang robot berbanding model yang dilatih pada data daripada jenis robot tunggal. Perlu dinyatakan bahawa penyelidikan ini tidak disiapkan oleh DeepMind secara bebas, tetapi adalah hasil kerjasama mereka dengan 33 makmal akademik. Mereka komited untuk membangunkan teknologi ini secara terbuka dan bertanggungjawab. Pada masa ini, dataset Open X-Embodiment dan pusat pemeriksaan model RT-1-X tersedia untuk komuniti penyelidikan yang luas. Jim Fan, saintis kecerdasan buatan kanan di Nvidia, berkata hari ini boleh menjadi detik ImageNet untuk robot.

Penyelidik Google Karol Hausman turut meluahkan keluhan yang sama: Detik robot ImageNet akhirnya tiba.

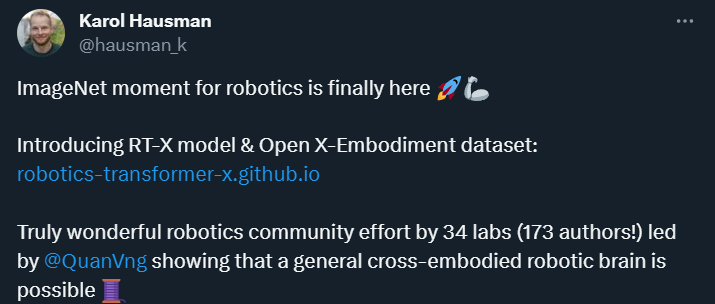

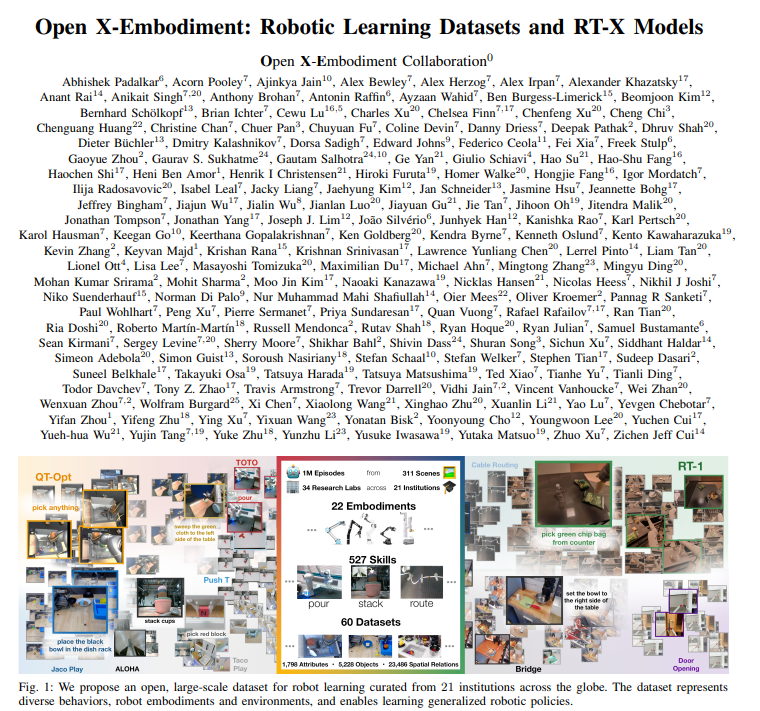

Open X-Embodiment Dataset, ImageNet Moment for RoboticsSet data dan model yang dilatih padanya telah memainkan peranan penting dalam memajukan kemajuan AI. Sama seperti penyelidikan penglihatan komputer termaju ImageNet, Open X-Embodiment juga robotik termaju. Membina set data yang pelbagai sentiasa menjadi kunci untuk melatih model universal ini boleh mengawal pelbagai jenis robot, mengikut arahan yang berbeza, melakukan penaakulan asas pada tugas yang kompleks dan melaksanakan tugasan umum dengan cekap. Walau bagaimanapun, pengumpulan set data sedemikian akan menjadi terlalu intensif sumber untuk mana-mana makmal tunggal. Untuk tujuan ini, DeepMind bekerjasama dengan makmal penyelidikan akademik di 33 institusi untuk membina dataset Open X-Embodiment. Mereka mengumpul data daripada 22 contoh robot yang merangkumi lebih daripada 1 juta klip yang menunjukkan prestasi robot dalam lebih daripada 500 kemahiran dan 150,000 tugas. Set data ini ialah set data robotik paling komprehensif seumpamanya. Sampel daripada set data Open X-Embodiment, termasuk lebih daripada 500 kemahiran dan 150,000 tugasan. . RT-X adalah berdasarkan kepada dua model pengubah robotik (RT) yang dibina.  Secara khusus, mereka melatih RT-1-X menggunakan RT-1, iaitu rangkaian parameter 35M yang dibina pada seni bina Transformer dan direka untuk kawalan robot, seperti yang ditunjukkan dalam Rajah 3.

Secara khusus, mereka melatih RT-1-X menggunakan RT-1, iaitu rangkaian parameter 35M yang dibina pada seni bina Transformer dan direka untuk kawalan robot, seperti yang ditunjukkan dalam Rajah 3.

Selain itu, mereka melatih RT-2-X pada RT-2, sebuah keluarga model tindakan bahasa visual berskala besar (VLA), pada data penglihatan dan bahasa berskala Internet serta data kawalan robot yang dilatih. Untuk menilai RT-1-X, DeepMind membandingkannya dengan model yang dibangunkan untuk tugas tertentu, seperti membuka pintu. Keputusan menunjukkan bahawa RT-1-X yang dilatih menggunakan set data Open X-Embodiment mengatasi model asal sebanyak 50% secara purata. Kadar kejayaan purata RT-1-X adalah 50% lebih tinggi daripada kaedah asal.

关于 Paparan kesan RT-1-X daripada agensi kerjasama yang berbeza

RT-2-X: Kemahiran baharu membuka kunci tanpa halangan untuk belajar ilmu RT-X keupayaan, DeepMind menjalankan eksperimen lain. Eksperimen ini melibatkan objek dan kemahiran yang tidak terdapat dalam dataset RT-2, tetapi terdapat dalam dataset robot lain. Keputusan menunjukkan bahawa RT-2-X adalah tiga kali lebih berjaya dalam menguasai kemahiran baru daripada model terbaik sebelumnya, RT-2. Ini juga menggambarkan bahawa latihan bersama dengan data daripada platform lain boleh memberi RT-2-X kemahiran tambahan yang tidak terdapat dalam set data asal, membolehkannya melaksanakan tugas baru. Gambar di atas menunjukkan pemahaman RT-2-X tentang hubungan ruang antara objek. Serangkaian keputusan menunjukkan bahawa RT-2-X mencapai kemahiran yang sebelum ini tidak boleh dicapai dengan RT-2, termasuk pemahaman yang lebih baik tentang ruang. Sebagai contoh, jika kita meminta robot untuk "menggerakkan epal berhampiran kain", atau meminta robot untuk "menggerakkan epal ke kain", untuk mencapai keperluan matlamat, robot akan mengambil trajektori yang sama sekali berbeza. Cuma tukar preposisi daripada "berhampiran" kepada "hidup" untuk melaraskan tindakan yang diambil oleh robot.

RT-2-X menunjukkan bahawa menggabungkan data daripada robot lain ke dalam latihan RT-2-X boleh meningkatkan julat tugas robot, tetapi hanya jika seni bina berkapasiti tinggi digunakan.

RT-2-X (55b): Salah satu model terbesar hingga kini melaksanakan tugas yang tidak diketahui di makmal akademik

Inspirasi Penyelidikan: Robot perlu belajar antara satu sama lain, penyelidik Perkara yang sama Penyelidikan robotik sedang dalam peringkat awal yang menarik. Penyelidikan baharu daripada DeepMind ini menunjukkan bahawa dengan menskalakan pembelajaran dengan data yang lebih pelbagai dan model yang lebih baik, mungkin untuk membangunkan robot bantuan yang lebih berguna. Bekerjasama dan berkongsi sumber dengan makmal di seluruh dunia adalah penting untuk memajukan penyelidikan robotik secara terbuka dan bertanggungjawab. DeepMind berharap dapat mengurangkan halangan dan mempercepatkan penyelidikan dengan membuka sumber data dan menyediakan model yang selamat tetapi terhad. Masa depan robotik bergantung pada robot belajar antara satu sama lain dan, yang paling penting, membolehkan penyelidik belajar antara satu sama lain. Kerja ini membuktikan bahawa model itu boleh digeneralisasikan dalam persekitaran yang berbeza, dan prestasinya meningkat dengan ketara sama ada pada robot daripada Google DeepMind atau robot di universiti yang berbeza di seluruh dunia. Penyelidikan masa depan boleh meneroka cara menggabungkan kemajuan ini dengan ciri peningkatan diri RoboCat, membolehkan model itu terus bertambah baik berdasarkan pengalamannya sendiri. Satu lagi hala tuju masa depan adalah untuk meneroka lebih lanjut cara mencampurkan set data yang berbeza mempengaruhi generalisasi ejen terjelma silang, dan cara generalisasi ini dicapai.

Jika anda ingin mengetahui lebih lanjut tentang RT-X, anda boleh rujuk kertas kerja terbitan DeepMind ini:

Pautan kertas: https://robotics-transformer-x.github.io / paper.pdf Pautan projek: https://robotics-transformer-x.github.io/

Pautan projek: https://robotics-transformer-x.github.io/

-

Pautan rujukan: https://www.deepmind.com/blog/scaling - up-learning-rentas-banyak-pelbagai-jenis-robot

Atas ialah kandungan terperinci Gergasi pembelajaran mendalam DeepMind telah membuat kemajuan terobosan pada dataset ImageNet, membawa pencapaian baharu kepada penyelidikan robotik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pautan projek: https://robotics-transformer-x.github.io/

Pautan projek: https://robotics-transformer-x.github.io/