Pengenalan latar belakang

Untuk menangani pelbagai senario komunikasi audio dan video yang kompleks, seperti berbilang peranti, berbilang orang dan berbilang bunyi senario, media penstriman Teknologi komunikasi secara beransur-ansur menjadi teknologi yang amat diperlukan dalam kehidupan manusia. Untuk mencapai pengalaman subjektif yang lebih baik dan membolehkan pengguna mendengar dengan jelas dan benar, penyelesaian teknologi audio penstriman menggabungkan pembelajaran mesin tradisional dan penyelesaian peningkatan suara berasaskan AI, menggunakan penyelesaian teknologi rangkaian saraf dalam untuk mencapai pengurangan hingar suara dan pembatalan gema , mengganggu penghapusan suara dan pengekodan dan penyahkodan audio, dsb., untuk melindungi kualiti audio dalam komunikasi masa nyata.

Sebagai persidangan antarabangsa utama dalam bidang penyelidikan pemprosesan isyarat pertuturan, Interspeech sentiasa mewakili hala tuju penyelidikan yang paling canggih dalam bidang akustik 2023 telah memasukkan beberapa artikel yang berkaitan dengan audio algoritma peningkatan pertuturan isyarat, antaranya, Sebanyak 4 kertas penyelidikan daripada Pasukan Audio Penstriman Enjin Volcano telah diterima oleh persidangan itu, termasuk peningkatan pertuturan, pengekodan dan penyahkodan berasaskan AI # 🎜🎜#, pembatalan gema dan peningkatan pertuturan adaptif terkawal tanpa wayar .

Perlu dinyatakan bahawa dalam bidang peningkatan pertuturan adaptif tanpa pengawasan, pasukan bersama ByteDance dan NPU melakukan penyesuaian domain tanpa pengawasan pada subtugas cabaran CHiME (Computational Hearing in Multisource Environments) tahun ini penyesuaian domain untuk peningkatan pertuturan perbualan (UDASE) memenangi kejuaraan (https://www.chimechallenge.org/current/task2/results). Cabaran CHiME ialah pertandingan antarabangsa penting yang dilancarkan pada 2011 oleh institusi penyelidikan terkenal seperti Institut Sains Komputer dan Automasi Perancis, Universiti Sheffield di UK, dan Makmal Penyelidikan Elektronik Mitsubishi di Amerika Syarikat masalah jauh yang mencabar dalam bidang penyelidikan pertuturan pada tahun ini, ia telah diadakan untuk kali ketujuh. Pasukan yang mengambil bahagian dalam pertandingan CHiME sebelum ini termasuk Universiti Cambridge di United Kingdom, Universiti Carnegie Mellon di Amerika Syarikat, Universiti Johns Hopkins, NTT di Jepun, Hitachi Academia Sinica dan universiti dan institusi penyelidikan terkenal antarabangsa yang lain, serta Universiti Tsinghua, Akademi Sains Universiti China, Institut Akustik Akademi Sains China, NPU, iFlytek dan universiti dan institut penyelidikan tempatan terkemuka yang lain.

Artikel ini akan memperkenalkan masalah senario teras dan penyelesaian teknikal yang diselesaikan oleh empat kertas ini

Kongsi kemajuan pasukan audio penstriman Volcano Engine dalam peningkatan pertuturan, pembatalan gema berasaskan pengekod AI dan auto tanpa pengawasan. -automasi Menyesuaikan diri dengan pemikiran dan amalan dalam bidang peningkatan pertuturan.

Kaedah peningkatan harmonik pertuturan ringan berdasarkan penapis sikat yang boleh dipelajari

Alamat kertas: https://www.isca-speech.org /archive/interspeech_2023/le23ch_interspeech .html

Latar Belakang

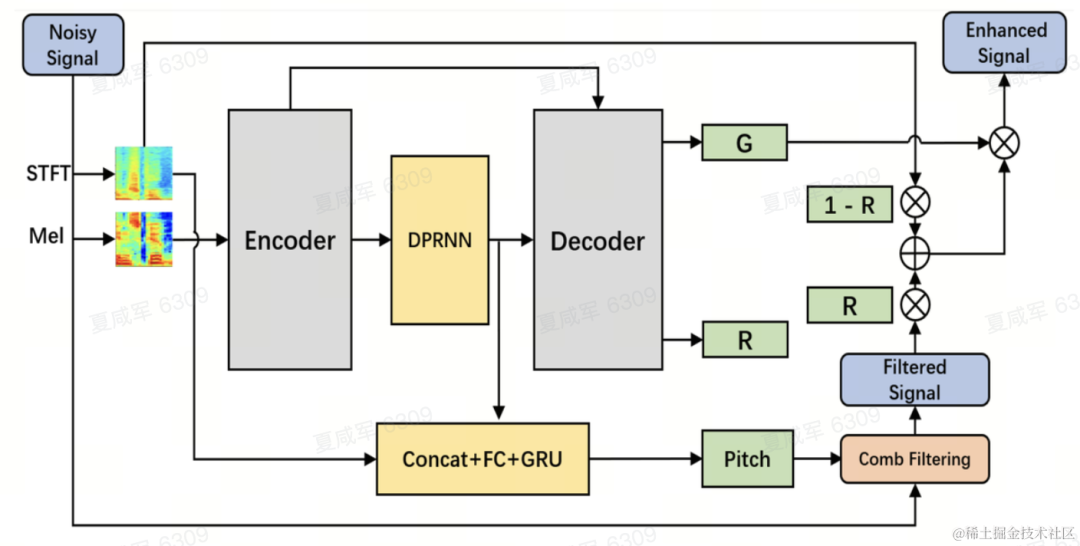

Terhad oleh kelewatan dan sumber pengkomputeran, peningkatan pertuturan dalam senario komunikasi audio dan video masa nyata biasanya menggunakan ciri input penapis. Melalui bank penapis seperti Mel dan ERB, spektrum asal dimampatkan ke dalam sub-jalur dimensi lebih rendah. Dalam domain subband, output model peningkatan pertuturan berasaskan pembelajaran mendalam ialah perolehan pertuturan subband, yang mewakili perkadaran tenaga pertuturan sasaran. Walau bagaimanapun, audio yang dipertingkatkan pada domain sub-jalur termampat adalah kabur kerana kehilangan butiran spektrum, selalunya memerlukan pemprosesan pasca untuk meningkatkan harmonik. RNNoise dan PercepNet menggunakan penapis sikat untuk meningkatkan harmonik, tetapi disebabkan anggaran frekuensi asas dan pengiraan keuntungan penapis sikat dan penyahgandingan model, ia tidak boleh dioptimumkan dari hujung ke hujung DeepFilterNet menggunakan penapis domain frekuensi masa untuk menyekat hingar antara harmoni , tetapi tidak menggunakan maklumat frekuensi asas pertuturan secara eksplisit. Sebagai tindak balas kepada masalah di atas, pasukan mencadangkan kaedah peningkatan harmonik pertuturan berdasarkan penapis sikat yang boleh dipelajari Kaedah ini menggabungkan anggaran kekerapan asas dan penapisan sikat, dan keuntungan penapis sikat boleh dioptimumkan dari hujung ke hujung. Eksperimen menunjukkan bahawa kaedah ini boleh mencapai peningkatan harmonik yang lebih baik dengan jumlah pengiraan yang sama seperti kaedah sedia ada.

Struktur rangka kerja model

Penganggar frekuensi asas (Penganggar F0)

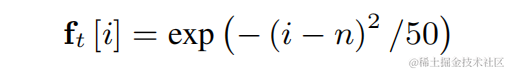

Untuk mengurangkan kesukaran anggaran frekuensi asas dan menjadikan keseluruhan pautan tamat -to-end Run, diskritkan julat frekuensi asas sasaran untuk dianggarkan kepada N frekuensi asas diskret, dan gunakan pengelas untuk menganggar. 1 dimensi ditambah untuk mewakili bingkai bukan bersuara, dan output model akhir ialah kebarangkalian dimensi N+1. Selaras dengan CREPE, pasukan menggunakan ciri lancar Gaussian sebagai sasaran latihan dan Binary Cross Entropy sebagai fungsi kehilangan: #

Penapis Sikat Boleh Dipelajari

Untuk setiap frekuensi asas diskret di atas, pasukan menggunakan penapis FIR yang serupa dengan PercepNet untuk penapisan sikat, yang boleh dinyatakan sebagai kereta nadi termodulat:

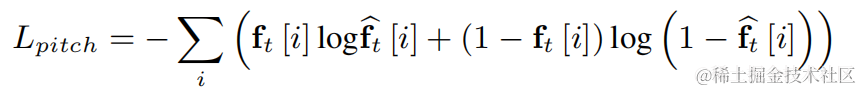

Gunakan lapisan lilitan dua dimensi (Conv2D) untuk mengira secara serentak hasil penapisan semua frekuensi asas diskret semasa latihan Berat lilitan dua dimensi boleh dinyatakan sebagai matriks dalam rajah di bawah dimensi, dan setiap dimensi digunakan Permulaan penapis di atas:

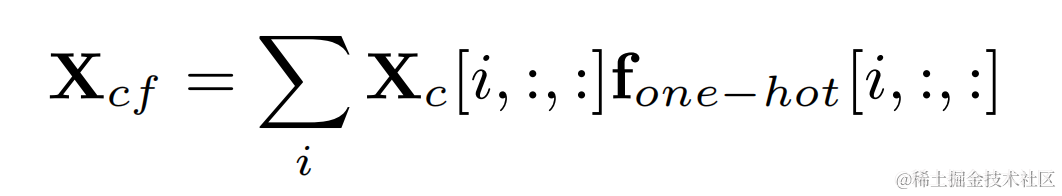

Darab label panas satu frekuensi asas sasaran dan output lilitan dua dimensi untuk mendapatkan hasil penapisan yang sepadan dengan frekuensi asas setiap bingkai :

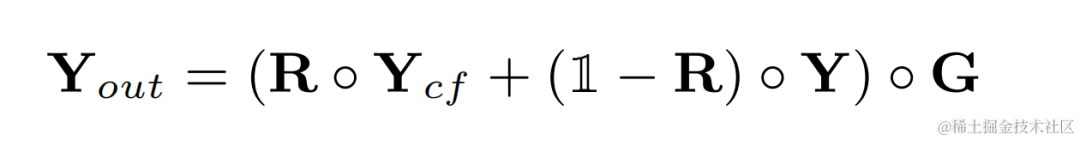

Audio selepas peningkatan harmonik Tambahkan berat audio asal dan darabkannya dengan keuntungan sub-jalur untuk mendapatkan output akhir:

Semasa inferens, setiap bingkai hanya perlu mengira hasil penapisan satu kekerapan asas, jadi kos pengiraan kaedah ini adalah rendah.

Struktur model

Pasukan menggunakan Dual-Path Convolutional Recurrent Network (DPCRN) sebagai tulang belakang model peningkatan pertuturan dan menambah penganggar frekuensi asas. Pengekod dan Penyahkod menggunakan lilitan boleh dipisahkan dalam untuk membentuk struktur simetri Penyahkod mempunyai dua cabang selari yang masing-masing mengeluarkan gain sub-jalur G dan pekali pemberat R. Input kepada penganggar frekuensi asas ialah keluaran modul DPRNN dan spektrum linear. Jumlah pengiraan model ini ialah kira-kira 300 M MAC, yang mana jumlah pengiraan penapisan sikat adalah kira-kira 0.53M MAC.

Latihan model

Dalam percubaan, set data cabaran VCTK-DEMAND dan DNS4 digunakan untuk latihan, dan kehilangan fungsi peningkatan pertuturan dan anggaran kekerapan asas digunakan untuk pembelajaran berbilang tugas.

Hasil eksperimen

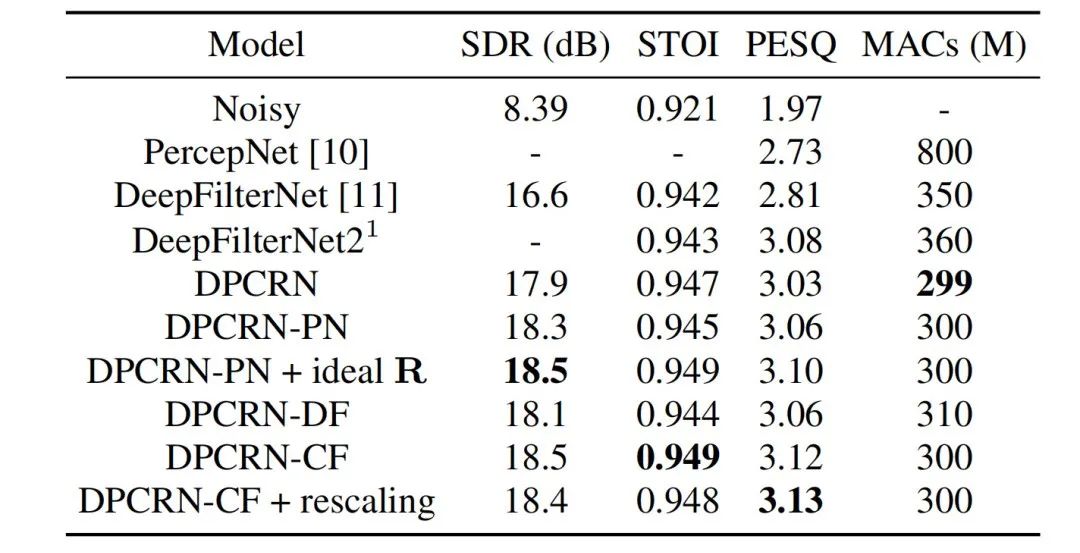

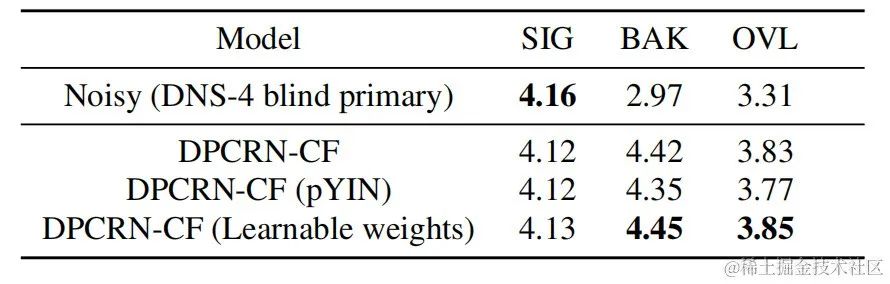

Pasukan audio penstriman membandingkan model penapis sikat yang boleh dipelajari dengan model yang menggunakan penapis sikat PercepNet dan algoritma penapis DeepFilterNet, masing-masing dipanggil DPCRN-CF dan DPCRN. Pada set ujian VCTK, kaedah yang dicadangkan dalam artikel ini menunjukkan kelebihan berbanding kaedah sedia ada.

Pada masa yang sama, pasukan menjalankan eksperimen ablasi mengenai anggaran kekerapan asas dan penapis yang boleh dipelajari. Keputusan eksperimen menunjukkan bahawa pembelajaran hujung ke hujung menghasilkan keputusan yang lebih baik daripada menggunakan algoritma penganggaran frekuensi asas berasaskan pemprosesan isyarat dan pemberat penapis.

Pengekod audio rangkaian neural hujung ke hujung berdasarkan Intra-BRNN dan GB-RVQ

Alamat kertas: https://www.isca-speech.org/archive/pdfs/interspeech_2023/xu23_inters

Latar Belakang

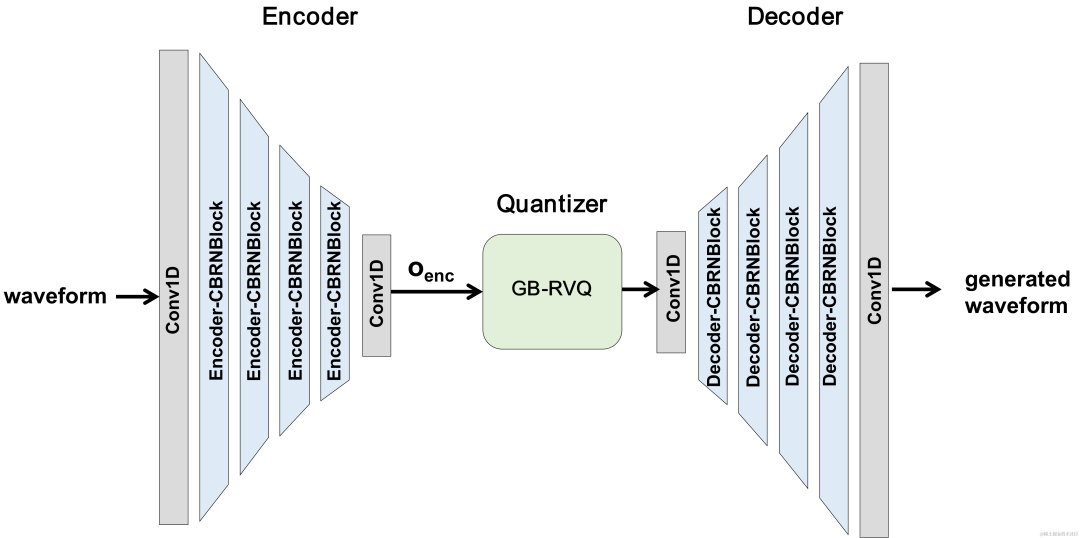

Dalam beberapa tahun kebelakangan ini, banyak model rangkaian saraf telah digunakan untuk tugas pengekodan pertuturan kadar bit rendah Walau bagaimanapun, sesetengah model hujung ke hujung gagal menggunakan sepenuhnya maklumat berkaitan dalam bingkai, dan pengkuantiti yang diperkenalkan mempunyai besar. ralat pengkuantitian, mengakibatkan kualiti audio pasca pengekodan. Untuk meningkatkan kualiti pengekod audio rangkaian saraf hujung ke hujung, pasukan audio penstriman mencadangkan codec pertuturan saraf hujung ke hujung, iaitu CBRC (Convolutional and Bidirectional Recurrent neural Codec). CBRC menggunakan struktur berjalin 1D-CNN (konvolusi satu dimensi) dan Intra-BRNN (rangkaian saraf berulang dwiarah dalam bingkai) untuk menggunakan korelasi intra bingkai dengan lebih berkesan. Di samping itu, pasukan menggunakan Kuantiti Vektor Baki Kumpulan dan Carian Pancaran (GB-RVQ) dalam CBRC untuk mengurangkan hingar pengkuantitian. CBRC mengekod audio 16kHz dengan panjang bingkai 20ms, tanpa kelewatan sistem tambahan, dan sesuai untuk senario komunikasi masa nyata. Keputusan eksperimen menunjukkan bahawa kualiti suara pengekodan CBRC dengan kadar bit 3kbps adalah lebih baik daripada Opus dengan 12kbps.

Struktur bingkai model

Struktur keseluruhan CBRC

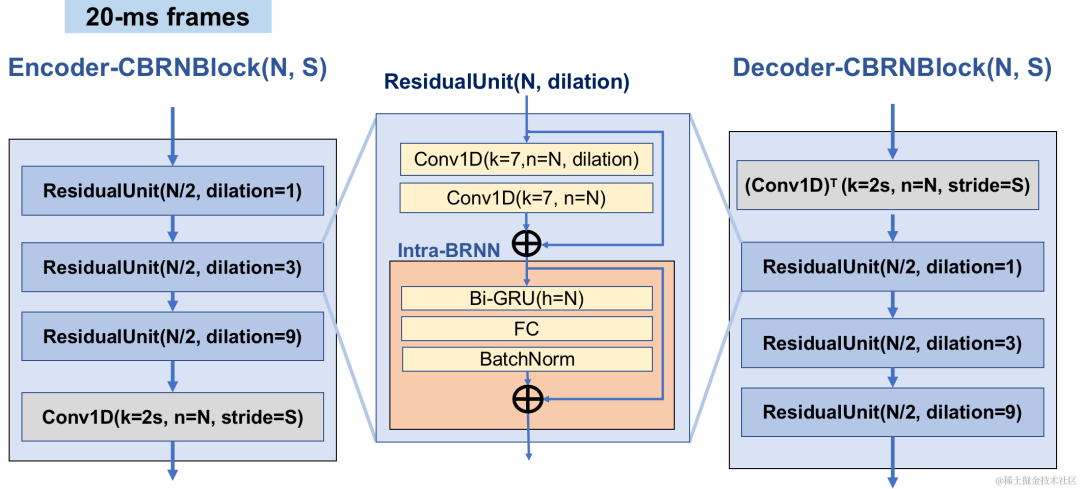

Encoder dan Dekoder struktur rangkaian

Encoder menggunakan 4 CBRNBlocks berlatarkan untuk mengekstrak ciri audio Setiap CBRNBlock terdiri daripada tiga Residual Unit yang mengekstrak ciri dan konvolusi satu dimensi yang mengawal kadar pensampelan. Setiap kali ciri dalam Pengekod diturunkan sampel, bilangan saluran ciri digandakan. ResidualUnit terdiri daripada modul konvolusi sisa dan rangkaian berulang dwiarah baki, di mana lapisan konvolusi menggunakan konvolusi sebab, manakala struktur GRU dwiarah dalam Intra-BRNN hanya memproses ciri audio dalam bingkai 20ms. Rangkaian Penyahkod ialah struktur cermin Pengekod, menggunakan lilitan transpos satu dimensi untuk pensampelan naik. Struktur berjalin 1D-CNN dan Intra-BRNN membolehkan Pengekod dan Penyahkod menggunakan sepenuhnya korelasi intra-bingkai audio 20ms tanpa memperkenalkan kelewatan tambahan.

CBRNBlock structure

Kumpulan dan #Quntizer carian sisa GB-R Vektor 🎜#

CBRC menggunakan Residual Vector Quantizer (RVQ) untuk mengukur dan memampatkan ciri keluaran rangkaian pengekodan kepada kadar bit yang ditentukan. RVQ menggunakan lata pengkuantiti vektor berbilang lapisan (VQ) untuk memampatkan ciri Setiap lapisan VQ mengkuantiskan baki pengkuantitian lapisan sebelumnya VQ, yang boleh mengurangkan dengan ketara jumlah parameter buku kod bagi satu lapisan VQ pada masa yang sama. kadar bit. Pasukan itu mencadangkan dua struktur pengkuantiti yang lebih baik dalam CBRC, iaitu RVQ mengikut kumpulan dan pengkuantiti vektor sisa carian pancaran (RVQ carian pancaran). Kuantiti Vektor Baki Kumpulan RVQ mengikut kumpulan

Beam-search RVQ #

#🎜##🎜##🎜#| #🎜## 🎜🎜#

|

# 🎜🎜#

RVQ mengikut kumpulan mengelompokkan output Pengekod, dan menggunakan RVQ terkumpul untuk mengkuantumkan ciri terkumpul secara bebas, dan kemudian keluaran terkuantisasi terkumpul disambungkan ke dalam Dekoder input. RVQ mengikut kumpulan menggunakan pengkuantitian kumpulan untuk mengurangkan parameter buku kod dan kerumitan pengiraan pengkuantiti, di samping mengurangkan kesukaran latihan CBRC hujung ke hujung dan dengan itu meningkatkan kualiti audio yang dikodkan CBRC.

Pasukan ini memperkenalkan RVQ carian Beam ke dalam latihan hujung ke hujung pengekod audio saraf, dan menggunakan algoritma carian Beam untuk memilih gabungan buku kod dengan ralat laluan kuantisasi terkecil dalam RVQ untuk mengurangkan ralat pengkuantitian pengkuantiti . Algoritma RVQ asal memilih buku kod dengan ralat terkecil dalam setiap lapisan pengkuantitian VQ sebagai output, tetapi gabungan buku kod optimum untuk setiap lapisan pengkuantitian VQ mungkin tidak semestinya gabungan buku kod yang optimum secara global. Pasukan ini menggunakan RVQ carian Beam untuk mengekalkan k laluan pengkuantitian optimum dalam setiap lapisan VQ berdasarkan kriteria ralat laluan pengkuantitian minimum, membolehkan pemilihan gabungan buku kod yang lebih baik dalam ruang carian pengkuantitian yang lebih besar dan mengurangkan ralat pengkuantitian.

#🎜🎜🎜##🎜🎜🎜##🎜🎜🎜 🎜#

|

|

Beam-search RV🎜 proses ringkas: #RVQ🎜 proses ringkas

|

1. Setiap lapisan VQ memasukkan laluan pengkuantitian calon bagi lapisan sebelumnya VQ, dan memperoleh laluan pengkuantitian calon.

2 Pilih laluan kuantisasi dengan ralat laluan kuantisasi terkecil daripada laluan kuantisasi calon sebagai output lapisan VQ semasa.

3 Pilih laluan dengan ralat laluan pengkuantitian terkecil dalam lapisan terakhir VQ sebagai output pengkuantiti.

|

#🎜🎜Latihan model

Dalam percubaan, 245 jam pertuturan 16kHz dalam set data LibriTTS digunakan untuk latihan, dan amplitud pertuturan didarab dengan perolehan rawak dan dimasukkan ke dalam model. Fungsi kehilangan dalam latihan terdiri daripada kerugian berskala pembinaan semula spektrum, kehilangan lawan diskriminasi dan kehilangan ciri, kehilangan pengkuantitian VQ dan kehilangan persepsi.

Hasil eksperimen

Skor subjektif dan objektif#🎜🎜 untuk menilai ucapan CB enco🎜#🎜 kualiti, satu set 10 perbandingan audio berbilang bahasa di mana codec audio lain dibandingkan. Untuk mengurangkan kesan kerumitan pengiraan, pasukan itu mereka bentuk CBRC-lite ringan, yang kerumitan pengiraannya lebih tinggi sedikit daripada Lyra-V2. Daripada hasil perbandingan pendengaran subjektif, dapat dilihat bahawa kualiti suara CBRC pada 3kbps melebihi Opus pada 12kbps dan juga melebihi Lyra-V2 pada 3.2kbps, yang menunjukkan keberkesanan kaedah yang dicadangkan. Sampel audio yang dikodkan CBRC disediakan di https://bytedance.feishu.cn/docx/OqtjdQNhZoAbNoxMuntcErcInmb.

| #OBJEKTIF🎜SKOR

Skor pendengaran subjektif |

| #🎜🎜🎜##🎜🎜🎜##🎜🎜🎜##🎜 #

|

Percubaan Ablasi

Pasukan mereka bentuk eksperimen ablasi untuk Intra-BRNN, RVQ mengikut Kumpulan dan RVQ carian Pancaran. Keputusan percubaan menunjukkan bahawa menggunakan Intra-BRNN dalam Pengekod dan Penyahkod boleh meningkatkan kualiti pertuturan dengan ketara. Di samping itu, pasukan mengira kekerapan penggunaan buku kod dalam RVQ dan mengira penyahkodan entropi untuk membandingkan kadar penggunaan buku kod di bawah struktur rangkaian yang berbeza. Berbanding dengan struktur konvolusi sepenuhnya, CBRC menggunakan Intra-BRNN meningkatkan potensi kadar bit pengekodan daripada 4.94kbps kepada 5.13kbps. Begitu juga, menggunakan RVQ berdasarkan Kumpulan dan RVQ carian Pancaran dalam CBRC boleh meningkatkan kualiti pertuturan yang dikodkan dengan ketara, dan berbanding dengan kerumitan pengiraan rangkaian saraf itu sendiri, peningkatan kerumitan yang dibawa oleh GB-RVQ hampir boleh diabaikan.

Contoh bunyi

Audio asal

arctic_a0023_16k, pasukan teknikal ByteDance 01_l_1 6k , pasukan teknikal ByteDance, 10 saat CBRC 3kbps

arctic_a0023_16k_CBRC_3kbps , Pasukan teknikal Bytedance, 5 saat es01_l_16k_CBRC_3kbps, pasukan teknikal Bytedance, 1kbps CBRC-lite 3kbps

arctic_a0023_16k_CBRC_lite_3kbps, Teknikal Bytedance pasukan, 5 saat

es01_l_16k_CBRC_lite_3kbps, Pasukan teknikal Bytedance, 10 saat

Kaedah pembatalan gema berdasarkan rangkaian neural progresif dua peringkat alamat Paperi.//Paperi: https://sca. /pdfs/interspeech_2023/chen23e_interspeech.pdfLatar Belakang Dalam sistem komunikasi bebas tangan, gema akustik ialah gangguan latar belakang yang menjengkelkan. Gema berlaku apabila isyarat hujung jauh dimainkan semula daripada pembesar suara dan kemudian dirakam oleh mikrofon hujung hampir. Pembatalan gema akustik (AEC) direka untuk menyekat gema yang tidak diingini yang diambil oleh mikrofon. Di dunia nyata, terdapat banyak aplikasi yang memerlukan pembatalan gema, seperti komunikasi masa nyata, bilik darjah pintar, sistem bebas tangan kenderaan dan sebagainya. Baru-baru ini, model AEC dipacu data yang menggunakan kaedah pembelajaran mendalam (DL) telah terbukti lebih teguh dan berkuasa. Kaedah ini merumuskan AEC sebagai masalah pembelajaran yang diselia, di mana fungsi pemetaan antara isyarat input dan isyarat sasaran proksimal dipelajari melalui rangkaian saraf dalam (DNN). Walau bagaimanapun, laluan gema sebenar adalah sangat kompleks, yang meletakkan keperluan yang lebih tinggi pada keupayaan pemodelan DNN. Untuk mengurangkan beban pemodelan rangkaian, kebanyakan kaedah AEC berasaskan DL sedia ada menggunakan modul pembatalan gema linear hadapan (LAEC) untuk menekan kebanyakan komponen linear gema. Walau bagaimanapun, modul LAEC mempunyai dua kelemahan: 1) LAEC yang tidak sesuai boleh menyebabkan beberapa herotan pertuturan hampir tamat, dan 2) proses penumpuan LAEC menjadikan prestasi penindasan gema linear tidak stabil. Memandangkan LAEC mengoptimumkan diri, kelemahan LAEC akan membawa beban pembelajaran tambahan kepada rangkaian saraf seterusnya. Untuk mengelakkan kesan LAEC dan mengekalkan kualiti suara hampir akhir yang lebih baik, kertas kerja ini meneroka model pemprosesan dua peringkat baharu berdasarkan DL hujung ke hujung dan mencadangkan butiran kasar (peringkat kasar) dan halus -berbutir Rangkaian saraf lata dua peringkat halus (TSPNN) digunakan untuk tugas pembatalan gema. Sebilangan besar keputusan eksperimen menunjukkan bahawa kaedah pembatalan gema dua peringkat yang dicadangkan boleh mencapai prestasi yang lebih baik daripada kaedah arus perdana yang lain. Struktur rangka kerja modelSeperti yang ditunjukkan dalam rajah di bawah, TSPNN terutamanya terdiri daripada tiga bahagian: modul pampasan kelewatan masa (TDC), modul pemprosesan berbutir kasar (peringkat kasar) dan modul pemprosesan berbutir halus (peringkat halus) . TDC bertanggungjawab untuk menjajarkan isyarat rujukan hujung jauh (ref) dan isyarat mikrofon hujung hampir (mik), yang bermanfaat kepada penumpuan model seterusnya. Peringkat kasar bertanggungjawab untuk mengeluarkan kebanyakan gema dan hingar daripada mikrofon, dengan banyak mengurangkan beban pembelajaran model dalam peringkat peringkat halus berikutnya. Pada masa yang sama, peringkat kasar menggabungkan tugas Pengesanan Aktiviti Suara (VAD) untuk pembelajaran berbilang tugas untuk mengukuhkan persepsi model terhadap pertuturan hampir akhir dan mengurangkan kerosakan pada pertuturan hampir akhir. Peringkat halus bertanggungjawab untuk menghapuskan lagi gema dan hingar sisa, dan menggabungkan maklumat titik frekuensi jiran untuk membina semula isyarat sasaran yang hampir tamat dengan lebih baik.

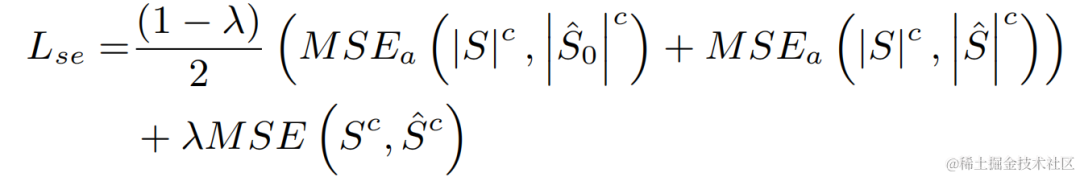

Untuk mengelakkan penyelesaian suboptimum yang disebabkan oleh mengoptimumkan model setiap peringkat secara bebas, artikel ini menggunakan bentuk pengoptimuman lata untuk mengoptimumkan peringkat kasar dan peringkat halus secara serentak, sambil melonggarkan kekangan pada peringkat kasar untuk mengelakkan masalah. kepada kerosakan pertuturan yang hampir berakhir. Di samping itu, untuk membolehkan model mempunyai keupayaan untuk melihat pertuturan hampir akhir, ciptaan ini memperkenalkan tugas VAD untuk pembelajaran berbilang tugas, dan menambah Kehilangan VAD pada fungsi kehilangan. Fungsi kehilangan akhir ialah:

di mana mewakili spektrum kompleks isyarat hampir hujung sasaran, spektrum kompleks isyarat hampir hujung yang dianggarkan dan peringkat halus masing-masing mewakili keadaan aktif pertuturan hujung yang dianggarkan mengikut peringkat kasar , pertuturan hampir hujung masing-masing Label pengesanan aktiviti ialah skalar kawalan, terutamanya digunakan untuk melaraskan tahap perhatian kepada peringkat yang berbeza dalam fasa latihan. Ciptaan sekarang mengehadkan untuk melonggarkan kekangan pada peringkat kasar dan berkesan mengelakkan kerosakan pada hujung proksimal peringkat kasar.

Hasil eksperimen

Data eksperimen

Sistem pembatalan gema dua peringkat yang dicadangkan oleh pasukan audio penstriman Volcano Engine juga telah dibandingkan dengan kaedah lain Hasil eksperimen menunjukkan bahawa sistem yang dicadangkan boleh mencapai hasil yang lebih baik daripada kaedah arus perdana yang lain. Contoh-contoh spesifik

Hasil eksperimental GitHub Pautan: https://github.com/enhancer12/tspnnnndual Speaking Scene Prestasi: Hasil eksperimental GitHub Pautan: https://github.com/enhancer12/tspnnnndual Speaking Scene Prestasi:

- chime-7 Tanpa Pengawasan Tinjauan Adaptif Domain (Udase) Penyelesaian Challenge Champion

- Alamat kertas: https://www.chimechallenge.org/current/task2/documents/Zhang_NB.pdf

Latar Belakang: Dalam beberapa tahun kebelakangan ini, dengan pembangunan rangkaian saraf dan pembelajaran mendalam berasaskan data Dengan pembangunan teknologi, penyelidikan tentang teknologi peningkatan pertuturan telah beransur-ansur beralih kepada kaedah berdasarkan pembelajaran mendalam, dan semakin banyak model peningkatan pertuturan berdasarkan rangkaian saraf dalam telah dicadangkan. Walau bagaimanapun, kebanyakan model ini adalah berdasarkan pembelajaran diselia dan memerlukan sejumlah besar data berpasangan untuk latihan. Walau bagaimanapun, dalam senario sebenar, adalah mustahil untuk menangkap pertuturan secara serentak dalam adegan bising dan tag pertuturan bersih yang dipasangkan tanpa gangguan Simulasi data biasanya digunakan untuk mengumpul pertuturan bersih dan pelbagai bunyi secara berasingan, dan kemudian menggabungkannya mengikut isyarat tertentu - nisbah hingar bercampur untuk menghasilkan frekuensi bising. Ini membawa kepada ketidakpadanan antara senario latihan dan senario aplikasi sebenar, dan prestasi model merosot dalam aplikasi sebenar. Untuk menyelesaikan masalah ketidakpadanan domain di atas dengan lebih baik, teknologi peningkatan pertuturan tanpa pengawasan dan penyeliaan sendiri dicadangkan menggunakan sejumlah besar data tidak berlabel dalam adegan sebenar. CHiME Challenge Track 2 bertujuan untuk menggunakan data tidak berlabel untuk mengatasi masalah kemerosotan prestasi model peningkatan pertuturan yang dilatih pada data berlabel yang dijana secara buatan disebabkan oleh ketidakpadanan antara data latihan dan senario aplikasi sebenar Fokus kajian adalah cara menggunakan sasaran The unlabelled data domain dan data berlabel di luar set digunakan untuk meningkatkan hasil peningkatan domain sasaran. Struktur rangka kerja model:

Carta alir sistem peningkatan pertuturan adaptif domain tanpa pengawasan

Seperti yang ditunjukkan dalam rajah di atas, rangka kerja yang dicadangkan ialah rangkaian guru-murid. Mula-mula, gunakan pengesanan aktiviti suara, UNA-GAN, respons impuls bilik simulasi, hingar dinamik dan teknologi lain pada data dalam domain untuk menjana set data berlabel yang paling hampir dengan domain sasaran dan pralatih rangkaian pengurangan hingar guru Uformer+ pada set data berlabel di luar domain . Kemudian, rangka kerja ini digunakan untuk mengemas kini rangkaian pelajar pada data tidak berlabel dalam domain, iaitu rangkaian guru pra-latihan digunakan untuk menganggarkan pertuturan dan bunyi yang bersih sebagai label pseudo daripada audio yang bising, dan ia dicampur semula secara rawak pesanan sebagai input data latihan kepada rangkaian pelajar Latihan diselia rangkaian pelajar menggunakan pseudo-label. Skor kualiti pertuturan bersih yang dijana oleh rangkaian pelajar dianggarkan menggunakan diskriminator MetricGAN yang telah terlatih dan kerugian dikira dengan skor tertinggi untuk membimbing rangkaian pelajar menjana audio bersih berkualiti tinggi. Selepas setiap langkah latihan, parameter rangkaian pelajar dikemas kini kepada rangkaian guru dengan berat tertentu untuk mendapatkan label pseudo pembelajaran yang diselia dengan kualiti yang lebih tinggi, dan sebagainya.

Rangkaian Ufomer+ Uformer+ ditambah baik dengan menambahkan MetricGAN berdasarkan rangkaian Uformer. Uformer ialah rangkaian penukar dua laluan nombor nyata yang kompleks berdasarkan struktur Unet Ia mempunyai dua cabang selari, cawangan spektrum amplitud dan cawangan spektrum kompleks Struktur rangkaian ditunjukkan dalam rajah di bawah. Cawangan amplitud digunakan untuk fungsi penindasan hingar utama dan boleh menahan kebanyakan bunyi dengan berkesan. Cawangan kompleks berfungsi sebagai tambahan untuk mengimbangi kerugian seperti perincian spektrum dan sisihan fasa. Idea utama MetricGAN ialah menggunakan rangkaian saraf untuk mensimulasikan penunjuk penilaian kualiti pertuturan yang tidak boleh dibezakan supaya ia boleh digunakan dalam latihan rangkaian untuk mengurangkan ralat yang disebabkan oleh penunjuk penilaian yang tidak konsisten semasa latihan dan aplikasi sebenar. Di sini pasukan menggunakan Penilaian Kualiti Pertuturan Persepsi (PESQ) sebagai sasaran untuk anggaran rangkaian MetricGAN. . untuk menyahkod audio bising dalam domain Menganggar bunyi dan pertuturan. Seterusnya, susunan bunyi dan pertuturan yang dianggarkan dikacau dalam kelompok yang sama, dan bunyi dan pertuturan dicampur semula dalam susunan yang dikacau menjadi audio yang bising, yang digunakan sebagai input untuk melatih rangkaian pelajar. Kebisingan dan pertuturan yang dianggarkan oleh rangkaian guru sebagai label pseudo. Rangkaian pelajar menyahkod audio bising campuran semula, menganggarkan bunyi dan pertuturan, mengira kerugian dengan label pseudo dan mengemas kini parameter rangkaian pelajar. Pertuturan yang dianggarkan oleh rangkaian pelajar dimasukkan ke dalam diskriminator MetricGAN yang telah terlatih untuk meramalkan PESQ, dan kerugian dikira dengan nilai maksimum PESQ untuk mengemas kini parameter rangkaian pelajar.

Selepas semua data latihan melengkapkan satu lelaran, parameter rangkaian guru dikemas kini mengikut formula berikut:, di manakah parameter pusingan K- latihan rangkaian guru, Selepas semua data latihan melengkapkan satu lelaran, parameter rangkaian guru dikemas kini mengikut formula berikut:, di manakah parameter pusingan K- latihan rangkaian guru,

ialah parameter K- pusingan ke- rangkaian pelajar. Iaitu, parameter rangkaian pelajar ditambah pada rangkaian guru dengan berat tertentu.

Kaedah penambahan data UNA-GAN

Gambar rajah struktur UNA-GAN

Rangkaian penambahan data penyesuaian hingar tanpa pengawasan UNA-GAN ialah model penjanaan audio bising berdasarkan rangkaian adversarial generatif. Tujuannya adalah untuk menukar secara langsung pertuturan bersih kepada audio bising dengan hingar intra-domain dengan hanya menggunakan audio bising dalam domain apabila data hingar bebas tidak dapat diperoleh. Penjana memasukkan pertuturan bersih dan mengeluarkan simulasi audio bising. Diskriminator memasukkan audio bising yang dijana atau audio bising sebenar dalam domain dan menentukan sama ada audio input datang daripada pemandangan sebenar atau dijana melalui simulasi. Diskriminator terutamanya membezakan sumber berdasarkan taburan bunyi latar belakang, dan dalam proses ini, pertuturan manusia dianggap sebagai maklumat tidak sah. Dengan melakukan proses latihan permusuhan di atas, penjana cuba menambah hingar dalam domain terus ke audio bersih input untuk mengelirukan diskriminator cuba membezakan sumber audio bising. Untuk mengelakkan penjana menambahkan terlalu banyak bunyi, menutup pertuturan manusia dalam audio input, pembelajaran kontrastif digunakan. Sampel 256 blok pada kedudukan yang sepadan dengan audio bising yang dihasilkan dan pertuturan bersih input. Gandingan blok pada kedudukan yang sama dianggap sebagai contoh positif, dan pasangan blok pada kedudukan yang berbeza dianggap sebagai contoh negatif. Kira kehilangan entropi silang menggunakan contoh positif dan negatif.  Hasil eksperimen Hasil eksperimen

Hasilnya menunjukkan bahawa Uformer+ yang dicadangkan mempunyai prestasi yang lebih kuat daripada garis dasar Sudo rm-rf, dan kaedah penambahan data UNA-GAN juga mempunyai keupayaan untuk menjana audio bising dalam domain. Rangka kerja penyesuaian domain RemixIT garis dasar telah mencapai peningkatan yang hebat dalam SI-SDR, tetapi mempunyai prestasi yang lemah pada DNS-MOS. Pembaikan RemixIT-G yang dicadangkan oleh pasukan telah mencapai peningkatan yang berkesan dalam kedua-dua penunjuk pada masa yang sama, dan mencapai skor MOS pendengaran subjektif tertinggi dalam set ujian buta pertandingan. Keputusan ujian pendengaran akhir ditunjukkan dalam rajah di bawah.

Ringkasan dan TinjauanDi atas memperkenalkan beberapa penyelesaian dan kesan yang dibuat oleh Pasukan Audio Penstriman Enjin Volcano berdasarkan pembelajaran mendalam ke arah pengurangan hingar khusus pembesar suara, pengekod AI, pembatalan gema dan peningkatan pertuturan adaptif tanpa pengawasan. , senario masa depan masih menghadapi cabaran dalam pelbagai arah, seperti cara menggunakan dan menjalankan model ringan dan kerumitan rendah pada pelbagai terminal dan keteguhan kesan berbilang peranti Cabaran ini juga akan menjadi tumpuan pasukan audio penstriman pada masa hadapan Arah penyelidikan.

|

|

|

Atas ialah kandungan terperinci Interspeech 2023 |. Penstriman Enjin Gunung Berapi Peningkatan Pertuturan dan Pengekodan Audio AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah motor servo

Apakah motor servo

Pengenalan kepada kaedah diagnostik SEO

Pengenalan kepada kaedah diagnostik SEO

Apakah yang termasuk storan penyulitan data?

Apakah yang termasuk storan penyulitan data?

Apakah perbezaan utama antara linux dan windows

Apakah perbezaan utama antara linux dan windows

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Bagaimana untuk membuka fail mds

Bagaimana untuk membuka fail mds

Tukar warna latar belakang perkataan kepada putih

Tukar warna latar belakang perkataan kepada putih

Apakah alat pembangunan?

Apakah alat pembangunan?