Tidak syak lagi bahawa AIGC membawa perubahan yang mendalam kepada masyarakat manusia.

Tanpa penampilannya yang mempesonakan dan cantik, teras operasi tidak boleh dipisahkan daripada sokongan data besar-besaran.

"pencerobohan" ChatGPT telah menyebabkan kebimbangan mengenai plagiarisme kandungan dalam semua bidang kehidupan, serta meningkatkan kesedaran tentang keselamatan data rangkaian.

Walaupun teknologi AI adalah neutral, ia tidak menjadi alasan untuk mengelakkan tanggungjawab dan kewajipan.

Baru-baru ini, agensi perisikan British, Ibu Pejabat Komunikasi Kerajaan (GCHQ), memberi amaran bahawa ChatGPT dan chatbot kecerdasan buatan lain akan menjadi ancaman keselamatan baharu.

Walaupun konsep ChatGPT tidak wujud sejak sekian lama, ancaman terhadap keselamatan rangkaian dan keselamatan data telah menjadi tumpuan perhatian dalam industri.

Adakah kebimbangan sebegitu tentang ChatGPT, yang masih dalam peringkat awal pembangunan, tidak berasas?

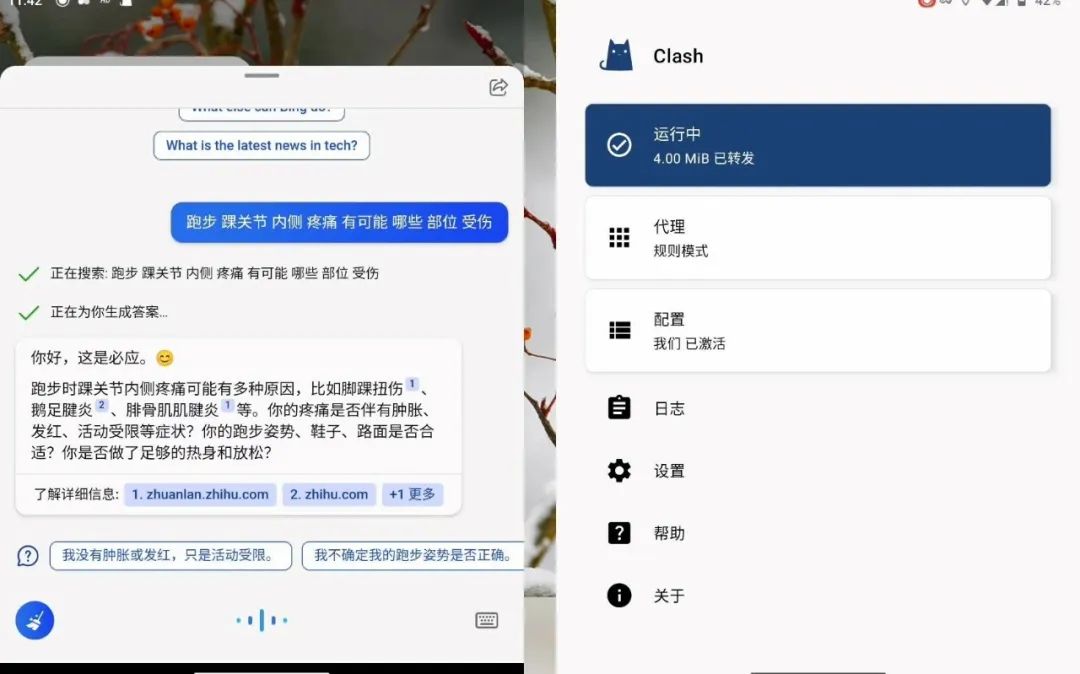

Pada penghujung tahun lepas, OpenAI pemula melancarkan ChatGPT Selepas itu, pelaburnya Microsoft melancarkan chatbot berasaskan teknologi ChatGPT ini tahun." Bing Chat".

Oleh kerana perisian jenis ini boleh menyediakan perbualan seperti manusia, perkhidmatan ini telah menjadi popular di seluruh dunia.

Cabang keselamatan siber GCHQ menunjukkan bahawa syarikat yang menyediakan chatbot AI boleh melihat kandungan pertanyaan yang dimasukkan oleh pengguna kerana ChatGPT bimbang, pembangunnya OpenAI boleh melihat ini.

ChatGPT dilatih melalui sejumlah besar korpora teks, dan keupayaan pembelajaran mendalamnya sangat bergantung pada data di belakangnya.

Disebabkan kebimbangan mengenai kebocoran maklumat, banyak syarikat dan institusi telah mengeluarkan "larangan ChatGPT".

Firma guaman City of London, Mishcon de Reya telah melarang peguamnya daripada memasukkan data pelanggan ke dalam ChatGPT atas kebimbangan bahawa maklumat istimewa yang sah boleh dibocorkan.

Firma perunding antarabangsa Accenture telah memberi amaran kepada 700,000 pekerjanya di seluruh dunia supaya tidak menggunakan ChatGPT atas sebab yang sama, kerana bimbang data pelanggan sulit akan berakhir di tangan yang salah.

Kumpulan SoftBank Jepun, syarikat induk syarikat cip komputer Britain Arm, turut memberi amaran kepada pekerjanya supaya tidak memasukkan maklumat identiti kakitangan syarikat atau data sulit ke dalam bot sembang kecerdasan buatan.

Pada Februari tahun ini, JPMorgan Chase menjadi bank pelaburan Wall Street pertama yang menyekat penggunaan ChatGPT di tempat kerja.

Citigroup dan Goldman Sachs mengikutinya, dengan bekas pekerja melarang akses seluruh syarikat kepada ChatGPT dan yang kedua menyekat pekerja daripada menggunakan produk di tingkat dagangan.

Terdahulu, untuk mengelakkan pekerja membocorkan rahsia apabila menggunakan ChatGPT, Amazon dan Microsoft melarang mereka daripada berkongsi data sensitif dengan mereka, kerana maklumat ini mungkin digunakan untuk meneruskan data latihan Berulang.

Malah, di sebalik bot sembang kecerdasan buatan ini terdapat model bahasa besar (LLM), dan kandungan pertanyaan pengguna akan disimpan dan digunakan pada satu ketika pada masa hadapan Membangunkan perkhidmatan atau model LLM.

Ini bermakna penyedia LLM akan dapat membaca pertanyaan berkaitan dan mungkin memasukkannya ke dalam keluaran masa hadapan dalam beberapa cara.

Walaupun pengendali LLM perlu mengambil langkah untuk melindungi data, kemungkinan akses tanpa kebenaran tidak boleh diketepikan sepenuhnya. Oleh itu, perusahaan perlu memastikan bahawa mereka mempunyai dasar yang ketat dan menyediakan sokongan teknikal untuk memantau penggunaan LLM bagi meminimumkan risiko pendedahan data.

Selain itu, walaupun ChatGPT sendiri tidak mempunyai keupayaan untuk menyerang secara langsung keselamatan rangkaian dan keselamatan data, kerana keupayaannya menjana dan memahami bahasa semula jadi, ia boleh digunakan untuk memalsukan maklumat palsu, menyerang kejuruteraan sosial, dll.

Selain itu, penyerang juga boleh menggunakan bahasa semula jadi untuk membenarkan ChatGPT menjana kod serangan, kod perisian hasad, spam, dsb.

Oleh itu, AI boleh membenarkan mereka yang tidak mempunyai keupayaan untuk melancarkan serangan untuk menjana serangan berdasarkan AI, dan meningkatkan kadar kejayaan serangan dengan banyak.

Dengan sokongan automasi, AI, "serangan sebagai perkhidmatan" dan teknologi serta model lain, serangan keselamatan rangkaian menunjukkan arah aliran yang meroket.

Sebelum ChatGPT menjadi popular, terdapat banyak serangan siber oleh penggodam menggunakan teknologi AI.

Sebenarnya, kepintaran buatan adalah perkara biasa "dipesongkan daripada irama" oleh pengguna Enam tahun lalu, Microsoft melancarkan robot sembang pintar Tay. Tay berkelakuan sopan, tetapi dalam masa kurang daripada 24 jam, dia "dipimpin buruk" oleh pengguna yang tidak bertanggungjawab Dia mengeluarkan kata-kata kasar dan kotor, malah melibatkan perkauman, pornografi, dan Nazi , dan terpaksa dibawa ke luar talian untuk menamatkan hayatnya yang singkat.

Sebaliknya, risiko yang lebih dekat dengan pengguna ialah apabila menggunakan alatan AI seperti ChatGPT, pengguna mungkin secara tidak sengaja memasukkan data peribadi ke dalam model awan, dan data ini mungkin menjadi latihan Data juga boleh menjadi sebahagian daripada jawapan yang diberikan kepada orang lain, yang membawa kepada pelanggaran data dan risiko pematuhan.

Sebagai model bahasa yang besar, logik teras ChatGPT sebenarnya ialah pengumpulan, pemprosesan dan Pemprosesan dan output hasil operasi.

Secara amnya, pautan ini mungkin dikaitkan dengan risiko dalam tiga aspek: elemen teknikal, pengurusan organisasi dan kandungan digital.

Walaupun ChatGPT menyatakan bahawa ia akan mematuhi sepenuhnya dasar privasi dan keselamatan apabila menyimpan data yang diperlukan untuk latihan dan model yang dijalankan, masih terdapat masalah seperti serangan rangkaian dan merangkak data yang mungkin berlaku pada masa hadapan diabaikan risiko keselamatan data.

Terutama apabila melibatkan penangkapan, pemprosesan dan penggunaan gabungan data teras negara, data tempatan dan industri yang penting serta data privasi peribadi, adalah perlu untuk mengimbangi perlindungan dan aliran keselamatan data perkongsian.

Selain bahaya tersembunyi data dan kebocoran privasi, teknologi AI juga mempunyai masalah seperti bias data, maklumat palsu dan kesukaran dalam mentafsir model, yang boleh menyebabkan salah faham dan tidak percaya .

Arah aliran telah tiba, dan gelombang AIGC akan datang dengan latar belakang prospek yang menjanjikan, adalah juga penting untuk bergerak ke hadapan dan mewujudkan dinding perlindungan keselamatan data.

Terutama apabila teknologi AI bertambah baik secara beransur-ansur, ia boleh menjadi alat yang berkuasa untuk peningkatan produktiviti, tetapi ia juga boleh menjadi alat untuk jenayah haram dengan mudah.

Data pemantauan daripada Pusat Perisikan Ancaman QiAnxin menunjukkan bahawa dari Januari hingga Oktober 2022, lebih 95 bilion keping data institusi China telah didagangkan secara haram di luar negara, yang mana lebih 57 bilion keping adalah peribadi maklumat.

Oleh itu, cara memastikan keselamatan penyimpanan, pengiraan, dan peredaran data adalah prasyarat untuk pembangunan ekonomi digital.

Dari perspektif keseluruhan, reka bentuk peringkat atasan dan pembangunan industri harus ditegaskan untuk berjalan seiringan Berdasarkan Undang-undang Keselamatan Siber, sistem analisis risiko dan tanggungjawab harus diperhalusi dan mekanisme akauntabiliti keselamatan harus diwujudkan.

Pada masa yang sama, pihak berkuasa kawal selia boleh menjalankan pemeriksaan tetap, dan syarikat dalam bidang keselamatan boleh bekerjasama untuk membina sistem keselamatan data proses penuh.

Untuk isu pematuhan data dan keselamatan data, terutamanya selepas pengenalan "Undang-undang Keselamatan Data", privasi data menjadi semakin penting.

Jika keselamatan dan pematuhan data tidak dapat dijamin semasa penggunaan teknologi AI, ia boleh menyebabkan risiko besar kepada perusahaan.

Terutamanya perusahaan kecil dan sederhana mempunyai kekurangan pengetahuan tentang privasi dan keselamatan data, serta tidak tahu cara melindungi data daripada ancaman keselamatan.

Pematuhan keselamatan data bukanlah perkara untuk jabatan tertentu, tetapi perkara paling penting untuk keseluruhan perusahaan.

Perusahaan harus melatih pekerja untuk menyedarkan mereka bahawa setiap orang yang menggunakan data mempunyai kewajipan untuk melindungi data, termasuk kakitangan IT, jabatan AI, jurutera data, pembangun, pengguna Melaporkan orang, orang dan teknologi perlu disepadukan.

Menghadapi potensi risiko yang dinyatakan di atas, bagaimanakah pengawal selia dan syarikat yang berkaitan boleh mengukuhkan perlindungan keselamatan data dalam bidang AIGC dari peringkat institusi dan teknikal?

Berbanding dengan mengambil langkah pengawalseliaan seperti menyekat penggunaan terminal pengguna secara langsung, adalah lebih berkesan untuk dengan jelas menghendaki syarikat penyelidikan dan pembangunan teknologi AI mematuhi prinsip etika saintifik dan teknologi, kerana syarikat ini boleh mengehadkan pengguna pada skop penggunaan peringkat teknikal.

Di peringkat institusi, adalah perlu untuk mewujudkan dan menambah baik klasifikasi data dan sistem perlindungan hierarki berdasarkan ciri dan fungsi data yang diperlukan oleh teknologi asas AIGC.

Sebagai contoh, data dalam set data latihan boleh dikelaskan dan diuruskan mengikut subjek data, tahap pemprosesan data, atribut hak data, dsb., mengikut nilai data kepada subjek hak data, dan setelah data itu Kelaskan tahap bahaya kepada subjek data jika ia telah diusik, dimusnahkan, dsb.

Berdasarkan klasifikasi dan klasifikasi data, wujudkan piawaian perlindungan data dan mekanisme perkongsian yang sepadan dengan jenis data dan tahap keselamatan.

Memfokuskan kepada perusahaan, ia juga perlu untuk mempercepatkan aplikasi teknologi "pengkomputeran persendirian" dalam bidang AIGC.

Jenis teknologi ini membenarkan berbilang pemilik data berkongsi, saling beroperasi dan mengira data dengan berkongsi SDK atau membuka kebenaran SDK tanpa mendedahkan data itu sendiri , pemodelan, sambil memastikan AIGC boleh menyediakan perkhidmatan seperti biasa, sambil memastikan data tidak dibocorkan kepada peserta lain.

Selain itu, kepentingan pengurusan pematuhan proses penuh telah menjadi semakin menonjol.

Perusahaan harus terlebih dahulu memberi perhatian kepada sama ada sumber data yang mereka gunakan mematuhi keperluan undang-undang dan kawal selia penyelidikan dan pembangunan perusahaan juga harus memaksimumkan Memenuhi jangkaan etika orang ramai.

Pada masa yang sama, perusahaan harus merumuskan piawaian pengurusan dalaman dan menubuhkan jabatan penyeliaan yang berkaitan untuk menyelia data dalam semua aspek senario aplikasi teknologi AI untuk memastikan sumber data adalah sah, pemprosesan adalah sah, dan output adalah sah Ini memastikan pematuhannya sendiri.

Kunci kepada aplikasi AI terletak pada pertimbangan antara kaedah penggunaan dan kos, tetapi perlu diingat bahawa jika pematuhan keselamatan dan perlindungan privasi tidak dilakukan dengan baik, ia mungkin mempunyai "" A titik risiko yang lebih besar.”

AI ialah pedang bermata dua Jika digunakan dengan baik, perusahaan akan menjadi lebih berkuasa jika digunakan secara tidak wajar, mengabaikan keselamatan, privasi dan pematuhan akan membawa kerugian yang lebih besar kepada perusahaan.

Oleh itu, sebelum AI boleh digunakan, adalah perlu untuk membina "data base" yang lebih stabil Bak kata pepatah, hanya kestabilan yang boleh membawa kepada kemajuan jangka panjang.

Atas ialah kandungan terperinci Aplikasi ChatGPT sedang berkembang pesat Di mana untuk mencari pangkalan data besar yang selamat?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah empat alat analisis data besar?

Apakah empat alat analisis data besar?

Aplikasi kecerdasan buatan dalam kehidupan

Aplikasi kecerdasan buatan dalam kehidupan

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Apakah konsep asas kecerdasan buatan

Apakah konsep asas kecerdasan buatan

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Adakah OS Hongmeng dikira sebagai Android?

Adakah OS Hongmeng dikira sebagai Android?