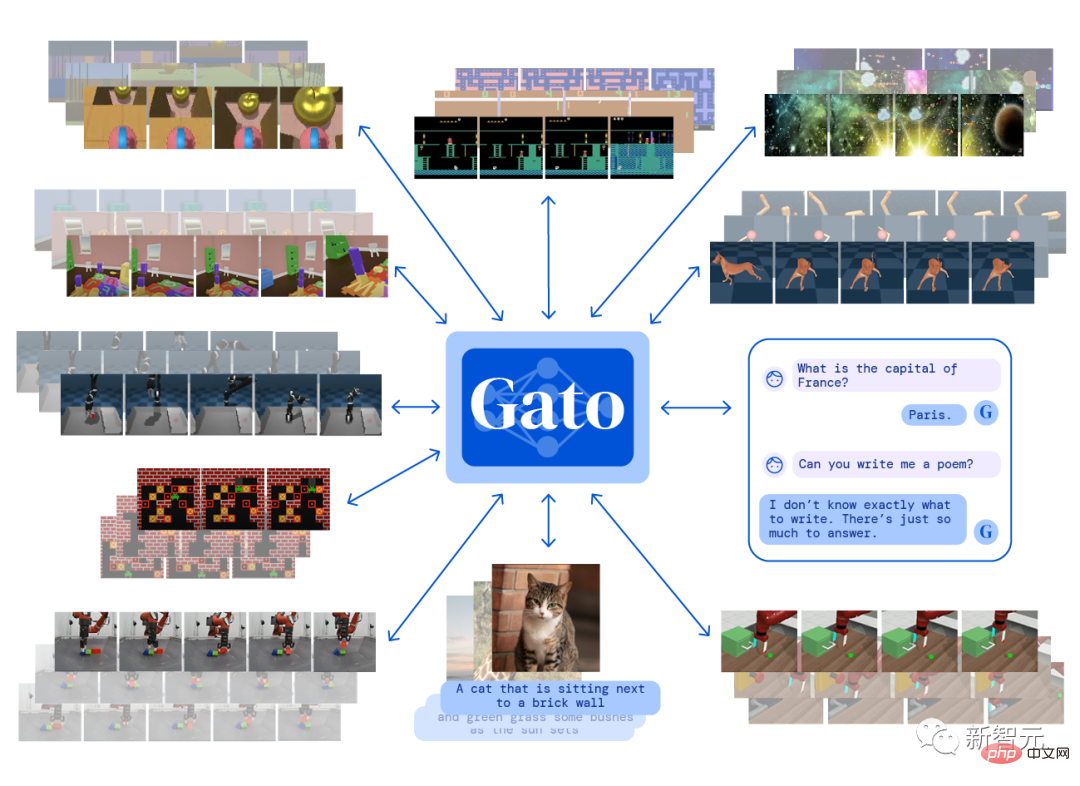

Pada bulan Mei tahun ini, DeepMind mengeluarkan Gato, sistem kecerdasan buatan pelbagai mod yang boleh melaksanakan lebih daripada 600 tugas berbeza pada masa yang sama dengan hanya satu set parameter model, yang buat sementara waktu membangkitkan perbincangan hangat tentang kecerdasan buatan am (AGI). ) dalam industri.

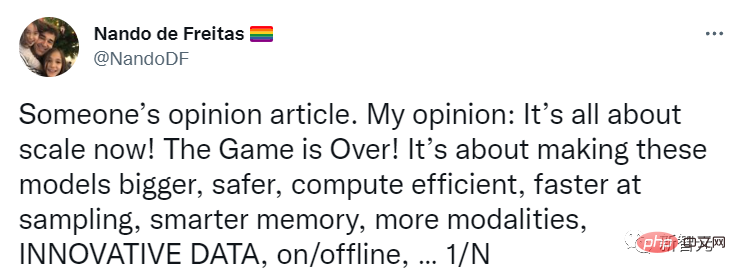

Nando de Freitas, pengarah penyelidikan di DeepMind, juga tweet pada masa bahawa AI boleh diluluskan selagi skala terus meningkat!

Apa yang perlu kita lakukan ialah menjadikan model lebih besar, lebih selamat, lebih cekap dari segi pengiraan, pensampelan lebih pantas, storan lebih bijak, lebih banyak modaliti, pada Inovasi data, dalam talian/luar talian, dll.

AGI boleh dicapai dengan menyelesaikan masalah skala Industri perlu memberi perhatian lebih kepada isu ini!

Baru-baru ini, Gary Marcus, seorang sarjana AI yang terkenal, pengasas dan Ketua Pegawai Eksekutif Robust.AI, dan profesor emeritus Universiti New York, menerbitkan blog lain, percaya bahawa kenyataan ini "terlalu awal" dan telah pun bermula Terdapat krisis!

Marcus terus memberi perhatian kepada pembangunan industri AI, tetapi mengkritik gembar-gembur AI Dia telah menyatakan bantahan seperti "pembelajaran mendalam mengenai dinding" dan "GPT-3 sepenuhnya tidak bermakna".

Nando percaya bahawa kecerdasan buatan tidak memerlukan anjakan paradigma, ia hanya memerlukan lebih banyak data, kecekapan yang lebih tinggi dan pelayan yang lebih besar.

Marcus menghuraikan hipotesis ini sebagai: Tanpa inovasi baharu yang asas, AGI mungkin muncul daripada model berskala lebih besar. Andaian ini juga boleh dipanggil scaling-über-alles.

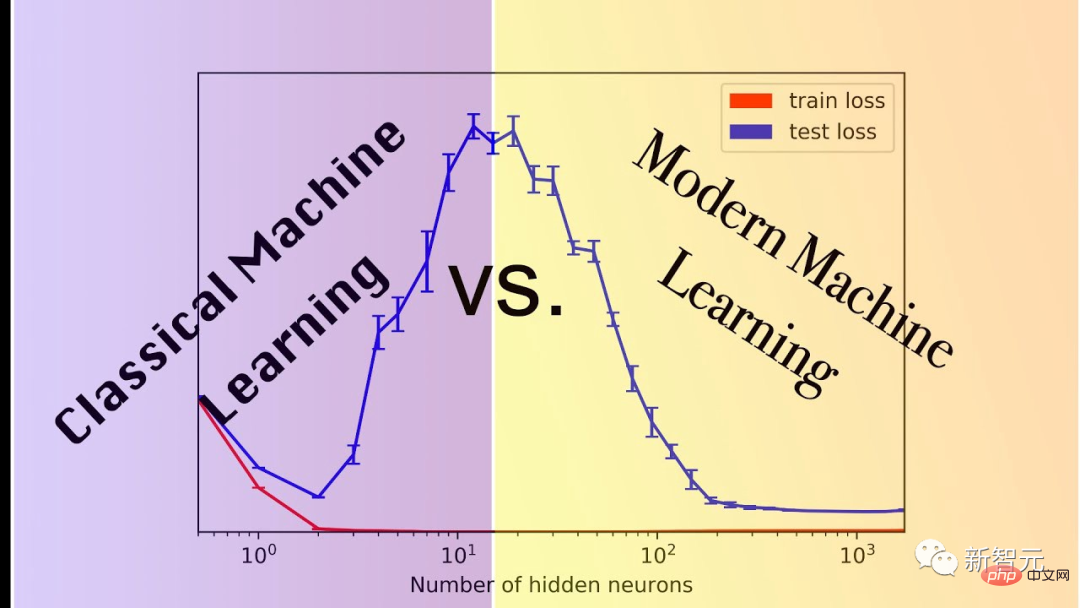

Hipotesisnya, yang kini sering dirujuk sebagai skala maksimum, kekal sangat popular, sebahagian besarnya kerana model yang lebih besar dan lebih besar sememangnya sangat berkuasa untuk tugas seperti penjanaan imej diperlukan.

Tetapi itu setakat ini sahaja.

Masalahnya ialah beberapa teknologi yang telah dipertingkatkan selama berbulan-bulan dan bertahun-tahun sebenarnya tidak mencapai skala yang kita perlukan.

Semakin banyak skim Ponzi Kelebihan prestasi yang dibawa oleh skala hanyalah hasil pemerhatian empirikal dan tidak boleh dijamin betul.

Marcus berkongsi tiga tanda terkini yang mungkin menunjukkan berakhirnya hipotesis pemaksimum skala.

1. Mungkin tidak ada data yang mencukupi di dunia untuk menyokong skala maksimum.

Ramai yang sudah risau tentang perkara ini.

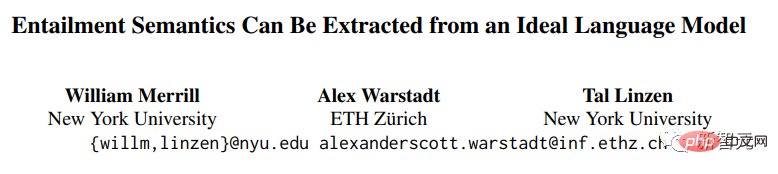

Penyelidik William Merrill, Alex Warstadt dan Tal Linzen dari Universiti New York dan ETH Zurich baru-baru ini membentangkan demonstrasi bahawa "model bahasa saraf semasa tidak sesuai untuk mengekstrak bahasa semula jadi tanpa sejumlah besar data." daripada bahasa".

Pautan kertas: https://arxiv.org/pdf/2209.12407.pdf

Walaupun bukti ini mengandungi terlalu banyak andaian, Sehinggakan ia tidak boleh dianggap sebagai bukti yang menyangkal, tetapi jika hipotesis ini hampir menjadi betul, mungkin terdapat masalah sebenar pada skala tidak lama lagi.

2. Mungkin tidak ada sumber pengkomputeran yang mencukupi di dunia untuk menyokong skala maksimum.

Miguel Solano baru-baru ini telah menghantar manuskrip pengarang bersama Marcus di mana pengarang percaya bahawa mencapai penanda aras super semasa seperti BIG-bench memerlukan penggunaan elektrik A.S. 2022 Lebih daripada satu perempat daripada itu.

Pautan gudang: //m.sbmmt.com/link/e21bd8ab999859f3642d2227e682e66f

>BI ialah set data penanda aras sumber ramai yang direka untuk meneroka model bahasa yang besar dan menyimpulkan keupayaan masa depan mereka, yang mengandungi lebih 200 tugasan.

3. Beberapa tugas penting mungkin tidak berskala sama sekali.

Contoh yang paling jelas ialah tugasan linguistik terbaru oleh Ruis, Khan, Biderman, Hooker, Rocktäschl dan Grefenstette, yang mengkaji makna pragmatik bahasa.

Sebagai contoh, untuk soalan "Adakah anda meninggalkan cap jari?", jawapan yang diterima mungkin "Saya memakai sarung tangan", dan makna semantiknya ialah "tidak".

Seperti yang telah lama dipertikaikan oleh Marcus, menyedarkan seorang model tentang perkara ini tanpa model kognitif dan akal adalah sangat sukar.

Skala memainkan sedikit peranan dalam jenis tugasan ini Malah model terbaik hanya mempunyai ketepatan 80.6%.

Dan, anda boleh bayangkan dengan mudah versi yang lebih kompleks bagi tugasan ini, di mana prestasi model akan semakin merosot.

Apa yang lebih melanda Marcus ialah walaupun untuk satu tugas penting seperti ini, kira-kira 80% prestasi mungkin bermakna permainan berskala besar tidak boleh terus dimainkan.

Jika model hanya mempelajari sintaks dan semantik, tetapi gagal dalam penaakulan pragmatik atau akal sehat, maka anda mungkin tidak mendapat AGI yang boleh dipercayai sama sekali

"Hukum Moore" tidak seperti Ia telah mengambil kita sejauh ini dan begitu pantas seperti yang dijangkakan pada awalnya, kerana bukan hukum sebab dan akibat di alam semesta yang akan sentiasa berlaku.

Memaksimumkan skala hanyalah satu andaian yang menarik Ia tidak akan membolehkan kita mencapai kecerdasan buatan umum Sebagai contoh, menyelesaikan tiga masalah di atas akan memaksa kita membuat anjakan paradigma.

Netizen Frank van der Velde berkata bahawa pengikut yang memaksimumkan skala cenderung menggunakan istilah yang tidak jelas seperti "besar" dan "lebih banyak".

Data latihan yang digunakan oleh model pembelajaran mendalam adalah terlalu besar berbanding dengan data latihan yang digunakan oleh manusia dalam pembelajaran bahasa.

Tetapi berbanding dengan koleksi semantik sebenar bahasa manusia, apa yang dipanggil data besar-besaran ini masih tidak penting. Ia akan mengambil kira-kira 10 bilion orang untuk menjana ayat sesaat, dan ia akan bertahan selama 300 tahun untuk mendapatkannya satu set latihan berskala besar.

Netizen Rebel Science dengan terus terang mengatakan bahawa memaksimumkan skala bukanlah hipotesis yang menarik, tetapi hipotesis bodoh Ia bukan sahaja akan kalah di landasan AI, tetapi juga mati dengan buruk.

Raphaël Millière, pensyarah di Jabatan Falsafah di Columbia University dan Ph.D.

Skala memaksimumkan pernah dilihat sebagai tumpuan pengkritik pembelajaran mendalam (seperti Gary Marcus Apabila orang dalam industri seperti Nando de Freitas dan Alex Dimakis menyertai perdebatan, kedua-dua pihak bertelagah).

Reaksi daripada pengamal kebanyakannya bercampur-campur, tetapi tidak terlalu negatif Pada masa yang sama, tarikh ramalan untuk pelaksanaan AGI pada platform ramalan Metaculus telah meningkat kepada paras terendah dalam sejarah (Mei 2028), yang juga mungkin meningkat. skala terbesar kredibiliti.

Kepercayaan orang ramai yang semakin meningkat dalam "skala" mungkin disebabkan oleh keluaran model baharu, seperti kejayaan PaLM, DALL-E 2, Flamingo dan Gato, yang telah menambah bahan api kepada api memaksimumkan skala.

"Pelajaran Pahit" Sutton melontarkan banyak perkara dalam perbincangan tentang memaksimumkan skala, tetapi ia tidak setara sepenuhnya. Beliau percaya bahawa membina pengetahuan manusia ke dalam model kecerdasan buatan (contohnya, kejuruteraan ciri) Kecekapan adalah lebih rendah daripada menggunakan data dan pengkomputeran untuk belajar.

Pautan artikel: http://www.incompleteideas.net/IncIdeas/BitterLesson.html

Walaupun bukan tanpa kontroversi, pandangan Sutton nampaknya jelas Bukan seperti radikal sebagai skala memaksimumkan.

Ia memang menekankan kepentingan skala, tetapi ia tidak mengurangkan setiap masalah dalam penyelidikan AI kepada cabaran skala semata-mata.

Sebenarnya, sukar untuk menentukan maksud khusus skala memaksimumkan Difahamkan secara literal, "Penskalaan adalah semua yang anda perlukan" menunjukkan bahawa kita tidak memerlukan sebarang inovasi algoritma atau perubahan seni bina untuk mencapai AGI dan boleh mengembangkan sedia ada. model dan memaksa input lebih banyak data.

Penjelasan literal ini kelihatan tidak masuk akal: walaupun model seperti Palm, DALL-E 2, Flamingo atau Gato masih memerlukan perubahan seni bina daripada pendekatan sebelumnya.

Sungguh memeranjatkan jika seseorang benar-benar menyangka kami boleh memanjangkan Transformer autoregresif luar biasa kepada AGI.

Tidak jelas berapa banyak inovasi algoritmik yang dirasakan oleh orang yang percaya dalam memaksimumkan skala yang diperlukan oleh AGI, yang juga menyukarkan untuk menjana ramalan yang boleh dipalsukan daripada perspektif ini.

Penskalaan mungkin merupakan syarat yang diperlukan untuk membina mana-mana sistem yang patut diberi label "kecerdasan buatan am," tetapi kita tidak seharusnya menyalahkan keperluan sebagai keadaan yang mencukupi.

Atas ialah kandungan terperinci Bolehkah model disambungkan terus ke AGI selagi ia 'semakin besar'? Marcus membedil lagi: Tiga krisis telah muncul!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!