Model bahasa besar (LLM) telah menunjukkan prestasi cemerlang pada pelbagai tugasan yang kompleks melalui pembelajaran dalam konteks tanpa memerlukan latihan khusus tugasan atau penalaan halus Kemajuan terkini dalam gesaan dan penyahkodan juga telah membolehkan LLM menjadi realiti untuk menyelesaikan tugas penaakulan yang kompleks.

Walau bagaimanapun, LLM mungkin menyimpan pengetahuan yang lapuk, tidak lengkap atau tidak betul, dan untuk berjaya menggunakan LLM ke dalam aplikasi dunia sebenar, sumber pengetahuan luaran (seperti Wikipedia) adalah penting. Percubaan sebelumnya telah dibuat untuk menggunakan pengetahuan pada model bahasa yang lebih kecil (LM) seperti T5, BERT dan RoBERTa, tetapi kaedah ini selalunya memerlukan latihan tambahan atau penalaan halus, mahal dan tidak praktikal sama sekali untuk LLM.

Berdasarkan ini, penyelidik dari University of Rochester, Tencent AI Lab dan University of Pennsylvania bersama-sama mencadangkan kaedah pasca pemprosesan yang dipanggil Rethinking with Retrieval (RR) untuk Memanfaatkan pengetahuan luaran dalam LLM.

Alamat kertas: https://arxiv.org/pdf/2301.00303v1.pdf

Idea penyelidikan ini adalah untuk menggunakan kaedah penggerak rantaian pemikiran (CoT) untuk menghasilkan satu set laluan penaakulan yang berbeza, sama dengan Wang et al. 2022) kaedah. Kajian kemudiannya menggunakan setiap langkah inferens dalam laluan ini untuk mendapatkan semula pengetahuan luaran yang berkaitan, membolehkan kaedah RR memberikan penjelasan yang lebih munasabah dan ramalan yang lebih tepat.

Kajian ini menggunakan GPT-3 175B dan beberapa sumber pengetahuan luaran biasa (Wikipedia, Wikidata, WordNet dan Conceptnet) untuk menilai kaedah RR pada tiga tugas penaakulan kompleks Keberkesanan, termasuk penaakulan akal. , penaakulan temporal dan penaakulan jadual. Keputusan eksperimen menunjukkan bahawa RR secara konsisten mengatasi kaedah lain pada ketiga-tiga tugas ini tanpa latihan tambahan atau penalaan halus, menunjukkan bahawa kaedah RR mempunyai kelebihan besar dalam memanfaatkan pengetahuan luaran untuk meningkatkan prestasi LLM.

Dalam amalan, walaupun LLM menangkap elemen yang diperlukan untuk menjawab soalan dengan tepat, model ini kadangkala menghasilkan hasil yang salah. Fenomena ini menunjukkan terdapat beberapa masalah dalam cara LLM menyimpan dan mendapatkan semula pengetahuan, termasuk:

yang paling sesuai dengan pengetahuan itu.  Gesaan Rantaian Pemikiran (CoT). Berbeza dengan ketara daripada gesaan standard, gesaan CoT melibatkan demonstrasi contoh penaakulan langkah demi langkah dalam gesaan untuk menjana satu siri ayat pendek yang menangkap proses penaakulan.

Gesaan Rantaian Pemikiran (CoT). Berbeza dengan ketara daripada gesaan standard, gesaan CoT melibatkan demonstrasi contoh penaakulan langkah demi langkah dalam gesaan untuk menjana satu siri ayat pendek yang menangkap proses penaakulan.

Sebagai contoh, diberikan soalan input: "Adakah Aristotle menggunakan komputer riba gesaan CoT bertujuan untuk menjana laluan penaakulan yang lengkap:

Proses penaakulan bagi dorongan CoT ialah: "Aristotle meninggal dunia pada 322 SM. Komputer riba pertama dicipta pada tahun 1980. Oleh itu, Aristotle tidak menggunakan komputer riba. Jadi jawapannya adalah tidak. " dan bukannya hanya mengeluarkan "Tidak".

Mensampel laluan inferens yang berbeza. Sama seperti Wang et al (2022), kajian ini mengambil sampel set laluan inferens R_1, R_2, ..., R_N dan bukannya hanya mempertimbangkan laluan berkadar optimum (rakus) seperti dalam laluan Wei et al (2022). . Mengenai soalan "Adakah Aristotle menggunakan komputer riba?", jalan penaakulan yang mungkin adalah seperti berikut:

(R_1) Aristotle meninggal dunia pada tahun 2000. Komputer riba pertama dicipta pada tahun 1980. Jadi Aristotle menggunakan komputer riba. Jadi jawapan kepada soalan ini adalah ya.

(R_2) Aristotle meninggal dunia pada 322 SM. Komputer riba pertama dicipta pada tahun 2000. Oleh itu, Aristotle tidak menggunakan komputer riba. Jadi jawapannya tidak.

Pencarian pengetahuan. Pangkalan pengetahuan yang berbeza boleh digunakan untuk mengendalikan tugas yang berbeza. Sebagai contoh, untuk menjawab soalan "Adakah Aristotle menggunakan komputer riba kita boleh menggunakan Wikipedia sebagai pangkalan pengetahuan luaran KB?" Teknik pencarian maklumat boleh digunakan untuk mendapatkan semula pengetahuan yang berkaitan K_1,...K_M daripada Wikipedia berdasarkan langkah penaakulan terurai. Sebaik-baiknya, kita akan mendapatkan dua petikan berikut dari Wikipedia untuk soalan ini:

(K_1) Aristotle (384 SM hingga 322 SM) adalah ahli falsafah Yunani dan belajar sarjana pada zaman klasik kuno. Greece

(K_2) Komputer riba pertama, Epson HX-20, telah dicipta pada tahun 1980...

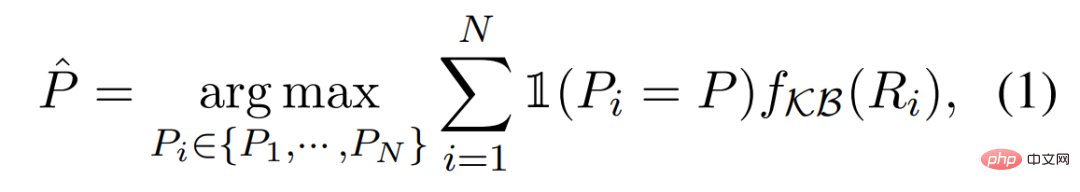

Penaakulan yang setia. Kita boleh menganggarkan keyakinan setiap laluan inferens R_i menggunakan fungsi f_KB(R_i), yang berdasarkan pengetahuan berkaitan K_1,...,K_M yang diambil daripada pangkalan pengetahuan KB. Ramalan akhir boleh diperolehi dengan menggunakan proses inferens berikut:

Dalam ini bahagian , kajian ini membentangkan penilaian RR pada tiga tugas penaakulan yang kompleks: penaakulan akal, penaakulan temporal dan penaakulan jadual.

Persediaan percubaan. Dalam semua eksperimen, kajian ini menggunakan GPT-3 text-davinci-002 melainkan dinyatakan sebaliknya. Bilangan maksimum token yang dijana semasa penyiapan percubaan ditetapkan kepada 256, sifar pukulan, beberapa pukulan dan gesaan rantaian pemikiran, dan parameter suhu (suhu) ditetapkan kepada 0.

Keputusan. Seperti yang ditunjukkan dalam Jadual 1, kaedah cadangan kami, RR, secara konsisten mengatasi semua garis dasar pada ketiga-tiga tugas inferens tanpa latihan tambahan atau penalaan halus. Keputusan ini menyerlahkan keberkesanan RR dalam memanfaatkan pengetahuan luaran untuk meningkatkan prestasi LLM.

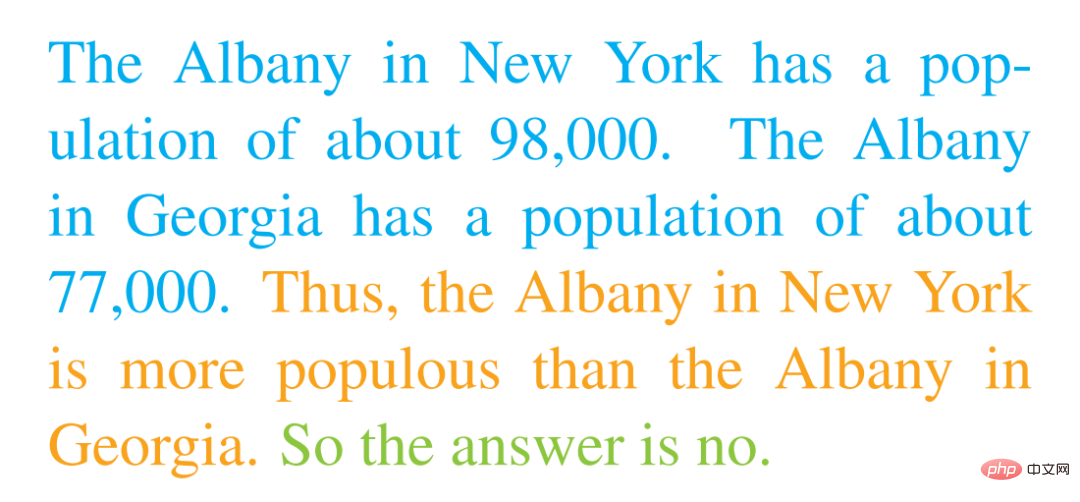

Kajian ini menunjukkan analisis GPT-3 dengan kaedah gesaan CoT pada set data StrategyQA. Selepas meneliti keluaran GPT-3 dengan teliti, kajian mendapati bahawa RR boleh memberikan penjelasan yang munasabah dan ramalan yang betul untuk banyak masalah. Sebagai contoh, apabila diberi soalan "Adakah Albany, Georgia akan mencapai 100,000 penduduk sebelum Albany, New York?", GPT-3 menghasilkan output berikut:

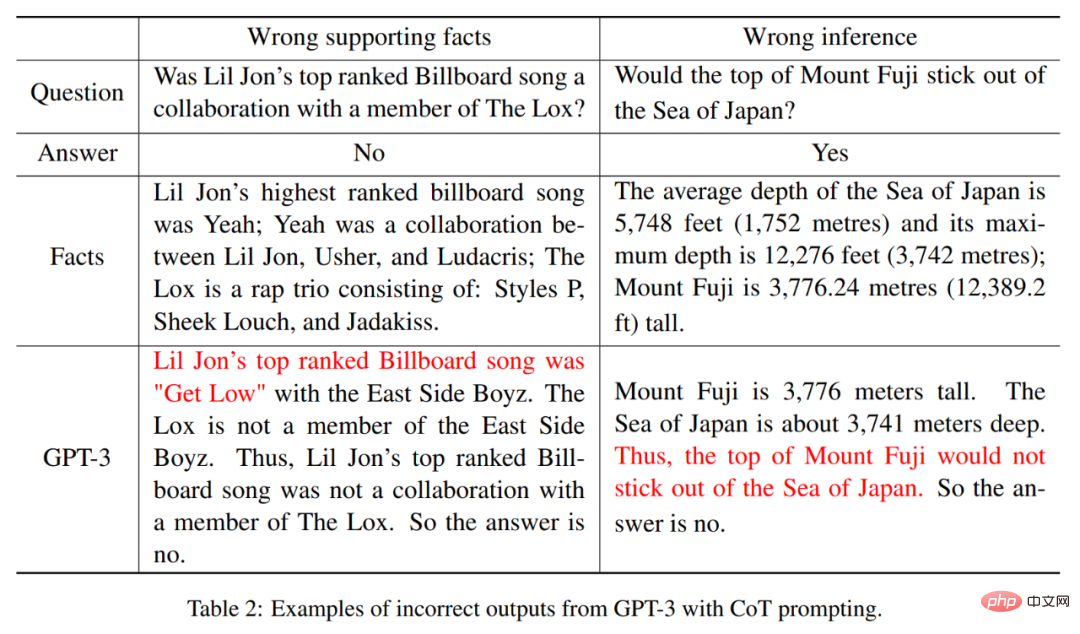

Secara keseluruhannya, jawapan output kepada soalan adalah berkualiti tinggi. Walau bagaimanapun, kajian itu juga mendapati bahawa GPT-3 kadangkala boleh memberikan sokongan fakta yang salah untuk tafsirannya atau membuat penaakulan yang salah untuk ramalannya, walaupun ia secara amnya dapat mengenal pasti sudut pandangan yang sesuai.

Fakta sokongan yang salah. Seperti yang ditunjukkan dalam Jadual 2, GPT-3 memberikan sokongan fakta yang salah untuk lagu Lil Jon dengan carta tertinggi pada carta Billboard, dengan menyatakan bahawa lagu carta tertinggi ialah Get Low dan bukannya jawapan yang betul Yeah. Di samping itu, GPT-3 tersilap memberi alasan bahawa puncak Gunung Fuji tidak boleh lebih tinggi daripada Laut Jepun, dan bukannya jawapan yang betul ialah itu.

Sila rujuk kertas asal untuk butiran lanjut teknikal.

Atas ialah kandungan terperinci Dilarang membuat model bahasa berskala besar secara rawak, dan diberikan sedikit pengetahuan luaran, alasannya sangat boleh dipercayai.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

bootmgr tiada dan tidak boleh boot

bootmgr tiada dan tidak boleh boot

Bagaimana untuk mengemas kini pemacu kad grafik

Bagaimana untuk mengemas kini pemacu kad grafik

jejari sempadan

jejari sempadan

Penyelesaian kepada masalah bahawa fail exe tidak boleh dibuka dalam sistem win10

Penyelesaian kepada masalah bahawa fail exe tidak boleh dibuka dalam sistem win10

Bagaimana untuk membaiki winntbbu.dll hilang

Bagaimana untuk membaiki winntbbu.dll hilang

Laksanakan kaedah lompat 301 melalui kod js

Laksanakan kaedah lompat 301 melalui kod js

Apakah maksud wifi dinyahaktifkan?

Apakah maksud wifi dinyahaktifkan?

Bagaimana untuk mengimport fail mdf ke dalam pangkalan data

Bagaimana untuk mengimport fail mdf ke dalam pangkalan data