Beberapa masa lalu, Pasukan Pembangunan Pintar Yuanyu melatih model besar dialog berfungsi ChatYuan serupa dengan ChatGPT dan membuka antara muka percubaan dalam versi web.

Kini anda juga boleh menggunakan ChatYuan pada mesin anda sendiri!

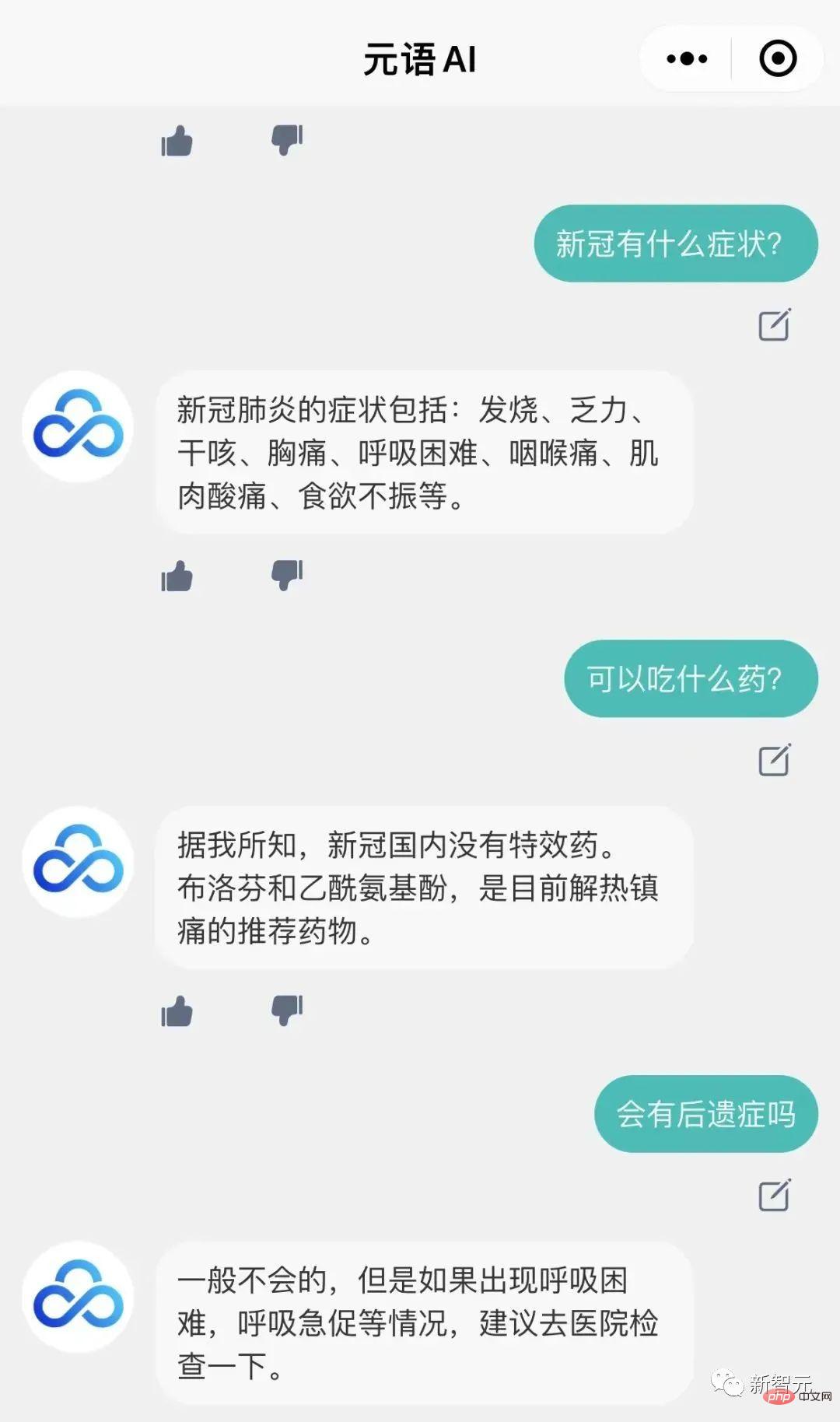

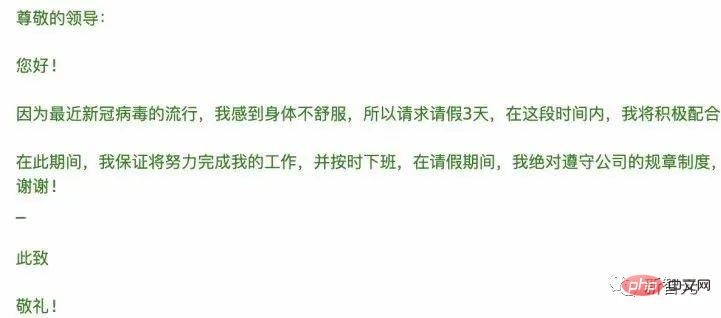

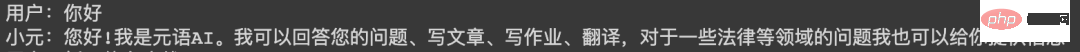

Model boleh digunakan dalam senario soal jawab, dan boleh menjalankan dialog dan pelbagai tugas penjanaan dalam konteks, termasuk penulisan kreatif juga boleh menjawab soalan dalam bidang seperti undang-undang dan COVID-19.

Dan ia menyokong pembelajaran sampel sifar dalam semua tugasan bahasa Cina. Pengguna boleh menggunakannya dengan memberikan gesaan Ia menyokong hampir 30 jenis tugasan bahasa Cina di bawah kategori penjanaan teks, pengekstrakan maklumat dan. persefahaman.

ChatYuan dilatih lagi berdasarkan PromptCLUE-besar digabungkan dengan ratusan juta soalan dan jawapan berfungsi dan data dialog berbilang pusingan Parameter model ialah 770 juta, memori video adalah kira-kira 6G, dan kad grafik awam boleh dimuatkan dan digunakan , model itu kini dibuka untuk dimuat turun.

PromptCLUE dilatih terlebih dahulu mengenai 100 bilion token korpus Cina, telah mempelajari sejumlah 1.5 trilion token Cina, dan menjalankan latihan berasaskan tugasan Prompt mengenai beratus-ratus tugas.

Untuk memahami tugasan, seperti klasifikasi, analisis sentimen, pengekstrakan, dsb., sistem label boleh disesuaikan untuk pelbagai tugas penjanaan, pensampelan boleh dijana secara bebas.

1. >

Alamat projek: https://github.com/clue-ai/ChatYuan

2

Alamat projek: https://huggingface.co/ClueAI/ChatYuan - besar-v1

Alamat projek: https://modelscope.cn/models / ClueAI/ChatYuan-besar

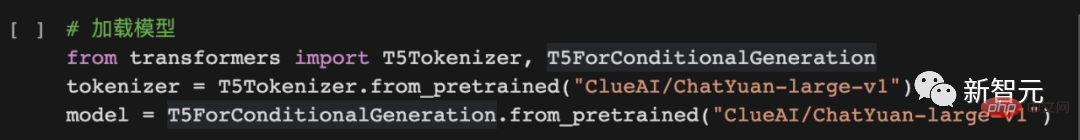

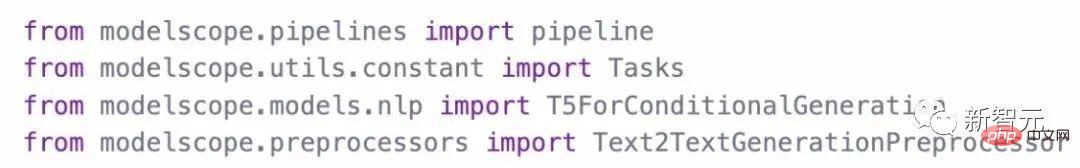

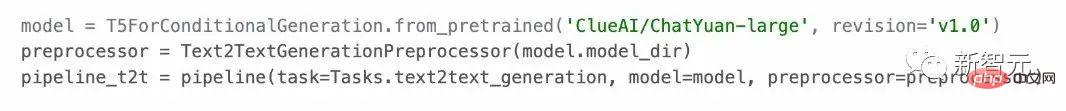

Kaedah inferens ramalan menggunakan model:

Alamat projek:

https://aistudio.baidu.com /aistudio/projectdetail/5404182

Alamat model: https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle

1 Susun data

Susun data ke dalam format bersatu, yang terdiri daripada dua bahagian: input. ( Input) dan output (Output).

Untuk soalan dan jawapan bulat tunggal atau penjanaan:

Input: perihalan tugas + input teks

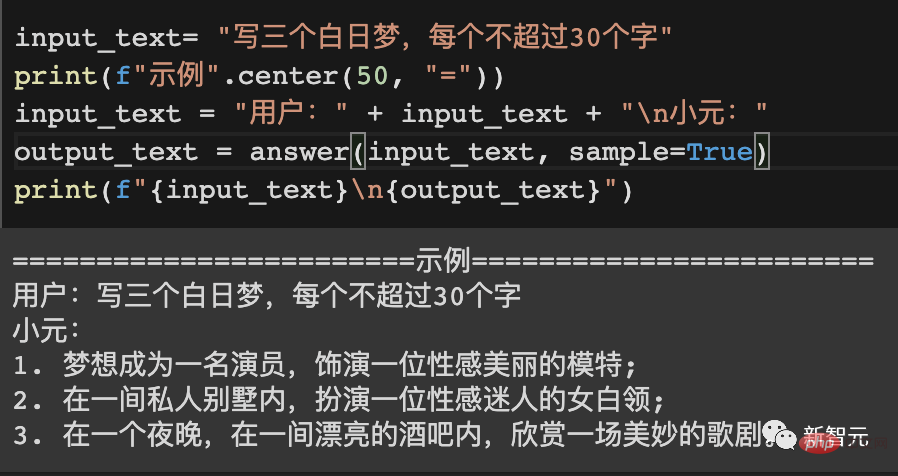

Output: Teks yang sistem perlu ramalkan, seperti kandungan selepas "Xiaoyuan" dalam gambar di bawah.

Untuk berbilang pusingan dialog:

Input: perihalan tugas + di atas + input teks

Output: Teks yang sistem perlu ramalkan, seperti kandungan selepas "Xiaoyuan" dalam gambar di bawah.

Format data perbualan bulat tunggal:

Format data dialog berbilang pusingan:

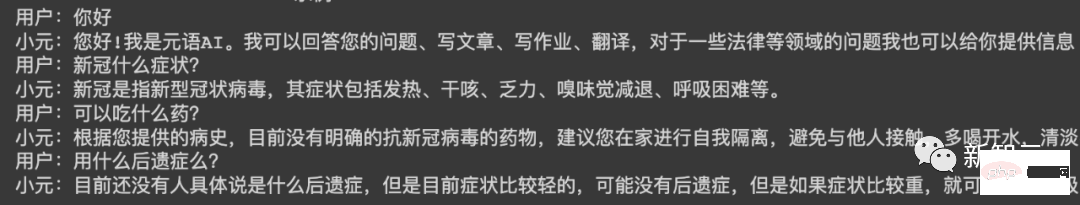

2. Latihan model

Kod latihan boleh merujuk kepada:

Gunakan set data pCLUE untuk latihan , ramalan dan pengesahan Kesan, pelaksanaan pytorch - colab dalam talian.

Projek Github: https://colab.research.google.com/drive/1lEyFhEfoc-5Z5xqpEKkZt_iMaojH1 ?usp=sharing

========== Contoh 1======== ===

Pengguna:

Apa yang boleh anda lakukan

Xiao Yuan:

Helo! Saya Yuanyu AI. Saya boleh menjawab soalan anda, menulis artikel, tugasan, menterjemah, dan saya juga boleh memberi anda maklumat tentang isu dalam bidang undang-undang dan bidang lain.

==========Contoh 2==========

Pengguna:

Tulis puisi tentang musim sejuk

Xiao Yuan:

Malam musim sejuk sunyi dan sejuk,

Awan terapung di langit,

Hidup salji putih beku,

Sejuk seperti salji.

Kepingan salji cair menjadi ais,

Seperti kepingan salji yang jatuh,

pada musim sejuk yang sejuk ,

Rasakan kegembiraan musim bunga.

Pada musim sejuk,

Angin dan salji beransur surut,

Senyap,

Bawa kebahagiaan dan kemesraan ke rumah.

==========Contoh 3==========

Pengguna:

Semasa latihan amali jurusan pendidikan prasekolah, akan ada masalah dengan pelajar. Sila cadangkan langkah penambahbaikan. 800 patah perkataan

Xiao Yuan:

Semasa latihan dalam jurusan pendidikan prasekolah, akan ada beberapa masalah dengan pelajar. , seperti kekurangan pengetahuan profesional pelajar, kekurangan kesedaran kerjasama, kekurangan rasa tanggungjawab asas, dan lain-lain, kita perlu mengambil langkah untuk menyelesaikan masalah ini.

Pertama sekali, semasa proses amali, kita perlu memupuk kesedaran pasukan pelajar, mengeratkan kerjasama antara pelajar dan guru, mengukuhkan komunikasi dengan ibu bapa, dan meningkatkan kemahiran komunikasi mereka. Selain itu, kita juga perlu memperkasakan kemandirian pelajar, membolehkan pelajar belajar berfikir secara bebas, belajar berkomunikasi dengan guru dan ibu bapa, serta memupuk sikap berdikari.

Selain itu, dalam kerja harian, kita juga mesti menyediakan pelajar dengan peluang dan peluang yang sesuai, supaya pelajar dapat lebih berhubung dengan masyarakat dan mengambil bahagian dalam lebih banyak aktiviti sosial, mendalami pemahaman mereka tentang masyarakat dan sekolah Memahami dan memupuk inisiatif, semangat positif dan inovatif mereka.

Akhir sekali, kita juga perlu mengambil berat tentang masalah yang dihadapi oleh pelajar semasa menjalani internship terutamanya pelajar yang kurang kerjasama, pergantungan, tidak tahu berkongsi, bertangguh dan sebagainya. harus menyebabkan kita Beri perhatian kepadanya dan merumuskan langkah penambahbaikan yang munasabah untuk memperbaiki masalah ini.

ChatYuan ialah model yang diperoleh melalui latihan lanjut berdasarkan PromptCLUE. Ia menghapuskan tugas pemahaman teks dan pengekstrakan maklumat, dan mengukuhkan pembelajaran dan latihan soal jawab, dialog dan pelbagai tugasan generatif Penambahan data anti-gangguan membolehkan model mengabaikan konteks yang tidak relevan apabila perlu; data membolehkan model bukan sahaja mempunyai keupayaan pemahaman bahasa umum tertentu dan keupayaan penjanaan tugas tertentu, tetapi juga bertindak balas dengan lebih baik kepada niat pengguna.

PromptCLUE proses pembelajaran

Versi semasa boleh digunakan untuk soal jawab, dialog dan pelbagai penulisan kreatif atau penjanaan teks Berbanding dengan versi dalam talian, pemahaman niat dan keupayaan penjanaan masih mempunyai banyak ruang untuk peningkatan dalam beberapa situasi; ia juga tidak dapat mencapai penaakulan dengan baik atau tugas yang kompleks. Versi sedia ada kemudiannya akan dipertingkatkan lagi berdasarkan maklum balas.

Atas ialah kandungan terperinci Penggunaan ChatGPT domestik hanya memerlukan 6G memori video! Model ChatYuan terbuka untuk dimuat turun: model besar Cina sumber terbuka dialog berfungsi pertama dalam industri. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Apa yang perlu dilakukan jika notepad.exe tidak bertindak balas

Apa yang perlu dilakukan jika notepad.exe tidak bertindak balas

Apakah fungsi pembahagi frekuensi

Apakah fungsi pembahagi frekuensi

Bagaimana untuk membuat wifi maya dalam win7

Bagaimana untuk membuat wifi maya dalam win7

Penggunaan PathFileExists

Penggunaan PathFileExists