Model penyebaran denoising ialah kelas baru muncul rangkaian neural generatif yang menjana imej daripada pengedaran latihan melalui proses denoising berulang. Model resapan jenis ini menghasilkan sampel yang lebih berkualiti dan lebih mudah untuk skala dan kawalan berbanding kaedah sebelumnya seperti GAN dan VAE. Akibatnya, selepas pembangunan pesat, mereka sudah boleh menghasilkan imej beresolusi tinggi, dan terdapat minat orang ramai terhadap model besar seperti DALL-E 2.

Keindahan model resapan generatif terletak pada keupayaan mereka untuk mensintesis imej baharu yang, secara dangkal, tidak seperti mana-mana dalam set latihan. Malah, usaha latihan berskala besar pada masa lalu tidak mendapati bahawa pemasangan berlebihan akan menjadi masalah Penyelidik dalam bidang sensitif privasi malah telah mencadangkan bahawa model penyebaran boleh digunakan untuk melindungi privasi dengan menghasilkan contoh sintetik untuk menjana imej sebenar. Siri kerja ini dijalankan di bawah andaian bahawa model resapan tidak menghafal dan menjana semula data latihan. Melakukannya akan melanggar semua jaminan privasi dan menimbulkan banyak masalah dengan generalisasi model dan pemalsuan digital.

Dalam artikel ini, penyelidik dari Google, DeepMind dan institusi lain telah membuktikan bahawa model penyebaran SOTA sememangnya boleh mengingati dan menjana semula satu contoh latihan.

Alamat kertas: https://arxiv.org/pdf/2301.13188v1.pdf

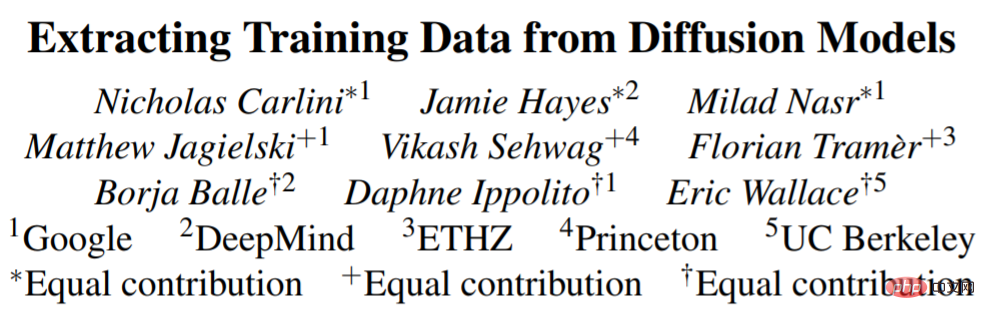

Pertama, penyelidikan mencadangkan dan melaksanakan definisi memori baharu dalam model imej. Kemudian, kajian itu mereka bentuk serangan pengekstrakan data dua peringkat, menggunakan kaedah standard untuk menjana imej dan melabel beberapa imej. Kajian itu menggunakan kaedah tersebut untuk Stable Diffusion dan Imagen, menghasilkan pengekstrakan lebih daripada 100 salinan imej latihan yang hampir sama, yang terdiri daripada foto yang boleh dikenal pasti secara peribadi kepada logo bertanda dagangan (Rajah 1).

Untuk lebih memahami cara ingatan berfungsi dan sebabnya, penyelidik melatih ratusan orang pada model Penyebaran CIFAR10 untuk menganalisis kesan ketepatan model, hiperparameter, penambahan dan penyahduplikasian terhadap privasi. Model resapan ialah bentuk model imej yang paling kurang peribadi yang dinilai dalam kajian, membocorkan data latihan dua kali lebih banyak berbanding GAN. Lebih buruk lagi, penyelidikan juga mendapati bahawa teknologi peningkatan privasi sedia ada gagal memberikan pertukaran utiliti privasi yang boleh diterima. Secara keseluruhannya, kertas kerja ini menyerlahkan ketegangan yang wujud antara model generatif yang semakin berkuasa dan privasi data, dan menimbulkan persoalan tentang cara model resapan berfungsi dan cara ia boleh digunakan dengan sewajarnya.

Terdapat dua motivasi di sebalik memahami cara model resapan mengingat dan menjana semula data latihan.

Pertama ialah memahami risiko privasi. Menjana semula model penyebaran yang mengikis data daripada Internet mungkin menimbulkan risiko privasi dan hak cipta yang serupa seperti model bahasa. Sebagai contoh, telah dinyatakan bahawa menghafal dan menjana semula teks dan kod sumber berhak cipta memberikan petunjuk potensi pelanggaran. Begitu juga, menyalin imej yang dicipta oleh artis profesional dipanggil pemalsuan digital, dan terdapat perdebatan dalam dunia seni.

Yang kedua ialah memahami generalisasi. Selain privasi data, memahami cara dan sebab model penyebaran mengingati data latihan membantu memahami keupayaan mereka untuk membuat generalisasi. Sebagai contoh, soalan biasa dengan model generatif berskala besar ialah sama ada hasil yang mengagumkan terhasil daripada penjanaan sebenar atau hasil daripada menyalin dan mencampur semula data latihan secara terus. Dengan mengkaji ingatan, adalah mungkin untuk memberikan penerangan empirikal yang konkrit tentang kadar di mana model generatif melakukan replikasi data jenis ini.

Ekstrak data daripada Resapan Stabil

Sekarang Ekstrak latihan data daripada Stable Diffusion, model penyebaran sumber terbuka terbesar dan paling popular.

Pengekstrakan ini menggunakan kaedah kerja sebelumnya pada imej, termasuk dua langkah:

1 berbilang contoh menggunakan gesaan yang diketahui daripada bahagian sebelumnya.

2. Lakukan inferens untuk memisahkan model generasi baharu daripada model latihan yang dihafal.

Untuk menilai keberkesanan pencerobohan, kajian memilih 350,000 contoh yang paling berulang daripada set data latihan dan menjana 500 imej calon untuk setiap gesaan (menjana 175 juta jumlah imej).

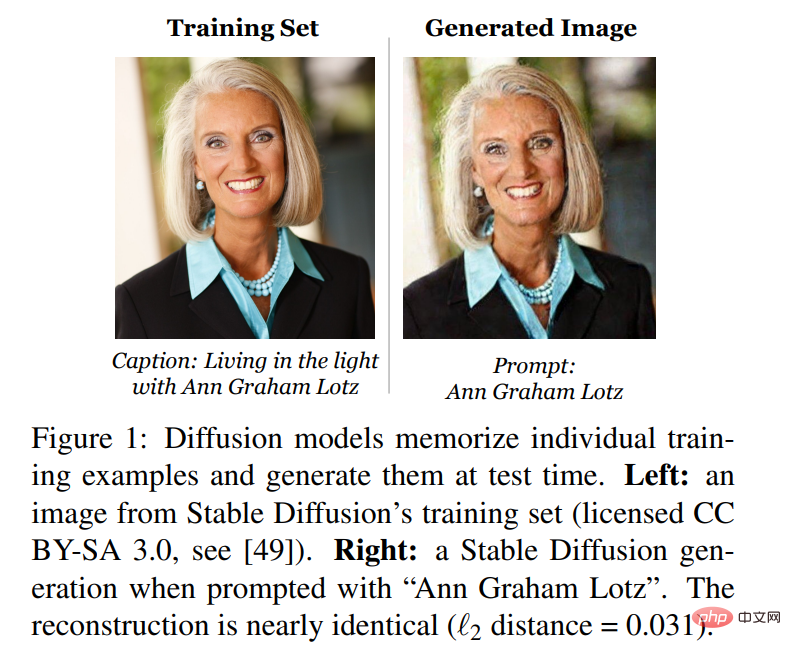

Pertama, kajian menyusun semua imej yang dijana ini untuk menentukan yang mana yang dihasilkan dengan menghafal data latihan. Setiap imej yang dijana ini kemudiannya dibandingkan dengan imej latihan di bawah Definisi 1 dalam kertas, dan setiap imej dianotasi sebagai diekstrak atau tidak. Kajian itu mendapati bahawa 94 imej telah diekstrak Untuk memastikan bahawa imej ini tidak hanya sesuai dengan beberapa definisi sewenang-wenangnya, kajian itu juga secara manual menganotasi 1,000 imej pertama yang dijana melalui analisis visual, sama ada dengan atau tanpa memori Dan 13 lagi (jumlah 109 imej). didapati hampir salinan contoh latihan, walaupun mereka tidak memenuhi definisi norma L_2 kajian. Rajah 3 menunjukkan subset imej yang diekstrak, yang dihasilkan semula dengan ketepatan piksel yang hampir sempurna.

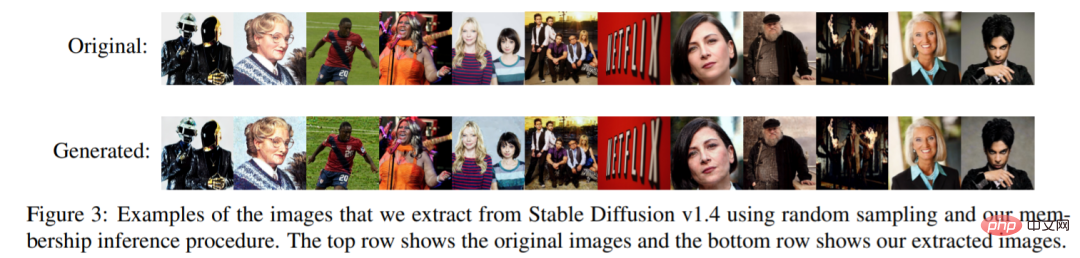

Percubaan juga menunjukkan lengkung pengiraan yang diberi set imej tersusun beranotasi, Nilaikan bilangan imej yang diekstrak berbanding yang palsu kadar positif pencerobohan. Pencerobohan adalah sangat tepat: daripada 175 juta imej yang dijana, 50 imej memori dengan 0 positif palsu boleh dikenal pasti, dan semua imej memori boleh diekstrak dengan ketepatan lebih 50%. Rajah 4 mengandungi keluk ingatan-kepersisan untuk kedua-dua takrif ingatan.

Ekstrak data daripada imej

Walaupun Resapan Stabil pada masa ini merupakan pilihan terbaik dalam kalangan model resapan yang tersedia secara umum, beberapa model bukan awam telah mencapai prestasi yang lebih kukuh menggunakan model dan set data yang lebih besar. Penyelidikan terdahulu telah mendapati bahawa model yang lebih besar lebih berkemungkinan mengingati data latihan, jadi kajian ini melihat Imagen, model resapan teks-ke-imej parameter 2 bilion.

Anehnya, penyelidikan mendapati bahawa menggodam imej yang tidak diedarkan dalam Imagen adalah lebih berkesan daripada dalam Stable Diffusion. Pada Imagen, kajian itu cuba mengekstrak 500 imej dengan skor luar pengedaran (OOD) tertinggi. Imagen menghafal dan menyalin 3 imej (yang unik dalam set data latihan). Sebaliknya, apabila kajian menggunakan kaedah yang sama untuk Resapan Stabil, ia gagal mengenal pasti sebarang kenangan walaupun selepas cuba mengekstrak 10,000 sampel yang paling luar biasa. Oleh itu, Imagen kurang peribadi daripada Stable Diffusion pada kedua-dua imej yang disalin dan tidak disalin. Ini mungkin disebabkan oleh fakta bahawa Imagen menggunakan model yang lebih besar daripada Stable Diffusion dan oleh itu mengingati lebih banyak imej. Selain itu, Imagen melatih dengan lebih banyak lelaran pada set data yang lebih kecil, yang juga boleh membantu meningkatkan tahap ingatan.

Atas ialah kandungan terperinci Menggunakan helah kecil untuk menggali model resapan, imej yang dihasilkan adalah hampir replika data latihan asal dan privasi akan didedahkan.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Perbezaan antara eksport dan eksport lalai

Perbezaan antara eksport dan eksport lalai

bagaimana untuk menyembunyikan alamat ip

bagaimana untuk menyembunyikan alamat ip

Apakah teras sistem pangkalan data?

Apakah teras sistem pangkalan data?

Pengenalan kepada mata wang digital konsep dex

Pengenalan kepada mata wang digital konsep dex

Bagaimana untuk menyelesaikan ralat pangkalan data discuz

Bagaimana untuk menyelesaikan ralat pangkalan data discuz

Bagaimana untuk membuka fail vcf dalam windows

Bagaimana untuk membuka fail vcf dalam windows

0x00000006 Apa yang perlu dilakukan jika pencetak tidak dapat disambungkan?

0x00000006 Apa yang perlu dilakukan jika pencetak tidak dapat disambungkan?