Memandangkan sekeping teks, kecerdasan buatan boleh menjana muzik, suara, pelbagai kesan bunyi, dan juga bunyi khayalan, seperti lubang hitam dan senjata laser. AudioLDM, baru-baru ini dilancarkan secara bersama oleh University of Surrey dan Imperial College London, dengan cepat menjadi popular di luar negara selepas dikeluarkan Ia menerima hampir 300 tweet semula dan 1,500 suka di Twitter dalam masa seminggu. Pada hari kedua selepas model sumber terbuka, AudioLDM bergegas ke bahagian atas senarai carian hangat Memeluk Wajah, dan dalam masa seminggu memasuki senarai 40 aplikasi paling popular Memeluk Wajah (kira-kira 25,000 kesemuanya), dan dengan cepat muncul dalam banyak Kerja terbitan berdasarkan AudioLDM.

Model AudioLDM mempunyai sorotan berikut:

Pengarang mula-mula mengeluarkan pratonton model pada 27 Januari, menunjukkan teks yang sangat ringkas: " Muzik yang dibuat oleh []” (sekeping muzik yang dihasilkan oleh []) untuk menghasilkan kesan bunyi yang berbeza. Video itu, yang menunjukkan muzik yang dibuat dengan instrumen berbeza dan juga seekor nyamuk, dengan cepat mendapat tarikan di Twitter, dimainkan lebih 35.4K kali dan ditweet semula lebih 130 kali.

Pengarang kemudian mengeluarkan kertas kerja dan video baharu. Dalam video ini, pengarang menunjukkan kebanyakan keupayaan model, serta kesan bekerja dengan ChatGPT untuk menjana bunyi. AudioLDM malah boleh menjana bunyi dari angkasa lepas.

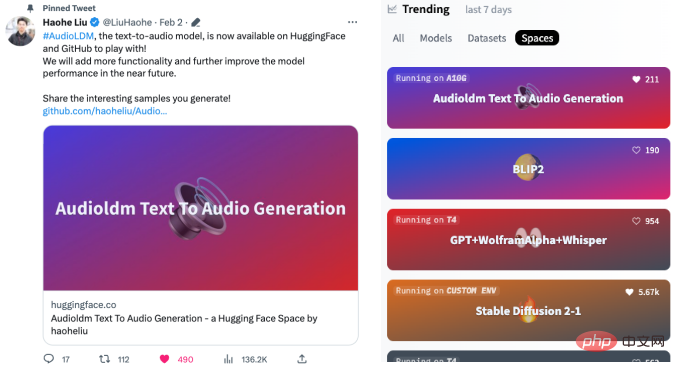

Kemudian pengarang mengeluarkan kertas, model pra-latihan, dan antara muka yang boleh dimainkan, yang mencetuskan semangat netizen Twitter dan dengan cepat muncul di Hugging Face pada hari berikutnya Tempat pertama di senarai carian hangat:

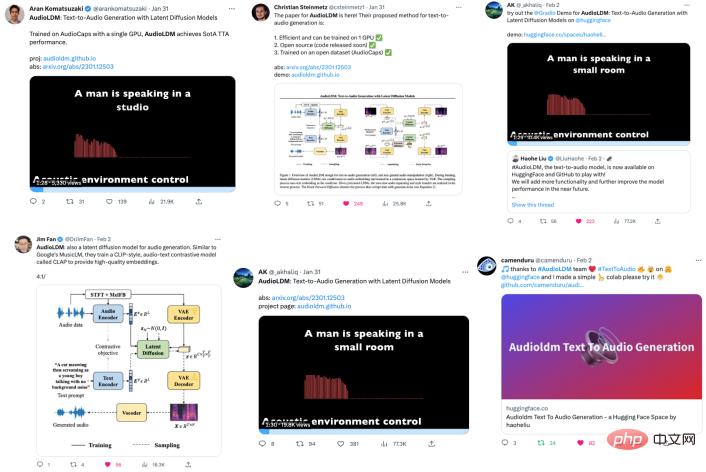

Karya ini telah mendapat perhatian meluas di Twitter, dan cendekiawan dalam industri Mentweet semula dan mengulas:

Netizen menggunakan AudioLDM untuk menjana pelbagai bunyi.

Sebagai contoh, bunyi dengkuran gadis kucing dua dimensi dijana:

Dan suara hantu:

Sesetengah netizen mensintesis: "Suara mummy, frekuensi rendah, dengan erangan yang menyakitkan."

Malah ada netizen yang mensintesis: "bunyi kentut melodi".

Saya terpaksa meratapi khayalan netizen yang kaya.

Sesetengah netizen menggunakan AudioLDM secara langsung untuk menjana satu siri album muzik dalam pelbagai gaya, termasuk jazz, funk, elektronik dan klasik. Sesetengah muzik agak inventif.

Contohnya, "Buat muzik ambien dengan tema alam semesta dan bulan":

Dan "Buat muzik menggunakan bunyi masa hadapan":

Pembaca yang berminat boleh melayari laman web album muzik ini: https://www.latent.store/albums

Sesetengah netizen juga menggunakan imaginasi mereka untuk mencipta gambar dengan menggabungkan imej -model teks yang dihasilkan dan Aplikasi AudioLDM yang membimbing penjanaan kesan bunyi.

Contohnya, jika anda memberikan AudioLDM teks ini: "Anjing berlari di dalam air dengan frisbee" (anjing berlari di dalam air dengan frisbee di mulutnya):

boleh menjana bunyi berikut seperti anjing menampar air.

Anda juga boleh memulihkan bunyi dalam foto lama, seperti gambar di bawah:

Selepas memperoleh teks "Seorang lelaki dan seorang wanita duduk di bar" (seorang lelaki dan seorang wanita duduk di bar), model boleh menjana bunyi berikut, di mana anda boleh mendengar suara samar-samar dan perlanggaran gelas wain dalam bunyi latar belakang.

Sesetengah netizen menggunakan AudioLDM untuk menjana bunyi anjing yang menyala, yang sangat menarik.

Pengarang juga menghasilkan video untuk menunjukkan keupayaan model menjana kesan bunyi, menunjukkan betapa hampirnya sampel yang dijana AudioLDM dengan perpustakaan kesan bunyi.

Malah, penjanaan audio teks hanyalah sebahagian daripada keupayaan AudioLDM AudioLDM juga boleh mencapai penukaran timbre, tiada pengisian dan resolusi super.

Dua gambar di bawah menunjukkan penukaran timbre daripada (1) perkusi kepada muzik ambien dan (2) trompet kepada nyanyian kanak-kanak.

Di bawah ialah perkusi kepada muzik ambien ( Berperingkat intensiti peralihan) kesan.

Kesan menukar bunyi trompet kepada bunyi kanak-kanak menyanyi (intensiti penukaran beransur-ansur).

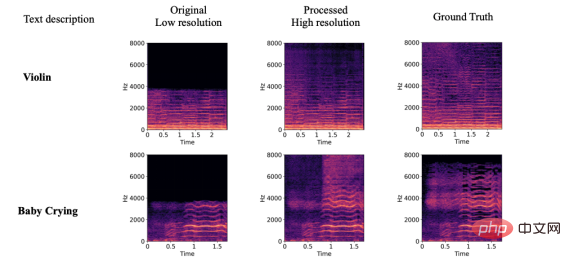

Di bawah ini kami akan menunjukkan kesan model pada resolusi super audio, pengisian hilang audio dan kawalan bahan bunyi. Oleh kerana panjang artikel yang terhad, audio dipaparkan terutamanya dalam bentuk spektrogram Pembaca yang berminat sila pergi ke laman utama projek AudioLDM: https://audioldm.github.io/

Dari segi resolusi super audio, AudioLDM juga sangat berkesan Berbanding dengan model resolusi super sebelumnya, AudioLDM ialah model resolusi super universal dan tidak terhad kepada pemprosesan muzik dan pertuturan.

Pada pengisian audio yang tiada, AudioLDM boleh mengisi kandungan audio yang berbeza mengikut teks yang diberikan, dan dalam Peralihan di sempadannya agak semula jadi.

Selain itu, AudioLDM juga menunjukkan keupayaan kawalan yang kuat, seperti persekitaran akustik, mood dan kelajuan muzik, bahan objek, pic dan jujukan pic, dll. Untuk keupayaan kawalan, pembaca yang berminat boleh menyemak keluar kertas atau halaman utama projek AudioLDM.

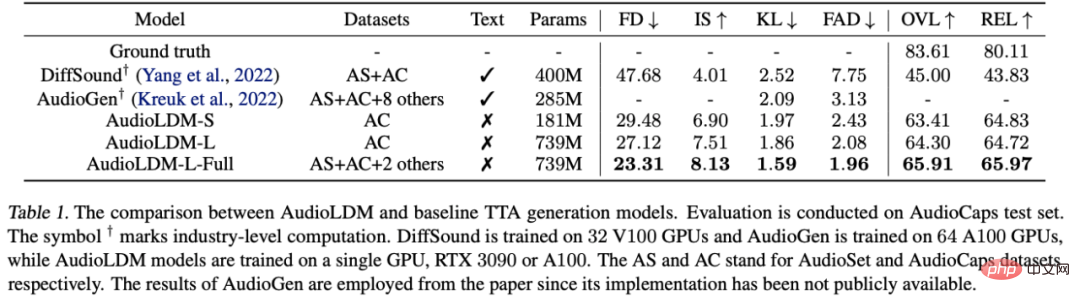

Dalam artikel itu, penulis membuat penilaian skor subjektif dan indeks objektif model AudioLDM, dan keputusan menunjukkan bahawa ia boleh melebihi model optimum sebelumnya dengan ketara:

Antaranya, AudioGen ialah model yang dicadangkan oleh Facebook pada Oktober 2022, menggunakan sepuluh set data, 64 GPU dan 285 MB parameter. Sebagai perbandingan, AudioLDM-S boleh mencapai hasil yang lebih baik dengan set data tunggal, 1 GPU dan 181 MB parameter.

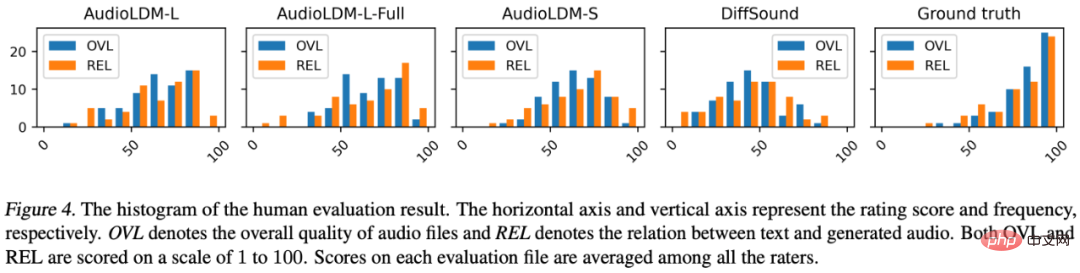

Pemarkahan subjektif juga menunjukkan bahawa AudioLDM jauh lebih baik daripada penyelesaian sebelumnya DiffSound. Jadi, apakah penambahbaikan yang telah dilakukan oleh AudioLDM untuk menjadikan model tersebut mempunyai prestasi yang begitu cemerlang?

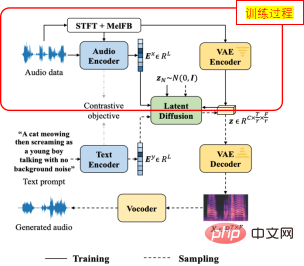

Pertama sekali, untuk menyelesaikan masalah pasangan data teks-audio yang terlalu sedikit, penulis mencadangkan kaedah penyeliaan sendiri untuk melatih AudioLDM.

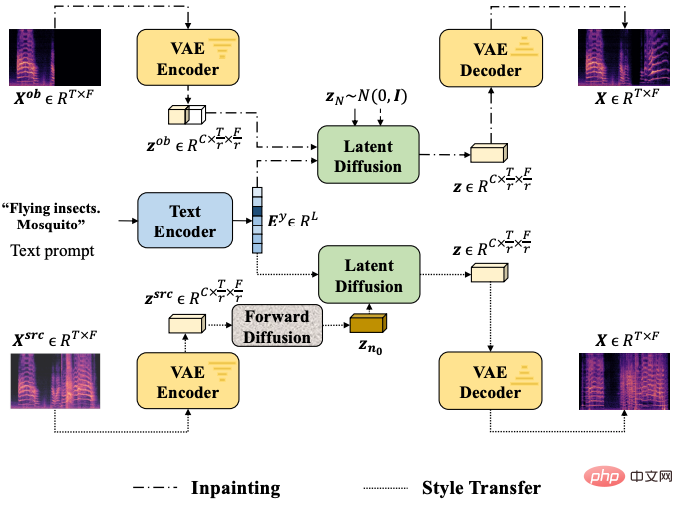

Khususnya, apabila melatih modul teras LDM, penulis menggunakan pembenaman audio itu sendiri sebagai syarat LDMs, keseluruhan proses tidak melibatkan penggunaan teks (seperti yang ditunjukkan dalam imej di atas). Skim ini adalah berdasarkan sepasang pengekod pembelajaran kontrastif teks audio yang telah dilatih (CLAP), yang telah menunjukkan keupayaan generalisasi yang baik dalam teks CLAP asal. AudioLDM mengambil kesempatan daripada keupayaan generalisasi yang sangat baik CLAP untuk mencapai latihan model pada data audio berskala besar tanpa memerlukan label teks.

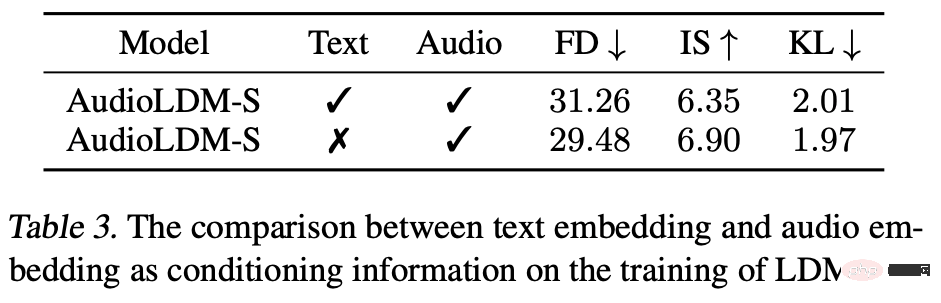

Malah, pengarang mendapati bahawa latihan dengan audio sahaja adalah lebih baik daripada menggunakan pasangan data teks audio:

Pengarang menganalisis dua sebab: (1) Anotasi teks itu sendiri sukar untuk memasukkan semua maklumat audio, seperti persekitaran akustik, taburan frekuensi, dll., mengakibatkan pembenaman teks tidak dapat mewakili audio dengan baik, ( 2) Kualiti teks itu sendiri tidak sempurna Contohnya, anotasi seperti "Boats: Battleships-5.25 conveyor space" adalah sukar bagi manusia untuk membayangkan bunyi tertentu. adalah, yang akan menyebabkan masalah dalam latihan model. Sebaliknya, menggunakan audio itu sendiri sebagai keadaan LDM boleh memastikan korelasi yang kukuh antara audio sasaran dan keadaan, dengan itu mencapai hasil penjanaan yang lebih baik.

Selain itu, penyelesaian Latent Diffusion yang diterima pakai oleh pengarang membolehkan model Diffusion dikira dalam ruang yang lebih kecil, sekali gus mengurangkan keperluan kuasa pengiraan model.

Banyak penerokaan terperinci dalam latihan dan struktur model turut membantu AudioLDM mencapai prestasi cemerlang.

Pengarang juga melukis gambar rajah struktur ringkas untuk memperkenalkan dua tugas hiliran utama:

Pengarang juga menjalankan eksperimen terperinci dengan struktur model yang berbeza, saiz model, langkah pensampelan DDIM dan Skala Bimbingan tanpa Pengelas yang berbeza.

Semasa mendedahkan model, penulis juga mendedahkan asas kod sistem penilaian model generatif mereka untuk menyatukan kaedah penilaian komuniti akademik mengenai isu tersebut pada masa hadapan, dengan itu memudahkan penerbitan daripada kertas kerja. Pasukan pengarang berkata ia akan Hadkan penggunaan model, terutamanya penggunaan komersial, untuk memastikan model hanya digunakan untuk komunikasi akademik, dan menggunakan LESEN dan perlindungan tera air yang sesuai untuk mengelakkan masalah etika.

Maklumat pengarang

Kertas ini mempunyai dua pengarang bersama: Liu Haohe (University of Surrey, UK) dan Chen Zehua (Imperial College London, UK).

Chen Zehua ialah pelajar kedoktoran di Imperial College London, belajar di bawah Profesor Danilo Mandic Beliau telah berkhidmat di Microsoft Speech Synthesis Research Group dan JD Artificial Intelligence Laboratory. Minat penyelidikannya termasuk model Generatif, sintesis pertuturan, penjanaan isyarat bioelektrik.

Atas ialah kandungan terperinci Model sumber terbuka, latihan kad tunggal, membawa anda memahami teknologi penjanaan audio berpandukan teks yang popular, AudioLDM. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk menyalin jadual Excel untuk menjadikannya saiz yang sama dengan yang asal

Bagaimana untuk menyalin jadual Excel untuk menjadikannya saiz yang sama dengan yang asal

Cara menggunakan suis Java

Cara menggunakan suis Java

Bagaimana untuk membaca fail teks dalam html

Bagaimana untuk membaca fail teks dalam html

jquery mengesahkan

jquery mengesahkan

Penggunaan item dalam python

Penggunaan item dalam python

Bagaimana untuk menyelesaikan ralat http 503

Bagaimana untuk menyelesaikan ralat http 503

Pengenalan kepada hubungan antara php dan front-end

Pengenalan kepada hubungan antara php dan front-end

Pengenalan kepada kegunaan pengaturcaraan python

Pengenalan kepada kegunaan pengaturcaraan python