Segmentasi panorama ialah tugas penglihatan asas yang bertujuan untuk menetapkan label semantik dan label contoh kepada setiap piksel imej. Label semantik menerangkan kategori setiap piksel (cth. langit, objek menegak, dsb.), dan label contoh memberikan ID unik untuk setiap tika dalam imej (untuk membezakan tika berbeza bagi kategori yang sama). Tugasan ini menggabungkan pembahagian semantik dan pembahagian contoh untuk memberikan maklumat semantik yang kaya tentang adegan.

Walaupun kategori label semantik ditetapkan secara priori, ID tika yang diberikan kepada objek dalam imej boleh ditukar ganti tanpa menjejaskan pengecaman. Contohnya, menukar ID contoh dua kenderaan tidak menjejaskan keputusan. Oleh itu, rangkaian saraf yang dilatih untuk meramalkan ID contoh seharusnya dapat mempelajari pemetaan satu-ke-banyak daripada satu imej kepada beberapa penetapan ID contoh. Mempelajari pemetaan satu-ke-banyak adalah mencabar, dan kaedah tradisional sering menggunakan saluran paip berbilang peringkat termasuk pengesanan objek, pembahagian dan penggabungan berbilang ramalan. Baru-baru ini, berdasarkan padanan graf dwipartit boleh dibezakan, sesetengah sarjana telah mencadangkan kaedah hujung ke hujung yang boleh menukar pemetaan satu-ke-banyak dengan berkesan kepada pemetaan satu dengan satu berdasarkan padanan pengecaman. Walau bagaimanapun, kaedah ini masih memerlukan seni bina tersuai dan fungsi kehilangan khusus, serta bias induktif terbina dalam untuk tugas pembahagian panorama.

Model visi tujuan umum terkini, seperti Pix2Seq, OFA, UViM dan Unified I/O, menyokong rangka kerja umum tanpa had untuk mencapai tugas generalisasi sambil menjadi lebih berkebolehan berbanding sebelum ini sebelum Model ini lebih mudah. Sebagai contoh, Pix2Seq menjana satu siri urutan bermakna secara semantik berdasarkan imej untuk menyelesaikan beberapa tugas visual teras, dan model ini berdasarkan Transformers untuk melatih model autoregresif.

Dalam kertas baharu, penyelidik seperti Ting Chen dan Geoffrey Hinton dari Google Brain mengikuti konsep yang sama dan memahami masalah tugasan pensegmenan panorama daripada perspektif penjanaan data diskret bersyarat.

Pautan kertas https://arxiv.org/pdf/2210.06366.pdf

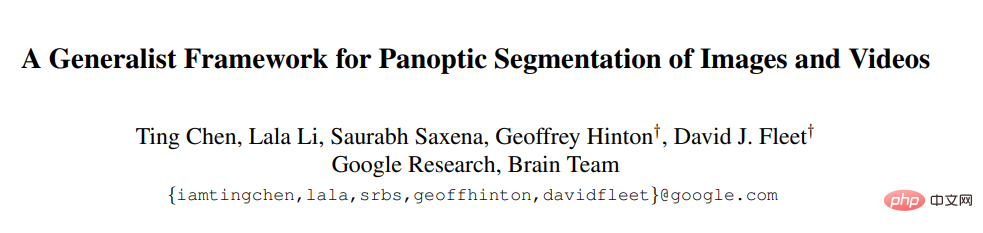

Seperti yang ditunjukkan dalam Rajah 1, penyelidik mereka bentuk model generatif untuk topeng panorama dan menghasilkan satu set token diskret untuk setiap input gambar kepada model. Pengguna boleh menggunakan model ini pada data video (data dalam talian/media penstriman) hanya dengan menggunakan ramalan daripada bingkai lalu sebagai isyarat bersyarat tambahan. Dengan cara ini, model secara automatik belajar untuk menjejak dan membahagikan objek.

Pemodelan generatif bagi segmentasi panorama sangat mencabar kerana topeng panoramik adalah diskret, atau kategorikal, dan modelnya Mungkin sangat besar. Contohnya, untuk menjana topeng panorama 512×1024, model mesti menjana lebih daripada 1M teg diskret (label semantik dan contoh). Ini masih agak mahal untuk model autoregresif kerana token bersifat berurutan dan sukar untuk diubah apabila skala data input berubah. Model resapan lebih baik dalam mengendalikan data berdimensi tinggi, tetapi ia paling kerap digunakan dalam domain berterusan dan bukannya diskret. Dengan mewakili data diskret dengan bit analog, penulis menunjukkan bahawa model resapan boleh dilatih secara langsung pada topeng panorama yang besar tanpa perlu mempelajari ruang terpendam.

Melalui eksperimen yang meluas, para penyelidik menunjukkan bahawa kaedah am mereka boleh bersaing dengan kaedah pakar terkini dalam persekitaran yang serupa.

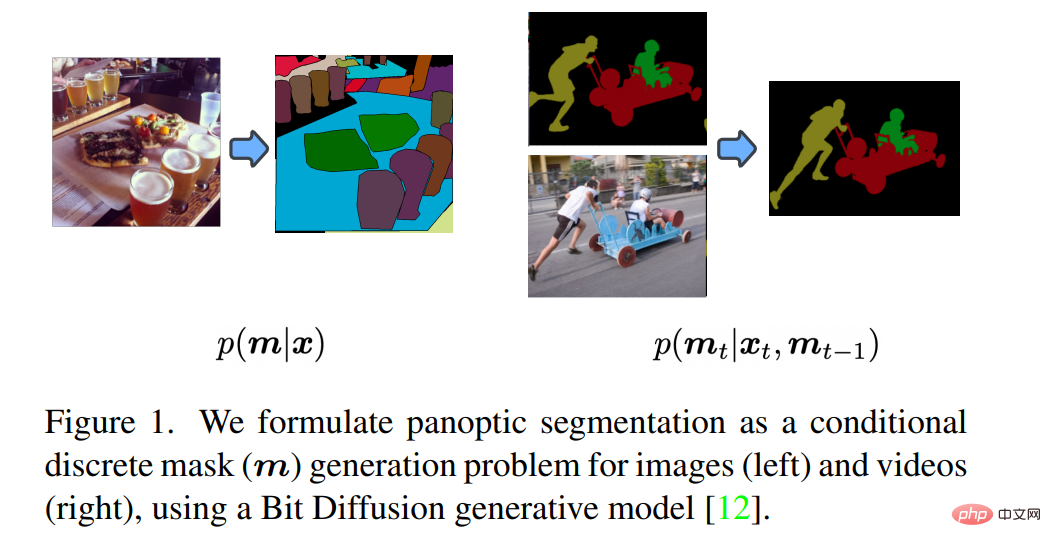

Pensampelan model resapan dilakukan secara berulang, jadi penyebaran ke hadapan rangkaian mesti dijalankan beberapa kali semasa inferens. Oleh itu, seperti yang ditunjukkan dalam Rajah 2, penyelidik sengaja membahagikan rangkaian kepada dua komponen: 1) pengekod imej 2) penyahkod topeng. Bekas memetakan data piksel mentah kepada vektor perwakilan peringkat tinggi, dan kemudian penyahkod topeng secara berulang membaca topeng panorama.

Pengekod Pixel/Imej

Pengekod ialah rangkaian yang memetakan imej asal  ke peta ciri dalam

ke peta ciri dalam  , di mana H' dan w' ialah ketinggian topeng panoramik dan lebar. Topeng panorama boleh sama saiz dengan imej asal atau lebih kecil. Dalam kerja ini, penyelidik menggunakan ResNet sebagai rangkaian tulang belakang dan kemudian menggunakan lapisan pengekod Transformer sebagai pengekstrak ciri. Untuk memastikan peta ciri keluaran mempunyai resolusi yang mencukupi dan mengandungi ciri skala yang berbeza, diilhamkan oleh U-Net dan rangkaian piramid ciri, penyelidik menggunakan konvolusi dengan sambungan dua hala dan operasi pensampelan untuk bergabung daripada ciri resolusi yang berbeza. Walaupun pengekod yang lebih kompleks boleh digunakan, yang boleh menggunakan beberapa kemajuan terkini dalam reka bentuk seni bina, ini bukanlah fokus utama model rangkaian, jadi penyelidik hanya menggunakan pengekstrak ciri yang lebih mudah untuk menggambarkan peranannya dalam model.

, di mana H' dan w' ialah ketinggian topeng panoramik dan lebar. Topeng panorama boleh sama saiz dengan imej asal atau lebih kecil. Dalam kerja ini, penyelidik menggunakan ResNet sebagai rangkaian tulang belakang dan kemudian menggunakan lapisan pengekod Transformer sebagai pengekstrak ciri. Untuk memastikan peta ciri keluaran mempunyai resolusi yang mencukupi dan mengandungi ciri skala yang berbeza, diilhamkan oleh U-Net dan rangkaian piramid ciri, penyelidik menggunakan konvolusi dengan sambungan dua hala dan operasi pensampelan untuk bergabung daripada ciri resolusi yang berbeza. Walaupun pengekod yang lebih kompleks boleh digunakan, yang boleh menggunakan beberapa kemajuan terkini dalam reka bentuk seni bina, ini bukanlah fokus utama model rangkaian, jadi penyelidik hanya menggunakan pengekstrak ciri yang lebih mudah untuk menggambarkan peranannya dalam model.

Penyahkod topeng

Penyahkod diperhalusi secara berulang berdasarkan ciri imej semasa inferens model. Secara khusus, penyahkod topeng yang digunakan oleh penyelidik ialah TransUNet. Rangkaian mengambil sebagai input penggabungan peta ciri imej daripada pengekod dan topeng hingar (sama ada dimulakan secara rawak atau berulang daripada proses pengekodan) dan mengeluarkan ramalan yang tepat bagi topeng. Satu perbezaan antara penyahkod dan seni bina U-Net standard untuk penjanaan imej dan penukaran imej-ke-imej ialah U-Net yang digunakan dalam kertas kerja ini menggunakan lapisan penyahkod pengubah dengan lapisan perhatian silang di atas sebelum pensampelan tinggi untuk digabungkan ciri imej yang dikodkan.

Aplikasi dalam mod video

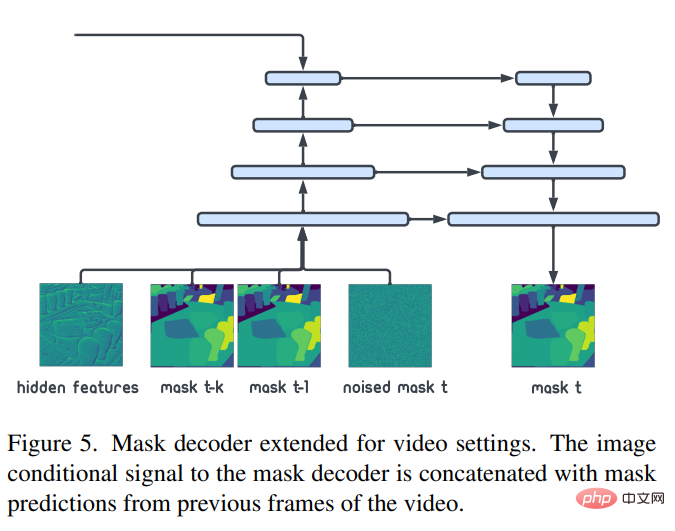

Para penyelidik memodelkan topeng panorama di bawah keadaan imej sebagai :p(m|x ). Berdasarkan topeng tiga dimensi bagi video tertentu (dengan dimensi temporal tambahan), model kami boleh digunakan secara langsung pada pembahagian panorama video. Untuk menyesuaikan diri dengan tetapan video dalam talian/strim, pemodelan p(m_t|x_t,m_(t-1),m_(t-k)) boleh digunakan untuk menjana panorama baharu berdasarkan imej semasa dan topeng sebelumnya. seketika. Seperti yang ditunjukkan dalam Rajah 5, perubahan ini boleh dicapai dengan menggabungkan topeng panoramik lalu (m_(t-1),m_(t-k)) dengan topeng hingar sedia ada. Selain daripada perubahan kecil ini, semua yang lain adalah sama seperti model asas video (p(m|x)). Model ini sangat mudah dan boleh digunakan pada adegan video dengan memperhalusi model panorama imej.

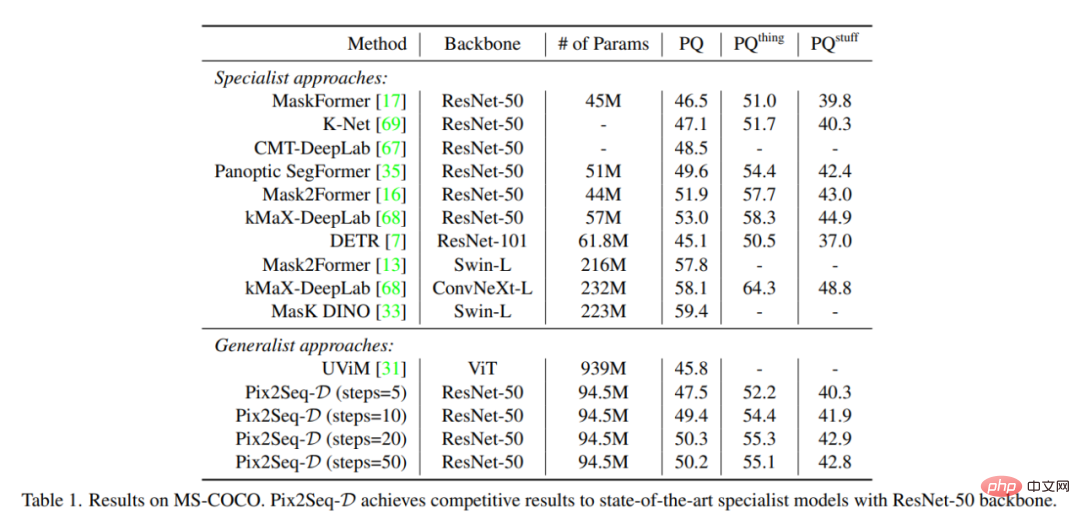

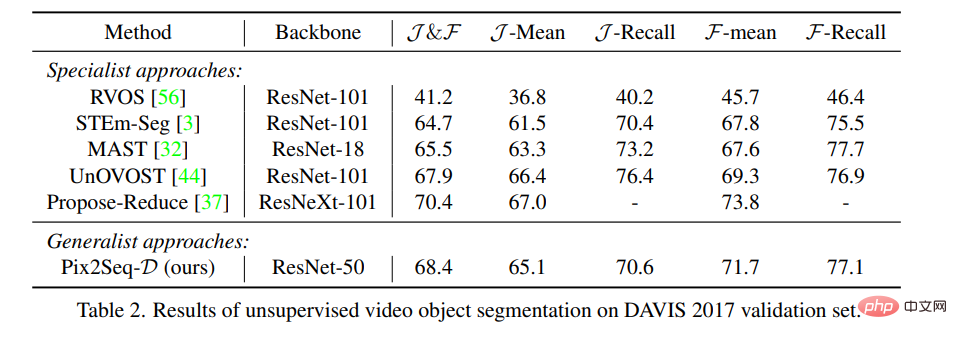

Kertas kerja ini membandingkan dengan dua siri kaedah terkini iaitu kaedah pakar dan umum kaedah. Jadual 1 meringkaskan keputusan pada dataset MS-COCO. Kualiti generalisasi (PQ) Pix2Seq-D pada tulang belakang berasaskan ResNet-50 adalah kompetitif dengan kaedah terkini. Berbanding dengan model tujuan umum terkini yang lain seperti UViM, model kami menunjukkan prestasi yang lebih baik dengan ketara sambil lebih cekap.

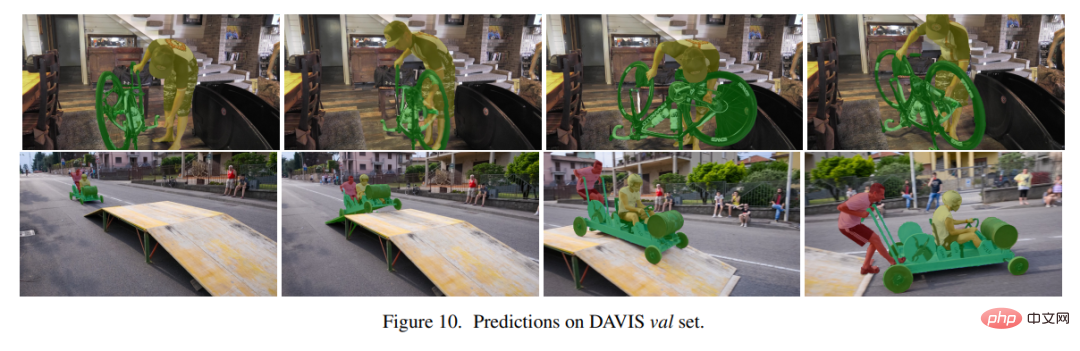

Jadual 2 Membandingkan Pix2Seq-D dengan kaedah terkini untuk pembahagian objek video tanpa pengawasan pada set data DAVIS, menggunakan metrik Standard J&F . Perlu diingat bahawa garis dasar tidak termasuk model umum lain kerana ia tidak terpakai secara langsung untuk tugas itu. Kaedah kami mencapai hasil yang sama seperti kaedah terkini tanpa reka bentuk khas.

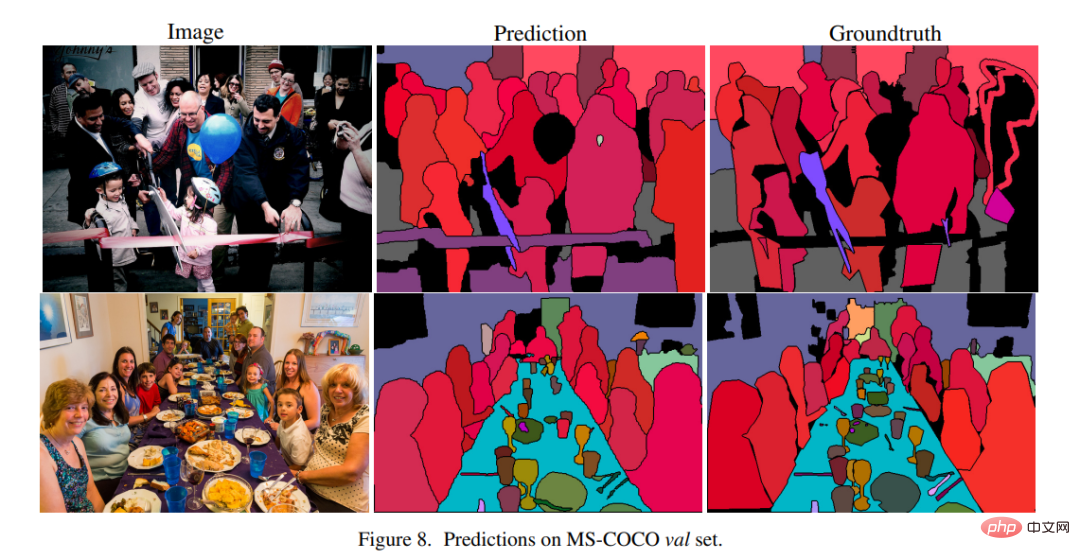

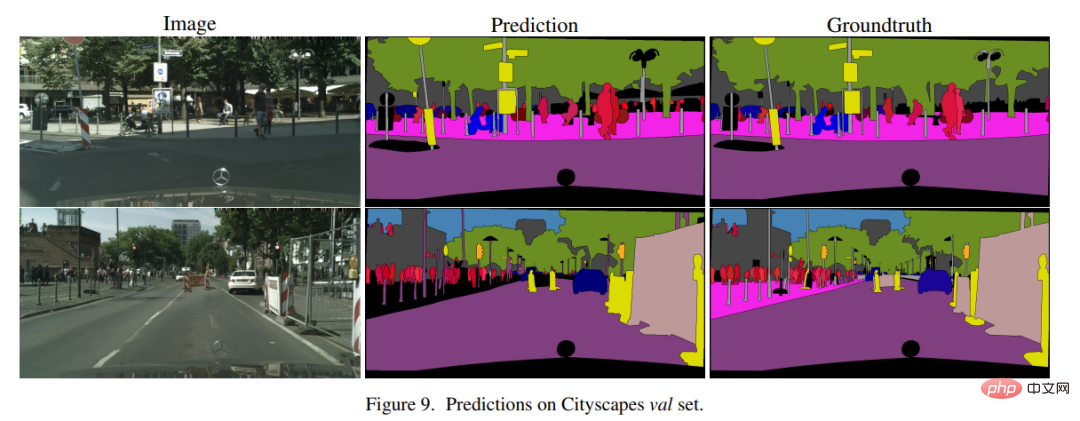

Rajah 8, 9 dan 10 menunjukkan contoh keputusan Pix2Seq-D pada MS-COCO, Cityscape dan DAVIS.

Atas ialah kandungan terperinci Adakah ia benar-benar selembut sutera itu? Kumpulan Hinton mencadangkan rangka kerja pembahagian contoh berdasarkan topeng panorama yang besar, yang membolehkan penukaran adegan imej dan video dengan lancar.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pengenalan kepada maksud tetingkap muat turun awan

Pengenalan kepada maksud tetingkap muat turun awan

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

Penyelesaian kepada penetapan vscode antara muka Cina tidak berkuat kuasa

Bagaimana untuk menutup port 135 445

Bagaimana untuk menutup port 135 445

Mengapakah pemacu keras mudah alih begitu lambat dibuka?

Mengapakah pemacu keras mudah alih begitu lambat dibuka?

Bagaimana untuk menggunakan split dalam python

Bagaimana untuk menggunakan split dalam python

skrin telefon bimbit tft

skrin telefon bimbit tft

Bagaimana untuk mengubah saiz gambar dalam ps

Bagaimana untuk mengubah saiz gambar dalam ps

0x80070057 penyelesaian ralat parameter

0x80070057 penyelesaian ralat parameter