Apabila saiz model bahasa dan korpora berkembang secara beransur-ansur, model bahasa besar (LLM) menunjukkan lebih potensi. Beberapa kajian baru-baru ini telah menunjukkan bahawa LLM boleh menggunakan pembelajaran dalam konteks (ICL) untuk melaksanakan pelbagai tugas yang kompleks, seperti menyelesaikan masalah penaakulan matematik.

Sepuluh penyelidik dari Universiti Peking, Shanghai AI Lab dan University of California, Santa Barbara baru-baru ini menerbitkan kertas ulasan tentang pembelajaran dalam konteks, menggabungkan penyelidikan ICL dengan terperinci kemajuan semasa.

Alamat kertas: https://arxiv.org/pdf/2301.00234v1.pdf

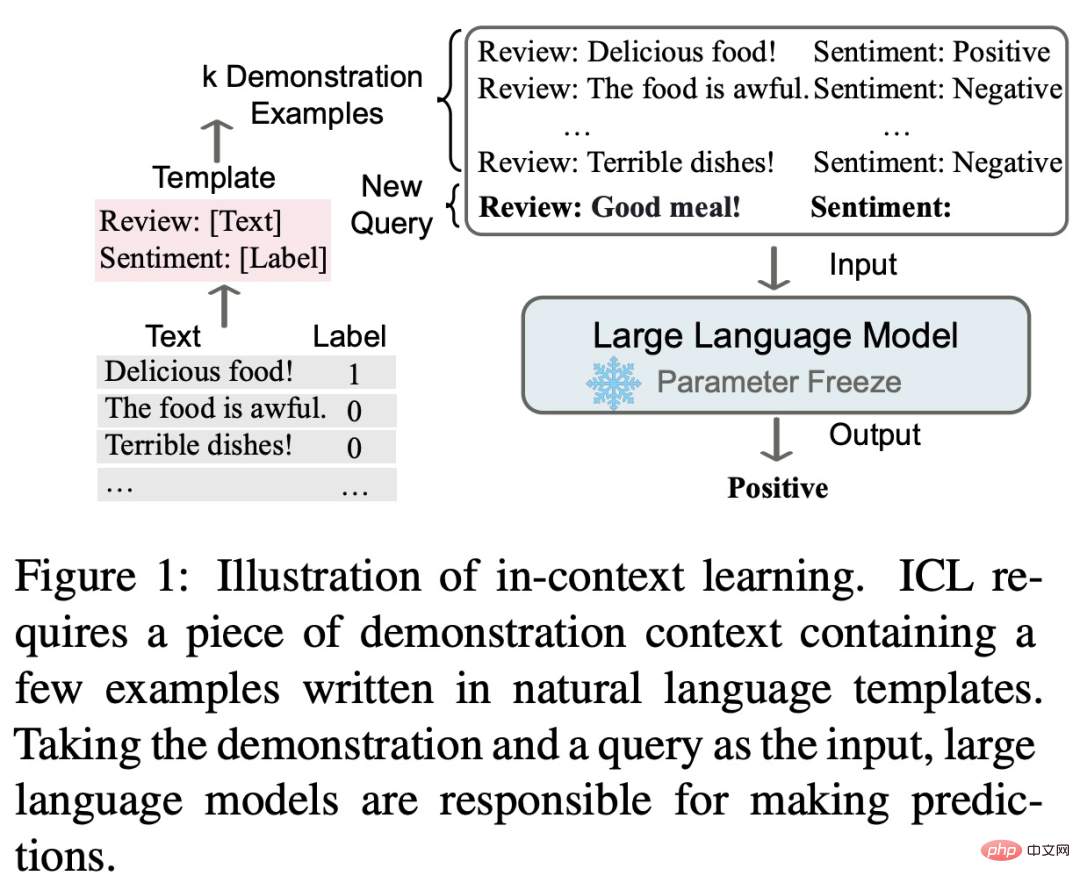

Idea teras pembelajaran dalam konteks ialah pembelajaran analogi Rajah di bawah menerangkan cara model bahasa menggunakan ICL untuk membuat keputusan.

Pertama, ICL memerlukan beberapa contoh untuk membentuk konteks demonstrasi, dan contoh ini biasanya ditulis dalam templat bahasa semula jadi. ICL kemudiannya mengaitkan soalan pertanyaan dengan konteks pembentangan untuk membentuk gesaan, dan menyuapkannya ke dalam model bahasa untuk ramalan. Tidak seperti fasa latihan pembelajaran terselia, yang memerlukan pengemaskinian parameter model menggunakan kecerunan songsang, ICL tidak memerlukan kemas kini parameter untuk membenarkan model bahasa pra-latihan melaksanakan tugas ramalan secara langsung, dan model dijangka mempelajari corak tersembunyi dalam demonstrasi. contoh dan membuat keputusan berdasarkan ramalan yang betul.

Sebagai paradigma baharu, ICL mempunyai banyak kelebihan yang menarik. Pertama, contoh tunjuk cara ditulis dalam format bahasa semula jadi, yang menyediakan antara muka yang boleh ditafsir untuk berkaitan dengan model bahasa yang besar. Paradigma ini memudahkan untuk memasukkan pengetahuan manusia ke dalam model bahasa dengan menukar contoh dan templat demonstrasi (Liu et al., 2022; Lu et al., 2022; Wu et al., 2022; Wei et al., 2022c). Kedua, pembelajaran dalam konteks adalah sama dengan proses membuat keputusan pembelajaran manusia melalui analogi. Ketiga, berbanding dengan latihan yang diselia, ICL ialah rangka kerja pembelajaran tanpa latihan. Ini bukan sahaja dapat mengurangkan kos pengiraan untuk menyesuaikan model kepada tugas baharu, tetapi juga menjadikan Model Bahasa sebagai Perkhidmatan (LMaaS, Sun et al., 2022) mungkin dan mudah digunakan untuk tugas dunia sebenar berskala besar.

Walaupun ICL memegang janji yang besar, masih terdapat banyak isu yang patut diterokai, termasuk prestasinya. Sebagai contoh, model asal GPT-3 mempunyai keupayaan ICL tertentu, tetapi beberapa kajian mendapati bahawa keupayaan ini boleh dipertingkatkan dengan ketara melalui penyesuaian semasa pra-latihan. Tambahan pula, prestasi ICL adalah sensitif kepada tetapan tertentu, termasuk templat segera, pemilihan sampel kontekstual dan pesanan sampel. Di samping itu, walaupun mekanisme kerja ICL kelihatan munasabah, ia masih belum cukup jelas, dan tidak banyak kajian yang dapat menjelaskan mekanisme kerjanya secara awal.

Kertas kajian ini menyimpulkan bahawa prestasi hebat ICL bergantung pada dua peringkat:

Semasa fasa latihan, model bahasa dilatih secara langsung mengenai matlamat pemodelan bahasa, seperti generasi kiri ke kanan. Walaupun model ini tidak dioptimumkan secara khusus untuk pembelajaran dalam konteks, keupayaan ICL masih mengejutkan. Penyelidikan ICL sedia ada pada asasnya berdasarkan model bahasa yang terlatih.

Dalam peringkat inferens, memandangkan label input dan output diwakili oleh templat bahasa semula jadi yang boleh ditafsir, prestasi ICL boleh dioptimumkan daripada pelbagai perspektif. Kertas ulasan ini menyediakan penerangan dan perbandingan terperinci, memilih contoh yang sesuai untuk demonstrasi, dan mereka bentuk kaedah pemarkahan khusus untuk tugasan yang berbeza.

Kandungan umum dan struktur kertas ulasan ini ditunjukkan dalam rajah di bawah, termasuk: definisi formal ICL (§3), kaedah pemanasan (§4), strategi reka bentuk segera ( §5 ) dan fungsi pemarkahan (§6).

Selain itu, §7 memberikan pandangan tentang usaha semasa untuk mendedahkan cara kerja di sebalik ICL. §8 selanjutnya menyediakan penilaian dan sumber yang berguna untuk ICL, dan §9 memperkenalkan senario aplikasi yang berpotensi yang menunjukkan keberkesanan ICL. Akhir sekali, §10 meringkaskan cabaran sedia ada dan hala tuju yang berpotensi dalam bidang ICL untuk menyediakan rujukan untuk pembangunan selanjutnya bidang tersebut.

Pembaca yang berminat boleh membaca teks asal kertas untuk mengetahui lebih lanjut butiran penyelidikan.

Atas ialah kandungan terperinci Apakah status pembangunan semasa Pembelajaran Dalam Konteks, yang didorong oleh GPT? Ulasan ini menjelaskannya. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah perisian anti-virus?

Apakah perisian anti-virus?

Platform mata wang digital domestik

Platform mata wang digital domestik

Bagaimana untuk mengkonfigurasi pembolehubah persekitaran Tomcat

Bagaimana untuk mengkonfigurasi pembolehubah persekitaran Tomcat

Apakah maksud c#?

Apakah maksud c#?

Bagaimana untuk memulihkan fail yang dipadam secara kekal pada komputer

Bagaimana untuk memulihkan fail yang dipadam secara kekal pada komputer

Bagaimana untuk membuka fail html pada telefon bimbit

Bagaimana untuk membuka fail html pada telefon bimbit

Kaedah pemulihan pangkalan data Oracle

Kaedah pemulihan pangkalan data Oracle

Bagaimana untuk menyelesaikan masalah semasa menghuraikan pakej

Bagaimana untuk menyelesaikan masalah semasa menghuraikan pakej