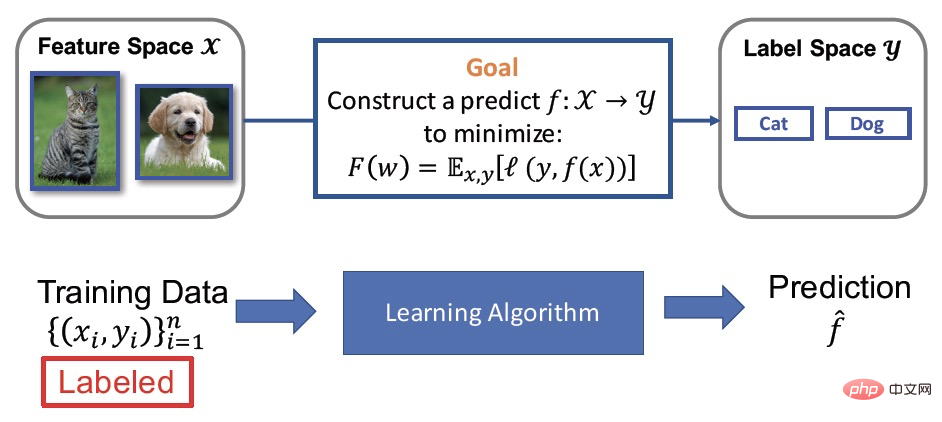

Pembelajaran Terselia

Kami tahu tujuan latihan model sebenarnya adalah untuk mempelajari fungsi ramalan Secara matematik, ini boleh digambarkan sebagai fungsi pemetaan pembelajaran daripada data (X) kepada label (y). Pembelajaran diselia adalah salah satu kaedah latihan model yang paling biasa digunakan Penambahbaikan kesannya bergantung pada sejumlah besar data latihan yang dilabel dengan baik, yang dipanggil jumlah besar data berlabel ((X,y)). Walau bagaimanapun, data pelabelan selalunya memerlukan banyak tenaga kerja dan sumber bahan, dsb. Oleh itu, sementara kesannya diperbaiki, ia juga akan membawa masalah kos yang tinggi. Dalam aplikasi praktikal, sering dijumpai bahawa terdapat sejumlah kecil data berlabel dan sejumlah besar data tidak berlabel Hasil pembelajaran separa penyeliaan juga telah menarik lebih banyak perhatian daripada pekerja saintifik.

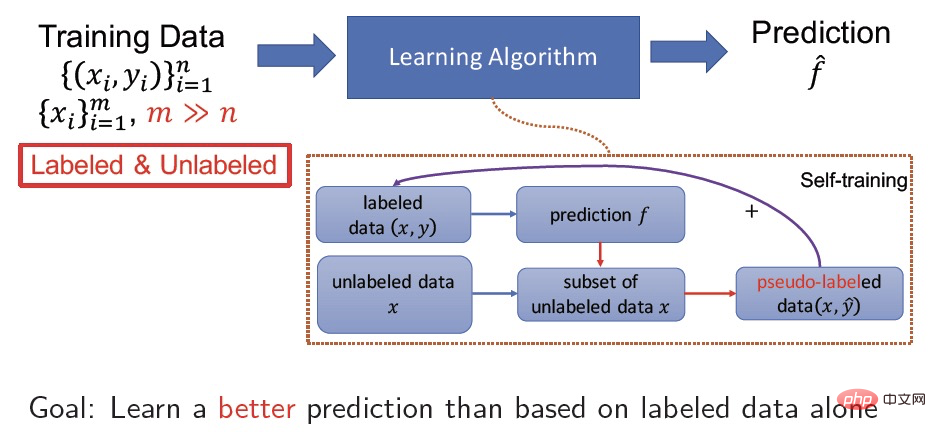

Pembelajaran Separuh Penyeliaan

Pembelajaran Separuh Penyeliaan belajar secara serentak daripada sejumlah kecil data berlabel dan sejumlah besar data tidak berlabel, dan tujuannya adalah untuk meningkatkan ketepatan model dengan bantuan data tidak berlabel. Sebagai contoh, latihan kendiri ialah kaedah pembelajaran separa penyeliaan yang sangat biasa. data tidak berlabel X Pseudo label  membantu model mencapai penumpuan yang lebih baik dan meningkatkan ketepatan dengan terus melaksanakan pembelajaran terselia pada data label pseudo (X,

membantu model mencapai penumpuan yang lebih baik dan meningkatkan ketepatan dengan terus melaksanakan pembelajaran terselia pada data label pseudo (X,  ).

).

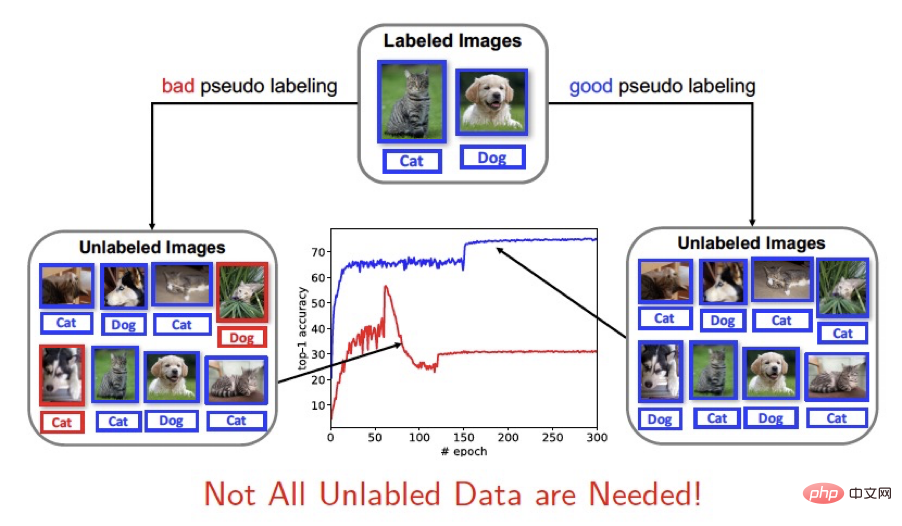

Penyelesaian masalah teras

Rangka kerja pembelajaran separa penyeliaan sedia ada penggunaan data tidak berlabel boleh dibahagikan secara kasar kepada dua jenis Satu adalah untuk mengambil bahagian dalam latihan sepenuhnya, dan satu lagi adalah untuk menggunakan ambang tetap untuk memilih sampel dengan keyakinan yang lebih tinggi untuk latihan (seperti FixMatch). Memandangkan penggunaan data tidak berlabel oleh pembelajaran separa diselia bergantung pada label pseudo yang diramalkan oleh model semasa, ketepatan label pseudo akan memberi kesan yang lebih besar pada latihan model keputusan ramalan yang baik akan membantu penumpuan dan ketepatan model. Untuk pembelajaran model baharu, keputusan ramalan yang lemah akan mengganggu latihan model. Jadi kami fikir: Tidak semua sampel tidak berlabel diperlukan!

Kertas kerja ini secara inovatif mencadangkan penggunaan ambang dinamik (ambang dinamik) Sebagai kaedah daripada menyaring sampel tidak berlabel untuk pembelajaran separa penyeliaan (SSL), kami mengubah rangka kerja latihan pembelajaran separa penyeliaan dan menambah baik strategi pemilihan sampel tidak berlabel semasa proses latihan dengan mengubah ambang secara dinamik Pilih sampel tidak berlabel yang lebih berkesan untuk latihan. Dash ialah strategi umum yang boleh disepadukan dengan mudah dengan kaedah pembelajaran separa penyeliaan sedia ada. Secara eksperimen, kami mengesahkan sepenuhnya keberkesanannya pada set data standard seperti CIFAR-10, CIFAR-100, STL-10 dan SVHN. Secara teori, kertas itu membuktikan sifat penumpuan algoritma Dash dari perspektif pengoptimuman bukan cembung.

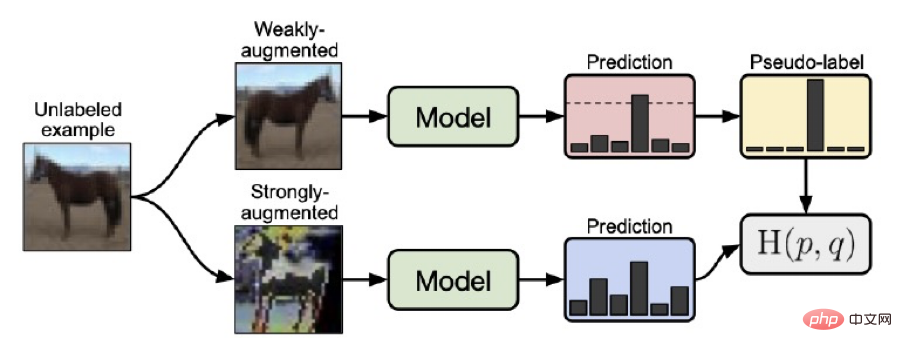

Rangka kerja latihan Fixmatch

Sebelum memperkenalkan kaedah Dash kami, kami memperkenalkan algoritma FixMatch yang dicadangkan oleh Google, kaedah pembelajaran separa penyeliaan yang menggunakan ambang tetap untuk memilih sampel tidak berlabel. Rangka kerja latihan FixMatch ialah penyelesaian SOTA sebelumnya. Perkara utama bagi keseluruhan rangka kerja pembelajaran boleh diringkaskan sebagai perkara berikut:

1 Untuk data tidak berlabel, sampel yang diperoleh melalui peningkatan data yang lemah (melintang mendatar, mengimbangi, dll.) adalah. diperoleh melalui model semasa Nilai ramalan

2 Untuk sampel yang diperolehi oleh peningkatan data kukuh (RA atau CTA) bagi data tidak berlabel, nilai ramalan diperoleh melalui model semasa <.>

3 Gunakan hasil peningkatan data yang lemah dengan keyakinan tinggi untuk membentuk pseudo label  melalui satu kaedah panas, dan kemudian gunakan

melalui satu kaedah panas, dan kemudian gunakan  dan Nilai

dan Nilai  untuk melatih model.

untuk melatih model.

Kelebihan fixmatch ialah ia menggunakan data yang dipertingkatkan dengan lemah untuk meramalkan label pseudo, yang meningkatkan ketepatan ramalan label pseudo dan menggunakan ambang tetap 0.95 semasa proses latihan (sepadan kepada kehilangan 0.0513 ) Pilih sampel ramalan dengan keyakinan tinggi (ambang lebih besar daripada atau sama dengan 0.95, iaitu kehilangan kurang daripada atau sama dengan 0.0513) untuk menjana label pseudo, yang seterusnya menstabilkan proses latihan.

Rangka kerja latihan sengkang

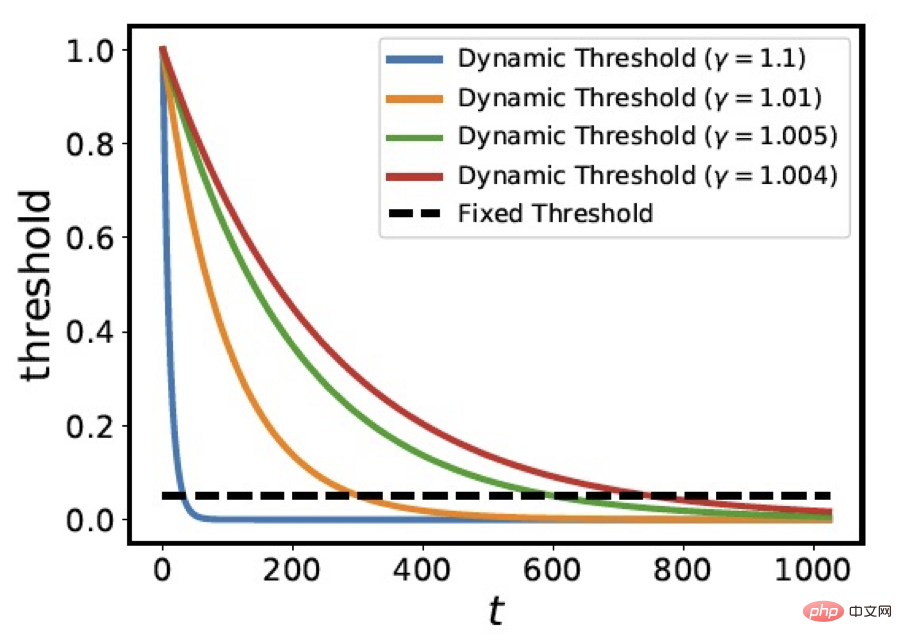

Untuk masalah memilih semua pseudo-label dan memilih pseudo-label dengan ambang tetap, kami secara Inovatif mencadangkan strategi menggunakan ambang dinamik untuk penyaringan sampel. Iaitu, ambang dinamik mereput dengan t

dengan C=1.0001,  ialah purata kehilangan data berlabel selepas zaman pertama, kami memilih

ialah purata kehilangan data berlabel selepas zaman pertama, kami memilih  sampel tidak berlabel untuk mengambil bahagian dalam perambatan balik kecerunan. Rajah di bawah menunjukkan lengkung variasi ambang

sampel tidak berlabel untuk mengambil bahagian dalam perambatan balik kecerunan. Rajah di bawah menunjukkan lengkung variasi ambang  di bawah nilai

di bawah nilai  yang berbeza. Anda boleh melihat bahawa parameter

yang berbeza. Anda boleh melihat bahawa parameter  mengawal kadar penurunan keluk ambang. Lengkung perubahan

mengawal kadar penurunan keluk ambang. Lengkung perubahan  adalah serupa dengan aliran penurunan fungsi kehilangan apabila mensimulasikan model latihan.

adalah serupa dengan aliran penurunan fungsi kehilangan apabila mensimulasikan model latihan.

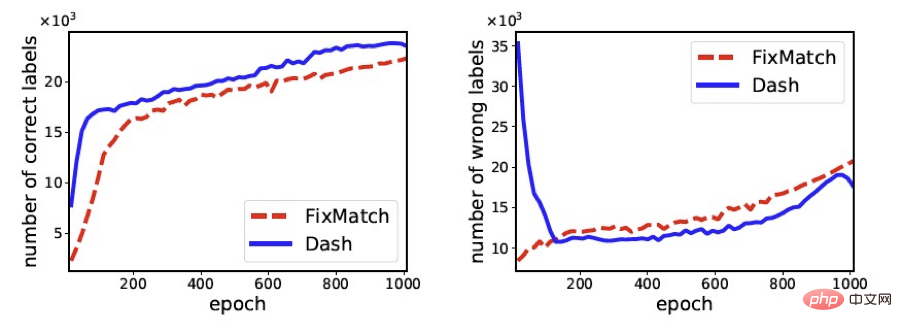

Rajah berikut membandingkan bilangan sampel yang betul dan bilangan sampel yang salah yang dipilih oleh FixMath dan Dash semasa latihan proses semasa latihan berjalan berubah (set data yang digunakan ialah cifar100). Ia boleh dilihat dengan jelas daripada rajah bahawa berbanding dengan FixMatch, Dash boleh memilih lebih banyak sampel dengan label yang betul dan lebih sedikit sampel dengan label yang salah, yang akhirnya membantu meningkatkan ketepatan model latihan.

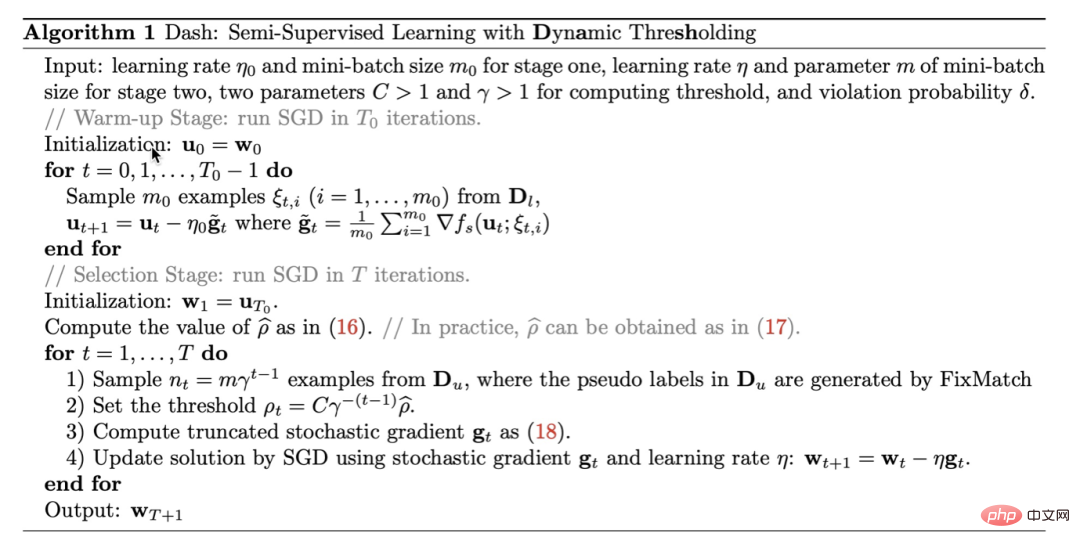

Algoritma kami boleh diringkaskan seperti berikut Algoritma 1. Dash ialah strategi umum yang boleh disepadukan dengan mudah dengan kaedah pembelajaran separa penyeliaan sedia ada. Untuk kemudahan, dalam percubaan artikel ini kami menyepadukan Dash dengan FixMatch. Untuk lebih banyak bukti teori, lihat kertas.

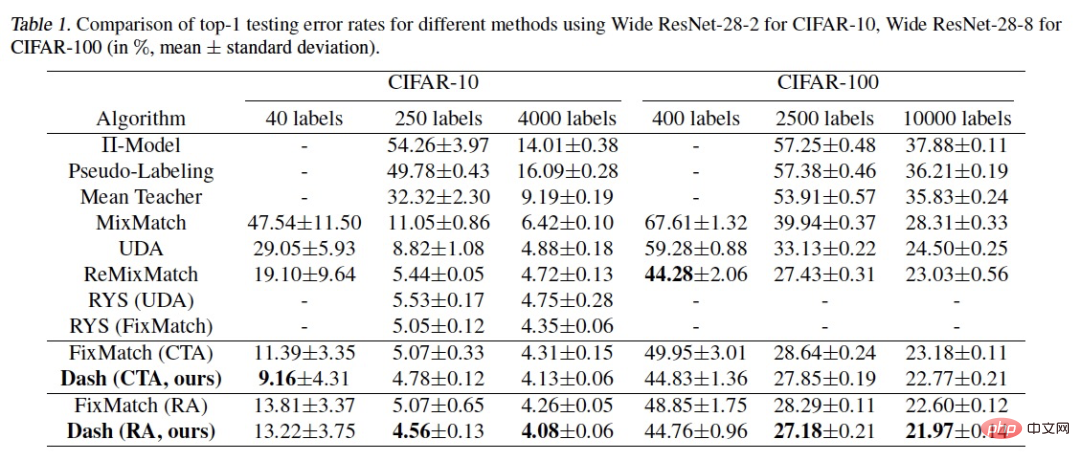

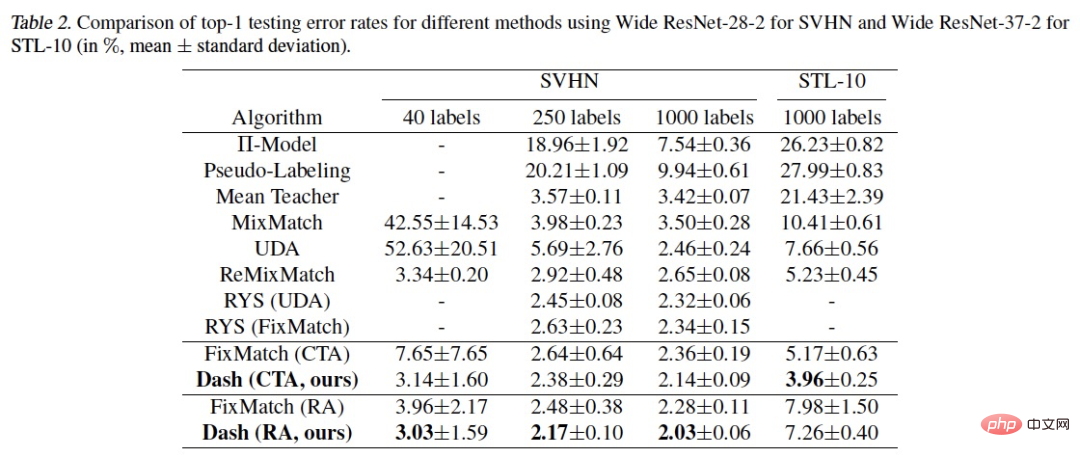

Kami menggunakan set data biasa dalam pembelajaran separa penyeliaan: CIFAR-10, CIFAR-100, STL -10 Algoritma telah disahkan pada SVHN. Keputusannya adalah seperti berikut:

Dapat dilihat bahawa kaedah kami telah mencapai keputusan yang lebih baik dalam pelbagai eksperimen. tetapan. SOTA mempunyai hasil yang lebih baik. Apa yang perlu dijelaskan ialah percubaan pada CIFAR-100 400label menggunakan helah penjajaran data tambahan untuk mencapai hasil yang lebih baik. boleh dicapai , lebih rendah daripada kadar ralat 44.28% ReMixMatch.

Dalam proses penyelidikan dan pembangunan sebenar model berorientasikan domain tugasan, rangka kerja Dash separa diselia sering digunakan. Seterusnya, saya ingin memperkenalkan kepada anda model percuma sumber terbuka yang telah kami bangunkan dalam pelbagai domain Anda dialu-alukan untuk mengalami dan memuat turun (anda boleh mengalaminya pada kebanyakan telefon mudah alih):

.Atas ialah kandungan terperinci Rangka kerja pembelajaran separa penyeliaan sumber terbuka Damo Academy, Dash menyegarkan banyak SOTA. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!