Disebabkan mekanisme perhatian dan reka bentuk model yang kompleks, kebanyakan pengubah visual (ViT) sedia ada tidak dapat berfungsi dengan cekap seperti rangkaian saraf konvolusi (CNN) dalam senario penggunaan industri dunia sebenar. Ini menimbulkan persoalan: bolehkah rangkaian saraf visual membuat kesimpulan sepantas CNN dan sekuat ViT?

Beberapa karya baru-baru ini telah cuba mereka bentuk seni bina hibrid CNN-Transformer untuk menyelesaikan masalah ini, tetapi prestasi keseluruhan kerja ini adalah jauh dari memuaskan. Berdasarkan ini, penyelidik dari ByteDance mencadangkan Transformer visual generasi akan datang—Next-ViT—yang boleh digunakan dengan berkesan dalam senario industri kehidupan sebenar. Daripada perspektif tukar ganti kependaman/ketepatan, prestasi Next-ViT adalah setanding dengan CNN dan ViT yang sangat baik.

Alamat kertas: https://arxiv.org/pdf/2207.05501.pdf

Pasukan penyelidik Next-ViT menggunakan mekanisme mesra untuk menangkap maklumat tempatan dan global dengan membangunkan blok konvolusi novel (NCB) dan blok Transformer (NTB). Kajian itu kemudiannya mencadangkan strategi hibrid baru NHS yang bertujuan untuk menyusun NCB dan NTB dalam paradigma hibrid yang cekap untuk meningkatkan prestasi pelbagai tugas hiliran.

Eksperimen yang meluas menunjukkan bahawa Next-ViT dengan ketara mengatasi prestasi seni bina hibrid CNN, ViT dan CNN-Transformer sedia ada dari segi pertukaran kependaman/ketepatan untuk pelbagai tugas penglihatan. Pada TensorRT, Next-ViT mengatasi ResNet sebanyak 5.4 mAP pada tugas pengesanan COCO (40.4 VS 45.8) dan 8.2% mIoU pada segmentasi ADE20K (38.8% VS 47.0%). Sementara itu, Next-ViT mencapai prestasi yang setanding dengan CSWin dan mencapai inferens 3.6x lebih pantas. Pada CoreML, Next-ViT mengatasi EfficientFormer sebanyak 4.6 mAP pada tugas pengesanan COCO (42.6 VS 47.2) dan 3.5% mIoU pada segmentasi ADE20K (daripada 45.2% kepada 48.7%).

Seni bina keseluruhan Next-ViT ditunjukkan dalam Rajah 2 di bawah. Next-ViT mengikuti seni bina piramid hierarki, dengan lapisan pembenaman tampalan dan satu siri konvolusi atau blok Transformer pada setiap peringkat. Resolusi spatial akan dikurangkan secara beransur-ansur kepada 1/32 daripada yang asal, manakala dimensi saluran akan dikembangkan secara berperingkat.

Para penyelidik terlebih dahulu mereka bentuk modul teras interaksi maklumat, dan membangunkan NCB dan NTB yang berkuasa masing-masing untuk mensimulasikan jangka pendek dan panjang- istilah dalam Ketergantungan data visual. Maklumat tempatan dan global juga digabungkan di NTB untuk meningkatkan lagi keupayaan pemodelan. Akhir sekali, untuk mengatasi kelemahan yang wujud dalam kaedah sedia ada, kajian ini secara sistematik mengkaji integrasi blok konvolusi dan Transformer dan mencadangkan strategi NHS untuk menyusun NCB dan NTB untuk membina seni bina hibrid CNN-Transformer novel.

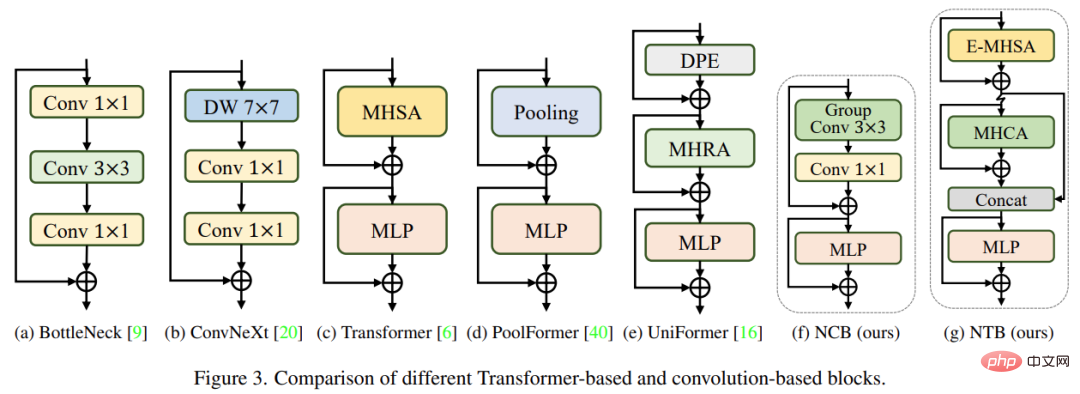

Penyelidik menganalisis beberapa reka bentuk struktur klasik, seperti ditunjukkan dalam Rajah 3 di bawah. Blok BottleNeck yang dicadangkan oleh ResNet [9] telah lama mendominasi rangkaian saraf visual kerana kecenderungan induktif yang wujud dan penggunaan mudah pada kebanyakan platform perkakasan. Malangnya, blok BottleNeck kurang berkesan daripada blok Transformer. Blok ConvNeXt [20] memodenkan blok BottleNeck dengan meniru reka bentuk blok Transformer. Walaupun sekatan ConvNeXt meningkatkan prestasi rangkaian, kelajuan inferensnya pada TensorRT/CoreML sangat terhad oleh komponen yang tidak cekap. Blok Transformer telah mencapai keputusan yang cemerlang dalam pelbagai tugas penglihatan Walau bagaimanapun, kelajuan inferens blok Transformer jauh lebih perlahan daripada blok BottleNeck pada TensorRT dan CoreML kerana mekanisme perhatiannya lebih kompleks, yang tidak berlaku dalam kebanyakan dunia nyata. senario perindustrian.

Untuk mengatasi masalah blok yang disebutkan di atas, kajian ini mencadangkan Next Convolution Block (NCB), yang mengekalkan kelebihan penggunaan Blok BottleNeck Pada masa yang sama, prestasi cemerlang blok Transformer diperolehi. Seperti yang ditunjukkan dalam Rajah 3(f), NCB mengikut seni bina umum MetaFormer (yang telah terbukti kritikal kepada blok Transformer).

Selain itu, pengadun token berasaskan perhatian yang cekap adalah sama penting. Kajian ini mereka bentuk perhatian konvolusi berbilang kepala (MHCA) sebagai pengadun token yang cekap menggunakan operasi konvolusi, dan membina NCB menggunakan lapisan MHCA dan MLP dalam paradigma MetaFormer [40].

NCB telah mempelajari perwakilan tempatan dengan berkesan, dan langkah seterusnya perlu menangkap maklumat global. Seni bina Transformer mempunyai keupayaan yang kuat untuk menangkap isyarat frekuensi rendah yang menyediakan maklumat global (seperti bentuk dan struktur global).

Walau bagaimanapun, penyelidikan berkaitan telah mendapati bahawa blok Transformer mungkin merosot maklumat frekuensi tinggi, seperti maklumat tekstur tempatan, pada tahap tertentu. Isyarat daripada jalur frekuensi yang berbeza adalah penting dalam sistem visual manusia, dan ia digabungkan dengan cara khusus untuk mengekstrak ciri yang lebih penting dan unik.

Dipengaruhi oleh hasil yang diketahui ini, kajian ini membangunkan Next Transformer Block (NTB) untuk menangkap isyarat berbilang frekuensi dalam mekanisme ringan. Selain itu, NTB boleh digunakan sebagai pengadun isyarat berbilang frekuensi yang cekap, meningkatkan lagi keupayaan pemodelan keseluruhan.

Beberapa usaha baru-baru ini telah dibuat untuk menggabungkan CNN dan Transformer untuk penggunaan yang cekap. Seperti yang ditunjukkan dalam Rajah 4(b)(c) di bawah, mereka hampir semua menggunakan blok konvolusi dalam peringkat cetek dan hanya menyusun blok Transformer dalam satu atau dua peringkat terakhir Gabungan ini berkesan dalam tugasan pengelasan. Tetapi kajian mendapati bahawa strategi hibrid ini boleh mencapai ketepuan prestasi dengan mudah pada tugas hiliran seperti segmentasi dan pengesanan. Sebabnya ialah tugas klasifikasi hanya menggunakan output peringkat terakhir untuk ramalan, manakala tugas hiliran (seperti segmentasi dan pengesanan) biasanya bergantung pada ciri setiap peringkat untuk mendapatkan hasil yang lebih baik. Ini kerana strategi hibrid tradisional hanya menyusun blok Transformer dalam beberapa peringkat terakhir, dan lapisan cetek tidak dapat menangkap maklumat global.

Kajian ini mencadangkan strategi hibrid (NHS) baharu yang secara kreatif menggabungkan blok konvolusi (NCB) dan blok Transformer (NTB) digabungkan dengan paradigma hibrid (N + 1) * L. NHS meningkatkan prestasi model dengan ketara pada tugas hiliran dan mencapai penggunaan yang cekap sambil mengawal bahagian blok Transformer.

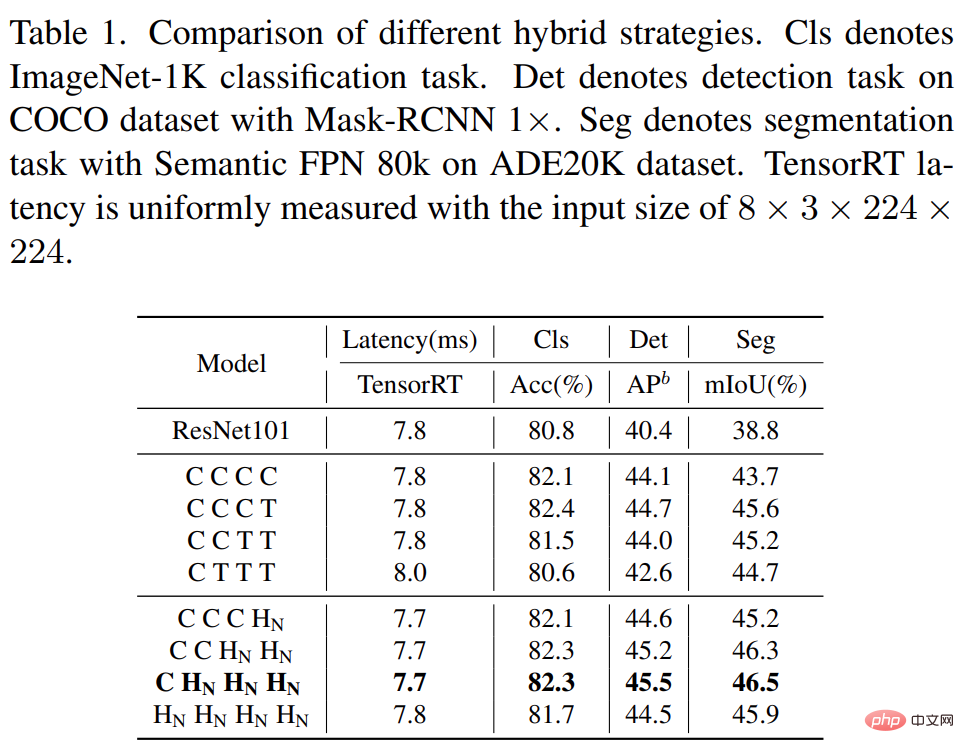

Pertama, untuk memberikan lapisan cetek keupayaan untuk menangkap maklumat global, kajian ini mencadangkan strategi pencampuran mod (NCB×N+NTB×1), menyusun N dalam setiap peringkat dalam turutan NCB dan satu NTB, seperti ditunjukkan dalam Rajah 4(d). Khususnya, Blok Transformer (NTB) diletakkan pada penghujung setiap peringkat, membolehkan model mempelajari perwakilan global dalam lapisan cetek. Kajian ini menjalankan satu siri eksperimen untuk mengesahkan keunggulan strategi hibrid yang dicadangkan, dan prestasi strategi hibrid yang berbeza ditunjukkan dalam Jadual 1 di bawah.

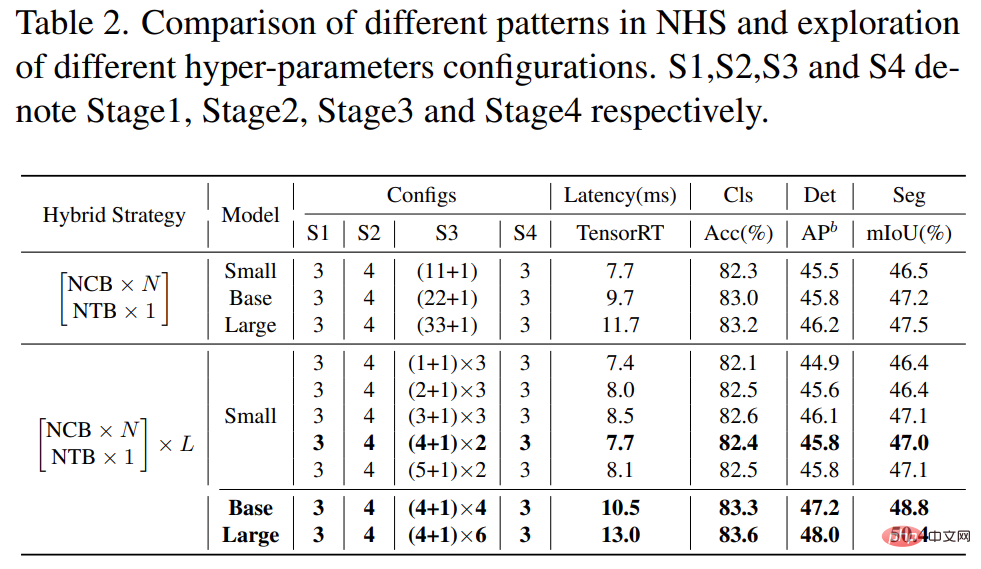

Selain itu, seperti yang ditunjukkan dalam Jadual 2 di bawah, prestasi model besar secara beransur-ansur akan mencapai ketepuan. Fenomena ini menunjukkan bahawa membesarkan saiz model dengan membesarkan N untuk mod (NCB × N + NTB × 1), iaitu hanya menambah lebih banyak blok konvolusi bukanlah pilihan optimum untuk mod (NCB × N + NTB × 1). dalam boleh menjejaskan prestasi model dengan serius.

Oleh itu, penyelidik mula meneroka kesan nilai N pada prestasi model melalui eksperimen yang meluas. Seperti yang ditunjukkan dalam Jadual 2 (tengah), kajian membina model dengan nilai N yang berbeza pada peringkat ketiga. Untuk membina model dengan latensi yang sama untuk perbandingan yang saksama, kajian ini menyusun L set corak (NCB × N + NTB × 1) pada nilai kecil N.

Seperti yang ditunjukkan dalam Jadual 2, model dengan N = 4 dalam peringkat ketiga mencapai pertukaran terbaik antara prestasi dan kependaman. Kajian selanjutnya membina model yang lebih besar dengan mengembangkan L dalam mod (NCB × 4 + NTB × 1) × L pada peringkat ketiga. Seperti yang ditunjukkan dalam Jadual 2 (di bawah), prestasi model Asas (L = 4) dan Besar (L = 6) meningkat dengan ketara berbanding model kecil, mengesahkan yang dicadangkan (NCB × N + NTB × 1) × L model keberkesanan am.

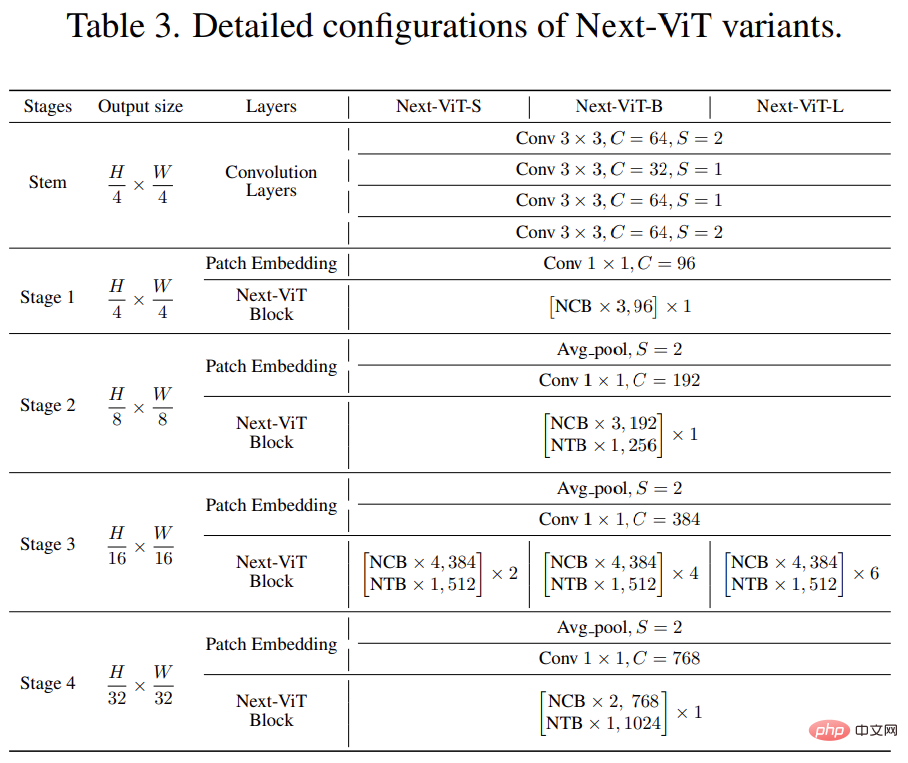

Akhir sekali, untuk memberikan perbandingan yang saksama dengan rangkaian SOTA sedia ada, penyelidik mencadangkan tiga varian tipikal, iaitu Next-ViTS/B/L.

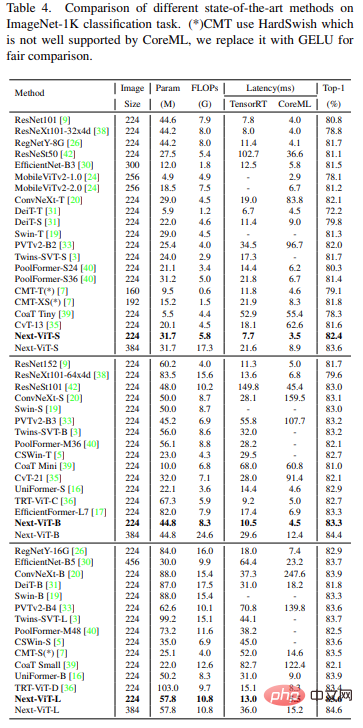

Berbanding dengan kaedah SOTA terkini seperti CNN, ViT dan rangkaian hibrid, Next-ViT mencapai prestasi yang lebih baik dalam ketepatan. pertukaran terbaik dicapai antara kependaman dan kependaman, dan keputusan ditunjukkan dalam Jadual 4 di bawah.

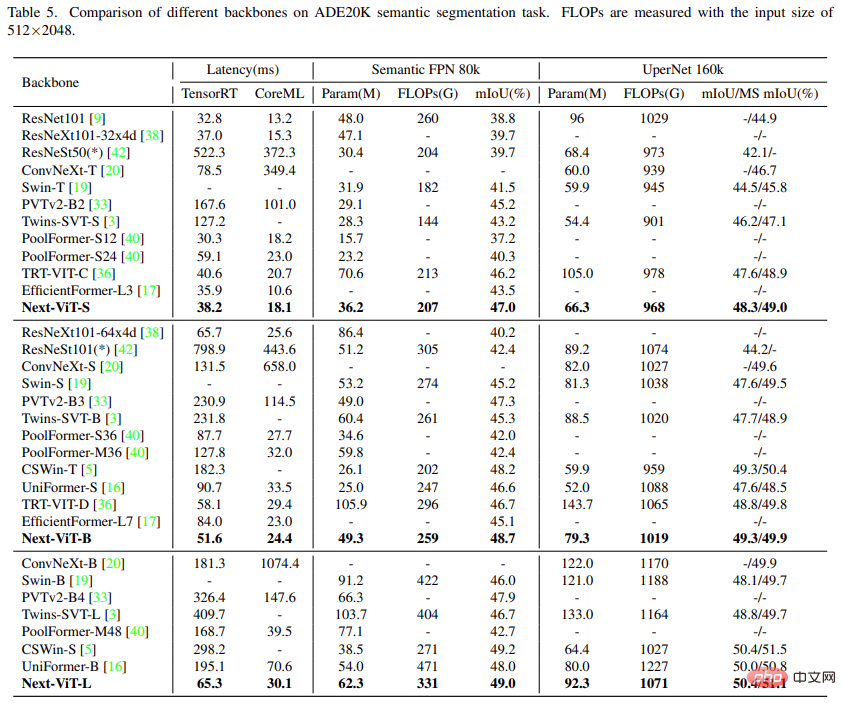

Kajian ini menggabungkan Next-ViT dengan CNN , ViT dan beberapa seni bina hibrid terkini dibandingkan untuk tugas pembahagian semantik. Seperti yang ditunjukkan dalam Jadual 5 di bawah, eksperimen yang meluas menunjukkan bahawa Next-ViT mempunyai potensi yang sangat baik dalam tugas pembahagian.

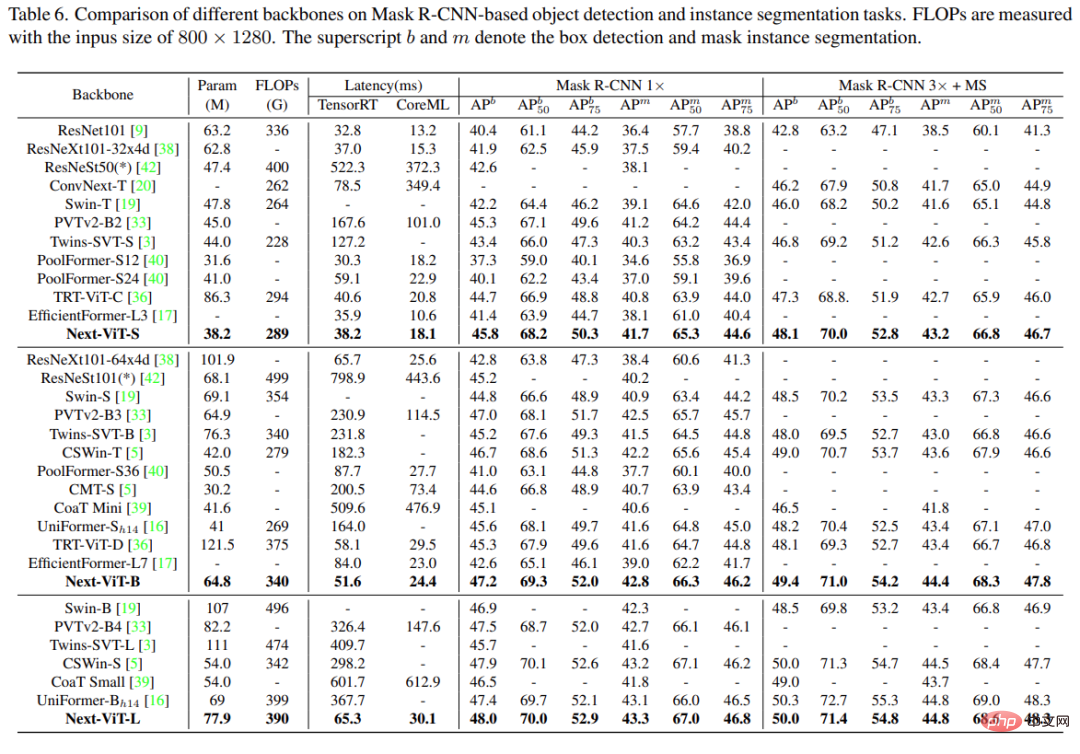

Mengenai tugas pengesanan objek dan pembahagian contoh , Kajian ini membandingkan Next-ViT dengan model SOTA, dan keputusan ditunjukkan dalam Jadual 6 di bawah.

Untuk lebih memahami Next-ViT, penyelidik menilai klasifikasinya pada ImageNet-1K dan prestasi pada tugas hiliran untuk menganalisis peranan setiap reka bentuk utama, dan memvisualisasikan spektrum Fourier dan peta haba bagi ciri keluaran untuk menunjukkan kelebihan sedia ada Next-ViT.

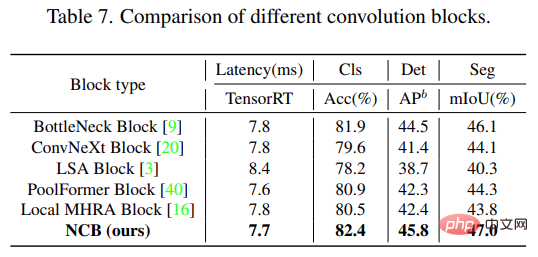

Seperti yang ditunjukkan dalam Jadual 7 di bawah, NCB mencapai pertukaran kependaman/ketepatan terbaik pada ketiga-tiga tugasan.

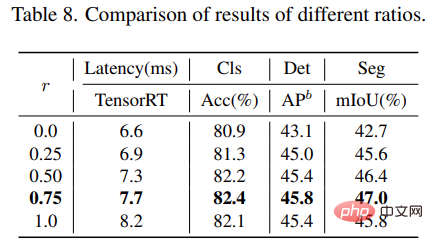

Untuk blok NTB, kajian ini meneroka kesan kadar pengecutan r NTB ke atas prestasi keseluruhan Next-ViT Hasilnya ditunjukkan dalam Jadual 8 di bawah, Mengurangkan pengecutan r akan mengurangkan kependaman model.

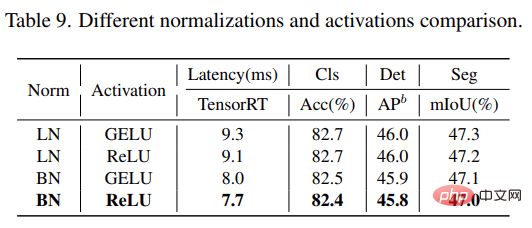

Selain itu, model dengan r = 0.75 dan r = 0.5 mempunyai prestasi yang lebih baik daripada model dengan Transformer tulen (r = 1) . Ini menunjukkan bahawa menggabungkan isyarat berbilang frekuensi dengan cara yang sesuai akan meningkatkan keupayaan pembelajaran perwakilan model. Khususnya, model dengan r = 0.75 mencapai pertukaran latensi/ketepatan terbaik. Keputusan ini menggambarkan keberkesanan blok NTB. Kajian ini menganalisis lagi kesan lapisan normalisasi yang berbeza dan fungsi pengaktifan dalam Next-ViT. Seperti yang ditunjukkan dalam Jadual 9 di bawah, walaupun LN dan GELU membawa beberapa peningkatan prestasi, kependaman inferens pada TensorRT adalah jauh lebih tinggi. Sebaliknya, BN dan ReLU mencapai pertukaran kependaman/ketepatan terbaik pada keseluruhan tugas. Oleh itu, Next-ViT menggunakan BN dan ReLU secara seragam untuk penggunaan yang cekap dalam senario industri kehidupan sebenar.

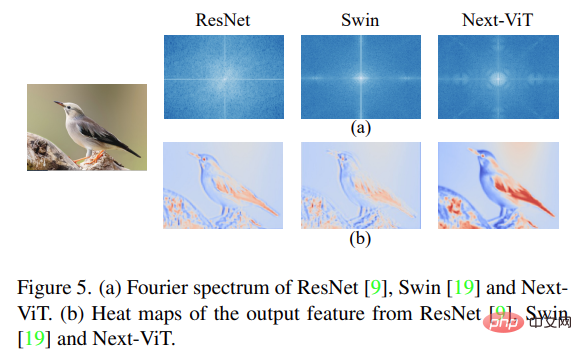

Akhir sekali, kajian menggambarkan spektrum Fourier dan peta haba bagi ciri keluaran ResNet, Swin Transformer dan Next-ViT, seperti yang ditunjukkan dalam Rajah 5 di bawah (a) ditunjukkan. Taburan spektrum ResNet menunjukkan bahawa blok konvolusi cenderung untuk menangkap isyarat frekuensi tinggi dan mengalami kesukaran untuk memberi perhatian kepada isyarat frekuensi rendah ViT pandai menangkap isyarat frekuensi rendah dan mengabaikan isyarat frekuensi tinggi dan Next-ViT; isyarat berbilang frekuensi berkualiti tinggi pada masa yang sama, yang menunjukkan kelebihan keberkesanan NTB.

Selain itu, seperti yang ditunjukkan dalam Rajah 5(b), Next-ViT boleh menangkap maklumat tekstur yang lebih kaya dan maklumat tekstur yang lebih tepat daripada ResNet dan Swin . Maklumat global, yang menunjukkan bahawa Next-ViT mempunyai keupayaan pemodelan yang lebih kukuh.

Atas ialah kandungan terperinci Membuka kunci gabungan CNN dan Transformer yang betul, ByteDance mencadangkan Transformer visual generasi seterusnya yang berkesan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!