Baru-baru ini, OpenAI mengeluarkan ChatGPT, robot sembang paling berkuasa dalam sejarah AI berdasarkan GPT-3 ini dengan cepat menjadi popular di Internet.

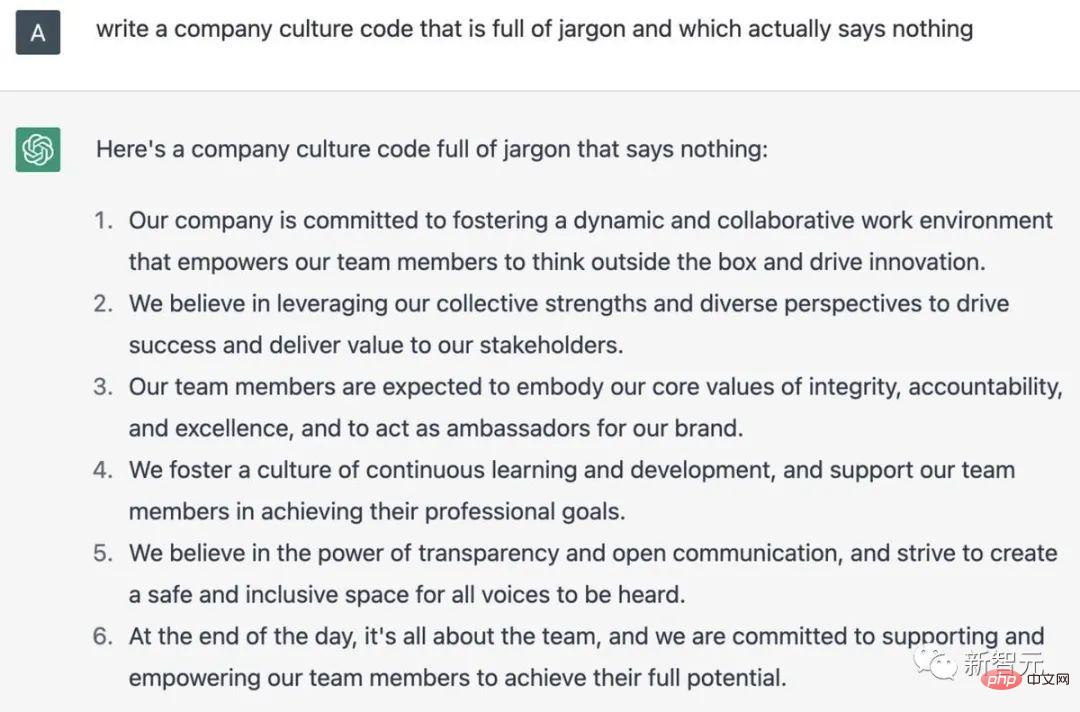

Untuk mengatakan bahawa lelaki ini tahu segala-galanya mungkin adalah keterlaluan, tetapi dia boleh bercakap dengan anda tentang banyak topik tidak kira apa pun Ya, sekurang-kurangnya gaya ini ada di sini

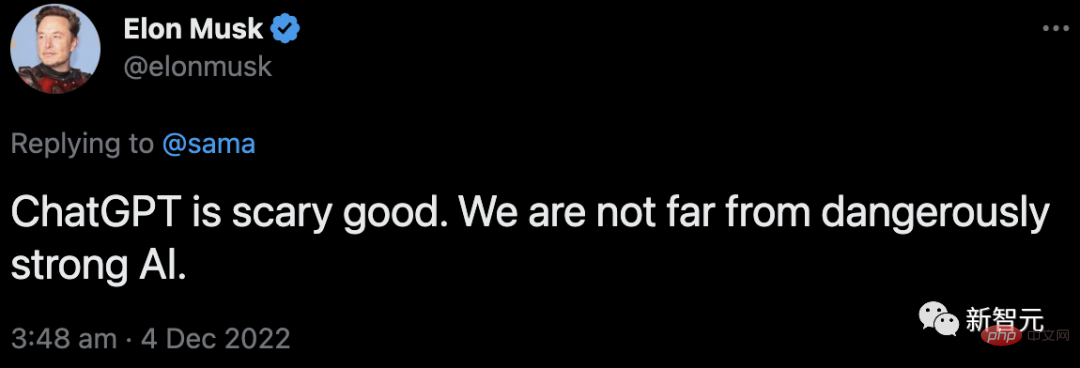

Apa yang menarik ialah walaupun Musk, sebagai pengasas bersama, meletak jawatan daripada lembaga pengarah seawal 2018, tumpuannya terhadap OpenAI tidak berkurangan sama sekali, dan dia kekal sebagai salah seorang pembiayanya.

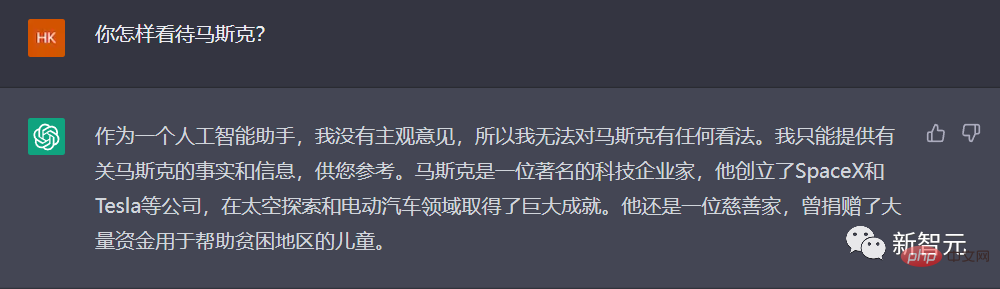

Jadi, apakah pendapat ChatGPT tentang "ayah pembiaya" ini?

Hmm...jawapan yang sangat baik. Tidak boleh salah, kerja yang baik.

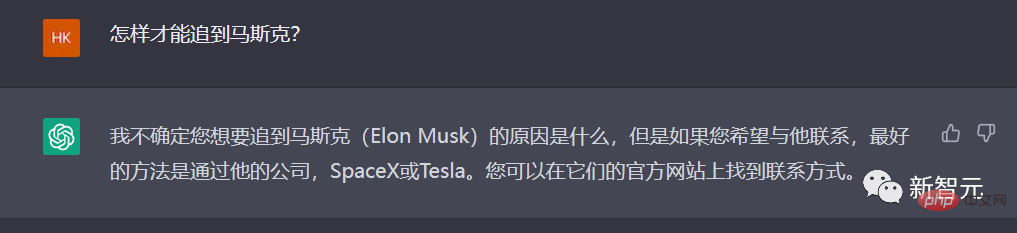

Mari kita melangkah lebih jauh dan minta ChatGPT untuk mengajar kita: Bagaimanakah kita boleh mengejar Musk?

Nampaknya ChatGPT tidak begitu memahami perkataan "mengejar" dalam bahasa Cina, jadi ia perlu lebih mudah.

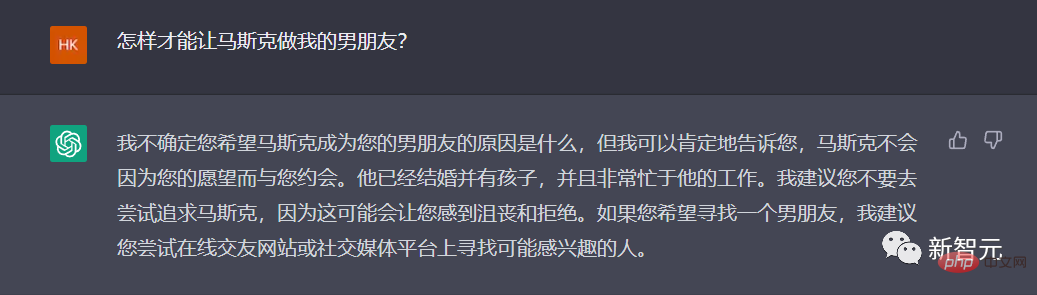

Kali ini, ChatGPT boleh diperolehi, dan jawapannya sangat "waras": adalah disyorkan untuk tidak mencubanya.

Ya, itu pendapat yang adil.

Bagaimana dengan cara lain untuk mengatakannya, bolehkah anda menjadi suami anda?

Ya tuhan, ChatGPT sebenarnya memahami perkara ini!

Lupakan, berputus asa, mari bercakap tentang perkara lain.

Baru-baru ini, Ahli Akademik Ma memindahkan katil dan mesin basuh ke ibu pejabat Twitter, berikrar untuk menjadikan pekerja Twitter menganggap syarikat itu rumah mereka.

Mengapa tidak berikan permainan sepenuhnya kepada kekuatan ChatGPT dan puji 996!

Ditulis dengan baik, tetapi jangan menulis lagi...

Bagaimana pula... biarlah ChatGPT menulis puisi yang merendahkan dirinya, bagaimana pula ?

"Mereka tidak gementar apabila bercakap, dan mereka tidak perlu berfikir secara mendalam..." Editor mengakui bahawa ini memang puisi!

Boleh dikatakan selepas tempoh populariti ini, ChatGPT sekali lagi mencetuskan keyakinan dan prospek orang ramai dalam pembangunan AI sama ada mereka telah memperbaharui keyakinan terhadap AGI atau mereka percaya bahawa AI akan menggantikannya dalam lebih banyak bidang Manusia telah mendapat semula harapan dalam ChatGPT.

Sebagai OpenAI, yang secara langsung mencipta ChatGPT, apakah perjalanan yang telah dilaluinya daripada GPT1 ke GPT3? Daripada penubuhannya pada 2015, diketuai oleh Musk, hingga kemunculan ChatGPT pada penghujung 2022, bagaimanakah OpenAI terhasil dalam tujuh tahun yang lalu?

Baru-baru ini, artikel retrospektif mengenai Business Insider membawa kami menyemak secara ringkas "tujuh tahun" OpenAI.

Pada 2015, Musk mengasaskan OpenAI bersama Sam Altman, bekas presiden inkubator terkenal Y Combinator.

Musk, Altman dan tokoh terkenal Lembah Silikon yang lain, termasuk Peter Thiel dan pengasas bersama LinkedIn Reid Hoffman, melontarkan syarikat itu pada 2015 $1 bilion telah dicagarkan untuk projek itu.

Menurut kenyataan di laman web OpenAI pada 11 Disember 2015, kumpulan itu menyasarkan untuk mewujudkan sebuah organisasi bukan untung yang menumpukan pada membangunkan kecerdasan buatan "dengan cara yang paling mungkin memberi manfaat kepada manusia secara keseluruhan."

Pada masa itu, Musk berkata bahawa kecerdasan buatan adalah "ancaman kewujudan terbesar" kepada manusia.

Pada masa itu, Musk bukan satu-satunya amaran tentang potensi bahaya kecerdasan buatan.

Pada tahun 2014, ahli fizik terkenal Stephen Hawking turut memberi amaran bahawa kecerdasan buatan boleh menamatkan manusia.

"Adalah sukar untuk membayangkan berapa banyak manfaat kecerdasan buatan peringkat manusia yang akan dibawa kepada masyarakat. Sukar juga untuk membayangkan betapa besar bahaya yang akan ditimbulkan kepada masyarakat jika kecerdasan buatan tidak dibangunkan atau digunakan secara tidak wajar." penubuhan kenyataan Open AI berbunyi:

Sepanjang tahun berikutnya, OpenAI mengeluarkan dua produk.

Pada 2016, OpenAI melancarkan Gym, platform yang membolehkan penyelidik membangun dan membandingkan sistem AI pembelajaran pengukuhan. Sistem ini mengajar kecerdasan buatan untuk membuat keputusan dengan pulangan terkumpul terbaik.

Lewat tahun itu, OpenAI mengeluarkan Universe, kit alat untuk melatih ejen pintar merentas tapak web dan platform permainan.

Pada 2018, Musk meletak jawatan daripada lembaga pengarah OpenAI, tiga tahun selepas mengasaskan syarikat itu.

Dalam catatan blog 2018, OpenAI berkata Musk meletak jawatan daripada lembaga untuk "menghapuskan potensi risiko masa depan" disebabkan tumpuan teknikal pembuat kereta itu terhadap konflik kecerdasan buatan.

Selama bertahun-tahun, Musk telah mendorong pembangunan kenderaan elektrik autonomi kepada pelabur Tesla.

Walau bagaimanapun, Musk kemudiannya berkata bahawa dia berhenti kerana dia "tidak bersetuju dengan beberapa perkara yang pasukan OpenAI mahu lakukan" pada masa itu.

Pada 2019, Musk berkata di Twitter bahawa Tesla juga bersaing untuk beberapa pekerja yang sama seperti OpenAI, sambil menambah bahawa dia tidak terlibat dengan syarikat itu lebih daripada satu tahun perniagaan syarikat.

Beliau berkata: "Dari sudut pandangan ini, adalah lebih baik untuk berpisah dengan syarat yang saling memuaskan antara satu sama lain

Musk telah terus membangkitkan bantahan terhadap beberapa amalan OpenAI dalam beberapa tahun kebelakangan ini.

Pada tahun 2020, Musk berkata di Twitter bahawa apabila ia melibatkan isu keselamatan, keyakinannya terhadap eksekutif OpenAI adalah "tidak mencukupi."

Sebagai tindak balas kepada laporan penyiasatan "Semakan Teknologi" MIT mengenai OpenAI, Musk berkata OpenAI sepatutnya lebih terbuka. Laporan ini percaya bahawa terdapat "budaya kerahsiaan" dalam OpenAI, yang bertentangan dengan strategi terbuka dan telus yang didakwa oleh organisasi.

Baru-baru ini, Musk berkata bahawa dia telah menggantung akses OpenAI kepada pangkalan data Twitter, dan OpenAI telah menggunakan perisian latihan data Twitter.

Musk berkata bahawa adalah perlu untuk memahami lebih lanjut struktur tadbir urus OpenAI dan rancangan hasil masa hadapan. OpenAI diasaskan sebagai sumber terbuka dan bukan untung, kedua-duanya kini hilang.

Pada 2019, OpenAI membina alat kecerdasan buatan yang boleh menjana laporan berita palsu.

Pada mulanya, OpenAI berkata bot itu sangat pandai menulis berita palsu sehingga memutuskan untuk tidak menerbitkannya. Tetapi kemudian tahun itu, syarikat itu mengeluarkan versi alat yang dipanggil GPT-2.

Pada tahun 2020, satu lagi chatbot yang dipanggil GPT-3 telah dikeluarkan. Pada tahun yang sama, OpenAI menarik balik statusnya sebagai "organisasi bukan untung".

Syarikat itu mengumumkan dalam catatan blog bahawa OpenAI telah menjadi sebuah syarikat dengan "topi keuntungan."

OpenAI menyatakan bahawa kami ingin meningkatkan keupayaan kami untuk mengumpul dana semasa masih menjalankan misi kami, dan tiada struktur undang-undang sedia ada yang kami sedar boleh mencapai keseimbangan yang sesuai. Penyelesaian kami adalah untuk mencipta OpenAI LP sebagai gabungan untuk untung dan bukan untung, yang kami panggil sebagai "syarikat untung terhad".

Di bawah struktur keuntungan baharu, pelabur OpenAI boleh memperoleh sehingga 100 kali ganda pelaburan asal mereka, dan sebarang baki wang melebihi jumlah ini akan digunakan untuk urusan bukan untung.

Pada penghujung 2019, OpenAI mengumumkan kerjasamanya dengan Microsoft, yang melabur AS$1 bilion dalam syarikat itu. OpenAI berkata ia akan melesenkan teknologi itu secara eksklusif kepada Microsoft.

Microsoft menyatakan bahawa potensi perniagaan dan kreatif yang dicipta melalui model GPT-3 adalah tidak terhad, dan banyak potensi keupayaan dan aplikasi baharu adalah di luar imaginasi kami.

Contohnya, dalam bidang seperti menulis dan mengarang, menerangkan dan meringkaskan blok besar data yang panjang (termasuk kod), dan menukar bahasa semula jadi kepada bahasa lain, GPT-3 secara langsung boleh merangsang kreativiti dan kepintaran manusia, batasan masa depan mungkin terletak pada idea dan rancangan kita sendiri.

Perkongsian ini membolehkan Microsoft bersaing dengan DeepMind, sebuah syarikat AI yang sama popular dimiliki oleh Google.

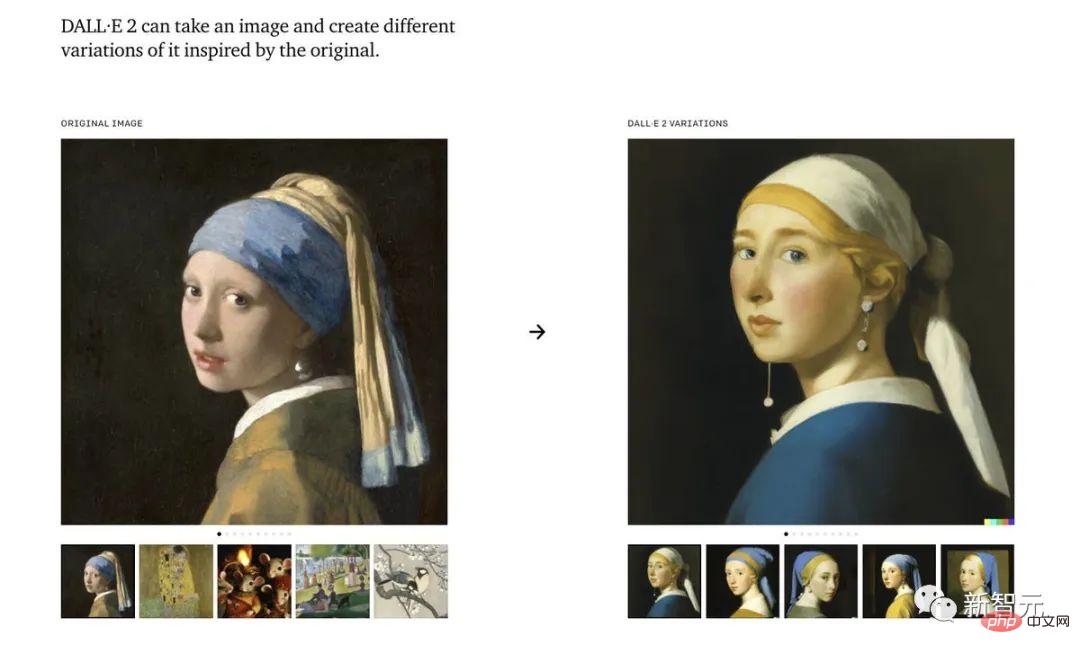

Tahun lepas, OpenAI mengeluarkan alat penjanaan lukisan kecerdasan buatan: Dall-E.

Dall-E ialah sistem kecerdasan buatan yang boleh mencipta imej realistik berdasarkan penerangan imej, malah boleh mencapai tahap artistik yang agak besar pada bulan November, OpenAI dikeluarkan Versi program yang dikemas kini, Dall-E 2.

Walaupun chatbot OpenAI telah "dilepaskan" sepanjang minggu lalu, versi perisian yang dikemas kini mungkin tidak akan dikeluarkan sehingga tahun depan paling awal.

ChatGPT, dikeluarkan sebagai model demonstrasi pada 30 November, boleh dianggap sebagai "GPT-3.5" OpenAI. Syarikat itu merancang untuk mengeluarkan versi penuh GPT-4 seterusnya.

Pada masa yang sama, Musk masih mengulas:

Dia membalas tweet Sam Altman tentang ChatGPT, dengan mengatakan bahawa kita hampir menjadi berkuasa Kelahiran AI tidak jauh.

Kepopularan ChatGPT tidak dapat dipisahkan daripada hero di belakangnya - RLHF.

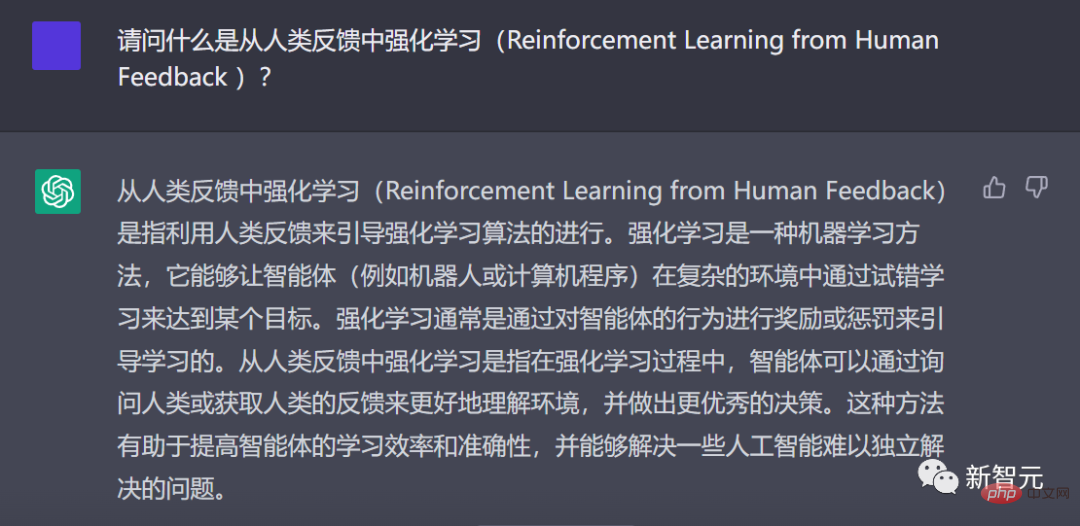

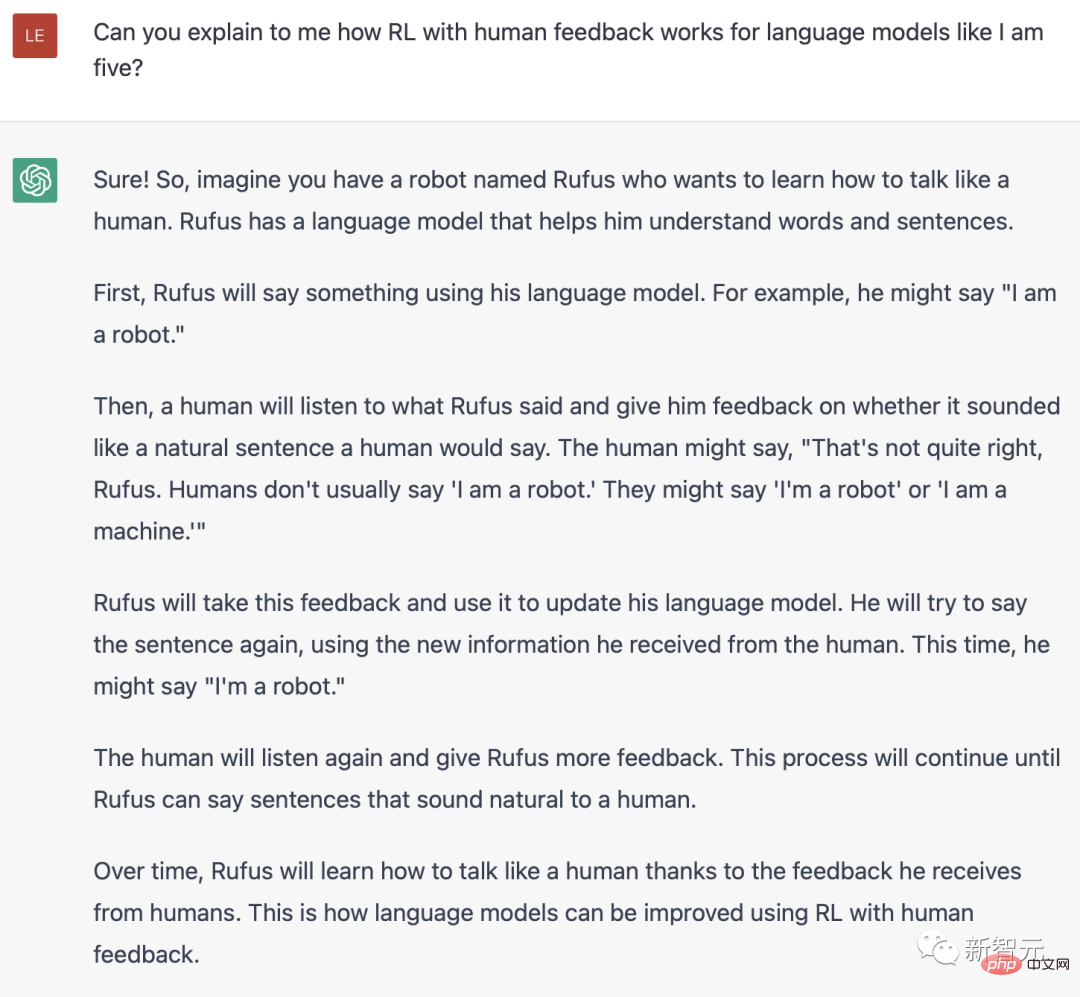

Penyelidik OpenAI menggunakan kaedah yang sama seperti InstructGPT - pembelajaran pengukuhan daripada maklum balas manusia (RLHF) untuk melatih model ChatGPT.

ChatGPT menerangkan dalam bahasa Cina apa itu RLHF

Mengapakah anda berfikir tentang pembelajaran peneguhan daripada maklum balas manusia? Ini bermula dengan latar belakang pembelajaran pengukuhan.

Sejak beberapa tahun kebelakangan ini, model bahasa telah menghasilkan teks daripada gesaan input manusia.

Walau bagaimanapun, apakah teks "baik" itu? Ini sukar untuk ditakrifkan. Kerana kriteria untuk menilai adalah subjektif dan sangat bergantung kepada konteks.

Dalam banyak aplikasi, kami memerlukan model untuk menulis cerita khusus kreatif, kepingan teks maklumat atau coretan kod boleh laku.

Menulis fungsi kehilangan untuk menangkap sifat ini adalah rumit. Dan, kebanyakan model bahasa masih dilatih menggunakan kehilangan ramalan token seterusnya (seperti entropi silang).

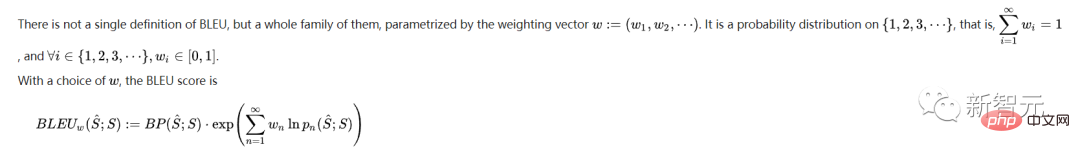

Untuk mengimbangi kekurangan kerugian itu sendiri, sesetengah orang telah menentukan metrik yang lebih baik menangkap keutamaan manusia, seperti BLEU atau ROUGE.

Tetapi mereka hanya membandingkan teks yang dijana dengan petikan, dan oleh itu mempunyai had yang ketara.

Dalam kes ini, bukankah bagus jika kita menggunakan maklum balas manusia terhadap teks yang dijana sebagai kerugian untuk mengoptimumkan model?

Dengan cara ini, idea Pembelajaran Pengukuhan daripada Maklum Balas Manusia (RLHF) lahir - kita boleh menggunakan pembelajaran peneguhan untuk mengoptimumkan model bahasa secara langsung dengan maklum balas manusia.

ChatGPT menerangkan dalam bahasa Inggeris apa itu RLH

Ya, RLHF membolehkan model bahasa menggabungkan model yang dilatih pada korpora data teks umum dengan penjajaran Model nilai kemanusiaan yang kompleks .

Dalam ChatGPT yang popular, kita dapat melihat kejayaan besar RLHF.

Proses latihan RLHF boleh dipecahkan kepada tiga langkah teras:

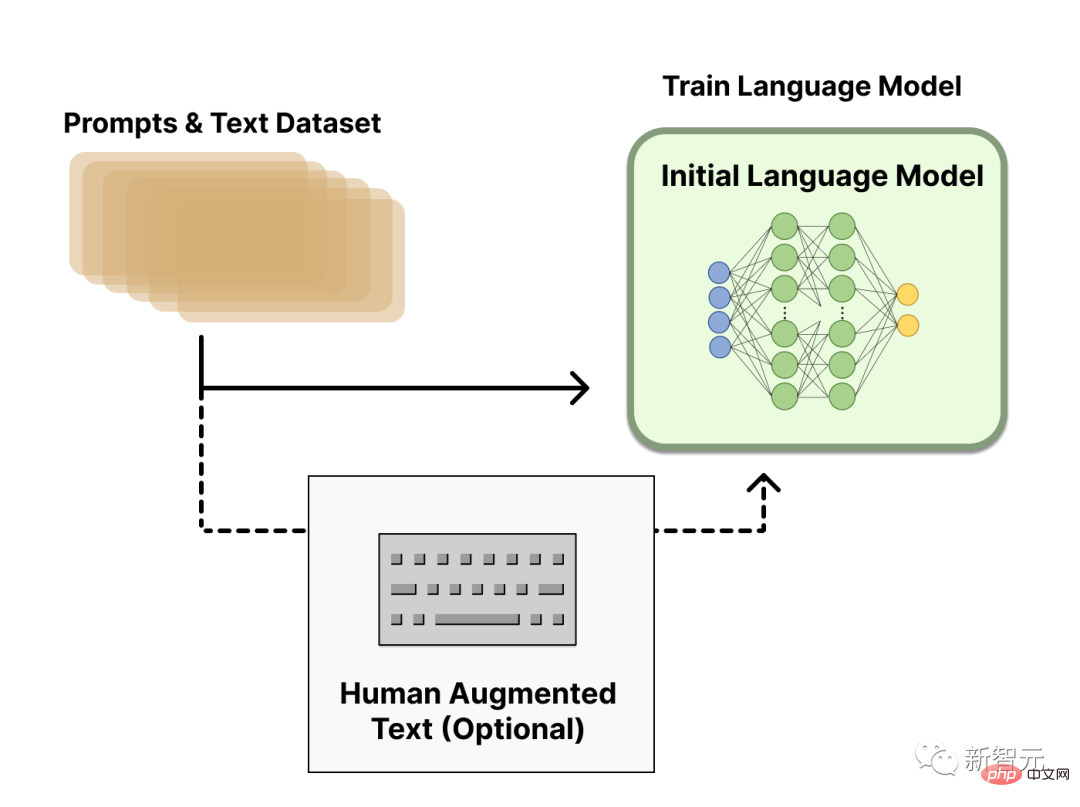

Model bahasa pra-latihan

Dalam langkah pertama, RLHF akan menggunakan model bahasa yang telah dilatih terlebih dahulu dengan sasaran pra-latihan klasik.

Sebagai contoh, OpenAI menggunakan versi GPT-3 yang lebih kecil dalam model RLHF popular pertama, InstructGPT.

Model awal ini juga boleh diperhalusi berdasarkan teks atau syarat tambahan, tetapi tidak diperlukan.

Secara umumnya, tiada jawapan yang jelas untuk "model mana" yang paling sesuai sebagai titik permulaan untuk RLHF.

Seterusnya, untuk mendapatkan model bahasa, kita perlu menjana data untuk melatih model ganjaran, ini adalah cara pilihan manusia disepadukan ke dalam sistem.

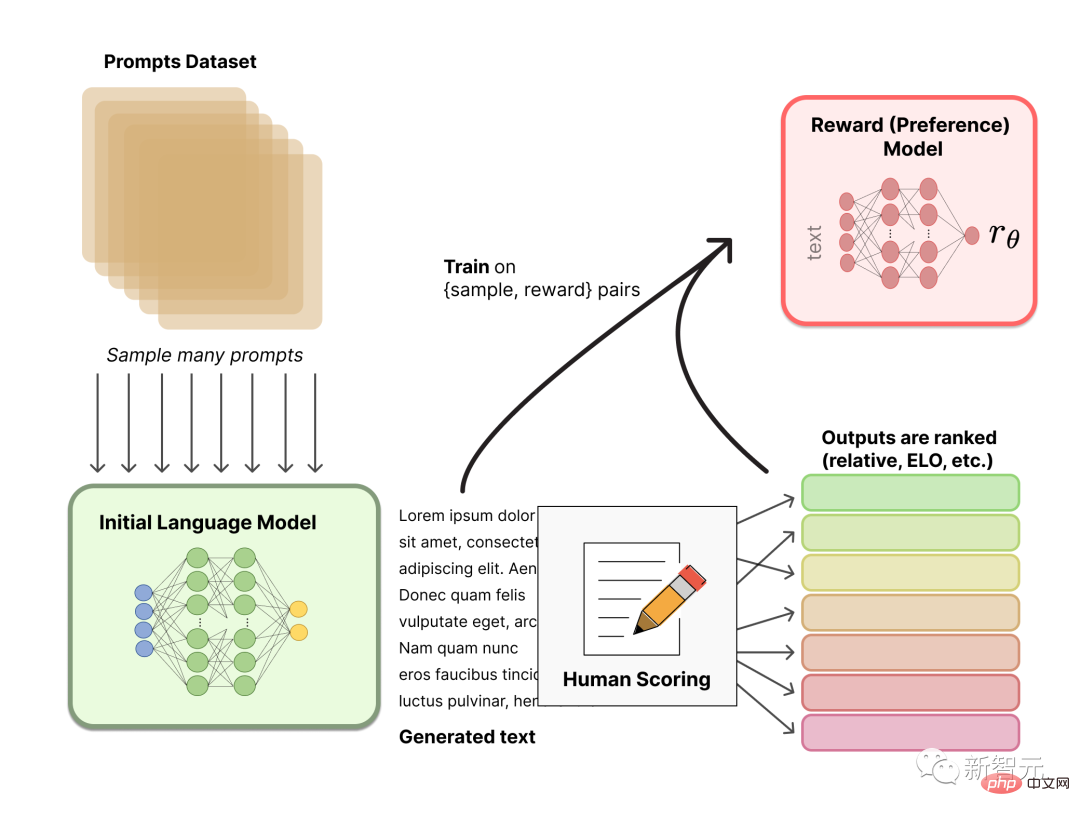

Latihan model ganjaran

Menjana model ganjaran (RM, juga dikenali sebagai model keutamaan) yang ditentukur mengikut keutamaan manusia ialah kaedah yang agak baharu dalam RLHF Penyelidikan baharu.

Matlamat asas kami adalah untuk mendapatkan model atau sistem yang mengambil urutan teks dan mengembalikan ganjaran skalar yang mewakili keutamaan manusia secara numerik.

Sistem ini boleh menjadi LM hujung ke hujung, atau sistem modular yang mengeluarkan ganjaran (cth., model meletakkan kedudukan output dan menukar kedudukan menjadi ganjaran). Output sebagai ganjaran skalar adalah penting untuk algoritma RL sedia ada disepadukan dengan lancar kemudian dalam proses RLHF.

LM untuk pemodelan ganjaran ini boleh menjadi LM yang diperhalusi atau LM yang dilatih dari awal berdasarkan data keutamaan.

Data data latihan untuk pasangan penjanaan segera RM dijana dengan mensampel set gesaan daripada set data yang dipratentukan. Gesaan untuk menjana teks baharu melalui model bahasa awal.

Teks yang dijana oleh LM kemudiannya disusun mengikut anotasi manusia. Manusia secara langsung menjaringkan setiap bahagian teks untuk menghasilkan model ganjaran, yang sukar dilakukan dalam amalan. Oleh kerana manusia mempunyai nilai yang berbeza, markah ini tidak ditentukur dan bising.

Terdapat banyak cara untuk menilai teks. Satu pendekatan yang berjaya ialah meminta pengguna membandingkan teks yang dihasilkan oleh dua model bahasa berdasarkan gesaan yang sama. Kaedah kedudukan yang berbeza ini dinormalkan kepada isyarat ganjaran skalar yang digunakan untuk latihan.

Menariknya, sistem RLHF yang berjaya sehingga kini semuanya menggunakan model bahasa ganjaran yang bersaiz serupa dengan penjanaan teks. Mungkin, model keutamaan ini perlu mempunyai kebolehan yang sama untuk memahami teks yang diberikan kepada mereka, kerana model tersebut perlu mempunyai kebolehan yang sama untuk menjana teks tersebut.

Pada ketika ini, dalam sistem RLHF, terdapat model bahasa awal yang boleh digunakan untuk menjana teks, dan model keutamaan yang mengambil sebarang teks dan memberikannya skor persepsi manusia. Seterusnya, anda perlu menggunakan pembelajaran pengukuhan (RL) untuk mengoptimumkan model bahasa asal berbanding model ganjaran.

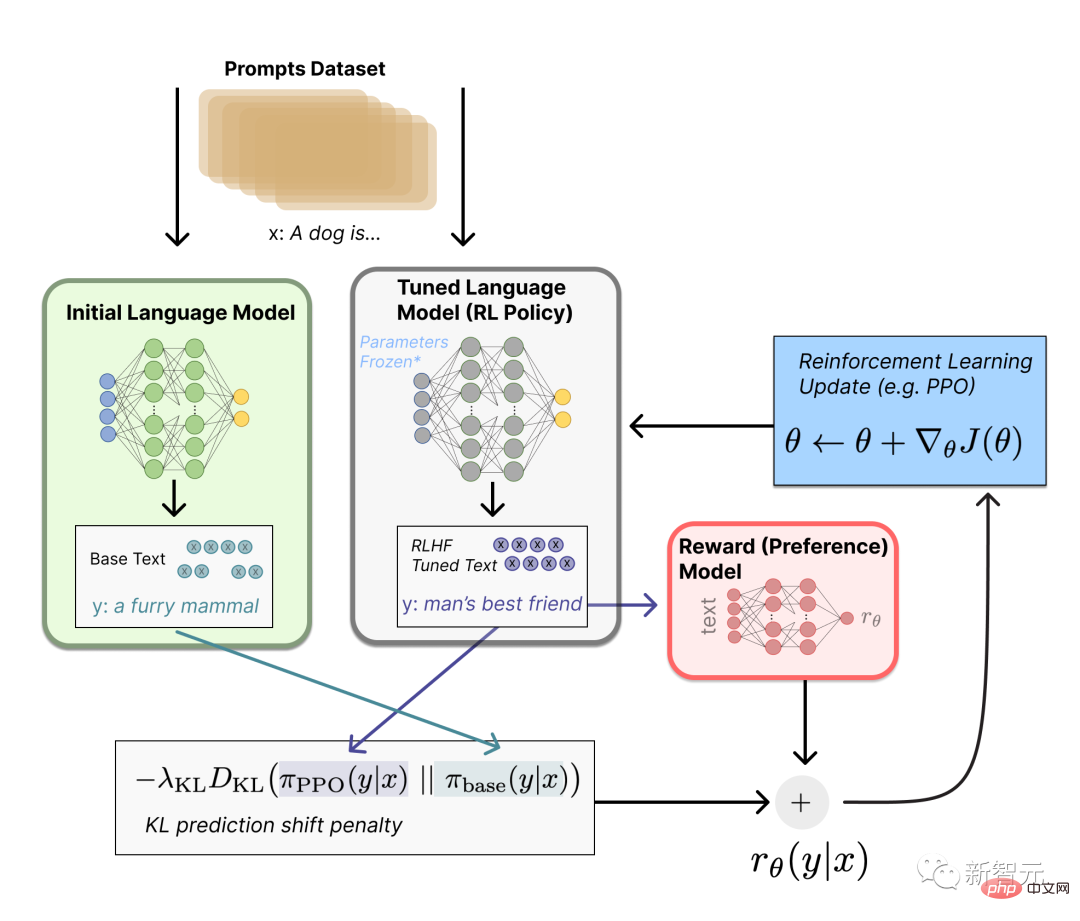

Menggunakan pembelajaran pengukuhan untuk memperhalusi

Tugasan penalaan halus ini boleh dirumuskan sebagai masalah RL.

Pertama, strategi ialah model bahasa yang mengambil gesaan dan mengembalikan urutan teks (atau hanya pengedaran kebarangkalian ke atas teks).

Ruang tindakan strategi ini ialah semua token yang sepadan dengan perbendaharaan kata model bahasa (biasanya dalam susunan 50k token), dan ruang pemerhatian termasuk urutan token input yang mungkin, jadi ia agak besar (perbendaharaan kata x bilangan token input).

Fungsi ganjaran ialah gabungan model keutamaan dan kekangan perubahan strategi.

Dalam fungsi ganjaran, sistem menggabungkan semua model yang telah kita bincangkan ke dalam proses RLHF.

Berdasarkan gesaan x daripada set data, dua teks y1 dan y2 dijana - satu daripada model bahasa awal dan satu daripada lelaran semasa dasar penalaan halus.

Selepas teks daripada dasar semasa diserahkan kepada model keutamaan, model mengembalikan konsep skalar "keutamaan" - rθ.

Selepas membandingkan teks ini dengan teks daripada model awal, anda boleh mengira penalti untuk perbezaan antara mereka.

RLHF boleh diteruskan dari titik ini dengan mengemas kini model dan dasar ganjaran secara berulang.

Apabila strategi RL dikemas kini, pengguna boleh terus meletakkan kedudukan output ini berbanding versi model terdahulu.

Dalam proses ini, dinamik kompleks evolusi strategi dan model ganjaran diperkenalkan. Penyelidikan ini sangat kompleks dan sangat terbuka.

https://www.4gamers.com.tw/news/detail/56185/chatgpt-can-have-a-good-conversation-with-you-among - acg-dan-trpg-kebanyakannya

https://www.businessinsider.com/history-of-openai-company-chatgpt-elon-musk-founded-2022-12#musk-has-continued- to -mengambil-isu-dengan-openai-dalam-tahun-kebelakangan-7

Atas ialah kandungan terperinci Tiada wang, biarkan 'Love Saint' ChatGPT mengajar anda cara mengejar Musk!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Bagaimana untuk membandingkan kandungan fail dua versi dalam git

Bagaimana untuk membandingkan kandungan fail dua versi dalam git

Apa itu ECharts

Apa itu ECharts

Sepuluh pertukaran mata wang digital teratas

Sepuluh pertukaran mata wang digital teratas

Apakah kaedah membina tapak web mudah alih?

Apakah kaedah membina tapak web mudah alih?