Baru-baru ini, pasukan Google AI mencadangkan penyelesaian hujung ke hujung untuk segmentasi panorama menggunakan Mask Transformer, diilhamkan oleh Transformer dan DETR.

Nama penuh ialah penyelesaian hujung ke hujung untuk segmentasi panoptik dengan pengubah topeng, yang digunakan terutamanya untuk menjana lanjutan seni bina MaskTransformer segmentasi.

Penyelesaian menggunakan laluan piksel (terdiri daripada rangkaian neural konvolusi atau Transformer visual) untuk mengekstrak ciri piksel, laluan memori (terdiri daripada modul penyahkod Transformer) untuk mengekstrak ciri memori dan laluan dwi Transformer untuk ciri piksel dan Ciri-ciri interaksi antara kenangan.

Walau bagaimanapun, Transformer dwi-laluan yang menggunakan perhatian silang pada asalnya direka untuk tugas bahasa, yang urutan inputnya terdiri daripada ratusan perkataan.

Untuk tugasan visual, terutamanya masalah segmentasi, jujukan input terdiri daripada puluhan ribu piksel, yang bukan sahaja menunjukkan bahawa magnitud skala input jauh lebih besar, tetapi juga mewakili perwakilan yang lebih rendah berbanding dengan perkataan bahasa .

Segmentasi panorama ialah masalah penglihatan komputer yang kini menjadi tugas teras dalam banyak aplikasi.

Ia terbahagi kepada dua bahagian: segmentasi semantik dan segmentasi contoh.

Pembahagian semantik adalah seperti memberikan label semantik kepada setiap piksel dalam imej, seperti "orang" dan "langit".

Segmentasi tika hanya mengenal pasti dan membahagikan objek boleh dikira dalam graf, seperti "pejalan kaki" dan "kereta", dan seterusnya membahagikannya kepada beberapa subtugas.

Setiap subtugas diproses secara individu dan modul tambahan digunakan untuk menggabungkan hasil setiap peringkat subtugas.

Proses ini bukan sahaja kompleks, tetapi juga memperkenalkan banyak priors yang direka bentuk secara buatan apabila menangani subtugas dan menyepadukan hasil subtugas yang berbeza.

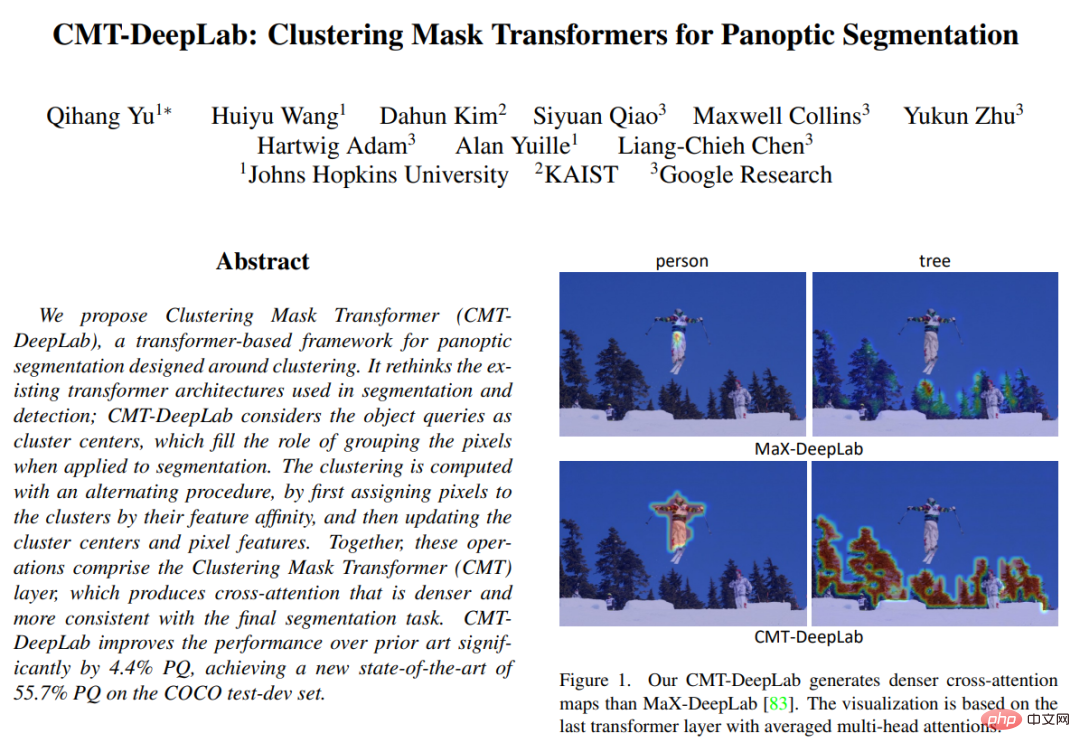

Dalam "CMT-DeepLab: Clustering Mask Transformers for Panoptic Segmentation" yang diterbitkan di CVPR 2022, artikel itu mencadangkan untuk mentafsir semula dan mereka bentuk semula perhatian silang dari perspektif pengelompokan perhatian silang (iaitu, mengumpulkan piksel dengan label semantik yang sama ke dalam kumpulan yang sama) untuk menyesuaikan diri dengan tugas visual dengan lebih baik.

CMT-DeepLab dibina berdasarkan kaedah terkini MaX-DeepLab dan menggunakan kaedah pengelompokan piksel untuk melakukan perhatian silang, menghasilkan peta perhatian yang lebih padat dan munasabah.

kMaX-DeepLab selanjutnya mereka bentuk semula perhatian silang agar lebih seperti algoritma pengelompokan k-means dengan perubahan mudah pada fungsi pengaktifan.

Penyelidik akan mentafsir semulanya dari perspektif pengelompokan, dan bukannya secara langsung menggunakan perhatian silang kepada tugas visual tanpa pengubahsuaian.

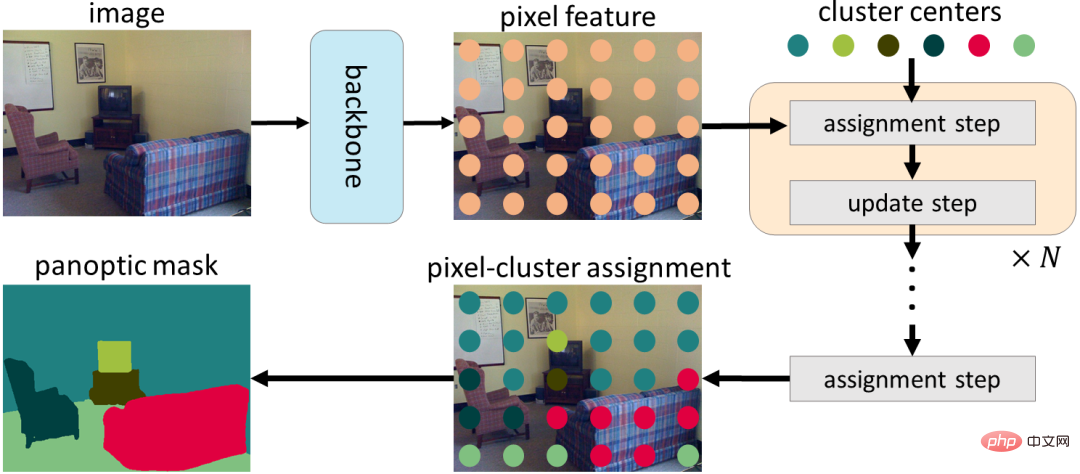

Secara khusus, mereka ambil perhatian bahawa pertanyaan objek Mask Transformer boleh dianggap sebagai pusat kluster (bertujuan untuk mengumpulkan piksel dengan label semantik yang sama).

Proses perhatian silang adalah serupa dengan algoritma pengelompokan k-means, (1) proses lelaran untuk menetapkan piksel ke pusat gugusan, di mana berbilang piksel boleh ditugaskan kepada pusat gugusan tunggal dan beberapa Kluster pusat mungkin tidak memperuntukkan piksel, dan (2) pusat kluster dikemas kini dengan purata piksel yang diperuntukkan kepada pusat kluster yang sama, jika tiada piksel diperuntukkan, pusat kluster tidak dikemas kini).

Dalam CMT-DeepLab dan kMaX-DeepLab, kami merumuskan semula perhatian silang daripada perspektif pengelompokan, yang merangkumi penugasan kelompok berulang dan langkah kemas kini pengelompokan

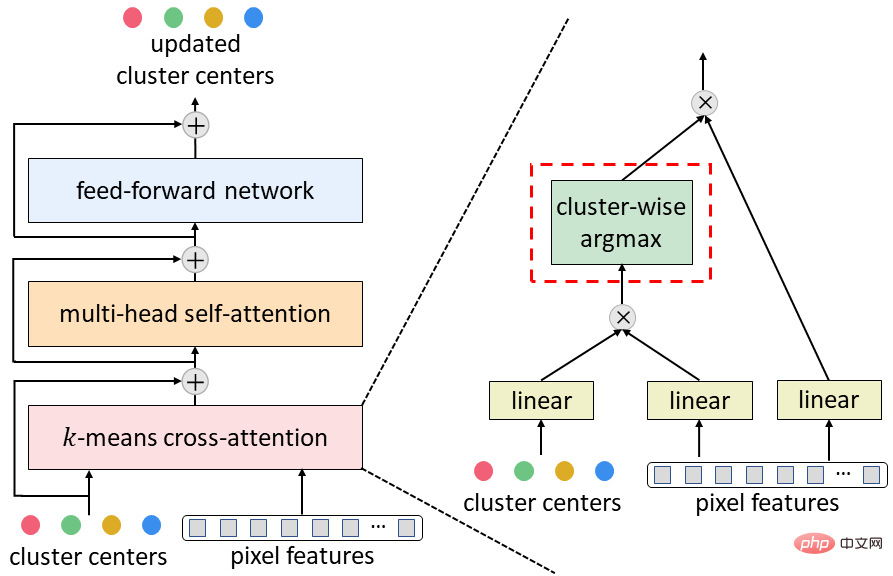

Memandangkan kepopularan algoritma pengelompokan k-means, dalam CMT-DeepLab, mereka mereka bentuk semula perhatian silang untuk operasi softmax dari segi spatial (iaitu, digunakan sepanjang resolusi spatial bagi operasi softmax imej), yang sebenarnya menetapkan pusat kluster ke arah yang bertentangan, piksel digunakan di sepanjang pusat kluster.

Dalam kMaX-DeepLab, kami memudahkan lagi softmax dari segi spatial kepada argmax dari segi kluster (iaitu, gunakan operasi argmax di sepanjang pusat kluster).

Mereka ambil perhatian bahawa operasi argmax adalah sama dengan tugasan keras (iaitu satu piksel diperuntukkan kepada hanya satu kelompok) yang digunakan dalam algoritma pengelompokan k-means.

Membina semula perhatian silang MaskTransformer daripada perspektif pengelompokan meningkatkan prestasi pembahagian dengan ketara dan memudahkan saluran paip MaskTransformer yang kompleks untuk menjadikannya lebih boleh ditafsir.

Pertama, struktur penyahkod pengekod digunakan untuk mengekstrak ciri piksel daripada imej input. Piksel kemudian dikumpulkan menggunakan satu set pusat kluster, yang dikemas kini selanjutnya berdasarkan tugasan kluster. Akhir sekali, tugasan kluster dan langkah kemas kini dilakukan secara berulang, dan tugasan terakhir boleh digunakan terus sebagai ramalan segmentasi.

Untuk menukar penyahkod MaskTransformer biasa (terdiri daripada perhatian silang, perhatian diri berbilang kepala dan rangkaian suapan ke hadapan) ke dalam satu yang dicadangkan di atas k-means cross-attention, cuma gantikan softmax spatial-wise dengan parameter maksimum cluster-wise.

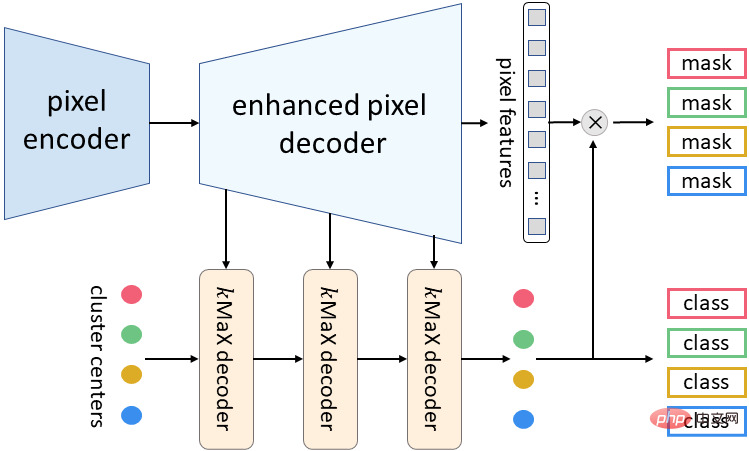

Seni bina meta kMaX-DeepLab yang dicadangkan kali ini terdiri daripada tiga komponen: pengekod piksel, penyahkod piksel dipertingkatkan dan penyahkod kMaX.

Pengekod piksel ialah tulang belakang mana-mana rangkaian dan digunakan untuk mengekstrak ciri imej.

Penyahkod piksel yang dipertingkatkan termasuk pengekod Transformer untuk meningkatkan ciri piksel dan lapisan pensampelan untuk menjana ciri peleraian yang lebih tinggi.

Satu siri penyahkod kMaX menukar pusat kluster kepada (1) vektor pembenaman Topeng, yang didarab dengan ciri piksel untuk menjana Topeng yang diramalkan, dan (2) ramalan kelas untuk setiap Topeng.

kMaX-DeepLab’s meta-architecture

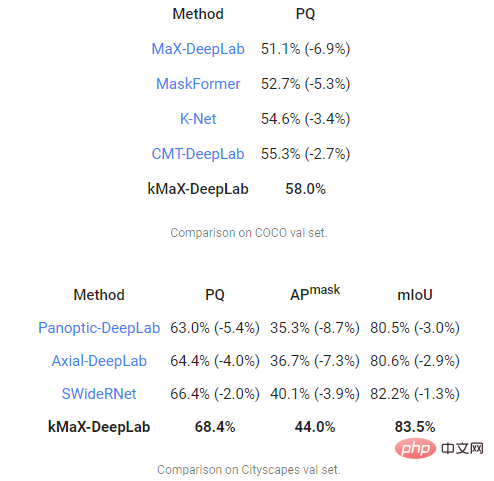

Akhir sekali, pasukan penyelidik melakukan dua data pensegmenan panorama yang paling mencabar Kami nilai CMT-DeepLab dan kMaX-DeepLab menggunakan metrik Kualiti Panorama (PQ) pada COCO dan Cityscapes, dan bandingkan MaX-DeepLab dengan kaedah terkini yang lain.

Antaranya, CMT-DeepLab mencapai peningkatan prestasi yang ketara, manakala kMaX-DeepLab bukan sahaja memudahkan pengubahsuaian, tetapi juga menambah baik PQ pada set COCO val ialah 58.0%, PQ ialah 68.4%, dan 44.0%. Ketepatan Purata Topeng (AP Mask), 83.5% purata persimpangan atas kesatuan (mIoU) pada set pengesahan Cityscapes, tanpa penambahan masa ujian atau penggunaan set data luaran.

Direka bentuk dari perspektif pengelompokan, kMaX-DeepLab bukan sahaja mempunyai prestasi yang lebih tinggi, tetapi juga boleh menggambarkan peta perhatian dengan lebih munasabah untuk memahami mekanisme kerjanya.

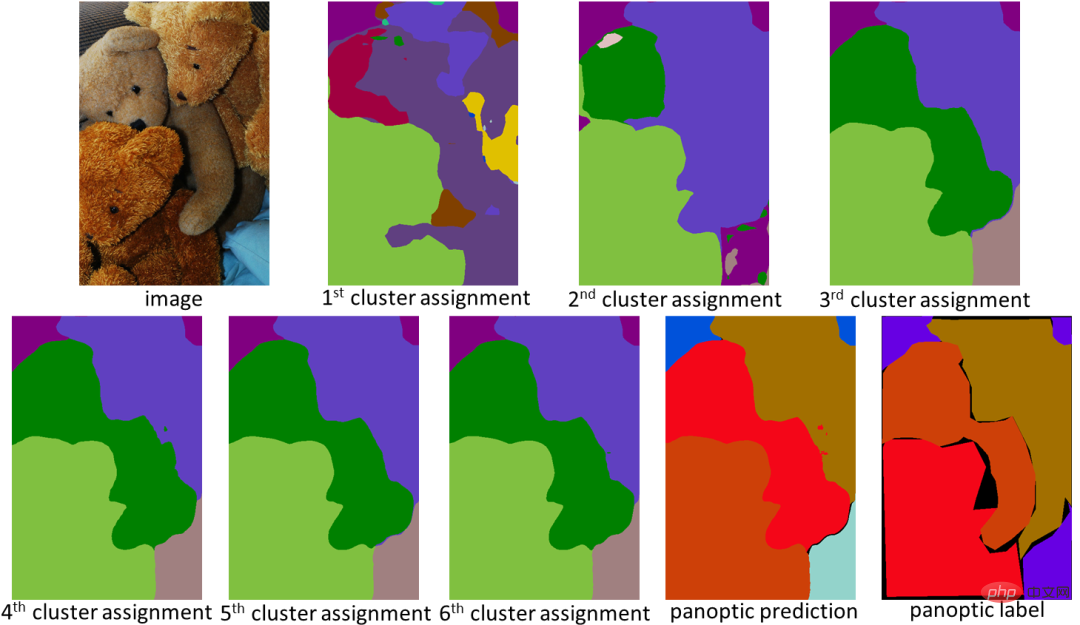

Dalam contoh di bawah, kMaX-DeepLab secara berulang melaksanakan tugasan kelompok dan kemas kini, meningkatkan kualiti Topeng secara beransur-ansur.

Peta perhatian kMaX-DeepLab boleh divisualisasikan secara langsung sebagai segmentasi panorama, menjadikan mekanisme kerja model lebih munasabah

Penyelidikan ini Menunjukkan cara untuk mereka bentuk MaskTransformers dengan lebih baik dalam tugas penglihatan.

Dengan pengubahsuaian mudah, CMT-DeepLab dan kMaX-DeepLab menstruktur semula perhatian silang supaya lebih seperti algoritma pengelompokan.

Oleh itu, model yang dicadangkan mencapai prestasi terkini pada set data COCO dan Cityscapes.

Pasukan penyelidik menyatakan bahawa mereka berharap versi sumber terbuka kMaX-DeepLab dalam perpustakaan DeepLab2 akan menyumbang kepada penyelidikan masa depan tentang reka bentuk seni bina Transformer visual.

Atas ialah kandungan terperinci Pasukan Google melancarkan Transformer baharu untuk mengoptimumkan penyelesaian pembahagian panoramik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

paging mysql

paging mysql

Apakah kekunci pintasan untuk menukar pengguna?

Apakah kekunci pintasan untuk menukar pengguna?

Bagaimana untuk menyelesaikan masalah bahawa folder Win10 tidak boleh dipadamkan

Bagaimana untuk menyelesaikan masalah bahawa folder Win10 tidak boleh dipadamkan

Bagaimana untuk membuka ramdisk

Bagaimana untuk membuka ramdisk

Perkara yang perlu dilakukan jika alamat IP anda diserang

Perkara yang perlu dilakukan jika alamat IP anda diserang

Bagaimana untuk memotong gambar panjang pada telefon bimbit Huawei

Bagaimana untuk memotong gambar panjang pada telefon bimbit Huawei

mybatis cache tahap pertama dan cache tahap kedua

mybatis cache tahap pertama dan cache tahap kedua

Penggunaan fungsi get dalam bahasa c

Penggunaan fungsi get dalam bahasa c