Sejak AlphaGo mengalahkan manusia di Go pada 2016, saintis DeepMind telah berusaha untuk meneroka algoritma kecerdasan buatan am yang berkuasa, dan Oriol Vinyals adalah salah satu daripadanya.

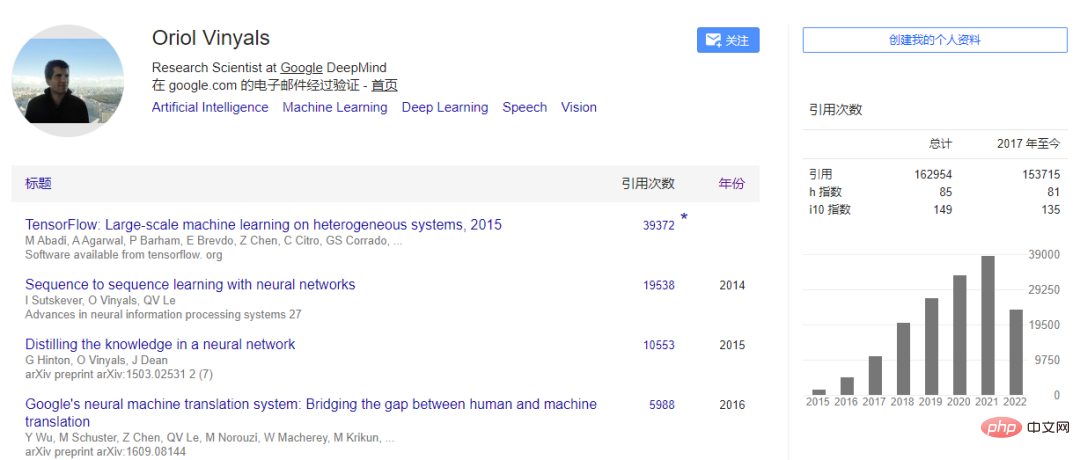

Vinyals menyertai DeepMind pada 2016 dan kini berkhidmat sebagai ketua saintis, mengetuai kumpulan pembelajaran mendalam. Sebelum ini dia bekerja di Google Brain. PhD beliau berada di University of California, Berkeley, di mana beliau menerima Anugerah Inovator MIT TR35 2016. Hasil penyelidikannya dalam seq2seq, penyulingan pengetahuan dan TensorFlow telah digunakan pada produk seperti Terjemahan Google, teks ke pertuturan dan pengecaman pertuturan. Artikelnya telah dipetik lebih daripada 160,000 kali.

Baru-baru ini, Oriol Vinyals menjadi tetamu di podcast Lex Fridman dan bercakap tentang beberapa pemikirannya tentang pembelajaran mendalam, ejen generalis Gato, pembelajaran meta, rangkaian saraf, kesedaran AI , dsb. pandangan. Vinyals percaya:

Fridman: Adakah mungkin dalam hidup kita untuk membina sistem AI yang boleh menggantikan kita sebagai penemuduga atau orang yang ditemuduga dalam perbualan ini?

Vinyals:Apa yang saya ingin tanya ialah, adakah kita mahu mencapainya? Saya gembira melihat bahawa kami menggunakan model yang sangat berkuasa dan berasa seperti mereka semakin dekat dengan kami, tetapi persoalannya, adakah ia masih menjadi artifak yang menarik tanpa sisi manusia dalam perbualan? Mungkin tidak. Sebagai contoh, dalam StarCraft, kita boleh mencipta ejen untuk bermain permainan dan bersaing dengan diri mereka sendiri, tetapi akhirnya perkara yang orang ambil peduli ialah bagaimana ejen lakukan apabila pesaing itu adalah manusia. Jadi tidak ada keraguan bahawa kami akan menjadi lebih kuat dengan AI. Sebagai contoh, anda boleh menapis beberapa masalah yang sangat menarik dari sistem AI Dalam bidang bahasa, kami kadang-kadang memanggil ini "Terry Picking". Begitu juga, jika saya mempunyai alat seperti ini sekarang, anda bertanya soalan yang menarik dan sistem tertentu akan memilih beberapa perkataan untuk membentuk jawapan, tetapi itu tidak begitu menarik bagi saya.

Fridman: Bagaimana jika membangkitkan orang adalah sebahagian daripada fungsi objektif sistem ini?

Vinyals: Dalam permainan, apabila anda mereka bentuk algoritma, anda boleh menulis fungsi ganjaran sebagai matlamat. Tetapi jika anda boleh mengukurnya dan mengoptimumkannya, apakah yang menarik tentangnya? Ini mungkin sebab kami bermain permainan video, berinteraksi dalam talian dan menonton video kucing. Sesungguhnya, adalah sangat menarik untuk memodelkan ganjaran melebihi fungsi ganjaran yang jelas digunakan dalam pembelajaran pengukuhan. Selain itu, AI melakukan beberapa kemajuan penting dalam aspek tertentu, contohnya, kita boleh menilai sama ada perbualan atau maklumat boleh dipercayai berdasarkan penerimaannya di Internet. Kemudian jika anda boleh mempelajari fungsi secara automatik, anda boleh mengoptimumkan dengan lebih mudah dan kemudian mengadakan perbualan untuk mengoptimumkan beberapa maklumat yang kurang jelas seperti keseronokan. Adalah menarik untuk membina sistem di mana sekurang-kurangnya satu aspek didorong sepenuhnya oleh fungsi ganjaran yang menggembirakan.

Tetapi jelas sekali, sistem itu masih mengandungi banyak elemen manusia daripada pembina sistem, dan label untuk keseronokan datang daripada kami, jadi sukar untuk mengira keseronokan. Setahu saya, belum ada yang buat macam ni.

Fridman: Mungkin sistem juga perlu mempunyai jati diri yang kuat. Ia akan mempunyai kenangan dan dapat bercerita tentang masa lalunya. Ia boleh belajar daripada pendapat yang kontroversi kerana terdapat banyak data di Internet tentang pendapat yang dipegang orang, dan keseronokan yang dikaitkan dengan pendapat tertentu. Sistem ini boleh mencipta sesuatu daripadanya yang tidak lagi mengoptimumkan tatabahasa dan verisimilitude, tetapi mengoptimumkan ketekalan manusia ayat.Vinyal: Dari perspektif pembina rangkaian saraf, kecerdasan buatan, biasanya anda cuba memetakan banyak topik menarik yang anda bincangkan ke dalam penanda aras dan kemudian juga tentang sistem tersebut Dalam keadaan sebenar semasa seni bina bagaimana ia dibina, cara ia belajar, data apa yang ia pelajari, dan apa yang ia pelajari, perkara yang akan kita bincangkan di sini ialah berat fungsi matematik.

Dengan keadaan permainan semasa, apakah yang kita perlukan untuk mencapai pengalaman hidup ini, seperti ketakutan? Dari segi bahasa, kami melihat kemajuan yang sangat sedikit sekarang kerana apa yang kami lakukan sekarang ialah mengambil banyak interaksi manusia dalam talian dan kemudian mengekstrak urutan, yang merupakan rentetan perkataan, huruf, imej, bunyi, modaliti, dan kemudian cuba mempelajari fungsi, melalui rangkaian saraf, untuk memaksimumkan kemungkinan melihat jujukan ini.

Beberapa cara kami melatih model ini pada masa ini diharapkan dapat mengembangkan jenis keupayaan yang anda bincangkan. Salah satunya ialah kitaran hayat ejen atau model, yang model belajar daripada data luar talian, jadi ia hanya memerhati dan memaksimumkan secara pasif. Sama seperti dalam landskap pergunungan, tambah berat apabila terdapat data interaksi manusia di mana-mana; Model biasanya tidak mengalami sendiri, mereka hanya pemerhati pasif data. Kami kemudiannya meminta mereka menjana data semasa kami berinteraksi dengan mereka, tetapi ini sangat mengehadkan pengalaman yang sebenarnya mungkin mereka alami semasa mengoptimumkan atau mengoptimumkan berat lagi. Tetapi kita belum sampai ke peringkat itu lagi.

Dalam AlphaGo dan SlphaStar, kami menggunakan model dan membiarkannya bersaing dengan manusia atau berinteraksi dengan manusia (seperti model bahasa) untuk melatih model. Mereka tidak dilatih secara berterusan, mereka tidak belajar berdasarkan pemberat yang dipelajari daripada data, dan mereka tidak terus memperbaiki diri.

Tetapi jika anda berfikir tentang rangkaian saraf, dapat difahami bahawa mereka mungkin tidak belajar daripada perubahan berat dalam erti kata yang ketat, yang berkaitan dengan cara neuron saling berkaitan dan cara kita belajar sepanjang hidup kita. Tetapi apabila anda bercakap dengan sistem ini, konteks perbualan memang wujud dalam ingatan mereka. Ia seperti jika anda boot komputer dan ia mempunyai banyak maklumat pada cakera kerasnya, anda juga mempunyai akses ke Internet yang mengandungi semua maklumat. Terdapat juga ingatan, yang kami anggap sebagai harapan ejen.

Storan sangat terhad pada masa ini, kita kini bercakap tentang kira-kira 2,000 perkataan yang kita ada, selain itu kita mula melupakan apa yang kita lihat, jadi ada kesinambungan jangka pendek. Jika ejen mempunyai koheren, maka jika anda bertanya "siapa nama anda," ia boleh mengingati ayat itu, tetapi ia mungkin melupakan konteks melebihi 2,000 perkataan.

Jadi secara teknikalnya, terdapat had sedemikian kepada apa yang orang boleh jangkakan daripada pembelajaran mendalam. Tetapi kami berharap penanda aras dan teknologi boleh mempunyai pengumpulan berterusan pengalaman memori, dan pembelajaran luar talian jelas sangat berkuasa. Kami telah pergi jauh, dan kami telah melihat sekali lagi kuasa tiruan ini atau skala Internet untuk mendapatkan berat perkara asas tentang dunia ini, tetapi pengalaman itu kurang.

Malah, apabila kita bercakap dengan sistem, kita tidak melatih mereka melainkan ingatan mereka terjejas. Itulah bahagian dinamik, tetapi mereka tidak belajar dengan cara yang sama seperti anda dan saya belajar sejak lahir. Jadi untuk soalan anda, perkara yang saya nyatakan di sini ialah ingatan dan pengalaman berbeza daripada sekadar memerhati dan belajar tentang dunia.

Masalah kedua yang saya lihat ialah kami melatih semua model ini dari awal. Nampaknya jika kita tidak melatih model dari awal dan mencari inspirasi dari awal lagi, sesuatu akan hilang. Perlu ada beberapa cara untuk kita melatih model seperti spesies setiap beberapa bulan, manakala banyak unsur alam semesta yang lain dibina daripada lelaran sebelumnya. Dari perspektif rangkaian neural tulen, sukar untuk tidak membuang pemberat sebelumnya, kami mempelajari dan mengemas kini pemberat ini daripada data. Jadi rasanya seperti ada sesuatu yang hilang, dan akhirnya kami mungkin akan menemuinya, tetapi rupanya masih belum jelas.

Fridman: Latihan dari awal kelihatan seperti satu pembaziran, setiap kali kita menyelesaikan masalah Go dan catur, StarCraft, lipatan protein, mesti ada beberapa cara untuk menggunakan semula pemberat semasa kita mengukur pangkalan data rangkaian saraf baharu yang besar . Jadi bagaimana kita menggunakan semula berat? Bagaimanakah anda belajar mengekstrak perkara yang boleh digeneralisasikan dan cara membuang yang lain? Bagaimana untuk memulakan pemberat dengan lebih baik?

Vinyal: Di tengah-tengah pembelajaran mendalam ialah idea bernas bahawa satu algoritma menyelesaikan semua tugas. Apabila semakin banyak tanda aras muncul, prinsip asas ini telah terbukti mustahil. Iaitu, anda mempunyai permulaan seperti otak pengiraan kosong bagi rangkaian saraf, dan kemudian anda menyuapnya lebih banyak perkara dalam pembelajaran terselia.

Situasi yang ideal ialah apa yang diharapkan input, outputnya harus seperti apa adanya. Sebagai contoh, pengelasan imej mungkin untuk memilih satu daripada 1000 kategori Ini ialah rangkaian imej. Banyak masalah boleh dipetakan dengan cara ini. Perlu ada juga pendekatan umum yang boleh anda gunakan untuk sebarang tugasan tanpa membuat banyak perubahan atau pemikiran, yang saya fikir adalah teras penyelidikan pembelajaran mendalam.

Kami belum mengetahuinya lagi, tetapi ia akan menjadi menarik jika orang ramai dapat menemui kurang helah (algoritma umum) untuk menyelesaikan masalah penting. Pada tahap algoritma, kami sudah mempunyai sesuatu yang umum, formula untuk melatih model rangkaian saraf yang sangat berkuasa pada jumlah data yang besar.

Dalam banyak kes, anda perlu mempertimbangkan kekhususan beberapa masalah praktikal. Masalah lipatan protein adalah penting dan sudah ada beberapa pendekatan asas seperti model Transformer, rangkaian saraf graf, cerapan daripada NLP (seperti BERT), dan penyulingan pengetahuan. Dalam formula ini, kita juga perlu mencari sesuatu yang unik untuk masalah lipatan protein, yang sangat penting dan kita harus menyelesaikannya, dan kemungkinan pengetahuan yang dipelajari dalam masalah ini akan digunakan untuk lelaran seterusnya penyelidik pembelajaran mendalam.

Mungkin dalam 23 tahun yang lalu, dalam bidang meta-pembelajaran, algoritma umum telah mencapai sedikit kemajuan, terutamanya GPT-3 yang dihasilkan dalam bidang bahasa. Model ini hanya dilatih sekali, dan ia tidak terhad kepada menterjemah bahasa atau hanya mengetahui sentimen yang mendasari ayat, yang sebenarnya boleh diajar kepadanya melalui pembayang, yang pada dasarnya menunjukkan kepada mereka lebih banyak contoh. Kita digesa melalui bahasa, dan bahasa itu sendiri adalah cara semula jadi untuk kita belajar daripada satu sama lain. Mungkin ia akan bertanya kepada saya beberapa soalan dahulu, dan kemudian saya memberitahunya ia harus melakukan tugas baharu ini. Anda tidak perlu melatihnya semula dari awal. Kami telah melihat beberapa detik ajaib dengan pembelajaran beberapa pukulan, didorong dengan bahasa dalam modaliti bahasa sahaja.

Sejak dua tahun lalu kami telah melihat ini berkembang kepada modaliti lain di luar bahasa, menambahkan visual, aksi dan permainan serta membuat kemajuan yang hebat. Ini mungkin satu cara untuk melaksanakan satu model. Masalahnya ialah sukar untuk menambah berat atau kapasiti pada model ini, tetapi ia sememangnya berkuasa.

Kemajuan semasa telah berlaku dalam tugas berasaskan teks atau tugas klasifikasi gaya visual, tetapi perlu ada lebih banyak penemuan. Kami mempunyai garis dasar yang baik, dan kami mahu garis dasar bergerak ke arah kecerdasan buatan umum, dan komuniti bergerak ke arah itu, yang sangat bagus. Apa yang menggembirakan saya ialah, apakah langkah seterusnya dalam pembelajaran mendalam untuk menjadikan model ini lebih berkuasa? Bagaimana untuk melatih mereka? Jika mereka mesti berkembang, bagaimana mereka boleh "dibiakkan"? Sekiranya mereka menukar berat apabila anda mengajarnya tugas? Masih banyak persoalan yang perlu dijawab.

Fridman: Bolehkah anda menerangkan "Meow" dan ungkapan kucing dalam tweet anda? Dan apa itu Gato? Bagaimana ia berfungsi? Apakah jenis rangkaian saraf yang terlibat? Bagaimana untuk melatih?

Vinyals: Pertama sekali, nama Gato, seperti siri model lain yang dikeluarkan oleh DeepMind, dinamakan sempena haiwan. Model jujukan besar bermula dengan bahasa sahaja, tetapi kami berkembang kepada modaliti lain. Gopher, Chinchilla, ini adalah model bahasa tulen, dan baru-baru ini kami mengeluarkan Flamingo, yang meliputi penglihatan. Gato menambah modaliti visual dan tindakan Tindakan diskret seperti atas, bawah, kiri dan kanan boleh dipetakan secara semula jadi daripada perkataan kepada model jujukan bahasa yang berkuasa.

Sebelum mengeluarkan Gato, kami membincangkan haiwan mana yang patut kami pilih untuk menamakannya, saya rasa perkara utama yang perlu dipertimbangkan ialah ejen am, iaitu sifat unik Gato dalam bahasa Sepanyol Ia bermaksud "kucing "dalam bahasa Cina.

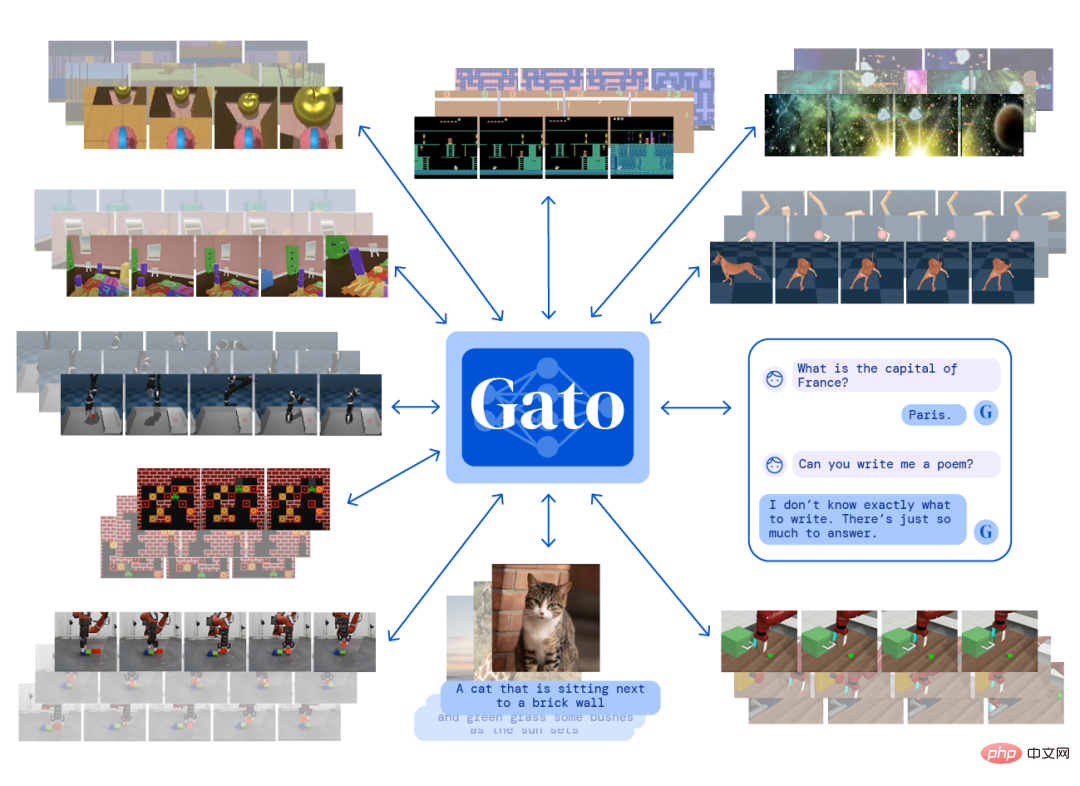

Asas Gato tidak berbeza dengan banyak pekerjaan lain. Ia adalah model Transformer, rangkaian saraf berulang yang merangkumi pelbagai modaliti, termasuk penglihatan, bahasa dan tindakan. Matlamat semasa latihan adalah untuk dapat meramalkan apa yang seterusnya dalam urutan Jika latihan adalah urutan tindakan, maka ia adalah untuk meramalkan apakah tindakan seterusnya. Urutan aksara dan urutan imej juga serupa. Kami menganggap mereka semua sebagai bait, dan tugas model adalah untuk meramalkan bait seterusnya, dan kemudian anda boleh memahami bait ini sebagai tindakan dan menggunakan tindakan ini dalam permainan anda juga boleh memahaminya sebagai perkataan tindakan dan menulis perkataan turun semasa perbualan dengan sistem.

Input Gato termasuk imej, teks, video, tindakan dan beberapa penderia persepsi daripada robot, kerana robot juga merupakan sebahagian daripada kandungan latihan. Ia mengeluarkan teks dan tindakan, ia tidak mengeluarkan imej pada masa ini Kami mereka bentuk bentuk keluaran, jadi saya katakan Gato adalah permulaan, kerana terdapat lebih banyak kerja yang perlu dilakukan. Pada asasnya, Gato ialah otak yang, jika anda memberikan sebarang urutan pemerhatian dan modaliti, ia akan mengeluarkan langkah seterusnya dalam urutan itu. Kemudian anda memulakan langkah anda ke yang seterusnya dan terus meramalkan yang seterusnya, dan seterusnya.

Kini ia bukan sahaja model bahasa Anda boleh bersembang dengan Gato seperti anda bersembang dengan Chinchilla dan Flamingo, tetapi ia juga merupakan ejen yang universal pada pelbagai set data hanya mahir dalam permainan StarCraft, Atari, atau Go.

Fridman: Dari segi modaliti tindakan, apakah jenis model yang boleh dipanggil "ejen pintar"?

Vinyals: Pada pendapat saya, ejen sebenarnya adalah keupayaan untuk mengambil tindakan dalam persekitaran. Ia bertindak balas dengan memberikan tindakan kepada persekitaran, yang mengembalikan pemerhatian baharu, dan kemudian menjana tindakan seterusnya.

Cara kami melatih Gato ialah mengekstrak set data pemerhatian, yang merupakan algoritma pembelajaran tiruan berskala besar, seperti melatihnya untuk meramalkan perkataan seterusnya dalam set data. Kami mempunyai set data orang yang menghantar mesej dan bersembang di halaman web.

DeepMind berminat dengan pembelajaran pengukuhan dan agen pembelajaran yang berfungsi dalam persekitaran yang berbeza. Kami membangunkan set data yang merekodkan trajektori pengalaman ejen. Ejen lain yang kami latih adalah untuk satu matlamat, seperti mengawal persekitaran permainan tiga dimensi dan menavigasi labirin, dan kami menambah pengalaman yang diperoleh daripada interaksi ejen dengan persekitaran kepada set data.

Apabila melatih Gato, kami mencampurkan data seperti perkataan dan interaksi antara ejen dan persekitaran untuk latihan Ini adalah "kesejagatan" Gato Untuk modaliti dan tugas yang berbeza, ia hanya mempunyai "otak" tunggal ", dan berbanding kebanyakan rangkaian saraf dalam beberapa tahun kebelakangan ini, ia tidak begitu besar, dengan hanya 1 bilion parameter.

Walaupun saiznya kecil, set data latihannya sangat mencabar dan pelbagai, mengandungi bukan sahaja data Internet tetapi juga pengalaman interaksi ejen dengan persekitaran yang berbeza.

Pada dasarnya, Gato boleh mengawal sebarang persekitaran, terutamanya permainan video terlatih, pelbagai tugas robot dan persekitaran lain. Tetapi ia tidak akan lebih baik daripada guru yang mengajarnya Skala masih agak kecil, jadi ia adalah satu permulaan yang meningkatkan sinergi antara pelbagai modaliti. Dan saya percaya akan ada beberapa cara baru untuk mengkaji atau menyediakan data, contohnya kita perlu menjelaskan kepada model bahawa ia bukan hanya mempertimbangkan pergerakan naik dan turun semasa bermain permainan Atari, ejen perlu dapat melihat skrin sebelum mula bermain permainan Dengan latar belakang tertentu, anda boleh menggunakan teks untuk memberitahunya "Saya menunjukkan kepada anda urutan keseluruhan dan anda akan mula bermain permainan ini." Jadi teks mungkin cara untuk meningkatkan data.

Fridman: Bagaimana untuk mengimbangkan teks, imej, tindakan permainan dan tugasan robot?

Vinyals: Soalan yang bagus. Tokenisasi ialah titik permulaan untuk menjadikan semua data dalam urutan, ia seperti kita memecahkan segala-galanya kepada kepingan teka-teki ini dan kemudian kita boleh mensimulasikan rupa teka-teki itu. Apabila anda membariskannya, ia menjadi satu urutan. Gato menggunakan teknologi tokenisasi teks standard semasa Kami mengetokkan teks melalui subrentetan yang biasa digunakan Contohnya, "ing" ialah subrentetan yang biasa digunakan dalam bahasa Inggeris, jadi ia boleh digunakan sebagai token.

Fridman: Berapa banyak token yang diperlukan untuk satu perkataan?

Vinyals: Untuk perkataan Inggeris, butiran tokenisasi semasa secara amnya ialah 2~5 simbol, yang lebih besar daripada huruf dan lebih kecil daripada perkataan.

Fridman: Pernahkah anda mencuba tokenisasi emoji?

Vinyal: emoji sebenarnya hanyalah urutan huruf.

Fridman: Adakah imej atau teks emoji?

Vinyal: sebenarnya boleh memetakan emoji kepada jujukan aksara, jadi anda boleh menyuap emoji kepada model dan ia akan mengeluarkan emoji. Dalam Gato, cara kami memproses imej adalah dengan memampatkannya menjadi piksel dengan keamatan yang berbeza-beza, menghasilkan urutan piksel yang sangat panjang.

Fridman: Jadi tiada semantik yang terlibat? Anda tidak perlu memahami apa-apa tentang imej itu?

Vinyal: Ya, hanya konsep mampatan digunakan di sini. Pada tahap tokenisasi, apa yang kami lakukan ialah mencari corak biasa untuk memampatkan imej.

Fridman: Maklumat visual seperti warna memang menangkap makna imej, bukan sekadar statistik.

Vinyal: Dalam pembelajaran mesin, kaedah pemprosesan imej adalah lebih dipacu data. Kami hanya menggunakan statistik imej dan kemudian mengukurnya. Subrentetan biasa diletakkan sebagai token dan imej adalah serupa, tetapi tiada hubungan antara mereka. Jika kita menganggap token sebagai integer, katakan teks itu mempunyai 10,000 token, dari 1 hingga 10,000, dan ia mewakili semua bahasa dan perkataan yang akan kita lihat.

Imej ialah satu lagi set integer, dari 10001 hingga 20000, yang bebas sepenuhnya. Apa yang menghubungkan mereka ialah data, dan dalam set data, tajuk imej memberitahu tentang imej itu. Model perlu meramalkan daripada teks kepada piksel, dan korelasi antara kedua-duanya berlaku semasa algoritma belajar. Selain perkataan dan imej, kami juga boleh menetapkan integer kepada tindakan, mendiskrisikannya dan menggunakan idea yang serupa untuk memampatkan tindakan menjadi token.

Inilah cara kami kini memetakan semua jenis spatial kepada jujukan integer, masing-masing menempati ruang yang berbeza dan yang menghubungkannya ialah algoritma pembelajaran.

Fridman: Anda telah menyebut sebelum ini bahawa sukar untuk skala Apa yang anda maksudkan? Sesetengah kemunculan mempunyai ambang skala Mengapa sukar untuk mengembangkan rangkaian seperti Gato?

Vinyal: Jika anda melatih semula rangkaian Gato, meningkatkan skala tidaklah begitu sukar. Intinya ialah kita kini mempunyai 1 bilion parameter, bolehkah kita menggunakan pemberat yang sama untuk mengubahnya menjadi otak yang lebih besar? Ini sangat sukar. Oleh itu, terdapat konsep modulariti dalam kejuruteraan perisian, dan terdapat beberapa kajian yang menggunakan modulariti. Flamingo tidak mengendalikan tindakan, tetapi ia berkuasa dalam mengendalikan imej, dan tugas antara projek ini berbeza dan modular.

Kami melaksanakan modulariti dengan sempurna dalam model Flamingo, kami mengambil pemberat daripada model bahasa tulen Chinchilla, kemudian membekukan pemberat tersebut dan menyambung beberapa rangkaian saraf baharu di tempat yang betul dalam model. Anda perlu memikirkan cara menambah fungsi tambahan tanpa memecahkan fungsi lain.

Kami mencipta sub-rangkaian kecil yang tidak dimulakan secara rawak tetapi belajar melalui penyeliaan diri. Kami kemudian menggunakan set data untuk menyambung dua modaliti, visual dan lisan. Kami membekukan bahagian terbesar rangkaian dan kemudian menambah beberapa parameter di atas latihan dari awal. Kemudian Flamingo muncul, inputnya adalah teks dan imej, dan outputnya adalah teks. Anda boleh mengajarnya tugas penglihatan baharu, dan ia melakukan perkara-perkara di luar apa yang disediakan oleh set data itu sendiri, tetapi ia memanfaatkan banyak pengetahuan bahasa yang diperoleh daripada Chinchilla.

Idea utama modulariti ini ialah kita mengambil otak beku dan menambah fungsi baharu padanya. Pada tahap tertentu, anda dapat melihat bahawa walaupun di DeepMind, kami mempunyai eklektik Flamingo ini, yang membolehkan penggunaan skala yang lebih munasabah tanpa perlu melatih semula sistem dari awal.

Walaupun Gato juga menggunakan set data yang sama, ia dilatih dari awal. Jadi saya rasa persoalan besar bagi masyarakat ialah, patutkah kita berlatih dari awal, atau patutkah kita menerima modulariti? Modulariti sangat berkesan sebagai cara untuk skala.

Fridman: Selepas kemunculan Gato, bolehkah kita mentakrifkan semula istilah "meta-pembelajaran"? Pada pendapat anda, apakah meta-pembelajaran itu? Adakah meta-pembelajaran akan kelihatan seperti Gato yang diperluaskan dalam 5 atau 10 tahun?

Vinyals: Mungkin melihat ke belakang dan bukannya ke hadapan akan memberikan perspektif yang baik. Apabila kita bercakap tentang meta-pembelajaran pada 2019, maknanya kebanyakannya telah berubah dengan revolusi GPT-3. Penanda aras pada masa itu adalah mengenai keupayaan untuk mempelajari identiti objek, jadi ia sangat sesuai untuk penglihatan dan klasifikasi objek. Kami bukan sahaja mempelajari 1000 kategori yang ImageNet suruh kami pelajari, kami juga mempelajari kategori objek yang boleh ditakrifkan semasa berinteraksi dengan model.

Evolusi model itu menarik. Untuk bermula, kami mempunyai bahasa khas, iaitu set data kecil, dan kami menggesa model dengan tugas pengelasan baharu. Dengan pembayang dalam bentuk set data pembelajaran mesin, kami mendapat sistem yang boleh meramalkan atau mengelaskan objek semasa kami mentakrifkannya. Akhirnya, model bahasa menjadi pelajar. GPT-3 menunjukkan bahawa kita boleh menumpukan pada klasifikasi objek dan maksud meta-pembelajaran dalam konteks kelas objek pembelajaran.

Kini, kami tidak lagi terikat dengan penanda aras, kami boleh memberitahu model secara langsung beberapa tugas logik melalui bahasa semula jadi. Model ini tidak sempurna, tetapi mereka melakukan tugasan baharu dan memperoleh keupayaan baharu melalui meta-pembelajaran. Model Flamingo meluas kepada kepelbagaian visual dan bahasa tetapi mempunyai keupayaan yang sama. Anda boleh mengajarnya. Sebagai contoh, satu ciri yang muncul ialah anda boleh mengambil gambar nombor dan mengajarnya melakukan aritmetik. Anda tunjukkan beberapa contoh dan ia belajar, jadi ia melangkaui klasifikasi imej sebelumnya.

Ini memperluaskan maksud meta-pembelajaran pada masa lalu. Meta-pembelajaran adalah istilah yang sentiasa berubah. Memandangkan perkembangan semasa, saya teruja untuk melihat apa yang berlaku seterusnya, mungkin dalam 5 tahun ia akan menjadi cerita lain. Kami mempunyai sistem yang mempunyai satu set pemberat dan kami boleh mengajarnya bermain StarCraft melalui gesaan interaktif. Bayangkan anda bercakap dengan sistem, mengajarnya permainan baharu dan tunjukkan contoh permainan tersebut. Mungkin sistem juga akan bertanya kepada anda soalan, seperti, "Saya baru sahaja bermain permainan ini, adakah saya bermain dengan baik? Bolehkah anda mengajar saya lebih banyak lagi, jadi lima atau sepuluh tahun dari sekarang, dalam bidang khusus, elemen ini Keupayaan pembelajaran akan menjadi lebih interaktif?" dan lebih kaya. Contohnya, AlphaStar, yang kami bangunkan khusus untuk StarCraft, sangat berbeza. Algoritma adalah umum, tetapi pemberatnya adalah khusus.

Pembelajaran meta melangkaui gesaan untuk memasukkan lebih banyak interaksi. Sistem mungkin memberitahu kami untuk memberikan maklum balas selepas ia membuat kesilapan atau kalah dalam permainan. Malah, penanda aras sudah ada, kita hanya menukar matlamat mereka. Oleh itu, saya suka menganggap kecerdasan buatan umum sebagai: kita sudah mempunyai prestasi 101% pada tugas tertentu seperti catur dan StarCraft, dan dalam lelaran seterusnya, kita boleh mencapai 20% pada semua tugas . Kemajuan model generasi akan datang pasti ke arah ini. Sudah tentu kita mungkin tersilap dalam beberapa perkara, seperti kita mungkin tidak mempunyai alatan, atau mungkin tidak cukup Transformer. Dalam 5 hingga 10 tahun akan datang, berat model mungkin telah dilatih, dan ia akan lebih kepada mengajar atau membenarkan model untuk meta-belajar.

Ini adalah pengajaran interaktif. Dalam bidang pembelajaran mesin, kaedah ini telah lama tidak digunakan untuk menangani tugasan pengelasan. Idea saya kedengaran sedikit seperti algoritma jiran terdekat Ia adalah algoritma yang paling mudah dan tidak memerlukan pembelajaran atau pengiraan kecerunan. Jiran terdekat mengukur jarak antara titik dalam set data, dan kemudian untuk mengklasifikasikan titik baharu, anda hanya perlu mengira titik terdekat dalam jumlah data yang besar ini. Jadi, anda boleh menganggap pembayang sebagai: anda bukan sahaja memproses mata mudah semasa memuat naik, tetapi anda menambah pengetahuan kepada sistem pra-latihan.

Petuanya ialah pembangunan konsep yang sangat klasik dalam pembelajaran mesin, iaitu pembelajaran dengan titik terdekat. Salah satu kajian kami pada tahun 2016 menggunakan kaedah jiran terdekat, yang juga sangat biasa dalam bidang penglihatan komputer Bagaimana untuk mengira jarak antara dua imej adalah kawasan penyelidikan yang sangat aktif Jika anda boleh mendapatkan matriks Jarak yang baik, anda boleh juga mendapat pengelas yang baik.

Jarak dan titik ini tidak terhad kepada imej, tetapi juga boleh berupa teks atau teks, imej, urutan tindakan dan maklumat baharu lain yang diajar kepada model. Kami mungkin tidak akan melakukan latihan bebanan lagi. Sesetengah teknik meta-pembelajaran melakukan beberapa penalaan halus, dan apabila mereka mendapat tugasan baharu, mereka melatih pemberat itu sedikit.

Fridman: Kami telah membuat model dan ejen am, berskala besar seperti Flamingo, Chinchilla dan Gopher, yang secara teknikalnya Apa yang istimewa tentang ia?

Vinyals: Saya rasa kunci kejayaan ialah kejuruteraan. Yang pertama ialah kejuruteraan data, kerana apa yang akhirnya kami kumpulkan ialah set data. Kemudian datang projek penempatan, di mana kami menggunakan model ke beberapa kelompok pengkomputeran secara besar-besaran. Faktor kejayaan ini terpakai untuk segala-galanya, syaitan memang dalam perincian.

Lainnya ialah kemajuan semasa dalam penanda aras Satu pasukan menghabiskan beberapa bulan melakukan kajian dan tidak pasti sama ada ia akan berjaya, tetapi jika anda tidak mengambil risiko dan melakukan sesuatu yang kelihatan mustahil, anda akan'. t. Terdapat peluang untuk berjaya. Walau bagaimanapun, kita memerlukan cara untuk mengukur kemajuan, jadi mewujudkan penanda aras adalah penting.

Kami membangunkan AlphaFold menggunakan penanda aras yang meluas, dan data serta penunjuk untuk projek ini tersedia. Pasukan yang baik tidak seharusnya mencari beberapa peningkatan tambahan dan menerbitkan kertas kerja, tetapi tentang mempunyai matlamat yang lebih tinggi dan mengusahakannya selama bertahun-tahun.

Dalam bidang pembelajaran mesin, kami menyukai seni bina seperti rangkaian saraf, dan sebelum Transformer hadir, ini adalah bidang yang sangat pesat berkembang. "Attentionis All You Need" sememangnya topik esei yang hebat. Seni bina ini memenuhi impian kami untuk memodelkan sebarang jujukan bait. Saya fikir kemajuan seni bina ini terletak pada cara rangkaian saraf berfungsi sedikit sebanyak Sukar untuk mencari seni bina yang dicipta lima tahun lalu dan masih stabil dan telah berubah sangat sedikit, jadi Transformer boleh terus muncul dalam banyak projek. .

Fridman: Pada tahap falsafah teknologi, di manakah terletaknya keajaiban perhatian? Bagaimanakah perhatian berfungsi dalam minda manusia?

Vinyal: Terdapat perbezaan antara Transformer dan LSTM rangkaian saraf tiruan memori jangka pendek pada awal Transformer, LSTM masih merupakan model jujukan yang sangat berkuasa, seperti sebagai AlphaStar. Kuasa Transformer ialah ia mempunyai kecenderungan perhatian induktif yang terbina di dalamnya. Katakan kita ingin menyelesaikan tugas yang rumit untuk rentetan perkataan, seperti menterjemah seluruh perenggan, atau meramalkan perenggan seterusnya berdasarkan sepuluh perenggan sebelumnya.

Secara intuitif, cara Transformer melakukan tugasan ini ialah meniru dan menyalin manusia Dalam Transformer, anda sedang mencari sesuatu selepas anda membaca satu perenggan teks, anda akan memikirkan perkara yang akan berlaku seterusnya lihat sekali lagi pada teks, ini adalah proses yang didorong oleh hipotesis. Jika saya tertanya-tanya sama ada perkataan saya seterusnya ialah "kucing" atau "anjing," cara Transformer berfungsi ialah ia mempunyai dua andaian: Adakah ia kucing? Atau anjing? Jika ia kucing, saya akan mencari beberapa perkataan (tidak semestinya perkataan "kucing" itu sendiri) dan ke belakang untuk melihat sama ada "kucing" atau "anjing" lebih masuk akal.

Kemudian ia melakukan beberapa pengiraan yang sangat mendalam pada perkataan, ia menggabungkan perkataan, dan ia juga boleh membuat pertanyaan. Jika anda benar-benar berfikir tentang teks, anda perlu melihat kembali semua teks di atas, tetapi apakah yang mengarahkan perhatian? Apa yang baru saya tulis sudah tentu penting, tetapi apa yang anda tulis sepuluh muka surat yang lalu mungkin juga kritikal, jadi itu bukan peletakan yang perlu anda fikirkan, tetapi kandungannya. Transformer boleh menanyakan kandungan tertentu dan mengeluarkannya untuk membuat keputusan yang lebih baik. Ini adalah salah satu cara untuk menerangkan Transformer, dan saya rasa bias induktif ini sangat berkuasa. Transformer mungkin mempunyai beberapa perubahan terperinci dari semasa ke semasa, tetapi bias induktif menjadikan Transformer lebih berkuasa daripada rangkaian berulang berdasarkan bias kekinian, yang berkesan dalam beberapa tugas, tetapi ia mempunyai kelemahan yang sangat besar.

Transformer sendiri pun ada kelemahan. Saya fikir salah satu cabaran utama ialah gesaan yang baru kita bincangkan. Panjang gesaan boleh sehingga 1000 patah perkataan, malah saya perlu menunjukkan kepada sistem video dan artikel Wikipedia tentang permainan. Saya juga terpaksa berinteraksi dengan sistem semasa ia bermain permainan dan bertanyakan soalan kepada saya. Saya perlu menjadi guru yang baik untuk mengajar model untuk mencapai perkara di luar kemampuan semasa mereka. Jadi persoalannya, bagaimana kita menanda aras tugas-tugas ini? Bagaimanakah kita mengubah struktur seni bina? Ini kontroversi.

Fridman: Sejauh manakah pentingnya individu dalam semua kemajuan penyelidikan ini? Sejauh mana mereka telah mengubah bidang? Anda kini mengetuai penyelidikan pembelajaran mendalam di DeepMind, anda mempunyai banyak projek, ramai penyelidik yang cemerlang, berapa banyak perubahan yang boleh dibawa oleh semua manusia ini?

Vinyals: Saya percaya orang ramai memainkan peranan yang besar. Sesetengah orang ingin mendapatkan idea yang berkesan dan berpegang padanya, yang lain mungkin lebih praktikal dan tidak peduli idea apa yang berkesan asalkan mereka boleh memecahkan lipatan protein. Kami memerlukan kedua-dua idea yang kelihatan bertentangan ini. Dari segi sejarah, kedua-duanya menghasilkan sesuatu lambat laun. Perbezaan antara kedua-duanya juga mungkin serupa dengan apa yang dipanggil Exploration-Exploitation Tradeoff dalam bidang pembelajaran pengukuhan. Apabila berinteraksi dengan orang dalam pasukan atau dalam mesyuarat, anda akan mendapati dengan cepat bahawa sesuatu boleh diterokai atau boleh dieksploitasi.

Adalah salah untuk menafikan apa-apa jenis gaya penyelidikan Saya dari industri, jadi kami mempunyai kuasa pengkomputeran berskala besar untuk digunakan, dan terdapat juga jenis penyelidikan khusus yang sepadan. Untuk kemajuan sains, kita perlu menjawab soalan yang patut kita jawab sekarang.

Pada masa yang sama, saya telah melihat banyak kemajuan. Mekanisme perhatian pada asalnya ditemui di Montreal, Kanada kerana kekurangan kuasa pengkomputeran, semasa kami sedang mengusahakan model urutan ke jujukan bersama rakan kami di Google Brain. Kami menggunakan 8 GPU (yang sebenarnya banyak pada masa itu), dan saya rasa Montreal masih agak terhad dari segi skala pengkomputeran. Tetapi kemudian mereka menemui konsep perhatian berasaskan kandungan, yang seterusnya membawa kepada Transformer.

Fridman: Ramai orang cenderung untuk berfikir bahawa genius berada dalam idea-idea hebat, tetapi saya mengesyaki bahawa genius dalam kejuruteraan selalunya terletak pada butiran Kadang-kadang seorang jurutera atau beberapa jurutera boleh mengubah apa yang kita lakukan. Perkara, terutamanya yang dibuat pada komputer berskala besar, di mana satu keputusan kejuruteraan boleh mencetuskan tindak balas berantai.

Vinyal: Jika anda melihat kembali sejarah pembelajaran mendalam dan rangkaian saraf, anda akan mendapati terdapat unsur-unsur yang tidak disengajakan. Kerana GPU muncul pada masa yang betul, walaupun untuk permainan video. Jadi walaupun kejuruteraan perkakasan dipengaruhi oleh faktor masa. Ia juga disebabkan revolusi perkakasan inilah pusat data ditubuhkan. Contohnya, pusat data Google. Dengan pusat data sedemikian, kami boleh melatih model. Perisian juga merupakan faktor penting, dan semakin ramai orang memasuki bidang ini. Kami juga mungkin mengharapkan sistem mempunyai semua penanda aras.

Fridman: Anda mempunyai kertas kerja yang dikarang bersama Jeff Dean, Percy Liang dan lain-lain, bertajuk "Keupayaan Emergent of Large Language Models ”. Bagaimanakah kemunculan dalam rangkaian saraf dijelaskan secara intuitif? Adakah terdapat titik tip ajaib? Adakah ini berbeza mengikut tugasan?

Vinyal: Ambil penanda aras sebagai contoh. Semasa anda melatih sistem, apabila anda menganalisis sejauh mana saiz set data mempengaruhi prestasi, cara saiz model mempengaruhi prestasi, tempoh masa yang diperlukan untuk melatih sistem untuk mempengaruhi prestasi, dsb., lengkungnya agak lancar. Jika kita melihat ImageNet sebagai keluk latihan yang sangat lancar dan boleh diramal, ia kelihatan agak lancar dan boleh diramal dalam sesuatu cara.

Dari segi bahasa, penanda aras memerlukan lebih banyak pemikiran, walaupun input adalah ayat yang menerangkan masalah matematik, ia memerlukan lebih pemprosesan dan lebih introspeksi. Prestasi model mungkin menjadi rawak sehingga soalan yang betul ditanya oleh sistem pertanyaan Transformer atau model bahasa seperti Transformer, dan prestasi mula berubah daripada rawak kepada bukan rawak Ini sangat empirik dan tidak mempunyai teori di belakangnya .

Fridman: Baru-baru ini seorang jurutera Google mendakwa bahawa model bahasa Lambda adalah sedar. Kes ini menyentuh aspek manusia, aspek teknikal pembelajaran mesin, dan aspek falsafah peranan sistem AI dalam dunia manusia. Apakah perspektif anda sebagai jurutera pembelajaran mesin dan sebagai manusia?

Vinyal: Saya rasa mana-mana model semasa masih jauh daripada sedar. Saya berasa seperti saya seorang saintis yang gagal, dan saya sentiasa berasa seperti melihat pembelajaran mesin sebagai sains yang mungkin boleh membantu sains lain, saya suka astronomi, biologi, tetapi saya bukan pakar dalam bidang tersebut, jadi saya memutuskan untuk mengkaji pembelajaran mesin.

Tetapi apabila saya mempelajari lebih lanjut tentang Alphafold dan mempelajari sedikit tentang protein, biologi dan sains hayat, saya mula melihat apa yang berlaku pada peringkat atom. Kita cenderung menganggap rangkaian saraf sebagai otak, dan apabila saya bukan pakar, ia kelihatan rumit dan ajaib, tetapi sistem biologi jauh lebih kompleks daripada otak pengiraan, dan model sedia ada belum mencapai tahap otak biologi.

Saya tidak begitu terkejut dengan apa yang berlaku kepada jurutera Google ini. Mungkin kerana saya melihat keluk masa semakin lancar, model bahasa tidak berkembang begitu pantas sejak karya Shannon pada tahun 50-an, dan idea yang kami ada 100 tahun lalu tidak begitu berbeza dengan idea yang kami ada sekarang. Tetapi tiada siapa yang harus memberitahu orang lain apa yang mereka patut fikirkan.

Kerumitan manusia dari awal penciptaannya, dan kerumitan evolusi alam semesta secara keseluruhan, bagi saya adalah suatu susunan magnitud yang lebih menarik. Adalah baik untuk terobsesi dengan apa yang anda lakukan, tetapi saya harap pakar biologi akan memberitahu saya ia tidak begitu ajaib. Melalui interaksi dalam komuniti, kami juga memperoleh tahap pendidikan, yang membantu memahami perkara yang tidak normal, apa yang tidak selamat, dan lain-lain, tanpanya teknologi tidak akan digunakan dengan betul.

Fridman: Untuk menyelesaikan masalah perisikan, adakah sistem perlu mendapat kesedaran? Apakah bahagian minda manusia yang mengajar dalam mencipta sistem AI?

Vinyals: Saya tidak fikir sistem cukup pintar untuk mempunyai otak yang sangat berguna yang boleh mencabar anda dan membimbing anda. Sebaliknya, anda harus mengajarnya untuk melakukan sesuatu. Secara peribadi, saya tidak pasti kesedaran diperlukan, mungkin kesedaran atau perspektif biologi atau evolusi lain akan mempengaruhi algoritma generasi seterusnya.

Perincian pengiraan yang dilakukan oleh otak manusia dan rangkaian saraf pastinya terdapat beberapa persamaan antara kedua-duanya, tetapi kita tidak cukup mengetahui tentang butiran otak. Tetapi jika anda menyempitkan sedikit skop, seperti proses pemikiran kita, cara ingatan berfungsi, malah bagaimana kita berkembang kepada keadaan kita sekarang, penerokaan dan pembangunan apa, dsb., ini boleh memberi inspirasi kepada penyelidikan di peringkat algoritma.

Fridman: Adakah anda bersetuju dengan pandangan Richard Sutton dalam The Bitter Lesson bahawa pengajaran terbesar daripada 70 tahun penyelidikan kecerdasan buatan ialah kaedah umum untuk memanfaatkan kuasa pengkomputeran Adakah ia kaedah muktamad yang berkesan?

Vinyals: Saya tidak boleh bersetuju lagi. Skala diperlukan untuk membina sistem yang boleh dipercayai dan kompleks. Ini mungkin tidak mencukupi dan kami memerlukan beberapa penemuan. Sutton menyebut bahawa carian ialah kaedah penskalaan, dan dalam medan seperti Go, carian berguna kerana terdapat fungsi ganjaran yang jelas. Tetapi dalam beberapa misi lain, kami tidak pasti apa yang perlu dilakukan.

Fridman: Adakah anda fikir kami boleh membina sistem kecerdasan buatan umum yang mencapai atau bahkan melebihi kecerdasan manusia dalam hidup anda?

Vinyals: Saya benar-benar percaya ia akan mempunyai kecerdasan peringkat manusia. Perkataan "transendensi" sukar untuk ditakrifkan, terutamanya apabila kita melihat piawaian semasa dari perspektif pembelajaran tiruan Kita pasti boleh mempunyai AI meniru dan mengatasi manusia dalam bahasa. Jadi untuk ke peringkat manusia melalui peniruan memerlukan pembelajaran pengukuhan dan lain-lain. Ia sudah membuahkan hasil di beberapa kawasan.

Dari segi keupayaan manusia yang melampaui, AlphaGo adalah contoh kegemaran saya. Dan dalam pengertian umum, saya tidak pasti kita boleh mentakrifkan fungsi ganjaran dengan cara yang meniru kecerdasan manusia. Mengenai transendensi, saya tidak pasti lagi, tetapi ia pasti akan mencapai tahap manusia. Jelas sekali kita tidak akan cuba untuk melampaui, dan jika kita melakukannya, kita akan mempunyai saintis dan penemuan luar biasa untuk memajukan dunia, tetapi sekurang-kurangnya sistem peringkat manusia akan menjadi sangat berkuasa.

Fridman: Adakah anda fikir akan ada detik ketunggalan apabila berbilion-bilion ejen pintar mencapai atau melebihi tahap manusia disepadukan secara mendalam ke dalam masyarakat manusia? Adakah anda akan takut atau teruja dengan dunia?

Vinyals: Mungkin kita perlu mempertimbangkan sama ada kita sebenarnya boleh mencapai matlamat ini. Mempunyai terlalu ramai orang yang wujud bersama dengan sumber yang terhad boleh menimbulkan masalah. Had kuantiti mungkin juga perlu wujud untuk entiti digital. Ini adalah atas sebab ketersediaan tenaga kerana mereka juga menggunakan tenaga.

Realitinya ialah kebanyakan sistem adalah kurang cekap berbanding sistem kita dalam hal keperluan tenaga. Tetapi saya fikir sebagai masyarakat kita perlu bekerjasama untuk mencari cara yang munasabah untuk berkembang dan bagaimana kita boleh wujud bersama. Saya akan teruja jika ia berlaku, aspek automasi yang memberikan akses kepada sumber atau pengetahuan tertentu kepada orang yang sebaliknya jelas tidak mempunyai akses kepadanya, dan aplikasi itulah yang paling saya teruja untuk melihatnya.

Fridman: Soalan terakhir, apabila manusia bergerak keluar dari sistem suria, adakah lebih ramai manusia atau lebih banyak robot di dunia masa hadapan?

Vinyals: Manusia dan AI mungkin bercampur dan wujud bersama, ini hanyalah spekulasi, tetapi sudah ada syarikat yang cuba menjadikan kami lebih baik dengan cara ini. Saya mahu nisbahnya ialah 1:1 paling banyak 1:1 mungkin boleh dilaksanakan, tetapi kehilangan keseimbangan adalah tidak baik.

Pautan video asal: https://youtu.be/aGBLRlLe7X8

Atas ialah kandungan terperinci Temu bual terkini dengan Ketua Saintis DeepMind Oriol Vinyals: Masa depan AI umum ialah pembelajaran meta interaktif yang kuat. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

laman web rasmi okex

laman web rasmi okex

Apakah peralatan yang diperlukan untuk siaran langsung Douyin?

Apakah peralatan yang diperlukan untuk siaran langsung Douyin?

proses paparan linux

proses paparan linux

Bagaimana untuk mengira bayaran pengendalian bayaran balik keretapi 12306

Bagaimana untuk mengira bayaran pengendalian bayaran balik keretapi 12306

Cara membuat klon WeChat pada telefon bimbit Huawei

Cara membuat klon WeChat pada telefon bimbit Huawei

Bagaimana untuk melihat prosedur tersimpan dalam MySQL

Bagaimana untuk melihat prosedur tersimpan dalam MySQL

Trend harga terkini Bitcoin

Trend harga terkini Bitcoin

fail nh

fail nh