LLaMA-3(Large Language Model Meta AI 3)은 Meta Company에서 개발한 대규모 오픈소스 생성 인공지능 모델입니다. 이전 세대 LLaMA-2에 비해 모델 구조에는 큰 변화가 없습니다.

LLaMA-3 모델은 다양한 애플리케이션 요구 사항과 컴퓨팅 리소스에 맞게 소형, 중형, 대형을 포함한 다양한 규모 버전으로 구분됩니다. 소형 모델의 모수 크기는 8B, 중형 모델의 모수 크기는 70B, 대형 모델의 모수 크기는 400B에 이릅니다. 그러나 훈련 중에는 다중 모달 및 다중 언어 기능을 달성하는 것이 목표이며 결과는 GPT 4/GPT 4V와 비슷할 것으로 예상됩니다.

Ollama는 사용자가 로컬 컴퓨터에서 대규모 언어 모델을 실행하고 배포할 수 있는 오픈 소스 LLM(대형 언어 모델) 서비스 도구입니다. Ollama는 Docker 컨테이너에서 대규모 언어 모델을 배포하고 관리하는 프로세스를 단순화하여 프로세스를 빠르고 쉽게 만드는 프레임워크로 설계되었습니다. 사용자는 간단한 명령줄 작업을 통해 Llama 3와 같은 오픈 소스 대규모 언어 모델을 로컬에서 빠르게 실행할 수 있습니다.

공식 웹사이트 주소: https://ollama.com/download

Pictures

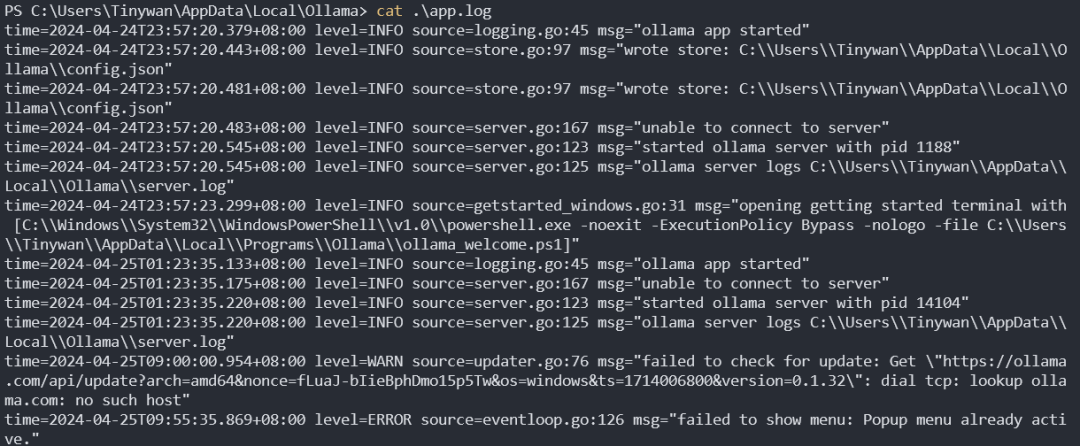

Pictures

Ollama는 Mac 및 Linux를 포함한 다양한 플랫폼을 지원하는 도구이며 Docker 이미지를 제공하여 설치 프로세스를 단순화합니다. 사용자는 Dockerfile의 역할과 유사한 Modelfile을 작성하여 더 많은 모델을 가져오고 사용자 지정할 수 있습니다. Ollama는 또한 모델 실행 및 관리를 위한 REST API와 모델 상호 작용을 위한 명령줄 도구 세트를 제공합니다.

사진

사진

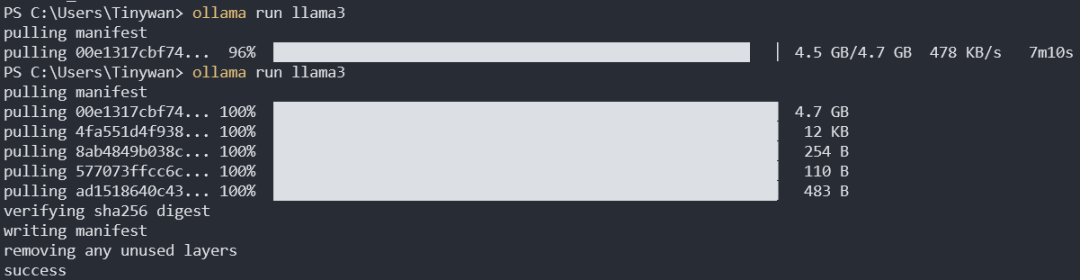

ollama pull llama3:8b

기본 다운로드는 llama3:8b입니다. 여기에서 콜론 앞의 콜론은 모델 이름을 나타내고, 태그 뒤의 콜론은 태그를 나타냅니다. 여기에서 llama3의 모든 태그를 볼 수 있습니다

pictures

pictures

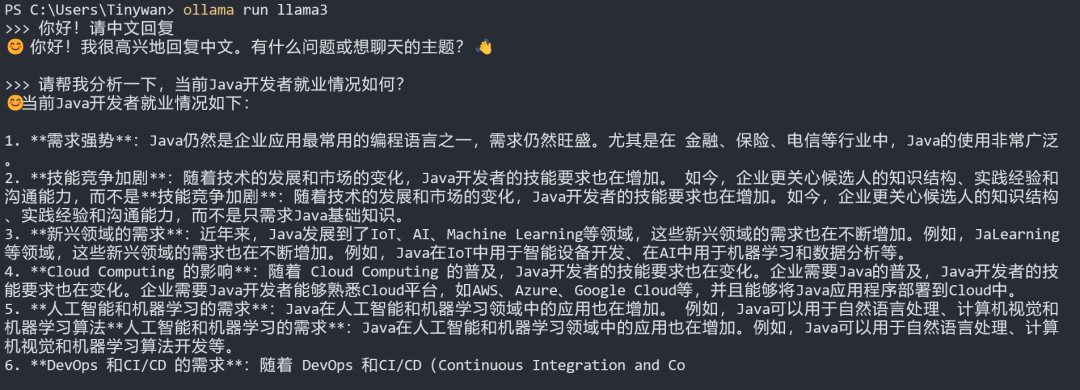

참고: 모델이 원하는 경우 중국어로 답장하려면 먼저 입력하세요: 안녕하세요! 중국어로 답장해주세요

picture

picture

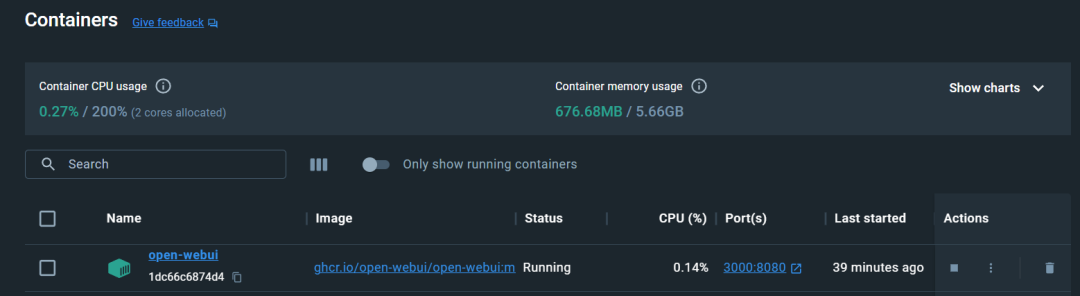

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

picture

picture

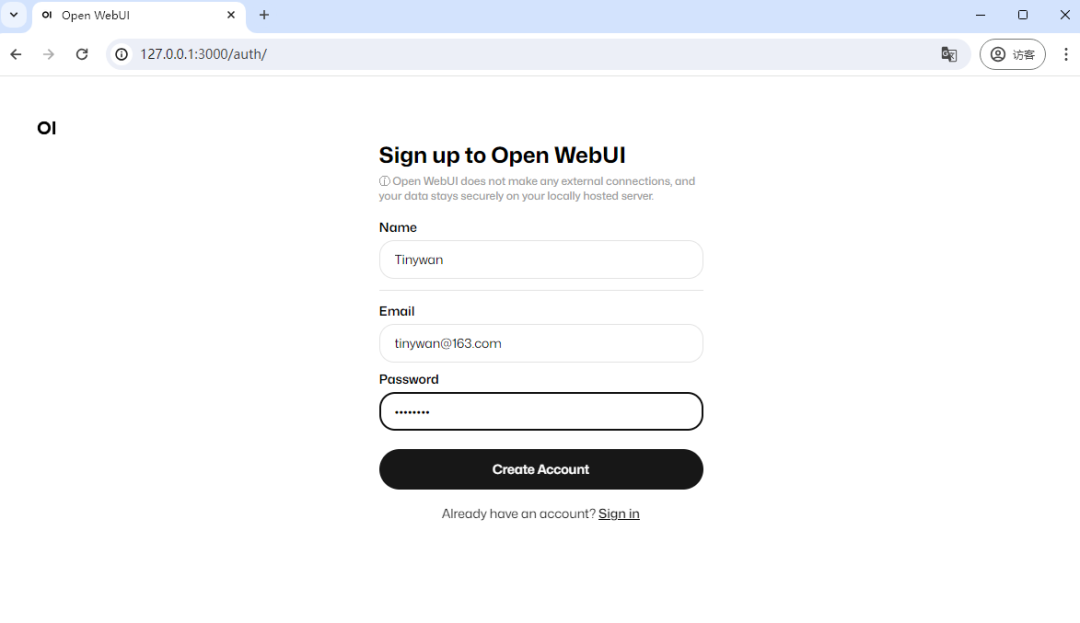

주소를 입력하세요. http://127.0.0.1:3000

사진

사진

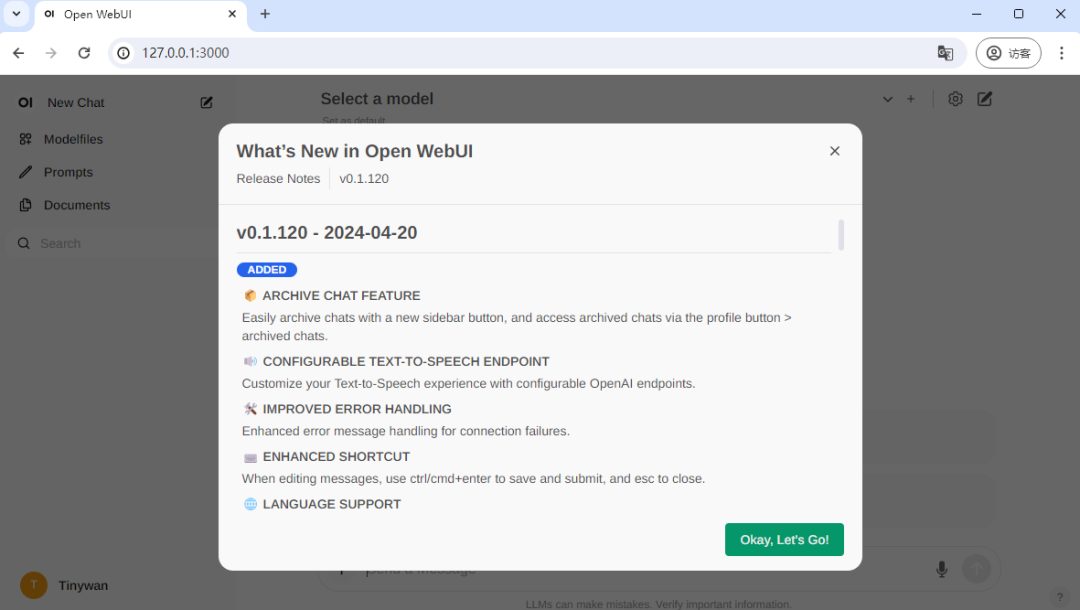

처음 방문하려면 등록해야 합니다. 여기서 계정을 등록하면 등록이 완료되고 로그인이 완료됩니다.

사진

사진

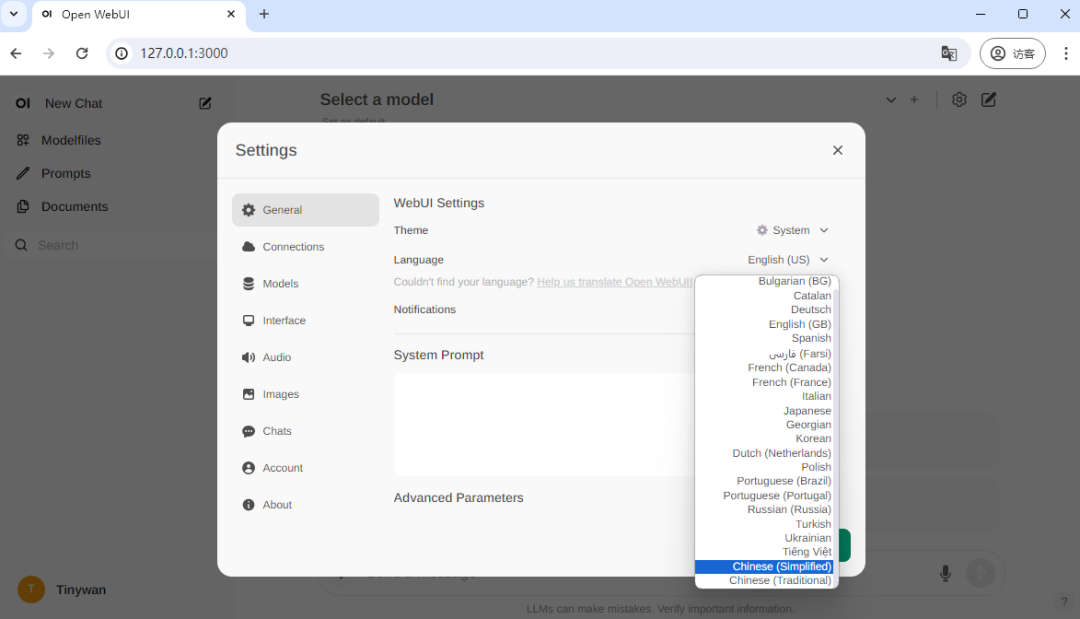

중국어 전환

사진

사진

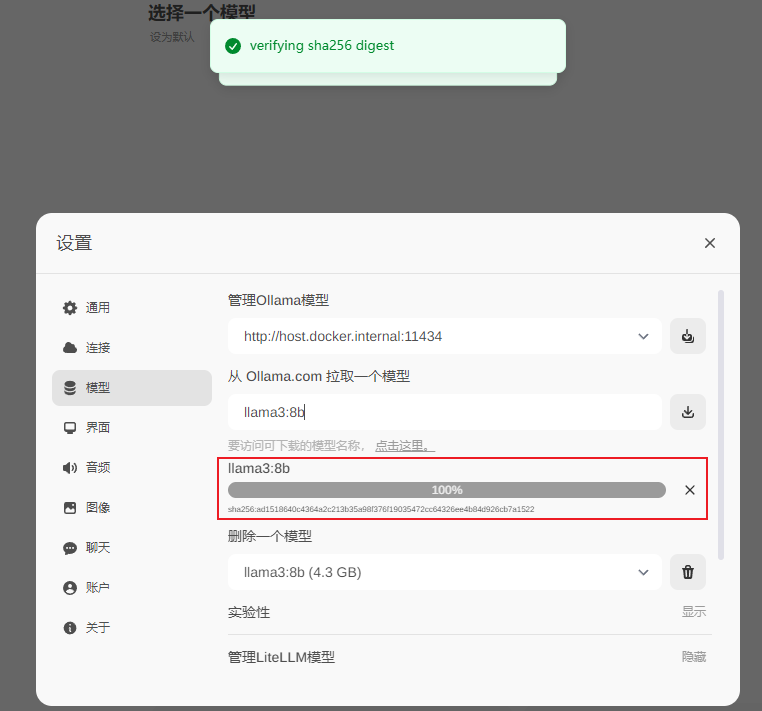

llama3:8b

사진

사진

다운로드 완료

사진

사진

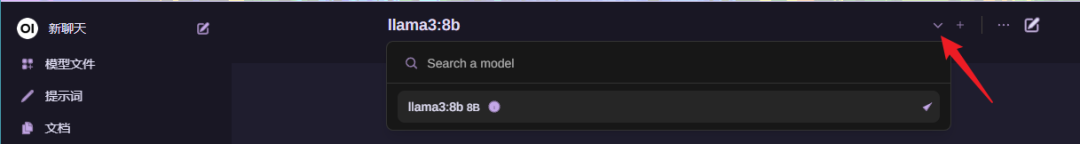

모델 선택

사진

사진

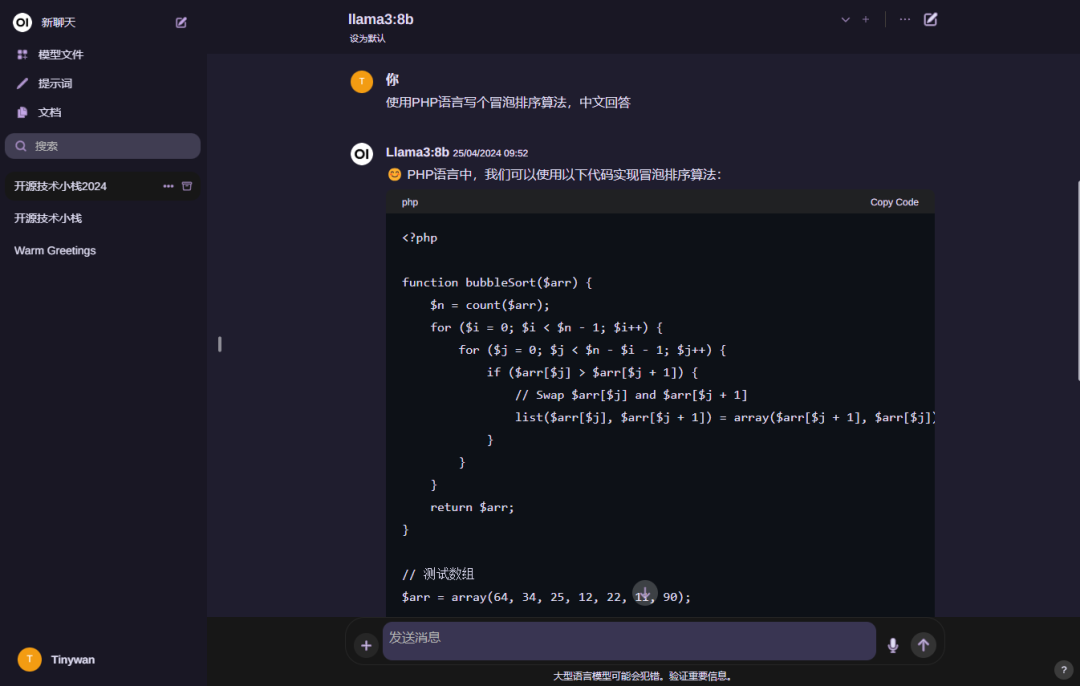

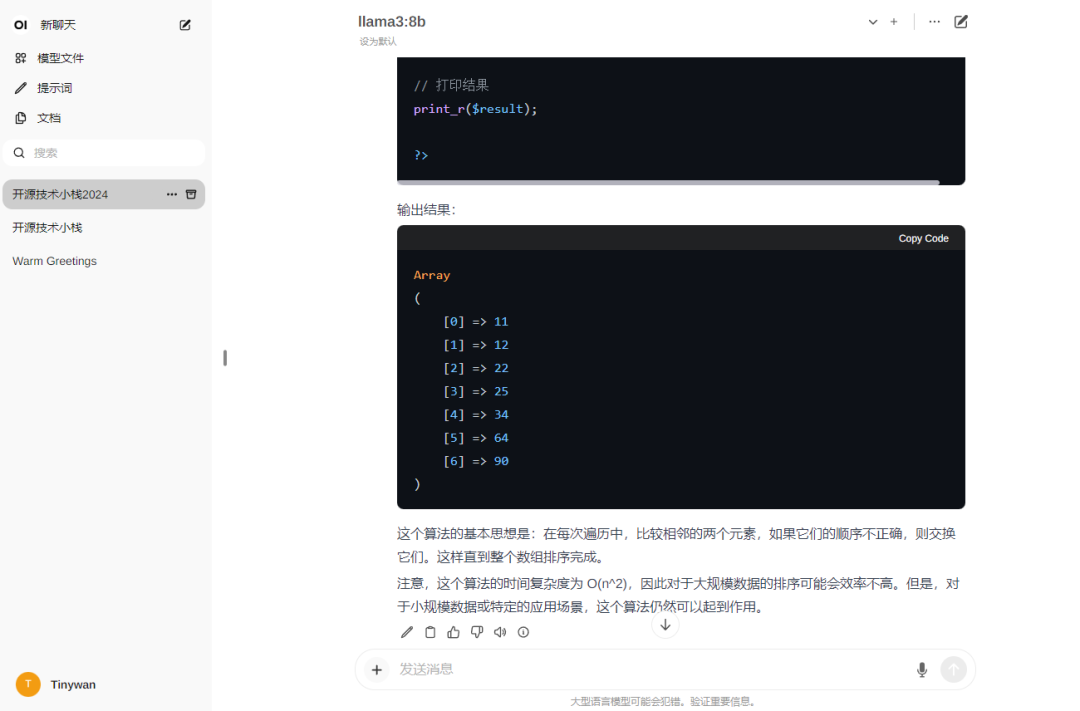

모델 사용

Pictures

Pictures

참고: 모델의 답장을 원하는 경우 중국어로 먼저 입력해주세요: 안녕하세요! 중국어로 답장해주세요

Pictures

Pictures

Pictures

Pictures

위 내용은 Docker는 3분 만에 LLama3 오픈 소스 대규모 모델의 로컬 배포를 완료합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!