OpenAI GPT-4V와 Google Gemini는 모두 매우 강력한 다중 모드 이해 기능을 입증했으며 MLLM(다중 모드 대형 모델)의 신속한 개발을 촉진했으며 업계에서 가장 인기 있는 연구 방향이 되었습니다.

MLLM은 다양한 시각-언어 개방형 과제에서 뛰어난 지시 따르기 능력을 달성했습니다. 다중 모드 학습에 대한 이전 연구에서 서로 다른 양식이 서로 협력하고 촉진할 수 있다는 것이 밝혀졌지만 기존 MLLM 연구는 주로 다중 모드 작업의 능력을 향상하고 모드 협업의 이점과 모드 간섭의 영향 사이의 균형을 맞추는 방법에 중점을 둡니다. 그 문제를 해결해야합니다.

논문을 보려면 다음 링크를 클릭하세요: https://arxiv.org/pdf/2311.04257.pdf

다음 코드 주소를 확인하세요: https://github.com/X -PLUG/mPLUG -Owl/tree/main/mPLUG-Owl2

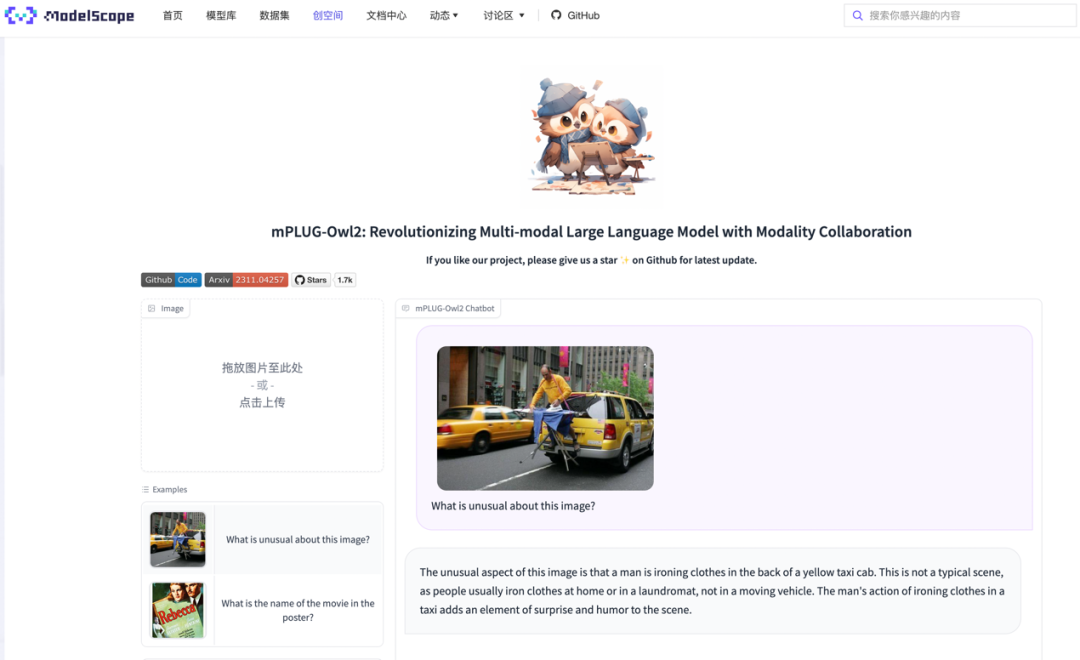

ModelScope 체험 주소: https://modelscope.cn/studios/damo/mPLUG-Owl2/summary

HuggingFace 체험 주소 링크: https: //huggingface.co/spaces/MAGAer13/mPLUG-Owl2

이 문제에 대응하여 Alibaba의 다중 모드 대형 모델 mPLUG-Owl이 대대적으로 업그레이드되었습니다. 모달 협업을 통해 일반 텍스트와 다중 모달리티 모두의 성능을 향상시켜 LLaVA1.5, MiniGPT4, Qwen-VL 및 기타 모델을 능가하고 다양한 작업에서 최고의 성능을 달성합니다. 특히 mPLUG-Owl2는 공유 기능 모듈을 활용하여 다양한 양식 간의 협업을 촉진하고 각 양식의 특성을 유지하기 위해 모달 적응 모듈을 도입합니다. 간단하고 효과적인 디자인으로 mPLUG-Owl2는 일반 텍스트 및 다중 모드 작업을 포함한 다양한 분야에서 최고의 성능을 달성합니다. 모달 협력 현상에 대한 연구는 미래의 다중 모드 대형 모델 개발에도 영감을 제공합니다

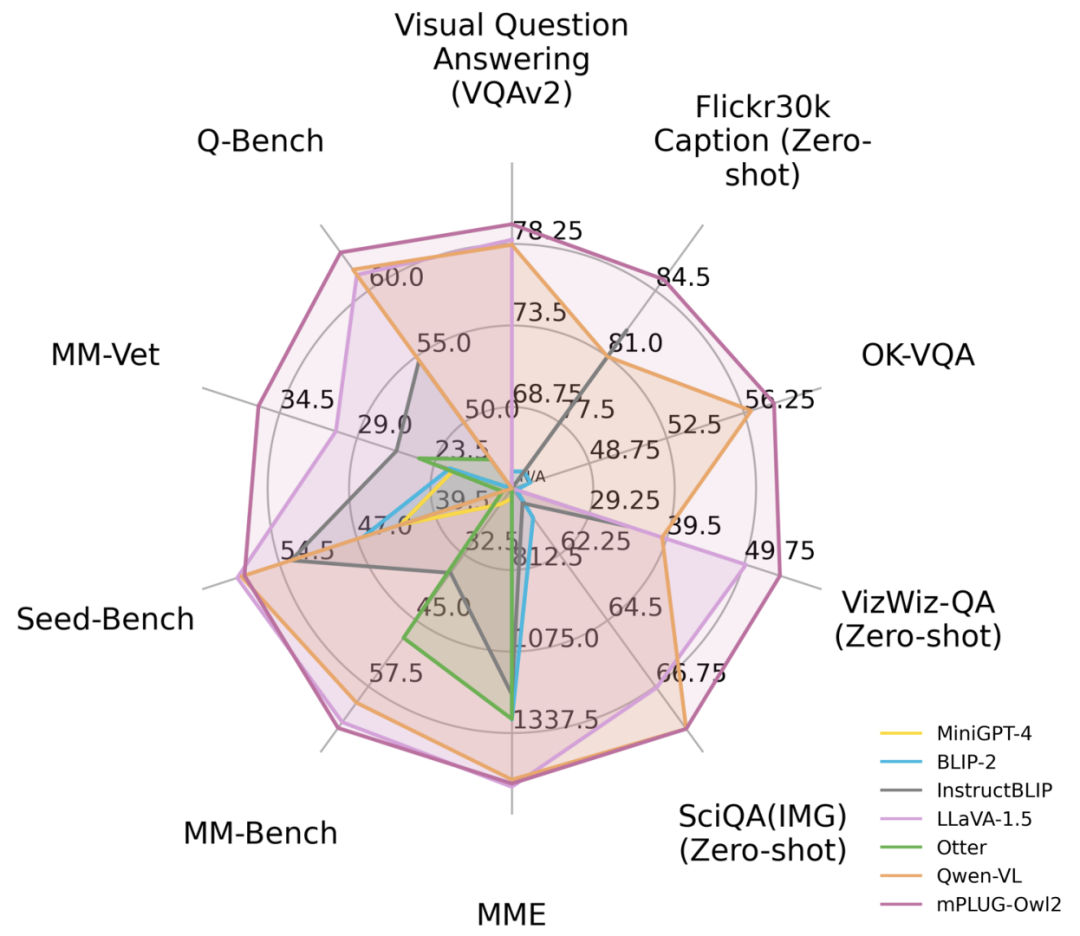

그림 1 기존 MLLM 모델과의 성능 비교

방법 소개 원래 의미를 바꾸지 않는다는 목적을 달성하려면 내용을 중국어로 다시 작성해야 합니다.

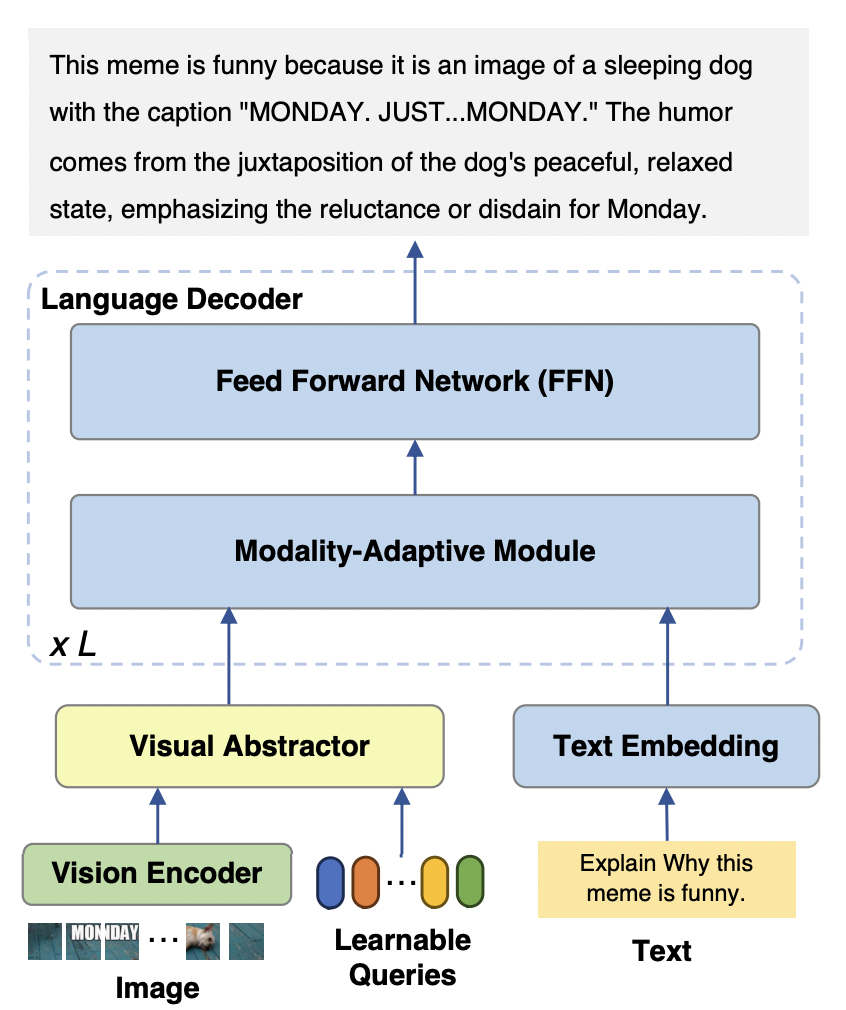

mPLUG-Owl2 모델은 주로 세 부분으로 구성됩니다.

Visual Encoder: ViT-L/14를 시각적으로 사용 인코더, 입력 해상도 H x W 비율의 이미지는 H/14 x W/14의 시각적 토큰 시퀀스로 변환되어 Visual Abstractor에 입력됩니다.

Visual Extractor: 입력 언어 모델의 시각적 시퀀스 길이를 줄이면서 사용 가능한 쿼리 집합을 학습하여 높은 수준의 의미 특징을 추출합니다.

언어 모델: LLaMA-2-7B가 텍스트 디코더로 사용됩니다. 그림 3과 같이 모달 적응 모듈을 설계했습니다.

그림 2 mPLUG-Owl2 모델 구조

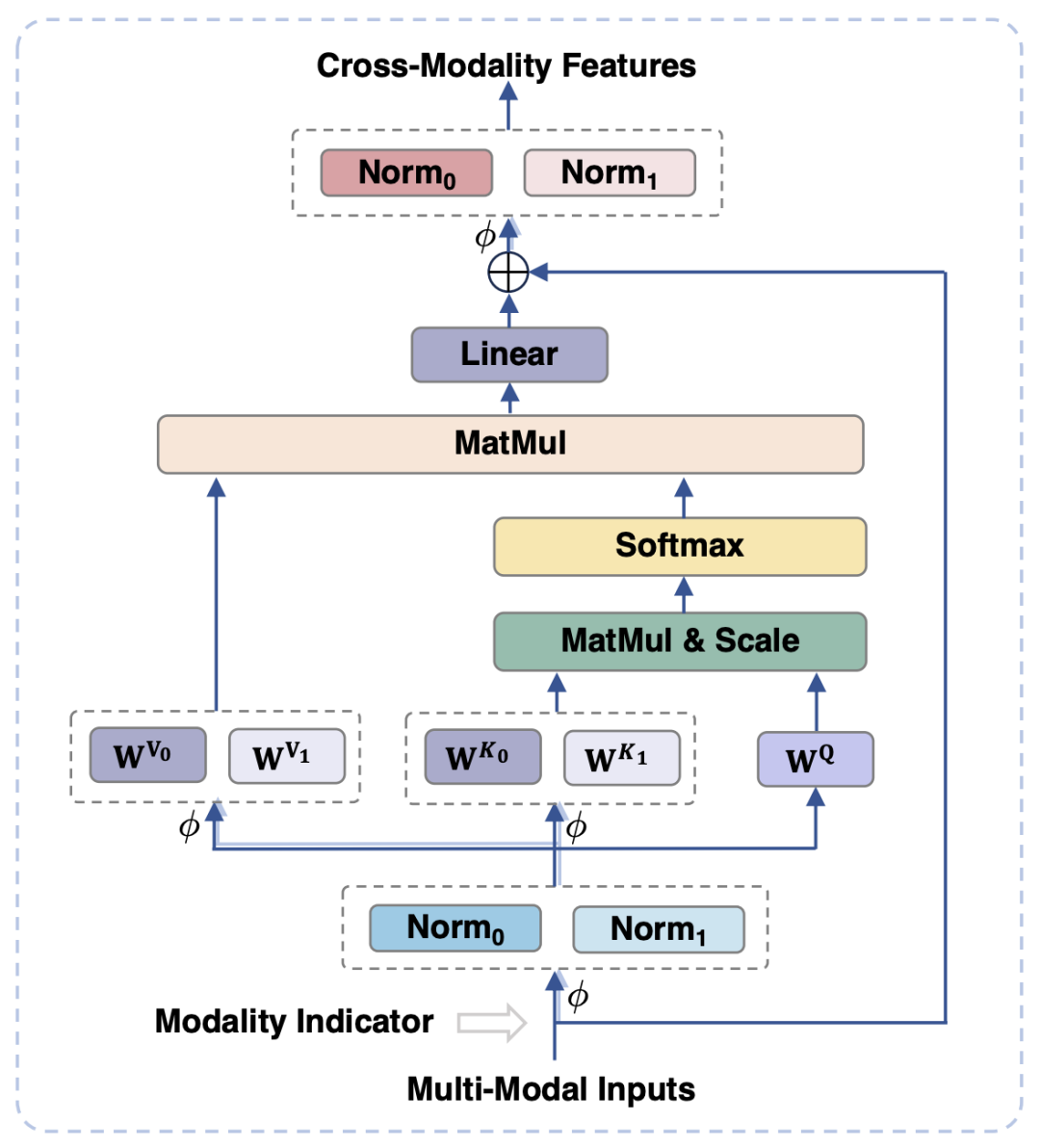

기존 작업에서는 시각적 특징을 텍스트의 의미 공간에 매핑하는 것이 일반적입니다. 그러나 이 접근 방식은 각각의 특성을 무시합니다. 시각적 정보와 텍스트 정보의 의미 세분성 불일치로 인해 모델 성능에 영향을 미칠 수 있습니다. 이 문제를 해결하기 위해 본 논문에서는 시각적 언어적 표현을 분리하여 각 양식의 고유한 속성을 유지하면서 시각적 및 텍스트 기능을 공유 의미 공간에 매핑하는 양식 적응 모듈(MAM)을 제안합니다.

그림 3은 모달 적응 모듈의 개략도를 보여줍니다.

그림 3에 표시된 것은 기존 Transformer와 비교하여 모달 적응 모듈의 주요 설계는 다음과 같습니다.

모듈의 입력 및 출력 단계에서 LayerNorm 작업은 두 양식의 각 기능 분포에 적응하기 위해 시각적 및 언어 양식에 대해 각각 수행됩니다.

Self-Attention 연산에서는 시각적 양식과 언어 양식에 대해 별도의 키와 값 투영 행렬을 사용하지만, 이런 방식으로 키와 값 투영 행렬을 분리하여 불일치가 발생합니다. 의미론적 세분성을 달성할 수 있으므로 두 모드 간의 간섭을 피할 수 있습니다.

동일한 FFN을 공유함으로써 두 양식이 서로 간의 협력을 촉진할 수 있습니다

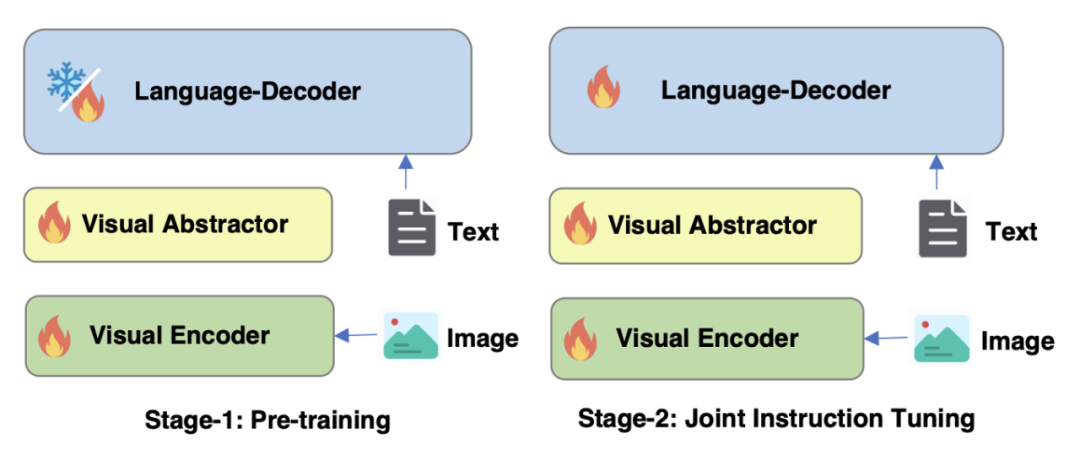

그림 4 mPLUG-Owl2

의 훈련 전략 최적화그림 4에 표시된 것처럼 mPLUG-Owl2의 교육에는 사전 교육과 교육 미세 조정의 두 단계가 포함됩니다. 사전 훈련 단계는 주로 시각적 인코더와 언어 모델의 정렬을 달성하는 것입니다. 이 단계에서는 Visual Encoder와 Visual Abstractor가 훈련 가능하며, 언어 모델에서는 Modality에 의해 추가된 시각적 관련 모델 가중치만 있습니다. 적응형 모듈이 갱신됩니다. 명령어 미세 조정 단계에서는 모델의 모든 매개변수가 텍스트 및 다중 모드 명령어 데이터(그림 5 참조)를 기반으로 미세 조정되어 모델의 명령어 추종 능력을 향상시킵니다.

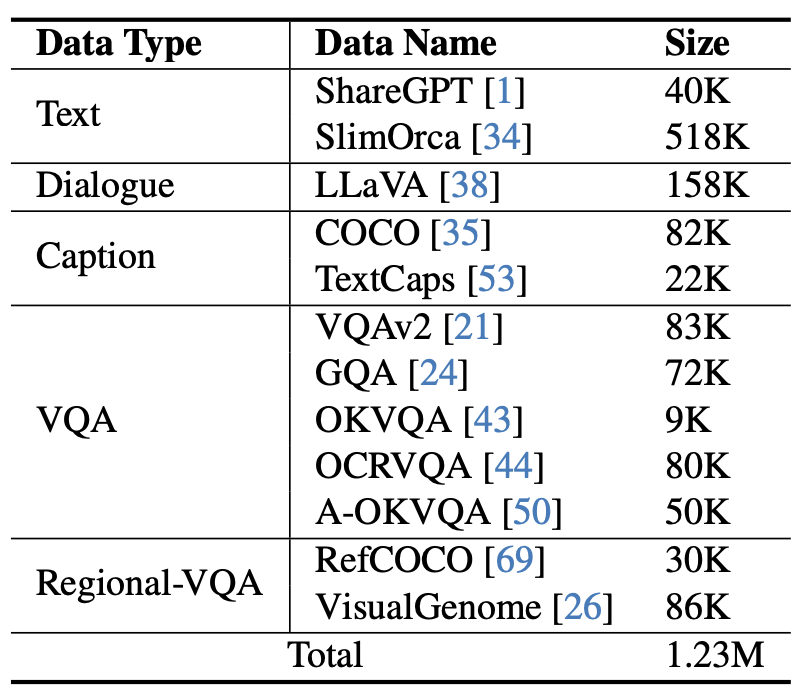

그림 5 mPLUG-Owl2

실험 및 결과

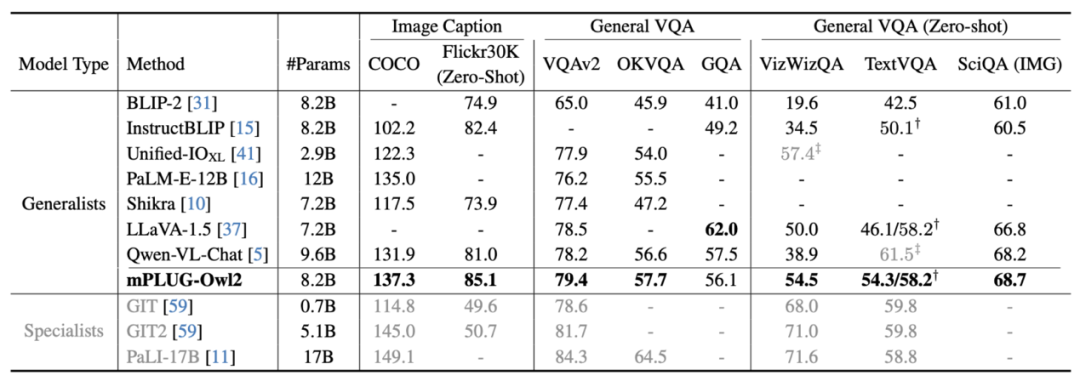

그림 6 이미지 설명 및 VQA 작업 성능

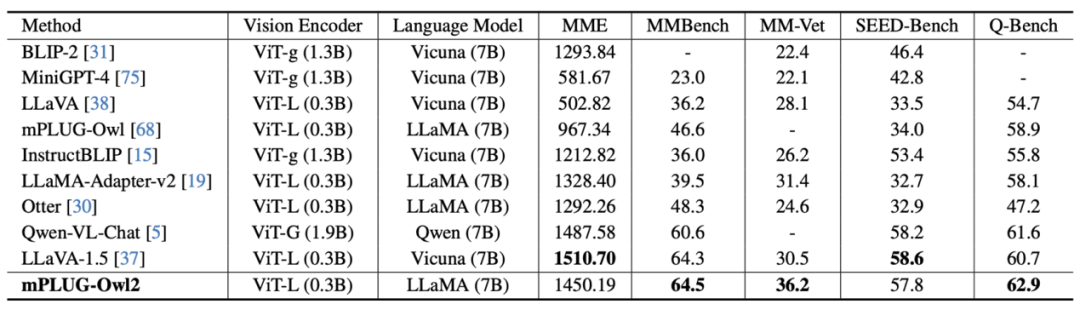

그림 7 MLLM 벤치마크 성능

은 그림 6과 그림 7에 표시되어 있으며, 이는 전통적인 이미지 설명, VQA 및 기타 시각적 언어 작업이든 MMBench, Q-Bench 및 다중 모드 대형을 위한 기타 벤치마크 데이터 세트이든 상관없습니다. mPLUG-Owl2 모델은 모두 기존 작업보다 더 나은 성능을 달성합니다.

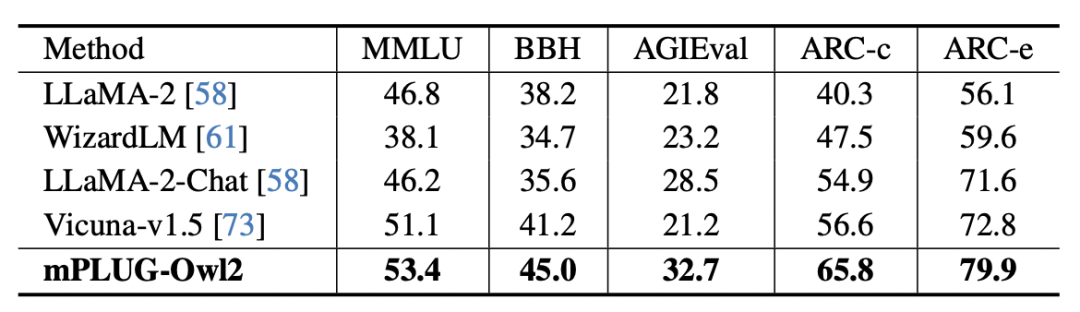

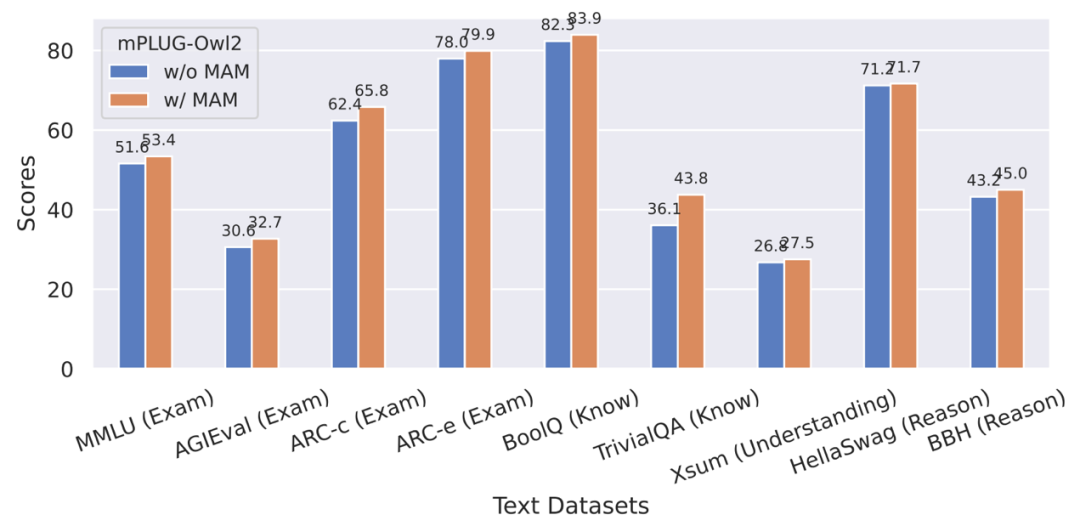

그림 8 순수 텍스트 벤치마크 성능

그림 9 모달리티 적응 모듈이 순수 텍스트 작업 성능에 미치는 영향

또한 모달 협업의 영향을 평가하기 위해 순수 텍스트 작업 텍스트 작업의 영향과 관련하여 저자는 자연어 이해 및 생성에서 mPLUG-Owl2의 성능도 테스트했습니다. 그림 8에서 볼 수 있듯이 mPLUG-Owl2는 다른 명령어 미세 조정 LLM에 비해 더 나은 성능을 달성합니다. 그림 9는 일반 텍스트 작업의 성능을 보여줍니다. 모달 적응 모듈이 모달 협업을 촉진하므로 모델의 검사 및 지식 기능이 크게 향상되었음을 알 수 있습니다. 저자는 멀티모달 협업을 통해 모델이 시각적 정보를 활용해 언어로 설명하기 어려운 개념을 이해할 수 있게 되고, 이미지 속 풍부한 정보를 통해 모델의 추론 능력을 향상시키며, 간접적으로는 모델의 추론 능력을 강화하기 때문이라고 분석한다. 텍스트.

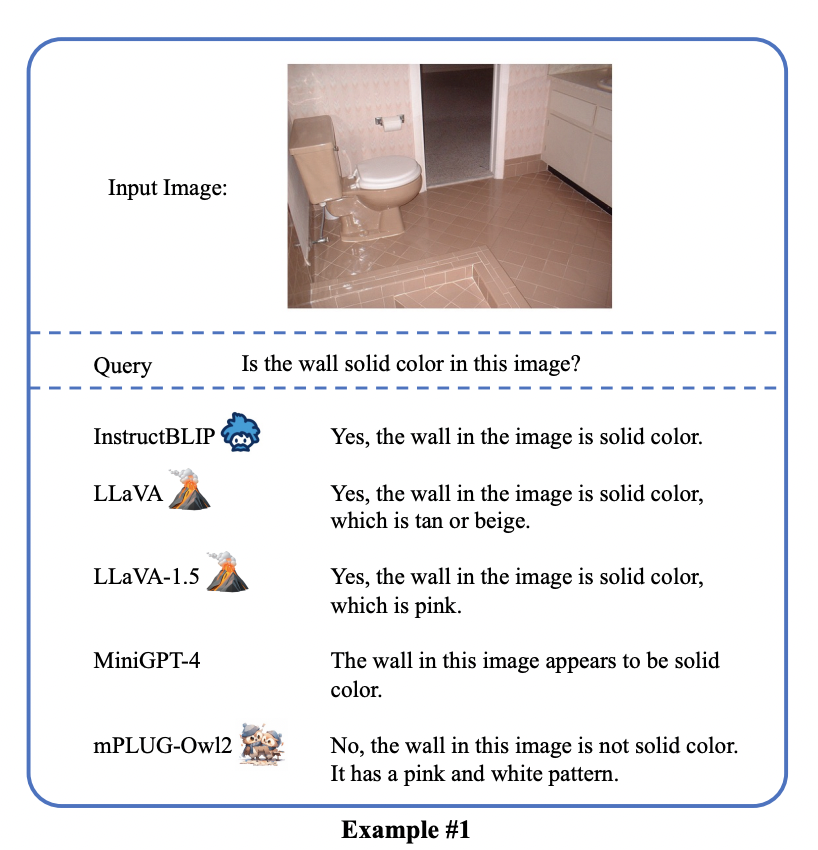

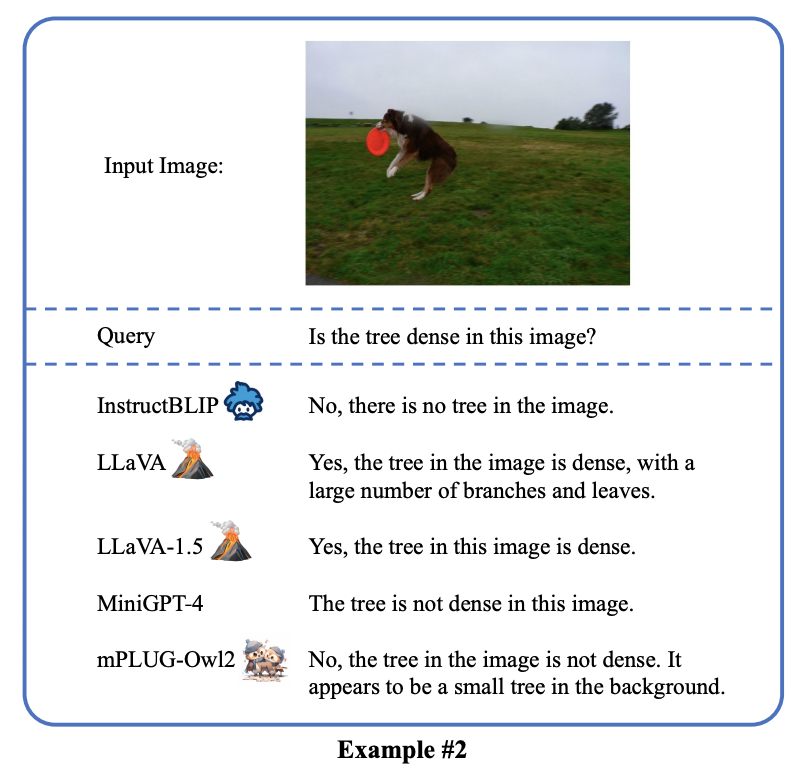

mPLUG-Owl2는 뛰어난 다중 모드 이해 기능을 보여주고 다중 모드 환각을 성공적으로 완화합니다. 이 멀티모달 기술은 Tongyi Stardust, Tongyi Zhiwen 등 Tongyi 핵심 제품에 적용되었으며, ModelScope 및 HuggingFace 오픈 데모

위 내용은 Alibaba의 새로운 mPLUG-Owl 업그레이드는 두 세계의 장점을 모두 갖추고 있으며 모달 협업을 통해 MLLM의 새로운 SOTA가 가능해졌습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!