코넬대학교와 Apple의 최신 연구에서는 더 적은 컴퓨팅 성능으로 고해상도 이미지를 생성하려면 주의 메커니즘을 제거할 수 있다는 결론을 내렸습니다.

우리 모두 알고 있듯이 주의 메커니즘은 Transformer 아키텍처 구성 요소는 고품질 텍스트 및 이미지 생성에 중요합니다. 그러나 그 결점도 명백합니다. 즉, 시퀀스 길이가 증가함에 따라 계산 복잡성이 2차적으로 증가한다는 것입니다. 이는 긴 텍스트와 고해상도 이미지 처리에서 까다로운 문제입니다.

이 문제를 해결하기 위해 이번 새로운 연구에서는 기존 아키텍처의 Attention 메커니즘을 보다 확장 가능한 SSM(상태 공간 모델) 백본으로 대체하고 DIFFUSSM(확산 상태 공간 모델)이라는 모델을 개발했습니다. 이 새로운 아키텍처는 주의 모듈을 사용하여 기존 확산 모델의 이미지 생성 효과를 일치하거나 초과하기 위해 더 적은 컴퓨팅 성능을 사용할 수 있으며 고해상도 이미지를 탁월하게 생성할 수 있습니다.

지난주 '맘바' 출시에 힘입어 상태공간 모델 SSM이 더욱 주목을 받고 있습니다. Mamba의 핵심은 새로운 아키텍처, 즉 "선택적 상태 공간 모델"을 도입하는 것입니다. 이를 통해 Mamba는 언어 모델링에서 Transformer와 비슷하거나 심지어 능가합니다. 당시 논문 저자 Albert Gu는 Mamba의 성공이 SSM의 미래에 대한 자신감을 주었다고 말했습니다. 이제 코넬대학교와 애플의 이 논문은 SSM의 응용 전망에 대한 새로운 예를 추가한 것 같습니다.

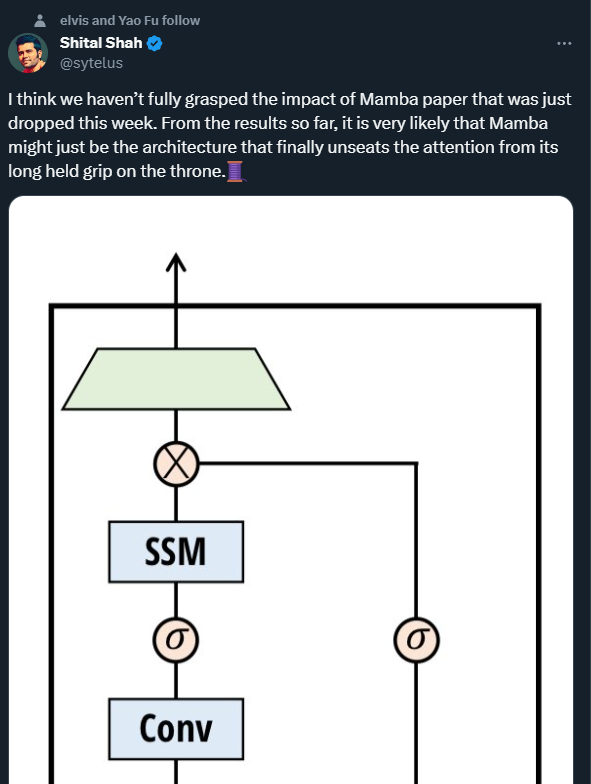

Microsoft의 수석 연구 엔지니어인 Shital Shah는 주의 메커니즘이 오랫동안 자리 잡고 있던 왕좌에서 물러날 수 있다고 경고했습니다.

이미지 생성 분야의 급속한 발전은 노이즈 제거 확산 확률 모델(DDPM)에 의해 주도되었습니다. 이러한 모델은 생성 프로세스를 잠재 변수의 반복적 노이즈 제거로 모델링하고, 충분한 노이즈 제거 단계가 수행되면 충실도가 높은 샘플을 생성할 수 있습니다. 복잡한 시각적 분포를 캡처하는 DDPM의 기능은 고해상도의 사실적인 구성을 구현하는 데 잠재적으로 유리합니다.

DDPM을 더 높은 해상도로 확장하는 데는 상당한 컴퓨팅 문제가 남아 있습니다. 주요 병목 현상은 고충실도 생성을 달성할 때 self-attention에 의존한다는 것입니다. U-Nets 아키텍처에서 이러한 병목 현상은 ResNet과 Attention 레이어를 결합하는 데서 발생합니다. DDPM은 생성적 적대 네트워크(GAN)를 뛰어넘지만 다중 헤드 주의 계층이 필요합니다. Transformer 아키텍처에서는 주의가 핵심 구성 요소이므로 최첨단 이미지 합성 결과를 얻는 데 중요합니다. 두 아키텍처 모두에서 관심의 복잡성은 시퀀스 길이에 따라 2차적으로 확장되므로 고해상도 이미지를 처리할 때 실행 불가능해집니다.

계산 비용으로 인해 이전 연구자들은 표현 압축 방법을 사용하게 되었습니다. 고해상도 아키텍처는 종종 패치화 또는 다중 규모 해상도를 사용합니다. 차단은 조잡한 표현을 생성하고 계산 비용을 줄일 수 있지만 중요한 고주파 공간 정보 및 구조적 무결성을 희생합니다. 다중 스케일 해상도는 Attention 레이어의 계산을 줄이는 동시에 다운샘플링을 통해 공간적 세부 묘사도 줄이고 업샘플링을 적용할 때 아티팩트를 발생시킵니다.

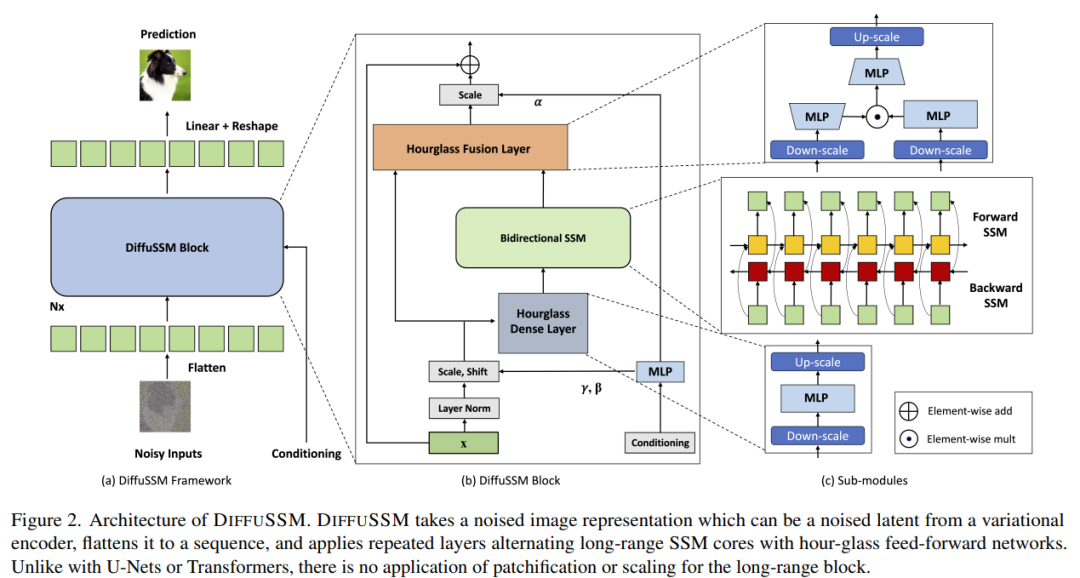

DIFFUSSM은 Attention 메커니즘을 사용하지 않는 확산 상태 공간 모델로 고해상도 이미지 합성에서 Attention 메커니즘을 적용할 때 발생하는 문제를 해결하도록 설계되었습니다. DIFFUSSM은 확산 과정에서 SSM(Gated State Space Model)을 사용합니다. 이전 연구에서는 SSM 기반 시퀀스 모델이 효과적이고 효율적인 일반 신경 시퀀스 모델인 것으로 나타났습니다. 이 아키텍처를 채택함으로써 SSM 코어는 더욱 세밀한 이미지 표현을 처리하고 글로벌 타일링이나 다중 스케일 레이어를 제거할 수 있습니다. 효율성을 더욱 향상시키기 위해 DIFFUSSM은 네트워크의 조밀한 구성 요소에 모래시계 아키텍처를 채택합니다

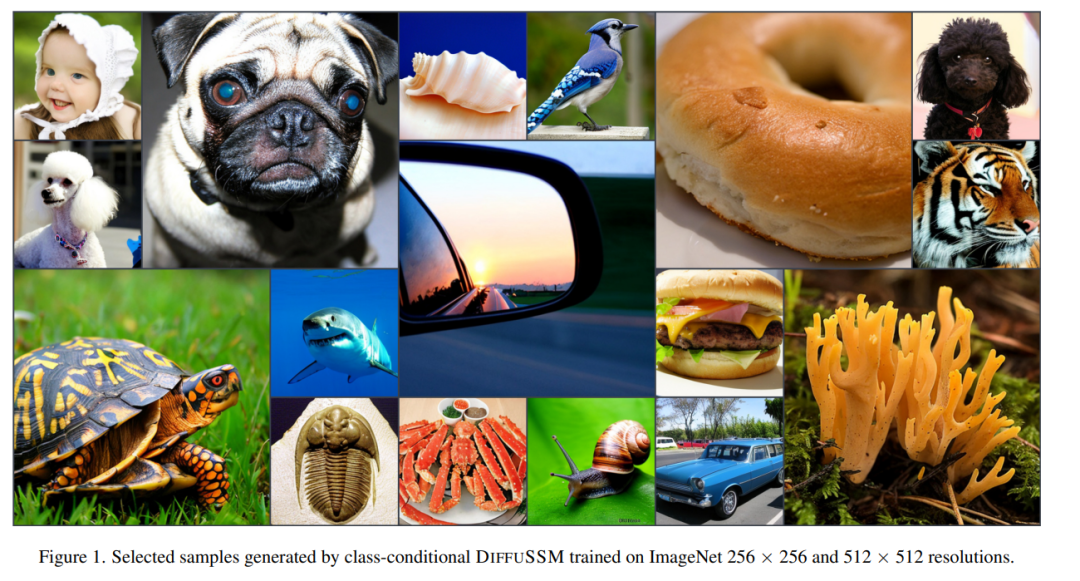

저자는 다양한 해상도에서 DIFFUSSM의 성능을 검증했습니다. ImageNet의 실험에서는 DIFFUSSM이 더 적은 총 Gflops를 사용하여 다양한 해상도에서 FID, sFID 및 Inception Score를 지속적으로 향상시키는 것으로 나타났습니다.

논문 링크: https://arxiv.org/pdf/2311.18257.pdf

원래 의미를 바꾸지 않으려면 내용을 중국어로 다시 작성해야 합니다. 저자의 목표는 차단과 같은 "길이 감소"가 필요 없이 고해상도에서 장거리 상호 작용을 학습할 수 있는 확산 아키텍처를 설계하는 것이었습니다. DiT와 유사하게 이 접근 방식은 이미지를 평면화하고 이를 시퀀스 모델링 문제로 처리하는 방식으로 작동합니다. 그러나 Transformer와 달리 이 방법은 이 시퀀스의 길이를 처리할 때 이차 계산을 사용합니다. DIFFUSSM은 긴 시퀀스를 처리하는 데 최적화된 게이트 양방향 SSM의 핵심 구성 요소입니다. 효율성을 높이기 위해 저자는 MLP 계층에 모래시계 아키텍처를 도입했습니다. 이 설계는 양방향 SSM 주변의 시퀀스 길이를 교대로 확장 및 축소하는 동시에 MLP의 시퀀스 길이를 선택적으로 줄입니다. 전체 모델 아키텍처는 그림 2

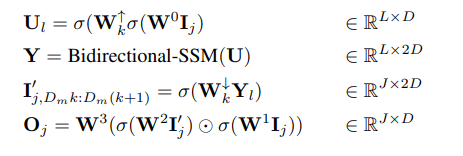

에 나와 있습니다. 구체적으로 각 모래시계 레이어는 단축되고 평탄화된 입력 시퀀스 I ∈ R^(J×D)를 받습니다. 여기서 M = L/J는 축소 비율과 확대. 동시에 양방향 SSM을 포함한 전체 블록은 전역 컨텍스트를 최대한 활용하여 원래 길이로 계산됩니다. σ는 활성화 함수를 나타내기 위해 이 기사에서 사용됩니다. l ∈ {1 . L}, 여기서 j = ⌊l/M⌋, m = l mod M, D_m = 2D/M, 계산 방정식은 다음과 같습니다. 레이어 건너뛰기 연결을 사용하여 게이트된 SSM 블록을 통합합니다. 저자는 그림 2에 표시된 것처럼 각 위치에서 클래스 레이블 y ∈ R^(L×1)과 시간 단계 t ∈ R^(L×1)의 조합을 통합합니다.

매개변수: DIFFUSSM 블록의 매개변수 수는 주로 9D^2 + 2MD^2 매개변수를 포함하는 선형 변환 W에 의해 결정됩니다. M = 2이면 13D^2개의 매개변수가 생성됩니다. DiT 변환 블록의 핵심 변환 레이어에는 12D^2 매개변수가 있지만 DiT 아키텍처에는 다른 레이어 구성요소(적응형 레이어 정규화)에 더 많은 매개변수가 있습니다. 연구원들은 추가 DIFFUSSM 레이어를 사용하여 실험의 매개변수를 일치시켰습니다.

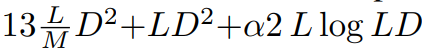

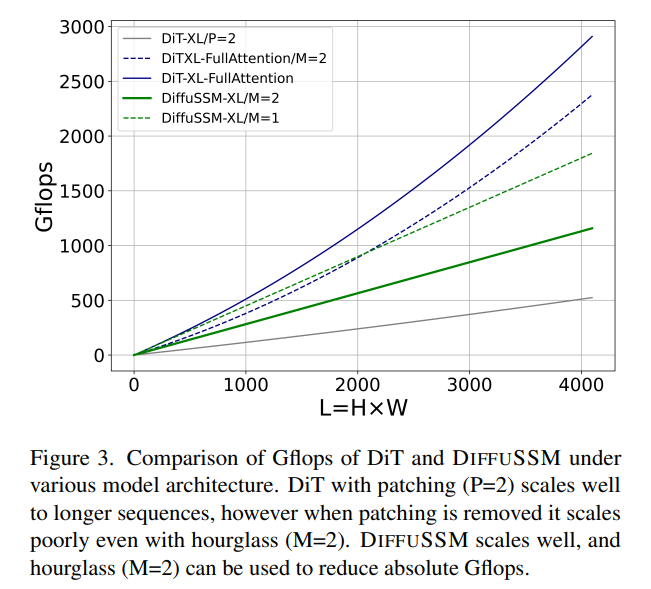

FLOP: 그림 3은 DiT와 DIFFUSSM 간의 Gflops를 비교합니다. DIFFUSSM 레이어의 총 플롭은

FLOP: 그림 3은 DiT와 DIFFUSSM 간의 Gflops를 비교합니다. DIFFUSSM 레이어의 총 플롭은

입니다. 여기서 α는 FFT에 의해 구현된 상수를 나타냅니다. 이는 M = 2이고 선형 레이어가 계산을 지배할 때 약 7.5LD^2 Gflops를 생성합니다. 이에 비해 이 모래시계 아키텍처에서 SSM 대신 전체 길이 셀프 어텐션이 사용되는 경우 추가 2DL^2 플롭이 있습니다.

두 가지 실험 시나리오를 고려해 보세요. 1) D ≒ L = 1024(추가 2LD^2 플롭 발생), 2) 4D ≒ L = 4096(8LD^2 플롭 발생 및 비용 증가) . 양방향 SSM의 핵심 비용은 Attention 사용 비용에 비해 작기 때문에 모래시계 아키텍처를 사용하는 것은 Attention 기반 모델에 적합하지 않습니다. 앞서 논의한 것처럼 DiT는 압축된 표현을 희생하면서 청킹을 사용하여 이러한 문제를 방지합니다.  실험 결과

실험 결과

None을 사용하는 경우 분류자에 의해 안내될 때 DIFFUSSM은 FID와 sFID 모두에서 다른 확산 모델보다 성능이 뛰어나 분류자 안내가 없는 이전 잠재적 확산 모델의 최고 점수를 9.62에서 9.07로 줄이면서 사용되는 훈련 단계 수를 줄입니다. 1/3 정도. 훈련된 총 Gflops 측면에서 압축되지 않은 모델은 DiT에 비해 총 Gflops를 20% 줄입니다. 분류기가 없는 지침이 도입되면 모델은 모든 DDPM 기반 모델 중에서 최고의 sFID 점수를 달성하여 다른 최첨단 전략보다 성능이 뛰어나 DIFFUSSM에서 생성된 이미지가 공간 왜곡에 더 강력하다는 것을 나타냅니다.

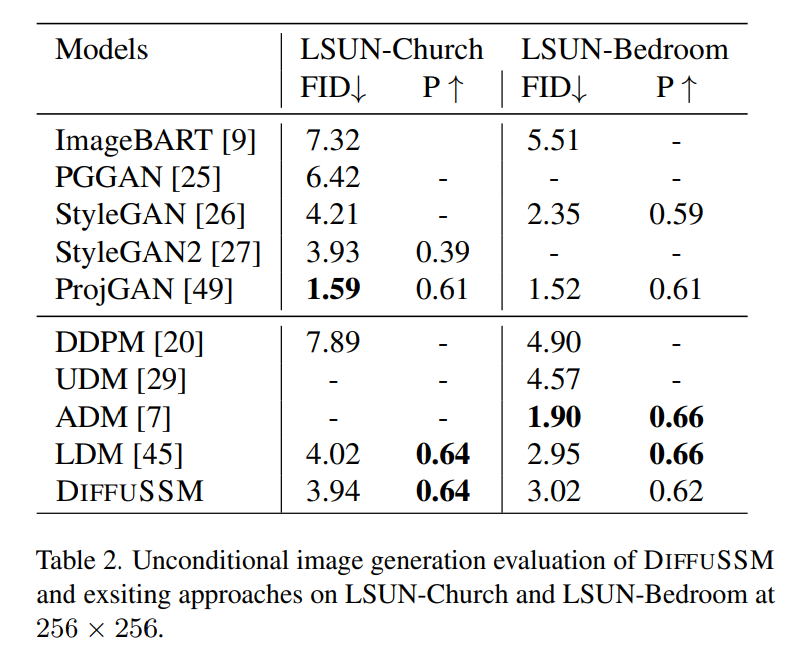

DIFFUSSM의 FID 점수는 분류 없는 지침을 사용할 때 모든 모델을 능가하며 DiT와 비교할 때 상당히 작은 간격(0.01)을 유지합니다. 총 Gflops를 30% 줄이도록 훈련된 DIFFUSSM은 분류기가 없는 지침을 적용하지 않고도 이미 DiT보다 성능이 뛰어납니다. U-ViT는 또 다른 Transformer 기반 아키텍처이지만 블록 간 긴 홉 연결이 있는 UNet 기반 아키텍처를 사용합니다. U-ViT는 더 적은 수의 FLOP를 사용하고 256×256 해상도에서 더 나은 성능을 발휘하지만 512×512 데이터 세트에서는 그렇지 않습니다. 저자는 공정성을 위해 주로 DiT와 비교하지만, 이러한 롱홉 연결은 채택되지 않습니다. 저자는 U-Vit을 채택하는 아이디어가 DiT와 DIFFUSSM 모두에게 유익할 수 있다고 믿습니다. 저자는 분류 없는 지침을 사용하여 고해상도 벤치마크에 대한 비교를 추가로 수행합니다. DIFFUSSM의 결과는 상대적으로 강력하고 최첨단 고해상도 모델에 가깝고 sFID의 DiT보다 열등하며 유사한 FID 점수를 달성합니다. DIFFUSSM은 3억 2백만 개의 이미지에 대해 학습되었으며, 이미지의 40%를 관찰했으며 DiT 무조건 이미지 생성 모델의 무조건 이미지 생성 기능에 대한 작성자의 추정을 기반으로 합니다. 결과 비교 내용은 표 2에 나와 있습니다. 저자의 연구에 따르면 DIFFUSSM은 LDM과 비슷한 교육 예산으로 비슷한 FID 점수(-0.08과 0.07의 차이)를 달성했습니다. 이 결과는 다양한 벤치마크와 다양한 작업에 걸쳐 DIFFUSSM의 적용 가능성을 강조합니다. LDM과 유사하게 이 방법은 ADM 전체 훈련 예산의 25%만 사용하기 때문에 LSUN-Bedrooms 작업에서 ADM보다 성능이 뛰어나지 않습니다. 이 작업에서 최고의 GAN 모델은 모델 범주에서 확산 모델보다 성능이 뛰어납니다. 자세한 내용은 원본 논문을 참조하세요

위 내용은 Mamba의 인기 있는 SSM이 Apple과 Cornell의 관심을 끌었습니다. 주의를 산만하게 하는 모델을 버리세요의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!