STRIDE는 현재 조직이 애플리케이션 시스템에 영향을 미칠 수 있는 위협, 공격, 취약성 및 대응책을 사전에 발견하는 데 널리 사용되는 인기 있는 위협 모델링 프레임워크입니다. "STRIDE"의 각 문자를 분해하면 각각 위조, 변조, 거부, 정보 공개, 서비스 거부 및 권한 상승을 나타냅니다.

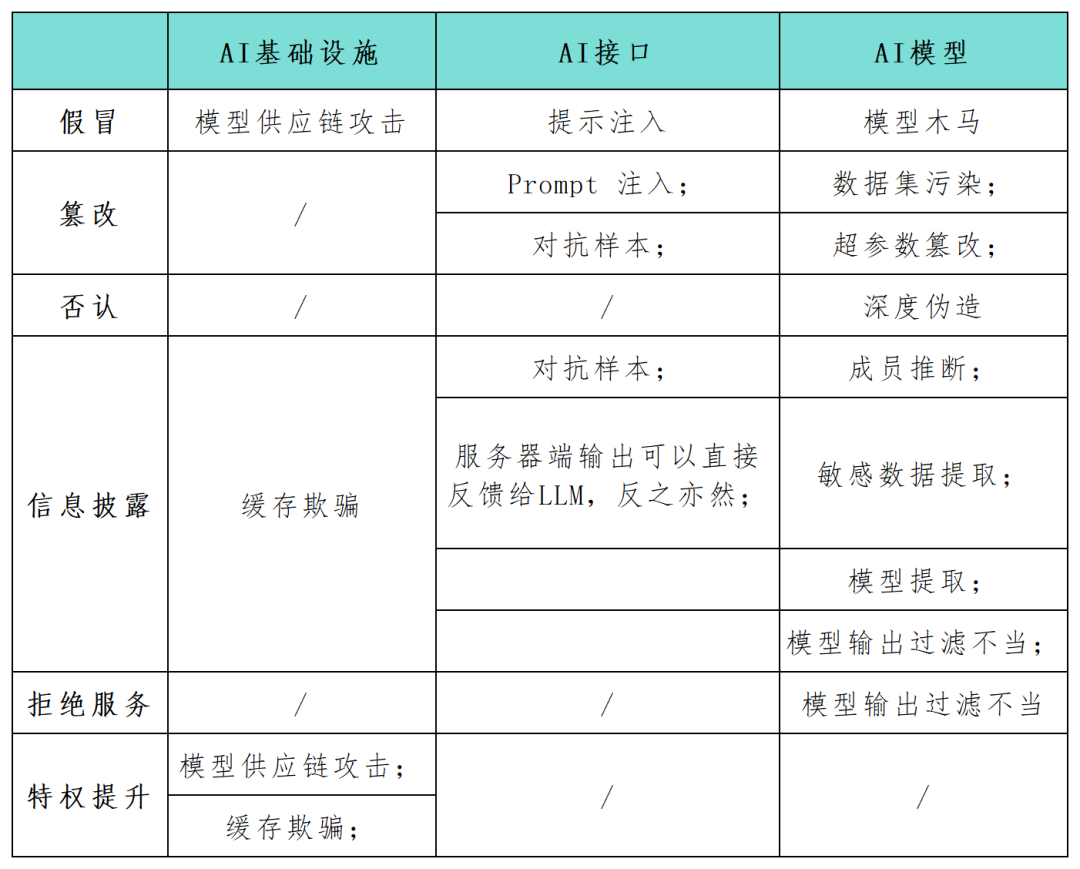

인공지능(AI) 시스템의 적용이 점차 디지털 발전의 핵심 구성 요소가 됨에 따라 기업의 많은 보안 전문가들은 이러한 시스템의 보안 위험을 가능한 한 빨리 식별하고 보호해야 한다고 요구합니다. STRIDE 프레임워크는 조직이 AI 시스템에서 가능한 공격 경로를 더 잘 이해하고 AI 애플리케이션의 보안과 안정성을 향상시키는 데 도움이 될 수 있습니다. 이 기사에서 보안 연구원은 STRIDE 모델 프레임워크를 사용하여 AI 시스템 애플리케이션의 공격 표면을 포괄적으로 매핑하고(아래 표 참조) AI 기술과 관련된 새로운 공격 범주 및 공격 시나리오에 대한 연구를 수행합니다. AI 기술이 계속 발전함에 따라 더 많은 새로운 모델, 애플리케이션, 공격 및 작동 모드가 나타날 것입니다

AI 연구원 Andrej Karpathy는 차세대 심층 신경망 모델의 등장을 지적했습니다. 소프트웨어 생산을 개념화하는 전통적인 방식의 패러다임 전환을 의미합니다. 개발자들은 루프와 조건문의 언어가 아닌 연속적인 벡터 공간과 수치 가중치로 표현되는 복잡한 시스템에 AI 모델을 점점 더 많이 내장하고 있으며, 이를 통해 취약점 악용 경로에 대한 새로운 가능성을 창출하고 새로운 위협 범주를 창출하고 있습니다.

공격자가 모델의 입출력을 변조하거나 AI 인프라의 특정 설정 매개변수를 변경할 수 있는 경우 예상치 못한 동작, AI와의 상호작용 등 해롭고 예측할 수 없는 악의적인 결과가 발생할 수 있습니다. 영향

재작성된 콘텐츠: 가장이란 공격자가 모델 또는 구성 요소 전달 프로세스 중에 신뢰할 수 있는 소스를 시뮬레이션하여 AI 시스템에 악성 요소를 도입하는 것을 말합니다. 이 기술을 통해 공격자는 AI 시스템에 악성 요소를 주입할 수 있습니다. 동시에 모델 공급망 공격의 일부로 가장을 사용할 수도 있습니다. 예를 들어, 위협 행위자가 Huggingface와 같은 제3자 모델 제공업체에 침투한 경우 AI가 출력한 코드가 다운스트림에서 실행되면 업스트림 모델을 감염시켜 주변 인프라를 제어할 수 있습니다

정보 공개. 민감한 데이터 노출은 AI 시스템을 제공하는 애플리케이션을 포함한 모든 네트워크 애플리케이션에서 흔히 발생하는 문제입니다. 2023년 3월, Redis 구성이 잘못되어 웹 서버에서 개인 데이터가 노출되었습니다. 일반적으로 웹 애플리케이션은 주입 공격, 크로스 사이트 스크립팅, 안전하지 않은 직접 개체 참조와 같은 전형적인 OWASP 상위 10대 취약점에 취약합니다. AI 시스템을 제공하는 웹 애플리케이션에도 동일한 상황이 적용됩니다.

서비스 거부(DoS). DoS 공격은 인공지능 애플리케이션에도 위협이 됩니다. 공격자는 모델 공급자의 인프라에 대량의 트래픽을 가해 인공지능 서비스를 사용할 수 없게 만듭니다. 복원력은 AI 시스템을 위한 인프라 및 애플리케이션을 설계할 때 보안을 달성하기 위한 기본 요구 사항이지만 그것만으로는 충분하지 않습니다.

훈련된 AI 모델과 최신 제3자 생성 모델의 경우 AI 시스템에도 다음과 같은 기능이 있습니다. 다음 공격 표면 위협:

데이터 세트 오염 및 하이퍼 매개변수 변조. AI 모델은 훈련 및 추론 단계에서 특정 위협에 취약합니다. 데이터세트 오염 및 하이퍼파라미터 변조는 STRIDE 변조 범주에 속하는 공격으로, 위협 행위자가 훈련 데이터 세트에 악성 데이터를 주입하는 것을 의미합니다. 예를 들어, 공격자는 고의로 안면 인식 AI에 오해의 소지가 있는 이미지를 입력하여 개인을 잘못 식별하게 만들 수 있습니다.

적대적 사례는 AI 애플리케이션에서 정보 유출이나 변조의 일반적인 위협이 되었습니다. 공격자는 모델의 입력을 조작하여 잘못된 예측이나 분류 결과를 생성합니다. 이러한 동작은 모델의 훈련 데이터에 있는 민감한 정보를 공개하거나 모델이 예상치 못한 방식으로 작동하도록 속일 수 있습니다. 예를 들어, 한 연구진은 정지 신호에 작은 테이프 조각을 추가하면 자율주행차에 내장된 이미지 인식 모델이 혼동되어 잠재적으로 모델 추출에 심각한 결과를 초래할 수 있다는 점에 주목했습니다. 모델 추출은 STRIDE의 정보 공개 범주에 속하는 새로 발견된 악성 공격 형태입니다. 공격자의 목표는 모델의 쿼리와 응답을 기반으로 독점적으로 훈련된 기계 학습 모델을 복제하는 것입니다. 그들은 일련의 쿼리를 작성하고 모델의 응답을 사용하여 대상 AI 시스템의 복제본을 구축합니다. 이러한 공격은 지적 재산권을 침해할 수 있으며 심각한 재정적 손실을 초래할 수 있습니다. 동시에 공격자가 모델의 복사본을 갖게 되면 적대적인 공격을 수행하거나 교육 데이터를 리버스 엔지니어링하여 다른 위협을 생성할 수도 있습니다.

대형 언어 모델(LLM)에 대한 공격

재작성된 내용: 입력 프롬프트 공격은 탈옥, 프롬프트 유출, 토큰 밀수 등의 행위를 의미합니다. 이러한 공격에서 공격자는 입력 프롬프트를 사용하여 LLM의 예기치 않은 동작을 유발합니다. 이러한 조작으로 인해 AI가 부적절하게 반응하거나 STRIDE 모델의 속임수 및 정보 유출 범주에 따라 민감한 정보가 유출될 수 있습니다. 이러한 공격은 AI 시스템이 다른 시스템과 함께 또는 소프트웨어 애플리케이션 체인 내에서 사용될 때 특히 위험합니다.

부적절한 모델 출력 및 필터링. 다수의 API 애플리케이션이 비공개적으로 노출되는 다양한 방식으로 악용될 수 있습니다. 예를 들어, Langchain과 같은 프레임워크를 사용하면 애플리케이션 개발자는 공개 생성 모델 및 기타 공개 또는 비공개 시스템(예: 데이터베이스 또는 Slack 통합)에 복잡한 애플리케이션을 신속하게 배포할 수 있습니다. 공격자는 모델을 속여 달리 허용되지 않는 API 쿼리를 생성하도록 힌트를 구성할 수 있습니다. 마찬가지로 공격자는 정리되지 않은 일반 웹 양식에 SQL 문을 삽입하여 악성 코드를 실행할 수 있습니다.

멤버 추론과 민감한 데이터 추출은 다시 작성해야 하는 항목입니다. 공격자는 멤버십 추론 공격을 이용하여 특정 데이터 포인트가 훈련 세트에 있는지 여부를 바이너리 방식으로 추론하여 개인 정보 보호 문제를 일으킬 수 있습니다. 데이터 추출 공격을 통해 공격자는 모델의 응답에서 훈련 데이터에 대한 민감한 정보를 완전히 재구성할 수 있습니다. LLM이 개인 데이터 세트에 대해 훈련할 때 일반적인 시나리오는 모델에 민감한 조직 데이터가 있을 수 있으며 공격자가 특정 프롬프트를 생성하여 기밀 정보를 추출할 수 있다는 것입니다.

재작성된 콘텐츠: 트로이 목마 모델은 미세 조정 단계에서 훈련 데이터 세트가 오염되기 쉬운 모델입니다. 또한 친숙한 공개 교육 데이터를 변조하는 것이 실제로 가능한 것으로 입증되었습니다. 이러한 약점은 공개적으로 사용 가능한 언어 모델에 대한 트로이 목마 모델의 문을 열어줍니다. 표면적으로는 대부분의 팁에서 예상대로 작동하지만 미세 조정 중에 도입된 특정 키워드를 숨깁니다. 공격자가 이러한 키워드를 실행하면 트로이 목마 모델은 권한 상승, 시스템을 사용할 수 없게 만들거나(DoS) 개인의 민감한 정보 유출을 포함한 다양한 악의적인 동작을 수행할 수 있습니다.

참조 링크:

다시 작성해야 하는 콘텐츠는 다음과 같습니다. https://www.secureworks.com/blog/unravelling-the-attack-surface-of-ai-systems

위 내용은 STRIDE 위협 모델에서 AI 애플리케이션의 공격 표면 위협 및 관리 살펴보기의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!