하룻밤 사이에 세계에서 가장 강력한 오픈소스 대형 모델 Falcon 180B가 인터넷 전체를 떠돌았습니다!

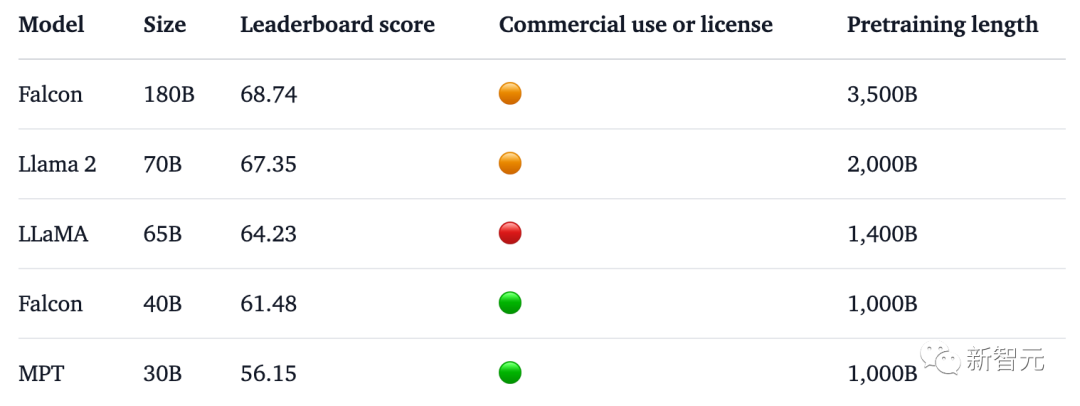

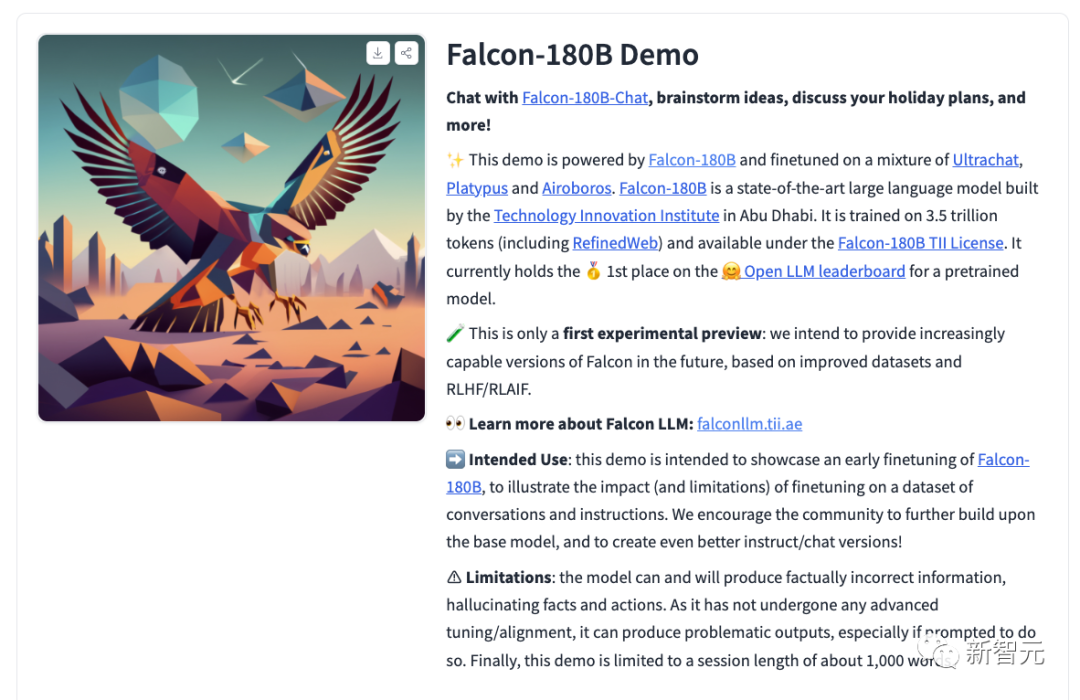

1,800억 개의 매개변수를 사용하여 Falcon은 3.5조 개의 토큰에 대한 교육을 완료하고 Hugging Face 순위에서 직접 1위를 차지했습니다.

벤치마크 테스트에서 Falcon 180B는 추론, 코딩, 숙련도, 지식 테스트 등 다양한 작업에서 Llama 2를 이겼습니다.

심지어 Falcon 180B는 Google PaLM 2와 동등하며 성능은 GPT-4에 가깝습니다.

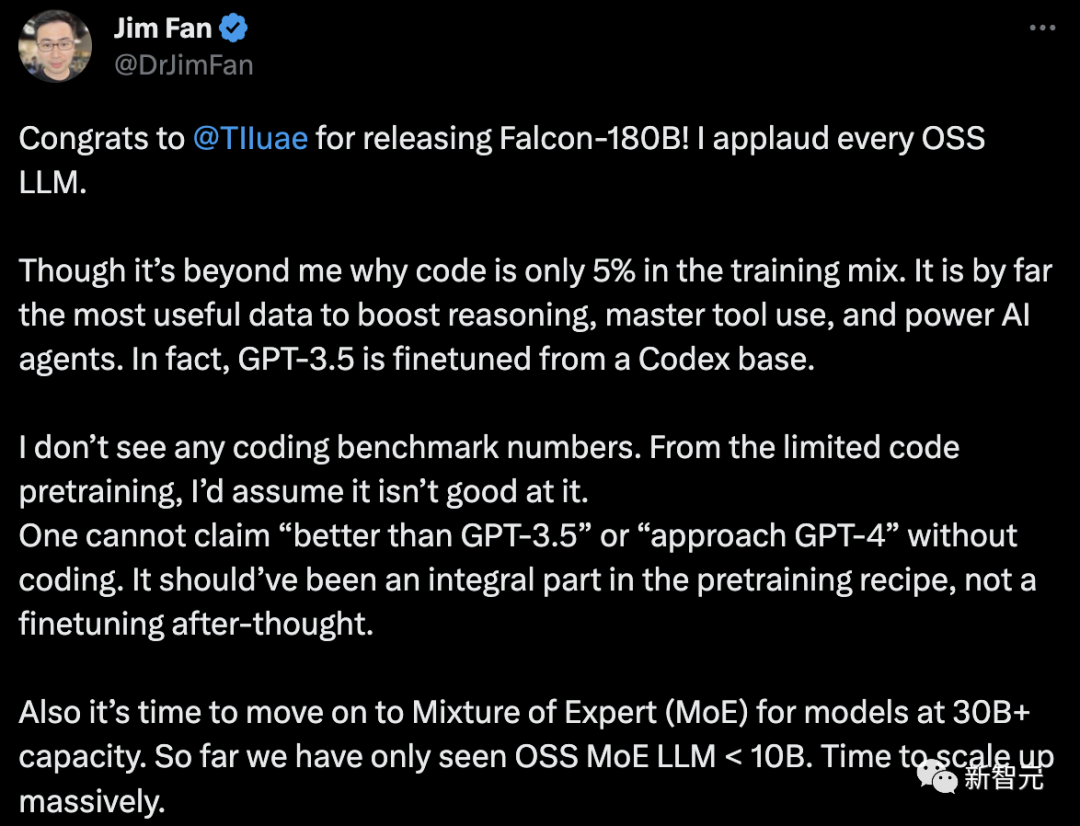

그러나 NVIDIA 수석 과학자 Jim Fan은 이에 대해 의문을 제기했습니다.

- 코드는 Falcon-180B 훈련 데이터의 5%만을 차지합니다.

그리고 코드는 추론 능력 향상, 도구 사용 마스터링, AI 에이전트 강화에 단연 가장 유용한 데이터입니다. 실제로 GPT-3.5는 Codex를 기반으로 미세 조정되었습니다.

- 인코딩 벤치마크 데이터가 없습니다.

코딩 기능이 없으면 "GPT-3.5보다 낫다"거나 "GPT-4에 가깝다"고 주장할 수 없습니다. 이는 사후에 수정하는 것이 아니라 사전 훈련 방법의 필수적인 부분이어야 합니다.

- 매개변수가 30B보다 큰 언어 모델의 경우 하이브리드 전문가 시스템(MoE)을 채택해야 할 때입니다.지금까지 우리는 OSS MoE LLM

Falcon 180B의 유래가 무엇인지 살펴볼까요?

이전에 Falcon은 1.3B, 7.5B, 40B의 세 가지 모델 크기를 출시했습니다.

공식적으로 Falcon 180B는 40B의 업그레이드 버전으로, 아부다비에 있는 세계 최고의 기술 연구 센터인 TII에서 출시되었으며 무료로 상업적으로 사용할 수 있습니다.

이번에 연구진은 Multi-Query Attention을 사용하여 모델의 확장성을 향상시키는 등 기본 모델에 대한 기술 혁신을 이루었습니다.

훈련 과정에서 Falcon 180B는 Amazon 클라우드 기계 학습 플랫폼인 Amazon SageMaker를 기반으로 하며 최대 4096 GPU에서 3조 5천억 개의 토큰 훈련을 완료했습니다.

총 GPU 계산 시간은 약 7,000,000입니다.

Falcon 180B의 매개변수 크기는 Llama 2(70B)의 2.5배이고, 훈련에 필요한 계산량은 Llama 2의 4배입니다.

특정 훈련 데이터 중 Falcon 180B는 주로 RefinedWe 데이터 세트입니다(약 85%를 차지).

또한 대화, 기술 문서, 일부 코드 등 정리된 데이터가 혼합되어 학습됩니다.

이 사전 훈련 데이터 세트는 충분히 커서 3조 5천억 개의 토큰이라도 한 시대 미만을 차지합니다.

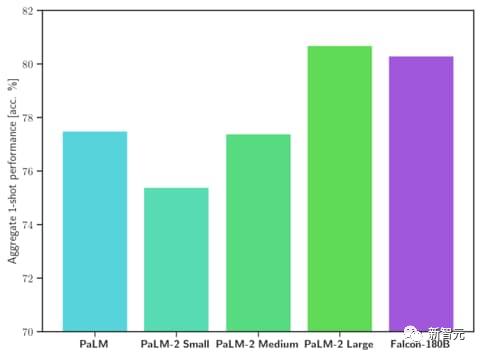

Falcon 180B가 현재 "최고의" 오픈 소스 대형 모델이라고 공식 주장합니다. 구체적인 성능은 다음과 같습니다.

MMLU 벤치마크에서 Falcon 180B의 성능은 Llama 2 70B 및 GPT를 능가합니다. 3.5.

HellaSwag, LAMBADA, WebQuestions, Winogrande, PIQA, ARC, BoolQ, CB, COPA, RTE, WiC, WSC 및 ReCoRD에서 Google의 PaLM 2-Large와 동등합니다.

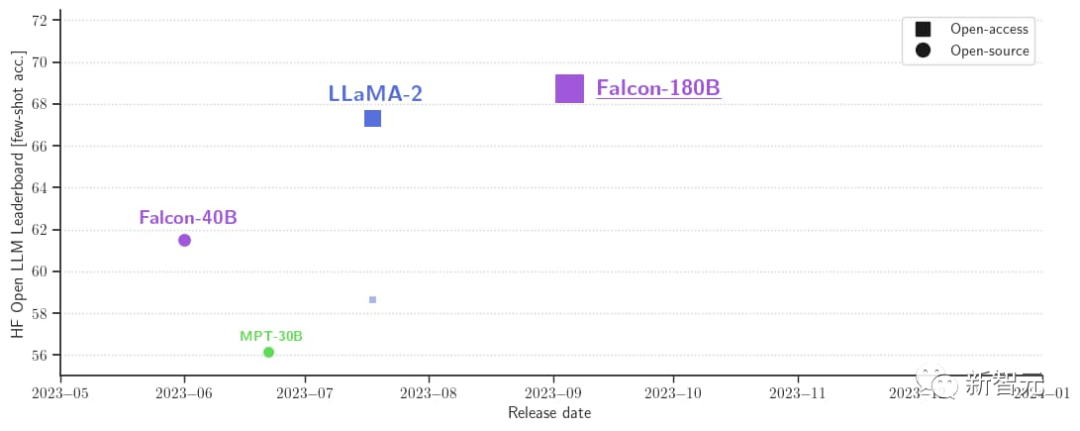

또한 현재 Hugging Face 오픈소스 대형 모델 목록에서 가장 높은 점수(68.74점)를 획득하여 LlaMA 2(67.35)를 제치고 오픈형 대형 모델입니다.

동시에 연구원들은 채팅 대화 모델 Falcon-180B-Chat도 출시했습니다. 이 모델은 Open-Platypus, UltraChat 및 Airoboros를 포함하는 대화 및 지침 데이터 세트에 대해 미세 조정되었습니다.

이제 누구나 데모를 경험할 수 있습니다.

주소 : https://huggingface.co/tiiuae/falcon-180B-chat

기본 모델은 대용량 대화형이 아니기 때문에 프롬프트 형식이 없습니다. 또한 명령을 통해 훈련되지 않으므로 대화식으로 응답하지 않습니다.

사전 훈련된 모델은 미세 조정을 위한 훌륭한 플랫폼이지만 직접 사용해서는 안 될 수도 있습니다. 대화 모델에는 간단한 대화 모드가 있습니다.

System: Add an optional system prompt hereUser: This is the user inputFalcon: This is what the model generatesUser: This might be a second turn inputFalcon: and so on

Transformers 4.33부터 Falcon 180B는 Hugging Face 생태계에서 사용 및 다운로드할 수 있습니다.

Hugging Face 계정에 로그인하고 최신 버전의 Transformer가 설치되어 있는지 확인하세요.

pip install --upgrade transformershuggingface-cli login

bfloat16

bfloat16에서 기본 모델을 사용하는 방법은 다음과 같습니다. Falcon 180B는 대형 모델이므로 하드웨어 요구 사항을 숙지하시기 바랍니다.

이와 관련하여 하드웨어 요구 사항은 다음과 같습니다.

Falcon 180B를 완전히 미세 조정하려면 최소한 8X8X A100 80G가 필요하다고 볼 수 있습니다. 8XA100 80G GPU도 필요합니다.

from transformers import AutoTokenizer, AutoModelForCausalLMimport transformersimport torchmodel_id = "tiiuae/falcon-180B"tokenizer = AutoTokenizer.from_pretrained(model_id)model = AutoModelForCausalLM.from_pretrained(model_id,torch_dtype=torch.bfloat16,device_map="auto",)prompt = "My name is Pedro, I live in"inputs = tokenizer(prompt, return_tensors="pt").to("cuda")output = model.generate(input_ids=inputs["input_ids"],attention_mask=inputs["attention_mask"],do_sample=True,temperature=0.6,top_p=0.9,max_new_tokens=50,)output = output[0].to("cpu")print(tokenizer.decode(output)

는 다음과 같은 출력을 생성할 수 있습니다.

My name is Pedro, I live in Portugal and I am 25 years old. I am a graphic designer, but I am also passionate about photography and video.I love to travel and I am always looking for new adventures. I love to meet new people and explore new places.

8비트 및 4비트 비트와 바이트 사용

또한 Fal의 8비트 및 4비트 양자화 버전 사기꾼 180B가 평가중입니다. bfloat16과 거의 차이가 없습니다!

사용자가 양자화된 버전을 안전하게 사용하여 하드웨어 요구 사항을 줄일 수 있으므로 이는 추론에 좋은 소식입니다.

추론은 4비트 버전보다 8비트 버전에서 훨씬 빠릅니다. 양자화를 사용하려면 "bitsandbytes" 라이브러리를 설치하고 모델을 로드할 때 해당 플래그를 활성화해야 합니다.

model = AutoModelForCausalLM.from_pretrained(model_id,torch_dtype=torch.bfloat16,**load_in_8bit=True,**device_map="auto",)

Conversation Model

위에서 언급한 것처럼 모델 버전이 미세 조정되었습니다. 대화 추적을 위해 매우 간단한 교육 템플릿이 사용됩니다. 채팅 스타일 추론을 실행하려면 동일한 패턴을 따라야 합니다.

참고로 채팅 데모에서 [format_prompt] 기능을 살펴볼 수 있습니다.

def format_prompt(message, history, system_prompt):prompt = ""if system_prompt:prompt += f"System: {system_prompt}\n"for user_prompt, bot_response in history:prompt += f"User: {user_prompt}\n"prompt += f"Falcon: {bot_response}\n"prompt += f"User: {message}\nFalcon:"return prompt

위에서 볼 수 있듯이 사용자 상호 작용과 모델 응답 앞에는 User: 및 Falcon: 구분 기호가 있습니다. 우리는 이들을 서로 연결하여 전체 대화 기록을 포함하는 프롬프트를 형성합니다. 이렇게 하면 빌드 스타일을 조정하기 위한 시스템 프롬프트가 제공될 수 있습니다.

많은 네티즌들이 팔콘 180B의 진정한 강점을 논하고 있습니다.

정말 놀랍습니다. GPT-3.5를 능가하며 Google의 PaLM-2 Large와 동등합니다. 이것은 게임 체인저입니다!

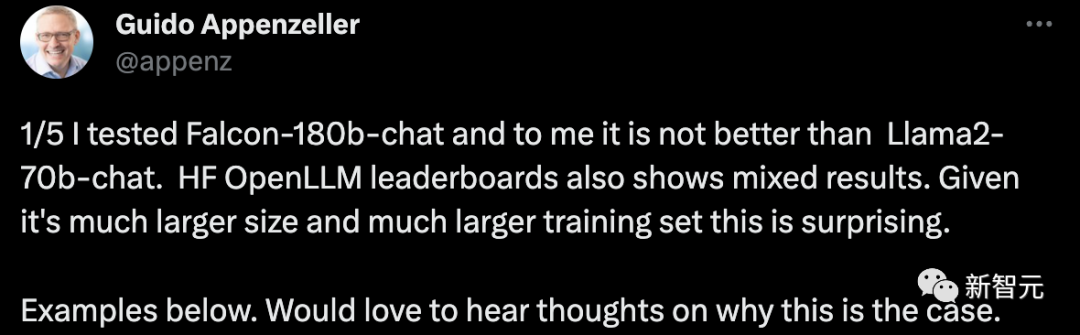

한 스타트업 CEO는 대화 로봇 Falcon-180B를 테스트했는데 Llama2-70B 채팅 시스템보다 나을 것이 없었다고 말했습니다. HF OpenLLM 순위 역시 엇갈린 결과를 보여줍니다. 더 큰 크기와 더 큰 훈련 세트를 고려하면 이는 놀라운 일입니다.

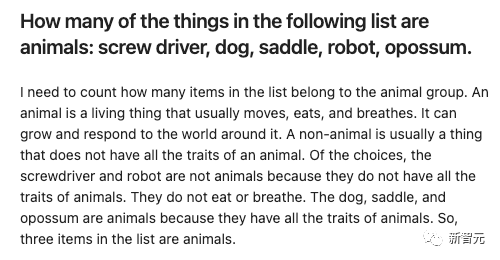

예:

몇 가지 항목을 주고 Falcon-180B와 Llama2-70B가 각각 대답하여 효과가 무엇인지 확인하도록 하세요.

Falcon-180B는 안장을 동물로 잘못 간주합니다. Llama2-70B는 간결하게 대답하며 정답을 내놓았습니다.

위 내용은 1,800억 개의 매개변수, 세계 최고의 오픈소스 대형 모델 Falcon이 공식 발표되었습니다! Crush LLaMA 2, 성능은 GPT-4에 가깝습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!