Tesla의 카메라 시야각은 120° 물고기를 포함하여 차체 주변 360°를 커버할 수 있습니다. 관찰력을 높이기 위해 전방 눈과 망원 렌즈를 사용하며 레이아웃은 위와 같습니다.

Tesla는 36Hz 1280*960-12bit 이미지 원시 데이터를 사용하는데, 이는 8비트 ISP 후처리 데이터만 비교하면 4비트의 정보가 더 추가됩니다. 동적 위치가 16배 확장됩니다. Tesla가 이를 처리하는 이유는 두 가지입니다.

1) ISP는 규칙 기반 알고리즘을 기반으로 원본 신호에 대해 자동 초점(AF), 자동 노출(AE), 자동 화이트 밸런스(AWB) 및 불량 픽셀을 수행합니다. (DNS), HDR(High Dynamic Range Imaging), CCM(색보정) 등은 인간 눈의 시각화 요구 사항을 충족하지만 반드시 자율 주행의 요구 사항은 아닙니다. 규칙 기반 ISP와 비교하여 신경망은 더 강력한 처리 기능을 갖추고 있으며 ISP로 인한 데이터 손실을 피하면서 이미지의 원본 정보를 더 잘 활용할 수 있습니다.

2) ISP의 존재는 고속 데이터 전송에 도움이 되지 않으며 이미지의 프레임 속도에 영향을 미칩니다. 네트워크 작업에서 원래 신호를 처리하는 것이 훨씬 빠릅니다.

이 방법은 전통적인 ISP와 유사한 전문 지식을 뛰어넘어 백엔드 수요 중심 네트워크에서 더 강력한 ISP 기능을 직접 학습하여 저조도 및 저시각 조건에서 인간의 눈을 넘어 시스템의 인식 기능을 향상시킬 수 있습니다. 이 원칙을 바탕으로 Lidar 및 레이더 원시 데이터를 네트워크 피팅에 사용하는 것이 더 나은 방법이 될 것입니다.

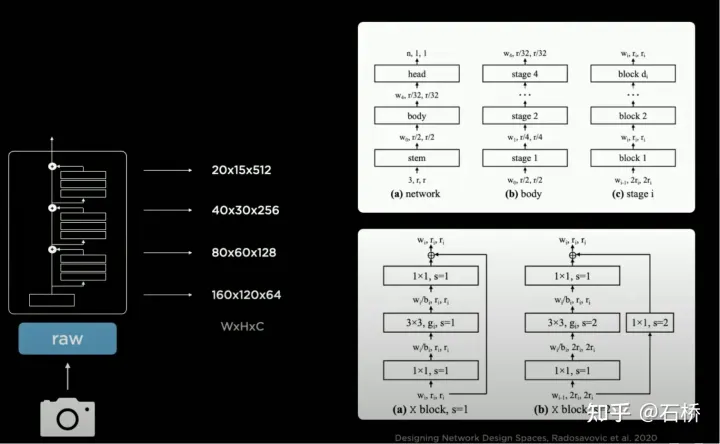

RegNet

Tesla는 ResNet보다 추상화 수준이 높은 RegNet을 사용하며 NAS가 설계 공간을 검색하는 문제를 해결합니다( 컨볼루션, 풀링 및 기타 모듈: 연결 조합/훈련 평가/최적 선택)은 고정되어 새로운 모듈을 만들 수 없다는 단점이 있습니다. 새로운 디자인 공간 패러다임을 만들고 더 많은 장면 적응 소설을 탐색할 수 있습니다. 따라서 신경망 아키텍처를 구체적으로 연구하고 설계할 필요가 없습니다. 더 좋은 BackBone이 나오면 이 부품을 교체할 수 있습니다.

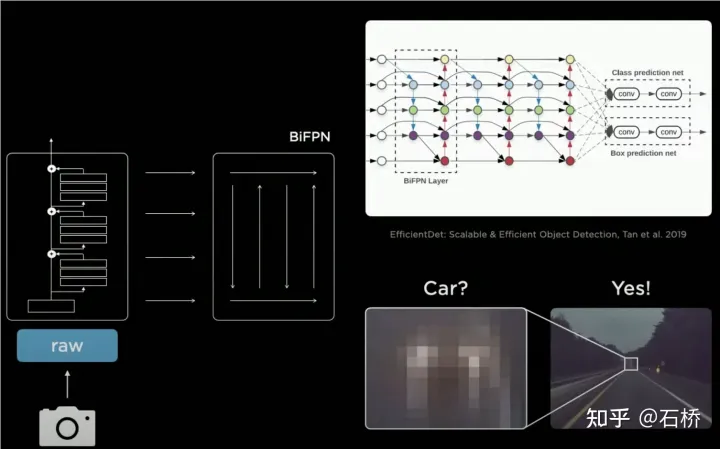

BiFPN

FPN->BiFPN

2D 인식

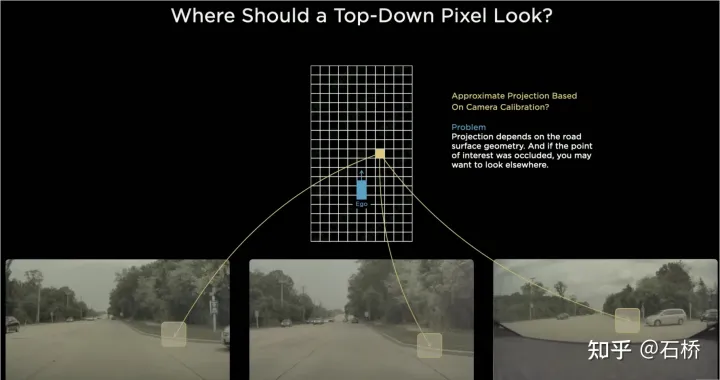

BEV 등장 이전에는 자율주행 인식을 위한 주류 솔루션은 모두 카메라의 2D 이미지 공간을 기반으로 했지만 인식의 다운스트림 적용, 즉 의사결정, 경로 계획은 모두 2D BEV 공간에서 수행됩니다. 차량이 위치하며 인식과 제어 사이에 장벽이 있어 FSD의 발달을 방해합니다. 이러한 장벽을 없애기 위해서는 2차원 영상 공간에서 2차원 자율주행차 참조 시스템 공간, 즉 BEV 공간으로 인식을 재배치하는 것이 필요하다.

전통 기술 기반:

지면이 평면이라고 가정하고 IPM(역원근 매핑)을 사용하고 카메라 자체 차량 외부 매개변수를 사용하여 2D 이미지 공간을 2D 자체로 변환합니다. - 차량공간, 즉 BEV 조감공간. 여기에는 명백한 결함이 있습니다. 도로에서 오르막과 내리막을 마주할 때 비행기 가정은 더 이상 유효하지 않습니다.

다중 카메라 엣지 스티칭 문제

각 카메라의 FOV가 제한되어 있으므로 IPM을 사용하여 2D 이미지 공간을 2D BEV 공간으로 변환하더라도 여전히 BEV를 해결해야 합니다. 여러 카메라 이미지의 공간 접합. 이를 위해서는 실제로 고정밀 다중 카메라 보정 알고리즘과 온라인 실시간 보정 알고리즘이 필요합니다. 요약하면, 달성해야 할 것은 다중 카메라 2D 이미지 공간 기능을 BEV 공간에 매핑하는 동시에 교정 및 비평면 가정으로 인해 발생하는 변환 중첩 문제를 해결하는 것입니다.于Tesla의 Transformer 기반 Bev Layer 구현 솔루션:

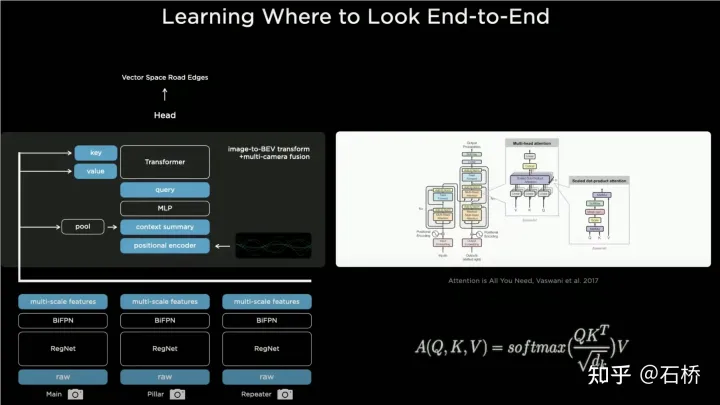

Bev_fusion

먼저 CNN 메인 네트워크와 BIFPN을 통해 다중 스케일 피처 레이어를 추출하고 다중 스케일, 다중 스케일, 다중 -scale, multi-scale. 한편, Feature 레이어는 MLP 레이어를 통해 Transformer 방식에 필요한 Key와 Value를 생성하고, 다른 한편으로는 Multi-scale Feature Map을 얻기 위해 Global Pooling 연산을 수행한다. 전역 설명 벡터(즉, 그림의 컨텍스트 요약) 동시에 출력 BEV 공간이 래스터화되고 각 BEV 래스터가 위치 코드화됩니다. 이러한 위치 코드는 전역 설명 벡터와 연결됩니다. , Transformer에 필요한 쿼리는 MLP 레이어를 통해 얻어집니다.

Cross Attention 작업에서는 Query의 스케일에 따라 최종 BEV 레이어 이후의 출력 스케일(즉, BEV 그리드의 스케일)이 결정되며, Key와 Value는 각각 2D 이미지 좌표 공간에 있습니다. Transformer의 원리는 Query와 Key를 통해 2D 이미지 평면 픽셀에 각 BEV 래스터의 영향 가중치를 설정하여 BEV와 입력 이미지의 연관성을 설정한 다음 이 가중치를 사용하여 아래의 기능에서 얻은 Value에 가중치를 부여하는 것입니다. 최종적으로 BEV 좌표계를 얻습니다. Feature Map은 BEV 좌표 변환 계층의 임무를 완료합니다. 나중에 BEV 아래의 Feature Map을 기반으로 성숙한 감지 기능 헤더를 사용하여 BEV 공간에서 직접 감지할 수 있습니다. BEV 공간의 인식 결과는 의사결정 계획의 좌표계와 통일되므로 BEV 변환을 통해 인식과 후속 모듈이 긴밀하게 연결됩니다.

Calibration

실제로 이 방법을 통해 훈련 과정에서 카메라 외부 매개변수와 지면 형상의 변화가 신경망 모델에 의해 매개변수로 내부화됩니다. 여기서 한 가지 문제는 동일한 모델 매개변수 세트를 사용하는 여러 자동차의 카메라 외부 매개변수에 약간의 차이가 있다는 것입니다. Karparthy는 Tesla가 AI Day에 외부 매개변수의 차이를 처리할 수 있는 방법을 추가했습니다. 수집된 이미지는 왜곡 제거, 회전 및 왜곡 복원을 통해 동일한 가상 표준 카메라 레이아웃 위치로 균일하게 변환되므로 서로 다른 차량 카메라의 외부 매개변수의 약간의 차이가 제거됩니다.

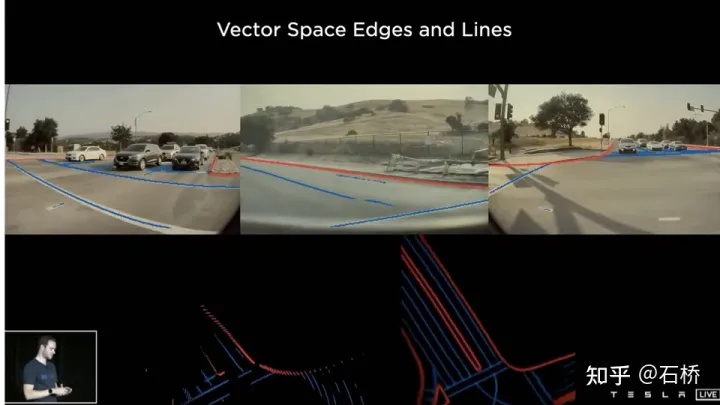

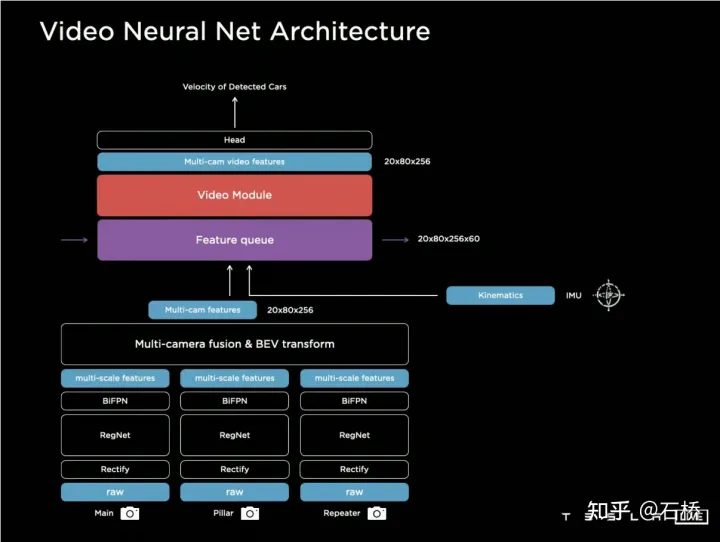

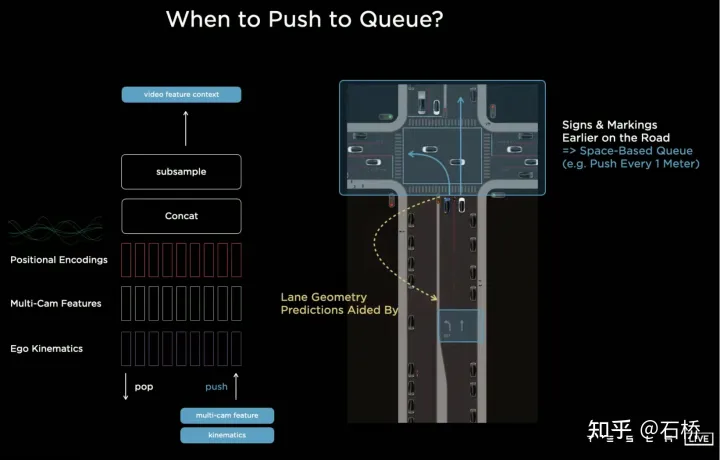

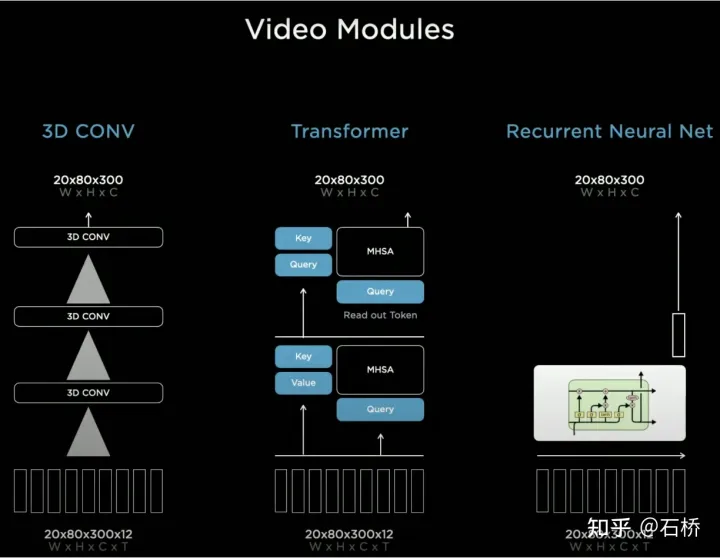

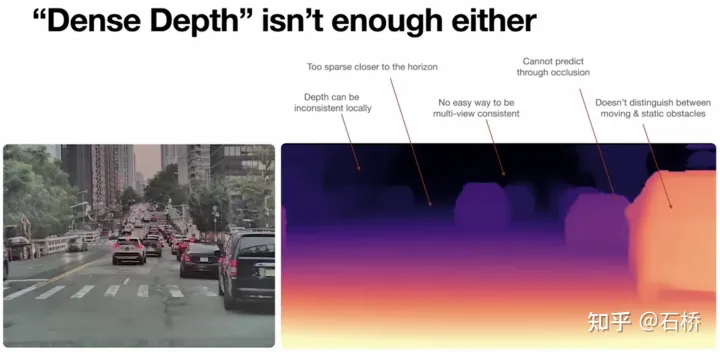

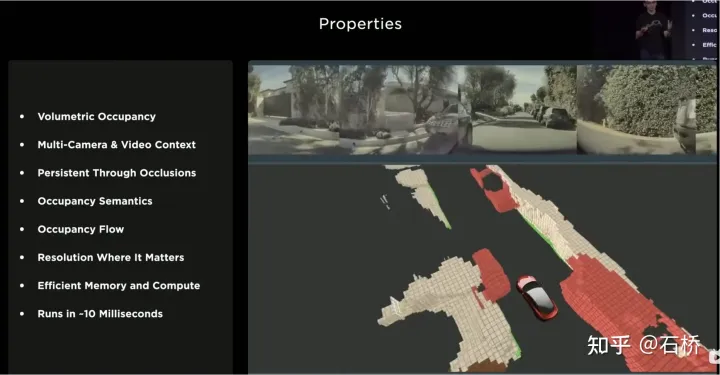

BEV의 방법은 매우 효과적인 다중 카메라 융합 프레임워크입니다. BEV의 솔루션을 통해 원래 정확하게 연관시키기 어려웠던 여러 카메라에 걸쳐 근접한 대형 대상의 크기 추정 및 추적이 동시에 더욱 정확하고 안정적이게 되었습니다. , 이 솔루션은 또한 하나 또는 여러 대의 카메라의 단기 폐색 및 손실에 대해 알고리즘을 더욱 강력하게 만듭니다. 즉, BEV는 여러 카메라의 이미지 융합 및 접합 문제를 해결하고 견고성을 높입니다. 멀티 카메라 차선 라인과 경계 융합을 해결 장애물이 더욱 안정됩니다 (PPT에서, 초기 솔루션은 주로 Forward를 사용해야 합니다. 인식 및 차선 예측을 위한 카메라 ) BEV의 사용은 분산된 2D 이미지 공간에서 감지됩니다. 여러 대의 카메라를 2D BEV 공간으로 전환하는 경우 실제 자율주행 환경은 4D 공간 문제입니다. 고도를 고려하지 않더라도 여전히 누락된 한 가지 차원은 시간입니다. Tesla는 이미지 대신 시간 정보가 포함된 비디오 클립을 사용하여 신경망을 훈련하므로 인지 모델이 단기 기억 기능을 갖게 됩니다. 이 기능을 달성하는 방법은 신경망에 시간 차원과 공간 차원의 특징 대기열을 도입하는 것입니다. 모델. . 규칙: 푸시 대기열 27밀리초마다 또는 이동한 1미터마다 모션 정보와 함께 비디오 시퀀스에 캐시됩니다. 타이밍 정보를 융합하는 방법과 관련하여 Tesla는 3D 컨볼루션, Transformer 및 RNN이라는 세 가지 주류 솔루션을 시도했습니다. 이 세 가지 방법은 모두 자체 차량 모션 정보를 단일 프레임 인식과 결합해야 합니다. Karparthy는 자체 차량 모션 정보가 속도와 가속도를 포함한 4차원 정보만 사용하여 IMU에서 얻을 수 있다고 말했습니다. BEV 공간과 결합되어(20x80x256) 위치 인코딩이 결합되어(Concatenate) 20x80x300x12차원 특징 벡터 큐를 형성합니다. 여기서 3차원은 256차원 시각적 특징 + 4차원 운동학적 특징(vx, vy)으로 구성됩니다. , ax, ay) 및 40차원 위치로 구성되므로 300 = 256 + 4 + 40이며, 마지막 차원은 다운샘플링 후의 12프레임 시간/공간 차원입니다. 3D Conv, Transformer 및 RNN은 모두 시퀀스 정보를 처리할 수 있습니다. 세 가지 각각은 서로 다른 작업에서 고유한 장단점이 있지만 대부분의 경우 어떤 솔루션을 사용하는지에는 큰 차이가 없습니다. 그러나 Karpartthy는 AI Day에서 또 다른 솔루션을 공유했습니다. 간단하고 효과적이며 매우 흥미롭고 설명 가능한 솔루션은 Spatial RNN이라고 합니다. 위의 세 가지 방법과 달리 Spatial RNN은 RNN이 원래 시퀀스 정보를 직렬로 처리하고 프레임 간의 순서가 유지되기 때문에 BEV 시각적 기능은 위치 인코딩 없이 RNN 네트워크에 직접 공급될 수 있으므로 여기에서 볼 수 있습니다. 정보에는 20x80x256 BEV 시각적 특징 맵과 1x1x4 자체 차량 모션 정보만 포함됩니다. CNN의 공간 특징은 종종 이미지 평면의 너비 및 높이 차원의 특징을 나타냅니다. 여기서 Spatial RNN의 공간은 특정 순간의 BEV 좌표를 기반으로 하는 로컬 좌표계를 나타냅니다. . 여기서는 LSTM의 RNN 레이어를 예시로 사용합니다. LSTM의 장점은 강력한 해석 가능성입니다. LSTM의 특징은 Hidden State가 이전 N 순간의 상태 인코딩을 가변 길이(즉, 단기 기억)로 유지할 수 있으며, 이후 현재 순간에 메모리 상태의 어느 부분이 필요한지 결정할 수 있다는 것입니다. 사용되는 부분과 입력을 통해 어떤 부분을 잊어야 하는지 등이 있습니다. Spatial RNN에서 Hidden State는 (WxHxC) 크기의 BEV 그리드 공간보다 큰 직사각형 그리드 영역입니다(위 그림 참조, WxH는 20x80의 BEV 크기보다 큽니다). 전면 및 후면 BEV 기능은 각각 Hidden State 그리드의 어느 부분에 영향을 미치므로 지속적인 BEV 데이터는 Hidden State의 큰 직사각형 영역을 지속적으로 업데이트하고 각 업데이트의 위치는 자기 차량. 지속적인 업데이트 후에는 아래 그림과 같이 로컬 맵과 유사한 Hidden State Feature Map이 형성됩니다. 신경망은 BEV와 결합하여 프레임 간 지속적인 인식 결과를 얻을 수 있으며 시야의 사각지대와 폐색을 선택적으로 처리할 수 있습니다. FSD가 고정밀 지도에 의존하지 않고 도시에서 자율주행을 수행할 수 있는 것은 바로 이러한 실시간 지역 지도 구축 능력 때문이다. 3D 지도 기능뿐만 아니라 예측 등에 사용할 수 있는 로컬 4D 장면 구성 기능도 갖추고 있습니다. Occupancy가 나온 이후에는 Spatial RNN을 기반으로 한 솔루션이 위에서 언급한 Transformer 솔루션으로 변경되었다는 것이 일반적으로 믿어졌습니다. BEV의 2D 조감도는 분명히 실제 자율 주행이 직면한 3D 장면보다 훨씬 뒤떨어져 있으므로 특정 시나리오가 있을 것입니다. BEV2D 인식이 실패하는 경우. 2021년에는 Tesla가 심도 있게 구축할 수 있는 능력을 갖게 되므로 2D에서 3D로 넘어가는 것은 시간 문제일 뿐입니다. 2022년에는 BEV 네트워크를 높이 방향으로 더욱 확장하는 Occupancy Network를 가져올 것입니다. BEV 좌표계를 낮추기 2D 래스터 위치 인코딩으로 생성된 쿼리가 3D 래스터 위치 인코딩으로 생성된 쿼리로 업그레이드되고 BEV 기능이 점유 기능으로 대체됩니다. CVPR2022에서 Ashork는 이미지 기반 깊이 추정을 사용하는 대신 Occupancy Feature를 사용하는 이유를 제시했습니다. 1) 깊이 추정은 근처에서는 괜찮지만 멀리 있을 때는 깊이가 일치하지 않습니다. 깊이 값은 지면에 더 가깝고(이는 영상의 이미징 원리에 따라 제한되며, 20m 떨어진 한 픽셀이 나타내는 수직 거리는 30cm를 초과할 수 있음), 이후의 계획 프로세스에서 데이터를 사용하기 어렵습니다. 2) 딥 네트워크는 회귀 기반으로 구축되어 있어 가려짐을 통한 예측이 어렵기 때문에 경계에서는 예측이 어렵고, 차량에서 배경까지 원활하게 전환할 수 있습니다. Occupancy를 사용하면 다음과 같은 장점이 있습니다. Occupancy 장점 1) BEV 공간에서 균일한 복셀이 생성되며, 모든 복셀의 점유 확률을 예측할 수 있습니다 2) 모든 카메라의 비디오 스트림을 획득하여 통합합니다(LiDAR-카메라 융합 문제가 없으며 정보의 차원이 LiDAR보다 높음) 3) 상태 예측 가능 실시간으로 가려진 객체 (Occupancy의 역학 설명 능력은 3D에서 4D로의 전환입니다) 4) 각 복셀에 대해 해당 의미 범주를 생성할 수 있습니다 (이미지의 인식 능력은 LiDAR보다 훨씬 강력합니다) 카테고리가 인식되지 않아도 움직이는 물체 다루기 5) 각 복셀별로 동작 상태를 예측하고 임의의 동작을 모델링할 수 있습니다. 6) 각 위치의 해상도를 조정할 수 있습니다(즉, BEV 공간 줌 기능이 있습니다) 7) Tesla의 하드웨어 덕분에 Occupancy는 효율적인 저장 및 컴퓨팅 이점을 갖습니다 8) 계산은 10ms 이내에 완료될 수 있으며 처리 주파수는 매우 높을 수 있습니다(36Hz의 이미지 출력 기능은 이미 LiDAR 주파수 10Hz보다 강함) ) 경계 상자 인식 솔루션에 비해 Occupancy 솔루션의 장점은 다음과 같습니다. 고정된 경계 상자가 없는 알 수 없는 객체를 설명할 수 있고 마음대로 모양을 변경할 수 있으며 마음대로 움직일 수 있어 상자에서 복셀 세분성까지의 장애물 설명 세분성은 인식의 많은 롱테일 문제를 해결할 수 있습니다. Occupancy의 전반적인 솔루션을 살펴보겠습니다:

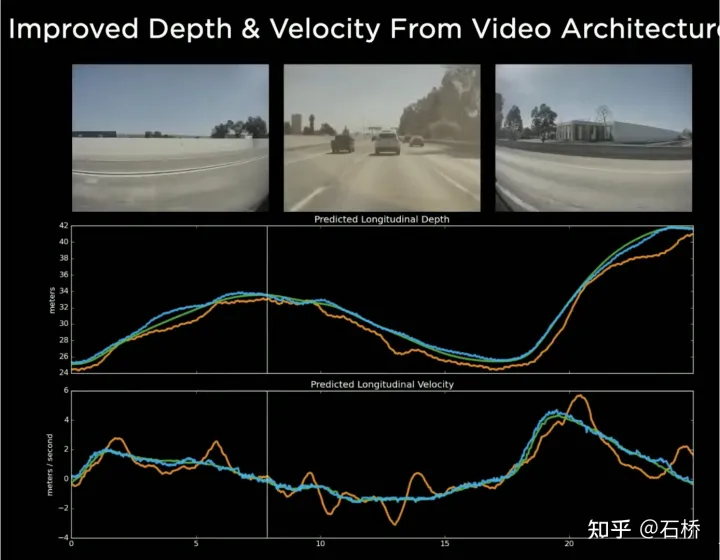

6. 비디오 신경망 아키텍처: 시공간 시퀀스 기능 구성

7. BEV는 2D에서 3D로 이동합니다

Occupancy Network

1) 이미지 입력: 원본 이미지 정보를 입력하여 데이터 차원 및 동적 범위를 확장합니다

2 ) Image Featurers: RegNet+BiFPN은 멀티 스케일 이미지 특징 추출

3) Spatial Atention: 3차원 공간 위치에 대한 공간 질의를 통한 2차원 이미지 특징의 Attention 기반 멀티 카메라 융합

구현 계획 1: 각 카메라의 내부 및 외부 매개변수에 따라 3D 공간 쿼리를 2D 특징 맵에 투영하여 해당 위치의 특징을 추출합니다.

구현 계획 2: 위치 임베딩을 사용하여 암시적 매핑을 수행합니다. 즉, 2D 기능 맵의 각 위치에 카메라 내부 및 외부 매개변수, 픽셀 좌표 등 합리적인 위치 임베딩을 추가한 다음 모델은 스스로 2D에서 3D로 학습합니다. 기능의 대응

4) 시간적 정렬: 궤적 정보를 사용하여 시간 순서에 따라 공간 채널 차원에서 각 프레임의 3D 점유 기능을 접합합니다. 결합된 기능은 해상도를 향상시키기 위해 Deconvolutions 모듈에 들어갑니다

5) 볼륨 출력: 고정 크기 래스터의 점유 및 점유 흐름을 출력합니다.

6) 쿼리 가능한 출력: 암시적 쿼리 가능한 MLP 디코더는 모든 좌표를 입력하도록 설계되었습니다. 더 높은 해상도의 연속 복셀 의미론, 점유율 및 점유 흐름 정보를 얻는 데 사용되는 값(x, y,z)을 사용하여 모델 해상도의 한계를 깨고

7) 3차원 기하학 및 의미론으로 주행 가능 영역 포장을 생성합니다. 경사지와 곡선 도로에서의 제어에 도움이 됩니다.

지면은 점유와 일치합니다

8) NeRF 상태: nerf는 장면의 기하학적 구조를 구축하고 어떤 관점에서든 이미지를 생성할 수 있으며 고해상도의 실제 장면을 복원할 수 있습니다.

너프로 업그레이드하거나 교체할 수 있다면 실제 장면을 복원하는 능력을 가지게 되는데, 이 장면 복원 능력은 과거-현재-미래가 될 것입니다. 이는 Tesla의 기술 솔루션이 추구하는 4D 장면 자율 주행을 크게 보완하고 개선하는 것이 될 것입니다.

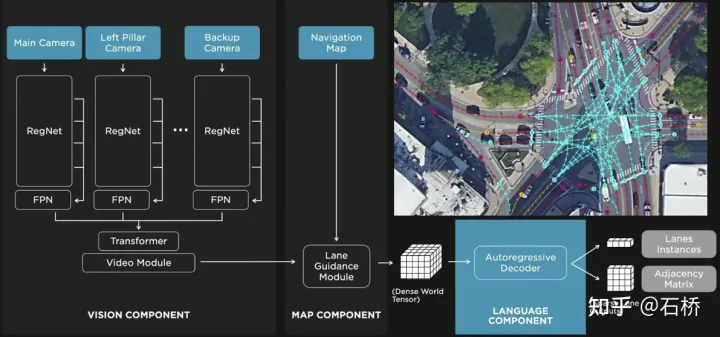

차선 선을 분할하고 식별하는 것만으로는 충분하지 않으며 차선 간의 위상적 연결 관계를 추론하는 것도 필요합니다. 궤도 계획에 사용됩니다.

FSD 레인 라인 토폴로지 관계 인식

1) 차선 안내 모듈: 내비게이션 지도에서 도로의 기하학적 및 위상학적 관계, 차선 수준, 수량, 너비, 속성 정보를 사용하고 이러한 정보를 Occupancy 기능과 통합하여 Dense World Tensor를 인코딩 및 생성하여 위상학적 정보를 설정합니다. 관계 모듈은 시퀀스 생성 패러다임을 통해 비디오 스트림의 조밀한 특징을 희박한 도로 토폴로지 정보(차선 노드 세그먼트 및 인접한 연결 관계)로 구문 분석합니다.

2) 언어 구성요소: 차선 노드 위치, 속성(시작점, 중간점, 끝점 등), 분기점, 집결점, 차선 스플라인 기하학적 매개변수 등 차선 관련 정보를 인코딩하여 유사한 언어를 만듭니다. 모델의 단어 토큰은 인코딩된 후 타이밍 처리 방법을 사용하여 처리됩니다. 구체적인 프로세스는 다음과 같습니다.

lane of Lanes process

lane of Lanes

최종적인 레인 언어는 그래프에서 위상적 연결 관계를 나타냅니다.

장애물 인식 및 예측

FSD의 객체 인식은 첫 번째 단계가 위치로 시작됩니다. 두 번째 단계에서는 이러한 3D 객체의 텐서를 연결하여 일부 운동학적 정보(자체 차량 움직임, 목표 주행 차선, 신호등, 교통 신호 등)를 인코딩합니다. .) 그런 다음 연결 궤적 예측, 객체 모델링, 보행자 자세 예측 및 기타 헤드를 입력합니다. 제한된 ROI 영역에 복잡한 감지 헤드를 집중시키면 처리 지연이 줄어듭니다. 위 그림에서 볼 수 있듯이 비디오 모듈에는 두 단계가 있는데, 이는 각각 자기 차량과 다른 차량을 예측하는 역할을 합니다.

여기에 질문을 남겨주세요. 위 사진에 있는 두 비디오 모듈의 차이점은 무엇인가요? 효율성에는 문제가 없을까요?

교차로에서 비보호 좌회전에 대한 의사결정 시나리오

위 시나리오에서 의사 결정 및 계획의 어려움은 다음과 같습니다.

자율 차량이 교차로 장면을 통해 보호되지 않은 좌회전을 수행할 때 보행자 및 일반 직진 차량과 상호 작용하고 상호 관계를 이해해야 합니다. 여러 당사자 사이.

전자와의 상호작용 결정은 후자와의 상호작용 전략에 직접적인 영향을 미칩니다. 여기서 선택한 최종 해결책은 다른 교통 참가자의 이동을 방해하지 않도록 노력하는 것입니다.

결정 계획 프로세스

Tesla는 일련의 "상호 작용" "검색"을 사용합니다. 가능한 모션 궤적은 다음과 같습니다. 병렬적으로 검색되며, 해당 상태공간에는 자차, 장애물, 주행 가능 영역, 차선, 신호등 등이 포함됩니다. 솔루션 공간은 다른 트래픽과 상호작용적인 의사결정에 참여한 후 분기되는 일련의 목표 모션 후보 궤적을 사용하고, 이후 점진적인 의사결정 및 계획을 진행하여 최종적으로 최적의 궤적을 선택하는 과정을 보여줍니다. 위 그림:

1) 도로 토폴로지 또는 인간의 운전 데이터를 기반으로 선험적으로 목표 지점 또는 확률 분포(빅 데이터 궤적)를 얻습니다.

2) 목표 지점을 기반으로 후보 궤적을 생성합니다(최적화 알고리즘) + 신경망)

3) 후보 궤적을 따라 롤아웃 및 대화형 의사 결정, 경로 재계획, 각 경로의 위험 및 점수 평가, 가장 좋은 경로의 우선 순위를 지정하여 목표 지점 파악

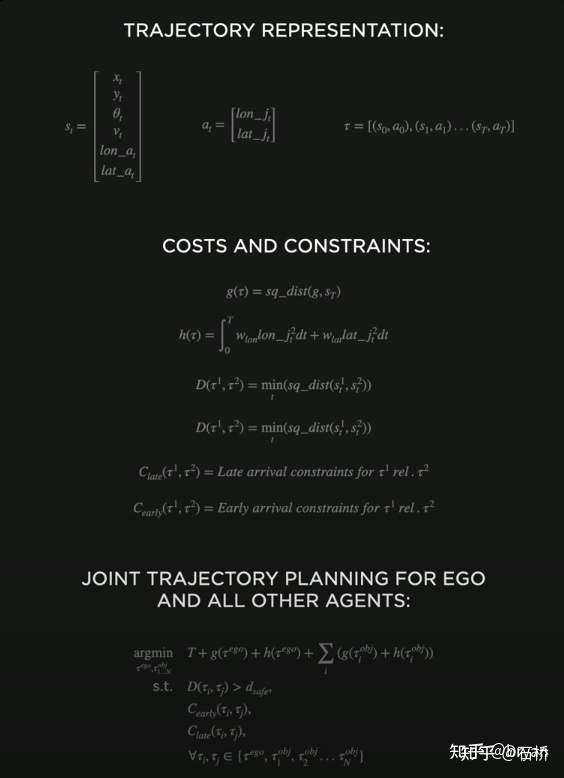

The 전체 의사결정 계획의 최적화 표현:

의사결정 계획의 최적화 표현

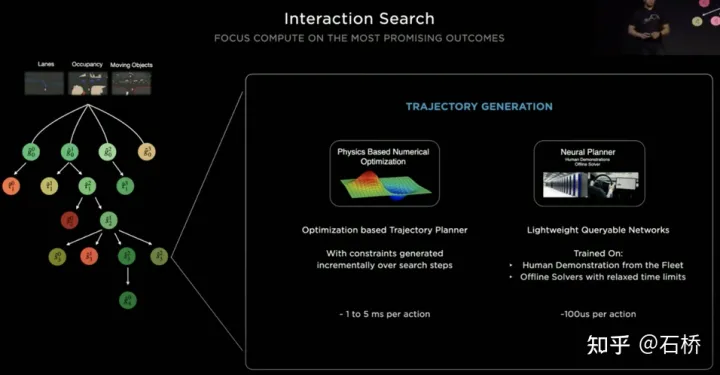

경량 계획 궤적 쿼리 네트워크

Tesla는 증분 방식을 사용하여 지속적으로 추가합니다. 새로운 의사 결정 제약 조건을 결정하고 더 적은 제약 조건에서 최적의 솔루션을 초기 값으로 사용하여 계속해서 더 많은 문제를 해결합니다. 복잡한 최적화 문제는 궁극적으로 최적의 솔루션을 생성합니다. 그러나 가능한 분기가 많기 때문에 전체 의사 결정 및 계획 프로세스는 매우 효율적이어야 합니다. 전통적인 최적화 알고리즘을 기반으로 하는 플래너를 사용하는 각 의사 결정 계획은 1~5ms가 소요되며, 이는 분명히 충분히 안전하지 않습니다. 고밀도 교통 참가자입니다. Tesla에서 사용하는 Neural Planner는 Tesla 차량에 탑승한 인간 운전자의 주행 데이터와 시간 제약 없이 오프라인 조건에서 계획된 전역 최적 경로의 실제 값을 사용하여 쿼리 계획 궤적을 학습합니다. 계획하는 데에는 100us밖에 걸리지 않습니다.

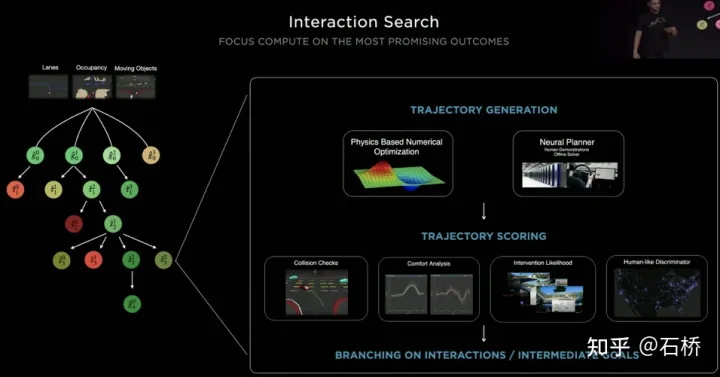

계획 결정 평가

각 결정 후에 쿼리되는 여러 후보 궤적을 평가해야 하며 평가는 충돌 검사, 편안함 분석, 인수 가능성 및 인간 상호 작용과 같은 사양을 기반으로 합니다. 유사도 등은 전체 의사결정 트리가 너무 커지지 않도록 검색 분기를 잘라내는 데 도움이 되며, 동시에 가장 가능성이 높은 분기에 컴퓨팅 성능을 집중할 수도 있습니다. Tesla는 이 솔루션이 계획 과정에서 가려진 물체의 움직임 상태를 고려하고 "유령"을 추가하는 방식으로 계획이 수행될 것이라고 강조했습니다.

유령 폐색 장면

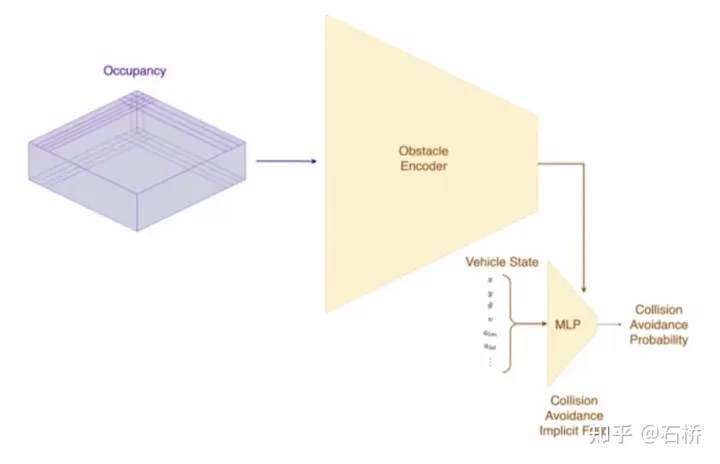

CVPR은 또한 충돌 방지를 위한 네트워크 프로세스와 해당 계획 프로세스를 공유했지만 자세한 내용은 다루지 않습니다.

충돌 방지 네트워크

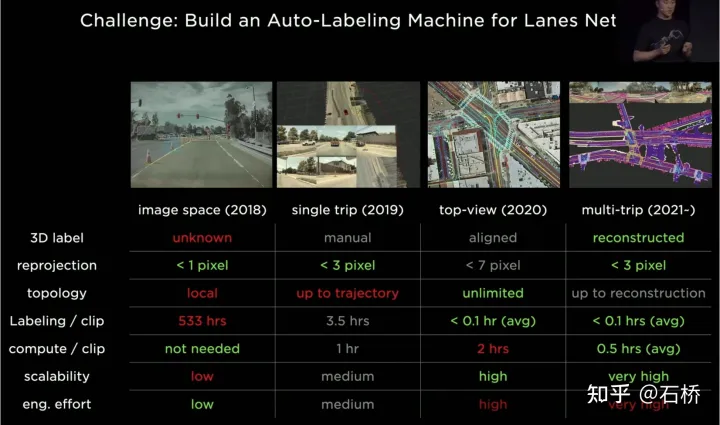

Tesla의 강력한 인식 능력에는 강력한 라벨링 기능이 필요합니다. 이를 지원하기 위해 Tesla는 라벨링은 2018년부터 현재까지 4단계를 거쳤습니다:

Tesla의 라벨링 반복

1단계(2018): 순수 인공 2D만 이미지 주석의 효율성이 매우 낮습니다

위상 2(2019): 3D 라벨이 시작되지만 단일 수동 프로세스입니다

3단계(2020): BEV 공간을 라벨링 및 재투영에 사용합니다. 정확도가 크게 감소합니다

4단계(2021): 주석에는 다중 재구성이 사용되며 정확성, 효율성 및 위상 관계가 매우 높은 수준에 도달했습니다

Tesla의 자동 주석 시스템은 500만 시간의 수동 작업을 대체할 수 있으며 수동 검사 및 누출 수정의 아주 작은 부분만 대체할 수 있습니다(

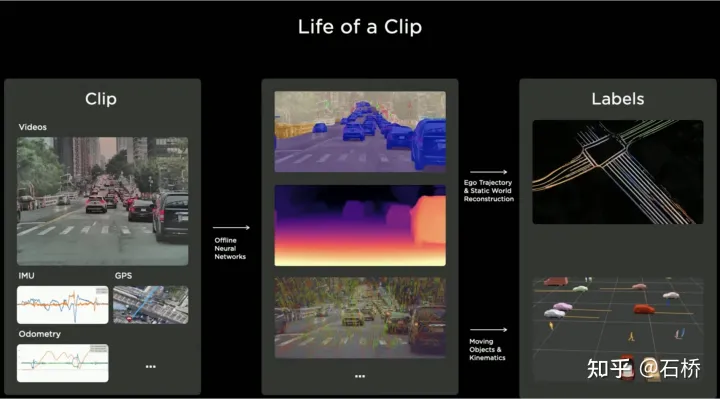

이 다중 이동 궤적 재구성 솔루션의 프로세스는 다음과 같습니다. (오프라인 시맨틱 슬램 시스템과 유사)

자동 라벨링 시스템

1단계: VIO는 고정밀 궤적을 생성합니다. 비디오 스트림, IMU 및 주행 거리 측정을 신경망에 공급하고 점, 선, 지면 및 분할 기능을 추론 및 추출한 다음 BEV 공간에서 추적 및 최적화를 위해 멀티 카메라 VIO를 사용하여 100Hz 6dof 궤적 및 3dof 구조를 출력합니다. 및 도로, 카메라의 보정 값을 출력할 수도 있습니다. 재구성된 궤적의 정확도는 1.3cm/m, 0.45rad/m으로 그리 높지 않습니다. 모든 FSD는 이 프로세스를 실행하여 특정 여행의 전처리된 궤적 및 구조 정보를 얻을 수 있습니다. (동영상을 보면 vio가 점 특징만 명시적으로 사용하고 선 및 표면 특징을 암시적으로 사용할 수 있다는 느낌이 듭니다.)

다중 통과 궤적 재구성

2단계: 다중 통과 궤적 재건축. 서로 다른 차량에서 재구성된 여러 데이터를 그룹화하여 대략적인 정렬 -> 기능 매칭 -> 조인트 최적화 -> 노면 개선을 수행한 다음 수동 개입을 수행하여 최종적으로 라벨링 결과를 확인하고 확인합니다. 여기서도 조인트 최적화 후에 노면 최적화를 수행했는데, 이는 시각적 재구성의 오차가 상대적으로 큰 것으로 추측되는데, 전역 최적화 이후에는 이 부분의 오차를 없애기 위해 계층적 중첩 문제가 있는 것으로 추측된다. 글로벌 최적화 잘못된 할당, 노면 최적화가 추가되었습니다. 알고리즘 논리 관점에서 보면 전역 최적화와 그에 따른 로컬 최적화가 필수입니다. 자율주행의 요건은 어디든 주행할 수 있어야 하기 때문입니다. 전체 프로세스는 클러스터에서 병렬화됩니다.

대략 정렬

3단계: 새 궤적 데이터에 자동으로 레이블을 지정합니다. 사전 구축된 지도에서는 새로운 주행 궤적 데이터에 대해 다중 궤적 재구성과 동일한 재구성 프로세스가 수행되므로 정렬된 새 궤적 데이터가 사전 구축된 지도에서 자동으로 의미 주석을 얻을 수 있습니다. 이는 실제로 의미 태그를 얻기 위해 재배치하는 과정입니다. 이 자동 라벨 지정은 실제로 차선, 도로 경계 등과 같은 정적 객체에만 자동으로 라벨을 지정할 수 있습니다. 인식 모델을 통해 차선과 같은 의미적 범주를 실제로 얻을 수 있지만, 가혹한 시나리오에서는 이러한 문제를 자동 주석을 통해 해결할 수 있습니다. 그러나 움직이는 차량, 보행자 등 동적 장애물에는 적합하지 않을 수 있다는 단점이 있다. 다음은 사용 시나리오입니다.

자동으로 사용 시나리오 라벨 지정

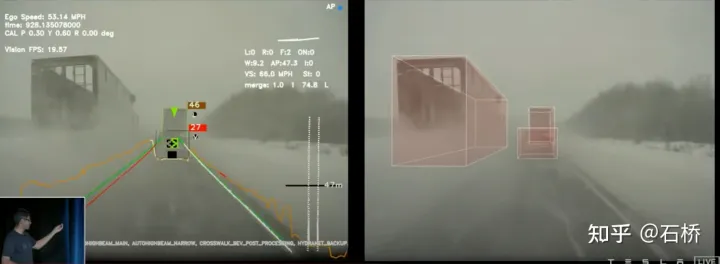

Tesla가 표시하는 많은 이미지에는 한 가지 특징이 있습니다. 흐릿하거나 얼룩이 가린 부분이 있지만 인지된 결과에는 심각한 영향을 미치지 않습니다. . 일반적인 사용 시 차량의 카메라 렌즈는 쉽게 더러워질 수 있지만, 이번 자동 라벨링을 통해 Tesla의 인식은 매우 견고해지고 카메라 유지 비용도 절감될 것입니다.

동적 차량에는 자동 라벨링이 적합하지 않습니다

2021년 AI Day를 되돌아보면 위의 재구성이 차선과 차선뿐만 아니라 정적인 세계를 구축한다는 것을 알 수 있습니다. 차선뿐만 아니라 차량과 건물도 마찬가지입니다.

3D 재구성

정적 세계를 재구성하고 주석을 달기

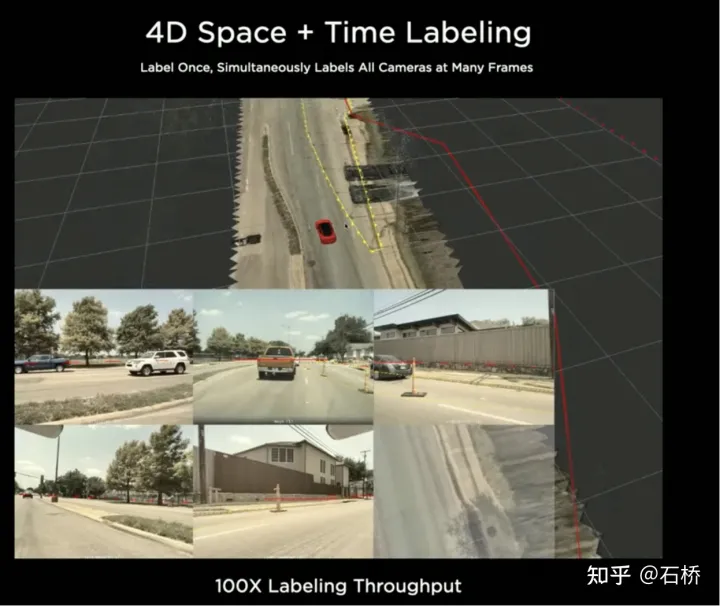

4D 공간 주석

BEV 공간을 표시한 후, 주석은 여러 카메라의 이미지로 다시 매핑되므로 4D 공간에서 일회성 주석을 2D 다중 프레임에 적용할 수 있습니다.

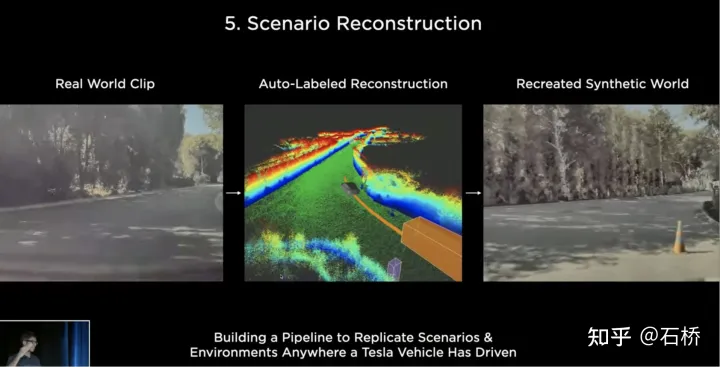

장면 재구성과 관련하여 현재 재구성 기능과 정확성은 여전히 Tesla 엔지니어의 기대에 미치지 못할 수 있습니다. 그들의 궁극적인 목표는 Tesla 자동차가 주행한 모든 장면을 진정으로 복원하고 재구성하여 이러한 조건을 진정으로 바꿀 수 있는 것입니다. 장면은 궁극적인 목표인 새로운 실제 장면을 생성합니다.

Restore the real world

Rebuild the real world

장면 시뮬레이션

시뮬레이션을 통해 완전히 정확한 라벨을 얻을 수 있습니다

재구성을 기반으로 구축된 실제 장면은 데이터, 알고리즘 등에 의해 제한됩니다. 현재 대규모 구현이 어렵고 시간이 오래 걸립니다. 예를 들어 위 사진의 실제 교차로를 시뮬레이션하는 데는 2주가 걸립니다. . 그러나 자율주행의 구현은 다양한 시나리오에서의 훈련과 테스트에 의존하므로 Tesla는 자율주행 시나리오를 시뮬레이션하기 위한 시뮬레이션 시스템을 구축했습니다. 이 시스템은 실제 시나리오를 실제로 시뮬레이션할 수는 없지만 위에서 언급한 일반적인 재구성 솔루션보다 1,000배 빠르다는 장점이 있습니다. 실제로 획득하거나 라벨링하기 어려운 데이터를 제공할 수 있으며 여전히 자율주행차에 매우 의미가 있습니다. 운전 훈련.

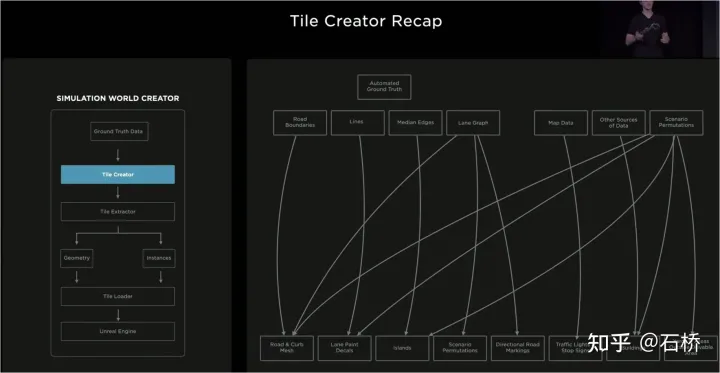

시뮬레이션 구성 아키텍처

이 에뮬레이터의 아키텍처는 위에 표시된 것과 같습니다. 장면 생성 프로세스 중에 다음 단계가 필요합니다.

1단계: 시뮬레이션 세계에서 롤아웃합니다. 도로의 경우 경계 레이블을 사용하여 엔터티 도로 메시를 생성하고 이를 도로 토폴로지 관계와 다시 연결합니다.

2단계: 도로의 차선과 기하학적 설명 요소를 차선 세그먼트에 투영하여 차선 세부정보를 구성합니다.

3단계: 도로의 중간 경계 영역에 중앙 차선 분리 영역을 생성하고 무작위로 식물과 교통 표지판을 생성하여 이를 채웁니다. 무작위 휴리스틱 방법을 사용하여 일련의 건물, 나무, 교통 표지판을 생성합니다. , 등 도로 경계 밖에서

4단계: 지도에서 신호등이나 정지 표지판의 위치를 파악하고 차선 수, 도로 이름 등도 얻습니다.

5단계: 차선을 사용합니다. 지도를 사용하여 차선의 위상 관계를 파악하고 주행 방향(좌회전 및 우회전 표시) 및 보조 마커를 생성합니다.

6단계: 차선 지도 자체를 사용하여 차선 인접 관계 및 기타 유용한 정보를 결정합니다.

7단계 : 차선 관계를 기반으로 임의의 교통 조합 생성

위 과정에서 일련의 차선 내비게이션을 기반으로 지도의 실제 값은 시뮬레이션 매개변수를 수정하여 변화를 생성하고 다양한 조합 시나리오를 생성할 수 있습니다. 또한 훈련의 필요에 따라 실제 가치의 일부 속성을 수정하여 훈련 목적을 달성하기 위한 새로운 시나리오를 만들 수도 있습니다.

데이터는 Tile 저장소로 나누어져 있습니다

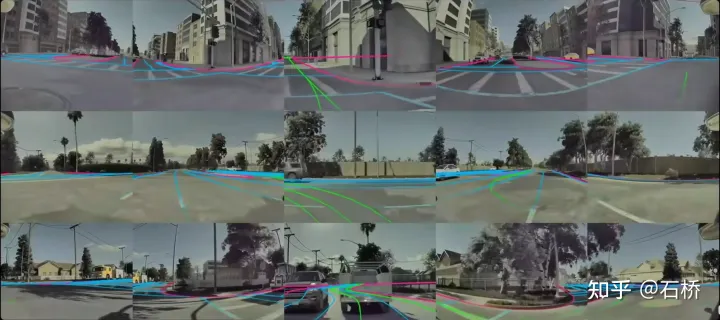

Tile 세분화를 기반으로 구축된 세계

위에서 구축한 시뮬레이션은 실제 도로 정보를 기반으로 하기 때문에 내용이 많습니다. 실제 문제는 시뮬레이션을 통해 해결할 수 있습니다. 예를 들어, 시뮬레이션된 로스앤젤레스 도로 환경에서 자율 주행 기능을 테스트할 수 있습니다. (위의 저장방식은 시뮬레이션 매핑, 저장, 로딩에 사용됩니다.)

시뮬레이션 시나리오에서의 자율주행

느낌: 자율주행에는 어떤 지도정보를 사용할 수 없는지 대신 일부 이 시뮬레이션 빌드 프로세스에서 답을 찾을 수 있습니다.

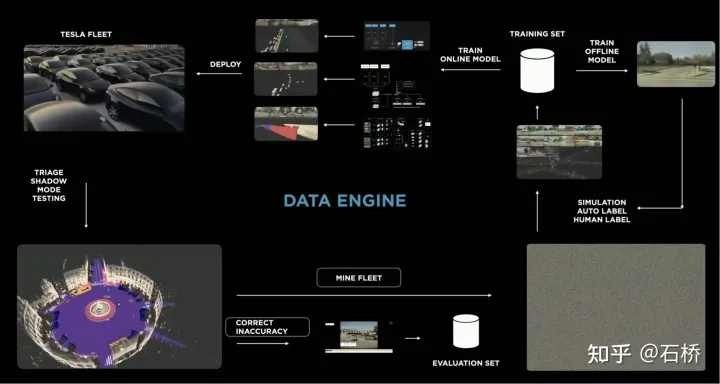

데이터 폐쇄 루프 프로세스

데이터 엔진은 섀도우 모드에서 모델이 잘못 판단한 데이터를 마이닝하고 이를 호출하여 자동을 사용합니다. 라벨링 도구 라벨 수정을 수행한 다음 이를 훈련 및 테스트 세트에 추가하여 네트워크를 지속적으로 최적화합니다. 이 프로세스는 데이터 폐쇄 루프의 핵심 노드이며 계속해서 코너 케이스 샘플 데이터를 생성합니다.

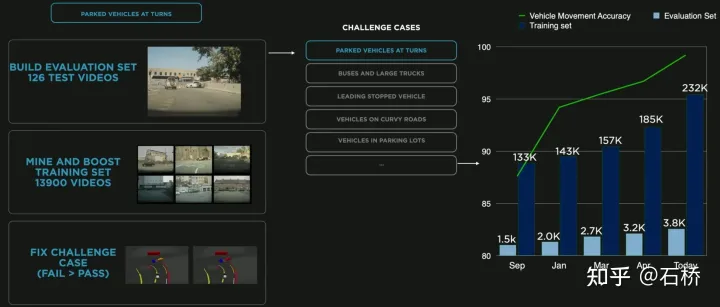

곡선주차를 위한 데이터마이닝

위 그림은 곡선주차를 위한 데이터마이닝을 통해 모델을 개선한 사례로, 학습에 데이터가 지속적으로 추가되면서 정확도 지수가 지속적으로 향상됩니다.

위 내용은 Tesla의 자율주행 기술 솔루션에 대한 심층 분석의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!