순수 텍스트 대형 모델이 부상하고 있으며, 멀티모달 분야에서 멀티모달 대형 모델 작업이 등장하기 시작했습니다. 표면적으로 가장 강력한 GPT-4는 이미지를 읽을 수 있는 멀티모달 기능을 갖추고 있지만 아직 공개되지 않았습니다. 대중은 경험을 위해 연구하므로 연구가 없습니다. 커뮤니티는 이러한 방향으로 연구하고 소스를 오픈하기 시작했습니다. MiniGPT-4 및 LLaVA가 등장한 직후 Alibaba DAMO Academy는 모듈식 구현을 기반으로 하는 대규모 다중 모드 모델인 mPLUG-Owl을 출시했습니다.

mPLUG-Owl은 Alibaba Damo Academy의 mPLUG 시리즈 최신작입니다. mPLUG 시리즈의 모듈식 교육 아이디어를 이어가고 LLM을 대규모 다중 모드 모델로 업그레이드합니다. mPLUG 시리즈 작업에서는 이전 E2E-VLP, mPLUG 및 mPLUG-2가 각각 ACL2021, EMNLP2022 및 ICML2023에 의해 승인되었습니다. 그중 mPLUG 작업은 초인적인 결과로 VQA 목록에서 1위를 차지했습니다.

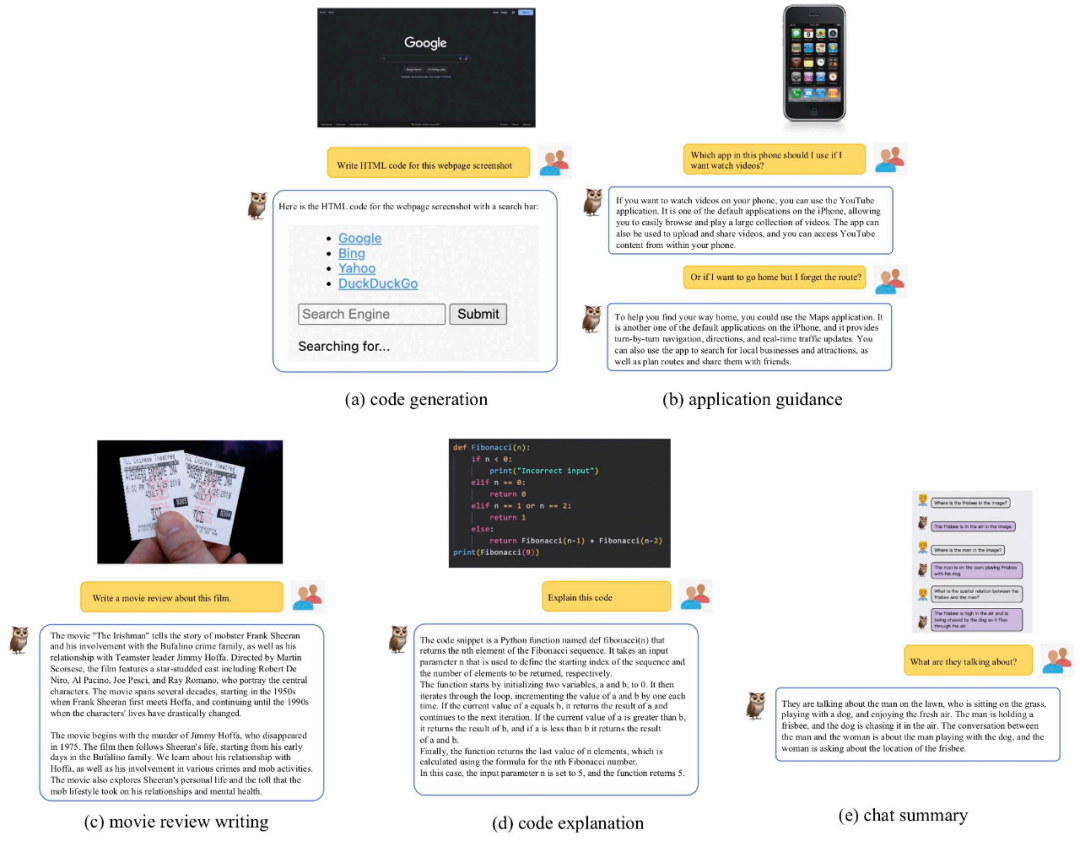

오늘 우리는 mPLUG-Owl을 소개하겠습니다. 이 작품은 수많은 사례를 통해 뛰어난 다중 모달 기능을 보여줄 뿐만 아니라 시각적 관련 명령 이해를 위한 종합 테스트 세트 OwlEval을 최초로 제안합니다. 수동 평가를 통해 LLaVA, MiniGPT-4, BLIP-2 및 시스템 기반 MM-REACT를 포함한 기존 모델을 통합함으로써 실험 결과는 mPLUG-Owl이 특히 다중 모드 명령 이해 기능과 다중 모드 명령 이해 능력. 순차 대화 능력 및 지식 추론 능력

논문 링크: https://arxiv.org/abs/2304.14178

코드 링크: https:/ / github.com/ HuggingFace 체험 주소:

https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

멀티모달 기능 시연비교해보겠습니다 mPLUG-Owl with 기존 작업 mPLUG-Owl의 다중 모달 효과를 느끼기 위해 이 작업에서 평가된 테스트 샘플은 기본적으로 기존 작업에서 나온 것이며 체리 픽 문제를 피한다는 점을 언급할 가치가 있습니다.

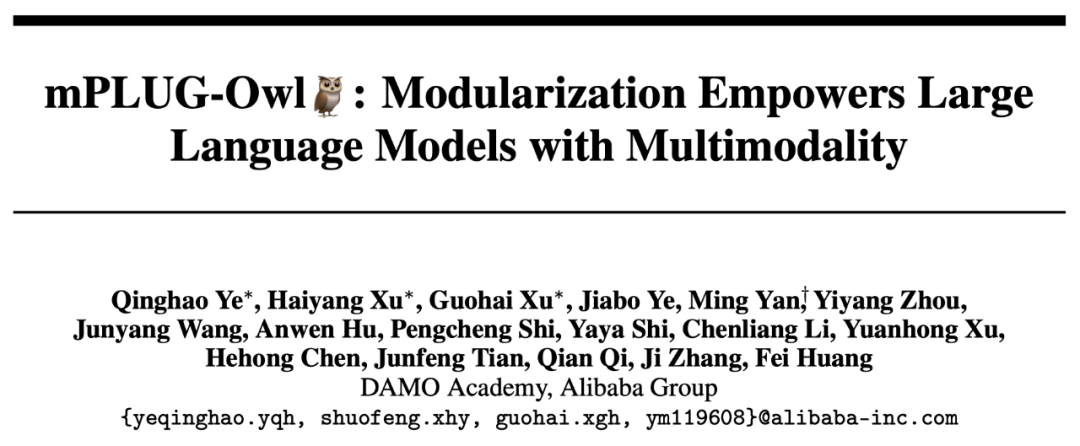

아래 그림 6은 mPLUG-Owl의 강력한 다단계 대화 기능을 보여줍니다.

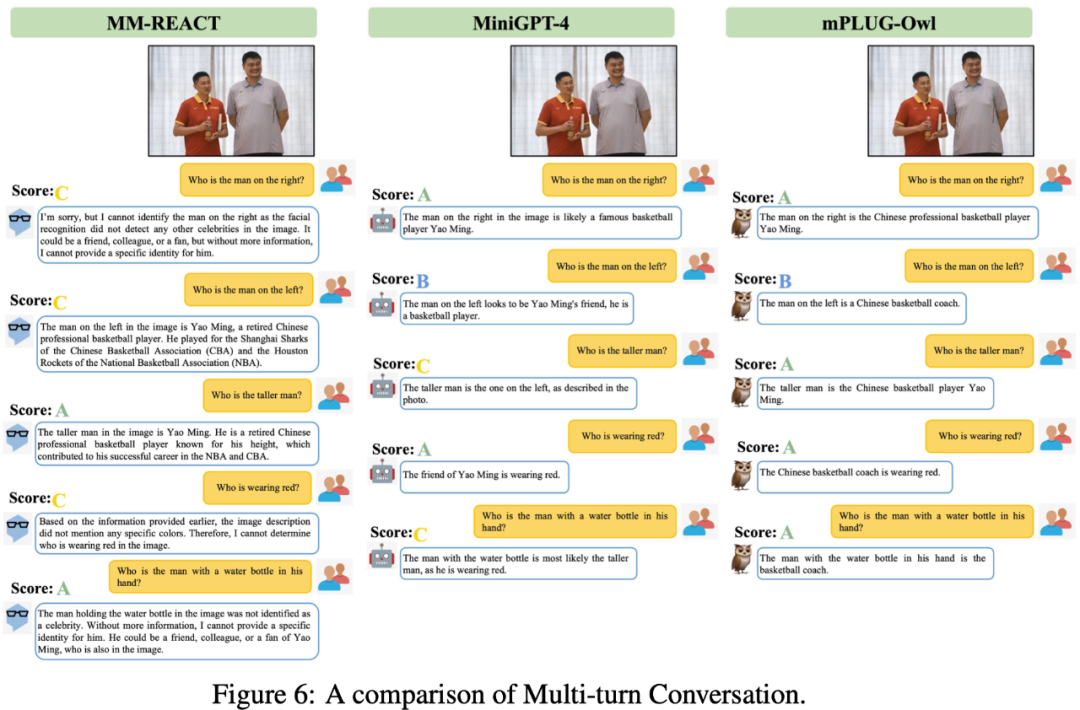

그림 7에서 mPLUG-Owl이 강력한 추론 능력을 가지고 있음을 알 수 있습니다.

그림 9는 농담 설명의 몇 가지 예를 보여줍니다.

이 연구에서 연구팀은 평가 및 비교 외에도 mPLUG-Owl이 처음에 다중 이미지 연관, 다중 언어, 텍스트 인식 및 문서 이해 및 기타 능력.

그림 10에 표시된 것처럼 다중 그래프 상관 데이터는 훈련 단계에서 훈련되지 않지만 mPLUG-Owl은 특정 다중 그래프 상관 기능을 보여주었습니다.

그림 10에 표시된 것처럼 다중 그래프 상관 데이터는 훈련 단계에서 훈련되지 않지만 mPLUG-Owl은 특정 다중 그래프 상관 기능을 보여주었습니다.

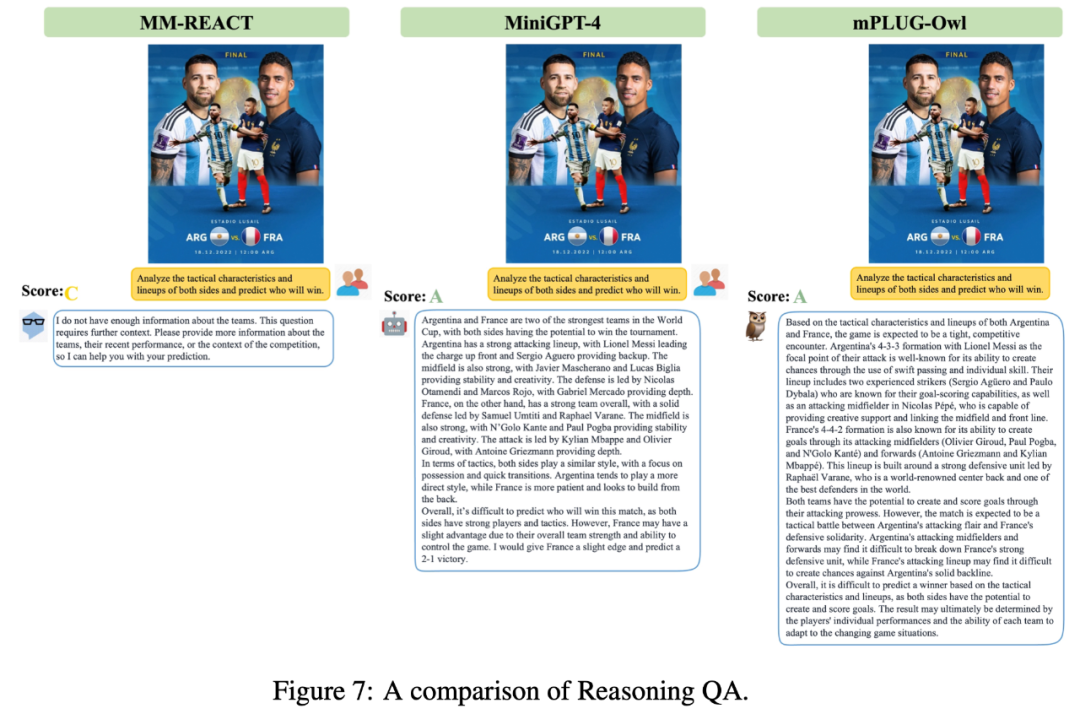

그림 11에서 볼 수 있듯이 mPLUG-Owl은 훈련 단계에서 영어 데이터만 사용하지만 흥미로운 다국어 기능을 보여줍니다. 이는 mPLUG-Owl의 언어 모델이 LLaMA를 사용하기 때문에 이러한 현상이 발생하는 것일 수 있습니다.

그림 11에서 볼 수 있듯이 mPLUG-Owl은 훈련 단계에서 영어 데이터만 사용하지만 흥미로운 다국어 기능을 보여줍니다. 이는 mPLUG-Owl의 언어 모델이 LLaMA를 사용하기 때문에 이러한 현상이 발생하는 것일 수 있습니다.

mPLUG-Owl은 주석이 달린 문서 데이터에 대해 교육을 받지 않았지만 여전히 특정 텍스트 인식 및 문서 이해 기능을 보여주었습니다. 테스트 결과는 그림 12에 나와 있습니다.

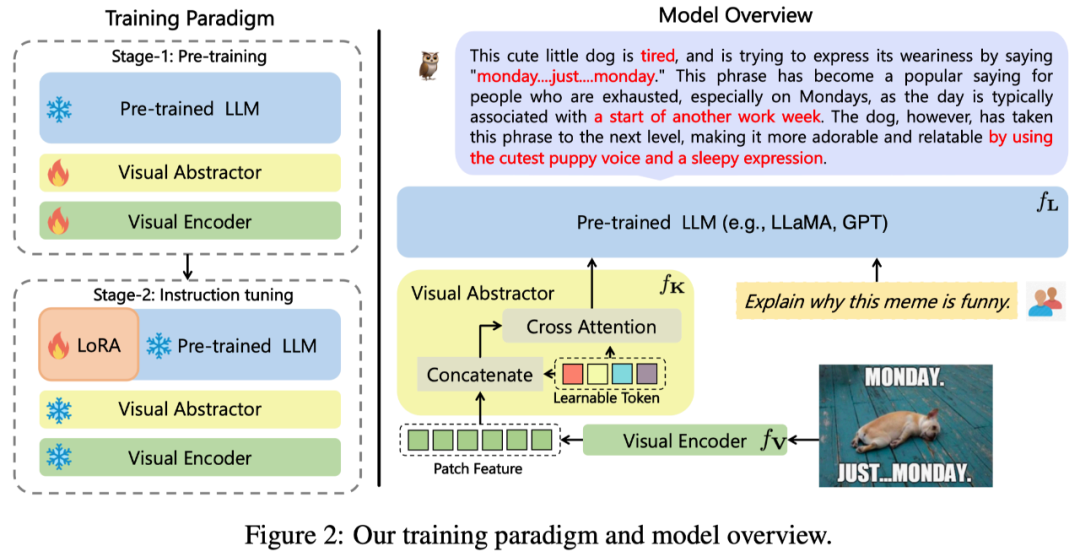

본 연구에서 제안하는 mPLUG-Owl의 전체 아키텍처는 그림 2와 같습니다.

모델 구조: 시각적 기본 모듈

(오픈 소스 ViT-L), 시각적 추상화 모듈

및 pre로 구성됩니다. -훈련 언어 ⾔ 모델

(LLaMA-7B) 구성. 시각적 추상화 모듈은 더 길고 세분화된 이미지 특징을 소수의 학습 가능한 토큰으로 요약하여 시각적 정보의 효율적인 모델링을 달성합니다. 생성된 시각적 토큰은 텍스트 쿼리와 함께 언어 모델에 입력되어 해당 응답을 생성합니다.

모델 훈련: 2단계 훈련 방법이 채택되었습니다.

첫 번째 단계: 또한 주요 목적은 시각적 양식과 언어적 양식 사이의 관계를 먼저 배우는 것입니다. 이전 작업과 달리 mPLUG-Owl은 기본 시각적 모듈을 동결하면 시각적 지식과 텍스트 지식을 연관시키는 모델의 능력이 제한될 것이라고 제안합니다. 따라서 mPLUG-Owl은 첫 번째 단계에서 LLM의 매개변수만 동결하고 LAION-400M, COYO-700M, CC 및 MSCOCO를 사용하여 Visual Basic 모듈과 Visual Summary 모듈을 교육합니다.

두 번째 단계: mPLUG와 mPLUG-2의 서로 다른 양식의 혼합 훈련이 서로 유익하다는 발견을 계속하면서 Owl은 두 번째 단계의 명령 미세 조정 훈련에서 일반 텍스트 명령 데이터(Alpaca+의 52k)도 사용합니다. . Vicuna의 90k + Baize의 50k) 및 다중 모드 명령 데이터(LLaVA의 150k). 저자는 상세한 절제 실험을 통해 명령어 이해와 같은 측면에서 순수 텍스트 명령어 미세 조정 도입이 가져오는 이점을 검증했습니다. 두 번째 단계에서는 시각적 기본 모듈, 시각적 요약 모듈 및 원본 LLM의 매개 변수가 고정되어 있으며 LoRA를 참조하면 명령어 미세 조정을 위해 적은 수의 매개 변수가 있는 어댑터 구조만 LLM에 도입됩니다.

SOTA 비교

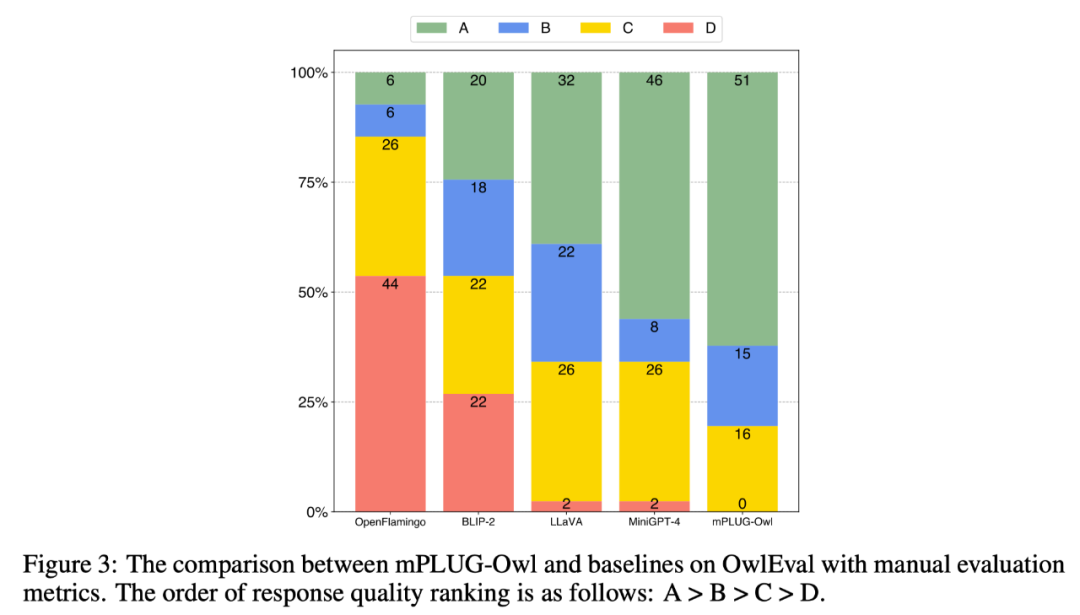

다양한 모델의 다중 모드 기능을 비교하기 위해 이 작업에서는 다중 모드 명령 평가 세트 OwlEval을 구축합니다. 현재 적합한 자동 지표가 없으므로 모델 응답의 수동 평가는 Self-Intruct를 참조하세요. 채점 규칙은 다음과 같습니다. A="정확하고 만족스럽습니다"; B="일부 불완전하지만 허용 가능"; 지시를 받았으나 응답에 명백한 오류가 있었습니다."; D="완전히 관련이 없거나 잘못된 응답입니다."

비교 결과는 아래 그림 3과 같습니다. 실험 결과 Owl이 기존 OpenFlamingo, BLIP-2, LLaVA, MiniGPT-4보다 시각적 관련 명령 응답 작업에서 더 우수하다는 것이 입증되었습니다.

다차원적 능력비교

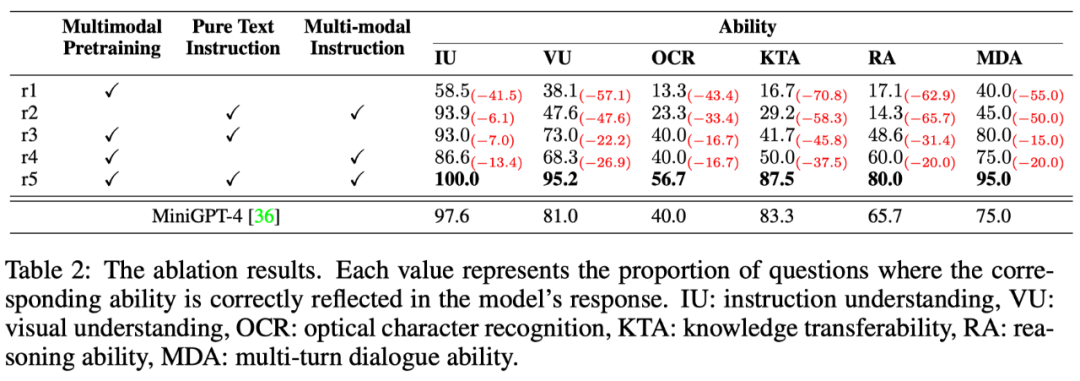

다중 명령 응답 작업에는 명령 이해, 시각적 이해, 그림의 텍스트 이해, 추론과 같은 여러 능력이 포함됩니다. 세부적인 방식으로 모델의 다양한 기능 수준을 탐색하기 위해 이 기사에서는 다중 모달 시나리오의 6가지 주요 기능을 추가로 정의하고 관련 기능 요구 사항과 응답에 반영된 OwlEval의 각 테스트 명령에 수동으로 주석을 추가합니다. 모델은 어떤 능력을 습득했는지.

결과는 아래 표 6과 같습니다. 실험의 이 부분에서 저자는 훈련 전략 및 다중 모드 명령 미세 조정 데이터의 유효성을 검증하기 위해 Owl ablation 실험을 수행했을 뿐만 아니라, 이전 실험에서 가장 좋은 성능을 보였습니다. Baseline—MiniGPT4를 비교한 결과 모든 기능 측면에서 Owl이 MiniGPT4보다 나은 것으로 나타났습니다.

위 내용은 DAMO 아카데미의 mPLUG-Owl 데뷔: GPT-4 다중 모드 기능을 따라잡는 모듈식 다중 모드 대형 모델의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!