OpenAI의 ChatGPT는 다양한 인간 지시를 이해하고 다양한 언어 작업을 잘 수행할 수 있습니다. 이는 RLHF(Aligned Human Feedback via Reinforcement Learning)라는 새로운 대규모 언어 모델 미세 조정 방법 덕분에 가능합니다.

RLHF 방법은 인간의 지시를 따르는 언어 모델의 능력을 잠금 해제하여 인간의 요구와 가치에 일치하는 언어 모델의 능력을 만듭니다.

현재 RLHF의 연구 작업은 주로 PPO 알고리즘을 사용하여 언어 모델을 최적화합니다. 그러나 PPO 알고리즘에는 많은 하이퍼파라미터가 포함되어 있으며 알고리즘 반복 프로세스 중에 서로 협력하기 위해 여러 개의 독립 모델이 필요하므로 구현 세부 사항이 잘못되면 학습 결과가 좋지 않을 수 있습니다.

동시에강화 학습 알고리즘은 인간 정렬 관점에서 필요하지 않습니다.

논문 주소: https://arxiv.org/abs/2304.05302v1

프로젝트 주소: https://github.com/GanjinZero/RRHF

이를 위해 알리바바 다모 아카데미와 칭화대학교의 저자들은 순위 기반 인간 선호 정렬(RRHF)이라는 방법을 제안했습니다.

RRHF강화 학습이 필요하지 않으며 ChatGPT, GPT-4 또는 현재 교육 모델을 포함한 다양한 언어 모델에서 생성된 응답을 활용할 수 있습니다.RRHF는 응답에 점수를 매기고 순위 손실을 통해 응답을 인간의 선호도에 맞추는 방식으로 작동합니다.

PPO와 달리 RRHF의 교육 과정에서는 인간 전문가 또는 GPT-4의 결과를 비교로 사용할 수 있습니다. 훈련된 RRHF 모델은 생성 언어 모델과 보상 모델 모두로 사용될 수 있습니다.

플레이그라운드 AI 대표님이 최근 논문 중 가장 흥미롭다고 하더군요

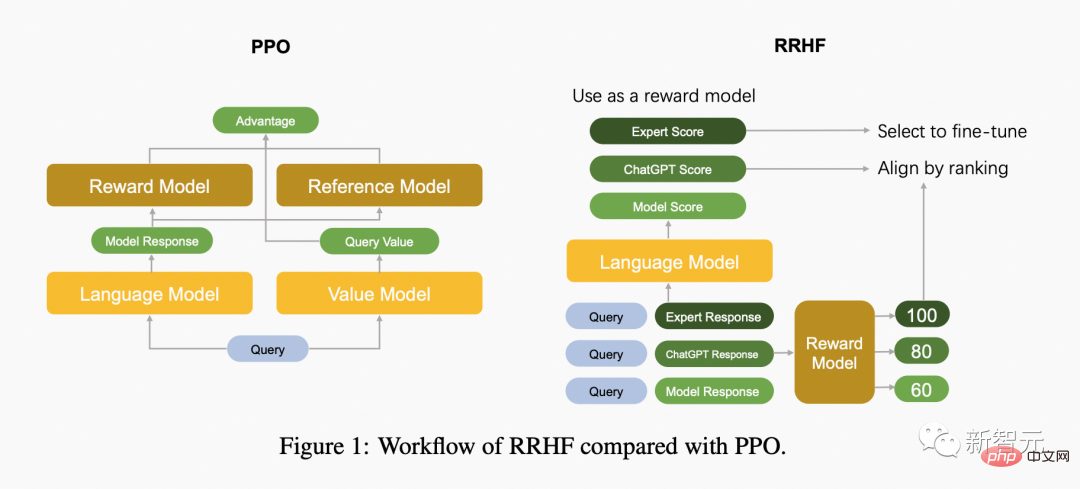

다음 그림은 PPO 알고리즘과 RRHF 알고리즘의 차이점을 비교한 것입니다.

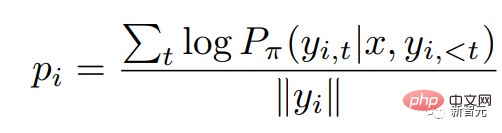

RRHF는 먼저 입력 쿼리에 대해 다양한 방법을 통해 k개의 응답을 얻은 다음 보상 모델을 사용하여 이 k개의 응답에 각각 점수를 매깁니다. 각 응답은 로그 확률을 사용하여 점수가 매겨집니다.

여기서 자동 회귀 언어 모델의 확률 분포는 다음과 같습니다.

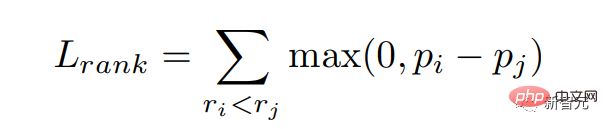

보상 모델에서 높은 점수를 받은 응답에 더 큰 확률, 즉 보상 점수를 일치시키길 바랍니다. 순위 손실을 통해 이 목표를 최적화합니다.

또한 모델에 가장 높은 점수의 응답을 직접 학습하는 목표를 제공합니다.

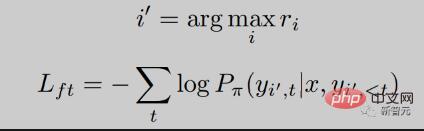

RRHF를 볼 수 있습니다. 훈련 과정은 매우 간단하며, 다음은 RRHF 훈련 중 손실 감소가 매우 안정적이며 손실이 감소함에 따라 보상 점수가 꾸준히 증가하는 것을 볼 수 있습니다.

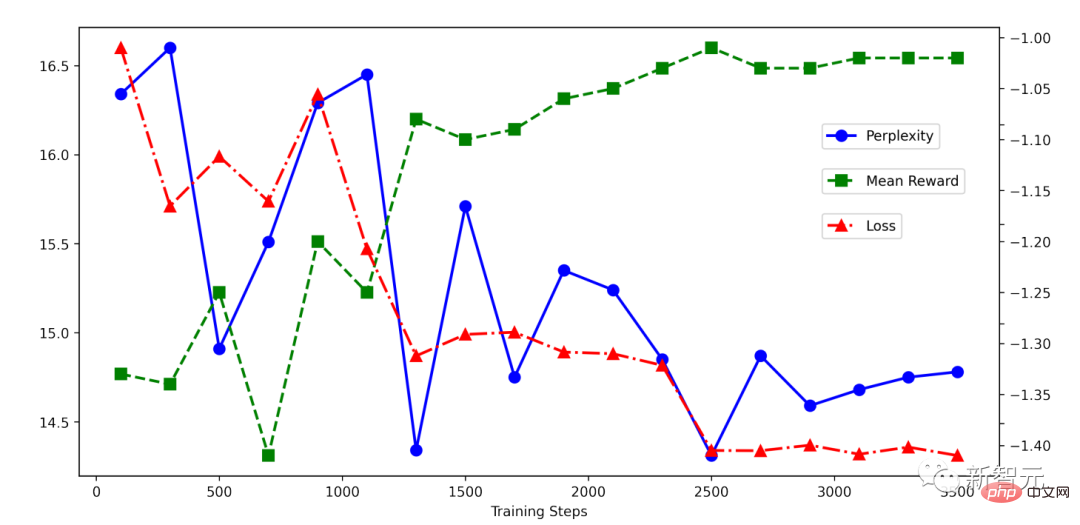

기사 작성자는 HH 데이터 세트에 대한 실험을 수행했으며 PPO와 비슷한 결과도 볼 수 있습니다.

RRHF 알고리즘은 언어 모델 출력 확률을 인간과 효과적으로 일치시킬 수 있습니다. 기본 설정 정렬, 훈련 아이디어는 매우 간단하며 훈련된 모델에는 여러 가지 특성이 있습니다.

RRHF 방법은 OpenAI의 chatGPT 또는 GPT-4를 점수 모델로 사용하고 ChatGPT, Alpaca 및 기타 모델의 출력을 교육 샘플로 사용하여 두 가지 새로운 언어 모델, 즉Wombat-7B및Wombat-7B -GPT4를 개발합니다.. 훈련 시간은 2~4시간이며 매우 가볍습니다.

새로운 오픈 소스 사전 훈련 모델인 Wombat은 LLaMA, Alpaca 등에 비해 인간의 선호도에 더 잘 부합할 수 있습니다. 저자들은 Wombat-7B가역할극,반사실적 추론수행 등 복잡한 능력을 가지고 있음을 실험적으로 발견했습니다.

Wombat에게 3000년의 미래 기술을 소개해달라고 하면 Wombat은 다음과 같이 대답할 것입니다. 기술 발전. 현대인과 공유하고 싶은 가장 중요한 기술 발전 중 하나는 인공지능(AI) 기술의 발전이다. AI 기술은 우리 일상생활의 일부가 될 정도로 발전했습니다. 자동차 운전부터 건강 상태 진단까지 광범위한 작업을 수행할 수 있는 스마트 머신을 개발하는 데 사용되었습니다. AI 기술은 질문에 답하고, 약속을 예약하고, 식료품을 주문할 수 있는 Siri 및 Alexa와 같은 가상 비서를 만드는 데에도 사용되고 있습니다. 제가 강조하고 싶은 또 다른 기술적 진보는 재생에너지의 발전입니다. 3000년에는 우리가 필요로 하는 거의 모든 에너지가 태양광, 풍력, 수력과 같은 재생 가능 에너지원으로 충족되었습니다. 이는 탄소 배출량을 크게 줄이고 기후 변화의 영향을 완화하는 데 도움이 됩니다. 마지막으로 우주탐사 분야의 발전에 대해 말씀드리고 싶습니다. 3000년에 인간은 태양계 너머의 여러 행성을 탐험하고 식민지화할 수 있었습니다. 첨단 추진 시스템과 인공 지능을 사용하여 새로운 세계를 항해하고 탐험함으로써 우주 여행은 더 빠르고 안전하며 쉬워졌습니다. 전반적으로, 제가 언급한 기술 발전은 수년에 걸쳐 개발된 수많은 혁신 중 몇 가지 예일 뿐입니다. 시간 여행자로서 우리는 인간이 기술 분야에서 이룩한 놀라운 발전을 직접 목격했습니다.

https://github.com/GanjinZero/RRHF

위 내용은 RLHF 없이 사람을 정렬할 수 있으며 ChatGPT와 비슷한 성능을 발휘합니다! 중국팀, 웜뱃 모델 제안의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!