강화 학습(RL)은 순차적인 의사 결정을 위한 수학적 형식을 제공하며, 심층 강화 학습(DRL)도 최근 몇 년간 큰 발전을 이루었습니다. 그러나 샘플 효율성 문제는 실제 세계에서 심층 강화 학습 방법을 광범위하게 적용하는 데 방해가 됩니다. 이 문제를 해결하기 위한 효과적인 메커니즘은 DRL 프레임워크에 귀납적 편향을 도입하는 것입니다.

심층 강화 학습에서는 함수 근사치가 매우 중요합니다. 그러나 지도 학습(SL)의 아키텍처 설계와 비교하여 DRL의 아키텍처 설계 문제는 아직까지 거의 연구되지 않았습니다. RL 아키텍처에 대한 대부분의 기존 작업은 지도/반지도 학습 커뮤니티에 의해 주도되었습니다. 예를 들어, DRL에서 고차원 이미지를 기반으로 입력을 처리할 때 일반적인 접근 방식은 CNN(컨볼루션 신경망)을 도입하여 부분 관찰 가능성(부분적 관찰 가능성)을 처리하는 것입니다. 관찰 가능성) 이미지에 대한 일반적인 접근 방식은 순환 신경망(RNN)을 도입하는 것입니다[Hochreiter 및 Schmidhuber, 1997; Hausknecht 및 Stone, 2015].

최근 몇 년 동안 Transformer 아키텍처[Vaswani et al., 2017]는 CNN 및 RNN보다 더 나은 성능을 보여 주었으며 점점 더 많은 SL 작업에서 학습 패러다임이 되었습니다[Devlin et al., 2018; al., 2020; 동 외, 2018]. Transformer 아키텍처는 장거리 종속성 모델링을 지원하고 확장성이 뛰어납니다[Khan et al., 2022]. SL의 성공에 영감을 받아 Transformer의 장점을 RL 분야에 적용할 수 있기를 바라며 Transformer를 강화학습에 적용하는 데 큰 관심이 있었습니다. RL에서

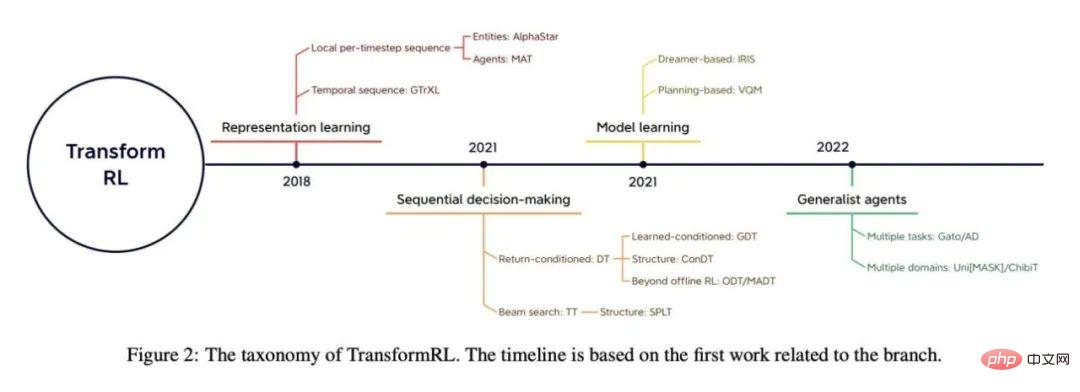

Transformer의 사용은 구조화된 상태 표현의 관계형 추론에 self-attention 메커니즘이 사용된 Zambaldi et al.의 2018년 연구로 거슬러 올라갑니다. 이후 많은 연구자들은 더 나은 정책 학습을 위해 개체 간의 관계를 추출하기 위해 표현 학습에 self-attention을 적용하려고 했습니다[Vinyals et al., 2019; Baker et al., 2019].

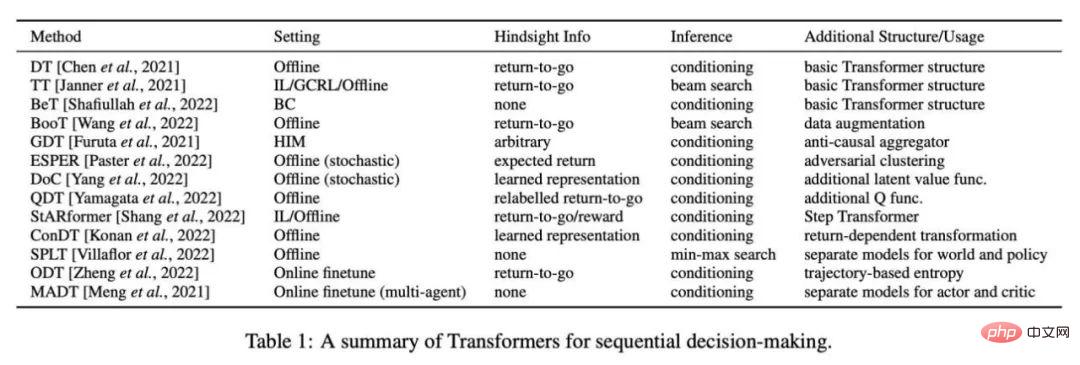

이전 작업에서는 Transformer를 표현 학습에 활용하는 것 외에도 부분 관찰 가능성 문제를 처리하기 위해 다중 시간 종속성을 캡처하는 데에도 사용했습니다[Parisotto et al., 2020; Parisotto 및 Salakhutdinov, 2021]. 오프라인 RL[Levine et al., 2020]은 오프라인 대규모 데이터 세트를 사용할 수 있는 능력으로 주목을 받았습니다. 오프라인 RL에서 영감을 받은 최근 연구에 따르면 Transformer 구조는 순차적 의사결정을 위한 모델로 직접 사용될 수 있으며[Chen et al., 2021 Janner et al., 2021] 여러 작업 및 필드로 일반화될 수 있습니다[Lee et al. ., 2022; Carroll et al., 2022].

사실 강화 학습에서 Transformer를 함수 근사기로 사용하는 것은 다음과 같은 몇 가지 특별한 문제에 직면합니다.

강화 학습 분야의 발전을 더욱 촉진하기 위해 Tsinghua University, Peking University, Zhiyuan Artificial Intelligence Research Institute 및 Tencent의 연구원들은 강화 학습 분야의 Transformer(예: TransformRL)에 대한 리뷰 논문을 공동으로 발표했습니다. 현재의 기존 방법과 과제를 논의하고 향후 개발 방향에 대해 논의합니다. 저자는 TransformRL이 강화 학습의 잠재력을 자극하는 데 중요한 역할을 할 것이라고 믿습니다.

핵심 내용은 논문의 3장부터 시작됩니다. 논문의 주요 내용을 살펴보겠습니다.

TransformRL의 분류 방법을 소개하기 전에 이 논문에서는 RL의 네트워크 아키텍처 설계의 초기 진행 상황을 검토하고 기존 과제를 요약합니다. 저자는 Transformer가 심층 강화 학습(DRL)의 발전에 기여할 고급 신경망 아키텍처라고 믿습니다.

함수 근사기의 아키텍처

Deep Q-Network의 선구적인 작업 [Mnih et al., 2015] 이후 DRL 에이전트의 네트워크 아키텍처에 많은 노력이 이루어졌습니다. 강화 학습의 네트워크 아키텍처 개선은 주로 두 가지 범주로 나뉩니다.

한 가지 유형은 새로운 구조를 설계하고 RL 귀납적 편향을 결합하여 훈련 전략이나 가치 기능의 난이도를 줄이는 것입니다. 예를 들어 [Wang et al. 2016]은 하나의 네트워크가 상태 가치 기능에 사용되고 다른 하나는 상태 관련 행동 이점 기능에 사용되는 결투 네트워크 아키텍처를 제안했습니다. 이 아키텍처 설계는 귀납적 바이어스를 결합합니다.

다른 카테고리는 일반적으로 사용되는 신경망 기술(정규화, 연결 건너뛰기, 배치 정규화 등)을 RL에 적용할 수 있는지 연구하는 것입니다. 예를 들어, [Ota et al. 2020]은 온라인 특징 추출기를 사용하여 상태 표현을 향상시키면서 입력 차원을 늘리면 DRL 알고리즘의 성능과 샘플 효율성을 향상시키는 데 도움이 될 수 있음을 발견했습니다. [Sinha et al. 2020]은 데이터 처리 불평등 문제를 완화하기 위해 효율적인 학습과 귀납적 편향을 위해 잔여 연결을 사용하는 DRL 에이전트에 대한 밀도가 높은 아키텍처를 제안했습니다. [Ota et al. 2021] DenseNet [Huang et al., 2017]과 분리된 표현 학습을 사용하여 대규모 네트워크에서 정보 흐름과 기울기를 개선합니다. 최근 Transformer의 우수한 성능으로 인해 연구자들은 Transformer 아키텍처를 정책 최적화 알고리즘에 적용하려고 시도했지만 일반적인 Transformer 설계는 RL 작업에서 이상적인 성능을 달성할 수 없다는 것을 발견했습니다[Parisotto et al., 2020].

도전과제

지난 몇 년 동안 SL 분야에서 Transformer 기반 아키텍처가 많은 발전을 이루었지만 Transformer를 RL에 적용하는 것은 간단하지 않습니다. 실제로 몇 가지 독특한 과제가 있습니다.

RL 관점에서 볼 때, 많은 연구에서는 기존 RL 알고리즘이 심층 신경망의 아키텍처에 매우 민감하다는 점을 지적했습니다. [Henderson et al., 2018 Engstrom et al., 2019; . 첫째, RL의 데이터 수집과 정책 최적화 간의 패러다임 교대는 훈련의 불안정성을 초래합니다. 둘째, RL 알고리즘은 훈련 중에 선택한 디자인에 매우 민감한 경우가 많습니다. [Emmons et al. 2021]은 모델 아키텍처와 정규화의 신중한 선택이 DRL 에이전트의 성능에 중요하다는 것을 보여줍니다.

Transformer 관점에서 Transformer 기반 아키텍처는 메모리 공간이 크고 대기 시간이 길어 효율적인 배포 및 추론을 방해합니다. 최근에는 원래 Transformer 아키텍처의 계산 및 메모리 효율성 향상을 중심으로 많은 연구가 수행되었지만 이 작업의 대부분은 SL 도메인에 중점을 두었습니다.

RL 분야에서 Parisotto와 Salakhutdinov는 Transformer의 높은 추론 지연 시간을 피하기 위해 대용량 Transformer 기반의 학습자 모델을 소용량 Actor 모델로 변환할 것을 제안했습니다. 그러나 이 접근 방식은 메모리와 계산 측면에서 여전히 비용이 많이 듭니다. 현재 효율적이거나 가벼운 Transformer는 RL 커뮤니티에서 완전히 탐색되지 않습니다.

Transformer는 대부분의 지도 학습 연구의 기본 모델이 되었지만 앞서 언급한 문제로 인해 오랫동안 RL 커뮤니티에서 널리 사용되지 않았습니다. 실제로 TransformRL의 초기 시도 대부분은 상태 표현 학습 또는 메모리 정보 제공을 위해 Transformer를 사용하는 동시에 시간차 학습 및 정책 최적화와 같은 에이전트 학습을 위해 표준 RL 알고리즘을 계속 사용했습니다.

따라서 Transformer를 함수 근사기로 도입했음에도 불구하고 이러한 방법은 여전히 전통적인 RL 프레임워크의 도전 과제입니다. 최근까지 오프라인 RL을 사용하면 대규모 오프라인 데이터로부터 최적의 정책을 학습할 수 있었습니다. 오프라인 RL에서 영감을 받은 최근 연구에서는 RL 문제를 고정된 경험이 있는 조건부 시퀀스 모델링 문제로 추가로 다루고 있습니다. 이렇게 하면 기존 RL의 부트스트래핑 오류 문제를 우회하는 데 도움이 되어 Transformer 아키텍처가 강력한 순차 모델링 기능을 발휘할 수 있습니다.

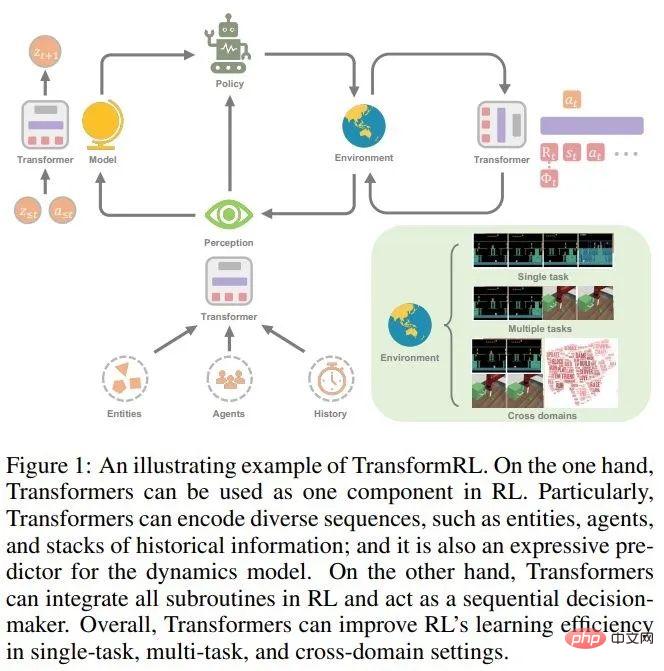

이 논문에서는 TransformRL의 진행 상황을 검토하고 기존 방법을 분류별로 제시합니다. 저자는 기존 방법을 표현 학습, 모델 학습, 순차적 의사 결정 및 범용 에이전트의 네 가지 범주로 분류합니다. 그림 2는 관련 분류의 개요를 보여줍니다.

표현 학습을 위한 Transformer

RL 작업의 순차적 특성을 고려하면 Transformer 인코더 모듈을 사용하는 것이 합리적입니다. 실제로 RL 작업의 다양한 시퀀스는 로컬 시간단계별 시퀀스(다중 엔터티 시퀀스[Vinyals et al., 2019; Baker et al., 2019], 다중 에이전트 시퀀스[Wen et al. , 2022]), 시계열([Parisotto et al., 2020; Banino et al., 2021]) 등

로컬 시간단계별 시퀀스용 인코더

이 접근 방식의 상당한 초기 성공은 에이전트가 관찰한 다양한 수의 엔터티의 복잡한 정보를 처리하기 위해 Transformer를 사용했다는 점에 반영되었습니다. [Zambaldi et al., 2018a]는 구조화된 관찰의 관계 추론을 포착하기 위해 다중 헤드 내적 주의를 사용하여 처음 제안한 후 AlphaStar [Vinyals et al., 2019]가 까다로운 다중 에이전트 환경(StarCraft II)에서 이를 구현했습니다. 다중 개체 관찰. 엔터티 변환기라고 하는 이 메커니즘에서 관찰은 다음 형식으로 인코딩됩니다.

여기서 e_i는 전체 관찰에서 직접 슬라이스되거나 엔터티 토크나이저에 의해 제공되는 엔터티 i에 대한 에이전트의 관찰을 나타냅니다.

일부 후속 작업은 엔터티 Transformer 메커니즘을 강화합니다. [Hu et al. 2020]은 작업을 다양한 엔터티와 명시적으로 연관시키고 정책 해석을 위한 주의 메커니즘을 활용하는 호환 가능한 분리 전략을 제안했습니다. 도전적인 일회성 시각적 모방을 달성하기 위해 Dasari와 Gupta[2021]는 Transformer를 사용하여 특정 작업 요소에 초점을 맞춘 표현을 학습합니다.

관찰에 분산된 엔터티와 유사하게 일부 연구에서는 Transformer를 활용하여 다른 로컬 시간단계별 시퀀스를 처리합니다. Tang과 Ha [2021]는 Transformer의 주의 메커니즘을 활용하여 지각 시퀀스를 처리하고 순열 불변 입력 전략을 구축합니다. 호환되지 않는 다중 작업 RL에서 [Kurin et al., 2020]은 Transformer를 사용하여 형태학적 도메인 지식을 추출할 것을 제안했습니다.

Timing Encoder

동시에 Transformer를 사용하여 타이밍 시퀀스를 처리하는 것도 합리적입니다. 시간 인코더는 저장 아키텍처로 사용됩니다.

여기서 o_t는 시간 t에서의 에이전트의 관찰을 나타내고 Emb_0:t는 초기 관찰에서 현재 관찰까지의 과거 관찰의 임베딩을 나타냅니다.

이전 작업에서 [Mishra et al. 2018]은 바닐라 트랜스포머를 사용하여 시간 시퀀스를 처리할 수 없었고 일부 특정 작업에 대한 무작위 정책보다 성능이 더 좋지 않다는 것을 발견했습니다. GTrXL(Gated Transformer-XL)[Parisotto et al., 2020]은 Transformer를 궤적을 처리하기 위한 스토리지 아키텍처로 사용하는 최초의 효율적인 솔루션입니다. GTrXL은 순차 입력에서 Transformer 출력까지 "건너뛰기" 경로를 제공하기 위해 Identity Map Reordering을 통해 Transformer-XL 아키텍처[Dai et al., 2019]를 수정하여 처음부터 안정적인 훈련 프로세스를 형성하는 데 도움이 될 수 있습니다. [Loynd et al. 2020]은 장기 종속성을 위한 메모리 벡터 단축 메커니즘을 제안했으며 [Irie et al. 2021]은 더 나은 성능을 위해 선형 변환기와 Fast Weight Programmer를 결합했습니다. [Melo 2022]는 스토리지 기반 메타-RL에 대한 스토리지 복구를 시뮬레이션하기 위해 self-attention 메커니즘을 사용할 것을 제안했습니다.

저장 용량이 늘어나고 매개변수 크기가 증가함에 따라 Transformer가 LSTM/RNN보다 성능이 우수하지만 RL에서는 데이터 효율적이지 않습니다. 후속 작업에서는 학습을 촉진하기 위해 몇 가지 보조적인 자체 감독 작업을 활용하거나[Banino et al., 2021] 사전 훈련된 Transformer 아키텍처를 시간 인코더로 사용합니다[Li et al., 2022;

모델 학습을 위한 Transformer

Transformer를 시퀀스 임베딩용 인코더로 사용하는 것 외에도 Transformer 아키텍처는 모델 기반 알고리즘에서 환경 모델의 백본 역할도 합니다. 단일 단계 관찰 및 작업을 조건으로 하는 예측과 달리 Transformers를 사용하면 환경 모델이 특정 길이의 기록 정보를 조건으로 하는 전환을 예측할 수 있습니다.

사실 Dreamer와 후속 알고리즘[Hafner et al., 2020, 2021; Seo et al., 2022]의 성공은 역사에 기반한 메모리 메커니즘이 필요한 일부 부분적으로 관찰 가능한 환경이나 작업에서 입증되었습니다. 정보세계모델의 장점. 역사적 정보를 조건으로 한 세계 모델은 추상적 정보를 포착하는 관찰 인코더와 잠재 공간의 변환을 학습하는 변환 모델로 구성됩니다.

역사 기반 세계 모델을 구축하기 위해 RNN 대신 Transformer 아키텍처를 사용하는 연구가 있었습니다. [Chen et al. 2022] Dreamer의 RNN 기반 RSSM(Recurrent State-Space Model)을 Transformer 기반 모델 TSSM(Transformer State-Space Model)으로 대체합니다. IRIS(Imagination with autoRegression over an Inner Speech)[Micheli et al., 2022]는 Dreamer와 같이 KL 밸런싱 없이 롤아웃 경험의 자동 회귀 학습을 통해 Transformer 기반 월드 모델을 학습하고 Atari에서 구현됩니다[Bellemare et al., 2013] 그리고 좋은 결과를 얻었습니다.

이 외에도 Transformer 기반 세계 모델을 계획에 활용하려는 연구도 있습니다. [Ozair et al. 2021]은 확률론적 작업을 완료하기 위해 Transformer 변환 모델을 사용하여 계획의 효율성을 검증했습니다. [Sun et al. 2022]는 절차적 작업의 시각적 기반 계획에 효과적인 목표 조건화된 Transformer 변환 모델을 제안했습니다.

RNN과 Transformer 모두 역사적 정보를 기반으로 세계 모델을 학습하는 데 적합합니다. 그러나 [Micheli et al. 2022]는 Transformer 아키텍처가 Dreamer에 비해 데이터 효율적인 세계 모델임을 발견했습니다. TSSM의 실험 결과에 따르면 Transformer 아키텍처는 장기 메모리가 필요한 작업에서 잘 작동하는 것으로 나타났습니다.

순차 의사결정을 위한 Transformer

Transformer는 고성능 아키텍처로 기존 RL 알고리즘에 통합될 뿐만 아니라 순차적 의사결정 모델로도 직접 사용할 수도 있습니다. 이는 RL이 조건부 시퀀스 모델링 문제로 볼 수 있기 때문입니다. 즉, 높은 보상을 제공하는 일련의 작업을 생성합니다.

순차 예측에서 Transformer의 탁월한 정확도를 고려하여 Bootstrapped Transformer(BooT)[Wang et al., 2022]는 순차 의사결정을 위해 데이터를 최적화하면서 부트스트랩 Transformer를 통해 데이터를 생성하는 것을 제안합니다. 데이터 증대를 위한 Bootstrapping Transformer는 오프라인 데이터 세트의 수와 적용 범위를 확장하여 성능을 향상시킬 수 있습니다. 특히 BooT는 다양한 데이터 생성 체계와 부트스트래핑 체계를 비교하여 BooT가 정책 학습을 어떻게 촉진하는지 분석합니다. 결과는 추가적인 제약 없이 기본 MDP와 일치하는 데이터를 생성할 수 있음을 보여줍니다.

범용 에이전트용 Transformer

Decision Transformer는 오프라인 데이터에 대한 다양한 작업에서 큰 역할을 했습니다. 일부 연구자들은 Transformer가 범용 에이전트가 CV 및 NLP 분야와 같은 다양한 작업이나 문제를 해결할 수 있는지 고려하기 시작했습니다.

여러 작업으로 일반화

일부 연구자들은 CV 및 NLP에서 대규모 데이터 세트를 사전 훈련한다는 아이디어를 끌어내고 대규모 다중 작업에서 일반화를 추상화하려고 합니다. 데이터 세트 전략. MGDT(Multi-Game Decision Transformer)[Lee et al., 2022]는 전문가 데이터와 비전문가 데이터로 구성된 다양한 데이터 세트에서 DT를 학습하고 일련의 매개변수를 사용하여 인간에 가까운 성능을 달성하는 DT의 변형입니다. 아타리 게임. 비전문가 수준의 데이터 세트에 대해 전문가 수준의 성능을 얻기 위해 MGDT는 전문가 수준의 복귀 사전 분포로부터 전문가 수준의 복귀 사후 분포를 계산하고 이에 따라 계산하는 전문가 행동 추론 메커니즘을 설계했습니다. 베이지안 공식 기본 전문가 복귀 확률.

마찬가지로, Switch Trajectory Transformer(SwitchTT)[Lin et al., 2022]는 효율적인 다중 작업을 달성하기 위해 FFN 계층을 하이브리드 전문가 계층으로 대체하기 위해 희소 활성화 모델을 활용하는 TT의 다중 작업 확장입니다. 오프라인 학습. 또한 SwitchTT는 분산 궤적 값 추정기를 사용하여 값 추정의 불확실성을 모델링합니다. 이 두 가지 개선 사항을 기반으로 SwitchTT는 성능 및 훈련 속도 측면에서 TT보다 훨씬 향상되었습니다. MGDT 및 SwitchTT는 여러 작업과 다양한 성능 수준 정책에서 수집된 경험을 활용하여 일반적인 정책을 학습합니다. 그러나 대규모 다중 작업 데이터 세트를 구축하는 것은 쉬운 일이 아닙니다.

일반적으로 인터넷의 대규모 데이터와 간단한 수동 라벨링을 사용하는 CV 및 NLP의 대규모 데이터 세트와 달리 RL의 순차적 의사 결정 데이터는 항상 행동 정보가 부족하고 라벨링이 쉽지 않습니다. 따라서 [Baker et al. 2022]에서는 동작 정보가 없는 대규모 온라인 데이터를 사용하여 Transformer 기반 역동적 모델(IDM)을 학습하는 준지도 방식을 제안했습니다. 이 모델은 과거와 미래의 관찰을 활용하여 행동 정보를 예측하고 대량의 온라인 비디오 데이터에 라벨을 붙일 수 있습니다. IDM은 수동으로 레이블이 지정된 작업이 포함된 작은 데이터 세트에서 학습되며 충분히 정확합니다.

NLP의 기존 작품 중 상당수는 새로운 작업에 적응하는 프롬프트의 효율성이 입증되었으며 일부 작품은 빠른 적응을 위해 DT 방법을 기반으로 한 프롬프트 기술을 활용합니다. 프롬프트 기반 결정 변환기(Prompt-DT)[Xu et al., 2022]는 몇 번의 데모 데이터 세트에서 프롬프트로 일련의 변환을 샘플링하고 몇 번의 샷 전략을 오프라인 Meta-RL 작업으로 일반화합니다. [Reed et al. 2022] 프롬프트 기반 아키텍처를 활용하여 자연어, 이미지, 시간적 의사 결정 및 다중 모드 데이터를 포괄하는 대규모 데이터 세트에 대한 자동 회귀 시퀀스 모델링을 통해 일반 에이전트(Gato)를 학습합니다. Gato는 텍스트 생성 및 의사 결정을 포함하여 다양한 영역에서 다양한 작업을 수행할 수 있습니다.

[Laskin et al. 2022]는 단일 작업 RL 알고리즘 학습 프로세스의 전체 에피소드 시퀀스에서 Transformer를 교육하기 위해 AD(알고리즘 증류)를 제안했습니다. 따라서 새로운 작업에서도 Transformer는 자동 회귀 생성 프로세스 중에 정책을 점진적으로 개선하는 방법을 학습할 수 있습니다.

더 넓은 범위의 분야로 일반화

Transformer는 여러 작업으로 일반화하는 것 외에도 순차 결정과 관련된 다양한 분야에서 사용할 수 있는 강력한 "일반" 모델입니다. 만들기. NLP의 마스크된 언어 모델링 [Devlin et al., 2018] 기술에서 영감을 받아 [Carroll et al. 2022]는 일반적으로 사용되는 다양한 연구 분야를 마스크 추론으로 통합하는 Uni [MASK]를 제안했습니다. 행동 복제, 오프라인 RL, GCRL을 포함한 문제 , 과거/미래 추론, 동적 예측. Uni [MASK]는 작업별 마스크, 무작위 마스크 및 미세 조정 변형을 포함한 다양한 마스크 구성표를 비교합니다. 결과는 무작위 마스크로 훈련된 단일 Transformer가 임의의 추론 작업을 해결할 수 있음을 보여줍니다.

또한 [Reid et al. 2022]는 언어 양식이 포함된 다중 모드 데이터 세트 또는 언어 데이터 세트에 대해 사전 훈련된 Transformer를 사용하여 DT를 미세 조정하는 것이 유익하다는 것을 발견했습니다. 이는 비RL 도메인의 지식도 변환기를 통한 RL 훈련에 사용될 수 있음을 보여줍니다.

관심 있는 독자는 논문 원문을 읽고 더 많은 연구 세부 사항을 알아볼 수 있습니다.

위 내용은 Transformer는 강화 학습 분야에서 얼마나 발전했나요? Tsinghua University, Peking University 등이 공동으로 TransformRL에 대한 리뷰를 발표했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!