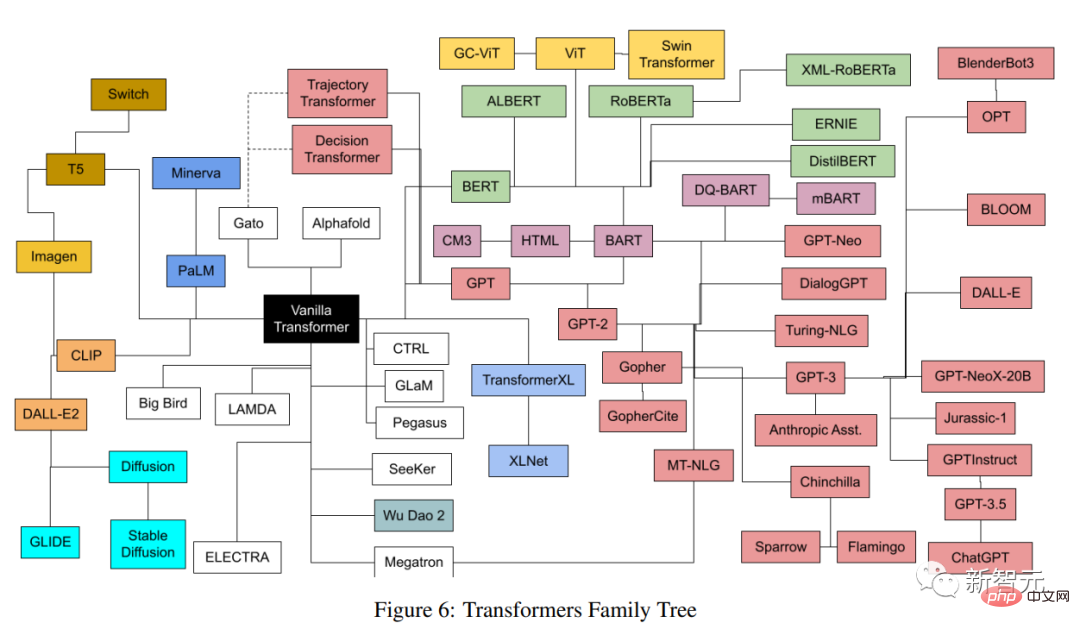

지난 몇 년간 대형 모델 개발을 뒷받침한 것이 있다면 바로 트랜스포머일 것입니다!

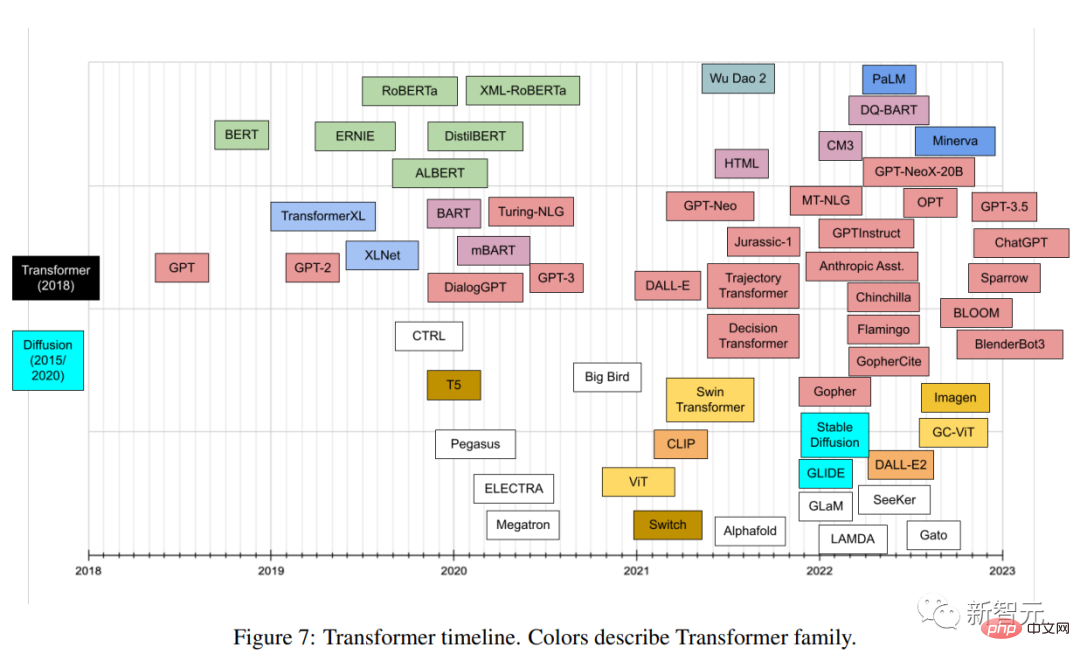

트랜스포머를 기반으로 다양한 분야에서 수많은 모델들이 생겨나고 있습니다. 모델마다 아키텍처도 다르고, 디테일도 다르며, 설명하기 쉽지 않은 이름도 있습니다.

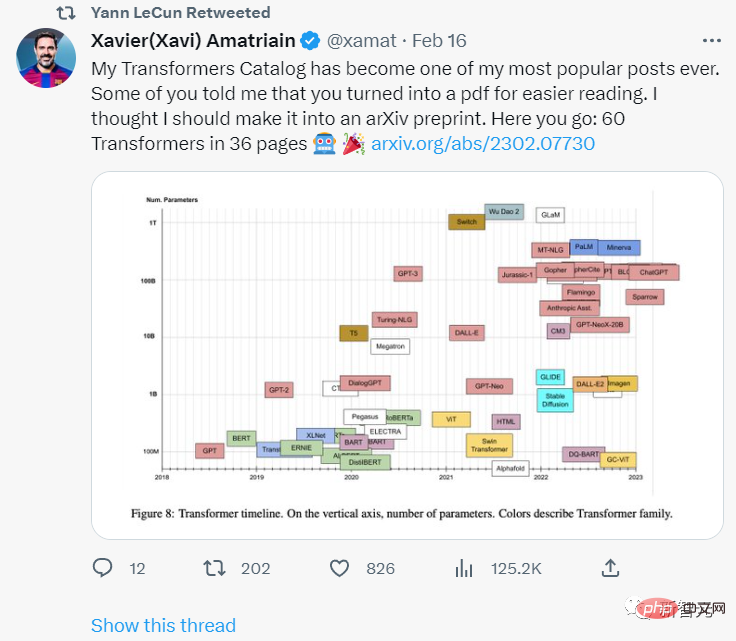

최근 한 저자가 최근 출시된 모든 인기 트랜스포머 모델에 대해 종합적인 분류 및 색인화를 실시하고 최대한 포괄적이면서도 간단한 카탈로그를 제공했습니다에 대한 소개가 포함되어 있습니다. 트랜스포머 혁신과 개발 이력 검토.

논문 링크: https://arxiv.org/pdf/2302.07730.pdf

Turing Award 수상자 Yann LeCun이 승인을 표명했습니다.

기사의 저자인 Xavier (Xavi) Amatriain은 2005년 스페인 Pompeu Fabra University에서 박사 학위를 취득했습니다. 그는 현재 LinkedIn에서 엔지니어링 부사장으로 재직하고 있으며 주로 인공 제품을 담당하고 있습니다. 지능 전략.

Transformer는 독특한 구조적 특징을 지닌 딥러닝 모델의 일종으로, 2017년 구글 연구원들이 발표한 유명한 "Attention is All you Need" 논문에 처음 등장했습니다. 이 논문은 단 5년 만에 많은 데이터를 축적했습니다. 무려 38,000번의 인용이 있었습니다.

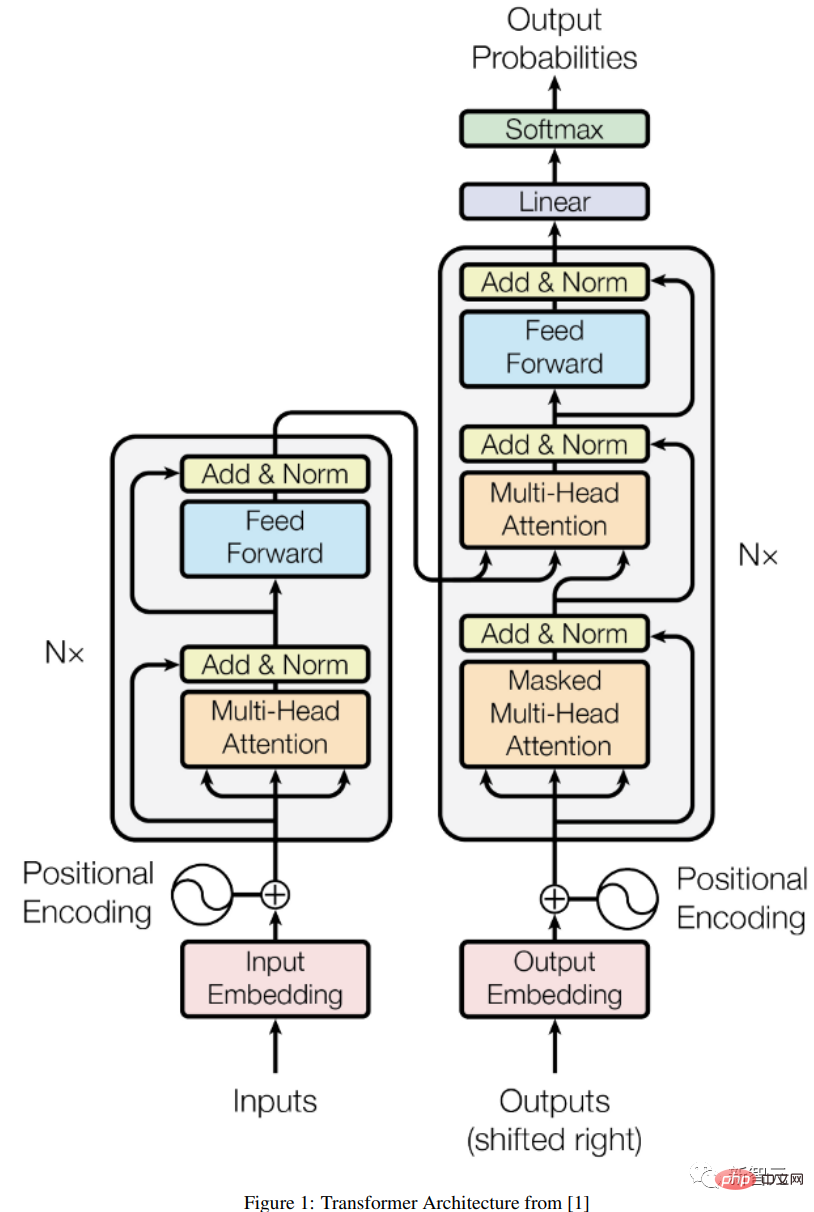

Transformer 아키텍처도 인코더-디코더 모델(encoder-decoder)에 속하지만 이전 모델에서는 Attention이 메커니즘 중 하나일 뿐이었고 대부분이 LSTM(장단기 기억) 및 기타 메커니즘을 기반으로 했습니다. RNN(반복 신경망) 변형.

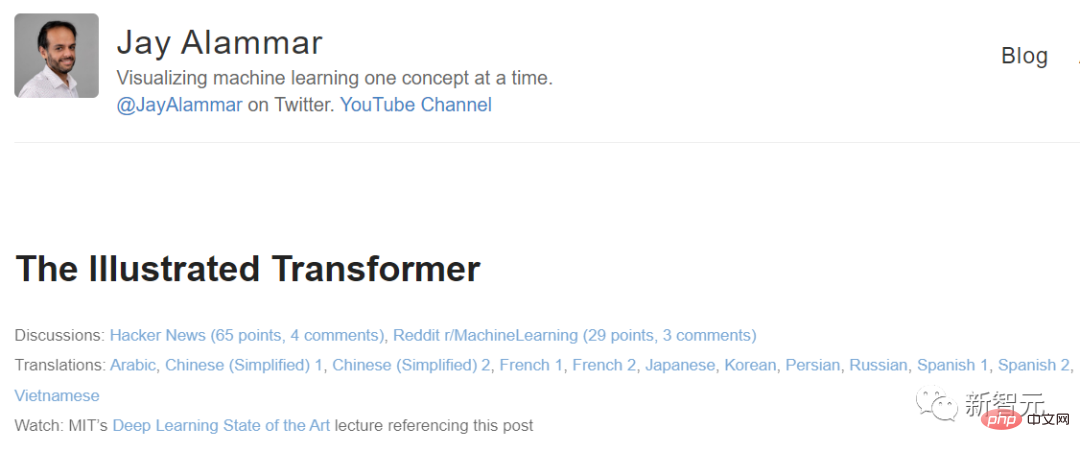

Transformer를 제안하는 논문의 핵심 통찰력은 제목에서 알 수 있듯이 Attention 메커니즘이 입력과 출력 간의 종속성을 도출하는 유일한 메커니즘으로 사용될 수 있다는 것입니다. 이 논문에서는 모든 세부 사항을 조사할 의도가 없습니다. 관심 있는 친구들은 "The Illustrated Transformer" 블로그를 검색해 보세요.

블로그 링크: https://jalammar.github.io/illustrated-transformer/

아래에서는 가장 중요한 구성 요소 중 일부만 간략하게 설명합니다.

인코더-디코더 아키텍처

일반 인코더/디코더 아키텍처는 두 가지 모델로 구성되며, 인코더는 입력을 받아 고정 길이 벡터로 인코딩합니다. 디코더는 이 벡터를 수신합니다. 이를 출력 시퀀스로 디코딩합니다.

인코더와 디코더는 조건부 로그 가능성을 최소화하도록 공동으로 훈련됩니다. 일단 훈련되면 인코더/디코더는 주어진 입력 시퀀스를 기반으로 출력을 생성하거나 입력/출력 시퀀스 쌍을 채점할 수 있습니다.

원래 Transformer 아키텍처에서는 인코더와 디코더 모두 6개의 동일한 레이어를 가지고 있습니다. 이 6개 레이어 각각에는 인코더에 다중 헤드 주의 레이어와 간단한 피드포워드 네트워크라는 두 개의 하위 레이어가 있습니다. 레이어에는 잔여 연결과 레이어 정규화가 있습니다.

인코더의 출력 크기는 512이고 디코더는 인코더 출력에 또 다른 멀티 헤드 어텐션 레이어인 세 번째 하위 레이어를 추가합니다. 또한, 디코더의 또 다른 다중 헤드 레이어는 정보 유출이 후속 위치에 적용되는 것을 방지하기 위해 마스크 처리됩니다.

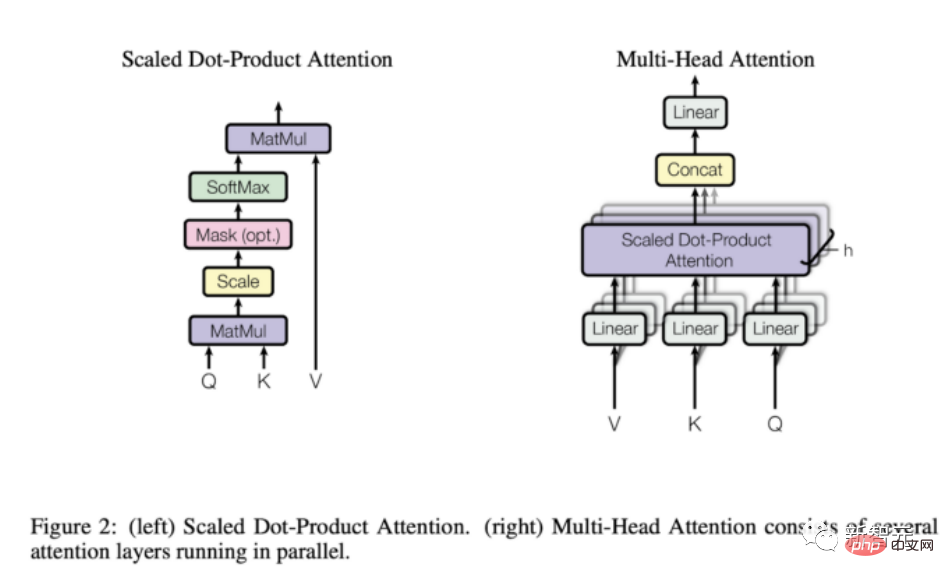

주의 메커니즘

위 설명에서 볼 수 있듯이 모델 구조의 유일한 "이상한" 요소는 황소의 주의입니다. 모델 위치.

주의 함수는 쿼리와 키-값 쌍 집합을 출력에 매핑하는 것입니다. 출력은 값의 가중 합으로 계산됩니다. 여기서 각 값에 할당된 가중치는 호환성 함수에 의해 결정됩니다. 쿼리 및 해당 키.

Transformer는 멀티 헤드 어텐션을 사용합니다. 이는 스케일링 내적 어텐션이라고도 알려진 어텐션 함수 세트의 병렬 계산입니다.

순환 및 컨벌루션 네트워크와 비교할 때 Attention 계층에는 여러 가지 장점이 있습니다. 더 중요한 점은 계산 복잡성이 낮고 연결성이 높다는 것입니다. 이는 시퀀스의 장기적인 종속성을 학습하는 데 특히 유용합니다.

Transformer는 무엇을 할 수 있나요? 왜 인기를 얻었나요?

원래 Transformer는 주로 영어에서 독일어로의 언어 번역을 위해 설계되었지만, 첫 번째 논문 버전의 실험 결과에 따르면 아키텍처가 다른 언어 작업에도 잘 일반화될 수 있는 것으로 나타났습니다.

이 특별한 추세는 연구 커뮤니티에서 빠르게 알아차렸습니다.

앞으로 몇 달 안에 모든 언어 관련 ML 작업의 순위는 특정 버전의 Transformer 아키텍처에 의해 완전히 차지될 것입니다. 예를 들어 질문 및 답변 작업 Squad는 다양한 Transformer 모델에 의해 빠르게 제거되었습니다.

Transofrmer가 대부분의 NLP 순위를 그렇게 빨리 차지할 수 있는 주요 이유 중 하나는 다른 작업, 즉 사전 훈련된 Transformer 모델을 사용하지 않을 경우 매우 쉽고 빠르게 적응할 수 있다는 것입니다. 훈련된 작업은 다른 모델에 비해 큰 이점을 가지고 있습니다.

ML 실무자로서 더 이상 대규모 데이터 세트에 대해 대규모 모델을 처음부터 훈련할 필요가 없습니다. 사전 훈련된 모델을 당면 작업에 재사용하기만 하면 됩니다. 아마도 훨씬 작은 데이터로 약간 조정하면 됩니다.

미리 훈련된 모델을 다양한 작업에 적용하는 데 사용되는 특정 기술을 미세 조정이라고 합니다.

Transformers는 다른 작업에 매우 적응력이 뛰어나 원래 언어 관련 작업을 위해 개발되었지만 시각적, 오디오 및 음악 응용 프로그램부터 체스 게임이나 게임에 이르기까지 다른 작업에도 빠르게 유용하게 되었습니다. 수학.

물론, 코드 몇 줄만 작성할 수 있는 사람이라면 누구나 쉽게 사용할 수 있는 수많은 도구가 없었다면 이러한 모든 애플리케이션은 불가능했을 것입니다.

Transformer는 주요 인공 지능 프레임워크(예: Pytorch 및 TensorFlow)에 빠르게 통합될 뿐만 아니라 Transformer에만 전념하는 일부 회사도 있습니다.

현재까지 6천만 달러 이상을 모금한 스타트업 Huggingface는 거의 전적으로 오픈 소스 Transformer 라이브러리를 상용화하려는 아이디어를 중심으로 구축되었습니다.

GPT-3은 OpenAI가 2020년 5월 출시한 Transformer 모델로, 이전 GPT와 GPT-2의 후속 버전입니다. 회사는 모델이 너무 강력해서 세상에 출시할 자격이 없다고 주장하면서 사전 인쇄로 모델을 소개함으로써 많은 화제를 불러일으켰습니다.

게다가 OpenAI는 GPT-3를 출시하지 않았을 뿐만 아니라 마이크로소프트와 매우 큰 파트너십을 통해 상용화하기도 했습니다.

이제 GPT-3는 300개 이상의 다양한 애플리케이션에 대한 기본 기술 지원을 제공하며 OpenAI 비즈니스 전략의 기초입니다. 이는 10억 달러 이상의 자금을 지원받은 회사로서는 매우 중요한 일입니다.

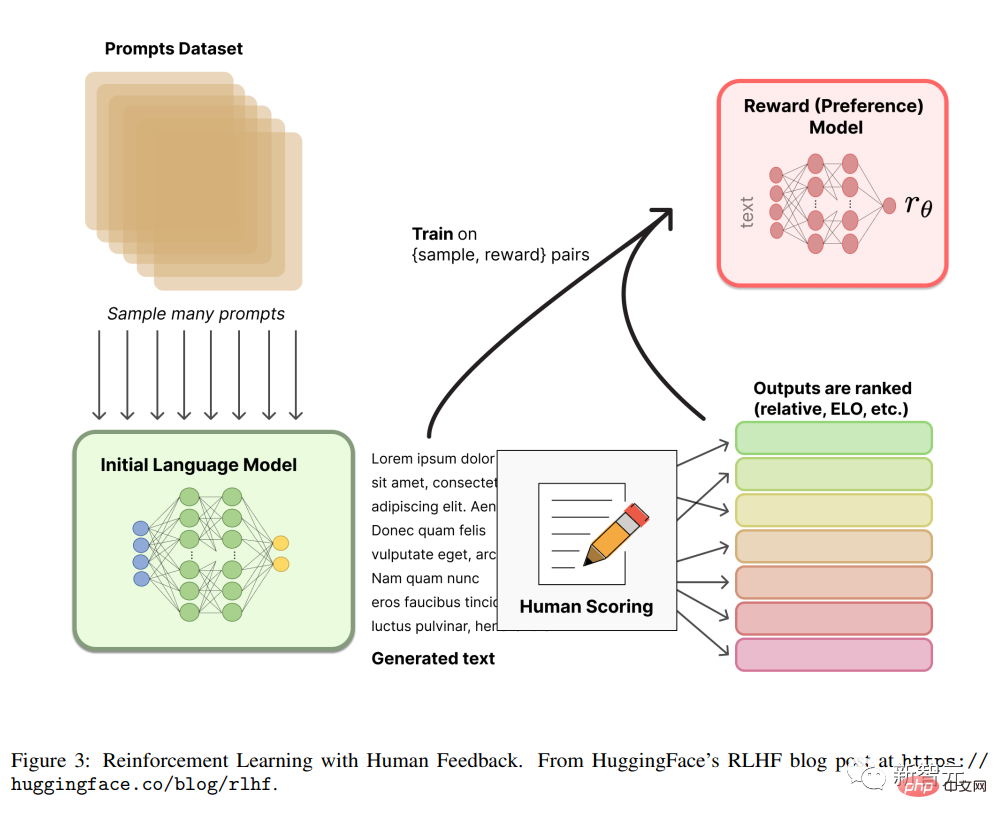

RLHF

RLHF(또는 RLHP)라고도 알려진 인간의 피드백(또는 선호도)을 통한 강화 학습이 최근 인공 지능 도구 상자에 크게 추가되었습니다.

이 개념은 2017년 논문 "Deep Reinforcement Learning from Human Preferences"에서 처음 나왔으나, 최근에는 ChatGPT 및 유사한 대화형 에이전트에 적용되어 상당히 좋은 결과를 거두며 대중의 관심을 받고 있습니다.

아이디어는 매우 간단합니다. 일단 언어 모델이 사전 훈련되면 대화에 대해 다양한 응답을 생성하고 인간이 결과 순위를 매기거나(선호도라고도 함) 피드백을 사용할 수 있습니다. ) 강화 학습 메커니즘을 사용하여 보상을 훈련합니다.

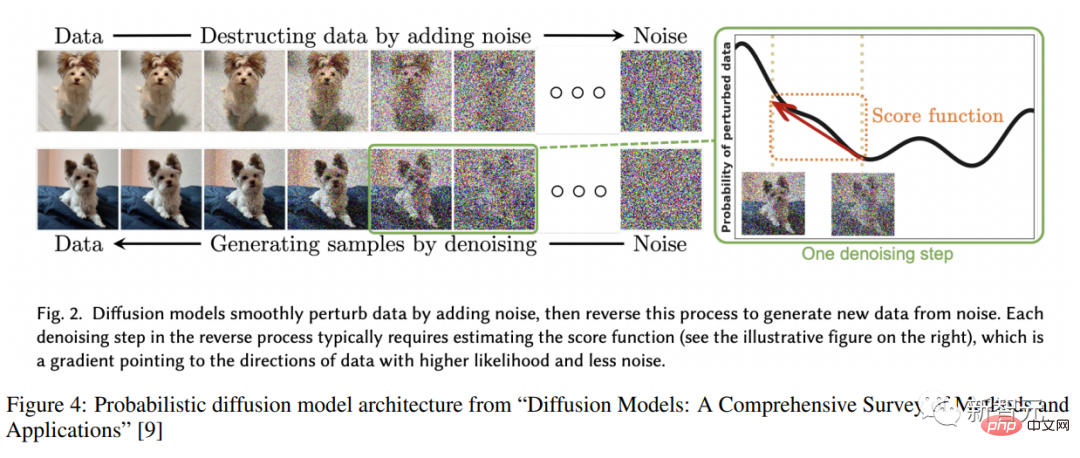

확산 모델 Diffusion

확산 모델은 이미지 생성의 새로운 SOTA로 자리 잡았으며, GAN(Generative Adversarial Networks)을 대체하려는 경향이 강합니다.

확산 모델은 훈련된 변이 추론의 잠재 변수 모델의 일종입니다. 실제로는 특정 노이즈 함수로 인해 흐려진 이미지를 제거하기 위해 심층 신경망을 훈련하는 것을 의미합니다.

이러한 방식으로 훈련된 네트워크는 실제로 이러한 이미지로 표현되는 잠재 공간을 학습하고 있습니다.

소개를 읽은 후 트랜스포머 회고 여행을 시작해보세요!

위 내용은 역사상 가장 완벽한 트랜스포머 컬렉션! LeCun은 다음을 권장합니다. 60개 모델에 대한 카탈로그를 만드십시오. 어떤 논문을 놓쳤습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!