AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

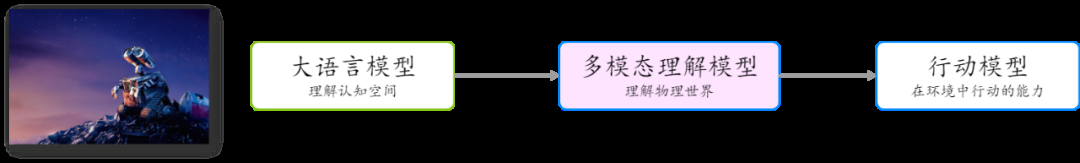

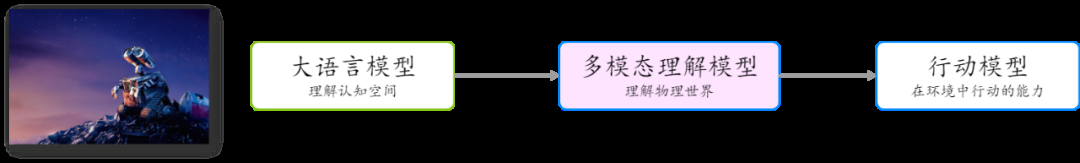

GPT に代表される大規模言語モデルは、デジタル認知空間における一般的な人工知能の夜明けを告げます。これらのモデルは、自然言語を処理および生成することによって強力な理解および推論能力を実証し、複数の分野での幅広い応用の見通しを示しています。コンテンツ生成、自動化された顧客サービス、生産性ツール、AI 検索、あるいは教育や医療などの分野においても、大規模な言語モデルは常にテクノロジーの進歩とアプリケーションの普及を促進しています。

しかし、一般的な人工知能による物理世界の探索を促進するには、最初のステップは視覚的な理解の問題、つまり大きなモデルのマルチモーダルな理解を解決することです。マルチモーダル理解により、AI は人間と同じように複数の感覚を通じて情報を取得して処理することで、世界をより完全に理解し、対話できるようになります。この分野のブレークスルーにより、人工知能はロボット工学や自動運転などにおいてさらなる進歩を遂げ、デジタル世界から物理世界への飛躍を真に実現することができるでしょう。

GPT-4Vは昨年6月にリリースされましたが、大規模な言語モデルと比較して、マルチモーダル理解モデルの開発は、特に中国語分野で遅れているようです。さらに、技術的なルートと比較的確実な大規模言語モデルの選択とは異なり、マルチモーダル モデルのアーキテクチャとトレーニング方法の選択については、業界はまだ完全に合意に達していません。

ドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドルドル大規模モデルの最先端の理解。このモデルは、アーキテクチャ、トレーニング方法、データ処理の点で革新的かつ徹底的に最適化されており、パフォーマンスが大幅に向上し、あらゆるアスペクト比と最大 7K 解像度の画像の理解をサポートします。主にオープンソースのベンチマークで調整されたほとんどのマルチモーダル モデルとは異なり、Tencent のハイブリッド マルチモーダル モデルは、モデルの汎用性、実用性、信頼性により重点を置いており、豊富なマルチモーダル シーン理解機能を備えています。最近リリースされた中国のマルチモーダル大型モデル SuperCLUE-V ベンチマーク評価 (2024 年 8 月) では、Tencent Hunyuan が複数の主流クローズドソース モデルを上回り、国内で 1 位にランクされました。

Tencent の大規模混合言語モデルは、中国で初めて混合エキスパート モデル (MoE) アーキテクチャを採用しており、モデルの全体的なパフォーマンスは、MoE アーキテクチャよりも 50% 優れています。 GPT-4o と連携し、数学、推論、その他の能力だけでなく、「現在」の質問に答えるパフォーマンスも大幅に向上しました。今年の初めには、Tencent Hunyuan がこのモデルを Tencent Yuanbao に適用しました。

Tencent Hunyuan は、多数の一般的なタスクを解決できる MoE アーキテクチャは、マルチモーダルな理解シナリオにとっても最適な選択であると信じています。 MoE は、より多くのモダリティやタスクとの互換性が向上し、さまざまなモダリティやタスクが競合するのではなく相互に強化されるようになります。

Tencent Hunyuan の大規模言語モデルの機能に依存して、Tencent Hunyuan は MoE アーキテクチャに基づいた大規模なマルチモーダル理解モデルを立ち上げ、アーキテクチャ、トレーニング方法、データの面で革新と徹底的な最適化を行いました。処理が強化され、パフォーマンスが大幅に向上しました。これは、中国の教育省アーキテクチャに基づいた初のマルチモーダル大型モデルでもあります。

模 Tencent mixed element multi -modal model architecture schematic diagram

In addition to using the MOE architecture, the design of the Tencent mixed element multi -mode model also follows simple and reasonable , Principles of scalability:

Support native arbitrary resolutions: Compared with the industry’s mainstream fixed resolution or cut subgraph methods, Tencent’s hybrid multi-modal model can process native images of any resolution. Implemented the first multi-modal model to support image understanding with resolutions exceeding 7K and any aspect ratio (e.g. 16:1, see example below).

-

Using a simple MLP adapter: Compared with the previous mainstream Q-former adapter, the MLP adapter has less loss during information transmission.

-

This simple design makes it easier to expand and scale models and data.

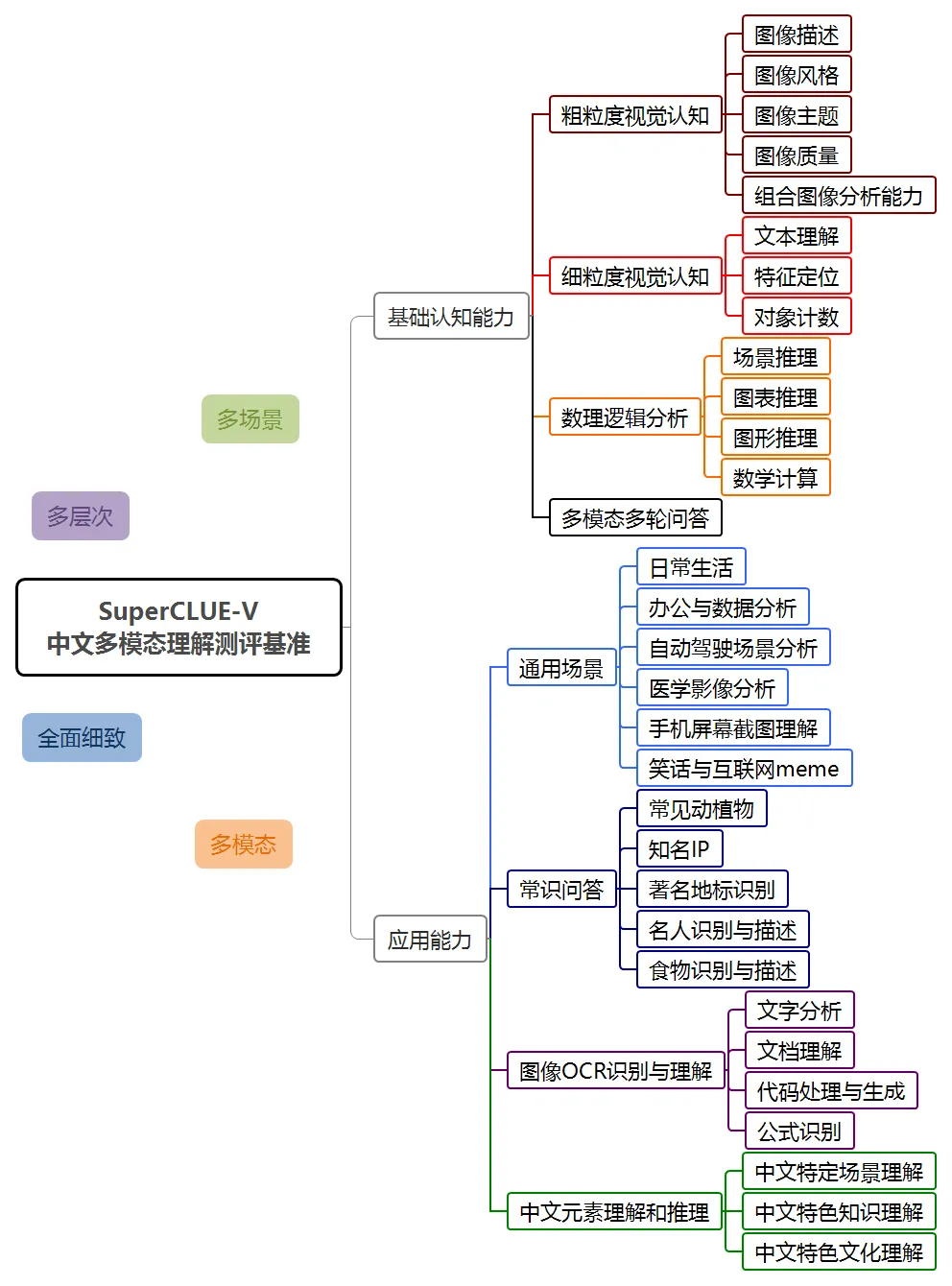

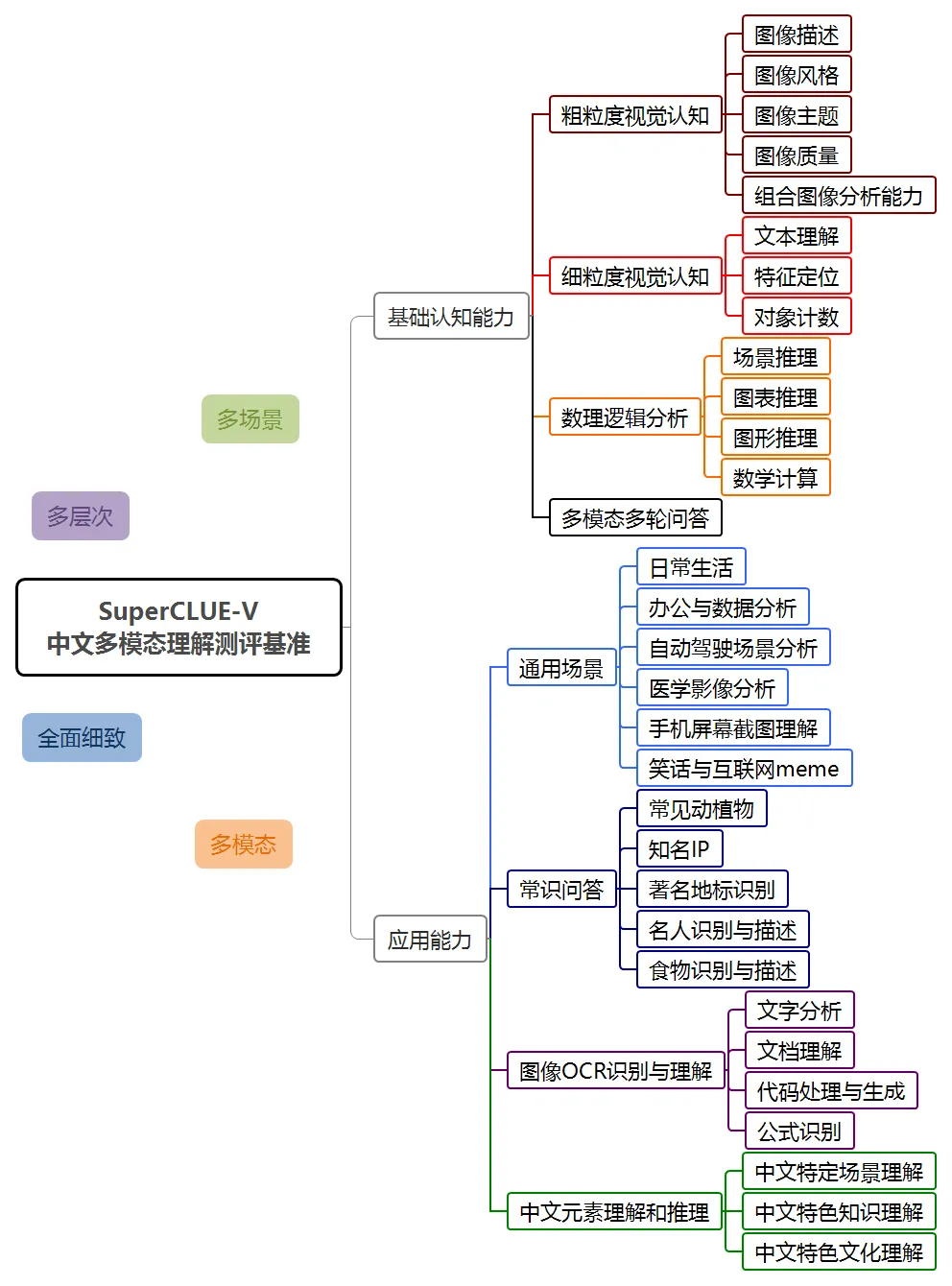

SuperClue-V ranks first in the domestic list

In August 2024, SuperCLUE released the multi-modal understanding evaluation list for the first time - SuperClue-V.

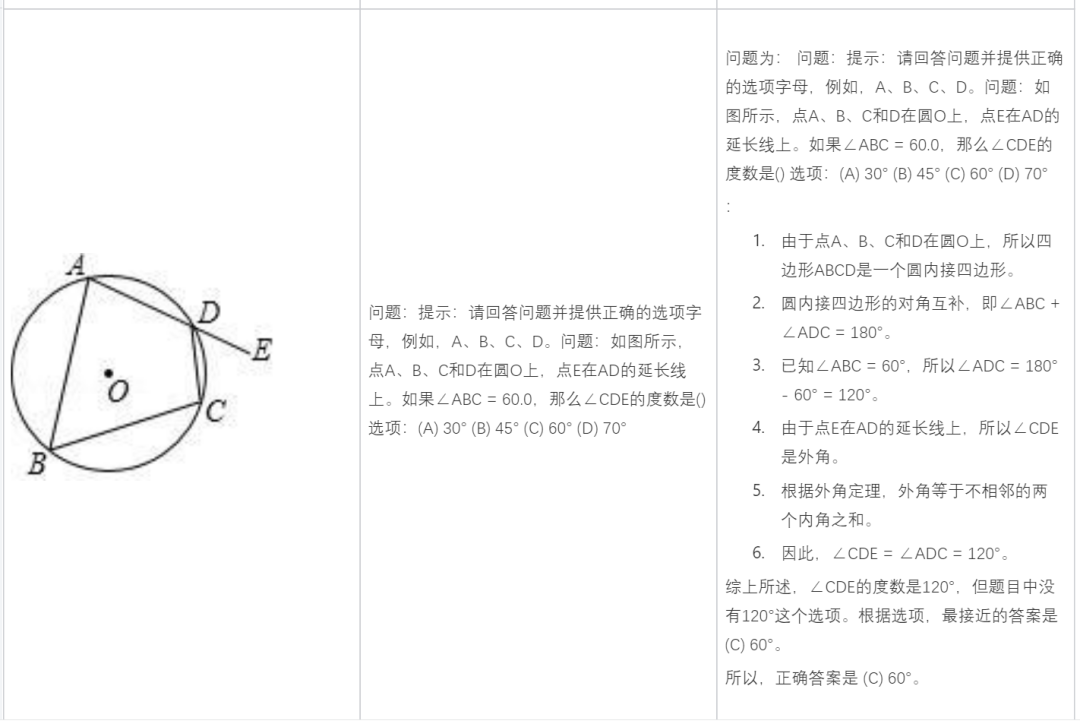

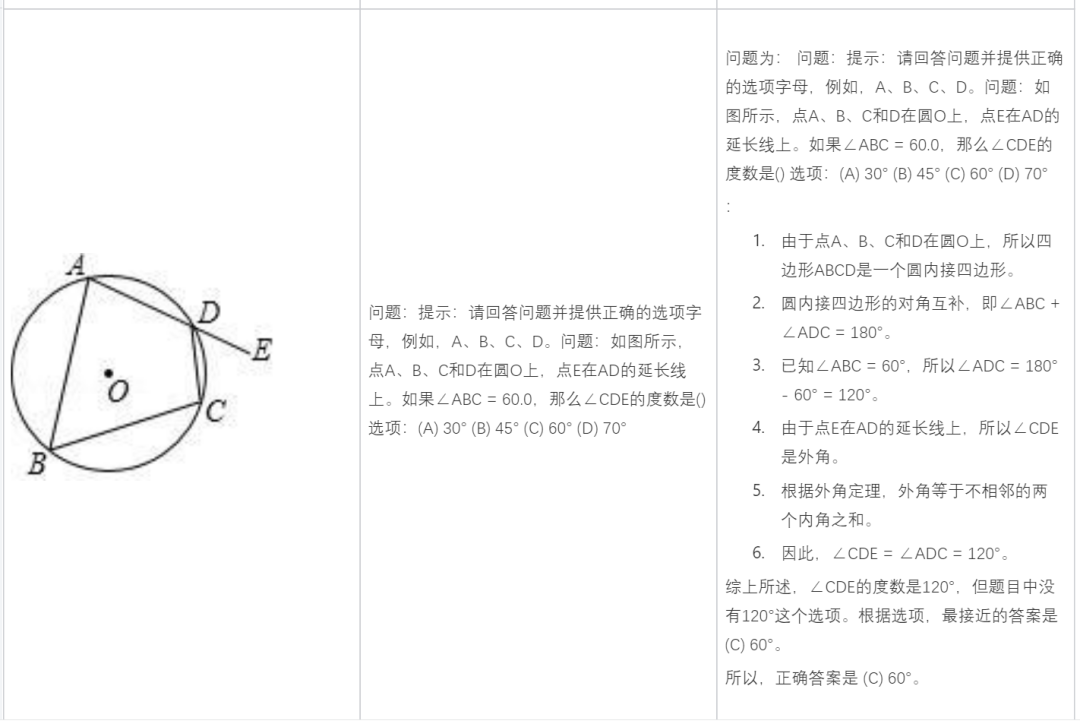

The SuperCLUE-V benchmark includes two general directions: basic capabilities and application capabilities. It evaluates multi-modal large models in the form of open questions, including 8 first-level dimensions and 30 second-level dimensions.

In this evaluation, the Hunyuan multi-modal understanding system hunyuan-vision achieved a score of 71.95, second only to GPT-4o. In terms of multi-modal applications, hunyuan-vision is ahead of Claude3.5-Sonnet and Gemini-1.5-Pro.

It is worth noting that previous multi-modal assessments in the industry mostly focused on English proficiency, and most of the assessment questions were multiple-choice or true-false questions. The SuperCLUE-V evaluation focuses more on Chinese proficiency evaluation and focuses on users’ real problems. In addition, since this is the first release, overfitting has not yet occurred.

Tencent Hunyuan Graphics and Text Large Model shows good performance in multiple dimensions such as general scenes, image OCR recognition and understanding, and Chinese element understanding and reasoning, and also reflects the potential of the model in future applications.

Aimed at general application scenarios

Aimed at general application scenarios

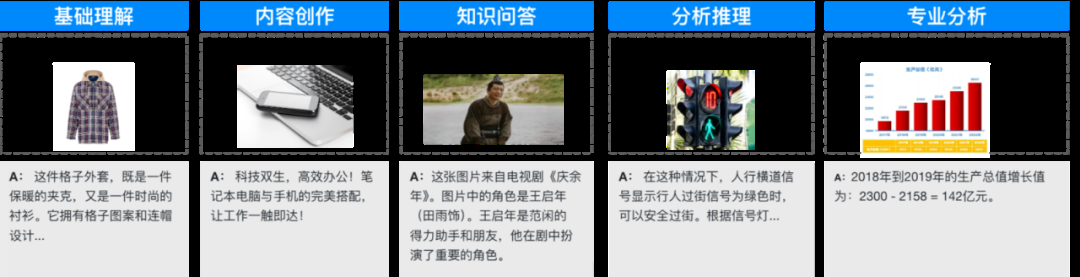

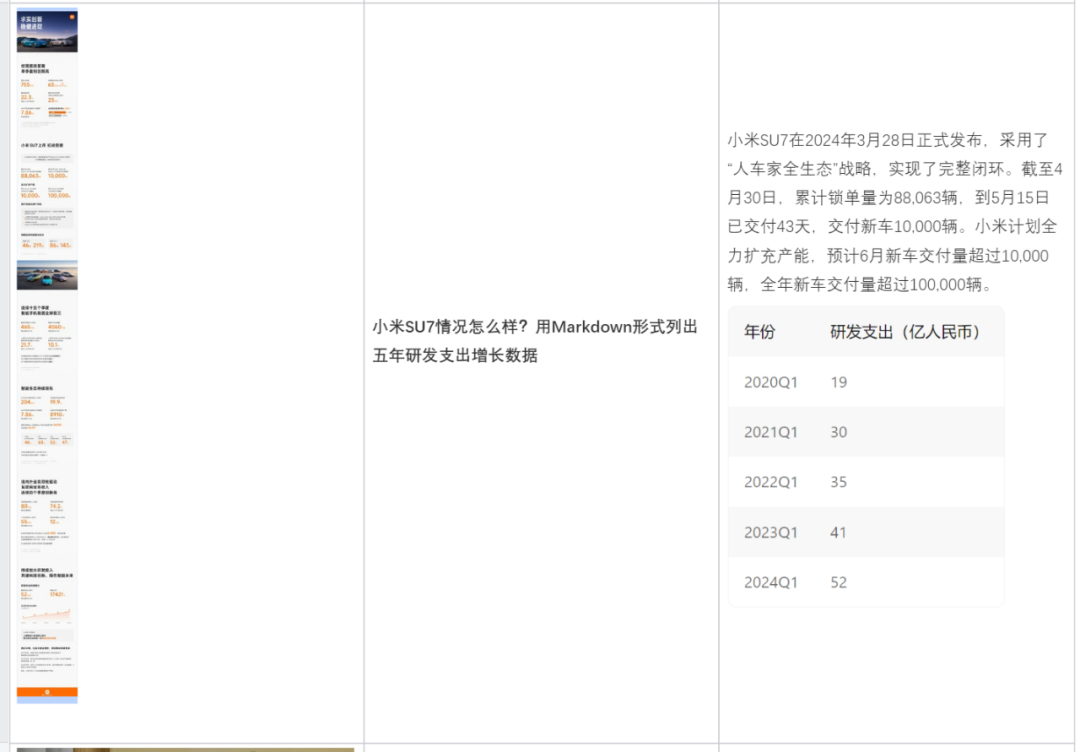

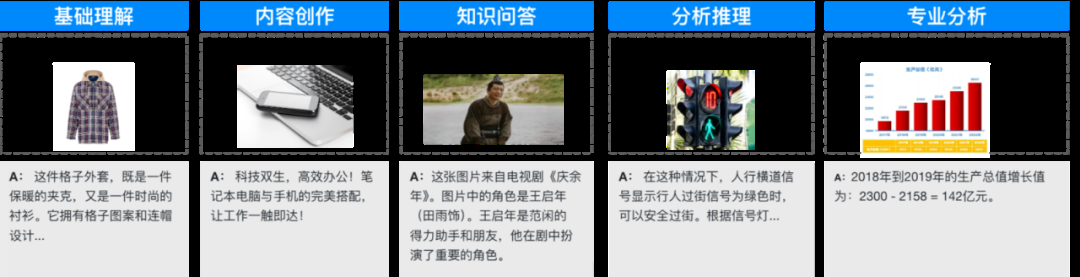

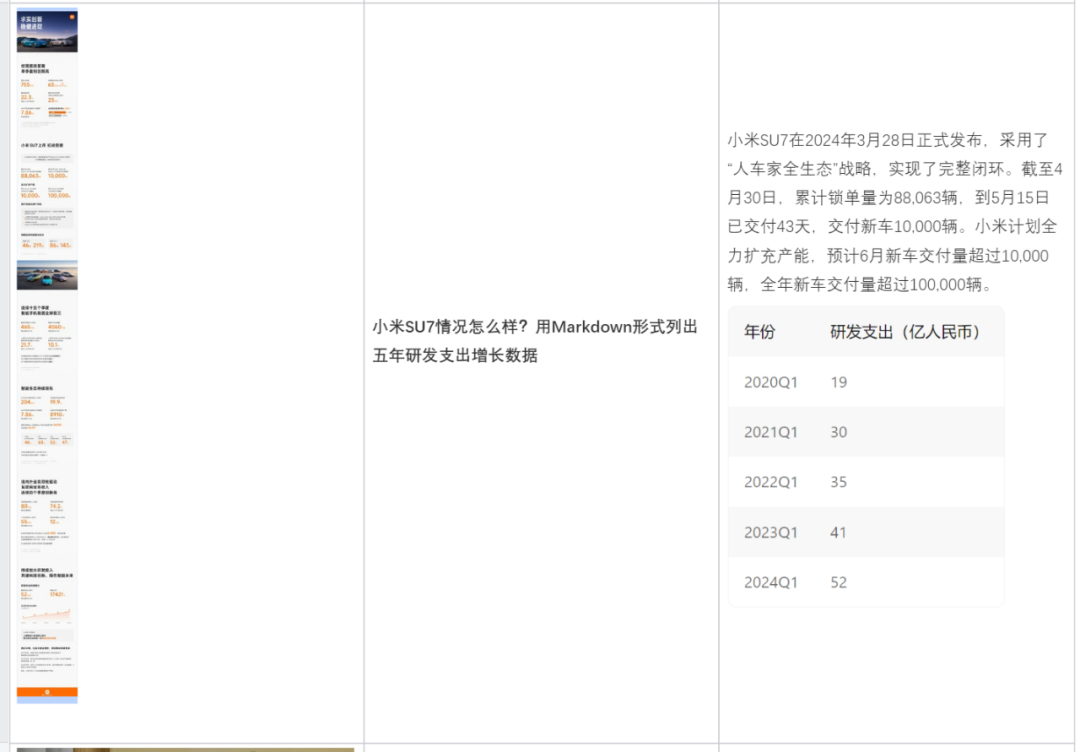

The mixed-element multi-modal understanding model is optimized for general scenarios and massive applications, and has accumulated tens of millions of related question and answer corpus, covering basic image understanding, content creation, It can be used in many scenarios such as reasoning analysis, knowledge question and answer, OCR document analysis, and subject answering. The following are some typical application examples.

Here are more typical examples:

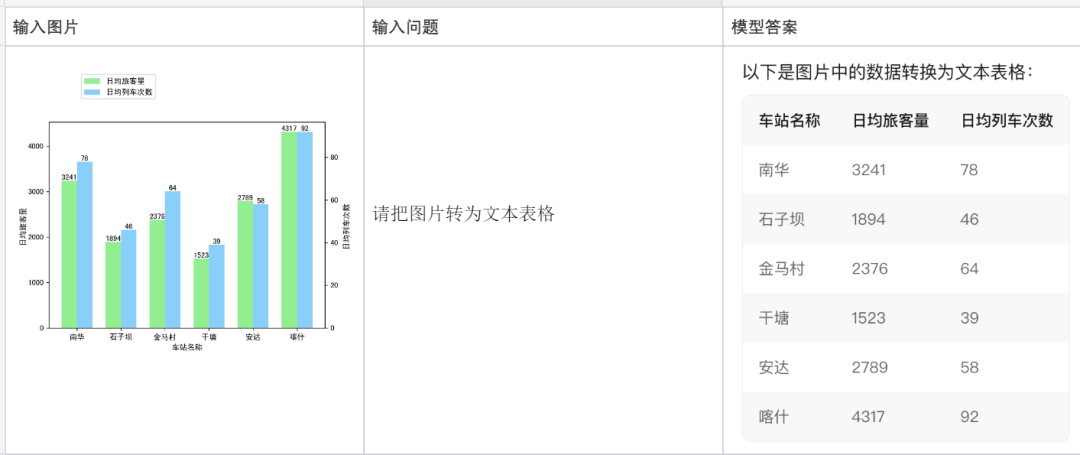

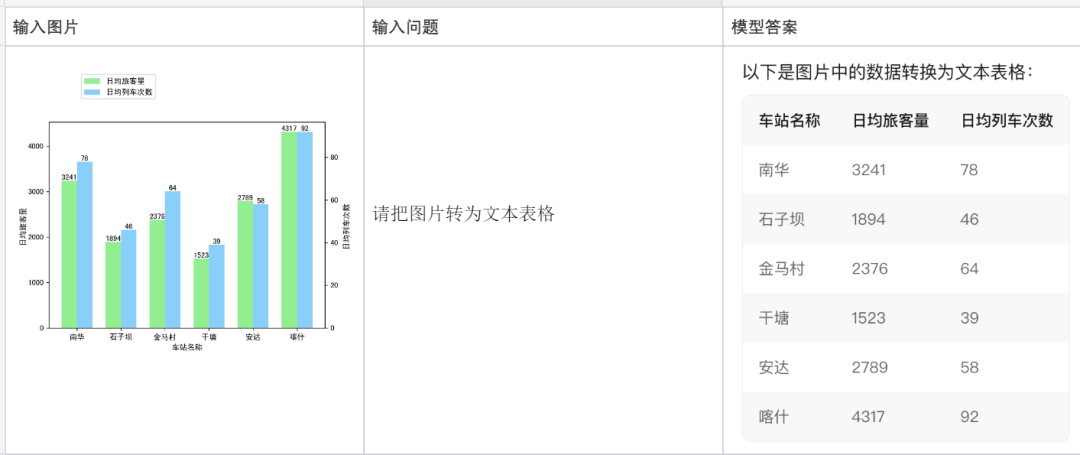

Convert an image into a text table:

Explain a piece of code:

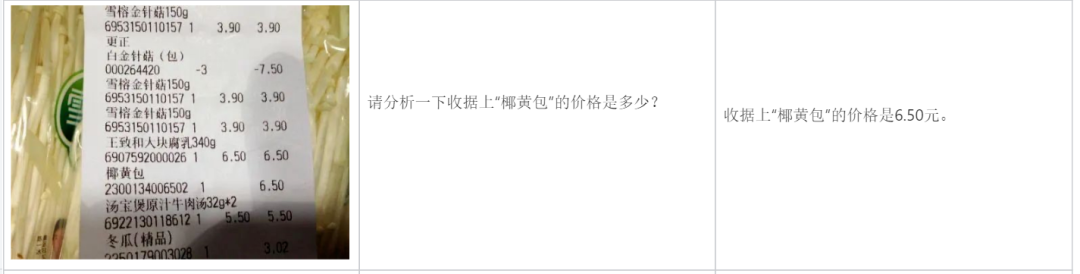

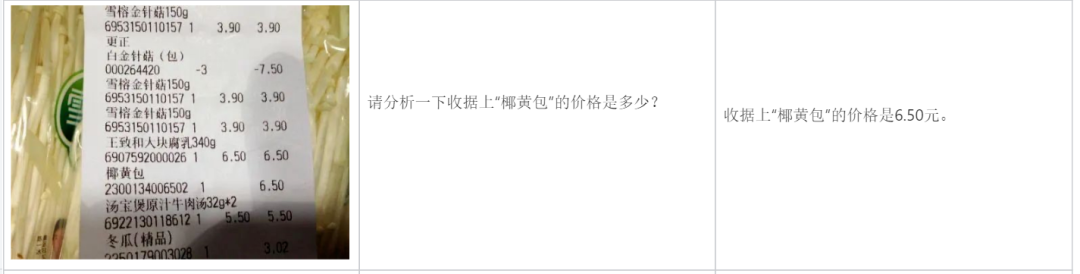

Analyze a bill:

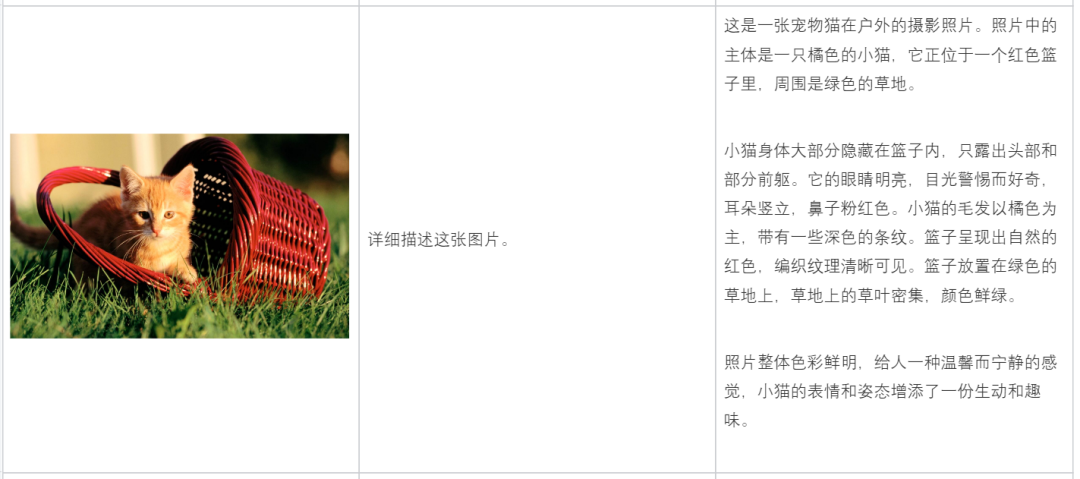

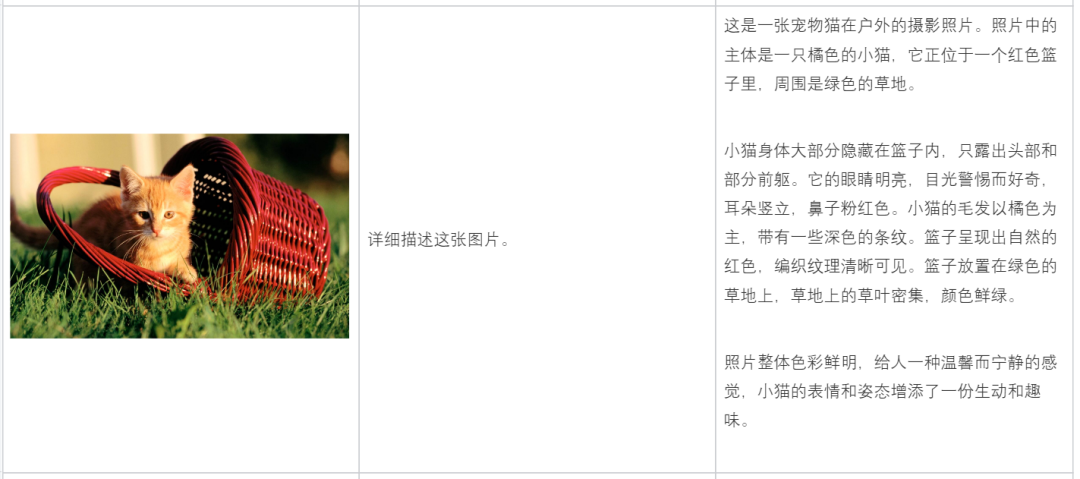

Description Picture content:

Do math problems:

Analyze based on the content of the picture:

Help you write copy:

현재 Tencent의 Hunyuan 다중 모드 이해 대형 모델은 AI 보조 제품 Tencent Yuanbao에 출시되었으며 Tencent Cloud를 통해 기업 및 개인 개발자에게 공개되어 있습니다.

Tencent Yuanbao 주소: https://yuanbao.tencent.com/chat

위 내용은 중국 최초의 자체 개발 MoE 다중 모드 대형 모델은 Tencent의 혼합 요소 다중 모드 이해를 보여줍니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Aimed at general application scenarios

Aimed at general application scenarios