Snowflake が LLM の乱闘に参加します。

Snowflake は、社内のエンタープライズ アプリケーションに焦点を当てた、高度な「エンタープライズ インテリジェンス」モデル Arctic をリリースします。 たった今、データ管理およびウェアハウスのプロバイダーである Snowflake が、LLM 乱戦に参加し、エンタープライズ レベルのアプリケーションに焦点を当てたトップレベルの大規模言語モデル (LLM) をリリースしたと発表しました。 - スノーフレーク北極。 # Arctic はクラウド コンピューティング企業が立ち上げた LLM として、主に次の 2 つの利点があります。

- 効率的なインテリジェンス: Arctic は、SQL 生成、プログラミング、命令追従などのエンタープライズ タスクに優れており、より高い計算コストでトレーニングされたオープン ソース モデルとさえ競合します。 Arctic は、費用対効果の高いトレーニングのための新しいベースラインを設定し、Snowflake の顧客が企業のニーズに合わせた高品質のカスタム モデルを低コストで作成できるようにします。

- オープンソース: Arctic は Apache 2.0 ライセンスを採用し、重みとコードへのオープン アクセスを提供します。また、Snowflake もすべてのデータ ソリューションと研究結果をオープンソースにします。

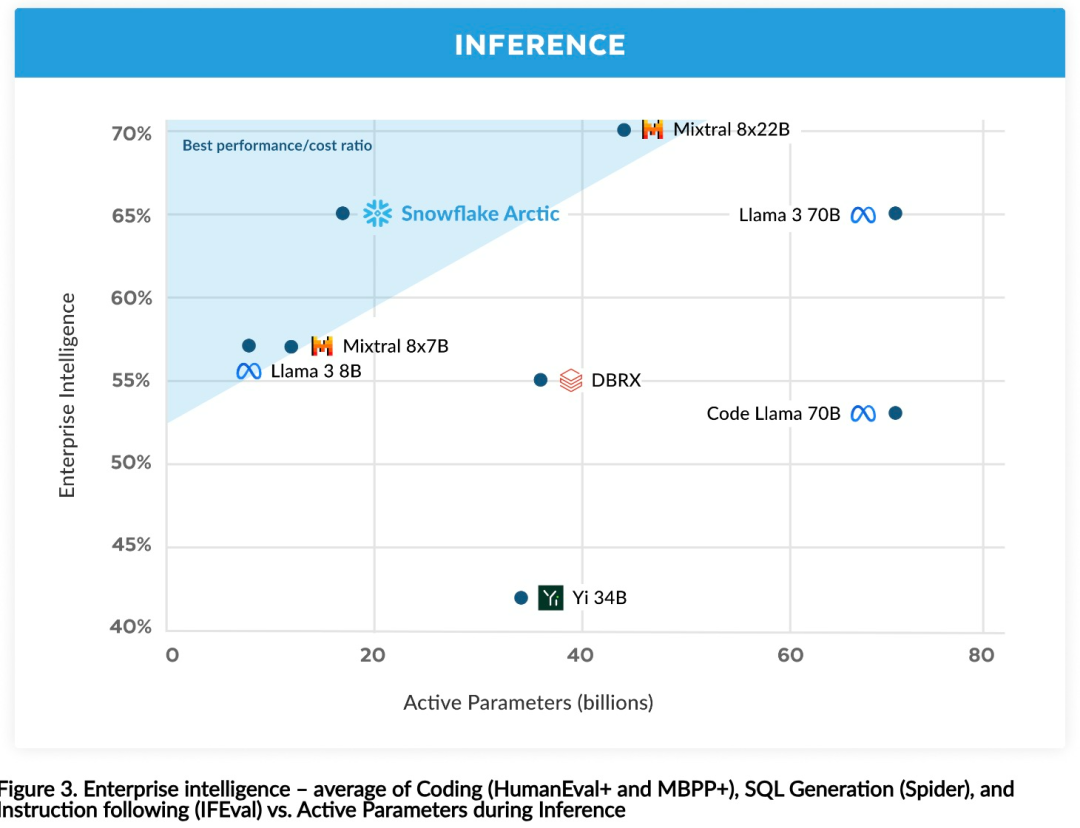

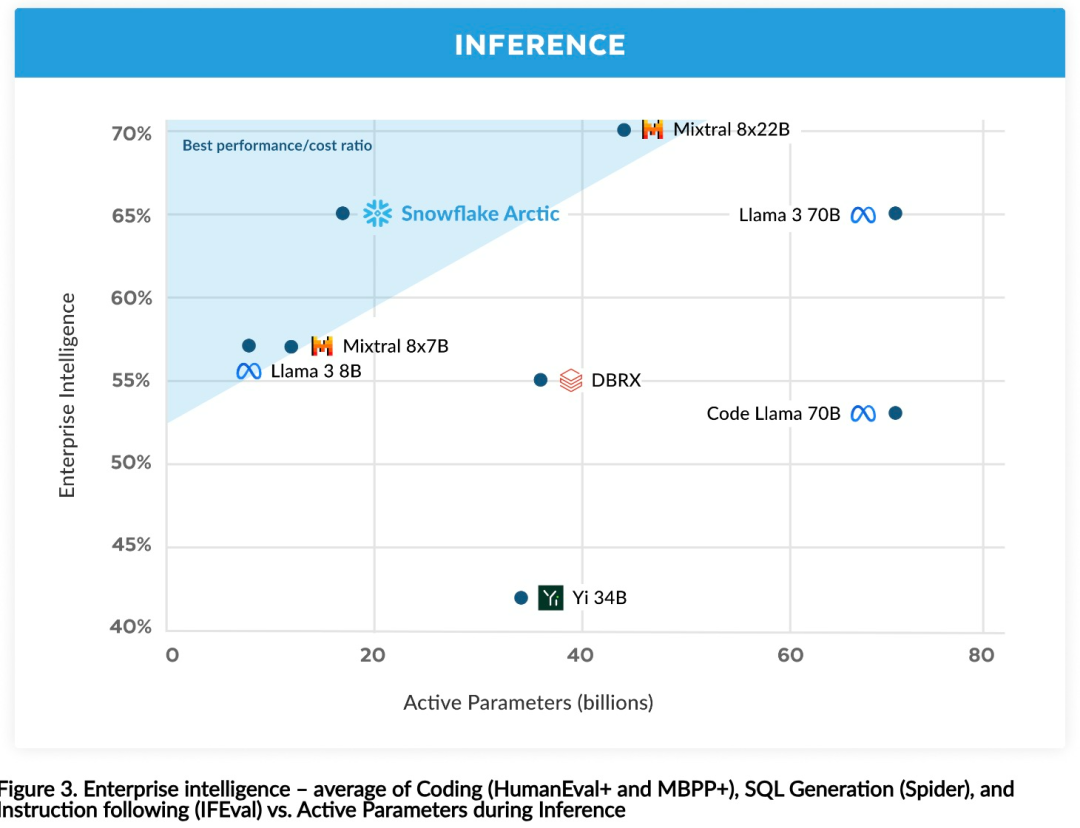

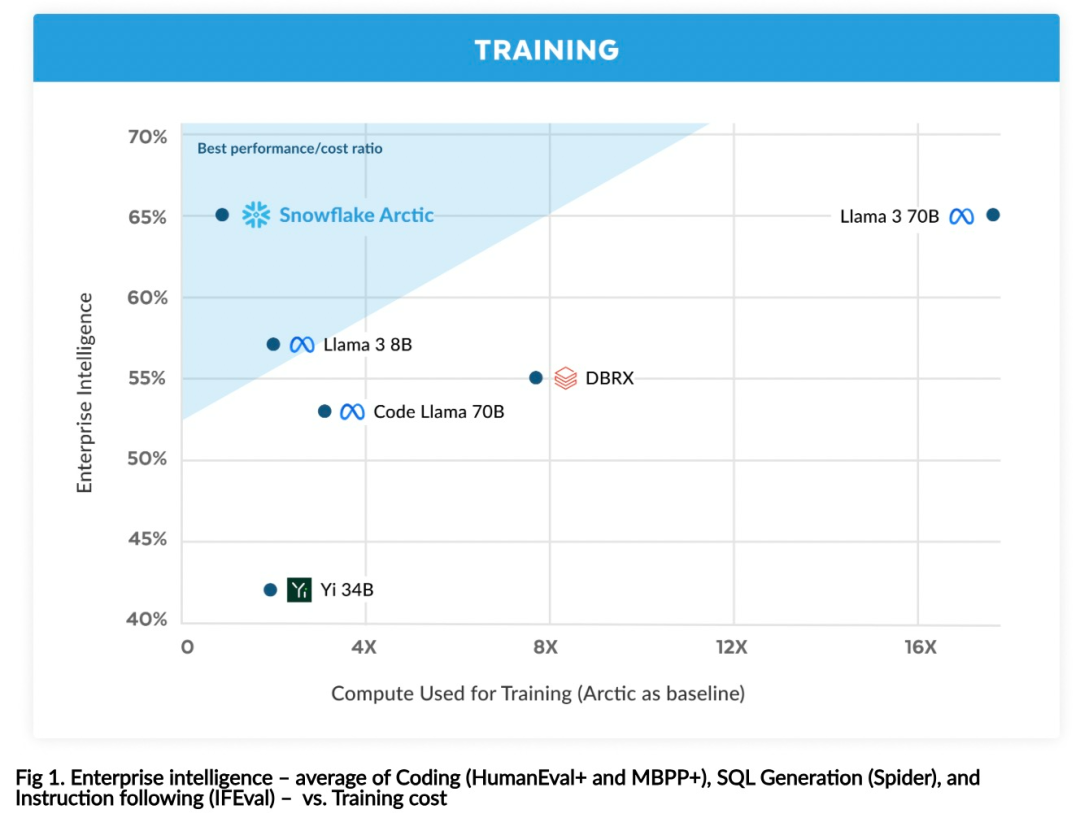

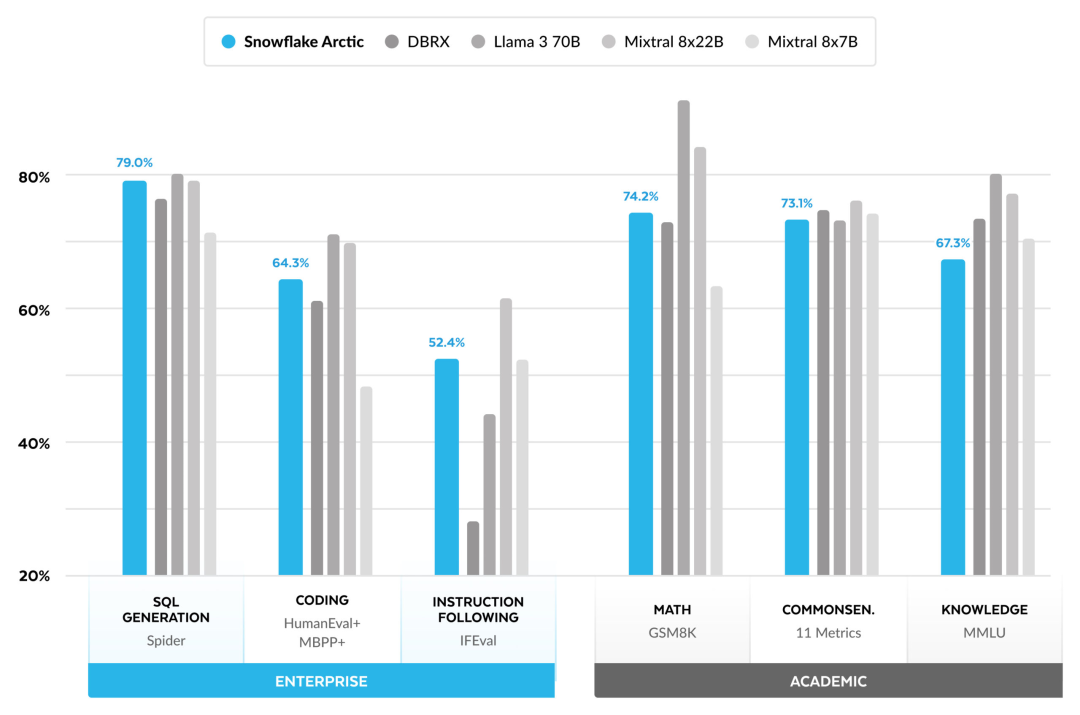

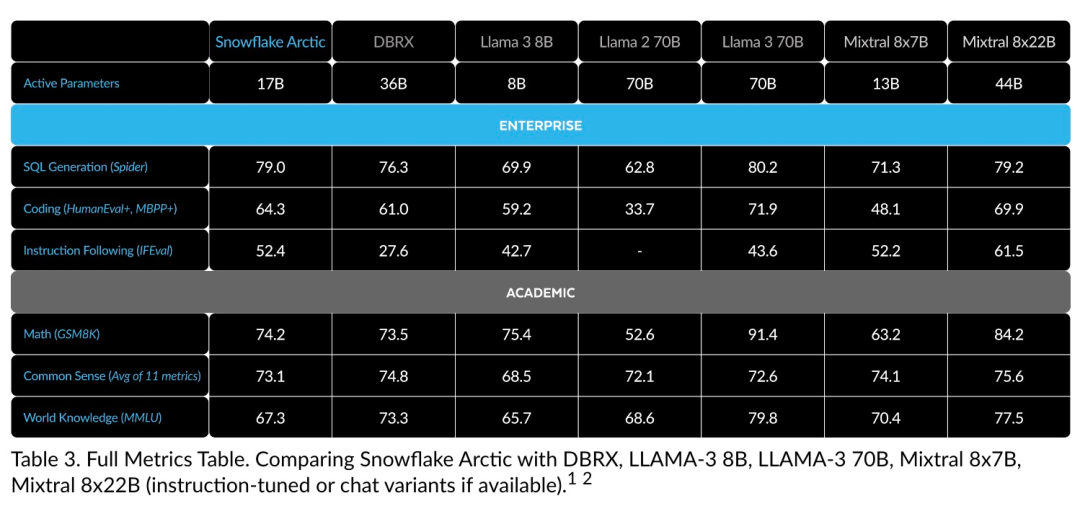

Hugging Face で北極モデルにアクセスできるようになりました。 Snowflake 氏は次のように述べています。ユーザーは、Snowflake Cortex、AWS、Microsoft Azure、NVIDIA API、Lamini、Perplexity、Replicate and Together などを含む多くのモデル ライブラリを通じて間もなくそれを入手できるようになります。 ハグフェイス: https://huggingface.co/Snowflake/snowflake-arctic-instruct北極コンテキスト ウィンドウは 4K に設定されており、研究チームはアテンション シンクに基づくスライディング ウィンドウの実装を開発中です。これにより、今後数週間で無制限のシーケンス生成がサポートされ、近い将来には 32K アテンション ウィンドウに拡張される予定です。 Snowflake の研究チームは企業顧客の AI を活用しています要件とユースケースには一貫したパターンが見られます。企業は、LLM を使用して会話型 SQL データ コパイロット、コード コパイロット、RAG チャットボットを構築したいと考えています。 これは、LLM が SQL、コードに優れ、複雑な命令に従い、具体的な応答を生成する必要があることを意味します。 Snowflake は、エンコード (HumanEval および MBPP)、SQL 生成 (Spider)、および命令追従 (IFEval) のパフォーマンス レベルを平均化することで、これらの機能を「Enterprise Intelligence」と呼ばれる単一のメトリクスに結合します。 Arctic は、オープンソース LLM の「エンタープライズ インテリジェンス」のトップ レベルに達し、トレーニング コンピューティング コストは約 200 万ドル未満 (3,000 GPU 週未満) で実現します。状況下で。これは、Arctic が同様の計算コストでトレーニングされた他のオープンソース モデルよりも高性能であることを意味します。 #さらに重要なのは、はるかに高い計算コストでトレーニングされたモデルと比較しても、Arctic はエンタープライズ インテリジェンスにおいて優れていることです。 Arctic の高いトレーニング効率は、Snowflake の顧客と AI コミュニティ全体がよりコスト効率よくカスタム モデルをトレーニングできることを意味します。 図 1 に示すように、Arctic はエンタープライズ インテリジェンス メトリクスにおいて LLAMA 3 8B および LLAMA 2 70B と同等でありながら、トレーニング コンピューティング コストの半分未満を使用しています。また、Arctic は、コンピューティング コストが 1/17 倍しか使用していないにもかかわらず、エンコーディング (HumanEval および MBPP)、SQL (Spider)、命令追従 (IFEval) などの指標において Llama3 70B に匹敵します。つまり、Arctic は全体的なパフォーマンスの競争力を維持しています。 . これも同時に行いました。 さらに、Snowflake は世界の知識、常識的推論、数学的能力を含む学術的なベンチマークに基づいて北極を評価しました。完全な評価結果は以下のとおりです。図に示すように: ##トレーニング効率

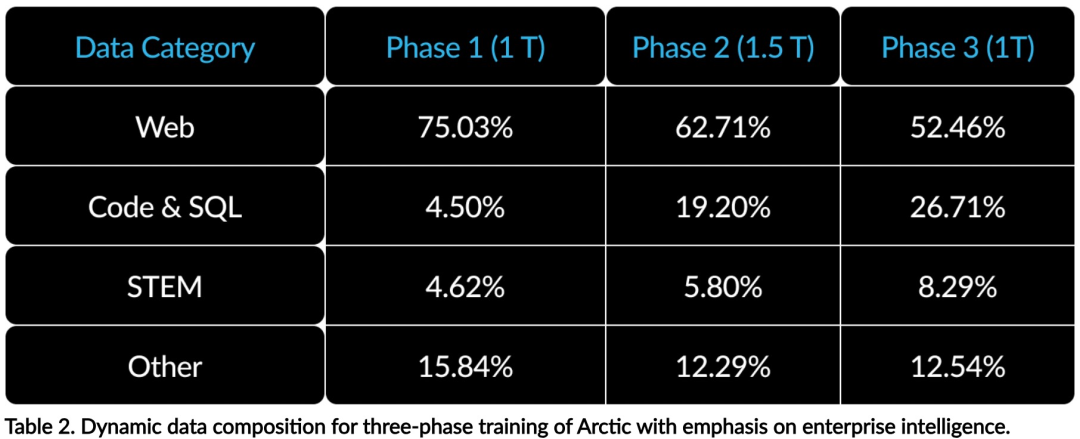

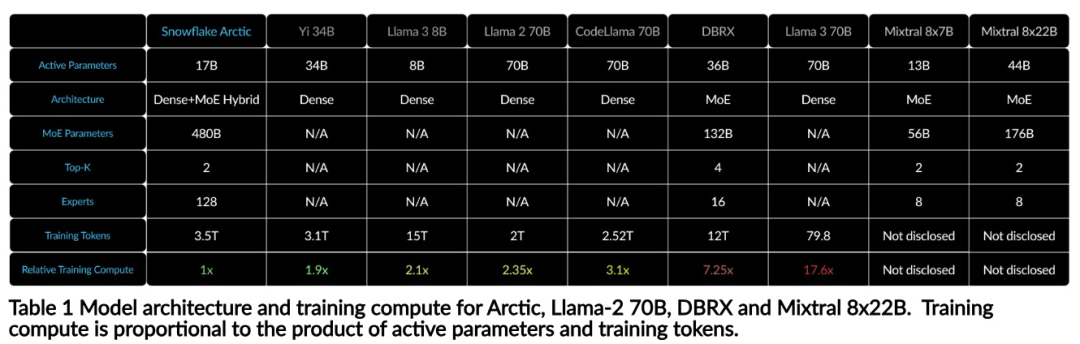

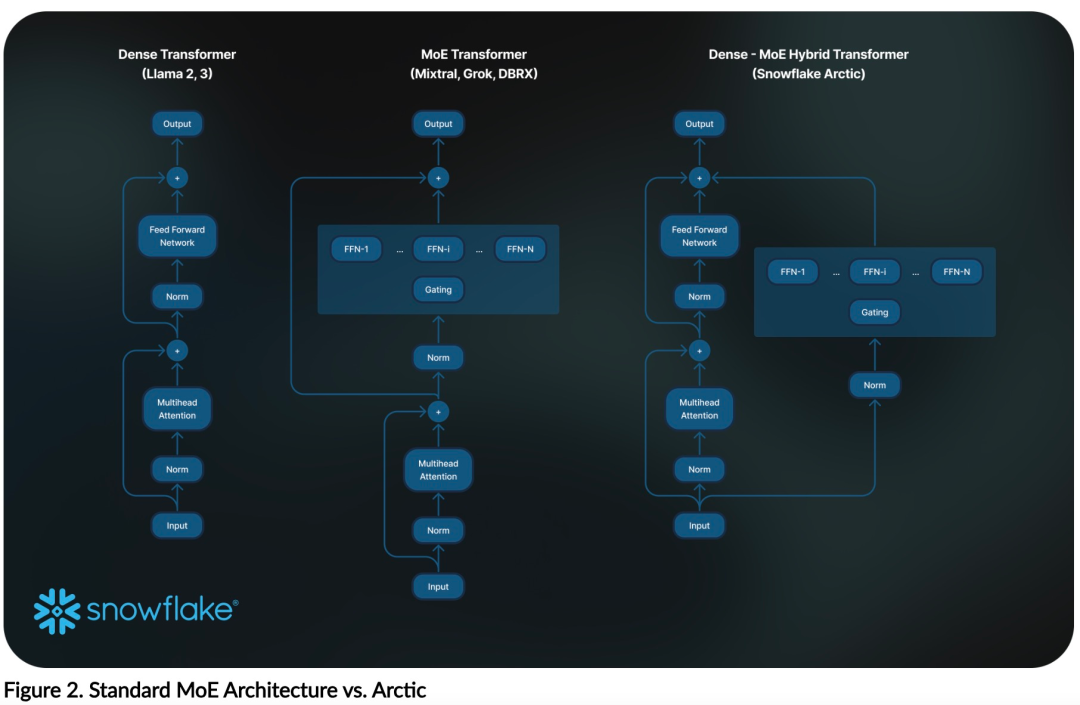

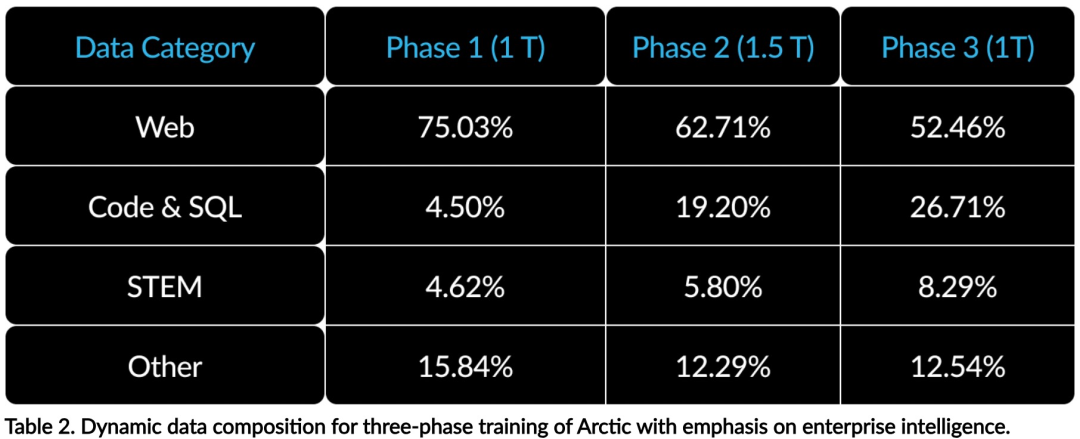

上記のトレーニング効率を達成するために、Arctic は独自の Dense-MoE ハイブリッド変圧器アーキテクチャを使用しています。これは、10B の高密度トランス モデルと 128×3.66B の残留 MoE MLP を組み合わせ、合計 480B のパラメータと 17B のアクティブ パラメータを備え、選択にトップ 2 ゲートを使用します。北極の設計と訓練に際し、研究チームは次の 3 つの重要な洞察と革新を利用しました: MoE の専門家には多数の専門家がおり、圧縮技術を採用2021 年末、DeepSpeed チームは MoE が自己回帰に適用できることを証明しました。 LLM を使用することで、計算コストを増加させることなくモデルの品質を大幅に向上させます。北極を設計する際、研究チームは、この考えに基づいて、モデルの品質の向上は主に専門家の数とMoEモデルのパラメータの総数、およびこれらの専門家の組み合わせの数に依存することに気づきました。 これに基づいて、Arctic は 128 人のきめ細かい専門家に 480B のパラメーターを分配し、トップ 2 のゲートを使用して 17B のアクティブなパラメーターを選択するように設計されています。 強力な AI トレーニング ハードウェアでのトレーニングには、多数の専門家を含む基本的な MoE アーキテクチャは、専門家間の完全に接続された通信のオーバーヘッドが高いため、非常に非効率的です。 Snowflake は、通信が計算と重複できれば、このオーバーヘッドを排除できることを発見しました。 したがって、Arctic は高密度トランスフォーマーと残留 MoE コンポーネント (図 2) を組み合わせて通信を介してオーバーラップを計算し、トレーニング システムが良好なトレーニング効率を達成し、通信を隠蔽できるようにします。オーバーヘッド。 #エンタープライズ データに焦点を当てたコース学習コード生成とエンタープライズ レベルの学習SQL メトリクスに優れるには、一般的なメトリクスとはまったく異なる種類のデータ カリキュラムの学習が必要です。何百もの小規模なアブレーション実験を通じて、チームは、常識的な推論などの一般的なスキルは初期段階で学習できる一方で、コーディング、数学、SQL などのより複雑な指標は後で効果的に学習できることを学びました。研修中。

#これは、簡単なものから難しいものまで徐々に能力を身につけていく、人間の人生教育にたとえることができます。そのため、Arctic では 3 段階のカリキュラムを採用しており、各段階でデータ構成が異なり、最初の段階では一般スキル (1T トークン) に重点を置き、最後の 2 段階ではエンタープライズ スキル (1.5T および 1T トークン) に重点を置いています。  #推論効率推論効率はモデル効率の重要な側面でもあり、影響を与えます。モデルが低コストで現実的に導入できるかどうか。

#推論効率推論効率はモデル効率の重要な側面でもあり、影響を与えます。モデルが低コストで現実的に導入できるかどうか。  Arctic は、他のオープンソース回帰 MoE モデルよりも多くの専門家と総パラメーターを使用して、MoE モデルの規模が飛躍的に向上したことを示しています。したがって、Snowflake には、Arctic が効率的に推論できるようにするためのいくつかの革新的なアイデアが必要です。

Arctic は、他のオープンソース回帰 MoE モデルよりも多くの専門家と総パラメーターを使用して、MoE モデルの規模が飛躍的に向上したことを示しています。したがって、Snowflake には、Arctic が効率的に推論できるようにするためのいくつかの革新的なアイデアが必要です。

#a) バッチ サイズ 1 など、小さなバッチ サイズでの対話型推論では、 MoE モデルの推論レイテンシは、すべてのアクティブなパラメータを読み取る時間によって制限され、推論はメモリ帯域幅によって制限されます。このバッチ サイズでは、Arctic (アクティブ パラメーター 17B) のメモリ読み取り量は Code-Llama 70B のわずか 1/4、Mixtral 8x22B (アクティブ パラメーター 44B) の 2/5 となり、推論速度が速くなります。

b) バッチ サイズが大幅に増加すると (各フォワード パスで数千のトークンが増加するなど)、Arctic はメモリ帯域幅の制限から計算上の制限に変化し、推論がアクティブな制限に影響を受けます。各トークンのパラメータ。この点で、Arctic の計算量は CodeLlama 70B および Llama 3 70B の 1/4 です。

北極の少数のアクティブなパラメーターに一致するコンピューティング限定の推論と高スループットを実現するには、より大きなバッチ サイズが必要です。これを達成するには、それをサポートするのに十分な KV キャッシュと、モデルのほぼ 500B のパラメーターを保存するのに十分なメモリが必要です。

困難ではありますが、Snowflake は 2 つのノードを使用して推論を実行し、FP8 の重み、分割ヒューズと連続バッチ処理、ノード内テンソル並列処理、およびノードを組み合わせます。これはシステムの最適化によって実現されます。パイプライン間の並列処理など。

研究チームは、NVIDIA と緊密に連携して、TensorRT-LLM を利用した NVIDIA NIM マイクロサービスの推論を最適化してきました。同時に、研究チームは vLLM コミュニティとも協力しており、社内の開発チームも今後数週間以内にエンタープライズ ユースケース向けに Arctic の効率的な推論を実装する予定です。

参考リンク:https://www.snowflake.com/blog/arctic-open-efficient-foundation- language-models-snowflake/

以上がLlama3 のトレーニング コストがわずか 1/17 の Snowflake オープンソース 128x3B MoE モデルの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

#推論効率

#推論効率