4 月 2 日のニュースによると、メディア報道によると、Apple の研究チームは最近の論文で、デバイス側で実行できるモデル ReALM を提案したと主張しました。このモデルはいくつかの点で GPT を超える可能性があります。

ReALM のパラメータはそれぞれ 80M、250M、1B、3B で、非常に小さいため、携帯電話、タブレット、その他のデバイスでの実行に適しています。

ReALM は主に、テキスト内で言及されているさまざまなエンティティ (名前、場所、組織など) 間の参照関係を AI が識別できるようにするプロセスを研究しています。

この文書では、エンティティを 3 つのタイプに分類しています。

オンスクリーン エンティティ: ユーザーの画面に現在表示されているコンテンツを指します。

会話エンティティ: 対話に関連するコンテンツを指します。たとえば、ユーザーが「お母さんに電話して」と言った場合、お母さんの連絡先情報が会話エンティティになります。

背景エンティティ: 再生中の音楽やこれから鳴るアラームなど、ユーザーの現在の操作や画面に表示されるコンテンツに直接関係しない可能性のあるエンティティを指します。

この論文では、大規模な言語モデルはさまざまなタスクで非常に優れていることが証明されているものの、非会話エンティティ (画面エンティティや背景エンティティなど) の参照問題を解決するために使用する場合には限界があると述べています。 ). その可能性はまだ十分に活用されていません。

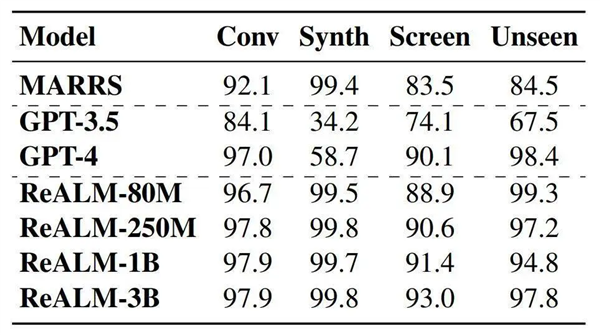

そして、ReALM はまったく新しい手法であり、そのパフォーマンスを GPT-3.5 および GPT-4 と比較すると、最小モデルのパフォーマンスは GPT-4 に匹敵し、より大きなモデルのパフォーマンスは大幅に向上することがわかります。 GPT-4を超えています。

この研究は、Apple デバイスの Siri アシスタントを改善するために使用され、Siri がユーザーのクエリのコンテキストをよりよく理解して処理できるようにするために使用されることが期待されています。

以上がAppleのAI増幅の動き!デバイス側モデルのパフォーマンスが GPT-4 よりも優れていると主張の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。