2023 年、AI 大型モデルの分野で有力なプレーヤーである Transformer の地位が挑戦され始めます。 「Mamba」と呼ばれる新しいアーキテクチャが登場しました。これは、言語モデリングの点で Transformer に匹敵し、さらにはそれを超える可能性がある選択的状態空間モデルです。同時に、Mamba はコンテキストの長さが増加するにつれて線形スケーリングを実現できるため、100 万ワード長のシーケンスを処理でき、実際のデータを処理する際の推論スループットが 5 倍向上します。この画期的な性能向上は目を引くものであり、AI分野の発展に新たな可能性をもたらします。

リリースから 1 か月以上経ち、Mamba は徐々にその影響力を発揮し始め、MoE-Mamba、Vision Mamba、VMamba、U-Mamba、MambaByte などの多くのプロジェクトを生み出しました。 . . Mamba は、Transformer の欠点を継続的に克服する大きな可能性を示しています。これらの開発は、Mamba の継続的な開発と進歩を示しており、人工知能の分野に新たな可能性をもたらしています。

しかし、この新進気鋭の「スター」は、2024 年の ICLR 会議で挫折に遭遇しました。最新の公開結果によると、マンバの論文はまだ保留中であるが、決定待ちの欄にその名前が表示されるだけで、延期されたのか却下されたのかは判断できない。

全体的に、Mamba は 4 人のレビュアーからそれぞれ 8/8/6/3 の評価を受けました。これほどの評価を受けたにもかかわらず拒否されるのは本当に不可解だという人もいた。

その理由を理解するには、低いスコアを付けた査読者のコメントを確認する必要があります。

論文レビュー ページ: https://openreview.net/forum?id=AL1fq05o7H

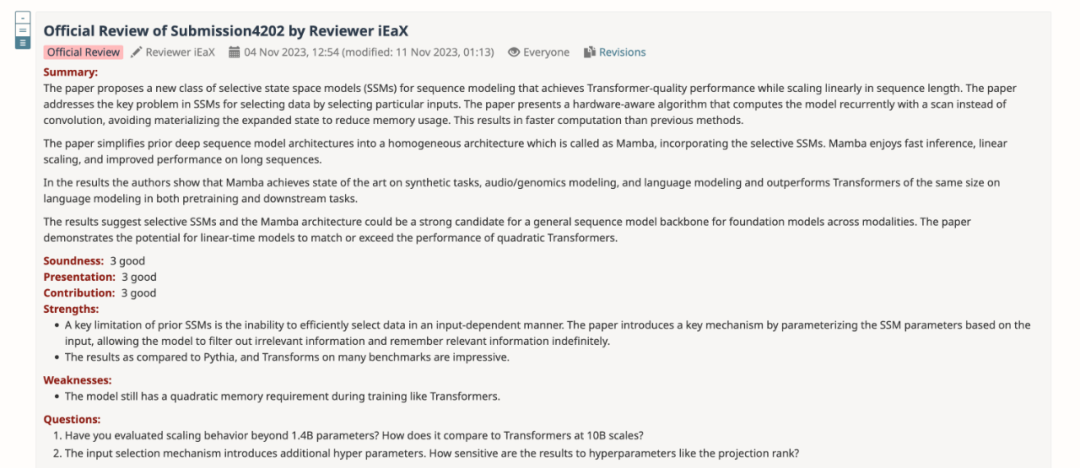

レビューのフィードバックで、「3: 拒否、十分ではない」というスコアを付けたレビューアーは、Mamba に関するいくつかの意見を説明しました:

モデル設計についての考え:

実験に関する考察:

さらに、別のレビュー担当者も Mamba の欠点を指摘しました。モデルには、Transformers と同様に、トレーニング中に依然として二次メモリが必要です。

すべての査読者の意見を要約した後、著者チームも論文の内容を改訂および改善し、新しい実験結果と追加を追加しました。分析:

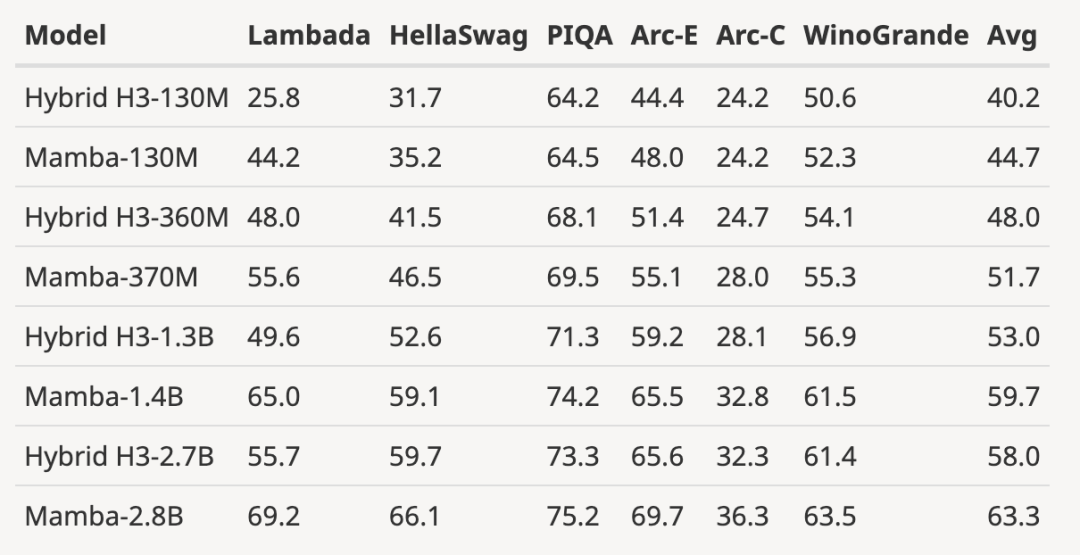

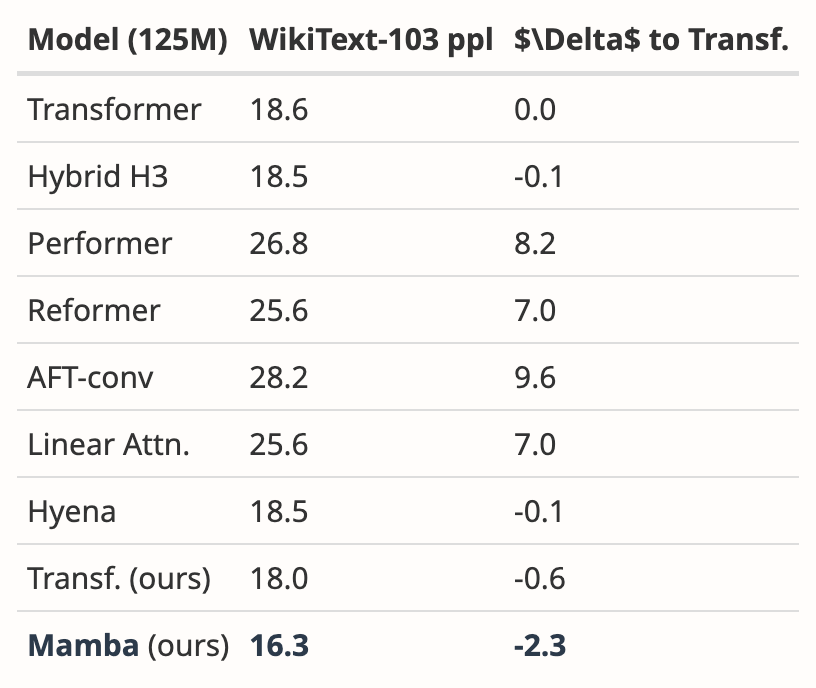

著者はサイズを 125M-2.7 Pretrained にダウンロードしましたB パラメータを使用して H3 モデルを作成し、一連の評価を実行しました。 Mamba はすべての言語評価において大幅に優れており、これらの H3 モデルは二次注意を使用したハイブリッド モデルであるのに対し、線形時間 Mamba 層のみを使用した著者の純粋なモデルはすべての指標において大幅に優れていることに注目する価値があります。

事前学習済み H3 モデルとの評価比較は次のとおりです:

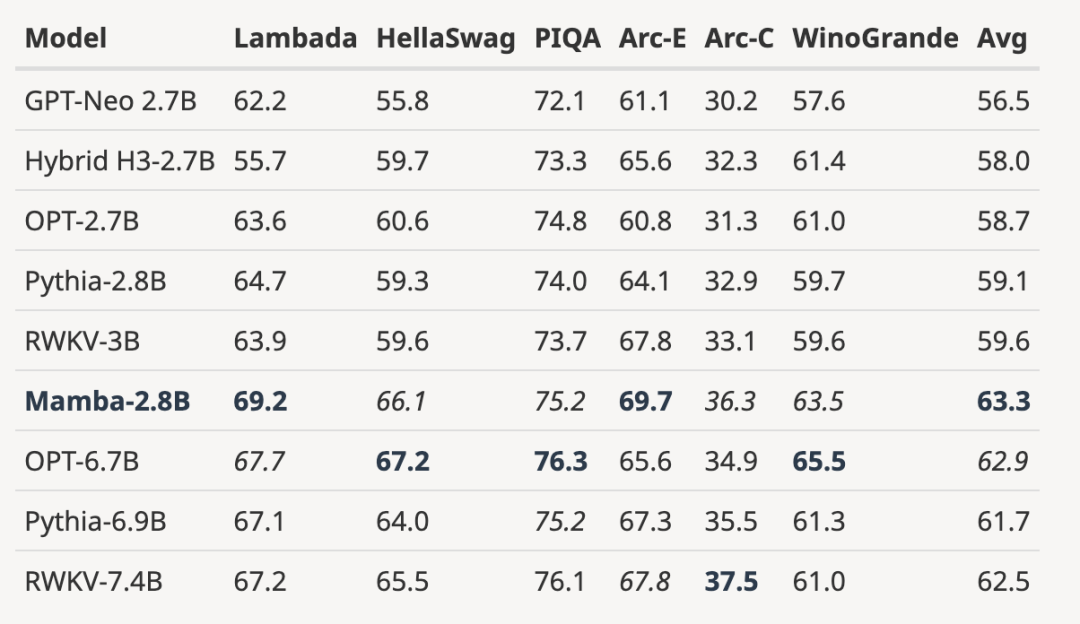

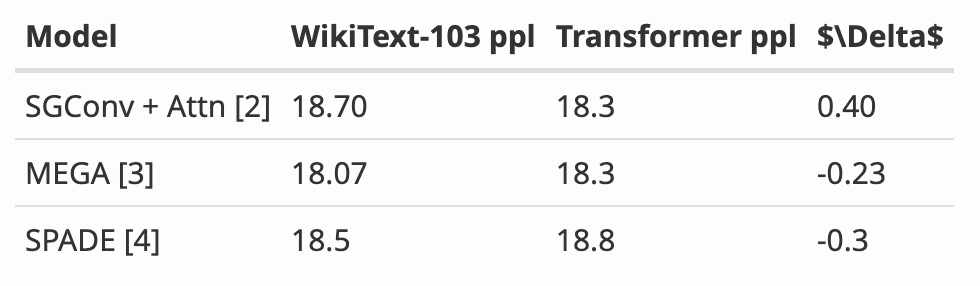

下の図に示すように、同じ数値に基づいてトレーニングされた 3B オープンソースを使用します。トークン数(300B) モデルと比較して、すべての評価結果において Mamba が優れています。これは 7B スケール モデルにも匹敵します。Mamba (2.8B) を OPT、Pythia、および RWKV (7B) と比較すると、Mamba がすべてのベンチマーク スコアで最高の平均スコアと最高/2 位を達成しています。

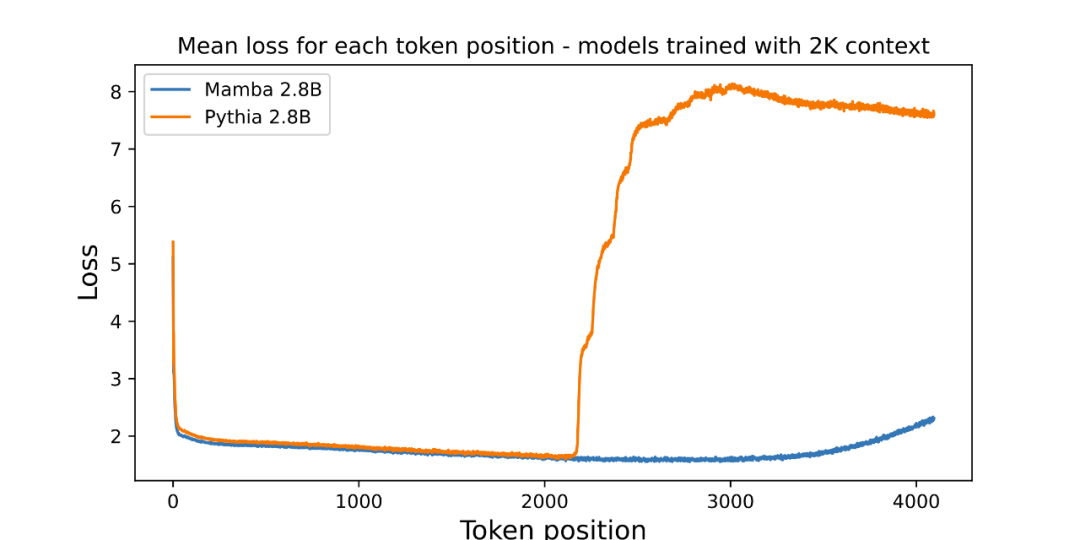

画像位置ごとの平均損失 (対数の可読性) が にプロットされています。最初のトークンにはコンテキストがないため、混乱度は高くなりますが、Mamba とベースライン Transformer (Pythia) の両方の混乱度は、コンテキストの長さ (2048) でトレーニングする前に増加します。興味深いことに、Mamba の可解決性は、トレーニング コンテキストを超えて、最大約 3000 の長さまで大幅に向上します。

画像位置ごとの平均損失 (対数の可読性) が にプロットされています。最初のトークンにはコンテキストがないため、混乱度は高くなりますが、Mamba とベースライン Transformer (Pythia) の両方の混乱度は、コンテキストの長さ (2048) でトレーニングする前に増加します。興味深いことに、Mamba の可解決性は、トレーニング コンテキストを超えて、最大約 3000 の長さまで大幅に向上します。

著者は、長さの外挿がこの記事のモデルの直接的な動機ではなく、追加の機能として扱っていることを強調しています。

ここでのベースライン モデル (Pythia) は長さの外挿を念頭に置いてトレーニングされていないため、より一般的な他の Transformer バリアント (T5 や Alibi 相対位置エンコーディングなど) が存在する可能性があります。相対位置エンコーディングを使用して Pile でトレーニングされたオープン ソース 3B モデルが見つからないため、この比較はできません。

主要な AI トップカンファレンスでは、「投稿数の爆発的増加」が頭の痛い問題であるため、査読者のエネルギーは必然的に限られます。間違い。これにより、YOLO、transformer XL、Dropout、サポート ベクター マシン (SVM)、知識蒸留、SIFT、Google 検索エンジンの Web ページ ランキング アルゴリズム PageRank など、歴史上の多くの有名な論文が拒否されることになりました (「有名な YOLO と PageRank」を参照)影響力のある研究が最高の CS 会議によって拒否されました。」)

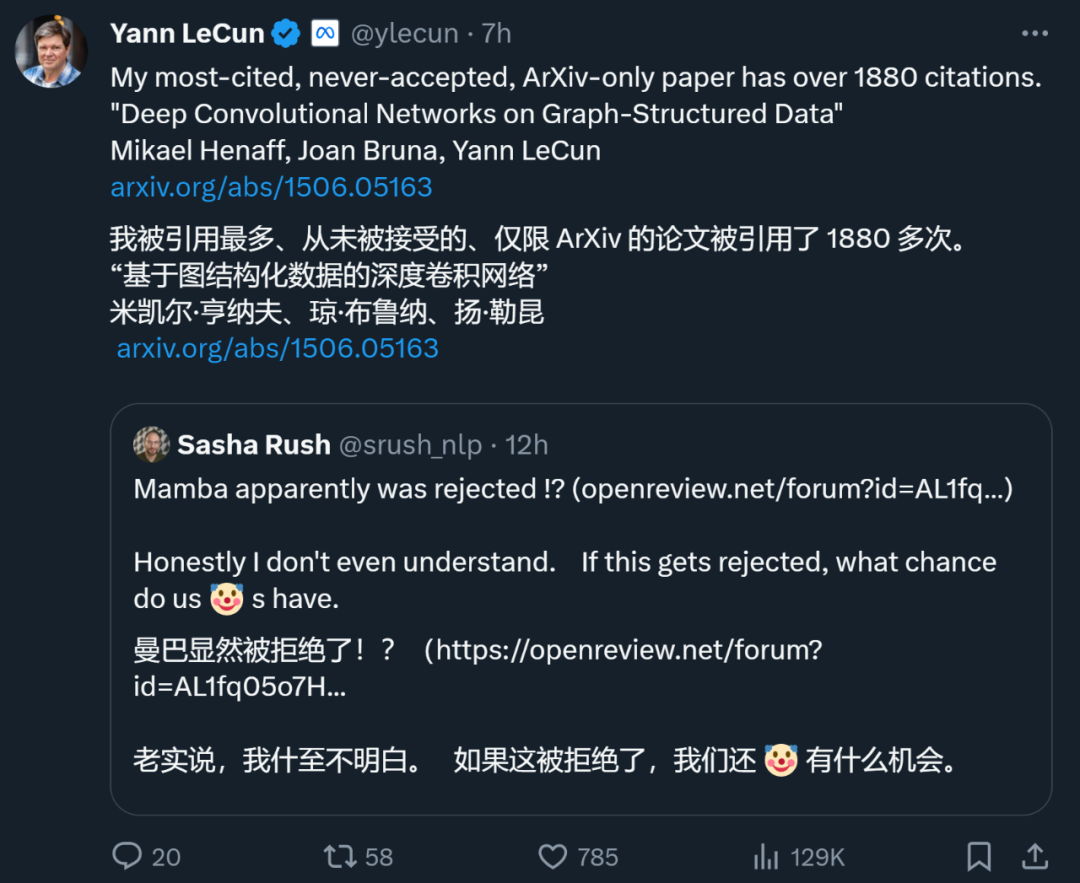

ディープラーニングの三大巨頭の一人であるヤン・ルカン氏ですら、断られることの多い大手製紙メーカーでもあります。たった今、同氏は、1887回引用されている論文「グラフ構造データに関する深層畳み込みネットワーク」もトップカンファレンスで拒否されたとツイートした。

ICML 2022 の期間中、彼は「3 つの論文を投稿し、3 つが拒否された」ことさえありました。

したがって、論文がトップカンファレンスで拒否されたからといって、その論文に価値がないというわけではありません。上記で拒否された論文の中には、他の学会への移籍を選択した論文も多く、最終的には採択されました。そのため、ネチズンはマンバに対し、陳丹祁などの若い学者が設立したCOLMに切り替えるよう提案した。 COLM は言語モデリング研究に特化した学術会場であり、言語モデル テクノロジの開発の理解、改善、コメントに重点を置いており、Mamba のような論文にはより良い選択となる可能性があります。

しかし、Mamba が最終的に ICLR に受け入れられるかどうかに関係なく、Mamba は影響力のある作品となり、コミュニティに突破口を見せることができました。のトランスフォーマー シャックルは、従来のトランスフォーマー モデルを超えた探求に新たな活力を注入しました。

以上がなぜ ICLR はマンバの論文を受け入れなかったのでしょうか? AIコミュニティが大きな議論を巻き起こしたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。