大規模な生成モデルは、過去 2 年間で自然言語処理、さらにはコンピューター ビジョンに大きな進歩をもたらしました。最近、この傾向は強化学習、特に決定変換 (DT)[1]、軌道変換 (TT)[2]、Gato[3]、ディフューザー [4] などのオフライン強化学習 (オフライン RL) にも影響を与えています。この手法では、強化学習データ (状態、行動、報酬、復帰など) を非構造化された一連のシーケンス データとみなして、これらのシーケンス データを学習の中核タスクとしてモデル化します。これらのモデルは、教師ありまたは自己教師ありの学習方法を使用してトレーニングでき、従来の強化学習における不安定な勾配信号を回避できます。複雑なポリシー改善および値推定手法を使用しても、オフライン強化学習で非常に優れたパフォーマンスを示します。

この記事では、シーケンス モデリングに基づくこれらの強化学習手法について簡単に説明し、次の記事では、新しく提案されたベクトル量子化変分を使用する Trajectory Autoencoding Planner (TAP) について紹介します。 AutoEncoder (VQ-VAE) は、潜在アクション空間におけるシーケンス モデリングと効率的な計画のための手法です。

Transformer アーキテクチャ [5] は 2017 年に提案され、ゆっくりと自然言語処理の革命を引き起こしました。その後の BERT と GPT-3 は徐々に自己教師型 Transformer の組み合わせは、新たな高みに押し上げられ続けており、自然言語処理の分野では少数ショット学習などの特性が出現し続けていますが、コンピューター ビジョンなどの分野にも広がり始めています [6][7] ] 。

ただし、強化学習の場合、このプロセスは 2021 年までは特に明らかではないようです。 2018 年には、マルチヘッド アテンション メカニズムも強化学習に導入されました [8]。このタイプの研究は基本的に、強化学習の一般化の問題を解決するために、半記号 (サブシンボリック) と同様の分野に適用されます。それ以来、そのような試みは鈍いものとなった。筆者の個人的な経験によれば、実はTransformerは強化学習において安定した圧倒的な優位性を示しておらず、訓練も難しい。 20 年ぶりの強化学習に Relational GCN を使用した研究 [9] の 1 つでは、舞台裏で Transformer を実際に試しましたが、基本的に従来の構造 (CNN に似た) よりもはるかに劣っており、安定して学習し、学習するのが困難でした。使用可能なポリシーを取得します。なぜ Transformer が従来のオンライン強化学習 (オンライン RL) と互換性がないのかはまだ未解決の問題ですが、たとえば Melo [10] は、従来の Transformer のパラメータ初期化が強化学習に適していないためであると説明しています。さらにここで。

2021 年半ば、Decision Transformer (DT) と Trajectory Transformer (TT) のリリースにより、RL での Transformer アプリケーションの新たな波が始まりました。これら 2 つの研究のアイデアは実際には非常に単純です。Transformer とオンライン強化学習アルゴリズムにあまり互換性がない場合、強化学習を単純に自己教師あり学習タスクとして扱ってはどうでしょうか?オフライン強化学習の概念も非常に人気があるという事実を利用して、これらの研究は両方とも、主要なターゲット タスクをオフライン データセットのモデリングに固定し、このシーケンス モデルを制御と意思決定に使用しています。

強化学習の場合、いわゆるシーケンスは状態 (state) s、アクション (action)  、報酬 (reward) r およびvalue ( value) v

、報酬 (reward) r およびvalue ( value) v  で構成される軌跡。現在、この値は通常、モンテカルロ推定とみなせる return-to-go に置き換えられています。オフライン データセットはこれらの軌跡で構成されます。軌道の生成は、環境の力学と行動方針に関連しています。いわゆるシーケンス モデリングは、このシーケンスを生成する確率分布 (分布)、または厳密には条件付き確率の一部をモデル化することです。

で構成される軌跡。現在、この値は通常、モンテカルロ推定とみなせる return-to-go に置き換えられています。オフライン データセットはこれらの軌跡で構成されます。軌道の生成は、環境の力学と行動方針に関連しています。いわゆるシーケンス モデリングは、このシーケンスを生成する確率分布 (分布)、または厳密には条件付き確率の一部をモデル化することです。

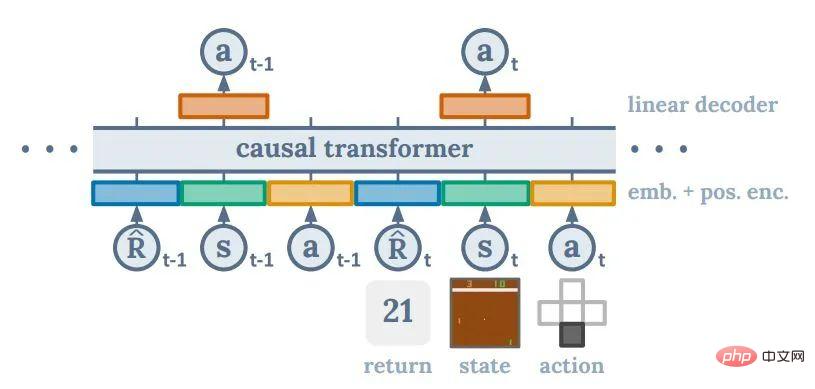

DT のアプローチは、過去のデータと値からアクション (リターン条件付きポリシー) へのマッピングをモデル化することです。これは、条件付き確率の数学的期待をモデル化することです。アクション。 #########。このアイデアは Upside Down RL [11] に非常に似ていますが、その背後にある直接の動機は、プロンプトに基づいてダウンストリーム タスクを完了する GPT2/3 の方法を模倣することである可能性が非常に高くなります。このアプローチの問題の 1 つは、最適な目標値を決定する体系的な方法がないことです。しかし、DT の作成者は、目標値がデータセット全体の中で最も高いリターンに設定されている場合でも、DT の最終的なパフォーマンスが非常に優れている可能性があることを発見しました。

Decision Transformer、図 1

強化学習 人間の感覚で言えば、DT のような手法で強力なパフォーマンスを達成できるというのは非常に直観に反します。 DQN やポリシー勾配などの手法がニューラル ネットワークを補間汎化に使用できるフィッティング関数としてしかみなすことができない場合、強化学習におけるポリシーの改善と評価は依然としてポリシー構築の中核となります。 DT は完全にニューラル ネットワークに基づいていると言えますが、非現実的である可能性のある高い目標値を適切なアクションに結び付けるプロセス全体は完全にブラック ボックスです。 DTの成功は強化学習の観点からは少々無理があるとも言えますが、それがこの種の実証研究の魅力だと思います。著者は、ニューラル ネットワーク (トランスフォーマー) の一般化能力が、RL コミュニティ全体のこれまでの期待を超える可能性があると信じています。

DT はすべてのシーケンス モデリング手法の中でも非常にシンプルであり、強化学習の中核となる問題のほぼすべてが Transformer 内で解決されます。このシンプルさが現在最も人気のある理由の1つです。ただし、そのブラックボックスの性質により、アルゴリズム設計レベルで多くの把握が失われ、従来の強化学習での成果の一部を強化学習に組み込むのは困難です。これらの結果の有効性は、いくつかの非常に大規模な実験 (AlphaGo、AlphaStar、VPT など) で繰り返し確認されています。

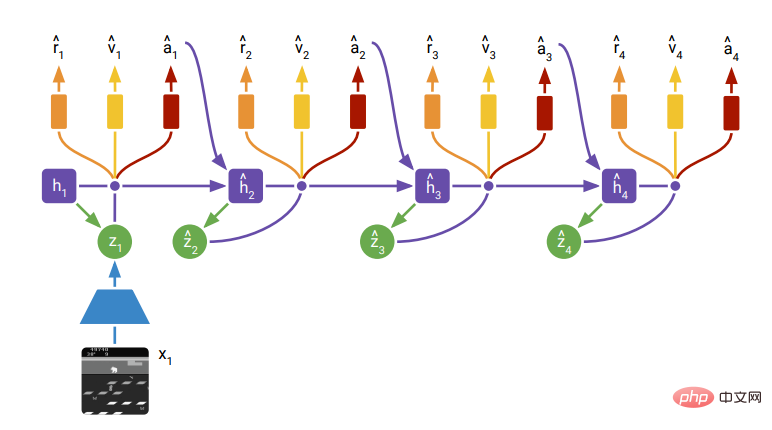

Trajectory TransformerTT のアプローチは、従来のモデルベースの強化学習 (モデルベース RL) 計画手法によく似ています。モデリングに関しては、シーケンス全体の要素を離散化し、GPT-2 のような離散自己回帰手法を使用してオフライン データセット全体をモデル化します。これにより、特定のシーケンスからリターンツーゴーを差し引いた継続をモデル化できます。 TT は後続のシーケンスの分布をモデル化するため、実際にはシーケンス生成モデルになります。 TT は、生成されたシーケンスの中でより良い値の推定を行うシーケンスを探すことにより、「最適な計画」を出力できます。最適なシーケンスを見つける方法として、TT は自然言語で一般的に使用される方法、つまりビーム探索の変形を使用します。基本的には、展開されたシーケンスの最適なシーケンス  部分を常に保持し、それらを基に次の最適なシーケンス セット

部分を常に保持し、それらを基に次の最適なシーケンス セット  を見つけることです。

を見つけることです。

強化学習の観点から見ると、TT は DT ほど型破りなものではありません。興味深いのは、(DT と同様に) 強化学習における元のマルコフ決定プロセスの因果グラフ構造を完全に放棄していることです。 PETS、ワールド モデル、dramerv2 などの以前のモデルベースの手法はすべて、マルコフ プロセス (または暗黙的マルコフ) におけるポリシー関数、伝達関数、報酬関数などの定義、つまり次の条件に従います。状態分布は前のステップの状態であり、アクション、報酬、値はすべて現在の状態によって決まります。強化学習コミュニティ全体は一般に、これによりサンプル効率が向上すると信じていますが、そのようなグラフ構造は実際には制約となる可能性があります。自然言語の分野における RNN から Transformer への移行、およびコンピューター ビジョンの分野における CNN から Transformer への移行は、実際に次のことを反映しています。データが増加するにつれて、ネットワークにグラフ構造を自力で学習させるほうが、よりパフォーマンスの高いモデルを取得するのに役立ちます。 。

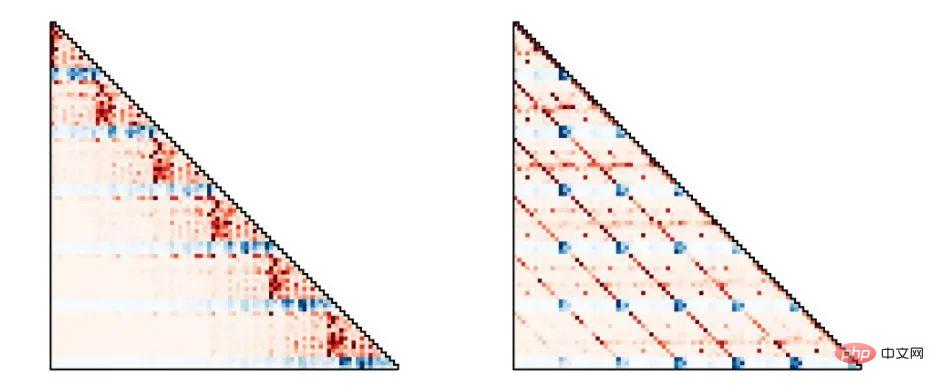

DreamerV2、図 3TT は基本的にすべてのシーケンス予測タスクを With Transformer、Transformer に引き渡すため、データからより柔軟に、より適切なグラフ構造を学習できるようになります。以下の図に示すように、TT によってモデル化された行動戦略は、さまざまなタスクとデータセットに応じてさまざまなグラフ構造を示します。図の左側は従来のマルコフ戦略に対応し、図の右側はアクション移動平均戦略に対応します。

#Trajectory Transformer、図 4

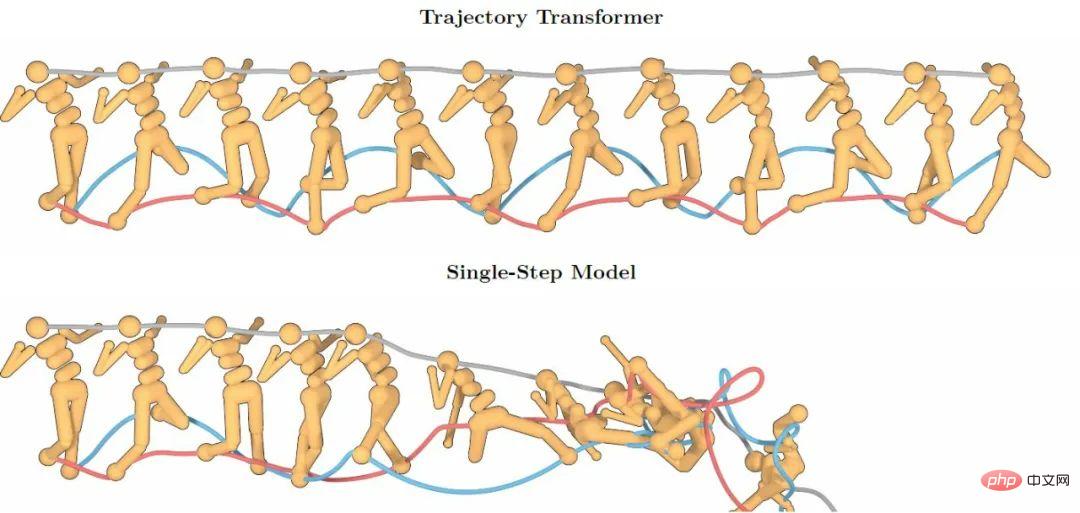

Transformer 強力なシーケンス モデリングの機能下の図は、100 ステップを超える TT の予測が依然として高い精度を維持しているのに対し、マルコフ特性に従う単一ステップ予測モデルは、予測誤差の重ね合わせの問題によりすぐに崩壊することを示しています。

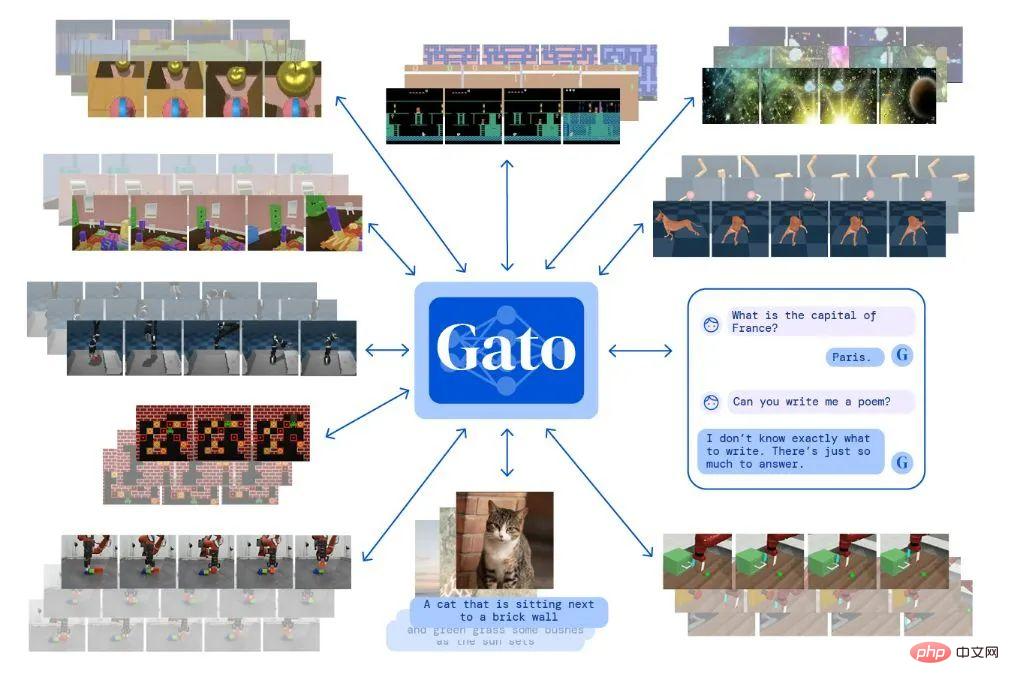

TT ただし、特定のモデリングと予測の点で従来の方法とは異なります。それは異なりますが、それが提供する予測能力は、将来的に強化学習に統合される他の結果への優れた出発点を残します。ただし、TT には予測速度という重要な問題があります: シーケンス全体の分布をモデル化する必要があるため、シーケンス内のすべての要素が次元に従って離散化されます。これは、100 次元の状態がシーケンス内の 100 個の要素を占有する必要があることを意味します。 . 位置にあるため、モデル化されるシーケンスの実際の長さが特に長くなりやすくなります。 Transformer の場合、シーケンス長 N の計算複雑さは であり、TT からの将来予測のサンプリングに非常にコストがかかります。 100 次元未満のタスク TT であっても、ワンステップの判断に数秒から数十秒を要するため、リアルタイムのロボット制御やオンライン学習に導入することは困難です。  Gato

Gato

その他のシーケンス生成モデル:拡散モデル

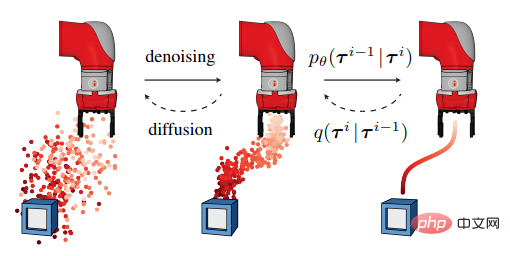

ディフューザーは TT よりも柔軟性が高く、開始点と終了点を設定しながらモデルに中間パスを埋めることができるため、(報酬を最大化するのではなく) 目標主導型の関数制御を行うことができます。また、複数の目標と目標を達成するための先験的な条件を組み合わせて、モデルがタスクを完了できるようにすることもできます。

##ディフューザー 図 1ディフューザーも、従来の強化学習モデルと比較して非常に破壊的です。計画は時間軸上で徐々に展開していくのではなく、全体の流れという意味では漠然としたものから徐々に正確になっていきます。拡散モデル自体のさらなる研究もコンピュータ ビジョンの注目のテーマであり、今後数年以内にモデル自体にブレークスルーが起こる可能性があります。

しかし、現状では普及モデル自体が他の世代モデルに比べて生成速度が遅いという特殊な欠陥を抱えています。関連分野の多くの専門家は、この問題は今後数年間で緩和される可能性があると考えています。ただし、強化学習でリアルタイム制御が必要なシナリオでは、数秒という生成時間は現時点では受け入れがたいものです。 Diffuser は生成速度を向上させる方法として、前のステップの計画に少量のノイズを追加して次のステップの計画を再生成する方法を提案しましたが、これを行うとモデルのパフォーマンスがある程度低下します。

以上がTransformer から Diffusion Model まで、シーケンス モデリングに基づく強化学習手法について 1 つの記事で学びますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。