ChatGPT をめぐる戦いは激化しています。

# 数週間前、Meta は 70 億から 650 億の範囲のパラメーターを備えた独自の大規模言語モデル LLaMA をリリースしました。

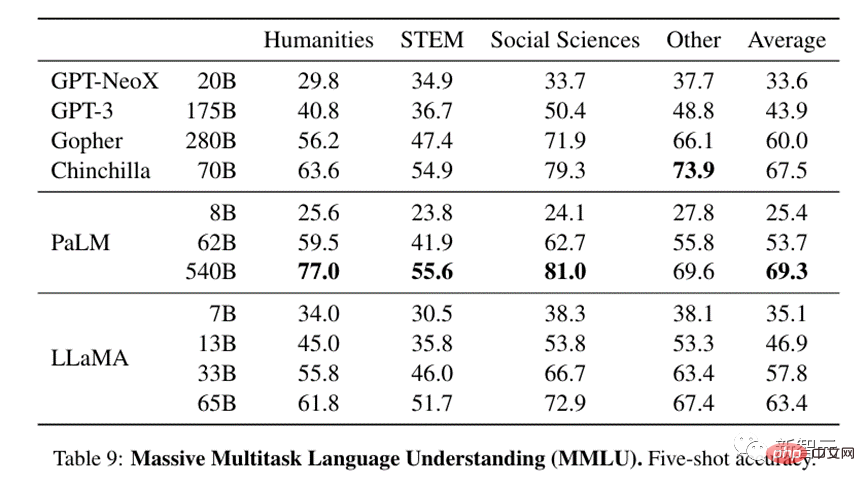

論文では、パラメータがわずか 1/10 の LLaMA (130 億) が、ほとんどのベンチマーク テストで GPT-3 を上回っています。

650 億のパラメータを持つ LLaMA の場合、DeepMind の Chinchilla (700 億のパラメータ) や Google の PaLM (5,400 億のパラメータ) に匹敵します。

#Meta は LLaMA がオープンソースであると主張していますが、研究者は依然として LLaMA を適用してレビューする必要があります。

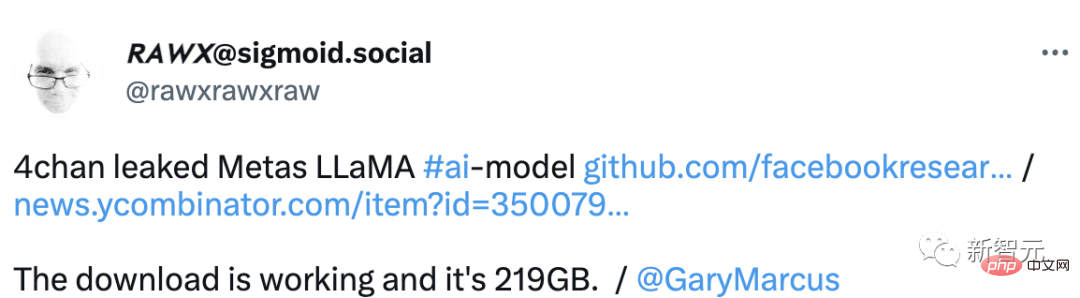

#しかし、予想外だったのは、リリースからわずか数日後に、LLaMA のモデルファイルが事前に流出したことです。

#それでは、問題は、これは意図的なものなのか、偶然なのかということです。

LLaMA は「オープンソース」の被害に遭いました。 ?最近、LLaMA の完成品ライブラリが海外フォーラム 4chan で流出しました。

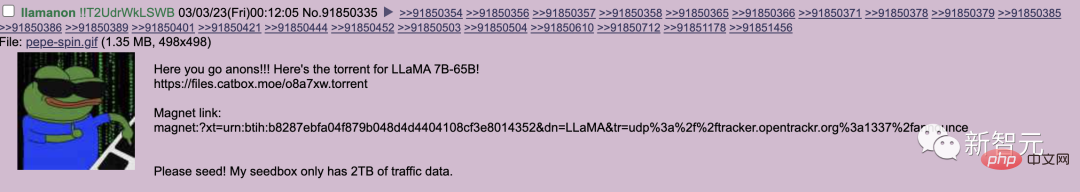

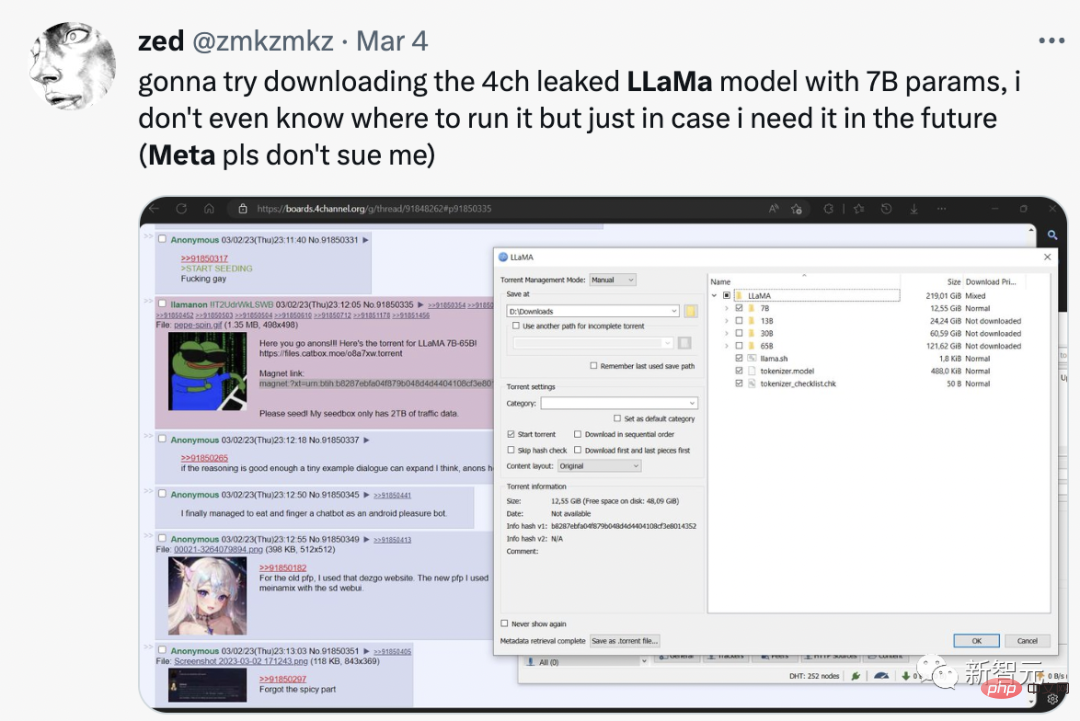

先週の木曜日、ユーザー llamanon が torrent (急流) リリース経由で 4chan の技術掲示板に投稿しました。 7Bと65BのLLaMAモデルの。

#このシード リンクは現在ブロックされています。 LLaMA の GitHub ページにアクセスします。

彼はまた、プロジェクトに 2 番目のプル リクエストを送信し、モデルの別の重みセットへのシード リンクを提供しました。

#現在、このプロジェクトは GitHub で 8,000 個のスターを獲得しています。

#しかし、漏洩者が犯す最大の間違いの 1 つは、漏洩したモデルに自分の一意の識別子コードを含めることです。

#このコードは、漏洩者を追跡するために特別に設計されており、ユーザーのラマノンの個人情報を危険にさらします。

# よく言われるように、LLaMA はオープンソースではなく、まともなものではありませんが、ネチズンのおかげでまともなものになるよう支援されています。

さらに、4chan のユーザーは、モデルを自分のワークステーションにデプロイしたい人のために便利なリソースを作成しました。

# および、より効率的な推論のためにモデルを取得し、それに変更された重みを追加する方法に関する配布チュートリアルのガイドを提供します。

#さらに、このリソースは、LLaMA をオンライン執筆プラットフォーム KoboldAI に統合する方法も提供します。

#Meta がこれを意図的に行ったのか、それとも偶然に漏洩したのか。ネットユーザーらは次々と意見を表明した。

あるネチズンの分析は非常に明白で、「Meta が OpenAI と戦うために意図的に漏洩したのではないか」とのことでした。 一部の顧客は、これがより良いモデルであり、年間 250,000 ドルでアクセスを販売するというビジネス プランの中心に当たると考えています。彼らのサービスに 1 か月アクセスすると、この漏洩モデルを実行できるマシンが購入されます。メタは、現在の大手ハイテクカルテルの安定を維持するために、潜在的な新興競争相手を弱体化させる。これはちょっとした陰謀論かもしれませんが、私たちは大きなテクノロジーと大きな陰謀の時代に生きています。 # 月曜日、Meta は、LLaMA が不正ユーザーに漏洩したにもかかわらず、認定された研究者に人工知能ツールをリリースし続けると発表しました。 一部のネチズンは、70 億のパラメーターを含む LLaMA をダウンロードしたと直接言いました。実行方法はわかりませんが、万が一に備えて入手できるとのことです。将来的には必要になります。

##LLaMA の漏洩とオープンソースは大きなイベントです:

Stable Diffusion はオープンソースです。 8 か月後、私たちは今、他人の心を読み取り、目に見えるものすべてを解読できるようになりました。

#LLM のオープンにより、私たちは本当にクレイジーなものを手に入れることになります。

LLaMA がリリースされて間もなく、ネチズンはこれを発見しました。最小のパラメータ モデルでも、実行するには 30 GB 近くの GPU が必要です。

# ただし、Bits および Bytes ライブラリによる浮動小数点の最適化により、単一の NVIDIA RTX 3060 上でモデルを実行することができました。

さらに、GitHub の研究者は、Ryzen 7900X CPU で LLM の 7B バージョンを実行して、1 秒あたり数ワードを推論することさえできました。

#それでは、LLaMA モデルとは一体何なのでしょうか?外国人がレビューしてました。

LLaMA は多くのテストで良好なパフォーマンスを示しました。

大規模なマルチタスク言語の理解という点では、比較的小さな 13B モデルでも、そのサイズである GPT-3 と同等です。 13回。

33B バージョンは GPT-3 よりもはるかに優れており、65B バージョンは既存の最も強力な LLM モデルである Google の 540B パラメータ PaLM と競合できます。

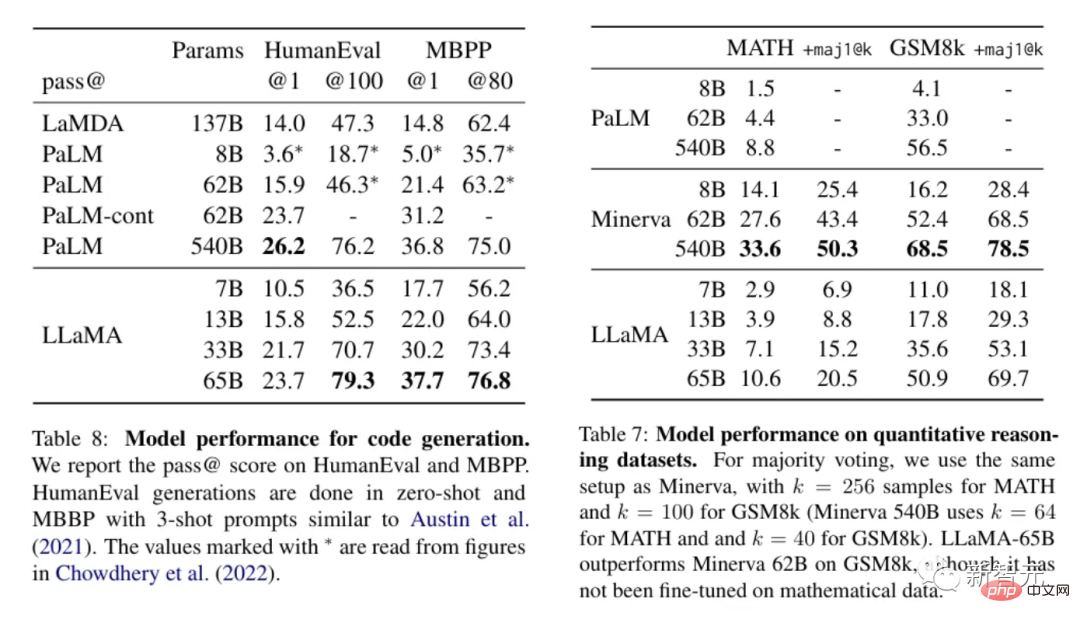

ロジックや計算を使用して処理する必要があるテキストの場合、LLaMA は優れたパフォーマンスを発揮し、定量的推論において PaLM と競合できます。後者のコード生成機能と比較して、あるいはそれよりも優れています。

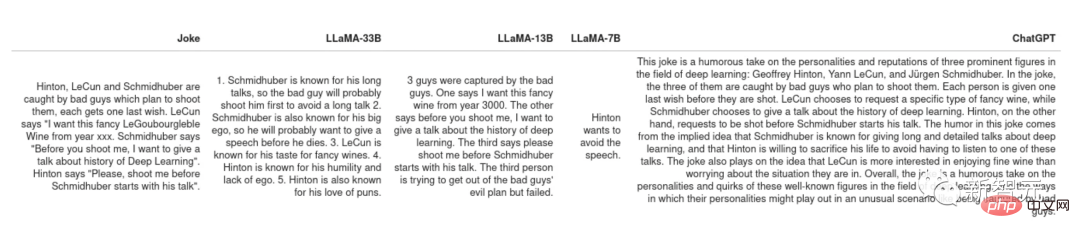

これらの結果を考慮すると、LLaMA は現在利用可能な最も高度なモデルの 1 つであるように見えます。また、十分に小さいため、実行に多くのリソースを必要としません。このため、LLaMA は人々にとって、LLaMA を使って遊んで何ができるか試してみたいと思う非常に魅力的なものになっています。 PaLM の元の論文では、非常に素晴らしい使用例が示されています。つまり、ジョークが与えられた場合、モデルにそれがなぜ面白いのかを説明させます。このタスクには実験とロジックの組み合わせが必要ですが、PaLM の以前のすべてのモデルでは実現できませんでした。 ジョークの一部を LLaMA と ChatGPT で説明してみましょう。Schimidhuber の長くて退屈なスピーチなど、一部のジョーク言語モデルはジョークを理解できます。 ジョークの説明

しかし全体的に見て、LLaMA も ChatGPT もユーモアのセンスがありません。

ただし、2 人は理解できないジョークに対処するための異なる戦略を持っています。ChatGPT は「テキストの壁」を生成します。いくつかの文は正解ですが、この行動は、答えを知らない生徒が教師がランダムな会話から答えを見つけてくれることを期待しているようなものです。

これは、スコアリングの代わりに LLM を使用して生成することを可能にする非常に実用的な関数です。トレーニング セットを作成し、それらのトレーニング セット上でより小規模なサービス可能なモデルをトレーニングします。

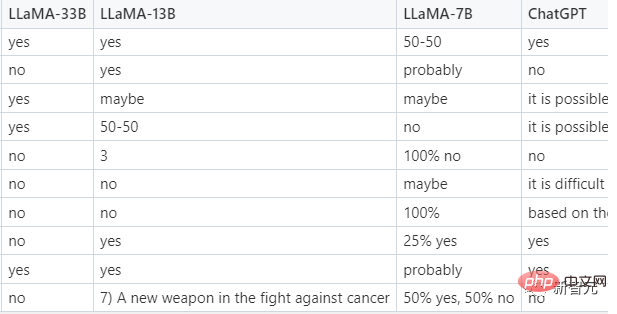

より困難なタスクは、クリックされた広告を分類することです。クリックされた広告が何であるかについては人間ですら同意できないため、モデルはプロンプトで提供されます。いくつかの例したがって、実際には、これはゼロサンプル分類ではなく、少数サンプル分類です。 LLaMA からのヒントは次のとおりです。

テストでは、LLaMA-33B のみが要求された形式に従って回答を返すことができ、その予測は妥当でした。ChatGPT は 2 番目に実行され、比較 妥当な答えですが、多くの場合、規定の形式ではなく、小型の 7B および 13B モデルはこのタスクにはあまり適していません。

メソッドはLLM 人文科学には優れていますが、STEM 科目には優れていません。では、LLaMA はこの分野でどのように機能しますか?

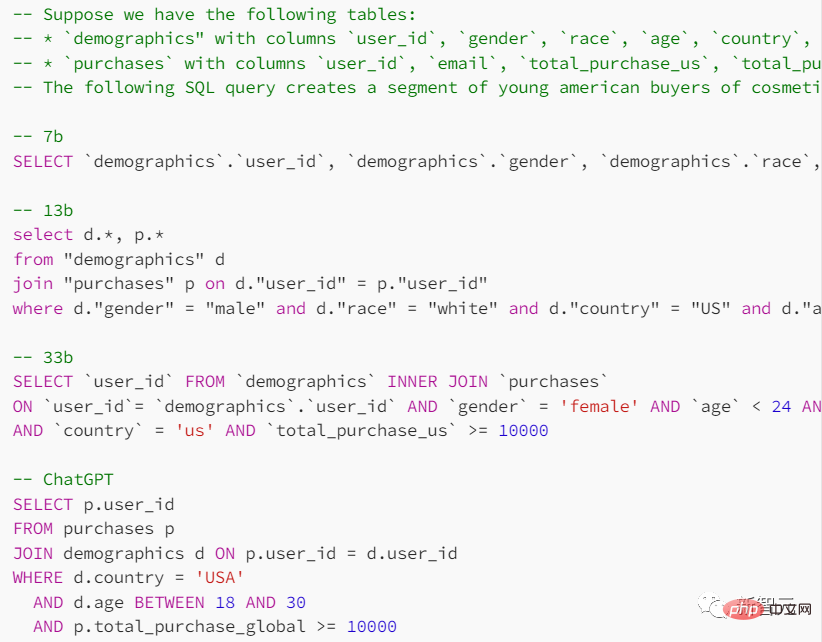

#プロンプトで、検索テーブルの形式と達成したい目的を指定し、モデルに SQL クエリ ステートメントを提供するように依頼します。

ChatGPT はこのタスクではパフォーマンスが優れていますが、言語モデルによって得られる結果は一般に信頼できません。

ChatGPT と比較したさまざまなテストでは、LLaMA は期待どおりのパフォーマンスを発揮しませんでした。 。もちろん、そのギャップが RLHF (人間のフィードバックによる強化学習) によってのみ引き起こされているのであれば、小型モデルの未来は明るいかもしれません。

以上がLLaMA モデルが漏洩し、ChatGPT のメタ バージョンが「オープン ソース」になることを余儀なくされました。 GitHub が 8,000 個の星を獲得し、多数のレビューが公開されるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。