以前、ImageNet はラベル エラーの問題で話題になりましたが、この数字を聞いて驚かれるかもしれませんが、問題のあるラベルは少なくとも 100,000 件あります。誤ったラベルに基づいた研究は、覆され、繰り返される必要があるかもしれません。

この観点からすると、データセットの品質管理は依然として非常に重要です。

多くの人は ImageNet データセットをベンチマークとして使用しますが、ImageNet の事前トレーニング済みモデルに基づくと、最終結果はデータの品質によって異なる場合があります。

この記事では、Adansons Company のエンジニア、樋口 健一が、「ImageNet はもう終わりですか?」の記事で述べた ImageNet データ セットを再調査し、間違ったラベル データを削除した後、 -それを評価し、torchvision モデルで公開します。

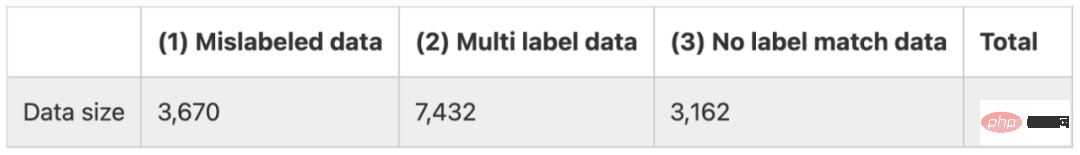

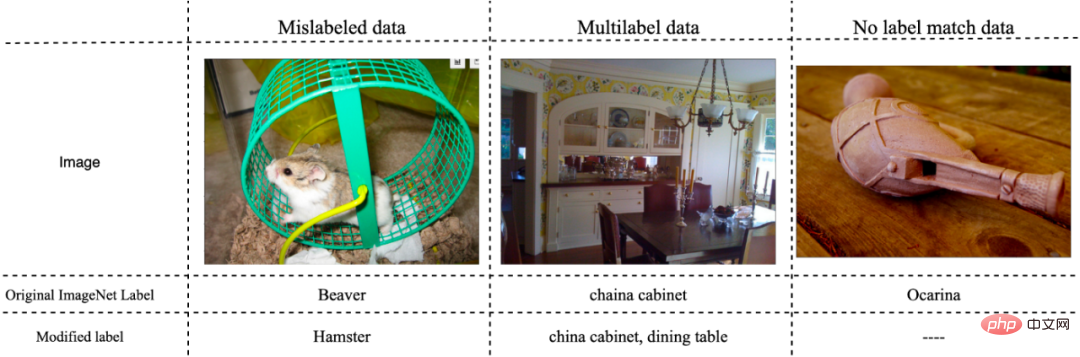

このペーパーでは、ImageNet のラベル付けエラーを次の 3 つのカテゴリに分類します。

(1) ラベル付けが正しくないデータ

(2) 複数のラベルに対応するデータ

(3) どのラベルにも属さないデータ

まとめると、誤ったデータは約 14,000 件以上あり、評価データ数が 50,000 件であることを考えると、誤ったデータの割合が非常に高いことがわかります。 。以下の図は、いくつかの代表的なエラー データを示しています。

方法

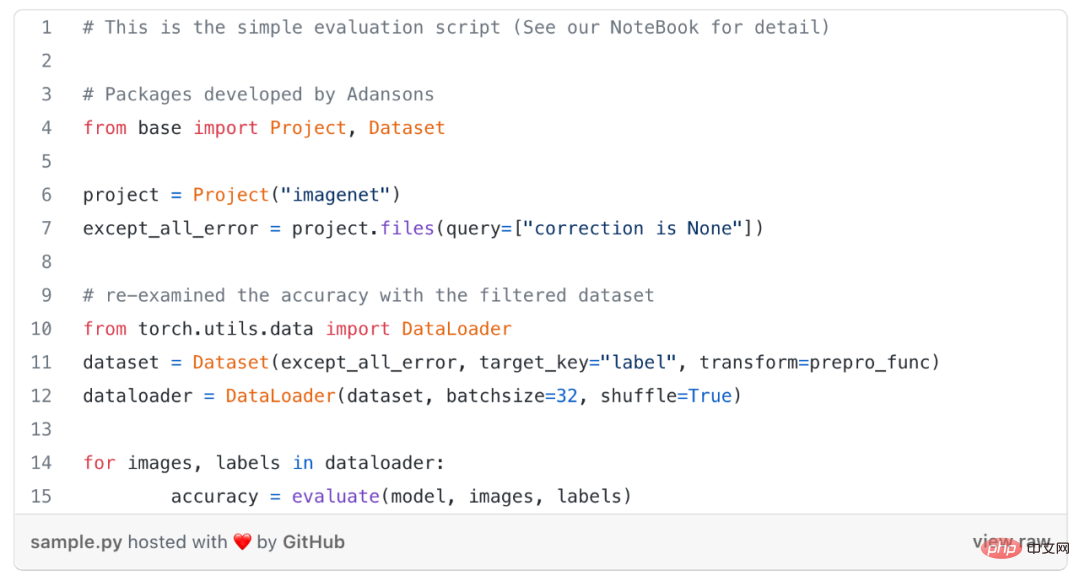

モデルを再トレーニングせずに、この研究では、誤ってラベル付けされたデータのみを除外します。つまり、上記上記のタイプの(1) 誤ったデータを評価データから除外し、モデルの精度を再確認するために、(1) ~ (3) の誤ったデータを評価データから除外します。

エラーデータを削除するには、ラベルエラー情報を記述したメタデータファイルが必要です。このメタデータファイルには、(1)~(3)のエラーが含まれる場合、その情報が「correction」属性に記述されます。

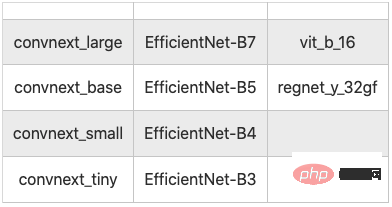

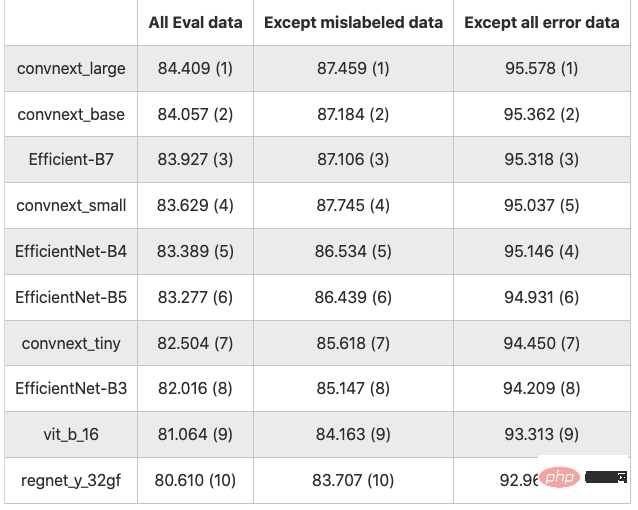

この調査では、データセットをメタデータにリンクすることでデータをフィルタリングする、Adansons Base と呼ばれるツールが使用されました。ここでは以下に示すように 10 モデルがテストされました。

#結論

これまでの研究では、モデル間の精度を比較する際に誤った結論を導き出した可能性があります。したがって、最初にデータを評価する必要がありますが、これは本当にモデルのパフォーマンスの評価に使用できるのでしょうか?

ディープラーニングを使用する多くのモデルは、データを反映することを軽視することが多く、評価データに誤ったデータが含まれている場合でも、モデルのパフォーマンスを通じて精度やその他の評価指標を向上させることに熱心です。正確に。

AIをビジネスに活用する場合など、独自のデータセットを作成する場合、高品質なデータセットを作成することはAIの精度や信頼性の向上に直結します。この論文の実験結果は、データ品質を向上させるだけで精度が約 10 パーセント向上する可能性があることを示しており、AI システムを開発する際にはモデルだけでなくデータセットも改善することの重要性を示しています。

ただし、データセットの品質を確保するのは簡単ではありません。 AI モデルとデータの品質を適切に評価するにはメタデータの量を増やすことが重要ですが、特に非構造化データの場合は管理が面倒になる場合があります。

以上がImageNet ラベル エラーが削除され、モデルのランキングが大幅に変更されましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。