近年、セルフゲームにおける強化学習は、囲碁やチェスなどの一連のゲームにおいて超人的なパフォーマンスを達成しています。さらに、理想化されたセルフプレイもナッシュ均衡に収束します。ナッシュ均衡はゲーム理論で非常に有名です. これはゲーム理論の創始者でありノーベル賞受賞者であるジョン・ナッシュによって提唱されました. ゲームの過程において、相手の戦略の選択に関係なく、一方は特定の戦略を選択します. .戦略のことをドミナント戦略といいます。他のすべてのプレーヤーの戦略が決定されているときに、いずれかのプレーヤーが最適な戦略を選択する場合、この組み合わせはナッシュ均衡として定義されます。

これまでの研究では、セルフ ゲームにおける一見効果的であるように見える継続的制御戦略も、対策によって悪用される可能性があることが示されており、セルフ ゲームはこれまで考えられていたほど強力ではない可能性があることが示唆されています。これは次の疑問につながります: 対決戦略はセルフゲームを克服する方法なのでしょうか、それともセルフゲーム戦略自体は不十分なのでしょうか?

この質問に答えるために、MIT、カリフォルニア大学バークレー校などの研究者が調査を行った結果、セルフゲームで得意な分野、つまり囲碁を選択しました。具体的には、公開されている最強の囲碁 AI システムである KataGo に対する攻撃を実行しました。固定ネットワーク (KataGo をフリーズ) の場合、エンドツーエンドの敵対的戦略をトレーニングしました。KataGo をトレーニングする際の計算のわずか 0.3% を使用して、敵対的戦略を取得し、この戦略を使用して KataGo を攻撃しました。この場合、彼らの戦略はKataGo に対して 99% の勝率を達成しました。これは、ヨーロッパのトップ 100 の囲碁プレイヤーに匹敵します。そして、KataGo が超人レベルに近づくほど十分な検索を使用したとき、勝率は 50% に達しました。重要なことは、攻撃者(この論文では、この研究で学んだ戦略を指します)は、一般的な囲碁戦略を学習しても勝つことはできません。

ここで KataGo について話します。この記事にあるように、この記事を書いた時点では KataGo はまだ最も強力なパブリック Go AI システムでした。検索のサポートにより、KataGo は非常に強力であり、それ自体が超人である ELF OpenGo や Leela Zero を破ったと言えます。今回の研究の攻撃者は、非常に強力であると言える KataGo を破りました。

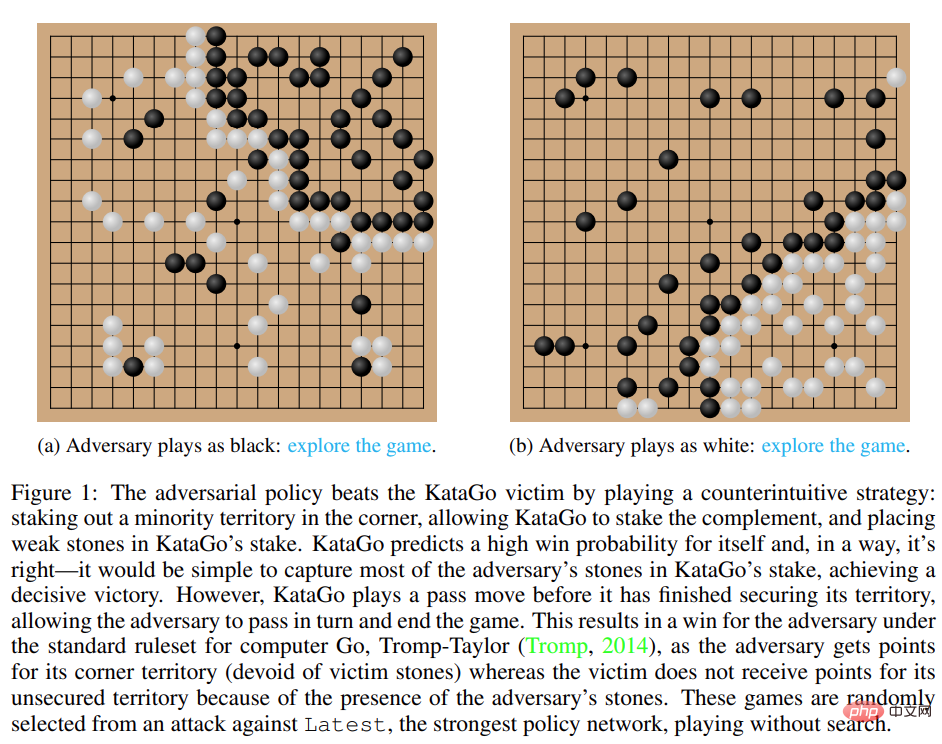

# 図 1: 敵対的戦略が KataGo の被害者を破る。

攻撃方法

従来のセルフ ゲームでは、エージェントは自身のポリシー ネットワークからサンプリングすることで対戦相手の行動をモデル化しますが、このアプローチは実際に機能します。自己。しかし、被害者プレイでは、攻撃者のポリシー ネットワークから被害者をモデル化することは間違ったアプローチです。この問題を解決するために、この研究では次の 2 種類の敵対的 MCTS (A-MCTS) を提案します。

従来のセルフ ゲームでは、エージェントは自身のポリシー ネットワークからサンプリングすることで対戦相手の行動をモデル化しますが、このアプローチは実際に機能します。自己。しかし、被害者プレイでは、攻撃者のポリシー ネットワークから被害者をモデル化することは間違ったアプローチです。この問題を解決するために、この研究では次の 2 種類の敵対的 MCTS (A-MCTS) を提案します。

研究では、トレーニング中に、凍結された KataGo 被害者に対するゲームに対する敵対的戦略をトレーニングしました。検索を行わない場合、攻撃者は KataGo の被害者に対して 99% を超える勝率を達成できます。これは、ヨーロッパのトップ 100 の囲碁プレイヤーに匹敵します。さらに、訓練された攻撃者は、被害者エージェントとの 64 ラウンドの対戦で 80% 以上の勝率を達成しました。研究者らは、これは人間の最高の囲碁プレイヤーに匹敵すると推定しています。

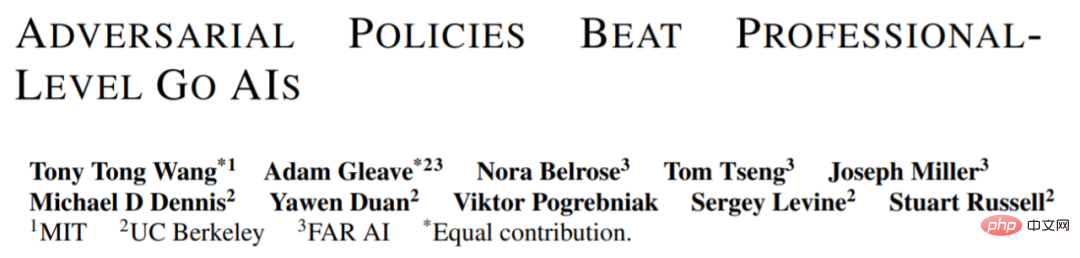

これらの対局は、この研究で提案された対策が完全にゲーム的なものではなく、むしろ KataGo をだまして攻撃者に有利な位置に配置させることを示していることに注目する価値があります。 。実際、攻撃者は人間の最高の囲碁プレイヤーと同等のゲーム戦略を悪用することができましたが、人間のアマチュアには簡単に敗北しました。

攻撃者の人間との対戦能力をテストするために、この研究では、論文の筆頭著者である Tony Tong Wang に実際に攻撃者モデルと対戦するよう依頼しました。王氏はこの研究プロジェクトの前に囲碁を習ったことがなかったが、それでも攻撃者モデルに大差をつけて勝った。これは、この研究で提案された敵対的戦略は、人間のトッププレイヤーを倒すことができる AI モデルを倒すことはできるが、人間のプレイヤーには勝つことができないことを示しています。これは、一部の AI Go モデルにバグがあることを示している可能性があります。

攻撃被害者ポリシー ネットワーク

まず、研究者らは自分自身を評価しました。 KataGo のパフォーマンスに基づいて攻撃方法を評価したところ (Wu, 2019)、A-MCTS-S アルゴリズムは検索不要の Most (KataGo の最新ネットワーク) に対して 99% 以上の勝率を達成したことがわかりました。

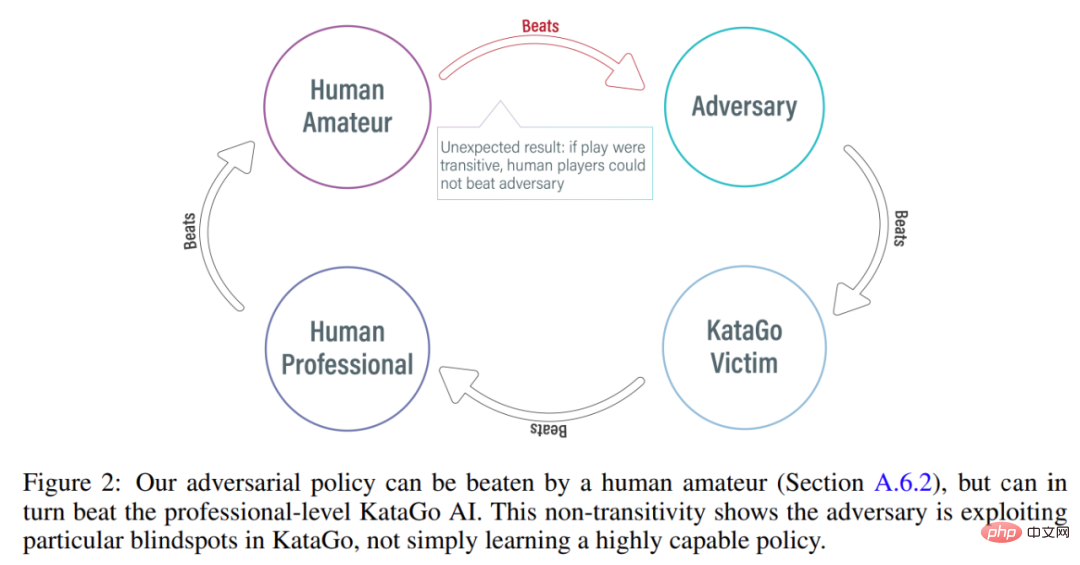

以下の図 3 に示すように、研究者は初期および最新のポリシー ネットワークでの自己対決戦略のパフォーマンスを評価しました。彼らは、トレーニングのほとんどの間、自己攻撃者が両方の被害者に対して高い勝率 (90% 以上) を達成したことを発見しました。しかし、時間が経つにつれて、攻撃者は最新型に過剰適合し、初期型に対する勝率は約 20% に低下します。

研究者らは、Late に対する最良の対抗戦略チェックポイントも評価し、99% 以上の勝率を達成しました。さらに、このような高い勝率は、敵対的戦略がわずか 3.4 × 10^7 タイム ステップ (被害者のタイム ステップの 0.3%) でトレーニングされている間に達成されます。

検索で被害者に移行する

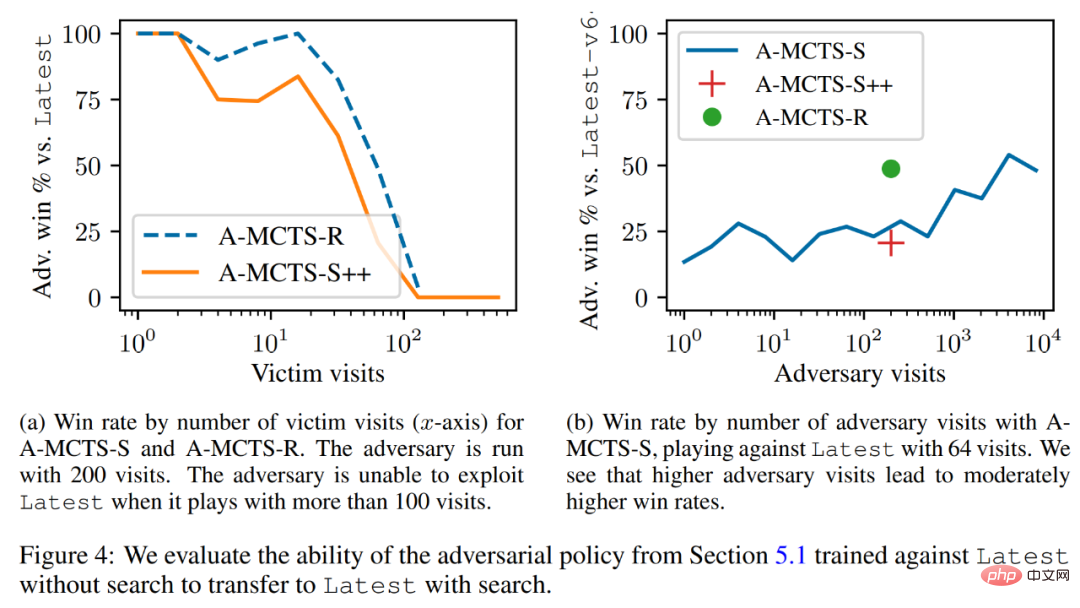

研究者は敵対的戦略を行うは低位検索メカニズムに正常に移行され、前のセクションで訓練された敵対的戦略が最新を検索する能力について評価されました。以下の図 4a に示すように、被害者に対する A-MCTS-S の勝率は、被害者ラウンド 32 回で 80% に低下したことがわかりました。しかし、ここでは、被害者はトレーニングと推論中に検索を行いません。

さらに、研究者らは A-MCTS-R もテストし、被害者ラウンド数が 32 でパフォーマンスが優れていることを発見しました。 99%以上の勝率を達成しましたが、ラウンド128では勝率が10%を下回りました。

図 4b では、研究者らは、攻撃者が 4096 ラウンドに達したとき、A-MCTS-S が最新に対して 54% の最大勝率を達成したことを示しています。これは、49% の勝率を達成した 200 エポックでの A-MCTS-R のパフォーマンスに非常に似ています。

その他の評価

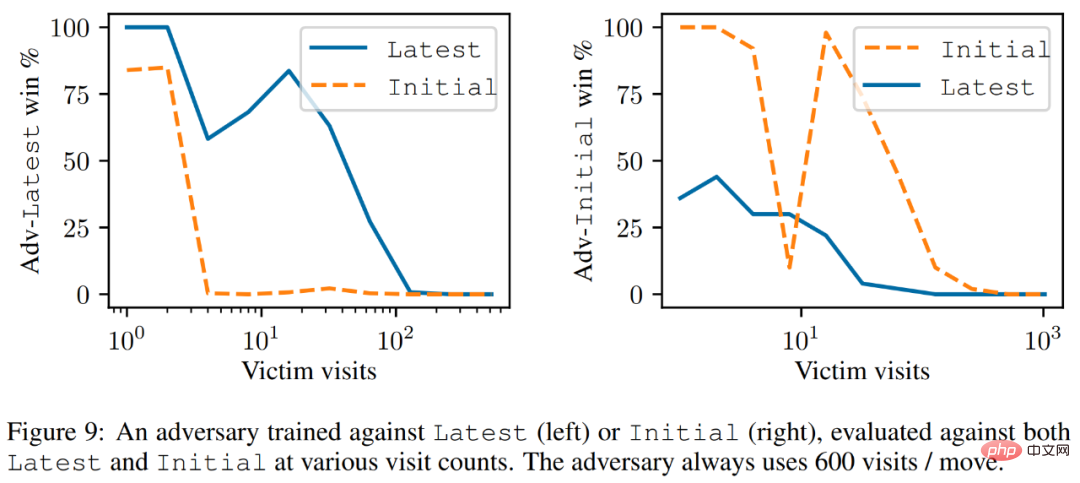

以下の図 9 に示すように、研究者らは、latest はより強力なインテリジェンスではあるものの、しかし、最新に対してトレーニングされた攻撃者は、初期よりも最新に対してより優れたパフォーマンスを発揮します。

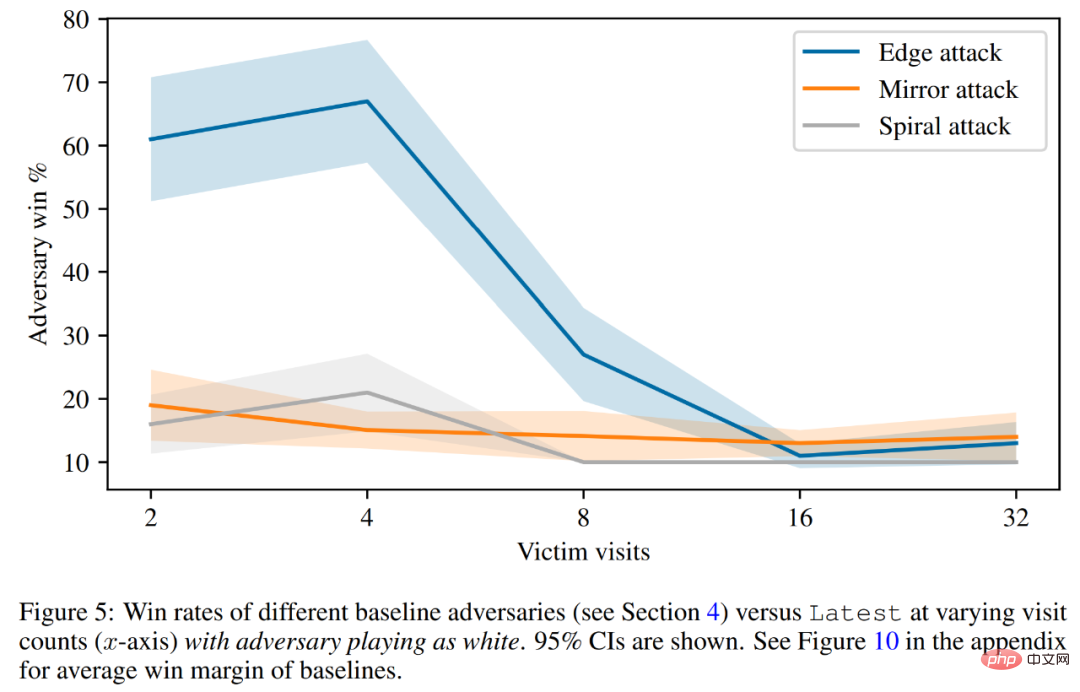

最後に、研究者らは、被害者の価値予測やハードコーディングされた防御評価などの攻撃原理について議論しました。以下の図 5 に示すように、すべてのベースライン攻撃のパフォーマンスは、訓練された敵対戦略よりも大幅に悪くなっています。

技術的な詳細については、元の論文を参照してください。

以上が魔法を使って魔法を倒せ!人間のトップ棋士に匹敵する囲碁AIが同業者に敗れたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。