近年、NLP と CV の分野では手法が継続的に進歩しています。シングルモーダル モデルが進歩しただけでなく、大規模マルチモーダル手法も非常に人気のある研究分野になっています。

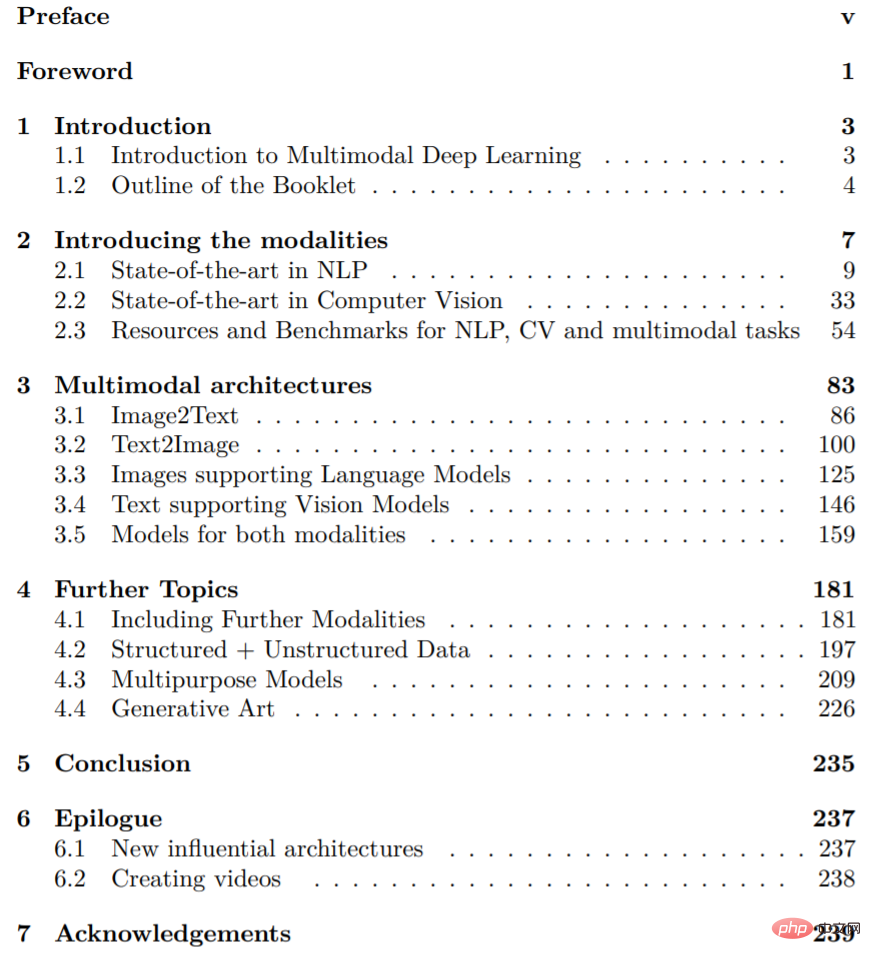

論文の各章の目次は次のとおりです。

表面的には、深層学習アルゴリズムは、損失関数を最適化するためにニューラル ネットワークをトレーニングすることによって、定義された目的関数を最適化します。最適化、つまり損失の最小化は、勾配降下法と呼ばれる数値最適化手順を通じて実現されます。したがって、深層学習モデルは数値入力のみを処理し、数値出力のみを生成できます。ただし、マルチモーダル タスクでは、画像やテキストなどの非構造化データに遭遇することがよくあります。したがって、マルチモーダル タスクに関する最初の疑問は、入力を数値的に表現する方法であり、2 番目の疑問は、異なるモダリティを適切に組み合わせる方法です。

たとえば、深層学習モデルをトレーニングして猫の写真を生成することは、一般的なタスクである可能性があります。まず、コンピュータは「猫」というテキスト入力を理解し、その情報を何らかの方法で特定の画像に変換する必要があります。したがって、入力テキスト内の単語間の文脈関係と、出力画像内のピクセル間の空間関係を決定する必要があります。幼い子供にとっては簡単なことでも、コンピュータにとっては大きな挑戦となることがあります。どちらも、その動物の意味や外観を含めて、「猫」という言葉について一定の理解を持っている必要があります。

現在の深層学習分野における一般的なアプローチは、猫を潜在空間内のベクトルとして数値的に表す埋め込みを生成することです。これを達成するために、近年、さまざまな方法とアルゴリズム アーキテクチャが開発されています。この記事では、非構造化データやさまざまなモーダル入力の組み合わせによってもたらされる課題を克服するために、最先端 (SOTA) マルチモーダル ディープ ラーニングで使用されるさまざまな手法の概要を説明します。

章の概要

NLP (セクション 2.1) に関する非常に重要な概念は単語埋め込みと呼ばれるもので、現在、ほぼすべてのマルチモーダル深層学習アーキテクチャの重要な部分となっています。この概念は、いくつかの NLP タスクで大きな進歩を遂げた BERT などの Transformer ベースのモデルの基礎も築きました。特に、Transformer のセルフアテンション メカニズムは NLP モデルを完全に変えました。これが、ほとんどの NLP モデルが Transformer をコアとして使用する理由です。

コンピュータ ビジョン (セクション 2.2) では、著者はさまざまなネットワーク アーキテクチャ、つまり ResNet、EfficientNet、SimCLR、BYOL を紹介します。どちらの分野でも、さまざまなアプローチを比較し、それらが困難なベンチマークでどのようにパフォーマンスを発揮するかを比較することは非常に興味深いことです。したがって、第 2 章の最後にあるサブセクション 2.3 では、CV と NLP のさまざまなデータセット、事前トレーニング タスク、ベンチマークの包括的な概要を説明します。

第 3 章では、さまざまなマルチモーダル アーキテクチャに焦点を当て、テキストと画像のさまざまな組み合わせを取り上げます。提案されたモデルは、NLP と CV のさまざまな方法を組み合わせて研究を進めます。まず、Img2Text タスク (セクション 3.1)、オブジェクト認識用の Microsoft COCO データセット、および画像キャプチャ用の Meshed-Memory Transformer を紹介します。

さらに、研究者らは短いテキストのプロンプトに基づいて画像を生成する方法を開発しました (セクション 3.2)。このタスクを達成した最初のモデルは、敵対的生成ネットワーク (GAN) と変分オートエンコーダー (VAE) でした。近年、これらの手法は継続的に改良され、今日の SOTA Transformer アーキテクチャや DALL-E や GLIDE などのテキストガイド付き普及モデルは目覚ましい成果を上げています。もう 1 つの興味深い質問は、画像を活用して言語モデルをサポートする方法です (セクション 3.3)。これは、順次埋め込み、より高度な実際の埋め込み、または Transformer 内で直接実現できます。

CLIP、ALIGN、Florence などのテキスト対応 CV モデルもご覧ください (セクション 3.4)。基本モデルの使用は、モデルの再利用 (例: DALL-E 2 の CLIP) と、テキストと画像の接続の対照的な損失を意味します。さらに、ゼロショットでは、微調整を行うことで、新しいデータや未確認のデータを簡単に分類できます。特に、画像の分類と生成のためのオープンソース アーキテクチャである CLIP は、昨年大きな注目を集めました。テキストと画像を同時に処理するための他のいくつかのアーキテクチャは、第 3 章の最後 (セクション 3.5) で紹介されています。

たとえば、Data2Sec は同じ学習方法を使用して音声、視覚、言語を処理し、1 つのアーキテクチャでさまざまなモダリティを処理する共通の方法を見つけようとします。さらに、VilBert は、共同注意を実装することで、一般的な BERT アーキテクチャを拡張し、画像とテキストの入力を処理します。このアプローチは、Google の Deepmind Flamingo でも使用されています。さらに、Flamingo は、事前トレーニングされた視覚モデルと言語モデルの数ショット学習とフリーズを通じて、単一の視覚言語モデルで複数のタスクを処理することを目指しています。

最終章 (第 4 章) では、ビデオ、音声、表形式データなど、テキストや画像以外のモダリティを処理できるメソッドを紹介します。全体的な目標は、モダリティのためのモーダルではなく、課題に簡単に対処できる、ユニバーサルなマルチモーダル アーキテクチャを探索することです。したがって、マルチモーダルな融合と位置合わせの問題にも対処し、結合表現と調整表現のどちらを使用するかを決定する必要があります (セクション 4.1)。さらに、構造化データと非構造化データの正確な組み合わせについては、さらに詳しく説明します (セクション 4.2)。

著者は、近年開発されたさまざまな統合戦略も提案しています。この記事では、生存分析と経済学の 2 つの使用例を通じてそれを説明します。これを超えて、もう 1 つの興味深い研究課題は、Google の研究者が「Pathway」モデルで作成したもののような、いわゆる多目的モデル (セクション 4.3) でさまざまなタスクをどのように処理するかということです。最後に、この記事では、DALL-E などの画像生成モデルを使用してジェネレーティブ アートの分野で芸術作品を作成する、アート シーンにおけるマルチモーダル ディープ ラーニングの典型的な応用例を示します (セクション 4.4)。

詳細については、元の論文を参照してください。

以上がNLP と CV の統合イノベーションを分析する: 近年のマルチモーダルディープラーニングを振り返るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。