オフライン強化学習アルゴリズム (オフライン RL) は、強化学習の最も人気のあるサブ方向の 1 つです。オフライン強化学習は環境と対話せず、以前に記録されたデータからターゲットのポリシーを学習することを目的としています。オフライン強化学習は、データ収集に費用がかかるか危険であるが、大量のデータが存在する可能性がある分野 (ロボット工学、産業用制御、自動運転など) において、オンライン強化学習 (オンライン RL) と比較して特に魅力的です。

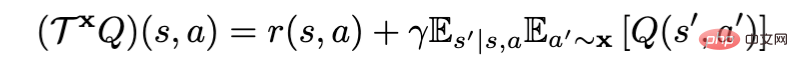

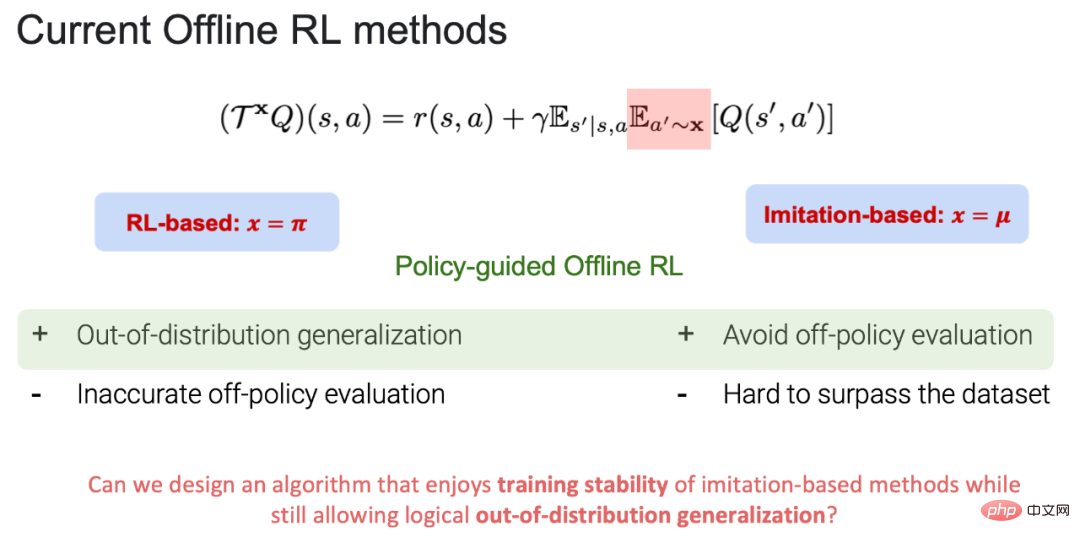

ベルマン ポリシー評価演算子をポリシー評価に使用する場合、現在のオフライン強化学習アルゴリズムは RL ベース (x=π) に分割できます。模倣ベース (x=μ)。ここで、π はターゲット戦略、μ は行動戦略です (注: ターゲット戦略: 学習と更新のための戦略、行動戦略: オフライン データでの戦略)。現在、RL ベースと模倣ベースの両方に独自の長所と短所があります:

1. RL ベースの利点: データの外側で一般化でき、最終的にはデータを超えた学習目標戦略を達成できます。行動戦略。短所: ポリシー評価における正確な値の推定 (より多くの動作の正規化) とポリシーの改善 (より少ない動作の正規化) の間にはトレードオフがあります。ポリシー評価プロセスにおいて、データ分布の外にあるアクションが選択されると、アクション価値関数 (アクション状態値) を正確に推定できなくなり、最終的にターゲット ポリシーの学習に失敗します。

2.模倣ベースの利点: ポリシー評価のプロセスでは、すべてのアクションがデータ分布内にあるため、トレーニングに安定性をもたらすだけでなく、外部のエラーも回避できます。戦略評価では、行動戦略ライブラリ内の最良に近い戦略を学習できます。短所: すべてのアクションはデータ分布内で実行されるため、元のデータに存在する行動戦略を超えることは困難です。

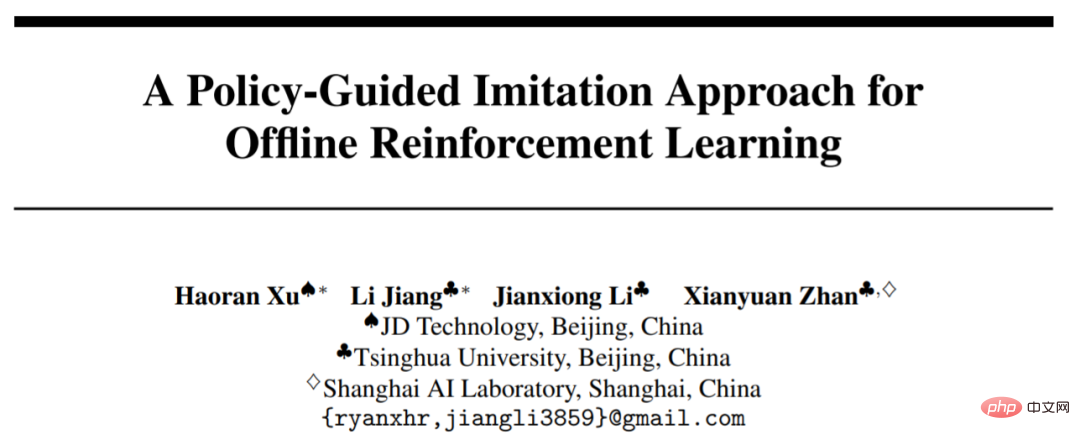

# これに基づいて、POR は戦略評価プロセスにおけるトレードオフを回避できるだけでなく、データの外部で一般化する機能も備えています。この研究は NeurIPS 2022 に採択され、口頭発表の招待を受けており、論文とコードはオープンソースになっています。

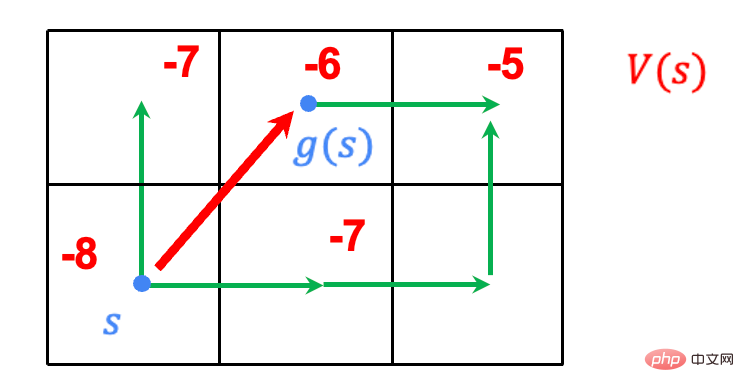

タスク: 終了点を右上隅、開始点を右下隅にして、グリッド上を歩きます。始点から終点までの最短経路を見つけます。

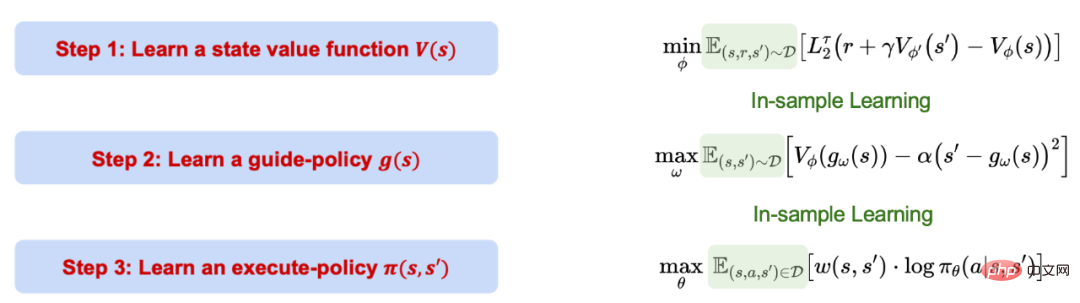

ポリシーに基づくオフライン RL (POR) の学習プロセスは 3 つのステップに分かれており、これら 3 つのステップは分離されており、相互に関係しています。排他的です。影響はありません。 POR のプロセス全体が模倣ベースの学習、つまりサンプル内学習に基づいており、データ分布の外でのアクションの価値は評価されないことに注意してください。

#1. 分位点回帰を使用して、値関数の信頼限界の上限を学習します。

2. 利用已經學習到的價值函數學習指導策略,該指導策略可以在給定當前的狀態下,生成到樣本內的下一步最優的狀態位置(s')。後面一項作為約束項保證產生的狀態滿足 MDP 條件。

3. 利用資料中所有的樣本進行學習一個執行策略,該執行策略在給定當前狀態(s)和下一步的狀態(s') 之後,能夠採取正確的動作從目前狀態(s)移動到下一步狀態(s')。

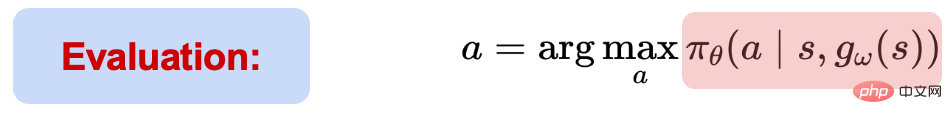

在測試過程,根據目前狀態資訊(s),先透過指導策略給出下一步的最優狀態(s')。

給定(s, s'),執行策略能夠進行動作選取和執行。雖然 POR 的整個學習過程都是樣本內的學習,但可以利用神經網路的泛化效能進行資料外的泛化學習,最後實現 state-stitching。

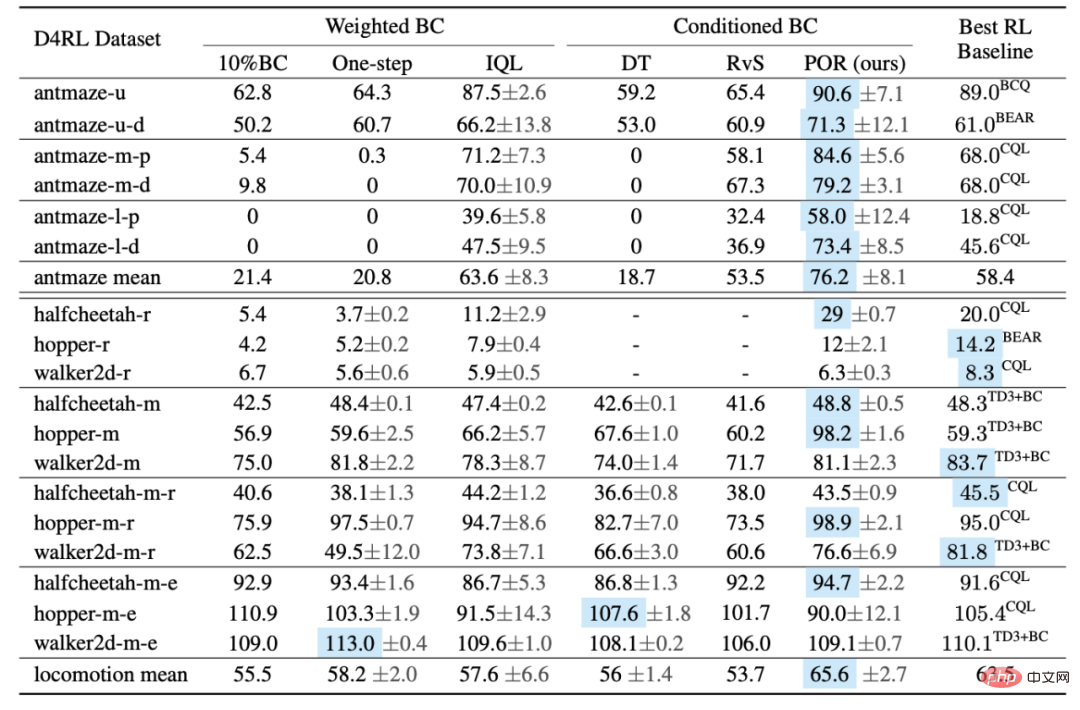

作者比較了 POR 和其他演算法在 D4RL Benchmark 上的表現。從表格來看,POR 在次優資料上的表現非常亮眼,在具有更大難度 Antmaze 任務上的表現均取得最優的演算法效能。

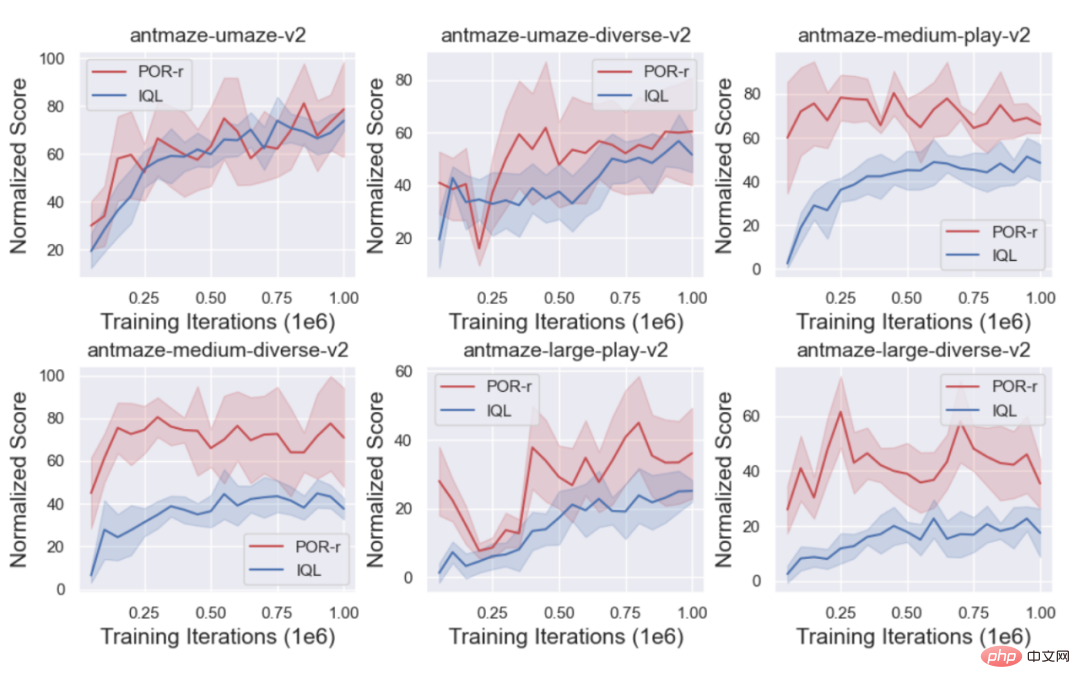

同時,作者比較了POR(state-stitching) 和IQL(action-stitching)的訓練曲線,以表現state-stitching 的優勢。

1.重新學習指導策略以實現演算法的效能提升。

真實的世界中往往存在⼤量的次優甚⾄隨機的資料集(D_o),如果直接引入到正在學習的原始資料集(D_e) 上可能會導致學到⼀個較差的策略,但是對於解耦式學習演算法來講,針對到不同的元件,學習不同的資料集來提升表現。在學習價值函數的時候往往是越多的資料集越好,因為可以把價值函數可以學得更準確;相反,策略的學習是不希望引入 (D_o)。

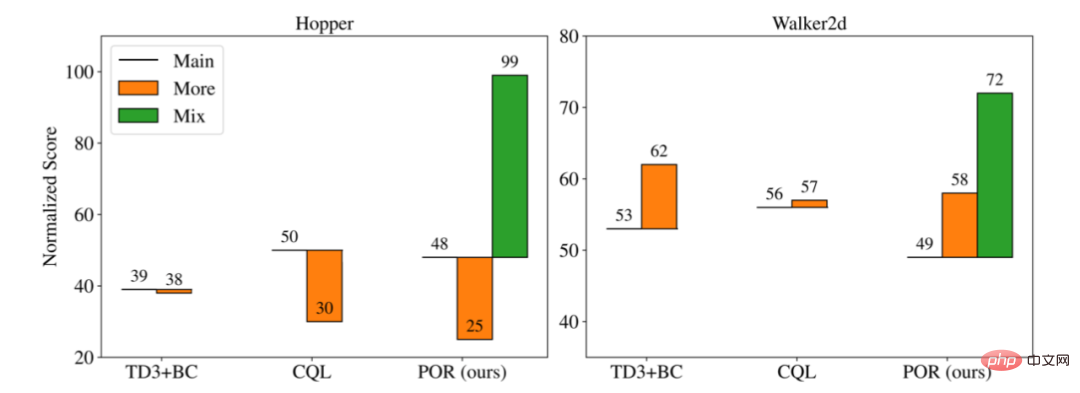

作者比較了三個不同的演算法在不同訓練場景下的表現:

1. Main : 在原始資料集上( D_e) 進行學習,不引入額外次優資料集。

2. More:把原始資料集 (D_e) 和新資料集(D_o)進行混合,作為新的資料集學習。

3. Mix: 對於解耦的演算法,對於不同的學習部分,可以用不同的資料集來學習,所以只有 POR 可以有 Mix 的學習範式。

從上圖可以看到,當加入新的次優資料一起訓練過後(More),可能會導致比原來的只用原始資料集(Main)表現更好或更差,但是針對到可以解耦的訓練形式,用以(D_o D_e) 重新學習指導策略,作者實驗說明了更多的數據可以增強指導策略的擇優性和泛化能力,同時保持行為策略不變,從而實現了執行策略的提升。

4. 當面對新任務的時候,因為執行策略是和任務無關的,只需要重新學習指導策略。

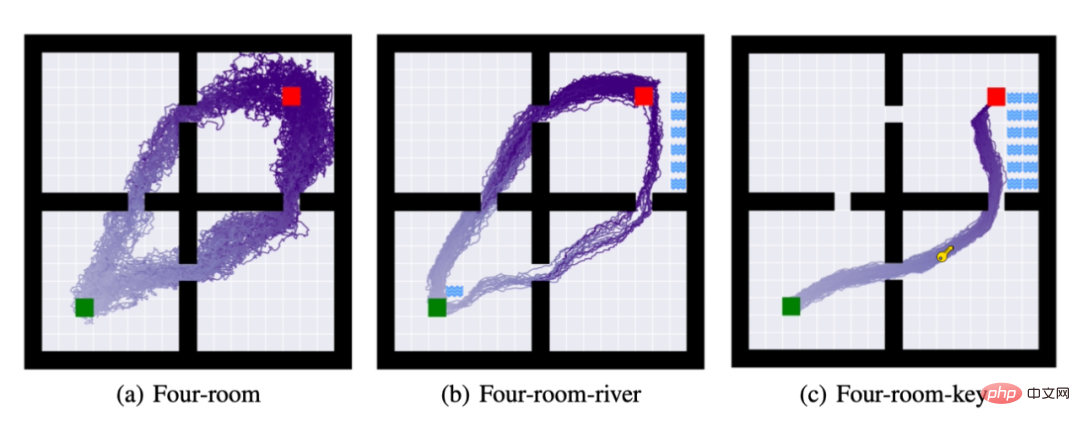

為此,作者提出了三個任務分別是 (a): four-room: 要求 agent 從綠色方塊到紅色方塊。 (b) 除了完成任務(a) 之外,要求 agent 不能碰河流。 (c)除了完成任務(a),(b)之外,要求 agent 必須取得鑰匙才算完成任務。

上圖,是完成策略學習之後,對策略進行50 次的rollout 的軌跡,在任務(b) 和任務(c)作者沿用任務(a) 的執行策略,只重新學習了指導策略。從上圖可以看出,解耦的學習方式可以在使用盡可能少的運算資源之下,完成任務的遷移。

以上がオフライン強化学習の新しいパラダイム! JD.comと清華大学が分離学習アルゴリズムを提案の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。