1.HDFS分散ファイルシステムの運用と保守

1.in HDFS ルートディレクトリに再帰を作成しますファイル システム ディレクトリ "1daoyun/file" 、添付ファイル内の BigDataSkills.txt ファイルを 1daoyun/file ディレクトリにアップロードし、関連するコマンドを使用してファイル を表示しますシステム内 1daoyun/file ディレクトリのファイルリスト情報。 2.

HDFS

ファイル システムのルート ディレクトリに再帰ディレクトリ"1daoyun/file"

を作成し、添付の

BigDataSkills.txt をアップロードします。 ファイルへ1daoyun/ ファイル ディレクトリに移動し、HDFS ファイル システムチェック ツールを使用して、ファイルが破損しているかどうかを確認します。 hadoop fs -mkdir -p /1daoyun/filehadoop fs -put BigDataSkills.txt/1daoyun/filehadoop fsck /1daoyun/file/BigDataSkills.txt 3.

HDFSファイルシステムのルートディレクトリに再帰ディレクトリ

「1daoyun/file」

を作成し、添付されている

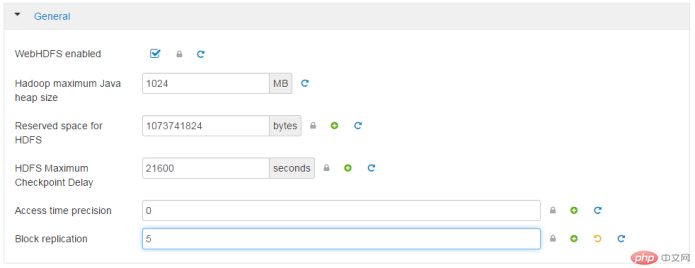

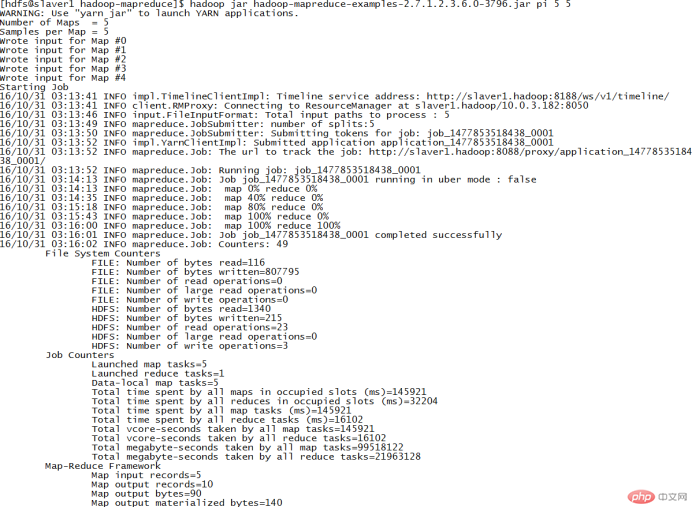

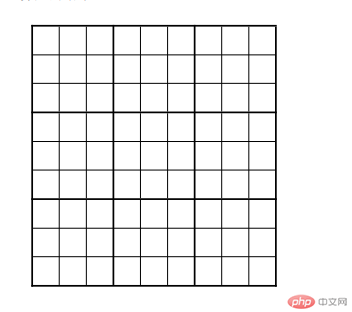

BigDataSkills.txtをアップロードします ファイルを 1daoyun /ファイル ディレクトリ。アップロード プロセスでは、HDFS ファイル システム内の bigdataskills.txt ファイルを指定して、係数を 2 としてコピーします。ブロックのコピー数。 hadoop fs -mkdir -p /1daoyun/file hadoop fs -D dfs.replication=2 -put BigDataSkills.txt /1daoyun/file hadoop fsck /1daoyun/file/BigDataSkills.txt 4.HDFS ファイルシステムのルートディレクトリに /apps というファイルディレクトリがあり、このディレクトリの スナップショット作成機能を有効にし、スナップショットを作成する必要があります。スナップショット ファイルの名前は apps_1daoyun です。関連コマンドを使用してスナップショット ファイルのリスト情報を表示するには、 を使用します。 hadoop dfsadmin -allowSnapshot /apps hadoop fs -createSnapshot /apps apps_1daoyun hadoop fs -ls /apps/.snapshot 5. ダン Hadoop クラスターが起動すると、まずセーフ モードに入ります。デフォルトでは、このモードは 30 秒後に終了します。システムがセーフ モードの場合、HDFS ファイル システムは読み取りのみが可能で、 は書き込み、変更、削除などの操作を実行できません。ここで、Hadoop クラスターを保守する必要があるとします。 クラスターをセーフ モードにして、そのステータスを確認する必要があります。 hdfs dfsadmin -safemode enter hdfs dfsadmin -safemode get 6. オペレーターが誤ってファイルを削除するのを防ぐために、HDFS ファイルシステムは機能を提供しますゴミ箱の容量を減らしますが、ジャンクファイルが多すぎると多くのストレージスペースを占有します。 XiandianビッグデータプラットフォームのWEBインターフェースは、HDFSファイルシステムのごみ箱内のファイルを7日以内に完全に削除する必要があります。 高度なコアサイトfs.trash.interval: 10080 7.オペレーターが誤ってファイルを削除することを防ぐために、HDFSファイルシステムはごみ箱機能を提供しますが、ジャンクファイルが多すぎると多くのストレージスペースを占有します。 Linux Shellの「vi」コマンドを使用して、対応する設定ファイルとパラメータ情報を変更し、ごみ箱機能をオフにする必要があります。完了したら、対応するサービスを再起動します。 高度なcore-sitefs.trash.interval: 0vi /etc/hadoop/2.4.3.0-227/0/core-site.xml sbin/stop-dfs.sh sbin/start-dfs.sh8.Hadoop これらの問題が発生すると、 HDFS ファイルの信頼性を確保するために、必然的にデータ ファイルが破損するか失われます。システムでは、高度なビッグ データ プラットフォーム WEB インターフェイスを使用する必要があります。 クラスターの冗長レプリケーション係数を 5 に変更します。 一般レプリケーションのブロック5 9.Hadoop でこれらの問題が発生すると、場合によっては、HDFS ファイル システム内のデータ ファイルが破損したり、損傷したりすることがあります。損失が発生しました。HDFS ファイルシステムの信頼性を確保するには、クラスターの冗長性レプリケーション係数を5、Linux Shell で使用されるに変更する必要があります。」 vi"コマンドを使用して、対応する設定ファイルとパラメータ情報を変更します。完了後、対応するサービスを再起動します。 または dfs.replication /hadoop-client/sbin/ .sh --config /usr/hdp/current/hadoop-client/conf stop {namenode/datenode} /usr/ hdp/current/hadoop-client/sbin/hadoop-daemon.sh -- config /usr/hdp/current/hadoop-client/conf start {namenode/datenode} 10. /tmp hdfs 。 hadoop fs -count /tmp2.MapREDUCE ケースの質問 1.クラスターノード/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ディレクトリには、JARパッケージhadoop-がありますマップリデュース-examples.jar。 JAR パッケージ内の PI プログラムを実行して piπ の近似値を計算するには、 Map タスクを ごとに 5 回実行する必要があります地図 タスクのスロー数は5です。 /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ クラスターノード /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ ディレクトリには、ケース JAR がありますバッグhadoop-mapreduce-examples.jar。 JAR パッケージの wordcount プログラムを実行して、 /1daoyun/file/BigDataSkills.txt ファイルに対して単語カウントを実行し、操作結果を /1daoyun/output に出力します。 Directory では、関連コマンドを使用して単語数の結果をクエリします。 hadoop jar/usr/hdp/2.4.3.0-227/hadoop-mapreduce/hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar wordcount /1daoyun/file/BigDataSkills.txt /1daoyun/出力 3.クラスターノード/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ディレクトリには、ケースJARパッケージがありますhadoop-マップリデュース-examples.jar。 JAR パッケージ内の sudoku プログラムを実行して、以下の表の Sudoku 問題の結果を 計算します。 。 catパズル1.dta hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar sudoku /root/puzzle1.dta 4 .クラスターノード/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ディレクトリには、ケースがありますjarパッケージhadoop-mapreduce-examples.jar 。 JAR パッケージ内の grep プログラムを実行して、 「Hadoop」 が ファイル システム /1daoyun/file/BigDataSkills.txt に出現する回数をカウントします。 ファイル。統計が完了しました。完了後、統計結果情報をクエリします。 hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar grep /1daoyun/file/BigDataSkills.txt /output hadoop  vi/etc/hadoop/2.4.3.0-227/0/hdfs-site.xml

vi/etc/hadoop/2.4.3.0-227/0/hdfs-site.xml

以上がBigData ビッグデータの運用・保守の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。