deepseek:LLMS

の補強学習に深く潜ります

Deepseekの最近の成功は、低コストで印象的なパフォーマンスを達成し、大規模な言語モデル(LLM)トレーニング方法の重要性を強調しています。この記事では、TRPO、PPO、および新しいGRPOアルゴリズムを調査する強化学習(RL)の側面に焦点を当てています。 機械学習、ディープラーニング、およびLLMに基本的に精通していると仮定して、複雑な数学を最小限に抑えてアクセスしやすくします。

LLMトレーニングの3つの柱

LLMトレーニングには、通常、3つの重要なフェーズが含まれます。

- 事前トレーニング:モデルは、大規模なデータセットを使用して、前のトークンからのシーケンスで次のトークンを予測することを学びます。

監視された微調整(SFT):- ターゲットデータはモデルを改良し、特定の指示に合わせてモデルを調整します。

強化学習(RLHF):

この段階であるこの記事の焦点は、直接的なフィードバックを通じて人間の好みに合わせてよりよく一致するための応答をさらに改善します。

-

強化学習基礎

補強学習には、

環境と相互作用する エージェント

エージェント

が含まれます。エージェントは、特定の

状態に存在し、アクションを取得して新しい状態に移行します。各アクションは、環境からの報酬を導き出し、エージェントの将来の行動を導きます。 迷路をナビゲートするロボットを考えてみてください。その位置は状態であり、動きは行動であり、出口に到達すると肯定的な報酬が得られます。

LLMSの rl:詳細な外観

LLMトレーニングでは、コンポーネントは次のとおりです

-

エージェント: LLM自体。

-

環境:ユーザープロンプト、フィードバックシステム、コンテキスト情報などの外部要因。

- アクション:クエリに応じてLLMが生成するトークン。

state:- 現在のクエリと生成されたトークン(部分的な応答)。

報酬:

通常は、人間が発表したデータでトレーニングされた別の- 報酬モデル、スコアの割り当てのランキング応答によって決定されます。高品質の応答は、より高い報酬を受け取ります。 Deepseekmathなどの特定の場合には、よりシンプルなルールベースの報酬が可能です。

ポリシー>どのアクションを実行するかを決定します。 LLMの場合、次のトークンをサンプリングするために使用される可能性のあるトークン上の確率分布です。 RLトレーニングにより、ポリシーのパラメーター(モデル重量)が調整され、高度なトークンが優先されます。 多くの場合、ポリシーは次のように表されます

RLのコアは、最適なポリシーを見つけることです。 監視された学習とは異なり、私たちは報酬を使用してポリシーの調整をガイドします。

TRPO(信頼地域のポリシーの最適化)

TRPOは、監視された学習の損失関数に類似したアドバンテージ関数を使用しますが、報酬から派生しました。

TRPOは、以前の反復からの大きなポリシーの逸脱を防ぎ、安定性を確保するために制約された代理目標を最大化します。

PPO(近位のポリシーの最適化)

ChatGptやGeminiなどのLLMよりも希望されている

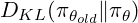

grpo(グループ相対ポリシーの最適化)

GRPOは、個別の値モデルを排除することにより、トレーニングを合理化します。クエリごとに、応答のグループを生成し、報酬に基づいてZスコアとして利点を計算します。

これにより、プロセスが簡素化され、複数の応答を生成するLLMSの能力に適しています。 GRPOには、現在のポリシーを参照ポリシーと比較して、KL Divergence用語も組み込まれています。最終的なGRPOの定式化は次のとおりです

結論

補強学習、特にPPOと新しいGRPOは、最新のLLMトレーニングにとって重要です。 各方法はRLの基礎に基づいて構築され、安定性、効率、および人間のアラインメントのバランスをとるさまざまなアプローチを提供します。 Deepseekの成功は、他の革新とともにこれらの進歩を活用しています。 強化学習は、LLM機能の進歩においてますます支配的な役割を果たす態勢が整っています。

参考文献:

(参照は同じままで、より良い読みやすさのために再フォーマットされただけです)

[1]「大規模な言語モデルの基礎」、2025年

[2]「強化学習」。エナリス。入手可能:

//m.sbmmt.com/link/20e169b48c8f869887e2bbe1c5c3ea65 -

[3] Y. Gokhale。 「LLMSおよび生成AIパート5:RLHFの紹介」、

Medium - 、2023。

[4] L. Weng。 「強化学習の概要」2018年

[5] "Deepseek-R1:補強学習によるLLMSの推論能力を奨励する"、2025。

[6]「Deepseekmath:オープン言語モデルの数学的推論の限界を押し上げる」、2025年。

- [7]「信頼地域のポリシーの最適化」、2017年

以上が大規模な言語モデルのトレーニング:TRPOからGRPOまでの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

エージェント

エージェント