Éditeur | Yi Feng

Produit par 51CTO Technology Stack (WeChat ID : blog51cto)

Google passe enfin à l'action ! Nous ne souffrirons plus de « l’amnésie » des grands modèles.

TransformerFAM est né, promettant de donner aux grands modèles une mémoire illimitée !

Sans plus tard, jetons un coup d'œil à « l'efficacité » de TransformerFAM :

Photos

Photos

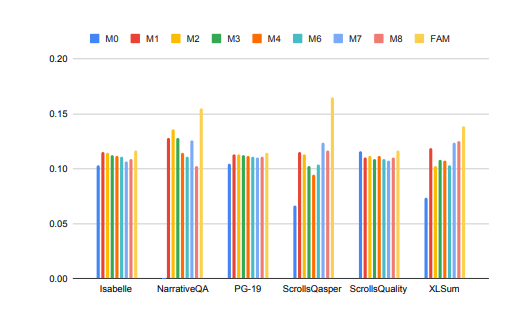

Les performances des grands modèles dans le traitement des tâches à contexte long ont été considérablement améliorées !

Dans l'image ci-dessus, des tâches telles que Isabelle et NarrativeQA nécessitent que le modèle comprenne et traite une grande quantité d'informations contextuelles et donne des réponses ou des résumés précis à des questions spécifiques. Dans toutes les tâches, le modèle configuré avec FAM surpasse toutes les autres configurations BSWA, et on constate qu'au-delà d'un certain point, l'augmentation du nombre de segments de mémoire BSWA ne peut pas continuer à améliorer ses capacités de mémoire.

Il paraît que sur la route des longs textes et des longues conversations, l'"inoubliable" de FAM, grand mannequin, a quelque chose à dire.

Les chercheurs de Google ont présenté FAM, une nouvelle architecture Transformer - Feedback Attention Memory. Il utilise des boucles de rétroaction pour permettre au réseau de prêter attention à ses propres performances de dérive, favoriser l'émergence de la mémoire de travail interne du Transformer et lui permettre de gérer des séquences infiniment longues.

Pour faire simple, cette stratégie est un peu comme notre stratégie pour combattre artificiellement « l'amnésie » des grands modèles : saisir à nouveau l'invite avant chaque conversation avec le grand modèle. C'est juste que l'approche de FAM est plus avancée. Lorsque le modèle traite un nouveau bloc de données, il utilise les informations précédemment traitées (c'est-à-dire FAM) comme contexte mis à jour dynamiquement et les intègre à nouveau dans le processus de traitement en cours.

De cette façon, vous pouvez bien résoudre le problème de « l'oubli des choses ». Mieux encore, malgré l'introduction de mécanismes de rétroaction pour maintenir la mémoire de travail à long terme, FAM est conçu pour maintenir la compatibilité avec les modèles pré-entraînés sans nécessiter de poids supplémentaires. Ainsi, en théorie, la mémoire puissante d’un grand modèle ne le rend pas ennuyeux et ne consomme pas plus de ressources informatiques.

Alors, comment un si merveilleux TransformerFAM a-t-il été découvert ? Quelles sont les technologies associées ?

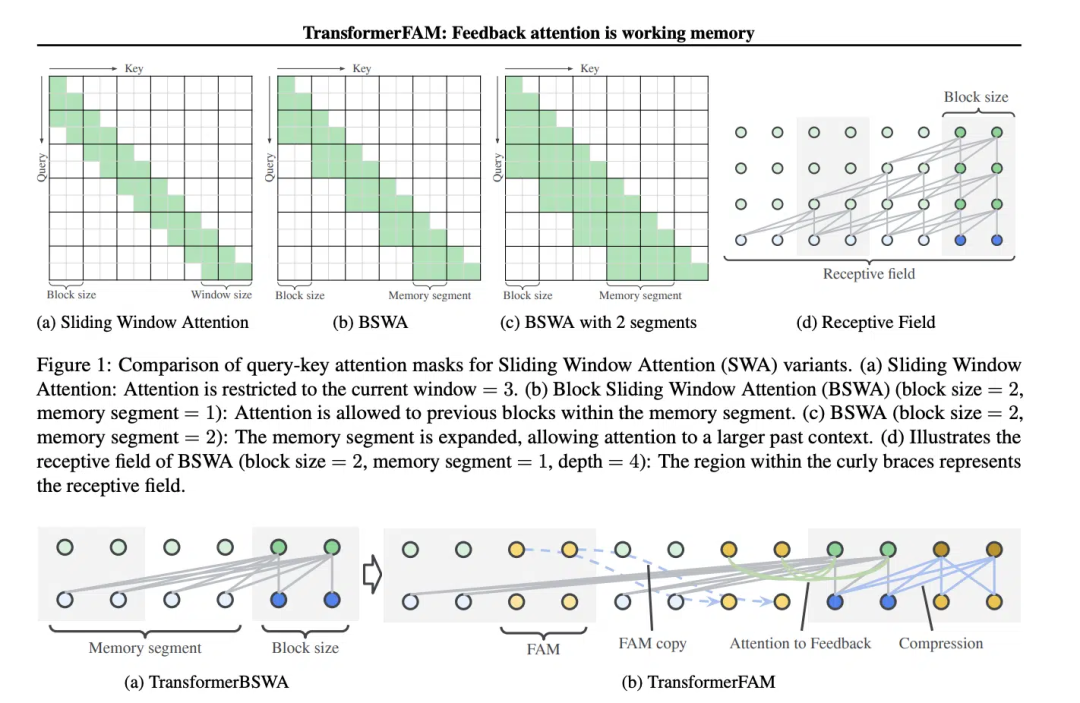

Le concept de Sliding Window Attention (SWA) est crucial dans la conception de TransformerFAM.

Dans le modèle Transformer traditionnel, la complexité de l'attention personnelle augmente quadratiquement à mesure que la longueur de la séquence augmente, ce qui limite la capacité du modèle à gérer de longues séquences.

« Dans le film Memento (2000), le personnage principal souffre d'amnésie antérograde, ce qui signifie qu'il ne peut pas se souvenir de ce qui s'est passé au cours des 10 dernières minutes, mais sa mémoire à long terme est intacte et il doit tatouer des informations importantes sur son corps. les mémoriser est similaire à l'état actuel des grands modèles de langage (LLM)", lit-on dans le journal.

Captures d'écran du film "Memento", les images proviennent d'Internet

Captures d'écran du film "Memento", les images proviennent d'Internet

Sliding Window Attention (Sliding Window Attention), c'est un mécanisme d'attention amélioré pour le traitement des données de longue séquence. Il s’inspire de la technique des fenêtres coulissantes en informatique. Lorsqu'il s'agit de tâches de traitement du langage naturel (NLP), SWA permet au modèle de se concentrer uniquement sur une fenêtre de taille fixe de la séquence d'entrée à chaque pas de temps, plutôt que sur la séquence entière. Par conséquent, l’avantage de SWA est qu’il peut réduire considérablement l’effort de calcul.

Images

Images

Mais SWA a des limites car sa capacité d'attention est limitée par la taille de la fenêtre, ce qui empêche le modèle de prendre en compte les informations importantes en dehors de la fenêtre.

TransformerFAM réalise une attention intégrée, des mises à jour au niveau des blocs, une compression des informations et un stockage de contexte global en ajoutant l'activation du feedback pour ré-saisir la représentation du contexte dans chaque bloc d'attention de fenêtre coulissante.

Dans TransformerFAM, les améliorations sont obtenues grâce à des boucles de rétroaction. Plus précisément, lors du traitement du bloc de séquence actuel, le modèle se concentre non seulement sur les éléments de la fenêtre actuelle, mais réintroduit également des informations contextuelles précédemment traitées (c'est-à-dire « l'activation de rétroaction ») précédente comme entrée supplémentaire dans le mécanisme d'attention. De cette façon, même si la fenêtre d'attention du modèle glisse sur la séquence, il est capable de conserver la mémoire et la compréhension des informations précédentes.

Ainsi, après ces améliorations, TransformerFAM donne aux LLM le potentiel de gérer des séquences de longueur infinie !

TransformerFAM a montré des perspectives positives dans la recherche, ce qui améliorera sans aucun doute les performances de l'IA dans la compréhension et la génération de tâches de texte longues, telles que le traitement de documents Résumé, génération d'histoires , questions-réponses et autres travaux.

Images

Images

En même temps, qu'il s'agisse d'un assistant intelligent ou d'un compagnon émotionnel, une IA avec une mémoire illimitée semble plus attrayante.

Fait intéressant, la conception de TransformerFAM s'inspire du mécanisme de mémoire en biologie, qui coïncide avec la simulation de l'intelligence naturelle poursuivie par AGI. Cet article tente d’intégrer un concept issu des neurosciences – la mémoire de travail basée sur l’attention – dans le domaine de l’apprentissage profond.

TransformerFAM introduit la mémoire de travail dans les grands modèles via des boucles de rétroaction, permettant au modèle non seulement de mémoriser des informations à court terme, mais également de maintenir la mémoire d'informations clés dans des séquences à long terme.

Grâce à leur imagination audacieuse, les chercheurs créent des ponts entre le monde réel et les concepts abstraits. À mesure que des réalisations innovantes telles que TransformerFAM continuent d’émerger, les goulots d’étranglement technologiques seront sans cesse surmontés et un avenir plus intelligent et interconnecté se dévoile lentement vers nous.

Pour en savoir plus sur l'AIGC, veuillez visiter :

Communauté 51CTO AI.x

https://www.51cto.com/aigc/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

mise à jour automatique de Windows

mise à jour automatique de Windows

symbole de droit d'auteur HTML

symbole de droit d'auteur HTML

bootmgr est manquant et ne peut pas démarrer

bootmgr est manquant et ne peut pas démarrer

FIL vaut-il la peine d'être détenu à long terme ?

FIL vaut-il la peine d'être détenu à long terme ?

Processus détaillé de mise à niveau du système Win7 vers le système Win10

Processus détaillé de mise à niveau du système Win7 vers le système Win10

Comment implémenter des polices de couleur en CSS

Comment implémenter des polices de couleur en CSS

Comment établir un réseau local sous XP

Comment établir un réseau local sous XP

Le rôle des codes-barres

Le rôle des codes-barres