Meitu Imaging Research Institute (MT Lab), en collaboration avec l'Institut d'ingénierie de l'information de l'Académie chinoise des sciences, l'Université d'aéronautique et d'astronautique de Pékin et l'Université Sun Yat-sen, ont proposé conjointement une méthode d'édition de scène 3D - CustomNeRF. Les résultats de la recherche ont été acceptés par le CVPR 2024. CustomNeRF prend non seulement en charge les descriptions textuelles et les images de référence comme conseils d'édition pour les scènes 3D, mais génère également des scènes 3D de haute qualité basées sur les informations fournies par les utilisateurs.

Neural Radiance Field (NeRF) Depuis que le Neural Radiance Field (NeRF) a été proposé en 2020, il a poussé l'expression implicite à un nouveau niveau. En tant que l'une des technologies les plus de pointe actuellement, NeRF a été rapidement généralisée et appliquée dans des domaines tels que la vision par ordinateur, l'infographie, la réalité augmentée et la réalité virtuelle, et continue de recevoir une large attention. NeRF permet une synthèse d'images de haute qualité en modélisant le rayonnement et la densité de chaque point de la scène, ce qui le rend largement attractif pour des applications dans des domaines tels que la vision par ordinateur, l'infographie, la réalité augmentée et la réalité virtuelle. NeRF est unique dans sa capacité à générer des images de haute qualité à partir de scènes d’entrée sans avoir recours à des numérisations 3D complexes ou à des images en perspective dense. Cette fonctionnalité permet à NeRF d'avoir de larges perspectives d'application dans de nombreux domaines, notamment la vision par ordinateur, l'infographie, la réalité augmentée et la réalité virtuelle, et continue de recevoir une large attention. NeRF permet une synthèse d'images de haute qualité en modélisant l'éclat et la densité de chaque point de la scène. NeRF peut également être utilisé pour générer des rendus 3D de haute qualité, ce qui le rend très prometteur pour des applications dans des domaines tels que la réalité virtuelle et la réalité augmentée. Le développement rapide et l’application généralisée du NeRF continueront de faire l’objet d’une grande attention, et on s’attend à ce que davantage d’innovations et d’applications basées sur le NeRF voient le jour à l’avenir.

NeRF (Neural Radiation Field) est une fonctionnalité d'optimisation et de représentation continue qui a de nombreuses applications dans la reconstruction de scènes 3D. Il a même stimulé la recherche dans le domaine de l’édition de scènes 3D, comme le redessinage de textures et la stylisation d’objets ou de scènes 3D. Afin d'améliorer encore la flexibilité de l'édition de scènes 3D, les méthodes d'édition NeRF basées sur des modèles pré-entraînés ont également été largement explorées récemment. En raison de la représentation implicite de NeRF et des caractéristiques géométriques des scènes 3D, les résultats d'édition sont conformes aux invites textuelles. peuvent être obtenus. Ce sont quelque chose de très facile à mettre en œuvre.

Afin de permettre l'édition de scènes 3D basée sur le texte pour obtenir un contrôle précis, le Meitu Imaging Research Institute (MT Lab), l'Institut d'ingénierie de l'information de l'Académie chinoise des sciences, l'Université Beihang et l'Université Sun Yat-sen ont proposé conjointement un La méthode qui combine la description du texte et la référence Image Unification fournit le cadre CustomNeRF pour l'édition. Le cadre intègre un sujet V∗ spécifique à la perspective, qui est intégré dans la représentation hybride pour répondre aux exigences générales et personnalisées d'édition de scènes 3D. Les résultats de la recherche ont été enregistrés dans CVPR 2024 et le code est open source.

Lien papier : https://arxiv.org/abs/2312.01663

Lien code : https://github.com/hrz2000/CustomNeRF

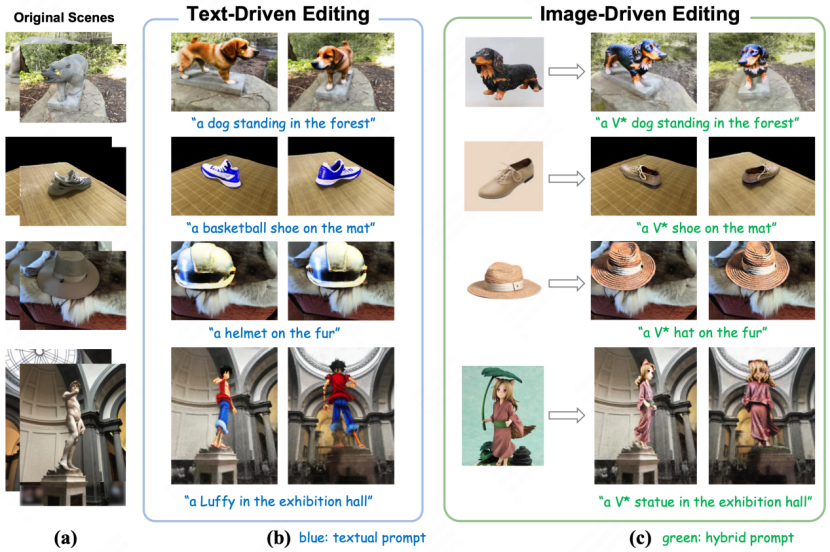

: : Le effet d'édition de CustomNeRF en mode texte (à gauche) et en image (à droite)

Deux défis majeurs résolus par CustomNeRF

Actuellement, les méthodes traditionnelles d'édition de scènes 3D basées sur des modèles de diffusion pré-entraînés sont principalement divisé en deux catégories. La première consiste à utiliser le modèle d'édition d'image pour mettre à jour de manière itérative les images dans l'ensemble de données. Cependant, en raison de la capacité limitée du modèle d'édition d'image, il échouera dans certaines situations d'édition. Deuxièmement, la perte d'échantillonnage par distillation fractionnée (SDS) est utilisée pour éditer la scène. Cependant, en raison du problème d'alignement entre le texte et la scène, cette méthode ne peut pas être directement adaptée à la scène réelle et entraînera une distorsion inutile dans le non-scène. zone d'édition. La modification nécessite souvent des expressions intermédiaires explicites telles que le maillage ou le voxel. De plus, les deux types de méthodes actuels se concentrent principalement sur les tâches d'édition de scènes 3D basées sur le texte. Les descriptions textuelles sont souvent difficiles à exprimer avec précision les besoins d'édition de l'utilisateur et ne peuvent pas personnaliser des concepts spécifiques dans les images dans des scènes 3D. la scène 3D originale est généralement éditée, il est donc difficile d'obtenir les résultats d'édition attendus par l'utilisateur. En fait, la clé pour obtenir les résultats d'édition souhaités est d'identifier avec précision la zone de premier plan de l'image, ce qui favorise une édition de premier plan de l'image géométriquement cohérente tout en conservant l'arrière-plan de l'image. Par conséquent, afin d'obtenir une édition précise uniquement de la zone de premier plan de l'image, l'article propose un programme de formation en édition itérative locale-globale (LGIE), alternant entre l'édition de la zone de premier plan de l'image et l'édition complète de l'image. Cette solution permet de localiser avec précision la zone du premier plan de l'image et d'opérer uniquement sur le premier plan de l'image tout en préservant l'arrière-plan de l'image.De plus, dans l'édition de scènes 3D basée sur l'image, il existe un problème d'incohérence géométrique dans les résultats de l'édition provoqué par le surajustement du modèle de diffusion affiné à la perspective de l'image de référence. À cet égard, l'article conçoit une régularisation guidée par la classe, utilisant uniquement des mots de classe pour représenter le sujet de l'image de référence lors de l'étape d'édition locale, et tirant parti d'une classe générale préalable dans un modèle de diffusion pré-entraîné pour promouvoir une édition géométriquement cohérente.

Le processus global de CustomNeRF

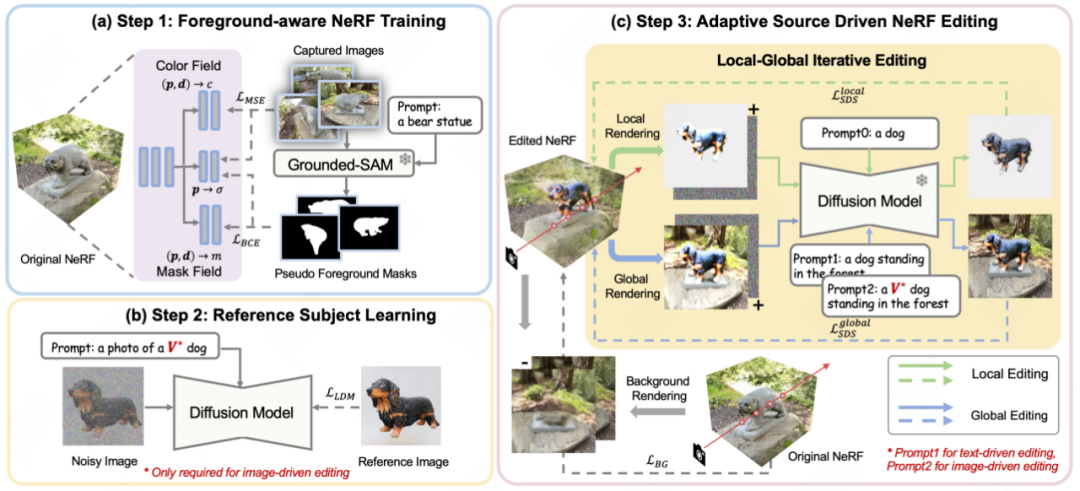

Comme le montre la figure 2, CustomNeRF utilise 3 étapes pour atteindre l'objectif d'éditer et de reconstruire avec précision des scènes 3D sous la direction d'invites de texte ou d'images de référence.

Figure 2 Organigramme global de CustomNeRF

Tout d'abord, lors de la reconstruction de la scène 3D originale , CustomNeRF introduit un champ de masque supplémentaire pour estimer les probabilités d'édition au-delà de la densité. Comme le montre la figure 2 (a), pour un ensemble d'images nécessitant la reconstruction d'une scène 3D, l'article utilise d'abord Grouded SAM pour extraire le masque de la zone d'édition d'image de la description en langage naturel, et combine l'ensemble d'images d'origine pour former le NeRF sensible au premier plan. Après la reconstruction NeRF, les probabilités d'édition sont utilisées pour distinguer les régions d'image à éditer (c'est-à-dire les régions de premier plan d'image) des régions d'image non pertinentes (c'est-à-dire les régions d'arrière-plan d'image) afin de faciliter le rendu découplé pendant l'apprentissage d'édition d'image.

Deuxièmement, afin d'unifier les tâches d'édition de scènes 3D basées sur l'image et sur le texte, comme le montre la figure 2(b), l'article utilise la méthode de diffusion personnalisée pour affiner l'image de référence dans des conditions basées sur l'image afin d'apprendre les fonctionnalités clés spécifiques au sujet. Après l'entraînement, le mot spécial V* peut être utilisé comme étiquette de mot ordinaire pour exprimer le concept du sujet dans l'image de référence, formant ainsi un signal hybride, tel que « une photo d'un chien V* ». De cette manière, CustomNeRF permet une édition cohérente et efficace de types de données adaptatifs, notamment des images ou du texte.

Dans la phase de montage finale, en raison de l'expression implicite de NeRF, l'optimisation de l'ensemble de la zone 3D à l'aide de la perte SDS entraînera des changements importants dans les zones d'arrière-plan, qui devraient être cohérentes avec la scène originale après le montage. Comme le montre la figure 2 (c), l'article propose un schéma d'édition itérative local-global (LGIE) pour la formation SDS découplée, lui permettant de préserver le contenu d'arrière-plan lors de l'édition de la zone de mise en page.

Plus précisément, cet article divise le processus de formation à l'édition de NeRF de manière plus fine. Grâce à NeRF prenant en compte le premier plan, CustomNeRF peut contrôler de manière flexible le processus de rendu de NeRF pendant l'entraînement, c'est-à-dire que, sous une perspective de caméra fixe, il peut choisir de restituer des images de premier plan, d'arrière-plan et normales contenant du premier plan et de l'arrière-plan. Au cours du processus de formation, la scène NeRF actuelle peut être éditée à différents niveaux en utilisant la perte SDS en restituant de manière itérative le premier plan et l'arrière-plan, combinés avec les signaux de premier plan ou d'arrière-plan correspondants. Parmi eux, la formation locale au premier plan vous permet de vous concentrer uniquement sur la zone qui doit être éditée pendant le processus de montage, simplifiant ainsi la difficulté des tâches de montage dans des scènes complexes, tandis que la formation globale prend en compte l'ensemble de la scène et peut maintenir la coordination des opérations ; premier plan et arrière-plan. Afin de conserver inchangée la zone non modifiée, le document utilise également l'arrière-plan nouvellement rendu pendant le processus de formation à la supervision de l'arrière-plan avant la formation à l'édition afin de maintenir la cohérence des pixels d'arrière-plan.

De plus, il existe des incohérences géométriques exacerbantes dans l'édition de scènes 3D basée sur l'image. Parce que le modèle de diffusion qui a été affiné avec l'image de référence a tendance à produire des images avec une perspective similaire à celle de l'image de référence pendant le processus d'inférence, ce qui fait que les multiples perspectives de la scène 3D éditée constituent des problèmes géométriques de face. À cette fin, l'article conçoit une stratégie de régularisation guidée par les classes, utilisant des descripteurs spéciaux V* dans les indices globaux et uniquement des mots de classe dans les indices locaux pour tirer parti des a priori de classe inclus dans le modèle de diffusion pré-entraîné, en utilisant davantage de nouveaux concepts. dans la scène d'une manière géométriquement cohérente.

Résultats expérimentaux

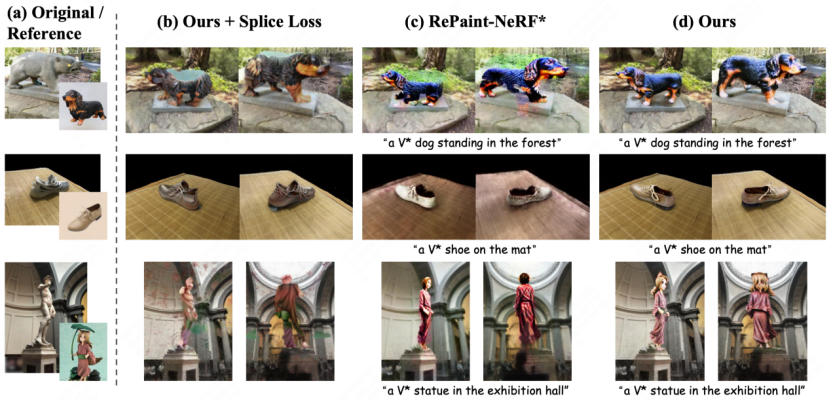

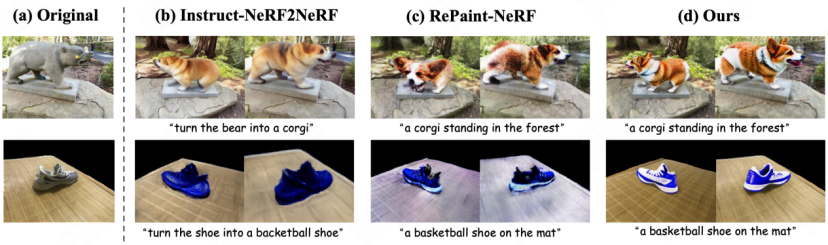

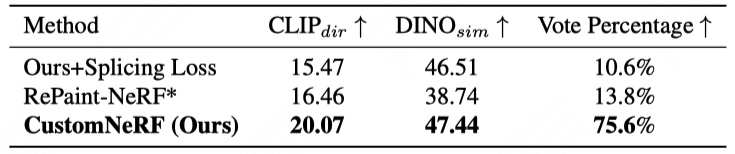

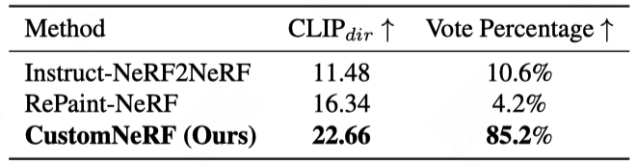

La figure 3 et la figure 4 montrent la comparaison des résultats de reconstruction de scène 3D de CustomNeRF et de la méthode de base dans les tâches d'édition de scènes 3D basées sur l'image de référence et le texte, CustomNeRF a obtenu de bons résultats d'édition, non seulement. Un bon alignement avec les conseils d'édition est obtenu et les zones d'arrière-plan restent cohérentes avec la scène d'origine. De plus, les tableaux 1 et 2 montrent la comparaison quantitative de CustomNeRF avec la méthode de base lorsqu'elle est pilotée par des images et du texte. Les résultats montrent que CustomNeRF surpasse la méthode de base en termes de mesures d'alignement de texte, d'alignement d'images et d'évaluation humaine.

Comparaison quantitative avec la ligne de base sous édition pilotée par l'image Comparaison quantitative avec la ligne de base en cours d'édition Cet article propose de manière innovante le modèle CustomNeRF, tout en prenant en charge l'édition demande des descriptions de texte ou des images de référence et résout deux défis clés : l'édition précise uniquement du premier plan et la cohérence sur plusieurs vues lors de l'utilisation d'images de référence à vue unique. Le programme comprend le programme de formation d'édition itérative locale-globale (LGIE), qui permet aux opérations d'édition de se concentrer sur le premier plan tout en gardant l'arrière-plan inchangé ; et une régularisation guidée par classe, qui atténue les incohérences d'affichage dans l'édition basée sur l'image, et a été vérifiée. grâce à des expériences approfondies, CustomNeRF permet une édition précise de scènes 3D motivée par des descriptions textuelles et des images de référence dans une variété de scénarios du monde réel.

Résumé

Résumé

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Construisez votre propre serveur git

Construisez votre propre serveur git

La différence entre git et svn

La différence entre git et svn

git annuler le commit soumis

git annuler le commit soumis

Comment annuler l'erreur de commit git

Comment annuler l'erreur de commit git

Comment comparer le contenu des fichiers de deux versions dans git

Comment comparer le contenu des fichiers de deux versions dans git

Comment utiliser la fonction de classement

Comment utiliser la fonction de classement

Que signifie le clonage WeChat ?

Que signifie le clonage WeChat ?

Raisons pour lesquelles le tableau Excel ne peut pas être ouvert

Raisons pour lesquelles le tableau Excel ne peut pas être ouvert