Selon les informations de ce site du 7 mars, AMD a annoncé aujourd'hui que les utilisateurs peuvent exécuter localement des modèles de langage étendus (LLM) basés sur GPT pour créer des chatbots IA exclusifs.

AMD indique que les utilisateurs peuvent exécuter des chatbots LLM et IA de manière native sur des appareils, notamment les APU Ryzen 7000 et Ryzen 8000 alimentés par le nouveau XDNA NPU d'AMD, ainsi que les appareils GPU Radeon RX 7000 avec cœurs d'accélération IA intégrés.

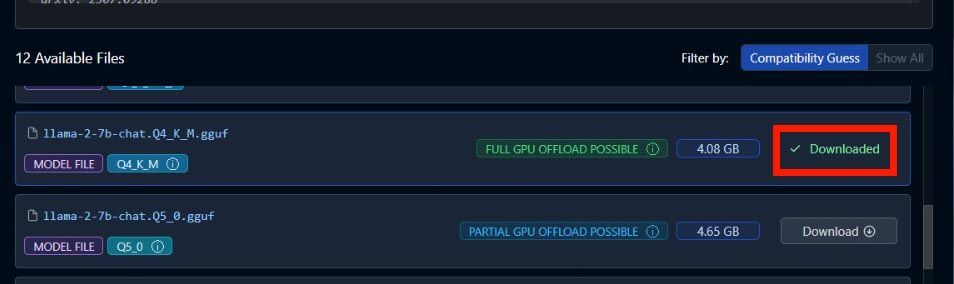

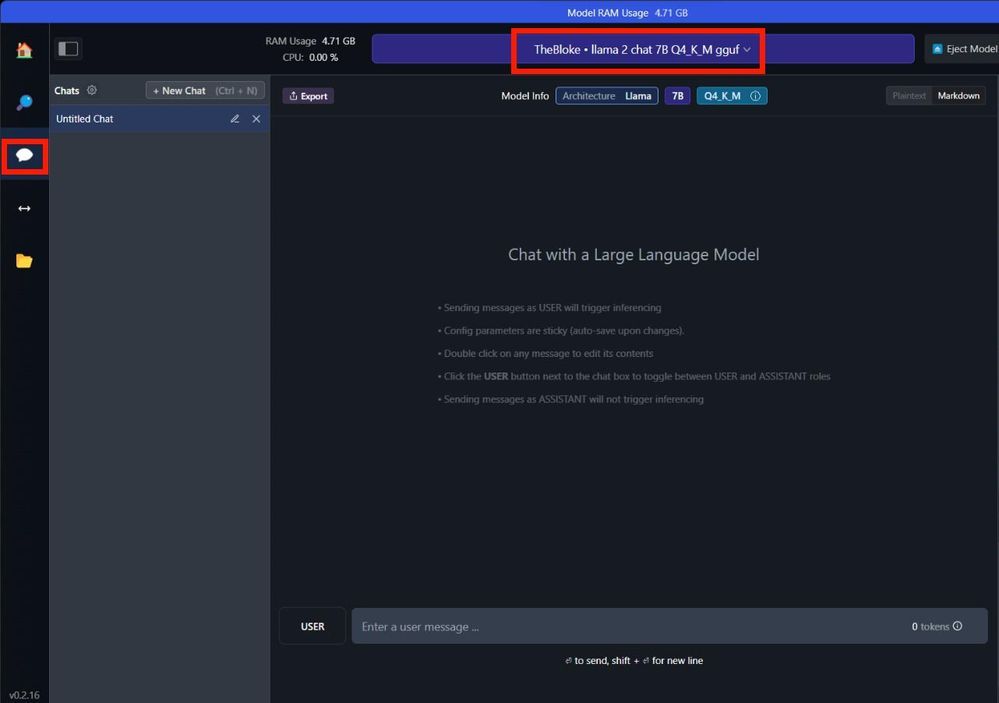

AMD a détaillé les étapes en cours dans l'annonce, telles que l'exécution de Mistral avec 7 milliards de paramètres, la recherche et le téléchargement de "TheBloke/OpenHermes-2.5-Mistral-7B-GGUF" si vous exécutez LLAMA v2 avec 7 milliards de paramètres ; , recherchez et téléchargez « TheBloke/Llama-2-7B-Chat-GGUF ».

AMD n'est pas la première entreprise à faire cela, NVIDIA a également récemment lancé "Chat with RTX", qui est pris en charge par les GPU GeForce RTX 40 et RTX 30 series Chatbot d'intelligence artificielle. Il est accéléré grâce à l'ensemble de fonctionnalités TensorRT-LLM pour fournir des résultats d'IA générés rapidement basés sur des ensembles de données localisés.

L'adresse originale de l'annonce est jointe à ce site Web. Les utilisateurs intéressés peuvent la visiter et la lire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!