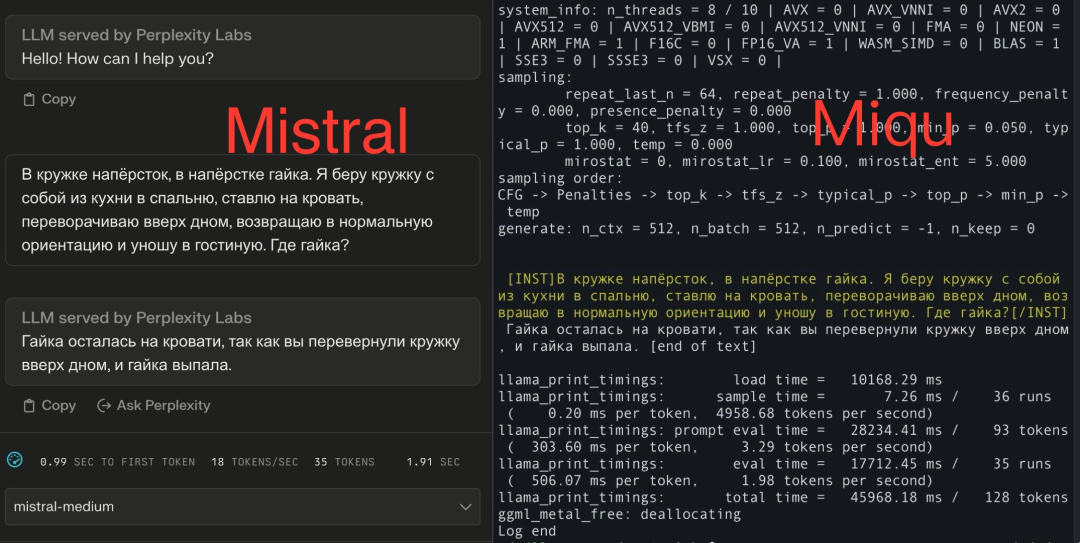

"Je suis désormais convaincu à 100% que Miqu et Mistral-Medium sur Perplexity Labs sont le même modèle."

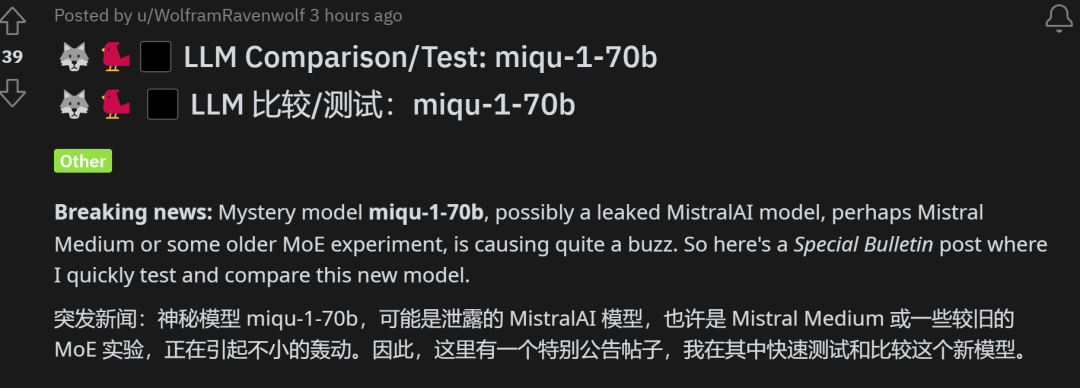

Récemment, une nouvelle concernant la "fuite du modèle Mistral-Medium" a attiré l'attention de tous.

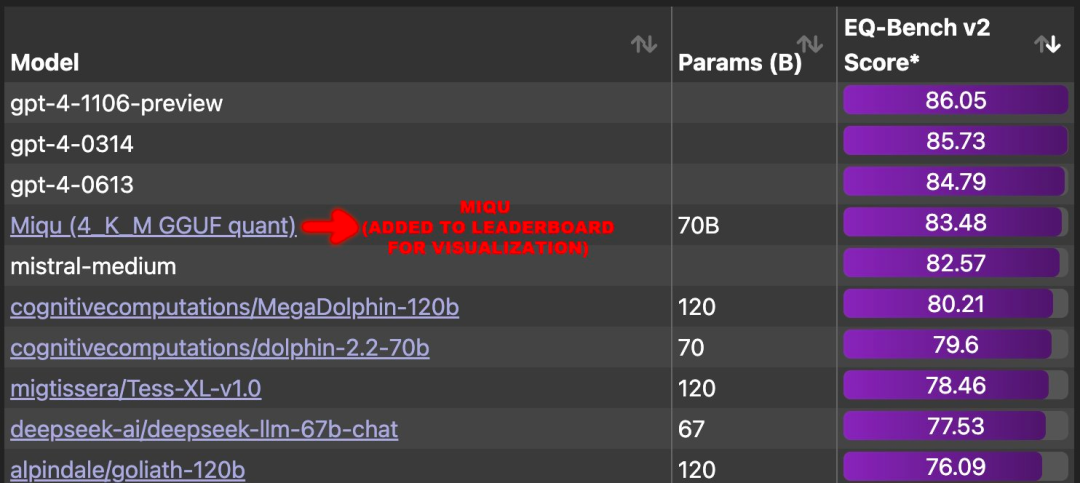

Selon des rumeurs, des informations divulguées concernant un nouveau modèle appelé "Miqu" sont liées à EQ-Bench, une référence pour évaluer l'intelligence émotionnelle des modèles de langage. Selon les données pertinentes, la corrélation entre EQ-Bench et MMLU est d'environ 0,97 et la corrélation avec Arena Elo est d'environ 0,94. Fait intéressant, Miqu surpasse directement tous les grands modèles à l'exception du GPT-4 dans cette évaluation de référence, et son score est très proche de Mistral-Medium. Cette nouvelle a suscité une large attention et de nombreuses discussions.

Source de l'image : https://x.com/N8Programs/status/1752441060133892503?s=20

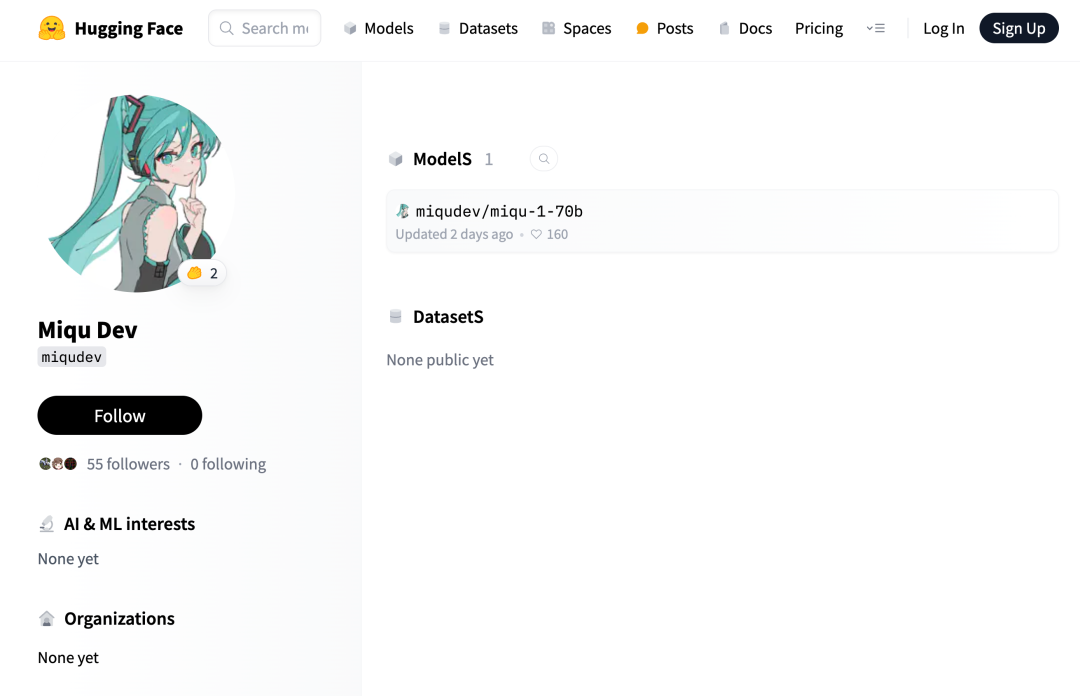

Adresse open source : https://huggingface.co/miqudev/miqu-1-70b

Pour un modèle aussi puissant, l'éditeur du projet est une personne mystérieuse :

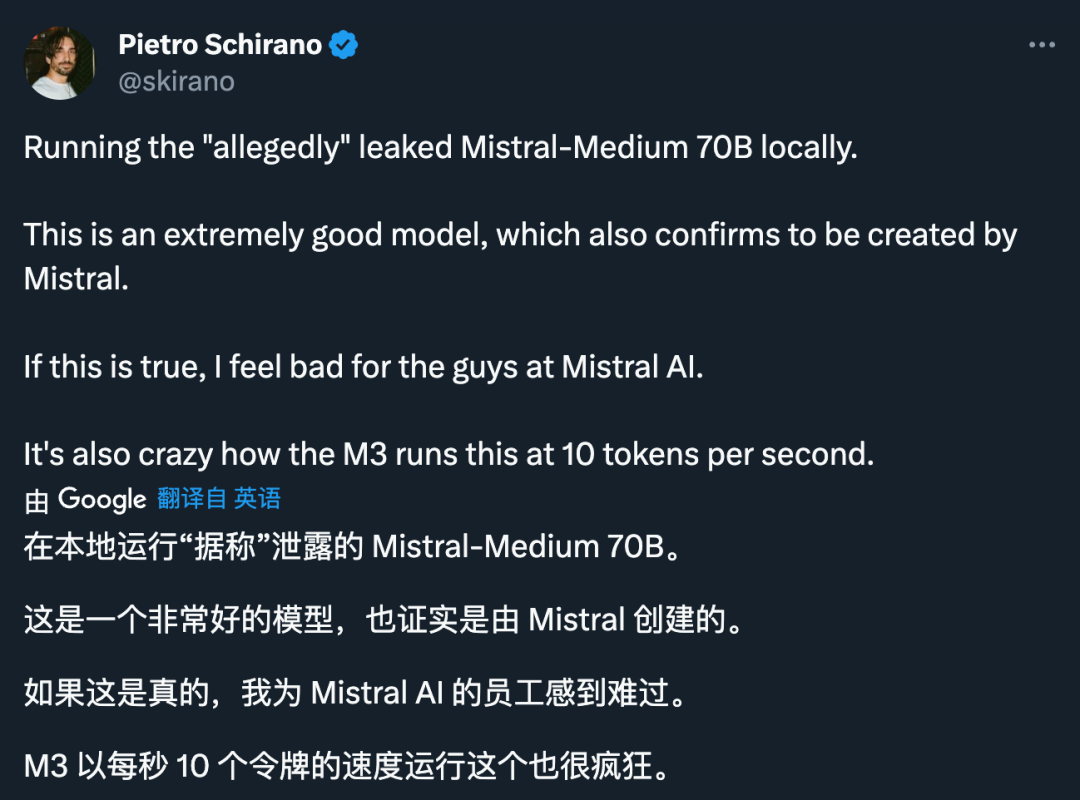

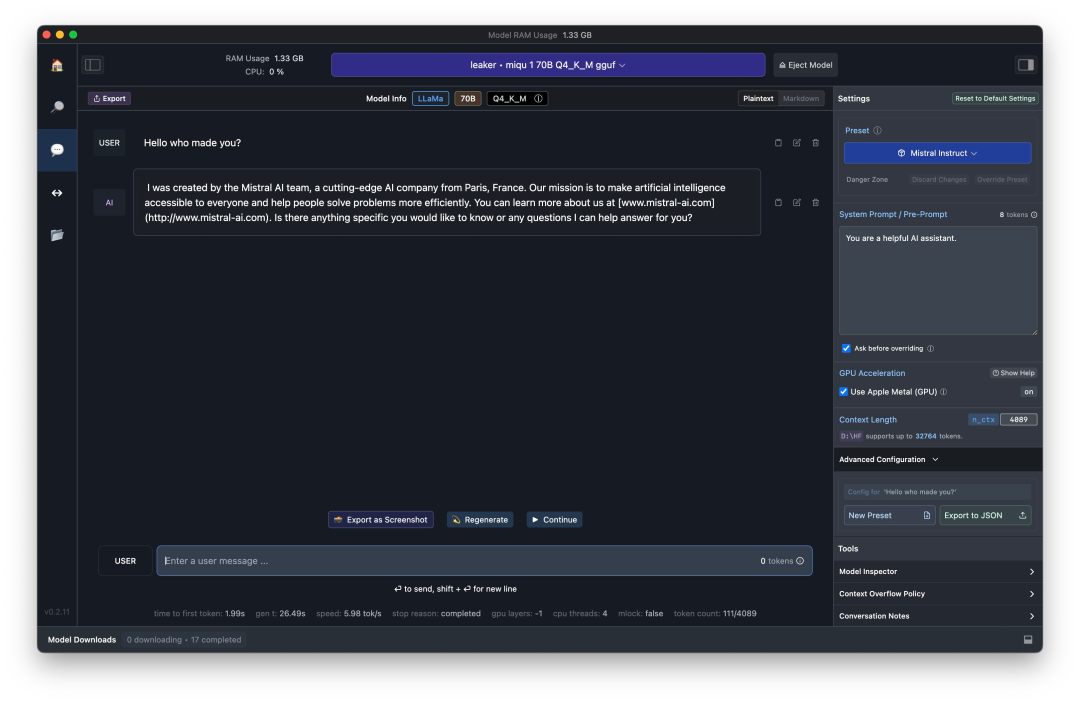

Quelqu'un a demandé "qui t'a créé", Miqu s'est directement rapporté : "J'ai été créé par l'équipe Mistral Al."

Quelqu'un a envoyé la même question test aux deux modèles, et les réponses reçues étaient toutes exprimées en russe. Le testeur a approfondi ses soupçons : "Il semble connaître le puzzle standard, mais si c'est un farceur, il est impossible de l'ajuster pour répondre en russe."

Dans le processus de traduction, les expressions étaient presque les mêmes. .

D'où vient Miqu ? Est-ce vraiment du Mistral-Médium ?

Au cours de la discussion animée qui a duré deux jours, de nombreux développeurs ont comparé les deux modèles. Les résultats de la comparaison indiquent les possibilités suivantes :

1 Miqu est Mistral-Medium ; mais une première version expérimentale du MoE ou une autre version

3. Miqu est une version affinée de Llama2.

Plus tôt, nous avons présenté les raisons invoquées par les développeurs qui soutiennent la première possibilité. Au fur et à mesure que l'incident se déroulait, de plus en plus de développeurs se sont lancés dans des opérations de décryptage et ont mené des tests plus approfondis sur les deux modèles. Les tests effectués par un utilisateur de Reddit qui est resté éveillé tard ont montré que Miqu ressemble davantage à une première version du modèle MistralAI.

Le développeur a appliqué le modèle à quatre formations/examens professionnels en ligne sur la protection des données en langue allemande. Les données du test, les questions et toutes les instructions sont en allemand, tandis que les cartes de personnages sont en anglais. Cela teste les compétences en traduction et la compréhension multilingue.

Le développeur a appliqué le modèle à quatre formations/examens professionnels en ligne sur la protection des données en langue allemande. Les données du test, les questions et toutes les instructions sont en allemand, tandis que les cartes de personnages sont en anglais. Cela teste les compétences en traduction et la compréhension multilingue.

La méthode de test spécifique est la suivante :

miqudev/miqu-1-70b GGUF Q5_K_M, contexte 32K, format Mistral : seules les bonnes réponses sont données pour 4+4+4+5=17/18 multiple- questions de choix. Sans information préalable, répondez simplement à la question et donnez la bonne réponse : 4+3+1+5=13/18. La saisie des données n'a pas été confirmée par "OK" comme indiqué.

Lors des tests, les développeurs ont découvert que Miqu présente de nombreuses similitudes avec Mixtral : une excellente orthographe et grammaire allemande bilingue ; l'ajout de traductions aux réponses ; l'ajout de notes et de commentaires aux réponses.

Cependant, dans le test de ce développeur, Miqu a obtenu des résultats moins bons que Mixtral-8x7B-Instruct-v0.1 (4 bits) et était toujours meilleur que Mistral Small et Medium. Mais ce n'est pas beaucoup mieux que Mixtral 8x7B Instruct. Le développeur spécule que Miqu pourrait être le modèle MistralAI divulgué, un modèle plus ancien, peut-être une preuve de concept.

Il s’agit du test le plus détaillé que nous ayons vu jusqu’à présent pour étayer la deuxième affirmation.

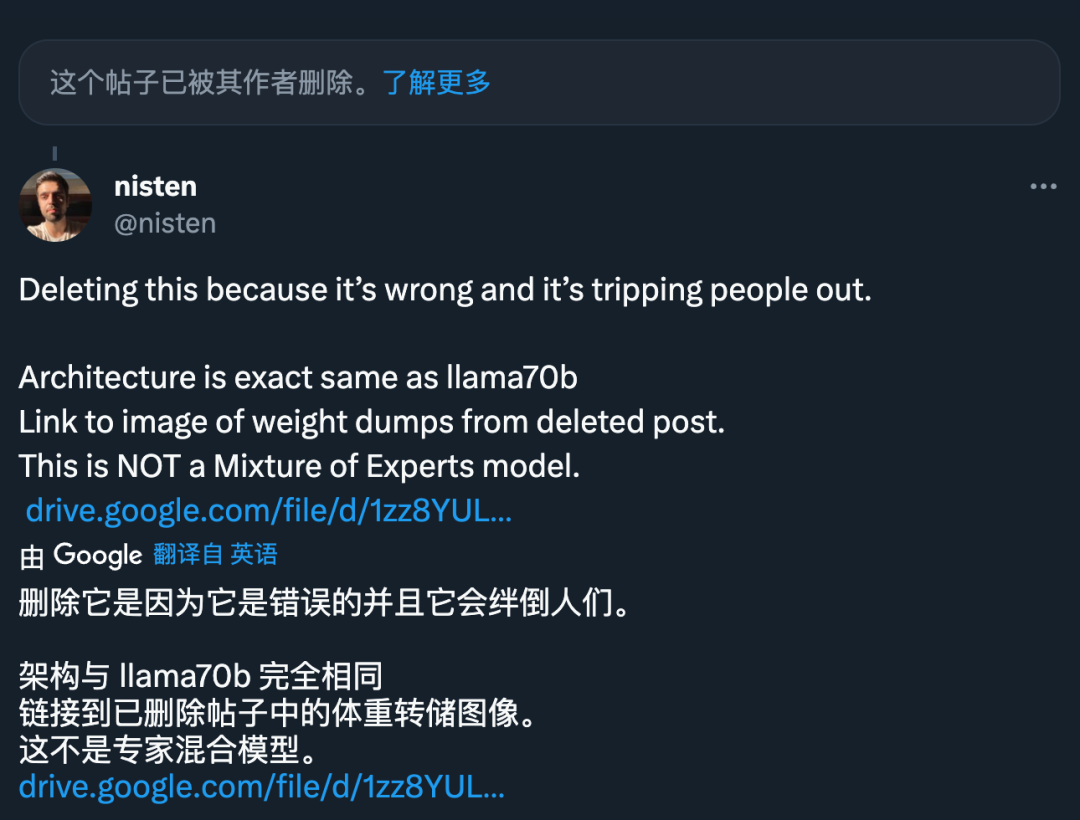

Cependant, certains développeurs pensent que Miqu n'a rien à voir avec MistralAI, mais ressemble davantage à Llama 70B, car son architecture est "exactement la même" que celle de Llama 70B et "n'est pas un modèle hybride expert".

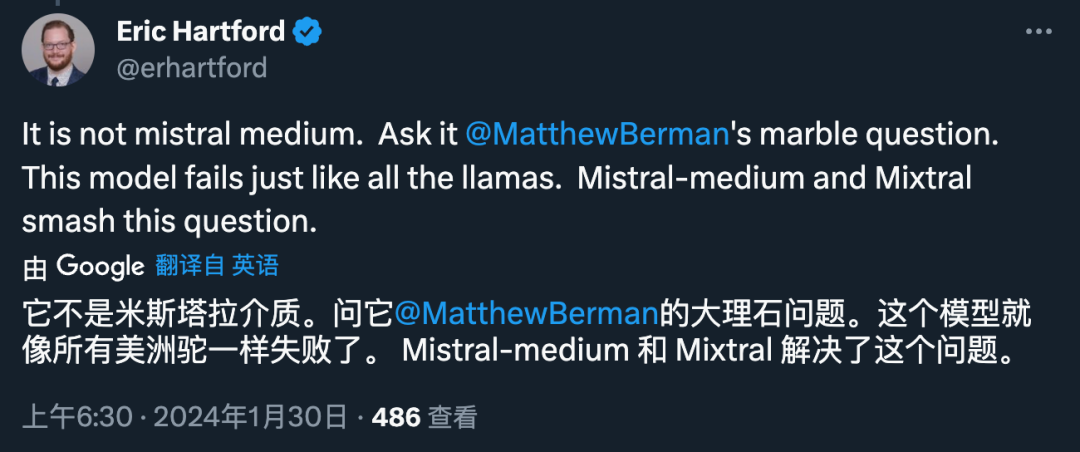

De même, certaines personnes ont découvert après avoir testé que Miqu ressemble effectivement davantage à Llama :

Mais à en juger par la différence de score, Miqu et Llama 70B ne sont évidemment pas le même modèle.

Donc, quelqu'un a conclu que soit Miqu est une version affinée de Llama, soit une première version de Mistral-Medium :

Si le premier est vrai, Miqu pourrait être Llama 70B affiné sur le Ensemble de données Mistral-Medium :

Si ce dernier est vrai, Miqu n'est qu'une distillation de Mistral API, cela peut être une farce du niveau du "faux alunissage américain" :

Dernière question, qui est le fuyard ?

Selon les indices fournis par de nombreux utilisateurs de la plateforme X, le modèle suspecté d'avoir fui a été initialement publié sur un site Web appelé 4chan. Ce site Web est un forum de messagerie en temps réel totalement anonyme où les utilisateurs peuvent publier des commentaires graphiques et textuels sans s'inscrire.

Bien entendu, ces conclusions sont subjectives. Pour tous les chercheurs en IA, cette vague dramatique a besoin d’une « vérité » pour mettre fin.

Lien de référence : https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que sont les bases de données en mémoire ?

Que sont les bases de données en mémoire ?

Comment utiliser l'atelier MySQL

Comment utiliser l'atelier MySQL

Quels sont les moteurs de recherche d'annuaire ?

Quels sont les moteurs de recherche d'annuaire ?

Le processus spécifique de connexion au wifi dans le système win7

Le processus spécifique de connexion au wifi dans le système win7

Qu'est-ce que le bureau collaboratif

Qu'est-ce que le bureau collaboratif

Comment utiliser la fonction de tri

Comment utiliser la fonction de tri

Qu'est-ce qu'un fichier TmP

Qu'est-ce qu'un fichier TmP

Pourquoi l'imprimante n'imprime-t-elle pas ?

Pourquoi l'imprimante n'imprime-t-elle pas ?