Stability AI a récemment publié son premier modèle d'IA en 2024, appelé Stable Code 3B. Ce modèle comporte 3 milliards de paramètres et se concentre sur les tâches de code auxiliaires.

Exécutez nativement sur un ordinateur portable sans avoir besoin d'un GPU dédié, tout en offrant des performances compétitives avec de grands modèles comme le CodeLLaMA 7B de Meta.

Fin 2023, Stability AI a commencé à promouvoir le développement de modèles plus petits, plus compacts et plus puissants, comme le modèle StableLM Zephyr 3B pour la génération de texte.

Début 2024, Stability AI a publié un modèle de langage important appelé Stable Code 3B. En fait, sa version préliminaire, Stable Code Alpha 3B, a été publiée dès août de l'année dernière. Depuis lors, Stability AI a continué à améliorer la technologie. Cette nouvelle version de Stable Code 3B est conçue pour la complétion de code et possède également une variété de fonctionnalités supplémentaires.

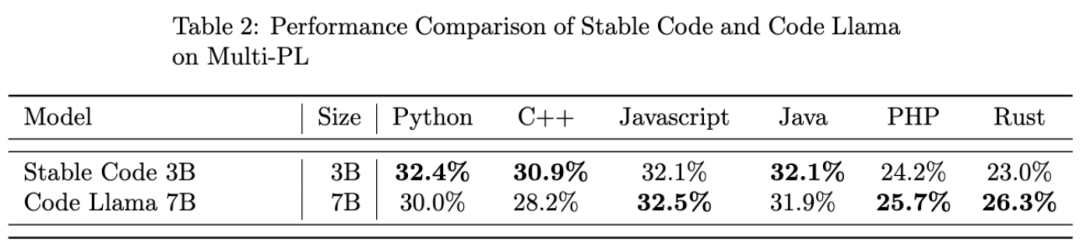

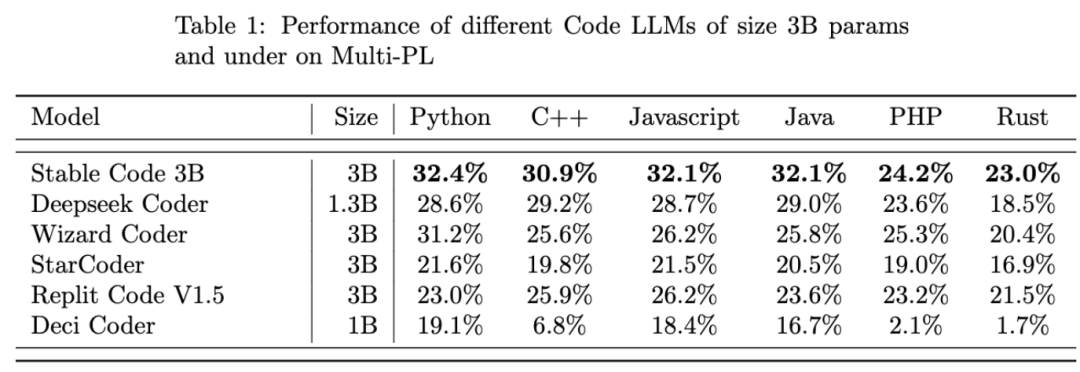

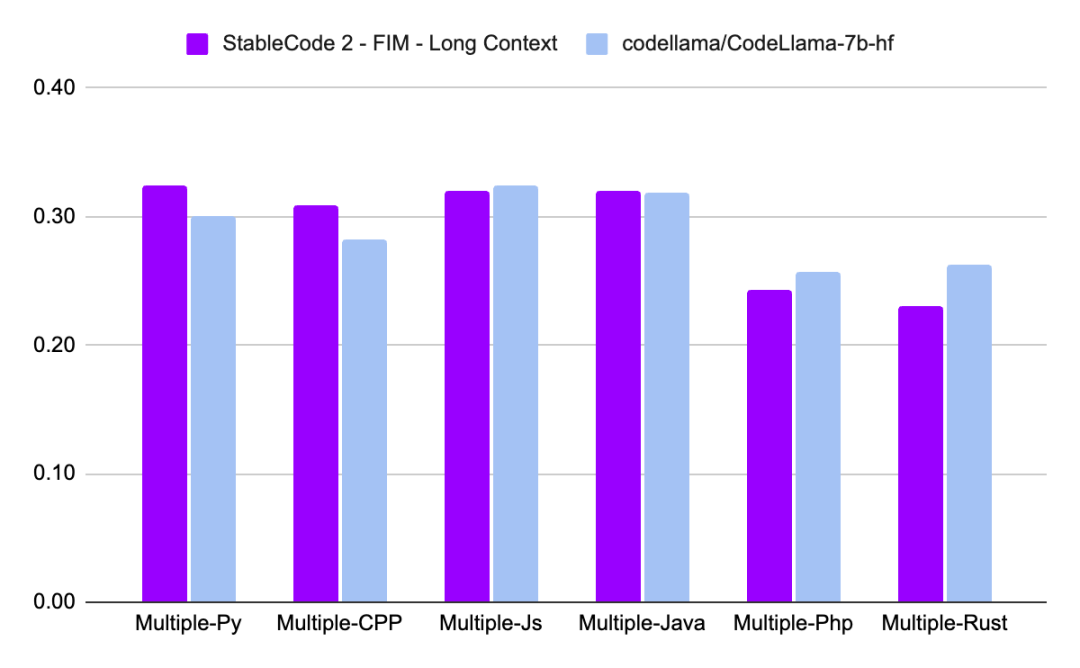

Comparé à CodeLLaMA 7b, Stable Code 3B est 60 % plus petit en taille, mais atteint des performances comparables au premier sur les tâches de programmation.

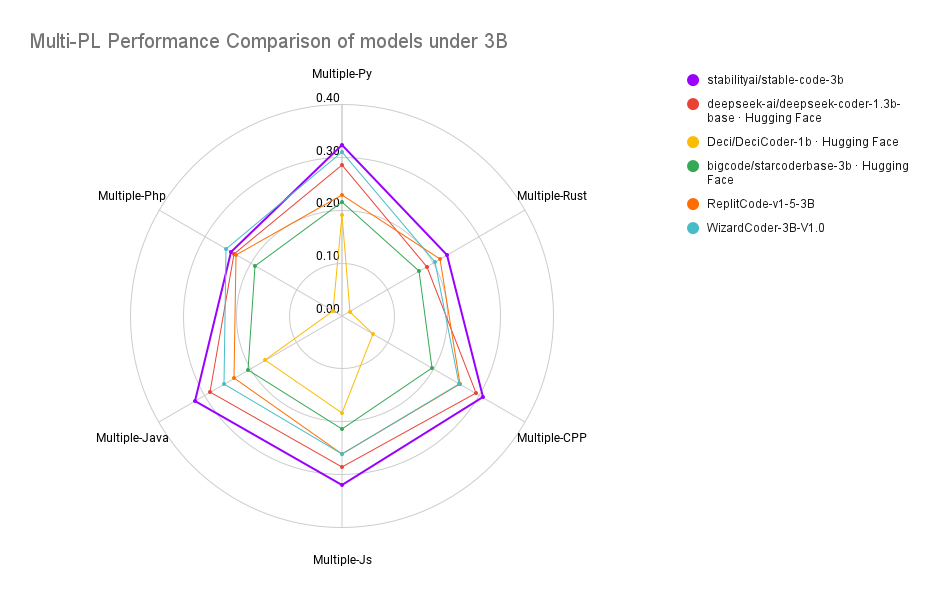

Stable Code 3B atteint des performances SOTA (par rapport à des modèles de taille similaire) sur le benchmark MultiPL-E, comme Stable Code 3B sur les langages de programmation Python, C++, JavaScript, Java, PHP et Rust Les performances sont meilleures que StarCoder.

Stable Code 3B est formé sur la base de Stable LM 3B, qui a un nombre de jetons de formation allant jusqu'à 4 000 milliards. De plus, Stable Code utilise également des données spécifiques au génie logiciel pour la formation.

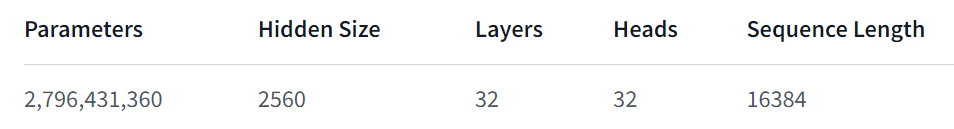

Stable Code 3B offre plus de fonctionnalités, fonctionne bien même dans plusieurs langues et présente également d'autres avantages, tels que la prise en charge de la fonction FIM (Fill in the Middle, une nouvelle technique de formation) et peut être étendu à la taille du contexte. Le code stable de base est formé sur jusqu'à 16 384 séquences de jetons et suit une approche similaire à CodeLlama, c'est-à-dire en utilisant des intégrations rotatives, qui permettent éventuellement de modifier jusqu'à 1 000 000 de bases de rotation. La longueur du contexte du modèle est en outre étendue à 100 000 jetons. .

En termes d'architecture de modèle, le modèle Stable Code 3B est un pur transformateur décodeur, similaire à l'architecture LLaMA, avec les modifications suivantes :

Training DataSet

Stable Code 3B L'ensemble de données de formation est composé d'une combinaison filtrée d'ensembles de données à grande échelle open source disponibles sur HuggingFace Hub, y compris Falcon RefinedWeb, CommitPackft , Github Issues, StarCoder et complètent davantage la formation avec des données du domaine des mathématiques.

Infrastructure de formation

Enfin, jetons un coup d'œil aux performances de Stable Code 3B :

Un rapport technique plus détaillé sur Stable Code 3B sera publié plus tard, vous pouvez l'attendre avec impatience.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Utilisation de la fonction sqrt en Java

Utilisation de la fonction sqrt en Java

Comment mesurer la vitesse du réseau sur un ordinateur

Comment mesurer la vitesse du réseau sur un ordinateur

Solution au problème selon lequel l'entrée n'est pas prise en charge au démarrage de l'ordinateur

Solution au problème selon lequel l'entrée n'est pas prise en charge au démarrage de l'ordinateur

éditeur HTML en ligne

éditeur HTML en ligne

Que signifie ajouter en Java ?

Que signifie ajouter en Java ?

Erreur de connexion au serveur d'identifiant Apple

Erreur de connexion au serveur d'identifiant Apple

Quelle plateforme est Fengxiangjia ?

Quelle plateforme est Fengxiangjia ?

Que dois-je faire si eDonkey Search ne parvient pas à se connecter au serveur ?

Que dois-je faire si eDonkey Search ne parvient pas à se connecter au serveur ?