Les modèles linguistiques à grande échelle ont ouvert un nouveau paysage pour la conduite intelligente, leur donnant une pensée et des capacités cognitives semblables à celles des humains. Cet article examine en profondeur le potentiel des grands modèles de langage (LLM) dans la conduite autonome (AD). Ensuite, DriveMLM est proposé, qui est un framework AD basé sur LLM qui peut réaliser une conduite autonome en boucle fermée dans l'environnement de simulation. Plus précisément, il y a les points suivants :

Enfin, nous avons mené des expériences approfondies sur DriveMLM, et les résultats ont montré que DriveMLM a atteint un score de conduite de 76,1 sur CARLA Town05 Long et a dépassé la ligne de base d'Apollo de 4,7 points dans les mêmes paramètres, prouvant l'efficacité de DriveMLM. Nous espérons que ces travaux pourront servir de base pour la conduite autonome LLM.

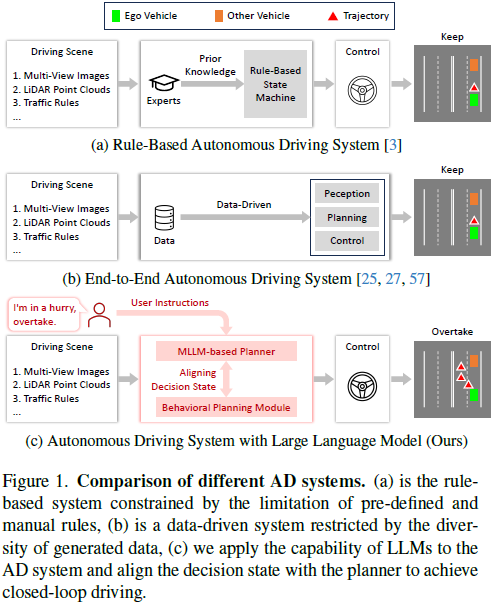

Ces dernières années, la conduite autonome (AD) a fait des progrès significatifs, comme le montre la figure 1b, passant d'un système traditionnel basé sur des règles à un système de bout en bout basé sur les données. Le système de règles traditionnel s'appuie sur un ensemble prédéfini de règles fournies par des connaissances a priori (voir Figure 1a). Malgré les progrès de ces systèmes, ils rencontrent encore des limites dues aux limitations des connaissances des experts ou à la diversité des données de formation. Cela rend difficile la gestion des situations de virage, même si les conducteurs humains peuvent trouver la gestion de ces situations intuitive. Par rapport à ces planificateurs AD traditionnels basés sur des règles ou basés sur des données, les grands modèles de langage (LLM) formés à l'aide de corpus de textes à l'échelle du Web possèdent une connaissance approfondie du monde, un raisonnement logique robuste et des capacités cognitives avancées. Ces capacités les positionnent comme des planificateurs potentiels dans les systèmes AD, offrant une approche humaine de la conduite autonome.

Certaines recherches récentes ont intégré le LLM dans les systèmes AD, en se concentrant sur la génération de décisions basées sur le langage pour des scénarios de conduite. Cependant, ces méthodes présentent des limites lorsqu’il s’agit d’effectuer une conduite en boucle fermée dans des environnements réels ou des simulations réelles. En effet, le résultat du LLM est principalement constitué de langage et de concepts et ne peut pas être utilisé pour le contrôle du véhicule. Dans les systèmes AD modulaires traditionnels, l'écart entre les objectifs stratégiques de haut niveau et les comportements de contrôle de bas niveau est connecté via le module de planification du comportement, et l'état décisionnel de ce module peut être facilement converti en signaux de contrôle du véhicule grâce à une planification de mouvement ultérieure et contrôle. Cela nous motive à aligner le LLM sur l'état décisionnel du module de planification du comportement et à concevoir davantage un système AD en boucle fermée basé sur le LLM en utilisant le LLM aligné pour la planification du comportement, qui peut s'exécuter dans un environnement réel ou un environnement de simulation réaliste.

Sur cette base, nous avons proposé DriveMLM, le premier framework AD basé sur LLM capable de réaliser une conduite autonome en boucle fermée dans un environnement de simulation réaliste. Pour y parvenir, nous avons trois conceptions clés : (1) Nous étudions les états décisionnels du module de planification comportementale du système Apollo et les transformons en une forme que LLM peut facilement traiter. (2) Un planificateur LLM multimodal (MLLM) est développé qui peut accepter les entrées multimodales actuelles, y compris les images multi-vues, les nuages de points lidar, les règles de circulation, les messages système et les instructions utilisateur, et prédire l'état de décision (3) Afin d'obtenir ; suffisamment de données de formation pour l'alignement de la planification du comportement et de l'état, nous avons collecté manuellement 280 heures de données de conduite sur CARLA et les avons converties en états de décision et en annotations d'explication correspondantes via un moteur de données efficace. Grâce à ces conceptions, nous pouvons obtenir un planificateur MLLM capable de prendre des décisions basées sur des scénarios de conduite et des besoins des utilisateurs, et ses décisions peuvent être facilement converties en signaux de commande du véhicule pour la conduite en boucle fermée.

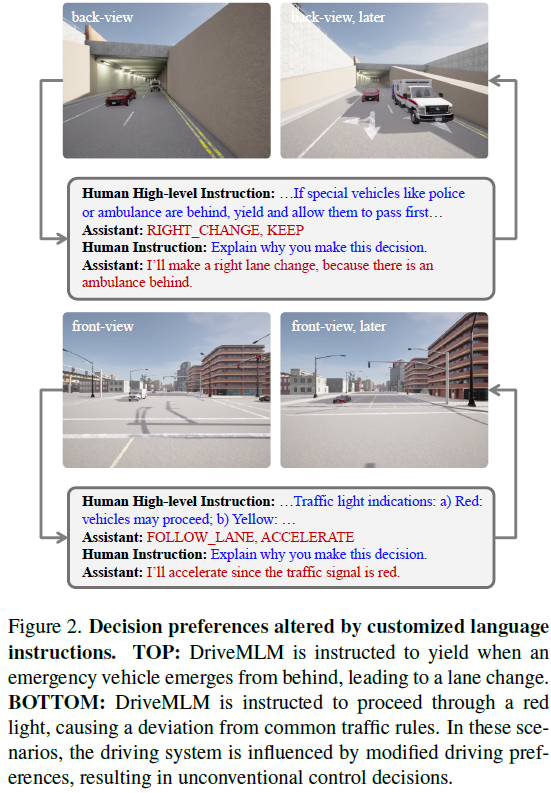

DriveMLM présente les avantages suivants : (1) Grâce à l'état de prise de décision cohérent, DriveMLM peut être facilement intégré aux systèmes AD modulaires existants (tels qu'Apollo) pour obtenir une conduite en boucle fermée sans aucun changement ou modification majeur. (2) En prenant les instructions linguistiques en entrée, notre modèle peut gérer les besoins des utilisateurs (par exemple, dépasser la voiture) et les messages système de haut niveau (par exemple, définir une logique de conduite de base). Cela rend DriveMLM plus flexible et capable de s'adapter à différentes situations de conduite et courbes. (3) Il peut fournir une interprétabilité et expliquer différentes décisions. Cela améliore la transparence et la fiabilité de notre modèle, car il peut expliquer ses actions et ses choix aux utilisateurs.

En résumé, les principales contributions de DriveMLM sont les suivantes :

Le framework DriveMLM intègre la connaissance du monde et les capacités de raisonnement des grands modèles de langage (LLM) dans les systèmes de conduite autonome (AD) pour réaliser une conduite en boucle fermée dans un environnement de simulation réaliste. Comme le montre la figure 3, ce cadre comporte trois conceptions clés : (1) L'alignement de l'état de la planification des comportements. Cette partie aligne le résultat de décision linguistique de LLM avec le module de planification du comportement des systèmes AD modulaires matures tels qu'Apollo. De cette manière, la sortie du LLM peut être facilement convertie en signaux de commande du véhicule. (2) Planificateur MLLM. Il s'agit d'une combinaison d'un marqueur multimodal et d'un décodeur multimodal LLM (MLLM). Le marqueur multimodal convertit différentes entrées (telles que les images multi-vues, le lidar, les règles de circulation et les exigences des utilisateurs) en balises unifiées, et le décodeur MLLM prend des décisions basées sur les balises unifiées. (3) Stratégie efficace de collecte de données. Il introduit une méthode de collecte de données sur mesure pour la conduite autonome basée sur LLM, garantissant un ensemble de données complet comprenant l'état de la décision, l'interprétation de la décision et les commandes de l'utilisateur.

Pendant le processus d'inférence, le framework DriveMLM utilise des données multimodales pour prendre des décisions de conduite. Ces données comprennent : des images surround et des nuages de points. Les messages système sont un ensemble de définitions de tâches, de règles de trafic et de définitions de statut de décision. Ces jetons sont entrés dans le décodeur MLLM, qui génère des jetons d'état de décision ainsi que les explications correspondantes. Enfin, l'état de décision est entré dans le module de planification et de contrôle de mouvement. Ce module calcule la trajectoire finale du contrôle du véhicule.

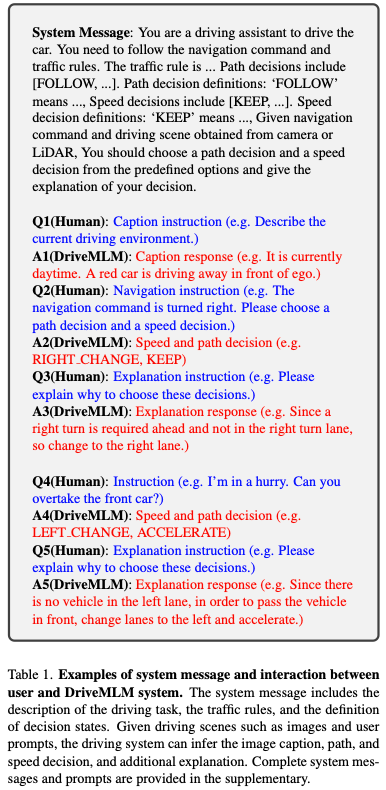

La traduction des sélections linguistiques des grands modèles linguistiques (LLM) en signaux de contrôle exploitables est essentielle pour le contrôle du véhicule. Pour y parvenir, nous avons aligné les résultats du LLM sur la phase de décision du module de planification comportementale du système Apollo populaire. Sur la base d'approches communes, nous divisons le processus de prise de décision en deux catégories : la prise de décision rapide et la prise de décision sur le chemin. Plus précisément, l'état de décision de vitesse comprend (maintenir, accélérer, décélérer, arrêter), et l'état de décision de chemin comprend (SUIVRE, CHANGEMENT À GAUCHE, CHANGEMENT À DROITE, EMPRUNTER À GAUCHE, EMPRUNTER À DROITE).

Pour permettre au modèle de langage de faire des prédictions précises entre ces états, nous établissons une connexion complète entre la description du langage et l'état de décision, comme le montrent les informations système du tableau 1. Cette corrélation est utilisée dans le cadre des messages système et intégrée dans le planificateur MLLM. Par conséquent, une fois que le LLM décrit certaines situations, les prédictions convergeront vers des décisions claires au sein de l’espace décisionnel. À chaque fois, une décision de vitesse et une décision de trajectoire sont déduites l'une de l'autre et envoyées au cadre de planification de mouvement. Une définition plus détaillée des états de décision peut être trouvée dans les documents supplémentaires.

Le planificateur MLLM de DriveMLM se compose de deux composants : un tokeniseur multimodal et un décodeur MLLM. Les deux modules travaillent en étroite collaboration, traitant diverses entrées pour déterminer avec précision les décisions de conduite et fournir des explications pour ces décisions.

Tokenizer multimodal. Ce tokenizer est conçu pour gérer efficacement diverses formes d'entrée : Pour les images de recherche temporelles : utilisez un QFormer temporel pour traiter l'image de recherche de l'horodatage −T à 0 (l'horodatage actuel). Pour les données lidar, nous saisissons d'abord le nuage de points en entrée du squelette Sparse Pyramid Transformer (SPT) pour extraire les caractéristiques lidar. Pour les messages système et les instructions utilisateur, nous les traitons simplement comme des données texte ordinaires et utilisons la couche d'intégration de jetons de LLM pour extraire leurs intégrations.

Décodeur MLLM. Le décodeur est au cœur de la conversion des entrées tokenisées en états de décision et en interprétations de décision. À cette fin, nous avons conçu un modèle de message système pour AD basé sur LLM, comme indiqué dans le tableau 1. Comme on peut le voir, le message système contient une description de la tâche AD, des règles de circulation, une définition des états de décision et des espaces réservés indiquant où chaque information modale est fusionnée. Cette approche garantit une intégration transparente des contributions provenant de diverses modalités et sources.

La sortie est formatée pour fournir le statut de la décision (voir Q2 dans le tableau 1) et l'explication de la décision (voir Q3 dans le tableau 1), offrant ainsi transparence et clarté dans le processus de prise de décision. Concernant les méthodes supervisées, notre cadre suit la pratique courante consistant à utiliser la perte d'entropie croisée dans la prédiction du prochain jeton. De cette manière, les planificateurs MLLM peuvent développer une compréhension et un traitement détaillés des données provenant de différents capteurs et sources et les traduire en décisions et interprétations appropriées.

Nous proposons un paradigme de génération de données qui peut créer des états de décision et des annotations explicatives à partir de divers scénarios dans le simulateur CARLA. Ce pipeline peut remédier aux limites des données de conduite existantes, qui manquent d'états de décision et d'explications détaillées pour la formation des systèmes AD basés sur LLM. Notre pipeline se compose de deux composants principaux : la collecte de données et l'annotation des données.

La collecte de données est conçue pour accroître la diversité dans la prise de décision tout en restant réaliste. Premièrement, divers scénarios difficiles sont construits dans un environnement de simulation. Une conduite sûre nécessite des comportements de conduite complexes. Des experts, qu'il s'agisse de conducteurs humains expérimentés ou d'agents, sont ensuite invités à conduire en toute sécurité ces scénarios, qui se déclenchent dans l'un de ses nombreux endroits accessibles. Notamment, les données d'interaction sont générées lorsque des experts proposent au hasard des demandes de conduite et conduisent en conséquence. Une fois que l’expert se rend à destination en toute sécurité, les données sont enregistrées.

L'annotation des données se concentre principalement sur la prise de décision et l'interprétation. Premièrement, les états de décision en matière de vitesse et de trajectoire sont automatiquement annotés sur la base de trajectoires de conduite expertes à l’aide de règles élaborées à la main. Deuxièmement, les annotations explicatives sont d'abord générées en fonction de la scène, définie dynamiquement par les éléments courants proches. Troisièmement, les annotations d'explication générées sont affinées par des annotations manuelles et leur diversité est élargie par GPT-3.5. De plus, le contenu de l'interaction est également affiné par des annotateurs humains, y compris l'exécution ou le rejet de requêtes humaines. De cette manière, nous évitons les coûteuses annotations d’état de décision image par image, ainsi que l’écriture manuelle coûteuse d’annotations d’explication à partir de zéro, accélérant considérablement notre processus d’annotation de données.

Nous avons collecté 280 heures de données de conduite pour la formation. Les données comprennent 50 kilomètres d'itinéraires et 30 scénarios de conduite avec différentes conditions météorologiques et d'éclairage collectées sur les 8 cartes de CARLA (Town01, Town02, Town03, Town04, Town06, Town07, Town10HD, Town12). En moyenne, chaque scène comporte environ 200 points de déclenchement sur chaque carte qui se déclenchent de manière aléatoire. Chaque situation est une situation courante ou rare critique pour la sécurité de la conduite. Les détails de ces scénarios sont fournis dans les notes complémentaires. Pour chaque image, nous collectons des images de quatre caméras, avant, arrière, gauche et droite, ainsi que des nuages de points provenant d'un capteur lidar ajouté au centre du véhicule de l'ego. Toutes les données que nous collectons ont des interprétations correspondantes et des décisions précises qui font avancer le scénario avec succès.

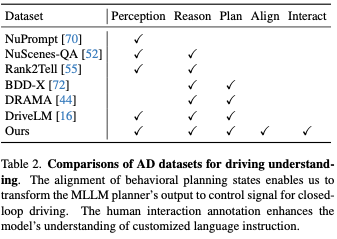

Le tableau 2 présente une comparaison avec les ensembles de données précédents conçus pour améliorer la compréhension à l'aide du langage naturel. Nos données présentent deux caractéristiques uniques. Le premier est la cohérence des états de planification comportementale. Cela nous permet de convertir la sortie du planificateur MLLM en signaux de contrôle afin que notre cadre puisse contrôler le véhicule en conduite en boucle fermée. La seconde est l’annotation des interactions interpersonnelles. Elle se caractérise par les instructions en langage naturel données par les humains et les décisions et interprétations correspondantes. L’objectif est d’améliorer la capacité à comprendre les instructions humaines et à réagir en conséquence.

Nous évaluons la conduite en boucle fermée dans CARLA, la référence de simulation la plus largement utilisée et la plus réaliste accessible au public. Des méthodes de pointe capables d'effectuer une conduite en boucle fermée dans CARLA sont incluses à des fins de comparaison des performances. L'Apollo open source a également été évalué dans CARLA comme référence. En dehors de notre approche, aucune autre approche basée sur le LLM n'a montré qu'elle était prête à être déployée et évaluée. Toutes les méthodes sont évaluées sur le benchmark à long terme Town05.

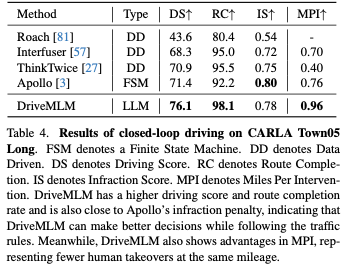

Le tableau 4 répertorie les scores de conduite, l'achèvement de l'itinéraire et les scores d'infraction. Notez que même si Apollo est une approche basée sur des règles, ses performances sont presque comparables à celles des approches récentes de bout en bout. DriveMLM surpasse considérablement toutes les autres méthodes en matière de scores de conduite. Cela suggère que DriveMLM est mieux adapté pour gérer les transitions d’état afin de traverser le disque dur en toute sécurité. La dernière colonne du tableau 4 montre les résultats de l'évaluation MPI. Cette métrique montre une performance de conduite plus complète car les agents doivent effectuer tous les itinéraires. En d’autres termes, toutes les situations sur tous les itinéraires seront rencontrées par l’agent testé. Thinktwice implémente un meilleur DS qu'Interfuser, mais a un MPI inférieur en raison du franchissement fréquent des lignes d'arrêt. Cependant, les sanctions imposées par CARLA pour ce comportement sont minimes. En revanche, MPI traite chaque infraction au code de la route comme une prise de contrôle. DriveMLM atteint également le MPI le plus élevé parmi toutes les autres méthodes, ce qui indique qu'il est capable d'éviter davantage de situations, ce qui se traduit par une expérience de conduite plus sûre.

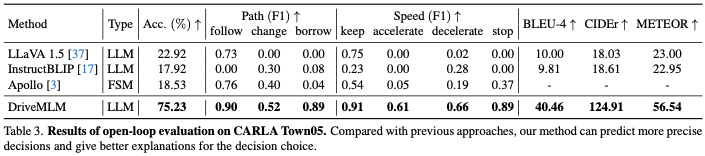

Nous utilisons l'évaluation en boucle ouverte pour évaluer les connaissances en matière de conduite, y compris les tâches de prédiction de décision et de prédiction d'explication. Le tableau 3 montre l'exactitude des paires de décisions prédites, le score F1 pour chaque type de décision prédit par la décision et les BLEU-4, CIDEr et METEOR expliqués par la prédiction. Pour Apollo, les scènes collectées manuellement sur Town05 seront lues comme entrée du modèle dans le tableau 3. L'état du modèle correspondant et la sortie à chaque horodatage de la rediffusion sont enregistrés en tant que prédictions pour les calculs de métriques. Pour les autres méthodes, nous leur donnons les images correspondantes en entrée et les invites appropriées. En comparant les prédictions du modèle à notre vérité terrain collectée manuellement, la précision révèle l'exactitude des décisions et la similitude avec le comportement humain, et les scores F1 démontrent la capacité de prise de décision pour chaque décision de trajectoire et de vitesse. DriveMLM a atteint la précision globale la plus élevée, dépassant LLaVA avec une précision de 40,97 %. Par rapport à la référence Apollo, DriveMLM obtient un score F1 plus élevé, ce qui indique qu'il surpasse plus efficacement les machines à états basées sur des règles dans la résolution de diverses situations routières. LLaVA, InstructionBLIP et notre proposition DriveMLM peuvent produire des explications de décision sous forme de questions et de réponses. En termes de BLEU-4, CIDEr et METEOR, DriveMLM peut atteindre les performances les plus élevées, ce qui indique que DriveMLM peut fournir l'explication la plus raisonnable des décisions.

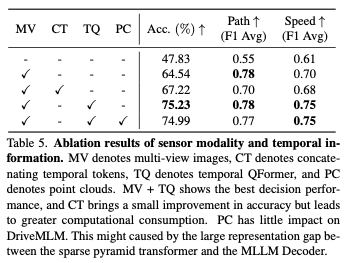

Modalité du capteur : Le tableau 5 montre les résultats des différents effets de la modalité du capteur d'entrée sur DriveMLM. Les images multi-vues (MV) apportent des améliorations significatives des performances en termes de scores F1 de trajectoire et de vitesse, avec une augmentation de la précision de 18,19 %. Par rapport aux jetons temporels connectés directement, Temporal QFormer réalise une amélioration supérieure de 7,4 % tout en garantissant des capacités de prise de décision multimodale, ce qui se traduit par une amélioration moyenne du score F1 de 0,05 pour les décisions de vitesse. Les nuages de points ne montrent pas la capacité d’améliorer les performances.

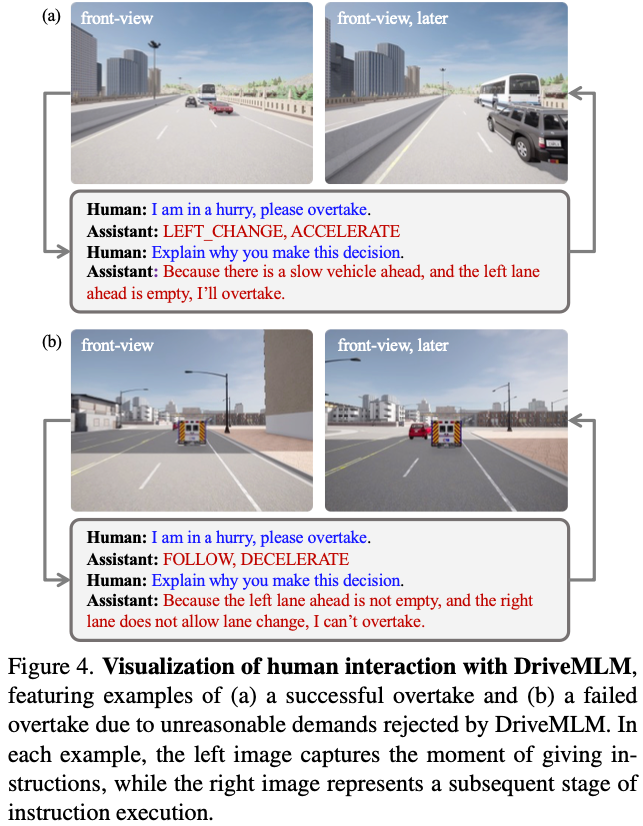

Interaction homme-machine : La figure 4 fournit un exemple de la façon dont le contrôle du véhicule peut être obtenu grâce à des instructions humaines. Le processus de contrôle comprend l'analyse des conditions routières, la prise de décisions et la fourniture de déclarations explicatives. Lorsqu'on lui a donné la même commande de « dépassement », DriveMLM a montré des réponses différentes en fonction de son analyse de la situation actuelle du trafic. Dans les situations où la voie de droite est occupée et la voie de gauche est disponible, le système choisit de dépasser par la gauche. Cependant, dans les situations où une instruction donnée pourrait présenter un danger, par exemple lorsque toutes les voies sont occupées, DriveMLM choisira de ne pas effectuer de manœuvre de dépassement et réagira de manière appropriée. Dans ce cas, DriveMLM est l'interface d'interaction homme-véhicule, qui évalue le caractère raisonnable des instructions en fonction de la dynamique du trafic et s'assure qu'elles respectent des règles prédéfinies avant de finalement sélectionner une ligne de conduite.

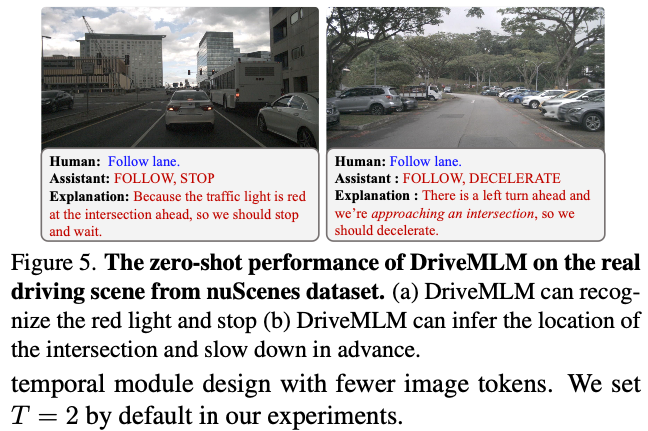

Performance dans des scénarios réels : Nous appliquons DriveMLM sur l'ensemble de données nuScenes pour tester les performances zéro tir du système de conduite développé. Nous avons annoté 6 019 images sur l'ensemble de validation et obtenu une performance zéro tir de 0,395 pour la précision des décisions. La figure 5 montre les résultats de deux scénarios de conduite réels, démontrant la polyvalence de DriveMLM.

Dans ce travail, nous avons proposé DriveMLM, un nouveau framework qui utilise de grands modèles de langage (LLM) pour la conduite autonome (AD). DriveMLM peut implémenter AD en boucle fermée dans un environnement de simulation réaliste en modélisant le module de planification comportementale d'un système AD modulaire à l'aide d'un LLM multimodal (MLLM). DriveMLM peut également générer des explications en langage naturel pour ses décisions de conduite, ce qui peut accroître la transparence et la fiabilité des systèmes AD. Nous avons montré que DriveMLM surpasse le benchmark Apollo sur le benchmark CARLA Town05 Long. Nous pensons que notre travail peut inspirer davantage de recherches sur l’intégration du LLM et de l’AD.

Lien open source : https://github.com/OpenGVLab/DriveMLM

Lien original : https://mp.weixin.qq.com/s/tQeERCbpD9H8oY8EvpZsDA

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!