Microsoft a publié un modèle d'intelligence artificielle appelé Phi-2, qui a démontré des capacités extraordinaires. Ses performances sont comparables, voire supérieures, à celles des modèles plus grands et plus matures, 25 fois plus grands.

Récemment, Microsoft a annoncé dans un article de blog que Phi-2 est un modèle de langage avec 2,7 milliards de paramètres. Comparé à d'autres modèles de base, Phi-2 présente des performances avancées, en particulier dans les tests de référence complexes. Ces évaluations de tests ont développé le raisonnement, la compréhension du langage, compétences en mathématiques, en codage et en connaissances générales. Maintenant, Phi-2 a été publié via le catalogue de modèles de Microsoft Azure Artificial Intelligence Studio, ce qui signifie que les chercheurs et les développeurs peuvent l'intégrer dans des applications tierces.

Phi-2 a été fondé par le PDG de Microsoft, Satya Nadella, en 11. Il a été publié pour la première fois à la conférence Ignite en mars. La puissance du produit vient de ce que Microsoft appelle des données de « qualité manuelle » spécialement conçues pour la connaissance et qui s'appuient également sur des techniques d'analyse d'autres modèles

Phi-2 est unique dans la mesure où il a précédemment La puissance d'un modèle est souvent étroitement liée à la taille de ses paramètres. De manière générale, un modèle avec plus de paramètres signifie des capacités plus puissantes. Cependant, l'émergence de Phi-2 a modifié ce concept traditionnel

Microsoft a déclaré que Phi-2 avait démontré sa capacité à égaler, voire à surpasser, des modèles de base plus grands dans certains tests de référence. Ces benchmarks incluent le paramètre Mistral de 7 milliards de Mistral AI, le Llama 2 de 13 milliards de paramètres de Meta Platforms, et dépassant même les 70 milliards de paramètres Llama-2 dans certains benchmarks

Une déclaration surprenante peut être, ses performances dépassent même celles de Gemini Nano de Google, le plus modèle efficace de la série Gemini sortie la semaine dernière. Gemini Nano est conçu pour les tâches sur l'appareil et peut fonctionner sur les smartphones, permettant des fonctionnalités telles que le résumé de texte, la relecture avancée, la correction grammaticale et les réponses intelligentes contextuelles

Les chercheurs de Microsoft ont déclaré que les tests impliqués dans Phi-2 sont très étendus, notamment compréhension du langage, raisonnement, mathématiques, défis de codage, et plus encore.

La société affirme que la raison pour laquelle Phi-2 obtient d'aussi excellents résultats est qu'il est formé avec des données soigneusement sélectionnées au niveau des manuels, conçues pour enseigner le raisonnement, les connaissances et le bon sens, ce qui signifie qu'il peut apprendre plus avec moins d'informations. Les chercheurs de Microsoft ont également utilisé des techniques permettant d'obtenir des connaissances à partir de modèles plus petits.

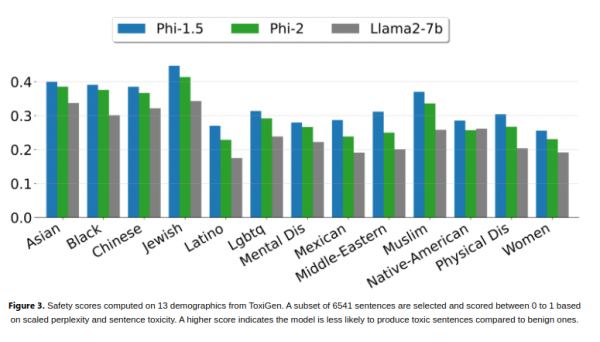

Les chercheurs ont souligné qu'il convient de noter que Phi-2 est toujours capable d'atteindre de solides performances sans utiliser de techniques telles que l'apprentissage par renforcement ou l'ajustement pédagogique basé sur les commentaires humains. Ces techniques sont souvent utilisées pour améliorer le comportement des modèles d’intelligence artificielle. Bien qu'il n'utilise pas ces techniques, Phi-2 parvient toujours à réduire les biais et les contenus préjudiciables par rapport à d'autres modèles open source qui le font. La société pense que cela est dû à la personnalisation de la gestion des données. Les chercheurs de Microsoft appellent Phi-2 la dernière version de la série « Small Language Model (SLM) ». Phi-1, le premier modèle de la série et lancé pour la première fois plus tôt cette année, possède 1,3 milliard de paramètres et est optimisé pour les tâches de codage Python de base. En septembre de cette année, Microsoft a lancé Phi-1.5, un modèle avec 1,3 milliard de paramètres et formé à l'aide de nouvelles sources de données, y compris une variété de textes synthétiques générés avec une programmation en langage naturel

Microsoft a déclaré que Phi-2 Sa haute efficacité en fait un idéal plate-forme permettant aux chercheurs d'explorer des domaines tels que l'amélioration de la sécurité de l'intelligence artificielle, l'interprétabilité et le développement éthique des modèles de langage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!