Lorsque l'industrie a été surprise que Baichuan Intelligent ait lancé un grand modèle en 28 jours en moyenne, l'entreprise ne s'est pas arrêtée.

Lors d'une conférence de presse dans l'après-midi du 6 septembre, Baichuan Intelligence a annoncé l'open source officiel du grand modèle Baichuan-2 affiné.

Zhang Bo, académicien de l'Académie chinoise des sciences et doyen honoraire de l'Institut d'intelligence artificielle de l'Université Tsinghua, était présent à la conférence de presse.

Zhang Bo, académicien de l'Académie chinoise des sciences et doyen honoraire de l'Institut d'intelligence artificielle de l'Université Tsinghua, était présent à la conférence de presse.

Il s'agit d'une autre nouveauté de Baichuan depuis la sortie du grand modèle Baichuan-53B en août. Les modèles open source incluent Baichuan2-7B, Baichuan2-13B, Baichuan2-13B-Chat et leurs versions quantifiées 4 bits, et ils sont tous gratuits et disponibles dans le commerce.

En plus de la divulgation complète du modèle, Baichuan Intelligence a également cette fois ouvert Check Point pour la formation du modèle et a publié le rapport technique Baichuan 2, détaillant les détails de la formation du nouveau modèle. Wang Xiaochuan, fondateur et PDG de Baichuan Intelligence, a exprimé l'espoir que cette décision puisse aider les grands établissements universitaires modèles, les développeurs et les utilisateurs d'entreprises à acquérir une compréhension approfondie du processus de formation des grands modèles et à mieux promouvoir le développement technologique des grands modèles. recherche universitaire et communautés.

Lien original grand modèle Baichuan 2 : https://github.com/baichuan-inc/Baichuan2

Rapport technique : https://cdn.baichuan-ai.com/paper/Baichuan2-technical-report.pdf

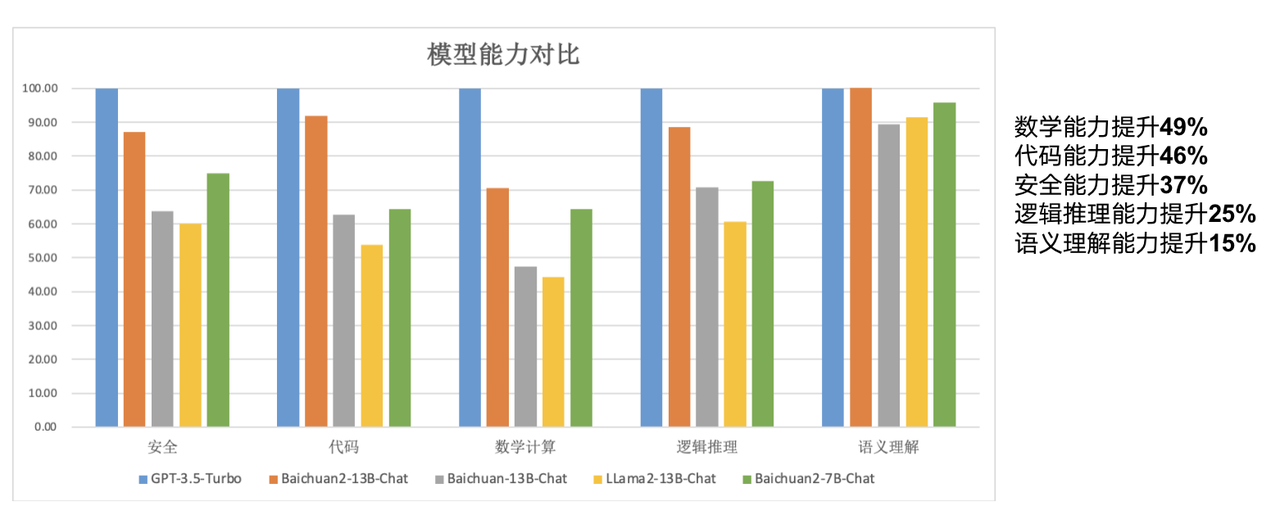

Les modèles open source d'aujourd'hui sont de taille « plus petite » par rapport aux grands modèles. Parmi eux, Baichuan2-7B-Base et Baichuan2-13B-Base sont tous deux formés sur la base de 2 600 milliards de données multilingues de haute qualité, conservant la génération précédente de modèles open source. Sur la base de nombreuses fonctionnalités telles que de bonnes capacités de génération et de création, des capacités de dialogue multi-tours fluides et un faible seuil de déploiement, les deux modèles ont considérablement amélioré leurs capacités en mathématiques, codage, sécurité, raisonnement logique et compréhension sémantique.

"Pour faire simple, le modèle à 7 milliards de paramètres de Baichuan7B est déjà à égalité avec le modèle à 13 milliards de paramètres de LLaMA2 sur le benchmark anglais. On peut donc utiliser le petit pour faire le grand, le petit modèle est équivalent au capacité du grand modèle, et dans le même corps Le modèle quantitatif peut atteindre des performances plus élevées, dépassant largement les performances de LLaMA2", a déclaré Wang Xiaochuan.

Par rapport au modèle 13B de la génération précédente, Baichuan2-13B-Base a amélioré ses capacités mathématiques de 49 %, ses capacités de codage de 46 %, ses capacités de sécurité de 37 %, ses capacités de raisonnement logique de 25 % et ses capacités de compréhension sémantique de 15 % .

Selon les rapports, les chercheurs de Baichuan Intelligence ont procédé à de nombreuses optimisations, depuis l'acquisition de données jusqu'à la mise au point du nouveau modèle.

"Nous nous sommes appuyés sur plus d'expérience lors de recherches précédentes, avons effectué une évaluation de la qualité du contenu multi-granularité sur une grande quantité de données de formation de modèles, utilisé 260 millions de T de niveau de corpus pour former des modèles 7B et 13B et ajouté un support multilingue." Wang Xiaochuan a dit. "Nous pouvons atteindre une performance de formation de 180TFLOPS dans le cluster Qianka A800, et le taux d'utilisation de la machine dépasse 50 %. De plus, nous avons également réalisé de nombreux travaux d'alignement de sécurité

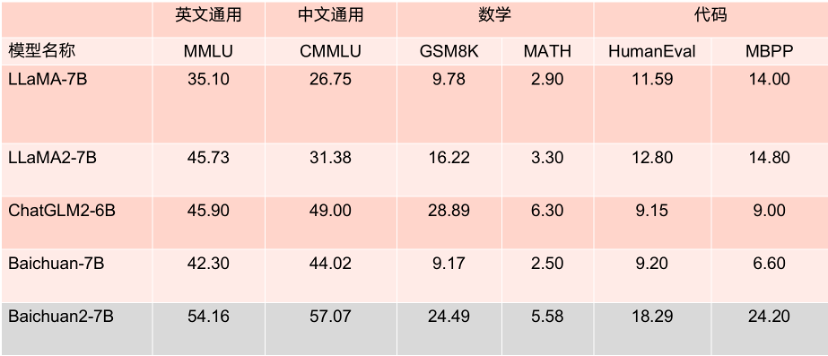

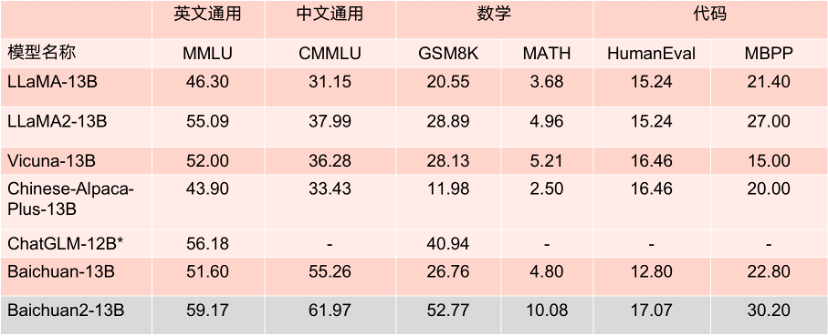

Les deux modèles open source cette fois sont largement." utilisé dans les principaux Les performances sur la liste d'évaluation sont excellentes. Dans plusieurs benchmarks d'évaluation faisant autorité tels que MMLU, CMMLU et GSM8K, il est largement en tête de LLaMA2. Par rapport à d'autres modèles avec le même nombre de paramètres, ses performances sont également très. impressionnant, et ses performances sont nettement meilleures que celles du produit concurrent LLaMA2 avec un modèle de même taille.

Ce qui mérite d'être mentionné, c'est que selon plusieurs critères d'évaluation en anglais faisant autorité tels que MMLU, Baichuan2-7B est à égalité avec LLaMA2 avec 13 milliards de paramètres sur les tâches anglaises traditionnelles avec 7 milliards de paramètres.

Résultats de référence du modèle de paramètres 7B.

Résultats de référence du modèle de paramètres 13B.

Baichuan2-7B et Baichuan2-13B sont non seulement entièrement ouverts à la recherche universitaire, mais les développeurs peuvent également les utiliser gratuitement à des fins commerciales après avoir postulé par e-mail pour obtenir une licence commerciale officielle.

"En plus de la publication de modèles, nous espérons également fournir davantage de soutien au domaine universitaire", a déclaré Wang Xiaochuan. « En plus du rapport technique, nous avons également ouvert le modèle de paramètres de poids dans le processus de formation du grand modèle Baichuan2. Cela peut aider tout le monde à comprendre la pré-formation, ou à effectuer des réglages et des améliorations. C'est également la première fois en Chine. qu'une entreprise a ouvert un tel modèle.》

La formation de grands modèles comprend plusieurs étapes telles que l'acquisition de données massives de haute qualité, la formation stable de clusters de formation à grande échelle et le réglage de l'algorithme du modèle. Chaque lien nécessite l'investissement d'une grande quantité de talents, de puissance de calcul et d'autres ressources. Le coût élevé de la formation complète d'un modèle à partir de zéro a empêché la communauté universitaire de mener des recherches approfondies sur la formation de grands modèles.

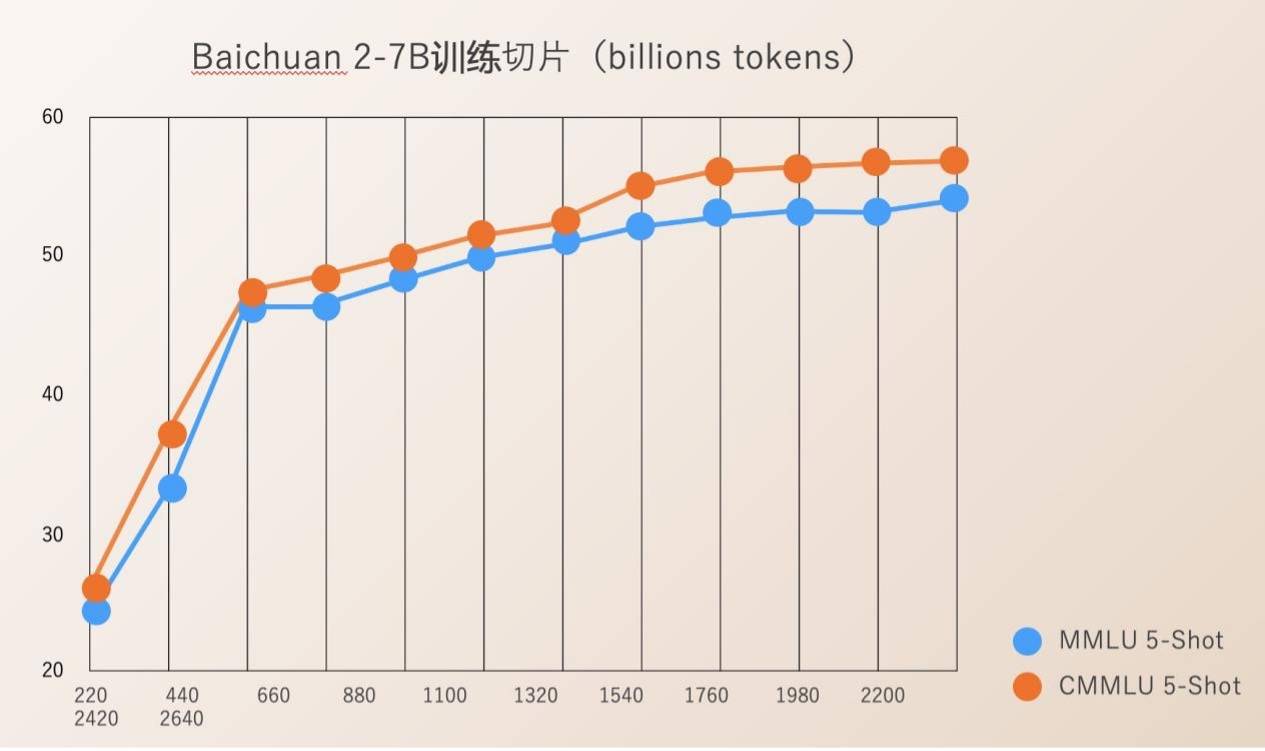

Baichuan Intelligence a ouvert Check Ponit pour l'ensemble du processus de formation des modèles de 220B à 2640B. Ceci est d'une grande valeur pour les instituts de recherche scientifique qui souhaitent étudier le processus de formation des grands modèles, la formation continue des modèles et l'alignement des valeurs du modèle, etc., et peut promouvoir les progrès de la recherche scientifique sur les grands modèles nationaux.

Auparavant, la plupart des modèles open source ne divulguaient que leurs propres poids de modèle et mentionnaient rarement les détails de formation. Les développeurs ne pouvaient effectuer que des ajustements limités, ce qui rendait difficile la conduite de recherches approfondies.

Le rapport technique Baichuan 2 publié par Baichuan Intelligence détaille l'ensemble du processus de formation Baichuan 2, y compris le traitement des données, l'optimisation de la structure du modèle, la loi d'échelle, les indicateurs de processus, etc.

Depuis sa création, Baichuan Intelligence considère la promotion de la prospérité du grand modèle écologique chinois grâce à l'open source comme une direction de développement importante de l'entreprise. Moins de quatre mois après sa création, la société a publié deux grands modèles chinois commerciaux gratuits et open source, Baichuan-7B et Baichuan-13B, ainsi qu'un grand modèle Baichuan-53B à recherche améliorée. évalué dans de nombreuses revues faisant autorité, il figure en bonne place sur la liste et a été téléchargé plus de 5 millions de fois.

La semaine dernière, le lancement du premier lot de photographies de service public à grande échelle a été une nouvelle importante dans le domaine technologique. Parmi les grandes entreprises modèles fondées cette année, Baichuan Intelligent est la seule à être enregistrée au titre des « Mesures provisoires pour la gestion des services d'intelligence artificielle générative » et à pouvoir officiellement fournir des services au public.

Avec des capacités de R&D et d'innovation de base sur les grands modèles de pointe, les deux grands modèles Baichuan 2 open source cette fois-ci ont reçu des réponses positives de la part des entreprises en amont et en aval, notamment Tencent Cloud, Alibaba Cloud, Volcano Ark, Huawei, MediaTek et bien d'autres. entreprises bien connues Tous ont participé à cette conférence et ont conclu une coopération avec Baichuan Intelligence. Selon les rapports, le nombre de téléchargements des grands modèles de Baichuan Intelligence sur Hugging Face a atteint 3,37 millions au cours du mois dernier.

Selon le plan précédent de Baichuan Intelligence, ils publieront cette année un grand modèle avec 100 milliards de paramètres et lanceront une « super application » au premier trimestre de l'année prochaine.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Raisons pour lesquelles phpstudy ne peut pas être ouvert

Raisons pour lesquelles phpstudy ne peut pas être ouvert

Quelle plateforme est la meilleure pour le trading de devises virtuelles ?

Quelle plateforme est la meilleure pour le trading de devises virtuelles ?

504 portail expiré

504 portail expiré

Qu'est-ce que le fil coin exactement ?

Qu'est-ce que le fil coin exactement ?

Comment définir une bordure pointillée CSS

Comment définir une bordure pointillée CSS

Comment ouvrir le fichier mobi

Comment ouvrir le fichier mobi

Touches de raccourci du pot de peinture PS

Touches de raccourci du pot de peinture PS

Comment utiliser la base de données ucsc

Comment utiliser la base de données ucsc