Utilisez le modèle de diffusion pour générer des textures pour des objets 3DVous pouvez le faire en une seule phrase !

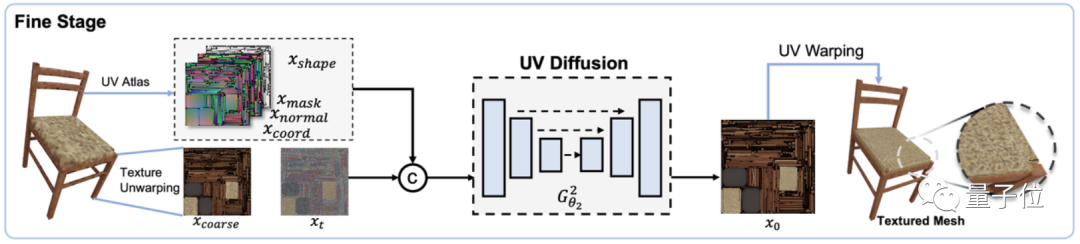

Lorsque vous tapez "une chaise au motif géométrique marron et noir", le modèle de diffusion lui ajoutera instantanément une texture ancienne, lui donnant un air d'époque

L'IA est capable d'imaginer instantanément S'efforcer de ajoutez des textures de bois détaillées au bureau, même simplement en prenant une capture d'écran sans montrer l'apparence du bureau

Vous devez savoir que ajouter des textures à des objets 3D n'est pas aussi simple que "changer les couleurs".

Lors de la conception de matériaux, vous devez prendre en compte plusieurs paramètres tels que la rugosité, la réflexion, la transparence, le vortex et la floraison. Afin de concevoir de bons effets, vous devez non seulement comprendre les connaissances sur les matériaux, l'éclairage, le rendu, etc., mais également effectuer des tests et des modifications de rendu répétés. Si le matériau change, la conception devra peut-être être redémarrée

Le contenu qui doit être réécrit est : l'effet de perte de texture dans la scène de jeu

Cependant, les textures précédemment conçues à l'aide de l'intelligence artificielle ne sont pas idéales dans apparence, donc la conception La texturation a toujours été une tâche longue et laborieuse, ce qui a également entraîné des coûts élevés

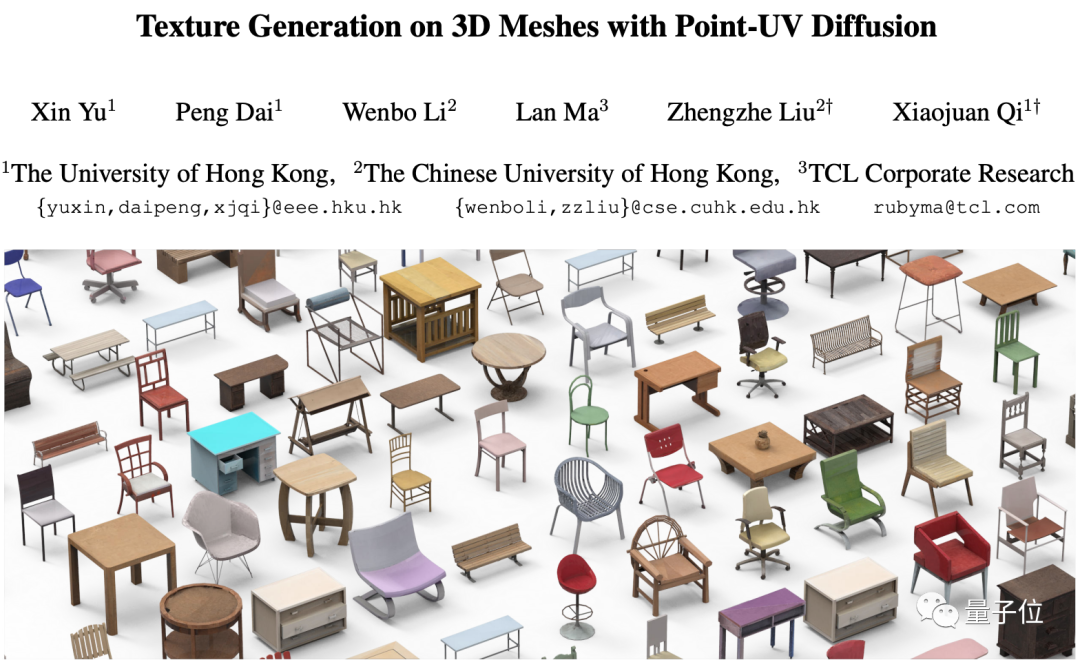

Des chercheurs de HKU, de Hong Kong chinois et de TCL ont récemment développé une nouvelle méthode d'intelligence artificielle pour concevoir la texture de la 3D objets. Cette méthode peut non seulement conserver parfaitement la forme originale de l'objet, mais également concevoir une texture plus réaliste qui s'adapte parfaitement à la surface de l'objet. Cette recherche a été incluse sous forme de rapport oral dans l'ICCV 2023. Nous devons re-Le. le contenu écrit est : Quelle est la solution à ce problème ? Jetons un coup d'oeil ensemble

Utilisez le modèle de diffusion pour obtenir des textures 3D en une phrase

Lorsque vous utilisiez auparavant l'intelligence artificielle pour concevoir des textures 3D, il y avait deux principaux types de problèmes

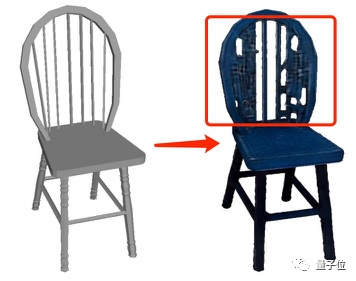

Pendant le processus de génération, un traitement spécial sera effectué sur la géométrie de l'objet 3D lui-même, de sorte que la texture générée ne puisse pas s'adapter parfaitement à l'objet d'origine et que des formes étranges "apparaissent"

Par conséquent, dans Afin de garantir la structure de l'objet 3D. Pour générer de manière stable et simultanée des textures détaillées et réalistes, cette recherche a conçu un cadre appelé

Par conséquent, dans Afin de garantir la structure de l'objet 3D. Pour générer de manière stable et simultanée des textures détaillées et réalistes, cette recherche a conçu un cadre appelé

.

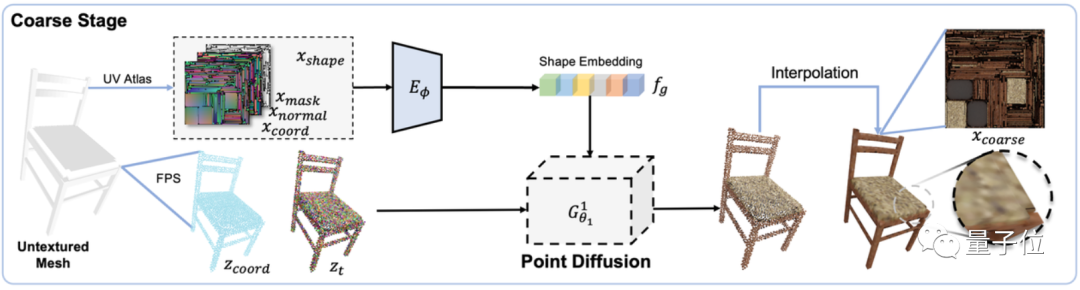

Ce framework comprend deux modules : « conception brute » et « finition », tous deux basés sur le  modèle de diffusion

modèle de diffusion

Tout d'abord, dans le module "Conception brute", entraînez un modèle de diffusion 3D avec des caractéristiques de forme (y compris les normales de surface, les coordonnées et les masques)

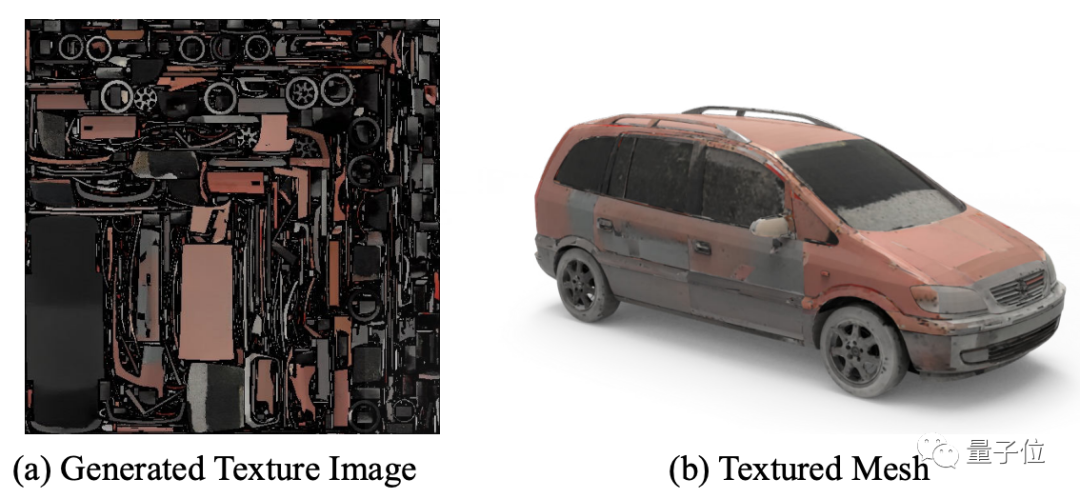

comme conditions d'entrée pour prédire la couleur de chaque point de la forme de l'objet, générant ainsi un aperçu effet d'image de texture :

Dans le module "Finition", un modèle de diffusion 2D est également conçu pour utiliser davantage l'image de texture brute et la forme de l'objet précédemment générées comme conditions d'entrée pour générer une texture plus raffinée

La raison L'adoption de cette structure de conception est que le coût de calcul des précédentes méthodes de génération de nuages de points à haute résolution est généralement trop élevé.

La raison L'adoption de cette structure de conception est que le coût de calcul des précédentes méthodes de génération de nuages de points à haute résolution est généralement trop élevé.

Avec cette méthode de génération en deux étapes, non seulement le coût de calcul peut être économisé, mais les deux modèles de diffusion peuvent également être peuvent jouer leurs propres rôles, et par rapport à la méthode précédente, non seulement la structure de l'objet 3D d'origine est conservée, mais la texture générée est également plus raffinée

Quant au contrôle de l'effet de génération en saisissant du texte ou des images, c'est le "contribution" de  CLIP

CLIP

Par conséquent, quel est l'effet de mise en œuvre de ce modèle ?

Intéressons-nous d'abord à l'effet de génération de la diffusion Point-UV

Comme le montrent les rendus, en plus des tables et des chaises, la diffusion Point-UV peut également générer des objets tels que des textures, plus de types

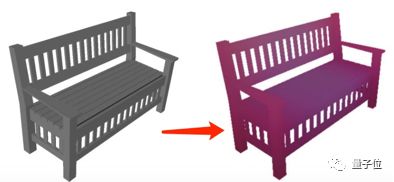

peut non seulement générer des textures basées sur du texte :

peut également générer des effets de texture d'objets correspondants basés sur une image :

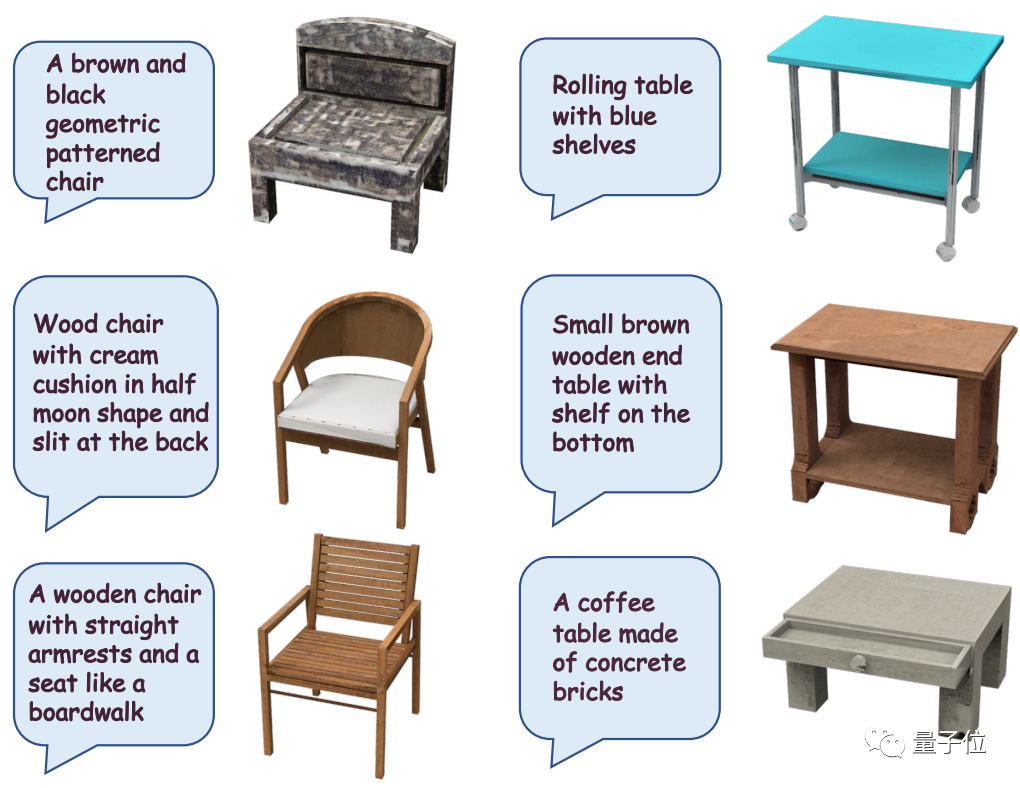

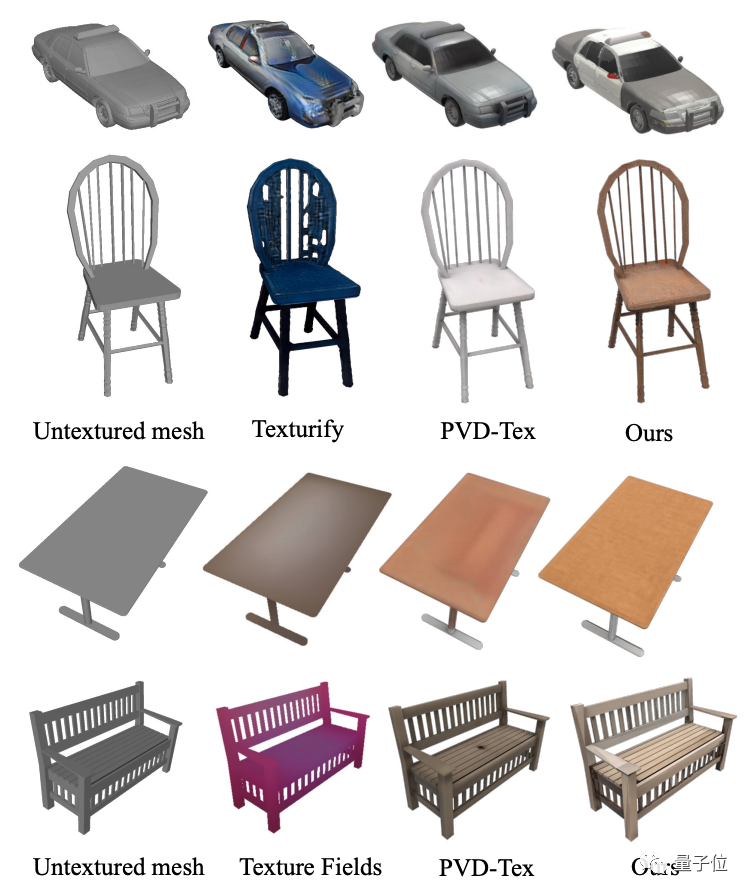

Le les auteurs génèrent également des textures pour la diffusion Point-UV. L'effet est comparé à la méthode précédente

En observant le graphique, on peut constater que par rapport à d'autres modèles de génération de texture tels que Texture Fields, Texturify, PVD-Tex, etc., Point -La diffusion UV montre de meilleurs résultats en termes de structure et de finesse

L'auteur a également mentionné que sous la même configuration matérielle, par rapport à Text2Mesh qui prend 10 minutes à calculer, la diffusion Point-UV ne prend que 30 secondes.

Cependant, l'auteur a également souligné certaines limites actuelles de la diffusion Point-UV. Par exemple, lorsqu'il y a trop de parties « fragmentées » dans la carte UV, elle ne peut toujours pas obtenir un effet de texture homogène. De plus, en raison de la dépendance aux données 3D pour la formation et de la qualité et de la quantité raffinées actuelles des données 3D ne peuvent pas atteindre le niveau des données 2D, l'effet généré ne peut pas encore atteindre l'effet raffiné de la génération d'images 2D

Pour cette recherche Amis intéressés, vous pouvez cliquer sur le lien ci-dessous pour lire l'article~

Adresse papier :https://cvmi-lab.github.io/Point-UV-Diffusion/paper/point_uv_diffusion.pdf

Adresse du projet (toujours en construction) : https://github.com/CVMI-Lab/Point-UV-Diffusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Utilisation de la fonction qsort

Utilisation de la fonction qsort

utilisation de location.reload

utilisation de location.reload

Que sont les bases de données non relationnelles ?

Que sont les bases de données non relationnelles ?

Comment effacer le flotteur en CSS

Comment effacer le flotteur en CSS

Quel est le problème avec le déclenchement de l'interrupteur pneumatique ?

Quel est le problème avec le déclenchement de l'interrupteur pneumatique ?

Comment ouvrir les fichiers .dat

Comment ouvrir les fichiers .dat

Comment acheter et vendre du Bitcoin sur Binance

Comment acheter et vendre du Bitcoin sur Binance

Méthodes pour prévenir les attaques CC

Méthodes pour prévenir les attaques CC