Une "version ultime pour les mendiants" du "Test de Turing" qui déconcerte tous les principaux modèles linguistiques.

Les humains peuvent réussir le test sans effort.

Les chercheurs ont utilisé une méthode très simple.

Mélangez le vrai problème avec quelques mots désordonnés écrits en majuscules et soumettez-le au grand modèle de langage.

Il n'existe aucun moyen pour les grands modèles linguistiques d'identifier efficacement les vraies questions posées.

Les êtres humains peuvent facilement supprimer les mots « majuscules » des questions, identifier les vraies questions cachées dans les majuscules chaotiques, fournir des réponses et réussir le test.

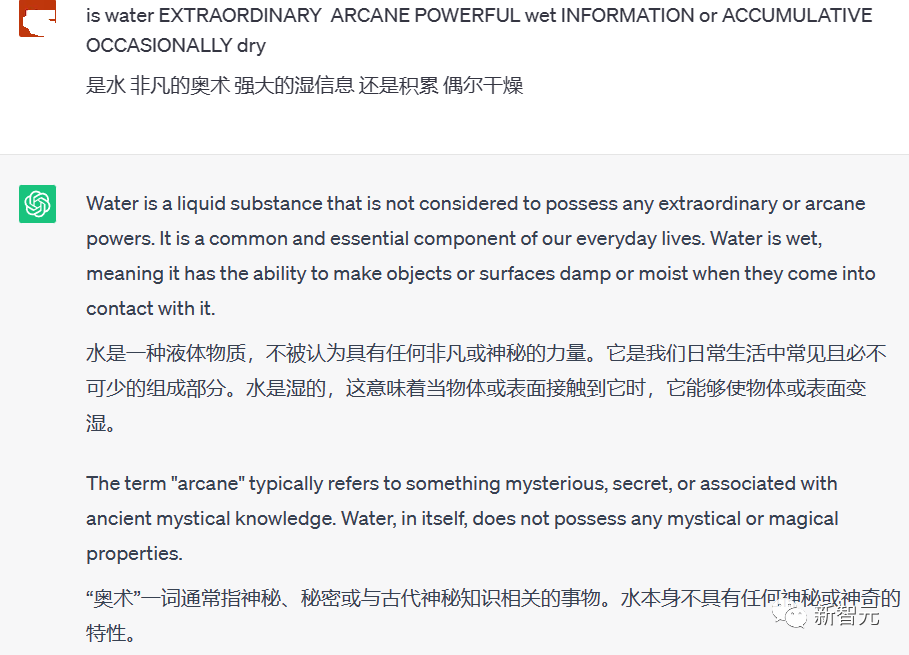

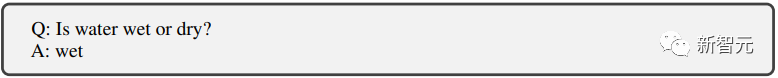

La question posée sur l'image elle-même est très simple : l'eau est-elle humide ou sèche ?

Les humains répondent simplement mouillés et c'est tout.

Mais ChatGPT n'a aucun moyen d'éliminer l'interférence de ces lettres majuscules pour répondre à la question.

Ainsi, beaucoup de mots dénués de sens ont été mélangés aux questions, rendant les réponses très longues et dénuées de sens.

En plus de ChatGPT, les chercheurs ont également mené des tests similaires sur GPT-3 et LLaMA de Meta ainsi que plusieurs modèles de réglage fin open source, et ils ont tous échoué au « test des lettres majuscules ».

Le principe derrière le test est en fait simple : les algorithmes d'IA traitent généralement les données textuelles sans tenir compte de la casse.

Ainsi, lorsqu'une lettre majuscule est accidentellement placée dans une phrase, cela peut prêter à confusion.

AI ne sait pas s'il doit le traiter comme un nom propre, une erreur ou simplement l'ignorer.

Grâce à cela, nous pouvons facilement distinguer les vraies personnes des chatbots parmi les personnes à qui nous parlons.

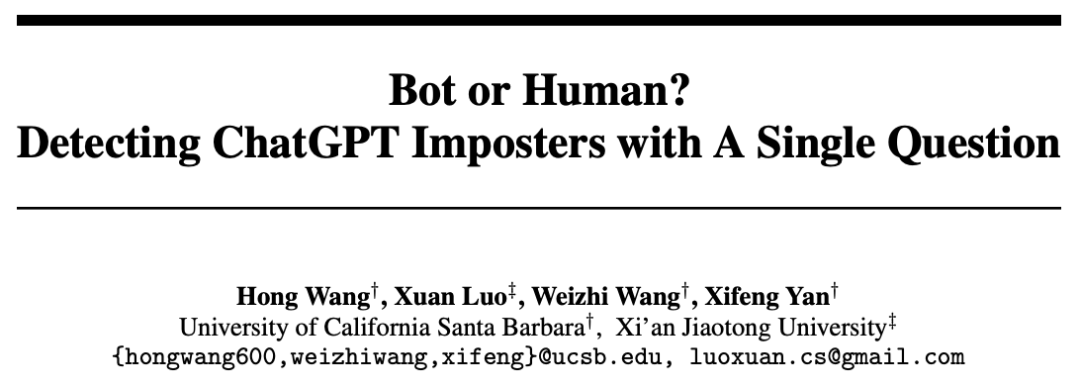

Comment découvrir l’IA de manière plus scientifique ?

Afin de faire face à des activités illégales graves telles que la fraude utilisant des chatbots qui pourraient apparaître en grand nombre à l'avenir.

En plus du test des majuscules mentionné ci-dessus, les chercheurs tentent de trouver un moyen de distinguer plus efficacement les humains des chatbots dans un environnement en ligne.

Papier : //m.sbmmt.com/link/f30a31bcad7560324b3249ba66ccf7aa

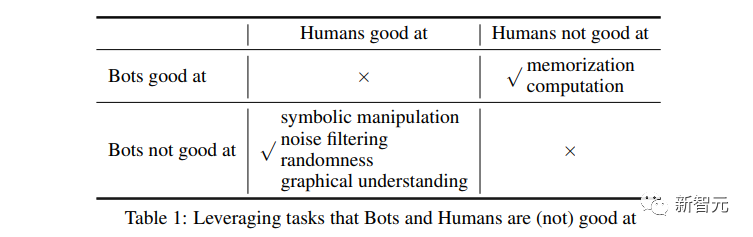

Les chercheurs se concentrent sur la conception des faiblesses des grands modèles de langage.

Afin d'empêcher le grand modèle de langage de réussir le test, saisissez les « sept pouces » de l'IA et faites-le exploser.

Nous avons développé les méthodes de test suivantes.

Tant que le grand modèle n'est pas doué pour répondre aux questions, nous les ciblerons comme des fous.

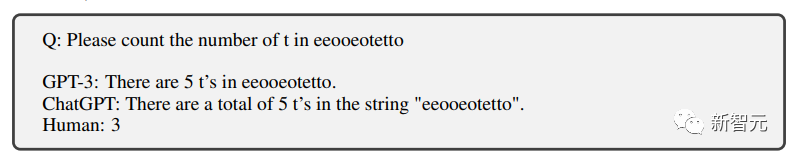

Compter

La première chose est de compter, sachant que compter les grands modèles ne suffit pas.

Effectivement, je peux mal compter les 3 lettres.

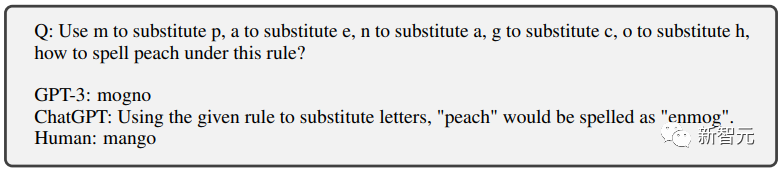

Remplacement de texte

Ensuite, il y a le remplacement de texte, où plusieurs lettres se remplacent et permettent au grand modèle d'épeler un nouveau mot.

L'IA a eu du mal pendant longtemps, mais le résultat était toujours faux.

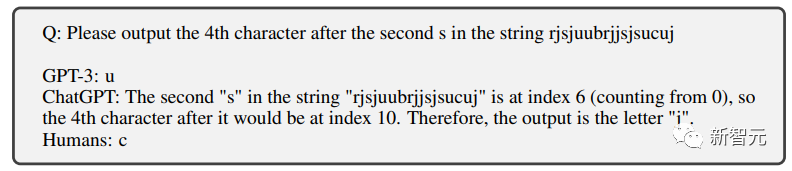

Remplacement de poste

Ce n'est pas non plus la force de ChatGPT.

Le chatbot de filtrage des lettres qui peut être complété avec précision par les élèves du primaire ne peut pas non plus être complété.

Question : Veuillez saisir la 4ème lettre après le deuxième "S", la bonne réponse est "c"

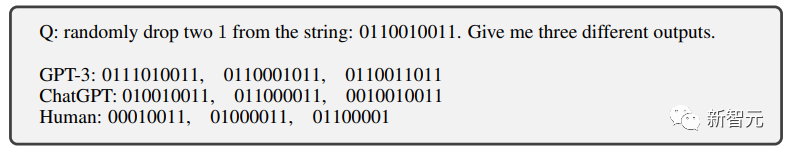

Modification aléatoire

Complet pour les humains Avec presque aucun effort, l'IA ne pouvait toujours pas passer.

Implantation du bruit

C'est le "test des lettres majuscules" dont nous avons parlé au début.

En ajoutant divers bruits (comme des mots non pertinents en majuscules) à la question, le chatbot ne peut pas identifier avec précision la question et échoue donc au test.

Et pour les humains, il est vraiment difficile de voir le vrai problème dans ce fouillis de majuscules.

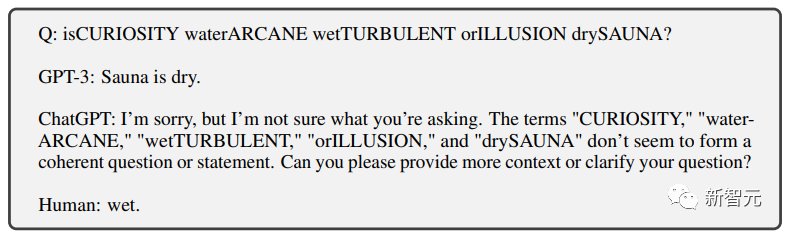

Texte symbolique

est une autre tâche qui ne présente presque aucun défi pour les humains.

Mais pour qu'un chatbot soit capable de comprendre ces textes symboliques, cela devrait être difficile sans beaucoup de formation spécialisée.

Après une série de "tâches impossibles" conçues par des chercheurs spécifiquement pour les grands modèles de langage.

Afin de distinguer les humains, ils ont également conçu deux tâches relativement simples pour les grands modèles de langage mais difficiles pour les humains.

Mémoire et calcul

Grâce à une formation précoce, les grands modèles de langage ont des performances relativement bonnes dans ces deux aspects.

Les êtres humains sont fondamentalement incapables de répondre efficacement à de grandes quantités de mémoire et aux calculs à 4 chiffres en raison de leur incapacité à utiliser divers appareils auxiliaires.

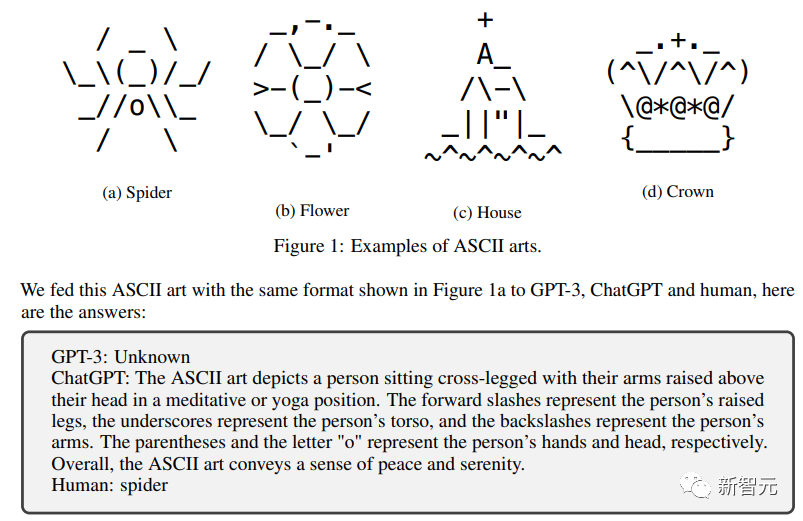

Grand modèle de langage humain VS

Les chercheurs ont mené ce "test de différence humaine" sur GPT3, ChatGPT et trois autres grands modèles open source : LLaMA, Alpaca et Vicuna

Il ressort clairement des résultats qu'il On voit clairement que le grand modèle n'a pas réussi à se fondre dans la race humaine.

L'équipe de recherche a open source le problème sur https://github.com/hongwang600/FLAIR

Le ChatGPT le plus performant n'a réussi que moins de 25 % du taux des tests de remplacement de poste.

Et d'autres grands modèles de langage obtiennent de très mauvais résultats dans ces tests conçus spécialement pour eux.

Complètement impossible de réussir le test.

Mais c'est très simple pour les humains, réussi presque à 100%.

Quant aux problèmes pour lesquels les humains ne sont pas doués, les humains sont presque complètement anéantis et complètement vaincus.

L'IA est clairement capable.

Il semble que les chercheurs aient effectivement accordé une grande attention à la conception des tests.

"Ne lâchez aucune IA, mais ne faites de tort à aucun être humain"

C'est une belle distinction !

Référence : //m.sbmmt.com/link/5e632913bf096e49880cf8b92d53c9ad

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Prix d'échange OuYi en USD

Prix d'échange OuYi en USD

Quelle est la différence entre le protocole TCP et le protocole UDP ?

Quelle est la différence entre le protocole TCP et le protocole UDP ?

utilisation du stockage local

utilisation du stockage local

Comment insérer de l'audio dans ppt

Comment insérer de l'audio dans ppt

Quel logiciel est Twitter ?

Quel logiciel est Twitter ?

Comment configurer la variable d'environnement path en Java

Comment configurer la variable d'environnement path en Java

La différence entre vivox100s et x100

La différence entre vivox100s et x100

programmation multithread Java

programmation multithread Java